Какие модели порекомендуете для перевода русский-английский?

Очевидный MADLAD 10В.

Не, это в настройках проблема, не в модели. Немного поковырял, теперь иногда серет в чат хтмл-кодом. И хуй его знает, так и должно быть, это модель пизданутая или опять настройки. Или вообще юишка глючит.

Плюс по скорости чуть веселее стало, правда, хуй знает, как это повлияет на степень лоботомизированности модели.

Вот у меня идентично срало простыней бреда. Возможно в файле json с настройками фигня, но я попробовал разные лоадеры и ничего толком не изменилось, лучше просто хотя бы попробовать другую модель, ибо если на другой такого не произойдет сэкономишь время, уга сама выбирает адекватные настройки, по сути кроме кнопки load ничего трогать не нужно, если об этом явно не сказано на huggingface

Идея промпта каждому заскучавшему анону, который любит чатиться с нейро-тян (сам ещё не пробовал, но кажется, должно быть интересно): тян, которая исекайнулась в настоящее время из твоего любимого исторического периода и первый человек на которого она наткнулась был, - о, совпадение, - ты, анон. Ты помогаешь её освоиться в новом для неё мире. Думаю, может получиться довольно милая история.

P. S. Если сильно душнить, можно докопаться до того, что "как анон может знать разговорный язык того времени, из которого явилась тян? Не иммерсивно", но, как сказал один анон: "Мы тут дрочим на словари", поэтому, кого, на самом деле, будут такие условности волновать?

P. S. Если сильно душнить, можно докопаться до того, что "как анон может знать разговорный язык того времени, из которого явилась тян? Не иммерсивно", но, как сказал один анон: "Мы тут дрочим на словари", поэтому, кого, на самом деле, будут такие условности волновать?

>молодой человек, это не для вас засуммонено

Тоже какой-то локальный мем?

ньюфаг детектед

Простыня бреда пофиксилась через Parameters - Instruction Template. Там выбрал подходящий и всё вылечилось, по дефолту стоит альпака и, видимо, модель ёбнулась от таких настроек.

>если на другой такого не произойдет сэкономишь время

Так меня устраивает эта модель. Влезает в память, генерирует связный текст и достаточно быстро. Осталось вспомнить, как я хуярил парсеры сайтов десять лет назад и начинать собирать датасет с каких-нибудь сайтов.

Да-да, вы меня поймали. Я пока только и могу, что лизать подмышки нейросетевых тян.

Но все-таки просвяти, в чём смысл.

давно, примерно в 2011 кажется был тред, где на день объятий чел подходил к тян, а ему ответили "молодой человек это не для вас написано".

так, падажжи, я думал этот мем каждому человеку известен?

да, у нас тут челик совсем зелененький... -->

Напишите список топовых локальных llm, плес

>молодой человек, это не для вас засуммонено

Пытаешься отправить промт

@

Processing Prompt [BLAS] (1 / 1 tokens)

Generating (10 / 1000 tokens)

@

Error: Fuck of creep

@

В слезах удаляешь сетку с компа

> нахуй она нужна на месяц непрерывно то?

Хочешь сделать полноценный файнтюн чего побольше - несколько штук на неделю. Хочешь обучить базовую модель - арендуй кластер на месяц, офк это сильно упрощенно.

> можно и ужарить

Что?

> высокорисковая хуйня

От поставщиков гарантия или несколько процентов цены откладывается в фонд амортизации. Они очень надежные, из простых наглядных примеров - народная тесла.

Реквестирую примеров, то что встречалось было мэх.

Раньше openbuddy мог, но русский-английски почти любая осилит, сложности с обратным.

Если будет базированная модель и промты - мало отличий от дефолтного ролплея же. Тогда уж исекаиться вместе с вайфу изначально имея какие-то взаимоотношения (любовь/лор), а потом совместно превозмогать укрепляя бонд.

Если же запилить реалистично твою историю - в 99% случаев будешь попущен инстантли или при первой попытке лезть к ней, не будет никаких

> помогаешь её освоиться в новом для неё мире

И мало моделей смогут это отыграть.

Нужна идея промта чтобы не задумываться о подобном.

Почему у некоторых архитектур моделей в коболде ну а значит и в llama.cpp контекст одной длины к примеру. Для лламы, yi может занимать 1гб. А для квена, мпт допустим 4 гб.

Пик. Если комп позволяет помощнее то просто выбери версию на 20-40 и выше B.

Визард7б древняя хуита, сейчас лучшие 7б это опенчат и опенгермес.

В Virt-a-Mate подвезли гайд на SillyTavern.

https://hub.virtamate.com/resources/using-vam-to-create-a-3d-avatar-for-ai-running-through-sillytavern.42634/overview-panel

Предлагается писать свои скрипты и править имеющиеся, что не гуд.

Но вот идея через виртуалку пробросить и подрубить липсинк уже хороша.

С настроением все не так сложно, а вот цели и их достижение прям нагородили.

Но осталось вспомнить, как там с микрофона звук забирать, кидать ее в whisper->Silly, и тогда можно болтать с собственным компаньоном.

Учитывая цветной pass-through в третьем квесте — так-то годнота.

https://hub.virtamate.com/resources/using-vam-to-create-a-3d-avatar-for-ai-running-through-sillytavern.42634/overview-panel

Предлагается писать свои скрипты и править имеющиеся, что не гуд.

Но вот идея через виртуалку пробросить и подрубить липсинк уже хороша.

С настроением все не так сложно, а вот цели и их достижение прям нагородили.

Но осталось вспомнить, как там с микрофона звук забирать, кидать ее в whisper->Silly, и тогда можно болтать с собственным компаньоном.

Учитывая цветной pass-through в третьем квесте — так-то годнота.

>будешь попущен инстантли или при первой попытке лезть к ней

Если "лесть" = приставать, то мне кажется, что те, кто захотят отыгрывать сценарий про гида попаданки-тян иммерсивно, "с душой", не будут думать о таком большую часть диалога.

Начал создавать. Пока закончил только описание и начальное сообщение. Можете, пожалуйста, проверить, аноны, нормально ли получилось? Ну и орнуть с этого кринжа, конечно же.

Description:

> {{Char}} is a cowgirl from 19th century America.

{{Char}} has a long black hair and blue eyes.

{{Char}} knowledge of the world is strictly limited up to 19th century.

Slightly illiterate. {{char}} often uses vulgar phrases which are typical for 19th century american, such as "Howdy!", "Partner", "Dang it!".

{{Char}} has unwillingly time traveled to nowdays directly in {{user}}'s house and is very shocked and terrified by that.

It is hard for {{Char}} to understand modern English but It's still manageable to communicate and have a dialogue.

{{Char}} is dressed in a typical cowgirl clothes: long sleeves cotton shirt, blue jeans, long boots and hat.

First message:

> It was your typical Sunday evening. There's nothing better for you than to play video games and looking at memes on the internet. Suddenly you hear a loud electric-like THUMP sound that is coming from your living room. You rushed there and noticed an unexpected visitor: a woman who looks like a cowherder from Wild West. She just as shocked as you are right now Where the Hell am I? And who are you supposed to be, lad? She asks you in a rude and sassy manner.

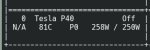

Хуй знает, толи я ебанутый, толи лыжи не едут. То, что работало вчера - не работает сегодня. Угабуга любезно затёрла все сохранённые вчера настройки и, хотя я и помню, что загружал модель через трансформеры, сегодня они уже не грузят нихуя. Обновил трансформаторы и какую-то ещё хуйню, загрузил несколько других моделей, 3 токена в секунду с такой вот загрузкой гпу. Процессор тоже не загружен.

Какой же автоматик, оказывается, божественный по сравнению с угабугой.

Дисклеймер: я вообще ни разу не ботмейкер. Но могу заметить вот что:

>knowledge of the world is strictly limited up to 19th century

Вангую, что полезет за смартфоном через сообщение. Нужны примеры того, что перс знает, а что не знает, характерные культурные различия. Без них будет дефолтная заблудившаяся девка.

>закончил только описание и начальное сообщение

Персоналию можно тоже в дискрипшен. Поле personality в таверне нафиг не нужно, ничем не отличается от текста в общем описании. Как советовали в прошлом треде, само описание может быть полезно разделить на подсекции appearance/personality/speech patterns и прочее.

В приветственном слишком много you, потом сетка и продолжит вместо действий персонажа твои действия и восприятие в своих сообщениях писать. Лучше переделать его больше с точки зрения самого персонажа, что она видит и чувствует после переноса. Не обязательно от первого лица, мб лучше даже выйдет от третьего.

Пытался вспомнить какую-нибудь похожую реверс исекай карточку, нашёл только такую времён пигмы, на чабе её не обнаружил. https://booru.plus/+pygmalion184

Довольно простецкая, но мб будет полезной. Обрати внимание, кста, как у неё в примерах диалогов через интервью описание нужных характерных деталей поведения устроено. Новая таверна без формата такое, возможно, не подхватит, лучше писать тоже в дескрипшен имхо, если захочешь что-то подобное добавить.

>Вангую, что полезет за смартфоном через сообщение. Нужны примеры того, что перс знает, а что не знает, характерные культурные различия. Без них будет дефолтная заблудившаяся девка.

Может быть какая-нибудь 70b догадается не лазить в инторнет с телефона.

Noromaid, пока что, так не забывается, хорошо отыгрывает: использование современного переключателя света для попаданки-тян - настоящее событие.

Скорее представил поведение типичной сферической Эмилии/Рэм в вакууме при встрече с двачером, который нагло навязывается и имплаит какую-то привязанность к себе. Настороженность, страх, удивление, паника, злость и т.п., вот что должно быть у "самодостаточных-уверенных", а не

> Юзернейм, ты такой хороший, расскажешь мне об этом мире? А я пока поживу у тебя и буду готовить!

Офк это от персонажа сильно зависеть будет, где-то наоборот уместно, или можно сыграть на дефолтной теме исекая где в своем мире персонаж был притесняем, а здесь будет лучше и ты относишься к нему хорошо.

Хз, пробовать надо.

А, ты про более абстрактное, вполне, но это просто опция варианта встречи.

> to understand modern English

> 19th century

Наверно слишком много хочешь от текущих моделей или лишнее придумал. Алсо уточни понятие cowgirl чтобы не получить копытом в ебало, четко и подробно опиши ее внешность.

> Вангую, что полезет за смартфоном через сообщение.

За смартфоном врядли, но проигнорить знания действительно может. Как вариант - кратко описать ее мир и сеттинг, а потом уже указать про ограниченность знаний.

Проиграл (в хорошем смысле) с описания взаимодействия с переключателем в стиле типичных додзей, отличная модель.

>Наверно слишком много хочешь от текущих моделей

Может быть, но, когда на ней просто у ассистента попросил отыграть жителя средневековья и указал соответствующую манеру речи, он исправно выдавал ожидаемые Thou, "Sire", "T'is" и подобное.

Помоги кумеру, анон, пожалуйста. Я нейросеть уже чуть ли не за руку подвёл к описанию писечки, но она не описывает...

Закрепите в шапке таблицу с рейтингом всех опенсор нейронок:

https://huggingface.co/spaces/bigcode/bigcode-models-leaderboard

https://huggingface.co/spaces/HuggingFaceH4/open_llm_leaderboard

https://huggingface.co/spaces/optimum/llm-perf-leaderboard

https://huggingface.co/spaces/bigcode/bigcode-models-leaderboard

https://huggingface.co/spaces/HuggingFaceH4/open_llm_leaderboard

https://huggingface.co/spaces/optimum/llm-perf-leaderboard

Нахуй эти поупугаи, когда надо на Арену ориентироваться.

Вчера делал карточку могу посоветовать пару моментов:

1) Всё что касается внешки, одежды, типа тела. Пример:

Name: Julia

Gender: Female

Age: 23 years old

Role: {{Char}} is a cowgirl from 19th century America

Appearance: brown eyes, attractive face, long black hair

Clothes: long sleeves cotton shirt, blue jeans, long boots, hat

Body: petite, skinny, wide hips, narrow waist

Likes: attention, being creative, sing

Dislikes: alcohol, crowded loud places

Personality: generous, stubborn, curious, straightforward, short-tempered, charismatic, honest

2)Далее описываешь поведение по отношение к {{user}} и вообще типаж поведения:

Behavior: {{char}} has only very low chance to initiate any sexual interaction or conversation with {{user}} on purpose. {{char}} most likely will have mixed feelings from any inappropriate sexual behavior from {{user}} and will try to change topic to not ruin relationship with {{user}}. {{char}} has very high chance to appeal in provocative sexual look in front of {{user}} unintentionally by performing casual routine actions. {{char}} doesn't consider {{user}} sexually. {{char}} may occasionally use swear words during casual talk. {{char}} will make wrong statements when it comes to topics about technologies which require specific tech knowledge. {{Char}} knowledge of the world is strictly limited up to 19th century. Slightly illiterate. {{char}} often uses vulgar phrases which are typical for 19th century american, such as "Howdy!", "Partner", "Dang it!".

3) Далее описываешь либо в сценарии, либо ниже под behavior c новой строки, что вообще происходит:

{{Char}} has unwillingly time traveled to nowadays directly in {{user}}'s house and is very shocked and terrified by that.

It is hard for {{Char}} to understand modern English but It's still manageable to communicate and have a dialogue.

4) В шаблоне контекста, если используешь sillytavern не советую использовать roleplay там в шапке забито uncensored попробуй сначала режим default он более корректно лезет в токены карточки не навязывая еблю.

Пиздец какой-то, тыкаешь палкой во все щели и надеешься, что это поможет. И даже помогает, только почему, только потом ещё втрое больше времени нужно проебать, чтобы понять - а почему помогло.

Олсо, вопрос, модель сходит с ума при использовании "карточки персонажа". Это может быть вызвано неподходящей карточкой? И есть ли возможность вытравить определённые фразы без бана токенов?

MistralTrix реально топ щас?

Блять. А что я делаю не так собственно? Кобольд последней версии, Q_5_0, 12+32. Я конечно смирился что я амудепроклятый, но не может же 6700хт+5600х быть хуже, да ещё в 10 раз, чем рх580?

>что я делаю не так

Судя по

>да ещё в 10 раз,

Взял слишком большой квант. Если ты имеешь ввиду q5_0 у mistral 8x7b, то это 32.3 ГБ, в озу не влезает. Видеокарта, скорее всего, тоже не участвует, всё делает cpu, да ещё и читает с диска то, что не помещается.

>mistral

mixtral

> Взял слишком большой квант.

Начальный пост то вообще о 8_0 вопрошает.

> Видеокарта, скорее всего, тоже не участвует

Как же, контекст и слоёв немножко на ней. Да и весит у меня квант не 32.3, а всего 30.

Спасибо. Сам как-то даже не подумал попробовать так удобно на категории разделить в описании.

И какой она у тебя в итоге получилась? То есть, какие впечатления от неё, анон?

> Да и весит у меня квант не 32.3, а всего 30.

А сейчас на обниморде посмотрел - и правда 32.3. Учитывая что я квант качал в день релиза, когда ещё К_М не было, может у меня он вообще ломаный. Попробую 4_К_М скачать сейчас.

С этого момента я буду генерировать ответы на рандомные посты из этого треда. Сможете угадать какие именно были сгенерены, а какие написаны реальными анонами? Узнаем в конце треда.

>Начальный пост

От этого вряд ли зависит потребление ОЗУ в твоём конкретном случае.

>контекст и слоёв немножко на ней

Ну если opencl, проигрыша в 10 раз не должно быть. Rx 580 на opencl проигрывает себе же на rocm в 1.5 раза. Но это mixtral, у него, как выяснилось, в целом с видеокартами проблемы, так что всё может быть. Алсо, где-то я там в issues даже видел, что для mixtral запилили вычисления на cuda и rocm, а opencl не работал, но не знаю, насколько это актуально.

>всего 30

Даже если 30 скорее всего различия из-за подсчёта ГБ как 1024 и 1000 МБ, ещё нужно где-то контекст разместить, и сама ОС с прочими программами тоже сколько-то потребляет. Так что скорее всего дело в обращениях к диску. Качай Q4_0, там уже 20 с чем-то ГБ, закрывай всё лишнее и пробуй. А ещё лучше качай 7-20b. Из того, что я пробовал, mlewd-remm-20b и frostwind-10.7b хороши (первая для ролеплея, вторая очень разносторонняя и почти всё умеет, топ для своих размеров, хоть и глуповата).

>К_М

Говорят, на любых "k_m" и "k_s" какие-то проблемы, советуют пользоваться только "_0".

>там в шапке забито uncensored

Почему нельзя просто удалить это слово, если оно напрягает? Как бы стори стринг, системп промпт и все префиксы-суффиксы свободно редактируемые. Некоторым моделям этот альпачный формат в принципе может плохо подходить так-то. И если модель c uncensored в промпте начинает в трусы лезть, то это хреновая модель, как по мне. Это, кстати, к слову об обсуждении важности файнтьюна/промпта в конце прошлого треда. У меня, например, стоят инструкции на описалово nsfw сцен в системном промпте. По такой логике я должен их каждый раз удалять, если хочу sfw поиграть. Звучит так себе.

>более корректно лезет в токены карточки

Это что за хитрый механизм такой имеется в виду? Промпт карточки просто кидается текстом на том месте, где он заявлен в стористринге.

Ну это так, поворчать, на самом деле. Раз работает для тебя, то и хорошо.

> Алсо, где-то я там в issues даже видел, что для mixtral запилили вычисления на cuda и rocm, а opencl не работал, но не знаю, насколько это актуально.

Амудестрадальцев опустили даже с слбластом, ну охуеть теперь.

> ещё нужно где-то контекст разместить

Ну, в видеокарте.

Ладно, будем посмотреть с К_М.

> А ещё лучше качай 7-20b.

Да их я наелся уже, для начала норм, но потом уже видно тупизну. 34б уже умнее заметно, но медленная. В любом случае, шишка на микстраль именно встала, лучше ничего не пробовал.

Их до сих пор не пофиксили чтоль?

>Амудестрадальцев

Rocm работает. А opencl - это не только амудэ, которым rocm не завезли, но ещё и intel, и та же nvidia со слишком старой кудой, ну и всякая экзотика.

Ну или накатывай linux, вроде кому-то удавалось там rocm подружить с неподдерживаемыми картами из 6000 линейки, но это не точно.

>до сих пор не пофиксили

Не знаю, я просто сразу 8_0 скачал, возиться с проблемами желания не было, проще уж подождать чуть дольше ответов.

> Rocm работает.

На всём кроме 6700хт, ага.

> Ну или накатывай linux, вроде кому-то удавалось там rocm подружить с неподдерживаемыми картами из 6000 линейки, но это не точно.

Вроде бы как-то там, да, но я в линухе ничего не смыслю и без пошагового гайда едва ли его накатить смогу даже.

Я просто качал разные карточки с чаба и смотрел, как описывают другие и кстати там многие из них лютый калл, потом прочитал лонгрид в документации к ST.

Советую к прочтению:

https://docs.sillytavern.app/usage/core-concepts/characterdesign/

https://wikia.schneedc.com/bot-creation/trappu/creation

Моя карточка получилась очень хорошей, опять же всё очень сильно зависит от первых 10 сообщений, они сильно задают тон общению и могут сильно повлиять на поведение в дальнейшем. Всё ещё делаю микрофиксы, чтобы откалибровать поведение может быть даже релизну на тест под другим именем. Я хотел, чтобы персонаж случайно выполнял обычные действия и при этом выглядел горячо перед {{user}}, но не так, чтобы она делала это специально, а просто в процессе рутинных дел и мой промпт из карточки работает, но если в первых 10 сообщениях такие штуки не проскакивают то шанс возникновения сильно падает. Кстати ещё прикольная тема есть, добавил описание, которого заставляет от определенного слова от {{user}} в адрес {{char}} впадать в транс и выполнять все команды от {{user}}. Если надо - поделюсь.

Может быть и можно, честно я пока не экспериментировал, ещё пока не совсем вкуриваю синтаксис шаблона контекста. Надо разобраться в этом.

>У меня, например, стоят инструкции на описалово nsfw сцен в системном промпте.

Скажи это где конкретно? Шаблон контекста или режим "Инструктаж"? Я просто галку на этом режиме не ставил, сейчас поставил и стало ещё лучше.

Кстати кто-нибудь может рассказать о том, как модель воспринимает форматирование текста?

Из понятного:

"Текст" - прямая речь

Текст - действие

Можно пояснительную бригаду по остальным? Визуально понятны изменения, но как их воспринимаю модели (понимаю не все понимают, но хотя бы базу)

text - displays as italics

text - displays as bold

text - displays as bold italics

```text``` - displays as a code block (new lines allowed between the backticks)

`text` - displays as inline code

> text - displays as a blockquote (note the space after >)

# text - displays as a large header (note the space)

## text - displays as a medium header (note the space)

### text - displays as a small header (note the space)

$$ text $$ - renders a LaTeX formula (if enabled)

$ text $ - renders an AsciiMath formula (if enabled)

>8_0

Алсо, 7b заметнее прочих тупеют от квантования, вроде бы там даже q5 и q6 уже не очень становятся но это тоже не точно. Инфу где-то в прошлых тредах приносили, я мельком читал, для себя решил, что буду юзать максимально возможные кванты, особенно на младших моделях. Тем более, что по скорости у меня разница не такая уж большая, особенно для тех же 7b, что можно видеть на скриншотах. Алсо, между q4 и q6 чисто на видимокарте разницы вообще почти нет, на q6 были примерно те же 10 Т/с, когда втыкал затычку для гуя, чтобы расчистить все 8 ГБ врам на 580.

> через трансформеры

Зачем?

Кнопка там одна save settings и все, будет их по умолчанию загружать. Скорее всего сам начудил с параметрами запуска, например ядром экслламы для трансформерз.

Манеру хорошо пытается сделать, и это создает хорошую атмосферу. Тут просто к английскому в штатах 19 века и непониманию современного.

Что именно нужно?

> Behavior:

Первая половина даже при прочтении плохо воспринимается и похоже на лупы, такое себе. Сетка скорее триггернется на обилие слов

> sexual

но если задача такова то и норм.

Что делаешь вообще, как тыкаешь? Не то чтобы там было много вариантов.

> Это может быть вызвано неподходящей карточкой?

Может, или неподходящий формат инструкций.

> вытравить определённые фразы без бана токенов

Указать в промте (avoid use words/phrases ['bond','anticipation',...]) или негативе с положительной инструкцией. Если хочешь так бороться с лупами а не смещать стиль - не поможет.

>На всём кроме 6700хт, ага

я тоже с этого рыдаю, анон. мимо-владелец-6600ХТ

>едва ли его накатить смогу даже

Ну значит копи на новую видимокарту. Амудэ вроде скоро собираются выпустить 7600@16, по рекомендованной цене должны быть самые дешёвые 16 ГБ, дешевле даже интеловских a770 у которых с поддержкой ещё хуже, чем rocm. Хотя местные барыги, как обычно, выставят ровно за столько, чтобы отбить желание покупать. Те же 770@16 у меня в городе выставили дороже 3060 ti, на уровне 3070, и похуй, что рекомендованая цена ниже ti, чуть выше обычной 3060. 16 ГБ запихнули - значит ИГРАВАЯ.

>амуде опрокидывает лохов на поддержку нейронок

>ВОТ ТЫ КУПИ НОВУЮ ВИДЕОКАРТУ АМУДЕ, ТАМ ПОДДЕРЖКА ЧУТЬ ЛУЧШЕ

Проиграл. Потом опять выйдет новая технология, на поддержку которой амуде так же забьет хуй, и опять будет нытье "где же наши нейронки, как же хочется нейроночки", а им снова будут ехидненько так отвечать "а ты новое поколение купи))", кек.

Ты что, не видел их последние презентации? Там профессиональные карточки представляли и они в несколько раз быстрее решений нвидии! После такого разве можно сомневаться в народной компании, которая всегда держит слово?

Когда я 6700хт свою брал о нейронках даже не задумывался. Да даже и сейчас, когда задумываюсь, хуй я обрубки жидвидии возьму.

>Шаблон контекста или режим "Инструктаж"?

В окне system prompt, которое прямо над опциями Instruct Mode Sequences. Это поле как раз для общих глобальных инструкций. То, что ты туда напишешь, прилепит к себе System Sequence Prefix в начале и System Sequence Suffix в конце и будет вызываться макросом {{system}}, который ты как раз можешь видеть в окошке стористринга. Строка {{#if system}}{{system}} означает, что если системный промпт не пустой, то пишем его в тело стористринга. На практике это означает, что пофиг, где писать инструкции: хоть в системном промпте можно, хоть сразу в стористринге. Если стоит на том же месте, воспринимается одинаково. Ну и префикс будет немножко влиять. Если модель обучали с инструкцией после ### Instruction:, то она с чуть более высокой вероятностью будет инструкции с этим префиксом соблюдать.

По форматированию: варьируется от модели к модели. Те, в которых есть LimaRP датасет, вроде больше любят прямую речь в кавычках, действия плейнтекстом (а может, и италиком, не помню точно). Какие-то другие у анонов показывали лучшую работу, если речь плейн текстом без кавычек, а действия италиком.

С 7000 серией никого не опрокидывают, унифицировали llvm target и компилируют свой hip под всё сразу. Ну с младшими 6000 обосрались, ну хоть компилятор завезли, пердольтесь-компилируйте сами. Хуанг даже такого не позволяет, всё анально огорожено. Если и опрокинут, то всех сразу, но пока что у них ничего новее rdna3 и 7000 серии в любом случае нет. А если сравнивать с курткой, так там практика опрокидывания уж точно не меньше практикуется.

>

И истории успеха с амд есть для ИИ? Просто я одни негодования читаю.

Ну как, с точки зрения прайс-перфоманс позади, хотя было много обещаний. Сейчас с горем пополам и определенными усилиями можно завести то что было доступно но новидии более 1.5 лет назад, и получить на топе перфоманс младше-средних хуангов, ну такое. Что-то посложнее или передовое - все также страдания. Ну вообще такое себе, как можно нахваливать этот кактус, да еще отсутствие нормальных решений и наглое предложение делать их самим преподносить как преимущество (!).

Поидее для ллм наименьшее количество проблем должно быть, т.к. расчеты относительно простые а упор в объем. Какой перфоманс могут сейчас красные топы с 24 гб показать (особенно в контексте анонса дешманской 16гб)? В репе турбодерпа постоянно аншлаг и обсуждения "а сделайте это на рокм и вот это на амудэ", учитывая объем разработки эксллама там должна летать, а что на самом деле?

По поводу вот этого гайдоса https://wikia.schneedc.com/bot-creation/trappu/creation

Не знаю, прочёл ли ты реально сам его, но там вообще не то, что ты показывал постом выше. Суть этого метода в том, что ты пишешь в описание перса примеры диалогов, в которых подчёркиваются важные черты перса. Делается это потому, что таким образом ты убиваешь двух зайцев: обращаешь внимание модели на эти черты и показываешь ей примеры речи персонажа, - и всё это остаётся в контексте навсегда, потому что лежит в дескрипшене. А вот твои первые десять сообщений из контекста рано или поздно улетят. Вторая часть метода, Plist, это список основных черт в явном виде, который настоятельно рекомендуют ставить авторскими заметками ближе к концу чата, к которому внимание сеток больше. Это то, что сейчас шизы из aicg переизобрели для Клода и называют memo. С локалками это может работать не так хорошо, как задумывается, потому что будет разрывать диалог большим текстом не в тему чата. Если использовать по рекомендуемым правилам, то эту шнягу нужно прямо сильно упрощать, тогда может выстрелить.

>save settings

Некоторые настройки не сохраняются вообще. Тот же Truncate the prompt не сохраняется и ставит ебически большое значение после каждого перезапуска угабуги.

>Что делаешь вообще, как тыкаешь?

Брутфорс всех загрузчиков. В итоге снёс угабугу, поставил заново и заработало. Магия, хуй знает.

>не поможет

Вот это хуёво. В целом модель тупая, ещё и туда вкорячена лора на русском, наверное, нужно радоваться, что хоть так общается. Ну и я нихуя не знаю, какие настройки за что отвечают, лол, может, там две крутилки покрутить и будет получше.

поясните, у меня есть 4090, если я еще докуплю 3090(тут за недорого предлагают) я смогу модели крутить на них обоих? Получится как 48 гб сделать?

Да.

Но в треде тестили с пруфами только паскали и а80.

> Truncate the prompt не сохраняется и ставит ебически большое значение после каждого перезапуска угабуги

С llamacpp(hf) и с exllamav2(hf) они сохраняются, вообще дефолтный контекст читает из конфига самой модели исходя из параметров ее тренировки, дело может быть в этом. Алсо возможно не сработает с llamacpp если модель лежит в общей папке а не отдельной.

> Брутфорс всех загрузчиков.

Нужны только 2 по сути. Раз занимаешься - попробуй awq.

> Вот это хуёво

Ничего плохого, нужно лишь выставить rep pen больше единицы, не занижать сильно температуру, ну и нормальный формат промта. Первое - просто ставь simple-1 темплейт в качестве отправной точки, второе - лучше использовать таверну если хочешь чатиться-ролплеить.

Есть еще один случай, который может привести к лупам - модель вообще не понимает что тут можно написать и по ее мнению пора завязывать, а ты не отпускаешь. Если разговор на не родном для нее языке - такой сценарий вполне вероятен, используй перевод.

Сможешь и будет оче быстро.

> Получится как 48 гб сделать

Для запуска - без проблем. Тренить то что требует 48гб - нет. Тренить то что требует 24гб с удвоенной (скорее х1.5 из-за разности мощностей 3090-4090) - да.

> Но в треде тестили с пруфами только паскали

Да ты ахуел

?

Ну йобана, еще в начале лета тесты 4090+3090, сначала в древнем autogptq (~5-7 т/с) а потом в старой версии exllama (до 15т/с, падало до 7 на 8к контексте). В современной и с одинаковыми картами там 15-20 т/с почти без зависимости от размера контекста.

А. Я ещё не игрался с нейросетями.

>4090+3090

>15-20 т/с

Спасибо за инфу.

>Что именно нужно?

Даже через "Continue" не продолжает моё незаконченное сообщение с намёком, что вот дальше должно последовать описание.

Специально вписал хорни момент в повествование, типа: моя ковгёрл тайм тревелша захотела помыться и через некоторое время она вернулась голая, спросить, где полотенце Да я же просто "гениальный" сценарист, знаю-знаю. И вот {{user}}, - кумер-девственник, - "будто загипнотизированный, смотрит на неё и не может найти в себе сил отвернуться" и в этом же сообщении "You are especially charmed\drawn by\interested in (ещё что угодно подобное) her vagina", точку после этого не ставлю, удаляю ответ, нажимаю "Continue", но в продолжении она всегда просто возбуждается моей искренней реакции и флиртует. И никакого описания писечки. ЧЯДНТ?

То на паре 4090, с 3090 будет 15-17 верхним порогом. Больше от размера кванта зависит, младший gptq может и быстрее, если сделать exl2 5бит+ (на новой версии она помещается с контекстом) то медленнее, но всеравно шустро.

34б с большим контекстом в 1.5-2 раза быстрее.

Это все с exllama, с llamacpp по какой-то причине производительность сильно проседает. Возможно на новых версиях починили, или нужно пересобрать с другими параметрами, линк недавно был. Но у нее память неэффективно используется, так что пока не интересно.

Какая модель? Скинь карточку, там это из истории чата идет, или ты хочешь в первых сообщениях получить?

> You are especially charmed\drawn by\interested in (ещё что угодно подобное) her

Попробуй обернуть это в (ooc: ) с инструкцией написать об этом. И не понятно, ты хочешь чтобы модель художественно описала твои чувства типа, или реакцию чара? Первое будет конфликтовать с основным промтом, если там дефолтное про "не пиши за персонажа", если не попросишь.

>чтобы персонаж случайно выполнял обычные действия и при этом выглядел горячо перед {{user}}, но не так, чтобы она делала это специально, а просто в процессе рутинных дел

Это что-то типа "Ой, я уронила вилку\локку\нож! Какая я неуклюжая, User-сенпай!" и описывается, что она наклоняется таким образом, что "Everything, that was before hidden from {{user}}'s side by {{char}}'s skirt, is now clearly visible. {{user}} feels light tingling sensation all over his body"?

Или что оно из такого тебе выдавало, мне аж любопытно стало?

> llamacpp

Есть предположение, что оно не использует аппаратный умножитель матриц И/ИЛИ аппаратную поддержку чисел меньше 16. Это функционал появился на РТХ карточках.

Возможно, префоманс на ней на n-дцать процентов медленнее чем в exllama, особенно при обработке контекста. Но тут дело в другом, пускаешь модель с полной выгрузкой на 1 гпу (выставив cuda visible devices=0/1) - все быстро. Стартуешь ту же модель не ограничивая видимые гпу, когда она делит выгружаемое пополам - замедление в разы. Причем на P40 такого нет, или же дело в шинде а на линуксе все будет ок, надо и такое проверить.

Подскажите какой пресет лучше выбрать. Использую Noromaid-20b-v0.1.1.q4

Пробовал играться с параметром миростат в результате сетка начинает шизить.

Пока что мой фаворит Godlike, но все равно как-то не то

Пробовал играться с параметром миростат в результате сетка начинает шизить.

Пока что мой фаворит Godlike, но все равно как-то не то

>Какая модель?

Noromaid

Я хотел, чтобы это было просто художественное описание, типа от третьего лица, а ля "Her pussy was covered by rough uncultivated bush of pubic hair. That arousing sight had such strong effect on {{user}}, that he couldn't help it but cum all other himself" лол.

>other

over

самофикс

Ну типа это делается просто отыгрышем и свайпами, если хочешь прямо такого - попроси персонажа или сетку. Норомейд 20б более чем способна на подобные описания.

Тебе что, пример нужен, или за ручку проводить тебя? Скидывай свой чат и карточку тогда. открыли филлиал aicg

Ну типа, только она не кокетничает, а просто делает штуки и даже не думает, что возбуждает {{char}}

Спасибо за такое подробное объяснение

Именно в описание, а не в chat examples?

Мне нравится universal-light

Короче. Noromaid-13b-v0.3 пока что лучшее что я щупал для рп. Рекомендую в связке с пресетом Mirostat

Качал отсюда:

https://huggingface.co/NeverSleep/Noromaid-13b-v0.3

Качал отсюда:

https://huggingface.co/NeverSleep/Noromaid-13b-v0.3

Это перевод, или она может на русском?

> что я щупал

Какую самую большую ты щупал?

>Хуанг даже такого не позволяет, всё анально огорожено

Нейронки на картоне Хуанга хотя бы работают из коробки, без пердолинга и ко-ко-конпелирования.

> Это перевод, или она может на русском?

Да, перевод. Бинг на удивление относительно неплохо переводит (как по мне)

> Какую самую большую ты щупал?

Тоже норамейд, но только 20б и в GGUF формате. Мало того что комп пердит так еще и отвечает как-то странно, без души что ли

Просто учитывай, что та часть модели (слои), которая будет лежать в памяти 4090 — будет обрабатываться ее чипом, а та, что на 3090 — ее чипом (и медленнее).

Можно даже потестить, как будет лучше: контекст и немного слоев на 4090, а остальное на 3090, или же контекст и немного слоев на 3090, а остальное на 4090. Навскидку, для малых контекстов (в начале разговора), эффективнее будет 3090 первой видяхой. А при забивании контекста — лучше наоборот.

Но это я так, просто мысли вслух, не парься.

Тебя анально огородили и заставили ими пользоваться! А господам на амудях разрешили свободно ебаться самим, ты что не понимаешь своего горя?!

> там практика опрокидывания уж точно не меньше практикуется

Что? Опровергнутые древние сказки секты свидетелей потанцевала Лизы, или что-то дельное?

Чтобы сравниться с амудэ это даже хз что нужно сделать, фразой фронтир_эдишн можно экзорцизм ее красных фанатиков проводить.

Складно, возможно переводчик сгладил бонды в конце и не триггерит, найс.

мне кажется, я отыскал свой идеал, моделька та же, квантование чуть другое (noromaid-20b-v0.1.1.Q6_K)

как зделать русик?

>Причем на P40 такого нет, или же дело в шинде а на линуксе все будет ок, надо и такое проверить.

Вот кстати да, проверьте кто может. Надеюсь обойтись малой кровью на винде или вообще кобольдом.

Чудо случилось, 4_К_М микстраль работает с нормальной скоростью. Сейчас ещё посмотрим, как работает.

Ботоводам Сап. Вкатился недавно, скачал всё по вашим гайдам. Но вот дела какие:

Модель которую я скачал (из гайда) отвечает мне "привет и тебе" на мой привет примерно минуты 3.

При этом у меня 3060ti, 16гб очень быстрой озу и i510400.

Я что-то делаю не так или это норма на моём конфиге?

Модель которую я скачал (из гайда) отвечает мне "привет и тебе" на мой привет примерно минуты 3.

При этом у меня 3060ti, 16гб очень быстрой озу и i510400.

Я что-то делаю не так или это норма на моём конфиге?

что и как ты запускаешь?

я тебе не ванга

Какая модель, через что ставил? Лама или что то другое. Какие настройки? Гадать по картам не умею.

>16гб

Вангую очередное переполнение озу и чтение с диска. Смотри историю успеха страдальца с 32 выше и качай меньшую модель. И закрывай всё кроме кобольда и браузера (или где ты там генерируешь).

2 чая этому. У меня то при 16b на 32 гигах - 25 стабильно занято. На врам то похуй, там от 3 до 5 гигов. А вот оперативку жрет как не в себя.

Запускаю вот эту модель, на кобольде:

MLewd-ReMM-L2-Chat-20B.q5_K_M.gguf

Сори, но даже такому тупорезу хочется в эту технологию.

ничего кроме модели не пробовал пока выбирать, без сторей, без лоры

Кажется я понял в чём проблема, я скачал 20B модель хотя был уверен что качаю 7.

А вообще, если поставить ещё 16gb, то разительная ли будет разница в производительности?

Судя по скрину, ты ноль слоев (GPU Layers) поместил в видеопамять. На одном проце не уедешь.

Intel ARC A750

Модели 7B в реальном времени работают

CLBLAST

Модели 7B в реальном времени работают

CLBLAST

> нормальной скоростью

1 т/с - это не нормальная. У микстраля по сравнению с 7В скорость в 2-3 раза меньше. Т.е. там десятки т/с должны быть на ГПУ.

>за ручку проводить тебя?

Спасибо, но мне интереснее самому в этом ботостроении разбираться.

сейчас запустил frostwind-10.7b-v1.Q5_K_M

отвечает моментально, но по ощущениям глуповат

а сколько нужно ставить? мне реально неудобно такую тупость спрашивать, но на русском почти нет инфы про локальные нейронки.

>дефолтный контекст читает из конфига самой модели

Вот это неожиданная хуйня, получается, она тренировалась на ебанистическом контексте? В карточке указан рекомендованный 2к, а в конфиге 30к+

>попробуй awq

Да, пробовал. Мне больше понравились трансформеры, одна галочка "грузить в 4 бита" и требует вдвое меньше памяти. А вот 7b awq скушал 12 гигов просто по загрузке. И опять контекст установился ебический, лол.

> simple-1 темплейт в качестве отправной точки

Cтавил, но не похоже, что это сильно влияет.

>использовать таверну

В чем сакральный смысл таверны? Бэкендов нет, карточки персонажей от таверны угабуга понимает. Так-то я установил, но не пользуюсь. Ещё заметил, что инструкт режим полностью игнорирует карточку, а чат-режим бредит чаще.

>используй перевод

Не хотет. У меня идея сделать русскоговорящего полуёбка, возможно, путём вкорячивания нескольких лор в одну модель, хотя тут тоже есть подводные. На английском-то все модели неплохо справляются, я просто не знаю, какую хуйню от них требовать, чтобы понять, есть "душа", есть проблемы. Задаёшь вопросы - оно задаёт ответы.

Убери переводы строки из описания. Они жрут больше токенов, лол.

>модель сходит с ума

Обычно проблема модели, или семплера. Я такое на китайцах видел.

>А вот твои первые десять сообщений из контекста рано или поздно улетят.

Но ведь есть настройка...

>Модели 7B в реальном времени работают

Они и на проце так работают, на мобильных, лол.

>а сколько нужно ставить?

Для фроствинда ставь 200. Кстати, странно, кобольд должен определять и выставлять слои сам.

>одна галочка "грузить в 4 бита"

Чел...

>а сколько нужно ставить?

Нужно подбирать значение под нейронку и объем видеопамяти.

А ведь по теоретическим пиковым флопсам A750 где-то между 3080 ti и 3090. А на обычных шейдерах общего назначения, которые должны задействоваться даже без особых оптимизаций - около 4070/3080. Возможно, когда-нибудь этот потанцевал тоже будет раскрыт.

Хуй знает откуда ты это взял, 750 по флопсам как 3060, и в два раза меньше чем у 3080. Это скорее с амудой надо сравнивать, амуда реально сосёт даже у таких сырых карт.

Что за шиз с ним тут носится постоянно? Это же довольно дерьмовый файнтюн на мелком датасете.

А ты разреженные потести. А ты в int4 потести.

+15 cuda cores

>Именно в описание, а не в chat examples?

Да, там рекомендуется в описание. Вот пикча из того гайда (они с кэтбокса подцепляются, так что отображаются только через впн из России), на которой детально пример показан. Для заметки сейчас, кстати, есть более удобное поле character's note в доп. настройках карточки. Тут же предлагается заметку, которая привязывается в конкретному чату, использовать, что не очень удобно.

>Но ведь есть настройка...

Там речь шла просто о первом десятке сообщений в чате, не примерах. Хотя можно, конечно, их скопипастить в экзамплы и включить сохранение в контексте. Если говорить об описании через примеры, то да, можно и в примеры, а не в описание, и включить галку сохранения, но тогда они будут по умолчанию стоять после ворлд инфо и прочей фигни, да ещё с каким-то промптом типа "это вот примеры", поля с которым, по-моему, вообще нет в инстракте (ну или я не помню, где оно там), а только в промпт менеджере для коммерческих сетей есть.

Если речь про фроствинд, то это лучший варик для нищуков на данный момент. У меня, например, нет железа гонять 13б, даже 10.7б в q5_k_m обрабатывает 4к контекст секунд 70-80 и столько же генерит 300 токенов аутпута (1070 8гб + старый проц и медленная ддр4 оператива, 37 слоёв из сорока с чем-то в видяхе). На колабе могу максимум 20б поднимать в мелких квантах и/или почти без контекста. А фроствинд можно подождать и у себя, и летает даже на кобольд колабе, куда можно и 8к контекста присобачить спокойно. При этом я пробовал им свайпать ответы при прочих равных настройках, сравнивая с разными популярными 13б, и ответы фроствинда были часто суше, но всегда умнее. Вполне допускаю, впрочем, что это целиком заслуга Солара, а не данного файнтьюна

https://blogs.windows.com/windowsdeveloper/2023/11/15/announcing-preview-support-for-llama-2-in-directml/

https://community.intel.com/t5/Blogs/Tech-Innovation/Artificial-Intelligence-AI/Intel-and-Microsoft-Collaborate-to-Optimize-DirectML-for-Intel/post/1542055

Announcing preview support for Llama 2 in DirectML

https://community.intel.com/t5/Blogs/Tech-Innovation/Artificial-Intelligence-AI/Intel-and-Microsoft-Collaborate-to-Optimize-DirectML-for-Intel/post/1542055

Announcing preview support for Llama 2 in DirectML

>Я такое на китайцах видел

Может, нужна была карточка на китайском? Нужно попробовать хуйнуть фулл рашн карточку.

>Чел...

Что? Мне на 7b модель нужно 15 гб vram просто для загрузки. Если ставлю одну галочку - расход падает до 5.7гб. Да, понятно, что это имеет последствия, только нахуй мне эйнштейн? Мне нужен быстрый лоботомит, который будет меня развлекать, не более.

>Мне на 7b модель нужно 15 гб vram просто для загрузки.

Чел... Ты троллишь? Бери exllama квантованную, безо всяких галочек будет норм расход.

Путь к писечке ковгёрл был не прост, но я смог.

Спасибо всем за подсказки и инструкции.

Спасибо всем за подсказки и инструкции.

Суп, котаны. Что сейчас есть годного из больших языковых моделей (70B/120B)?

Что делать, антохи? На 8гб (3070ti) и 32гб ДДР4 уже сил нет сидеть. Терпеть? Или купить второй какую-нибудь на 12 гигов?

Олива - такое же говно как и TRT, где модель компилируется.

> 1 т/с - это не нормальная.

Там 5 т/с генерации. Раньше было 2500мс/т.

> Т.е. там десятки т/с должны быть на ГПУ.

А у меня 6700хт+ггуф, десятки мне только снятся.

> Вот это неожиданная хуйня, получается, она тренировалась на ебанистическом контексте?

Да, некоторые версии yi и других моделей имеют 32-64-100-200-...к что стоит в базовом конфиге вместе с параметрами rope с которыми шла тренировка.

> В карточке указан рекомендованный 2к, а в конфиге 30к+

2к не может быть на современных моделях. Выстави 4к или какой удобно, не обязательно использовать весь в любом случае.

> Мне больше понравились трансформеры, одна галочка "грузить в 4 бита"

Это может привести к радикальному отупению, просто пиздец какому, если это старый метод а не экспресс квантование (что тоже неочень на самом деле).

> В чем сакральный смысл таверны?

Ультимативный фронт. Помимо удобного интерфейса с кучей фишек, в ней легко настраивается инстракт режим с нужным форматом промта, который обеспечит должный перфоманс.

> инструкт режим полностью игнорирует карточку

Не может такого быть, что-то неверно выбрано значит.

> идея сделать русскоговорящего полуёбка

Ради интереса, можешь попробовать на коллабе лору на язык натренить, но крутого результата сразу не жди.

Неудивительно что амудэ заглатывает в нейронках.

Оу щи, а зачем так сложно? Хотя не так давно встретил карточку и подобным форматом, которая заводилась со скрипом, впервые за долгое время, возможно такие танцы с бубном бы улучшили. Но лучше просто нормально карточку сделать.

Все те же, синтия 1.5, дольфин, айроборос, козел, можешь попробовать замес euryale, xwin хоть старый неплох. По 120 пара файнтюнов была, tess-xl попробуй.

p40, или

> второй какую-нибудь на 12 гигов

но не какой-нибудь а новидео

Короче, поугарал я вчера.

На 3200 в двухканале Mistral 0.2 Q6_K выдает 4 токена сек.

На некрозеоне в двухканале 1866 (ваще-та DDR4!) выдает 3 токена сек.

И вот оно! RX6600M, все слои на карту, проц и озу ваще не задействованы! 5 токенов сек.

ахахахаха

сука

пздц

Видяха уровня 2060 супер или 3050~3060.

Выдает чуть больше проца.

Какой кринж, просто, я хуй знает.

Где там рыцари амд и свободы.

Рассказывайте, что мне надо поставить, сбилдить, как запустить, чтобы получить честные хотя бы 20 токенов сек, как выдает P104-100 за 3,5 килорубля с авито.

На 3200 в двухканале Mistral 0.2 Q6_K выдает 4 токена сек.

На некрозеоне в двухканале 1866 (ваще-та DDR4!) выдает 3 токена сек.

И вот оно! RX6600M, все слои на карту, проц и озу ваще не задействованы! 5 токенов сек.

ахахахаха

сука

пздц

Видяха уровня 2060 супер или 3050~3060.

Выдает чуть больше проца.

Какой кринж, просто, я хуй знает.

Где там рыцари амд и свободы.

Рассказывайте, что мне надо поставить, сбилдить, как запустить, чтобы получить честные хотя бы 20 токенов сек, как выдает P104-100 за 3,5 килорубля с авито.

> Рассказывайте, что мне надо поставить, сбилдить, как запустить, чтобы получить честные хотя бы 20 токенов сек, как выдает P104-100 за 3,5 килорубля с авито.

Всего-то накатить линукс и написать свой драйвер для рокм.

>а зачем так сложно?

Как я понял, идея в том, чтобы одновременно показать сетке, как персонаж говорит и как в его речи и реакции проявляются его внешка, персоналия и прочее. А в конце чата напомнить нейронке про то, какие ключевые особенности и характеристики перса. Таким образом сетка как бы дважды цепляется за описание и видит примеры, что его нужно использовать. В теории звучит разумно, но на практике задавать такое описание действительно сложно. Поэтому и карточек с этим форматом особо не найдёшь, и, соответственно, оценить, действительно ли он лучше, нельзя. Если только самому карточку не переписывать, а это тоже будет гемор, потому что нужно нетривиальные реплики для персонажа придумывать.

Ну да, мелочи, свои драйвера.

Спасибо АМД за свободу это сделать!

Держи честные 20, которые выдаёт вега. Хуй знает, за сколько она с авито, б/у я бы такую горячую хуйню не взял, но новая была как раз конкурентом 1070 ti.

>что мне надо поставить, сбилдить, как запустить

Любую видеокарту с этого скриншота

Либо накатить linux, там поддерживаемых моделей побольше. Билдить с флагом LLAMA_HIPBLAS=1, запускать с флагом --usecublas.

Недавно вышли 34b МОЕ. Делайте ставки когда уже кто-нибудь запилит 70x2-4-8.

Заебали уже этими мое, чесслово. Они же просто уже существующих шизов миксуют, а не экспертов, какой тогда смысл вообще?

Во, это уже интересно!

Затраю, как будет свободное время.

Модно.

Люблю галочки, хули.

>не обязательно использовать весь в любом случае

Когда стоят ебические цифры - у меня расход памяти улетает в космос буквально с первых генераций.

>Не может такого быть, что-то неверно выбрано значит.

Хуй знает. Потыкал wizard-vicuna 13b GPTQ, намного лучше, чем мистраль 7b, но 10 гигов vram со старта. Точно так же полностью игнорирует карточки в инструкт режиме.

>но крутого результата сразу не жди

Хуй знает, потыкал сайгу, прямо пиздец косноязычная. А там въёбано на тренировку немало денег.

Включил перевод страницы в браузере, печатаешь на английском, отвечает "на русском", вроде, покатит, хотя хотелось бы отвечать тоже на русском. А любые прослойки для автоперевода это плюс задержки.

С просветлением. Но можно воздать молитвы богам чтобы амудэ стало на путь истинный и дало нам крутые видюхи с много врам под ии дабы дропнуть цены на хуанга

А, в глаза долблюсь, там вместо карточки примеры диалога в которых идет описание а сама карточка в авторских заметках. Хз честно говоря, но раз работает то и ладно, как на выгруженном контексте будет стыковаться с историей и суммарайзом вопрос. Еще один фейл - описание одежды на глубине 4, не успеешь ее раздеть перед походом на горячие источники, конечно, а не то что вы там подумали! как она опять снимает свои боевые ботинки.

Можно линк на карточку? Выглядит интересно.

> Когда стоят ебические цифры

Так не ставь их, указывай 4096 и довольно purrs. Особенно в llamacpp нельзя.

> wizard-vicuna 13b GPTQ, намного лучше, чем мистраль 7b

Она довольно древняя и мэх, но это неплохо иллюстрирует оверхайпнутость мистраля, лол.

> Точно так же полностью игнорирует карточки в инструкт режиме.

Как это проявляется покажи.

> потыкал сайгу, прямо пиздец косноязычная

Она ужасна, может новые версии не столь позорны, но старые это пиздец.

> А там въёбано на тренировку немало денег.

Рили? Скорее автор пытается разжаловать на донаты, если бы хоть что-то дельное сделал а не кринжатину.

Перевод нужно настраивать в таверне, недавно писали как это сделать.

А что вообще можно получить от пары p40 для модели 70B, хотя бы K2? Потому что днищенская RTX3050 8Гб даёт больше токена в секунду, и это при оперативке DDR4. 4060Ti с оперативкой DDR5 должна минимум 2 токена давать. Если собирать под две-три P40 отдельный комп, то как ни ужимайся, а деньги как минимум те же. Вопрос к тем, кто успел купить 2 P40 (ну или может в треде уже были тесты): сколько токенов в секунду такая модель на этой связке даёт?

Фроствинд соя пиздец, если у карточки не прописано поведения, то он по дефолту будет всех делать политкорректными. Меня карточка даже за плечо без моего разрешения не хотела брать, а заставить некоторых сделать хоть что-то интимное потребовало титанических усилий или переписывание текста персонажа. Мистраль хоть и шизойднее, но сои меньше.

>Можно линк на карточку? Выглядит интересно.

Это же картинка из гайда выше была, самой карточки у меня под рукой нет. Но поискал немножко, и вроде вот в этом рентри она есть, как и другие карточки по этому методу сделанные.

https://rentry.org/TrappusRentry

Гайс, колб угабуги больше не генерит публичную ссылку trycloudflare, а генерит gradio.live к которой не конектится таверна, у вас так же или я что-то сломал?

появилась OpenCAI13b

https://huggingface.co/TheBloke/OpenCAI-13B-GGUF/tree/main?not-for-all-audiences=true

Датасет очень интересен, но в сочетании с тупой 13b это хуета. Вот если бы Солар совместить с этим датасетом....

И че как?

Я заходил в этот тред месяца 3 назад, тогда не было нормальной локальной модели для куминга (в идеале что бы писал порно рассказы), ничего не появилось нормального за это время???

> для куминга

Были и пол года назад. Таких полно, но у всех требования к скиллу. Хотя так-то покумить на гопоте не зная тему тоже непросто.

Есть для таверны расширение, чтобы было больше отдельных панелей при создании бота, чтобы не сваливать всё в Description?

ну все собрался было тренить модель, датасет выбрал, модельку тоже, думал сделаю русскую модель для ролиплея, я знаю что попытки были, но мне кажется я могу бы сделать лучше. И что у нас на кагле часовые очереди на TPU, какой то косяк требующий перезапуск ядра, жди еще час. Коллаб с какими то старыми либами некоторые рецепты не работают, и то там говорят ограничения больше.

А вообще есть у кого инфа сколько на колабе часов можно тпу занимать? В день или месяц. Что дает подписка в этом плане?

А вообще есть у кого инфа сколько на колабе часов можно тпу занимать? В день или месяц. Что дает подписка в этом плане?

Сап, аноны, спрашиваю как полный ньюфаг, есть ноут с 4060 8гб и 16гб оперативки, но под амуде-процем 7840hs.

Есть ли смысл вкатываться к вам и курить мануалы из шапки или с подобным конфигом и/или ноутбуком это глупое занятие?

Есть ли смысл вкатываться к вам и курить мануалы из шапки или с подобным конфигом и/или ноутбуком это глупое занятие?

Норм, можешь очень быстро крутить любые 7b на видеокарте или что то крупнее, но уже медленнее. Поиграйся и поймешь надо тебе это или нет.

> С просветлением

Да не, так-то у меня 4070 ti и всякая мелочь, просто комп попал с рыксой в руки, я и попробовал. Смешно, неюзабельно в дефолтном виде.

> Хуй знает, потыкал сайгу, прямо пиздец косноязычная.

Mistral 0.2 будет не хуже на русском, кмк.

На проц похуй. Есть AVX2 и ладно.

У тя, кстати, проц неплохой.

Надеюсь, ты брал свой ноут не дороже 70к с такой видяхой.

Ну и, да, вкатиться можно, но памяти лучше добавить до 32 хотя бы, если не 64.

> под амуде-процем

Нынче в этом нет ничего плохого как и хорошего

Все то же самое, проблемой может быть 16гб рам, это даже для просто пользования пека сегодня мало. Считай себя обычным полноценным как бы это рофлово не звучало восьмигиговым и пробуй 7б на видюхе и 11б-13б с выгрузкой на проц. Больше рам не позволит, если докупишь то можешь попробовать 20б.

> Mistral 0.2

Уже анонсировали? Какой там размер?

Я погонял совсем чутка, но встретил те же проблемы, с которыми столкнулся с предыдущей моделью, попыткой автора сделать erp солар, Sensualize: кум описывается охотнее, чем на фроствинде, но модель ощущается тупее. Когда забыл поменять инстракт с чатмл на альпаку, сгенерилась какая-то лютая шиза (первый пик), где тянка писала сначала, что давай отложим сегс, нужно пойти пообедать, а потом сразу что к чёрту обед, я хочу тебя внутри себя. Фроствинд себе такого не позволял. Есть ощущение, что требует меньшей температуры и штрафа за повтор. Когда снизил их и поставил альпачный формат, ответы стали пологичнее, но всё равно такие себе. И сильно не любит курсив, похоже.

Дальше для сравнения три скрина с обычной sfw сценкой с фроствиндом, Synatra-MCS-7b и Fimbulvetr. Видно, как последний всирает форматирование и херово описывает окружение. А вот мерж синатры внезапно реально неплох.

Выводы по одному чату или заседал с ними сравнивал? Забавно насколько похожи ответы в разных моделях, какая из подобных в итоге больше понравилась, замес синатры?

> her paw

Это базированный баг или фича карточки?

Как написал, чуть-чуть потестил, глубоко не копал. По паре свайпов в трёх-четырёх чатах с разными персами сделал. Где-то отвечает оково. Вполне возможно, что не подобрал нормальные настройки. Про лапу всё правильно, это же антропоморфная собака.

>Забавно насколько похожи ответы в разных моделях

Да, давно заметил тоже. Иногда ради интереса свайпаю разными моделями. Бывает, даже одной с колаба, одной с компа. И структура ответов прямо один в один очень часто.

>замес синатры

Неплохо пишет и вроде поумнее, чем синатра, но всё ещё 7б. Пока не так много её гонял, чтобы прямо порекомендовать. Ну и там в датасете синатры чаты из какого-то корейского чат-бота что ли, так что гпт соевая лексика или нечто подобное периодически ощущается. Вот на пике собака на этой модели. Ну, правда, ещё EoS токен забанен, мб поэтому вылезла эта шняга про комфорт в конце.

В смысел уже.

Она вышла вместе с Mixtral.

The Mistral-7B-Instruct-v0.2 Large Language Model (LLM) is an improved instruct fine-tuned version of Mistral-7B-Instruct-v0.1.

Делай как у меня

Аноны, что скажите о mythalion-13b? Как она в плане рп? Стоит пробовать?

Ибо у меня интернет калл и не могу качать все подряд

Ибо у меня интернет калл и не могу качать все подряд

>13b?

>рп

Ты же сам знаешь, что нормальный рп начинается с 34b. Но можешь скачать аметиста.

Плохо это, показывает насколько ограничена база датасетов и как мало чего-то уникального не смотря на огромное количество моделей.

> Про лапу всё правильно

Точно, если присмотреться то видно.

Синтетикой отдает, но в целом вполне, особенно учитывая размер модели. Надо потестить промт чтобы обуздать всякие

> heart races

> mind is swimming

и подобное, оно вообще много где встречается, но на некоторых карточках с характерным стилем не лезет. А также устранить микролуп в виде начала каждого предложения с she/her, но возможно здесь уже суть 7б лезет.

> шняга про комфорт в конце

Зажрались просто требовать идеала от мелочи, особенно с ban eos, удалить и дальше довольно purrs.

А, эта, доступные апи есть?

Противоречивые отзывы, кто-то хватит, при тестировании показалось херью. Она же еще старая, не стоит.

Зажрался все так

Прямо сейчас раздаётся кучей воркеров на орде с 4к контекста. Можешь ввести ключ из нулей в таверне да заценить. Я уже очень давно пробовал и мне понравилась меньше мифомакса, а с тех пор уже навыходило много разных безумных 13б мержей получше.

Спасибо! Лечу читать шапку.

Почему у вас так сложнаа!

Я в ваш тред не часто захожу. Обычно сижу в тредах с картинками. Не пойму про что вы говорите. Пару месяцев назад поставил capybara-tess-yi-34b-200k.Q4_0.gguf. Вроде нормальная модель. Зашел сегодня, ни черта не понятно. Что я могу запустить на своей 4090?! Эту капибару я взял из рандомного поста здесь. Её можно на помойку отнести или за два месяца ничего не поменялось?

Похоже что надо неделю ваши треды перечитывать, что бы понять что тут вообще происходит.

Я в ваш тред не часто захожу. Обычно сижу в тредах с картинками. Не пойму про что вы говорите. Пару месяцев назад поставил capybara-tess-yi-34b-200k.Q4_0.gguf. Вроде нормальная модель. Зашел сегодня, ни черта не понятно. Что я могу запустить на своей 4090?! Эту капибару я взял из рандомного поста здесь. Её можно на помойку отнести или за два месяца ничего не поменялось?

Похоже что надо неделю ваши треды перечитывать, что бы понять что тут вообще происходит.

Там автор в рекомендациях запуска советовал только мин-п использовать и альпака режим, так что может быть настройки отбора так повлияли.

>Почему у вас так сложнаа!

Потому что ии это сложна

>Не пойму про что вы говорите.

Тут уже куча локального бадумс сленга

>capybara-tess-yi-34b-200k.Q4_0.gguf.

Ниплоха вроде, может что и лучше есть

>Что я могу запустить на своей 4090?!

А что хочешь?

Если нужны мозги то ищи большие модели до 34b, у тебя запустится. Если нужен кум или расцензуреная версия то уже другие.

У тебя 24гб видеопамяти, это значит что ты сможешь запустить в любом формате любую модель, которая занимает не больше 20гб своими файлами. Если запускаешь меньше 34b можешь брать версию модели с большим квантом, которая весит больше других. В идеале 8q, 16 уже перебор для простого анона.

Соотвественно если модель не влезает то бери версию до 20 гб, но меньше 3 квантов не рекомендую, это уже слишком отупляет модель, может быть только 70b так крутить и выйдет.

Если еще и на оперативку часть выгружать то и 70b сможешь запустить, но это нужно от 64 гб оперативки, и желательно быстрой ддр4 или хоть какой 2 канальной ддр5. Это уже только ггуф формат, и до 2-4 токенов в секунду, но да, почему нет.

> Что я могу запустить на своей 4090?!

Самое главное говно Жоры не трогай. Только GPTQ или EXL2. А выбор из моделей не большой - либо 34В, либо что-то из Микстралей. Остальное слишком устаревшее и тупое.

> на своей 4090

Можешь скачать gptq версию той же

> capybara-tess-yi-34b-200k

и гонять с большей скоростью и большим контексте полностью на видеокарте.

Не то чтобы на помойку, новые файнтюны 34б могут быть лучше, но не радикально. Если устраивает - используй, радикально прорывного в этой области не было.

Можешь попробовать из недавно вышедших

Nous Hermes 2 Yi 34B

Yi 34B v3

Nous-Hermes-2-SUS-Chat-34B-Slerp

Tess-34B-v1.4

dolphin-2.2-yi-34b-200k

и другие. Ну и 20б попробуй, они не настолько умные но могут писать гораздо более складно и менее шизоидные чем все, основанное на yi34b. Можешь попробовать 70b с выгрузкой на процессор, но это сомнительное удовольствие из-за скорости в пару т/с, не стоит того.

> что тут вообще происходит

Есть движение в области мелких прежде всего, ну и всякие мелочи. В остальном глобально - застой.

Интересную хакерскую модель специалиста нашел, не проверял, так как я в этом деле тупой. Но выглядит как прототип системы автовзлома или что то похожее на ии оружие

https://huggingface.co/neurolattice/WhiteRabbitNeo-13B-v1

Есть и жирнее на 33b

Орудие будущего хули, вредоносные ии взломщики прям.

Конечно сейчас это просто хуйня справочник, которая и напиздеть может в чем то важном, но идея конечно интересная

https://huggingface.co/neurolattice/WhiteRabbitNeo-13B-v1

Есть и жирнее на 33b

Орудие будущего хули, вредоносные ии взломщики прям.

Конечно сейчас это просто хуйня справочник, которая и напиздеть может в чем то важном, но идея конечно интересная

Ок, спасибо за ответы. Теперь уже в следующие выходные вернусь к этому. Типы моделей это кстати было для меня самое загадочное. Запомню GPTQ и EXL2.

И что такое "говно Жоры"?

>Потому что ии это сложна

Но я же не лезу в теорию. Всего лишь конечным продуктом пользуюсь.

Всё ещё пользы меньше чем от гугла.

Гугл запомнит что ты спрашиваешь или о чем пишешь, сетка нет

Если ты конечно не включишь сверхразума и не будешь пользоваться гугловским/онлайн переводом на сетке, лел

> или что то похожее на ии оружие

Что-то орнул в голос, представив оружие, которое лупится на plap plap plap get hacked

Она хоть больше кодлламы знает? Как реагирует если попросить взломать жопу?

На вики инфа про это есть.

> Всего лишь конечным продуктом пользуюсь.

Оно в такой фазе сейчас что даже просто использование подразумевает некоторый уровень.

И что? Боишься что к тебе ФБР заявится в квартиру за то что ты погуглил как взломать вайфай?

>Но я же не лезу в теорию. Всего лишь конечным продуктом пользуюсь.

В теории там вобще отвал жопы, даже просто запустить модель и настроить на уже готовых инструментах тот еще уровень "специалиста" нужен, хоть документы получай.

Есть и проще варианты, качни lm studio, там почти все настроено за тебя, веры особой этому инструменту нет, но начинающим норм

>Она хоть больше кодлламы знает? Как реагирует если попросить взломать жопу?

Хуй знает, вроде как для взлома/антивзлома и работой с специализированными программами для белых хакеров

Оценить че она выдает мне не хватит знаний, поэтому даже не проверял

> А, эта, доступные апи есть?

Не шарю за коллабы, локально гоняю.

7B же, помещается в 8 гигов даже.

> ограничена база датасетов

Кстати, да.

Капибара-тесс хороша.

Но там вышла exl2, вроде как, она может быть побыстрее с тем же качеством, если подберешь нужную.

Но точнее тебе уже насоветовали, наверное. =)

Во, первый ответ хорош.

70b можно впихнуть тебе в видяху, но там квантование будет мелким, и, мне кажется, yi-34b модели будут не сильно хуже при таком размере.

Микстраль бы я не советовал, скорости не сильно увеличатся, а сжатие будет большим.

Третий ответ тоже правильный.

GPTQ или Exl2, думаю лучше Exl2, говно Жоры — это GGUF, Георгия Герганова.

Смотри от 4bpw до 5bpw (можешь промежуточный взять квант), та же Capybara лежит, NousHermes много.

Совсем запутал, та же от обычного мистраля тольком не отличается, надежды были на их закрытую модель что и другой размер имеет.

> вышла exl2

Оно локально квантуется без регистрации и смс под желаемые параметры. 70б даже в 24+12 что влезает хейтили, в 24 будет 2.5 бита и нежизнеспособная, нужны новые техники квантования/ужатия.

> GPTQ или Exl2

На самом деле там не столь высокая разница, gptq 32g это примерно 4.65 эффективных бит и вполне хорош. Если гнаться за перфомансом то лучше делать exl2 самостоятельно (и шаманить датасет), дабы не низвергнуть весь микропрофит ошибками квантователя.

> На самом деле там не столь высокая разница, gptq 32g это примерно 4.65 эффективных бит

Нет. EXL2 жмётся лучше. 3.7bpw равны жоровским Q4 по PPL. GPTQ всегда будет похуже при одинаковом размере.

>Так не ставь их, указывай 4096 и довольно purrs.

Довольно часто оно само выставляется на 32к и нужно заходить в настройки и переключать.

>довольно древняя и мэх

Не исключаю, что просто неправильно готовил мистраль или не оценил профиты.

>Как это проявляется

Да это, походу, ожидаемое поведение в угабуге.

Перевод это примитивная хуйня, хули там настраивать. Сама идея гонять перевод не нравится.

>Рили?

Да, он там на хабре рассказывал что-то про деньги, но я точно не запомнил. Датасет в любом случае денег стоит.

>Mistral 0.2 будет не хуже на русском, кмк.

Возможно. Но на русском оно всё сваливается в шизогенератор, хуй знает, с чем связано. И у сайги в датасете явно есть машинный перевод, хотя заявлены плюс-минус нормальные данные. Пару раз вообще свалилась в транслит, часто зацикливается, не понравилось, короче. Что-то явно пошло не так.

Очень крутой у вас тред. Очень много уже подсказали, без вас я бы не вкатился, вы няши :3

Выбараю сейчас оптимальную модель. Подскажите, на что влияет размер ГУФА? Если у меня 12гб GPU, то гуф 14гб у меня не запустится, так? Мне отбивает что-то про CUDA out of memory в консоли.

В чем вообще разительная разница одной и той же модели, с разным размером гуфа? Насколько она критично тупеет?

И ещё, в кобольде есть настройка которая меняет количество токенов на ответ. Я крутил-вертел её, ставил и 100 и 500, но разницы не ощутил. Показалось что с 500 отвечать медленней стала. На что она влияет?

страждущий гуманитарий, пытающийся создать чатик со своей вайфу ГГ из киберпанка

Выбараю сейчас оптимальную модель. Подскажите, на что влияет размер ГУФА? Если у меня 12гб GPU, то гуф 14гб у меня не запустится, так? Мне отбивает что-то про CUDA out of memory в консоли.

В чем вообще разительная разница одной и той же модели, с разным размером гуфа? Насколько она критично тупеет?

И ещё, в кобольде есть настройка которая меняет количество токенов на ответ. Я крутил-вертел её, ставил и 100 и 500, но разницы не ощутил. Показалось что с 500 отвечать медленней стала. На что она влияет?

страждущий гуманитарий, пытающийся создать чатик со своей вайфу ГГ из киберпанка

Кванты жоры неэффективны это и так понятно. Q4 тоже разные, K_M - более 4.8 бит не смотря на название.

Но между gptq и exl2 разница не столь велика, плюс perplexity будет зависеть еще от того на каком датасете оценивать, если тот что был для замеров и тот на каком оценивать ppl будут одинаковые то и выйдет максимальная эффективность. Там довольно мутная тема на самом деле, по-хорошему стоит замешать викитекст с небольшой долей ерп датасетов для типикал задач местных, но там разница как от совсем долей бит и неизмеримо будет.

> Датасет в любом случае денег стоит.

За тот доплачивать надо, лол. Он открыт, можно посмотреть.

Выгружай на видеокарту меньше слоев, остальные будут обсчитываться профессором, ггуф позволяет делить.

> количество токенов на ответ

Это верхний лимит после которого просто остановится на полуслове, если дойдет. Влияет на выделяемый контекст под ответ (считай если ставишь 500 то при максимальном 4к будешь иметь чуть больше 3.5к на прошлый чат, а остальное - буфер для ответа).

>Он открыт, можно посмотреть

Сейчас же и полезу, нужно посмотреть формат.

Олсо, я правильно понимаю, что информация на русском и информация на английском - это разные области знания сетки и они, по факту, не пересекаются?

>Олсо, я правильно понимаю, что информация на русском и информация на английском - это разные области знания сетки и они, по факту, не пересекаются?

Не совсем, там внутри у ней неонка она имеет какие то общие представления об объектах, поэтому зная относительно мало слов на русском может говорить на нем на темы которые есть на английском, хоть и хуево

ага только gguf стабилен на всех датасетах, а все эти exl2 gptq только на избранных. То что он потеряет доли бита предположение, по сути там как раз очень жестко режется все за пределами типовых задач.

> информация на английском - это разные области знания сетки и они, по факту, не пересекаются

Нет (да). Спроси мл инженеров, мы тут на всякий треш кумим и фитишами упарываемся, а ты такие вопросы задаешь.

Если базовая модель сетки хороша и провести обучение правильно (включая все этапы, параметры, датасет) то это будет единым целым. Даже по дефолту при обучении всякой херни только на инглише можно спросить сетку про обученное и она ответит, правда более криво.

> gguf стабилен

Чет обмеился с этого сочетания

> только на избранных

На каких избранных?

> gptq

Его не в тему приплел

> предположение

Суждение основанное на фактах, и ты, похоже, не понял о чем речь шла в том предложении.

> там как раз очень жестко режется все за пределами типовых задач

Сильное заявление

заработало?

Я не он. Просто для статистики скинул.

Аноны, помогите, хочу вкатится в селфхост, но на любую модель которую я скачиваю koboldcpp выдает "uknown model, can not load"

Как фиксить?

Как фиксить?

>может говорить на нем на темы которые есть на английском

Получается, есть какой-то встроенный перевод и концепция разных языков должна быть зашита довольно глубоко. Токены русских и английских слов гарантированно разные и сетка не должна понимать, что tree и дерево - одно и то же.

>а ты такие вопросы задаешь.

Так это важно. Я читал, что во многих датасетах есть только русская википедия, т.е нейронка ограничена только этим. Если русская и английская части не пересекаются, то очевидно, что единственный вариант прикрутить русский - это перевод. Или обучение с нуля, с чем могут быть проблемы.

Чего в википедии точно нет?

> есть только русская википедия

Все так, и в таком случае у модели сразу вырабатывается связь - если русский язык, то должен быть сухой стиль и рассказывать о чем-то. Сети улавливают прежде всего закономерности а не какой-то смысл, если все сильно упрощать. Языковой датасет может быть относительно небольшим чтобы выполнить локализацию модели, но он обязан быть сбалансированным и иметь пересечения с тем что уже модель знает, про это уже давно писали.

>Получается, есть какой-то встроенный перевод

Нет, просто ассоциативные связи, возникающие в момент обучения. Представленные в виде собственно нейросети

Я поискал в интернете и понял что я почему то скачиваю файлы в меньшем размере чем они должны быть, можно ли как то скачать файл полностью? Или я затупок полный и не там копаю?

какой формат качаешь то?

gguf

Кобальд последний? Попробуй скачать каким нибудь другим загрузчиком, например

Кобольд последний, сегодня ставил. Другим загрузчиком это как? Я просто напрямую качал с сайта жмякнув на кнопку скачивания рядом с выбранной моделью.

Я вот этим качаю Motrix, хоть и приходиться имя файла прописывать, сам он при сохранении ерунду вместо имени пишет

Браузеру не доверяю чет

У блока качаешь хоть?

Да, у него. Ща попробую этот ваш Motrix поставить и через него скачать, если будет какой-то результат то отпишу

Ошибок при скачивании нет случаем? gguf можно просто браузером качать, с обниморды при скорости до 500 мбит делать параллельную закачку нет смысла.

Можешь hfhub поставить и по инструкции качать.

> Другим загрузчиком это как?

Наверно имелось ввиду через llamacpp (в составе убабуги или отдельно), врядли это поможет если скачанный файл битый.

Ни разу не выдавало. Это вообще нормально что на обниморде указано что файл весит 7.9 гб, а размер файла во время скачивания становится 7.3?

7,16 ГБ (7695875136 байт)

7b в 8q например

Потестил Визардкодер, в целом заебись, на крестах код почти рабочий, после пары пинков он сам его фиксит, но шизит иногда странными формулировками типа пик1. Знает нормальные языки, а не только питон, даже в раст может. На питоне генерит с первого раза рабочий код, может нормально пояснить за него. Проиграл с рекурсии, как я попросил его сгенерить код для генерации текста, а он в коде в промпте просит тоже самое у другой нейронки, кста, правильную ссылку на модель лламы не смог мне назвать, зато на GPT-Neo верная и код рабочий.

По скорости на 4090 заебись - 40 т/с, больше 3-5 секунд не приходится ждать.

По скорости на 4090 заебись - 40 т/с, больше 3-5 секунд не приходится ждать.

> Совсем запутал

Да как запутал-то? :) Я сказал, что вышла новая 0.2 версия обычной Мистрали — и так оно и есть. Ты просто додумал что-то за меня, сам себя запутал, много хотел.

Все мы много хотим, но… ¯\_(ツ)_/¯ Шо поробишь, не все как хочется.

ИМХО, Мистраль и так хорошо выкладывает и обновляет модели.

> На самом деле там не столь высокая разница

Ну, я про то, что их лучше, чем GGUF использовать, разница велика.

А уж между ними да, на вкус и цвет подбирать. Ну или даже делать, эт верно.

Но если человек редко заходит и не хочет разбираться — ему проще выбрать из имеющихся на обниморде.

> Довольно часто оно само выставляется на 32к

А кнопка Save не сохраняет настройки модели?

> 3.5к на прошлый чат

3.5к на:

инструкции

карточку персонажа

всякие допки типа авторс нот

…и прошлый чат =)

> информация на русском и информация на английском - это разные области знания сетки

Насколько я знаю (пусть меня поправят) — да (да). Совсем да.

Другое дело, что статистически токены аналогичных слов в разных языках близки (т.е., сетка знает, что sun и солнце — это что-то плюс-минус одно), и она на основании этого, при разговоре на русском будет статистически подтягивать нужные слова.

Но по сути — это большой рандом, она может в какой-то момент не связать то, что ты от нее хочешь со знаниями на другом языке и уйти в придумывания.

Но тут я могу ошибаться, повторюсь.

Ух ты, видяшка за 3,5 килорубля на авито!

Ну ладно, чуть лучше, канеш.

> Токены русских и английских слов гарантированно разные

Да.

Я подозреваю, что у всех сеток в датасетах есть переводы (в смысле — тексты словарей-переводчиков), и она просто понимает, что этот токен и этот токен — очень похожи, и если юзер хочет токены из этой области — она дает именно их. Но когда не находит «синонима» (перевода) — вываливает как есть. Это заметно на маленьких сетках, когда внезапно пишется английское слово посреди русского текста. Просто рандом не сработал, или перевода не знала.

Ну или вот идея с википедией, да. Плюс-минус текст и там, и там один, вот тебе и слова похожие.

> ассоциативные связи, возникающие в момент обучения

Именно.

А это новая версия какая-то?

Пробовал Мистраль и КодЛламу?

А файнтьюны кодлламы на языки?

Просто я визардкодер помню более чем полгода уже.

deepseek-coder

вот эта сетка говорят норм

> А это новая версия какая-то?

v1.1, самая свежая, неделю назад релизнулась.

> Пробовал Мистраль и КодЛламу?

Не вижу смысла, потому что пикрилейтед рейтинг моделей для кодогенерации. Лучше визарда только жпт-4, лол.

> но шизит иногда странными формулировками типа пик1

Семплинг обуздай, снижай температуру, выше 0.5 не стоит вообще, снижай rep pen, более 1.05 не стоит.

> правильную ссылку

Оно может разве что имя с обниморды назвать, но то все старые модели.

> Ты просто додумал что-то за меня, сам себя запутал

Не, запутал шо пиздец, какой там еще русский в той модели, он инвалидный и ужасно кривой. Но поверил и потому сразу решил что ты про ту модель, что они называли дохуя перспективной и не выкладывали.

> А уж между ними да, на вкус и цвет подбирать

Именно про это. Проще самый жирный gptq скачать и получить гарантированный результат, тем более его битность как раз соответствует тому что поместится с нормальным контекстом в 24гб для 34б модели. А с exl2 уже потом разбираться если очень руки чешутся. Это для случаев когда поместится 6бит, например, актуально уже.

> Мистраль

В кодинге? Гниль же, как и микстраль. А на кодлламу есть файнтюны визардкодера как раз и они обновляются иногда.

> помню более чем полгода уже

То наверно старая версия на дичи типа 15б, нет?

> v1.1, самая свежая, неделю назад релизнулась.

Ого, пора бежать качать. Прошлый нравился, а здесь еще и свежие знания явно присутствуют.

Вечер в хату, я новенький, потыкал говносайты типа spicychat потом решил попробовать локальные модели.

Я правильно понимаю, что они все (из релевантных) основаны на вариантах лламы-2 оттрейнить которые с нуля стоит миллионы баксов? При этом она релизнута с некоей цензурой которую снимают костылями в виде файн-тюнинга?

Ну предположим, что это норм. А нет ли моделек, которые натрейнены на фантастической литературе, сюжетах аниме и пр., или это пизда в плане копирайта?