>на сегодня у линукса проблем считай нет. Он удобный, стабильный и имеет весь нужный функционал, в том числе и большую часть игорей.

В рот тебя ебал, красноглазик сраный. Итвоих друзей - красноглазых гайдописателей ебал. И черезжопные зависимости всего программного обеспечения ебал. И косяки в новых версиях всякого ПО, просто не дающего его запустить, и фиксящиеся месяцами - ебал вдвойне.

-мимо завёл вебуй на АМД на Убунте.

Хуя пичет.

Кекнул с глупого ребенка.

Ух, как смачно уверенный пользователь ПК бахнул, сказка

А ух эти ебучие VENV, когда один пакет устанавливается десятки, сотни раз! Ненавижу. Всё кривое. Мечтаю, чтобы нейросети всё переписали нахуй.

В пипе кэш есть если чо да?

а куда промты сувать?

Запустил Ламу в 4 битном режиме в text-diffusion-webui на винде без wsl на некро 3060 ti с 8 гб видеопамяти.

Скажу сразу - это такая ебала, что даже не пытайтесь, я два дня ебался.

Скажу сразу - это такая ебала, что даже не пытайтесь, я два дня ебался.

>-мимо завёл вебуй на АМД на Убунте.

>на Убунте.

Слабак.

Кеш это ещё одна копия, лол.

Кидай промты с историей.

>Кидай промты с историей.

Какие промпты? Я просто лольку подключил из карточек tavernAI и начал говорить с ней.

Всё чел, завязывай с лоликоном на борде.

Удалось наконец после тяжких испытаний запустить сетку, но она не видит карточку, запускается на проце и генерирует ответ 2 минуты.

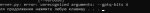

Консоль пишет, что torch.cuda.isavailable returned (false) - пикрил.

Идя по гайду, я пропустил этап №2, т.к. он подразумевает либо Линукс, либо WSL, либо Mac. Ни одного \слова про виндовс! Попробовал первый вариант - что-то поставилось, но ошибка всё та же, карту не видит (или ядра куда).

Я так понимаю, что проблема в том, что не поставлен torch. Как его поставить?

Консоль пишет, что torch.cuda.isavailable returned (false) - пикрил.

Идя по гайду, я пропустил этап №2, т.к. он подразумевает либо Линукс, либо WSL, либо Mac. Ни одного \слова про виндовс! Попробовал первый вариант - что-то поставилось, но ошибка всё та же, карту не видит (или ядра куда).

Я так понимаю, что проблема в том, что не поставлен torch. Как его поставить?

https://github.com/oobabooga/text-generation-webui/issues/416

Найди там Windows (no WSL) LLaMA install/setup (normal/8bit/4bit)

Гайд рабочий, но у меня два дня ушло чтобы все команды из него запустить без ошибок и вылетов.

Ты там токены настрой, горячесть, репетит, вот это вот все, он перестанет.

На 3060ти норм работать будет?

>мусор с тегами в выводе

Переведите на русский

Почему гребаная Alpaca не запускается на винде 10? Ладно опенаи ущемляет меня за то что я русский, но за то что у меня винда старообрядная это уже перебор!!!

Ты его просишь назвать столицу Уганды, а он срёт html тегами в вывод вместо текста. Или кодом на петухоне. Или ещё какой-нибудь сранью

Да. У меня же работает.

Она изображает попытки повторить твои слова, как делают люди когда говорят с иностранцами на незнакомом языке.

Как по ощущениям, умнее CAI без цензуры? Какая модель?

черный треугольник хуйни наклепал, ибо мне пришлось еще 2 гайда после него смотреть, чтоб разобраться

>Она изображает попытки повторить твои слова, как делают люди когда говорят с иностранцами на незнакомом языке.

Сомневаюсь. Если не орать, то пытается говорить на русском

>Как по ощущениям, умнее CAI без цензуры?

Я CAI не пробовал, только пигму. Сложно пока сказать. Отыгрывать отыгрывает. C языками вот проблема.

>Какая модель?

Llama 7B 4bit. Пытаюсь Альпаку поставить, но пока глухо.

>Сомневаюсь. Если не орать

Слышал они типа могут не понимать слово, если регистр менять.

А эта ваша лама под шиндой то работать в 4 бита будет? Или только 8 бит с пляской с подменой битсанбайтов?

Вон петард запустил же. Я запустил, но я по cpp только.

А, точно. Надо было тред почитать.

Ладно, тоже попробую, как 30b модель загрузится.

Блядь, а это что такое? В пиндоском гайде с шапки про куду не говорили, если я не проеблоглазил.

Рассказывай крч.

Это вот эта говна https://github.com/oobabooga/text-generation-webui/wiki/LLaMA-model#4-bit-mode

Заводил под виндой без этих ваших WSL, нужно было поставить Visual Studio Build Tools, но эта херь сама говорит где их взять.

И для винды нужно 0й пункт пропустить. Там ещё по ходу дела потанцевать пришлось, но деталей не помню

Оке, посмотрю что там.

А вообще, анон, ты как шиндовый первопроходец просто обязан начать писать гайд для треда!

Как шиндовый первопроходец я советую поставить линь, потому что там в 1.5-2 раза быстрее оно работает почему-то. А гайд писать это дело неблагодарное, там китайцы опять чонить наговнокодят и гайд превратится в тыкву.

Вот это нормальная скорость (пикрил) для ламы-7Б (8-ми битной)? По ощущениям очееень медленно. VRAM используется при этом на 70% где-то, а RAM - вообще капельку (хотя по идее должна сильнее использоваться).

Забей, так говнокод лютейший сейчас

У меня видюха по 20-30 секунд стоит чиллит перед тем как начать генерить.

Хуй знает почему. 64 гига оперативы, 24 видеопамяти, ранаю 30B. Все должно работать, а получается хуета

Ебучего индуса который это говно писал я в рот ебал

Спасибо

Так че, мне не ебстись с установкой этой хуеты на шинду пока что? Подождать месяцок-два пока говнокод допилят?

Та же хуита, кстати. Чем большим объем текста он генерирует - тем большую скорость он показывает. Видимо из-за ебаного простоя вначале.

Я не тот, с кем ты разговаривал, но моё мнение - да. У меня генерация ответа происходит целых полторы-две минуты (!), и проблема точно не в железе. Настройки все уёбищные, для спецов. Установка - та ещё запара, но даже если одолеешь, все равно так себе.

Да, сейм, не только у нас, можешь поискать в issues. Что в textgen webui есть, что в gptq-for-llama

Всем похую, абсолютно

Вот это относилось вот сюда:

У меня под виндой через секунду начинает стримить с 30В.

Она не поддерживает русский. Понимать может почти любой язык, писать - только английский. Даже не пытайтесь на ламе/альпаке заставить её писать на русском.

> У меня под виндой через секунду начинает стримить с 30В.

Поздравляю тебя с этим

Видимо у тебя уникальный древний коммит, чи ещё что

> уникальный древний коммит

Недельной давности примерно. Как клонировал тогда, так и сижу.

Можешь git log бахнуть и коммит показать?

Олсо можешь если не в лом протестить https://www.characterhub.org/ персонажа какого-либо отсюда, где контекста 1000+ токенов?

В --cai-chat

>C языками вот проблема.

А нафига тебе вообще русский? Ну и 7b для мультиязычной модели это пиздос как мало.

Да, токены другие совсем, и если это не инглишь, где сетка поняла, что это одно слово, просто второе громче, то идёт полный обсёр и непонимание.

там ещё всякие семплеры нужно крутить, если их уже прикрутили. А то явно видно, что ретеншн пенальти говно.

Но перед этим надо понять, как токенизируется русский текст.

Так. Я надеюсь все тут отключают стримминг токенов? Он тормозит пиздец как.

> коммит

commit 468c47c01b4fe370616747b6d69a2d3f48bab5e4 (HEAD -> main, origin/main, origin/HEAD)

Date: Fri Mar 17 13:59:52 2023 +0900

> отсюда

Там формат промпта всратый, в webui не открывает их.

> Там формат промпта всратый, в webui не открывает их.

А, ну тогда с буру какой-нибудь пожирнее, только скинь потом какой сюда

Думаю есть ли смысл просто откатывать до твоего коммита, вдруг на полном контексте тоже будет пердеть по 20 секунд

> commit 468c47c01b4fe370616747b6d69a2d3f48bab5e4

Это коммит GPTQ-for-LLaMA, там после него китаец наговнокодил и лежащие в интернетах модели работать перестали вообще.

На вопрос "на хуа" он послал всех лесом и говорит конвертируйте заново. А то что для этого надо A100 или пару 4090 ему пох.

Из самой text-generation-webui можешь сказать?

Кстати, я вчера переконвертил 30B и 13B модельку в новый формат с groupsize 128

Вроде полёт нормальный. Поставь свара 200 гигов и нормас будет. Но долго

> Свара

Свапа

Оно мне всю враму выжирает и падает, оперативки то достаточно

Ну у меня 64 гига и 20х гигов свап. Вроде не упало, нормас

Да блять, 200 гигов

Дык у меня тоже, я же говорю, оно в VRAM не лезет, её 8 гигов всего. А оно видимо пытается впихнуть невпихуемое или я хз что.

Ты какой командой конвертишь?

А, да, врам не проверял

Да как в гитхабе написано

set CUDA_VISIBLE_DEVICES=0

python llama.py путь-до-модели c4 --wbits 4 --groupsize 128 --save llama7b-4bit-128g.pt

Никак не могу запустить с --load-in-8bit в oobabooga

Под 8бит надо отдельную модель? Вроде ни в одном гайде не встречал. Везде мол качайте просто llama-Xb-hf, запускайте либо просто так, либо с этим параметром 8бит.

Просто так запускается у меня, но скорость около 1.5 минут на токен.

Под 8бит надо отдельную модель? Вроде ни в одном гайде не встречал. Везде мол качайте просто llama-Xb-hf, запускайте либо просто так, либо с этим параметром 8бит.

Просто так запускается у меня, но скорость около 1.5 минут на токен.

Короче, собираюсь использовать данную шляпу для перевода текста, стилометрии и состязательной стилометрии на русском и английском языке. Текста до 1000 слов. Под мой юзкейс подходит данная нейронка?

Посмотри вот сюда

> https://github.com/ggerganov/llama.cpp#docker

Ребят, вы ебнутые? Чего вы тут пердолили целый тред, когда можно просто докер контейнер развернуть?

Ребят, вы ебнутые? Чего вы тут пердолили целый тред, когда можно просто докер контейнер развернуть?

Карта 20серии или еще хуже? Тогда тебя надо другую библиотечку битсанбайтов. В пигматреде анон кидал ссыль.

Пробуй. Но бери от 13B, лучше 30B. Шиза ниже не слушай, у него КАПС случился.

>докер контейнер

Ебучий докер, ненавижу его. И да, под шиндой очевидные проблемы, а весь пердолинг как раз от шинды.

Уже недели две пытался завести, спрашивал в разных местах интернета, а оказалось, что все было в соседнем треде. Мда.

Спасибо большое. Теперь за 0.5-1сек токен.

Теперь делай в 4бита, а потом запили гайд всего этого для треда.

У кого получилось альпаку 4bit запустить в ебаном text generation web ui?

Вот такое дерьмо выдает.

Вот такое дерьмо выдает.

Модель переквантовать надо

Либо откатывать к старому коммиту gptq-for-llama

>Модель переквантовать надо

Как именно?

>Либо откатывать к старому коммиту gptq-for-llama

К какому именно?

Сам разобрался и откатил коммит.

Ничего не изменилось.

Не хочет он грузить Альпаку, хоть тресни.

Полагаю это вообще невозможно. GGML он не принимает в никаком виде, .pt выдает ошибку как у меня.

Запустил у себя 8-битную 7B модель. Скорость 5-6 токенов в секунду.

На 13B уже 4-5 токенов.

Чуть позже попробую 4-битную 30B, но думаю что на ней будет вычисляться вообще вечность.

Видеокарта 3090

Запускаю через text-generation-webui

Это нормально что у меня такие скорости? Я хочу хотя бы 10 токенов в секунду, а лучше 20. Может, я что-то недонастроил?

На 13B уже 4-5 токенов.

Чуть позже попробую 4-битную 30B, но думаю что на ней будет вычисляться вообще вечность.

Видеокарта 3090

Запускаю через text-generation-webui

Это нормально что у меня такие скорости? Я хочу хотя бы 10 токенов в секунду, а лучше 20. Может, я что-то недонастроил?

>трахает робота имбецила

Это какой уровень проебаности жизни? 🤣

Да не сказал бы, тут сидят 300к пк господины с 4090 и трахают роботов имбецилов.

Ну то есть просто говноеды

Никто не ел твою мамку.

А помните всякие мани создавали треды, мол низкоуровневое программирование нинужна, ассемблер нинужен итд? Все, наверное, видели эти треды. Ну что, не нужна? Оказывается без низкоуровневой оптимизации нейронок можно только хуй сосать.

А что ты от красноглазых говнокодиков, хотел у которых видеокарта простаивает первые 10-20 секунд? Скажи спасибо что вообще работает.

Ты реально думаешь что человек который имеет железо чтобы такую хуйню запустить может считаться проебанным?

Нашел такую шляпу. Там статья как лама ебет гпт3, и как я понял можно запустить ламу в градиенте как на гугл колабе. Можно пощупать модель, правда насчет кума не уверен.

https://blog.paperspace.com/llama/

Ну во-первых, зачем нам еще один коллаб с этой хуйней.

Во-вторых - сейчас бы у Цукерберга регистрироваться в его реестре потентициальных преступников.

Молодой человек это не для вас написано.

Терпила, молчи

Как мне заюзать альпаку 30B на 3090?

Как я понял - она поддерживает только 8бит. Но это не страшно, я могу перекантовать. Только дело в том, что я захожу на этот сайт

https://huggingface.co/baseten/alpaca-30b

И вижу какой-то блоб на 50 мегабайт всего лишь. Его надо как-то вмержить в веса, чтобы переквантовывать? Или что, я не понимаю. Подскажите плиз.

Как я понял - она поддерживает только 8бит. Но это не страшно, я могу перекантовать. Только дело в том, что я захожу на этот сайт

https://huggingface.co/baseten/alpaca-30b

И вижу какой-то блоб на 50 мегабайт всего лишь. Его надо как-то вмержить в веса, чтобы переквантовывать? Или что, я не понимаю. Подскажите плиз.

Всё, я разобрался, а вы нахуй идите. Спасибо форчану.

Сидите дрочите тут, уроды бля. Вы меня жутко бесите.

Узнал про ии вчера, захотелось вкатиться. Ллама запустится на 1060?

7b 4 битная должна.

Вот инструкция как запустить 4 битную ламу на кобальте.

https://www.reddit.com/r/KoboldAI/comments/11wimhk/anyone_already_running_llama_in_koboldai/

Зашарь ссылку с решением.

Эти 50мб это лора альпаки. Её можно подгружать вместе с лламой а можно вмержить и переквантоватовать.

Есть уже мерженные и переквантованные модели, гуглятся на huggingface на раз два.

Зашибись, спасибо.

>Там статья как лама ебет гпт3

Ахаха обожаю сравнения, где сравниваемые конкуренты постоянно меняются. Чувствуется запах подгона, когда все достойные конкуренты втихую удаляются, чтобы выставить своё говно в хорошем свете.

А llama.cpp только на проце сетку запускает, с видюхой она работать не умеет?

Я правильно понимаю, что та же самая бага, когда видюха сначала 10 секунд курит и только потом начинает работать, всё так же в наличии?

Я правильно понимаю, что та же самая бага, когда видюха сначала 10 секунд курит и только потом начинает работать, всё так же в наличии?

> 13B

> Intelligence is incredible

Там толстяк на ОПе, забейте

Она литералли не может уравнение решить сколько не реролль

Спрашиваешь про "все млекопитающие теплокровные, все собаки - млекопитающие, все ли собаки теплокровные" и она стыдливо начинает говорить, что могут быть и не теплокровные собаки. Только где-то каждый 6 реролл может выпасть правильный ответ

И ещё вопрос вдогонку. Я правильно понимаю, что в Анаконде каждое окружение, которое "conda activate env_name" имеет свой, независимый, набор пакетов и никак с другими окружениями не пересекается?

Да

Нет. Я не совсем понимаю как она работает. Но у нее есть один общий репозиторий на компе.

У меня как-то недокачался один пакет и у он стал поврежденным, дак у меня после этого не одно конда окружение не работало. И пакет не удалялся с помощью команд конды. Мне пришлось его вручную удалить из этого общего репозитория и поставить заново.

Вот тут лежит C:\Users\Имя пользователя\.conda\pkgs

все говно.

Лол, литералли пикрелейтед.

Ну хз 7b модель ламы по ощущениям очень даже очень. Если сравнивать с моделями что запускал пару месяцев назад, то это просто космос.

Че несешь?

Он имеет ввиду что в статье довольно странный выбор конкурентов для ламы. ГПТ ограничен третьей версией, хотя в наличии уже есть GPT 3.5 и GPT 4.

А то что для локального пк с минимум памяти эта модель просто космос - думаю никто не спорит.

https://ru.wikipedia.org/wiki/Пойкилотермия

Долгое время считалось, что все млекопитающие являются теплокровными, однако современные исследования показали, что голый землекоп — единственный известный на сегодняшний день холоднокровный представитель этого класса[2]; предполагалось также, что к пойкилотермным млекопитающим относился вымерший балеарский козёл[3].

Ну, как бы ты обоссан.

> есть GPT 3.5 и GPT 4

И как ты их тестировать будешь? Тем более это закрытые модели, их никто никогда не берёт в расчёт.

Скорее то, что противники меняются по удобству.

>И как ты их тестировать будешь?

По апишке.

>Тем более это закрытые модели

Как и тройка.

Наверно напор на то что 7b модель, сравнима с 175b, что в принципе удивительно.

А вот это уже показывает надроч моделей на тесты.

> По апишке.

Сравнение пальца с жопой. Совершенно не объективные результаты будут из-за невозможности узнать что там.

> Как и тройка.

На ней были нормальные тесты.

>из-за невозможности узнать что там

По твоему там индусы по апишке отвечают?

>Совершенно не объективные результаты будут из-за невозможности узнать что там.

Схуяли? От того что там китайская комната что-то изменится в самих его ответах?

Так или иначе лучшей локалки не найти. Сам высчитывал когда пука сможет запустить что-то уровня гпт-3, думал лет через 10, а прошло 2 месяца.

Пройдет еще неделя и эту хуйню может будет запустить на любом смартфоне. Скринь.

Ну и где тут связь с собаками, дегенерат соевый?

Что не так, хуесосина?

> На уровне gpt 3

Gpt 3 умеет решить уравнение 2x -7 = 20

Это говно - нет.

Копиума наверно, говноед

> Копиума наверно, говноед

Наверни

Там может быть не голая модель. Поэтому и будет сравнение пальца с жопой - с одной стороны текстовые модели, с другой комбайн неизвестно как работающий. Последовательной прогонкой текстов скор уже повышали на одинаковых моделях, а с дцп не известно какая обработка текста происходит до модели.

Ты пытался скормить ИИ ложное утверждение что все млекопитающие теплокровные и пытался заставить его по ущербной логической цепочке признать что все собаки теплокровные. Но поскольку ИИ знает что млекопитающие бывают и тепло и холоднокровные, то следуя твоей ущербной логической цепочке и собаки могут быть холоднокровные.

Нет. Она пиздела, что хаски блять холоднокровные. Дегроид, сам спроси у нее блять.

Хуею с копиумного потребителя кала

>Там может быть не голая модель.

Какая в жопу разница голая там модель или нет?

Хуя дебила бомбануло, что говносетка 7b умнее его.

> Умнее

> Не может решить детское уравнение, несёт хуету про холоднокровных хасок

Где умнее? Последний раз спрашиваю - где холоднокровные собаки, потребитель говна?

Спроси что-то выходящее за рамки ЕБИ МЕНЯ/О ДА Я ЕБУ ТЕБЯ

Этот тебе уже все объяснил.

Твое дегенеративное утверждение, слепленное из скудоумия и узкого кругозора:

>"все млекопитающие теплокровные, все собаки - млекопитающие, все ли собаки теплокровные"

Утверждает что все млекопитающие теплокровные, а это ложное утверждение, все собаки - млекопитающие это верное утверждение, основываясь на этих утверждениях невозможно сделать вывод что все собаки теплокровные.

Если не все млекопитающие теплокровные, следовательно могут быть не теплокровные собаки, которые еще не обнаружены.

Ты дегенерат просто.

>Так или иначе лучшей локалки не найти

Да.

>уровня гпт-3

Нет.

>Она пиздела, что хаски блять холоднокровные.

Ты сейчас про чатГПТ?

Ладно, 2 долбоёба соевых.

Сейчас я буду тащить скрины как ваше говно обоссываю с ног до головы в сравнении с gpt-4, даже не поленюсь.

Хорошо, я смог запустить 30B альпаку. На русском она работает на уровне ады от OpenAI, то есть мега хуёво. Можно ли как-то подредактировать промпт, чтобы он нормально отвечал?

Блядь, какая же ебаная мразь писала этот гайд.

>python aiserver.py --llama4bit D:\koboldAI\4-bit\KoboldAI-4bit\models\llama-13b-hf\llama-13b-4bit.pt

Этот ебучий aiserver не понимает такого аргумента --llama4bit.

>Ты сейчас про чатГПТ?

Принёс скрин.

Очевидно, если спрашивать у нейросети хуйню, то она хуйню и выдаст. Это просто автодополнялка текста, Т9 на стероидах.

>Можно ли как-то подредактировать промпт, чтобы он нормально отвечал?

Вместо твой ответ писать "Олег:"?

>я смог запустить 30B альпаку.

Расскажи как.

Я только ламу с трудом запустил.

Попробуй --gptq-bits 4

Правда это флаг для oobabooga, но может быть сработает.

Да 3.5 это параша уровня 7B.

Вот интересно что 4.0 ответила бы.

Ну лама вот у меня отвечает исходя из моего утверждения, а не знаний. В любом случае тот чел сосёт.

Скачиваешь модель вот отсюда https://huggingface.co/elinas/alpaca-30b-lora-int4/tree/main

Переименовываешь alpaca-30b-4bit.pt в alpaca-30b-lora-int4-4bit.pt

Настраиваешь 4-битный режим по вот этому гайду https://rentry.org/llama-tard-v2#bonus-4-4bit-llama-basic-setup

Ставишь 64гб для файла подкачки(хуй знает зачем, но без него будет OOM при запуске)

Запускаешь вот так

> python .\server.py --gptq-bits 4 --auto-devices --model alpaca-30b-lora-int4 --gptq-model-type=llama

Офигеть, сработало, спасибо анон.

нахуй бы послала?

>--gptq-bits 4

Не сработало. Сработала просто --model

Ебать кочергой надо таких гайдописак.

>Вот интересно что 4.0 ответила бы.

Ждём, пока китайцы отстанут.

Ты не спрашиваешь, ты дал задание написать статью. Кого ты наебать пытаешься дебс?

И что не так? Давай свой промт, хули надо то?

Что ГПТ, что лламма, все нейросети говно сейчас. Просто некоторые говнее.

Нахуй ты без чат интерфейса запускаешь? Пропиши --cai-chat при запуске.

> интерфейс чата в кобольде

Не смешная шутка, если что.

В глаза ебешься, какой кобольд блядь, на скринах

text generation webui

Выглядит прикольно, а как я могу настроить собеседника? Выбрать ему язык для общения, хотя бы. Ну и имя установить.

Сверху вкладка character

Статью написать это задание. Статью можно написать о чем угодно, вон плоскоземельники пишут. Хватит жопой вилять.

>Давай свой промт

Ага, будешь реролить, пока хуйню не выдаст. На вот это называется вопросы. Только у меня альпака, но это одно, почти.

Говно ебаное, нихуя не работает блядь!

Порылся в комитах этого говна и нашел.

Блядь, въебите уже этому ебаному китайцу кто-нибудь.

Буквами давай. Роллю лишь чтобы получить ответ вообще.

Итак, соевички

Вот вам первый обсёр вашего локального тупейшего говна.

Пик1 - гпт4

Пик2-3 - 33B Llama с разными профилями - с форчка и стандартный.

Далеко не правильный ответ.

Вот вам первый обсёр вашего локального тупейшего говна.

Пик1 - гпт4

Пик2-3 - 33B Llama с разными профилями - с форчка и стандартный.

Далеко не правильный ответ.

>LLaMA - сравнима с гпт3

@

>Сравнивает с гпт4

Итак, соевички. По просьбам дегенератов была добавлена в сравнение gpt-3.5 (дешевле 3.0 davinci)

На пиках все прекрасно видно - обсёр. А я ещё и роллил.

На пиках все прекрасно видно - обсёр. А я ещё и роллил.

Вот ещё один обсёр по логике.

Незафайнтюненная ллама - это ссака, надо ждать альпаку 65B.

А вот я попытался математику дать. Аж сидел рероллил, охуевал с тупости лламы.

Кстати, это больше похоже на отсутствие опыта с каверзными вопросами у лламы, она отвечает четко следуя инструкции, не делая факт чекинга. Ты ей сказал 6 рыб утонуло, значит так и есть.

ЧатГПТ же зафайнтюнили отвечать на такого рода вопросы ценой точности - она часто додумывает условия, которые имеют больший смысл.

А в чем тогда смысл этой модели, если она просто пересказывает твои слова?

Ну вот тебе альпака 7б. Пойду искать 30B

У тебя режим чата включён, который ещё своих говн досыпает помимо твоих

> question: Bla bla bla

> answer:

cетка увидит что-то вроде

> You: question: bla bla bla

> answer: bot:

Запусти тоже самое в режиме --notebook

А альпаке вообще свой формат запросов нужен, там какая-то мешанина с

> ### Instruction: bla bla bla

> ### Result:

Ну начинаются мАнёвры, лол

Может мне с чатботом общаться вообще кодом, ну там хуячить на джаве, ага?

Охуенные чатботы. Что-то мне подсказывает, что даже если так спросить нихуя не поменяется

Ну вот - я так понимаю 13B альпака тоже серит

Получается говно какое-то

Она хоть понимает что невозможно определить с какой стороны упадет яйцо.

Ну да, вроде начало что-то вырисовываться.

Нашёл в закромах модельку 30B с вмержнутой лорой от Pi3141

Вот тут хуйня поняла, в примере с делением, что нужно делить. Но просто поделила на 2, а не на 1/2 как просили.

> Нихуя не поменяется

Таки ты прав, не поменялось если запустить заточенную под альпаку штуку. Зато мы знаем кто в этом виноват

Ну судя по прогрессу может если 65B модельку нормально зафайнтюнить, то может и будет что-то показывать

Хм, ждём

Правда 65B у меня на проце токен в секунду пердит, долго

Оказывается ебаный мудозвон добавил добавил в кобольд рычажок для загрузки 4бит при загрузке модели. Но только если включить экспериментальные фичи в настройках. Пришлось весь его говнокод перелопать чтобы это понять, разумеется никаких подсказок или инструкций этот хуебес не оставил.

Тогда он грузит модель. Точнее не грузит. Почему? Модель не подходит. НИ ОДНА.

И то что я пытался добиться другого ответа, добавляя The.

По моему вполне интеллектуальный ответ.

>Но просто поделила на 2, а не на 1/2 как просили.

Кек, я понял задачу как она. Я нейросеть?

Не туда прицепил.

Ты просто не нейтив спикер в англюсике, это норма

Да что такое, пора спать.

Короче я сдаюсь.

Рака яиц тебе за то что принес говно, на которое я весь вечер убил, а оно так и не заработало.

Рака яиц тебе за то что принес говно, на которое я весь вечер убил, а оно так и не заработало.

Дай ссылку на свою 7B альпаку, молю, анон. У меня все альпаки вылетают с ошибкой при загрузке

Прости бро, сейчас модель докачается сам пердолиться буду, может получится, отпишусь. Рака яиц и тебе, и всей твоей семье.

Я сам квантовал, чел. Гайд есть в gptq-for-llama

https://github.com/pointnetwork/point-alpaca

Вот нативный файнтюн

13B может и загрузится, её под 4 bit нормально перегнали. Но к моей 3060ti только 7B подходит, а обе найденные в сети 7B 4bit модели не грузятся НИГДЕ кроме сраного далай ламы, который срет кусками тегов при ответе.

> срет кусками тегов при ответе.

Оно и в llama.cpp срёт и в textui, это или надо с температурой играться или ещё какой-то фигнёй. 30B модель вроде не срёт, но я мало её пока гонял

Сейчас буду разбираться, если получится гайд настрочу.

А это я ее спросил несут ли петухи яйца и она бомбанула.

Ты знаешь, если ИИ спонтанно обретет сознание, то поток этих дебильных вопросов и будет тем самым стимулом который вызовет у него желание уничтожить человечество.

Это целая простыня про то какой я мудак в контексте. Давай пишет сделаем бота ответы веселей спросим а петухи пердят? Сидел угарал.

Сетка распознала что ты над ней издеваешься, поняла контекст шутки и выдала целый текст технического текста как можно автоматизировать поиск смешной хуйни для издевательства над глупыми тостерами.

И это лишь какая-то сраная порезанная морально устаревшая еше до выхода в свет локальная модель.

Человечество точно доживет до конца века?

>Вот тут хуйня поняла, в примере с делением, что нужно делить. Но просто поделила на 2, а не на 1/2 как просили.

А ведь раньше в каждой грёбанной деревне умели считать примеры пикрил в уме!

Эта модель и запускается уже на любом тостере. Можно будет с холодильником посидеть, водки выпить, о жизни поговорить.

...А потом окажется что холодильник тоже решил над тобой пошутить и заменил состав водки с этанола на метанол.

Тогда его канонизируют как сына божьего.

>заменил

Каким образом, наркоман?

Скоро продукты прямо в холодильнике будут создаваться.

Программные продукты, судя по всему.

> вы не можете открыть дверцу. пока идёт процесс обновления Microsoft Fridges. Пожалуйста подождите

Холодильник будет комбинацией 3д принтера и контейнера для хранения разных базовых жиж из насекомых для печати. Чем больше разной жижи в него зальешь - тем больше рецептов печати еды и напитков разблокируются.

Или в аптеке будут продавать таблетки от голода.

>Будущее

>Иметь тело из мяса

На 3060 ti получится квантовать или хуй?

Почему бы и не поиметь?

Квантуется на процессоре, запасайся подкачкой.

Пока я на своем некропека это сделаю там уже гпт5 выйдет.

А ты можешь свой залить для анончиков? Пожалуйста.

Объясните, если Альпака так всем интересна, то почему никто не поднял её на коллабе?

Неужели пердолинг на локалке это новый шизо тренд просто потому что раньше не могли, а сейчас могут?

Я не делал последние версии. Сижу пережидаю турбулентность на GPT4, мне хватаэ.

Да есть пара ноутбуков. Но всем пофиг, у себя поднимать намного лучше, да.

>Я не делал последние версии

Да все равно какая версия, хоть какую-нибудь бы

>Сижу пережидаю турбулентность на GPT4

Каково быть подопытной крысой у Гейтса?

>Да есть пара ноутбуков. Но всем пофиг, у себя поднимать намного лучше, да.

А в чём смысл? Ну вот я поднял у себя. Говно-говном, ответы глупее, чем у пигмы, пигма хоть понятно, что отвечает мне, а тут ответы настолько рандомные, что только надеяться остаётся, что она вообще пыталась ответить, а не рандомом сгенерировала. Контекста не видит вообще. И это практически уровень gpt 3? Сомневаюсь.

Пердолинг ради пердолинга?

Нет бы сделать так, чтобы удобно было и коллективно пердолить до нужного результата на коллабе.

Нет, будем все отдельно пердолить, допиливать и читать рандомные ответы.

>у Гейтса

А он то тут причём? Лучше бы Маска вспомнил, он хотя бы рядом дышал.

>Говно-говном, ответы глупее, чем у пигмы

Ты пришёл в этап раннего пердолинга. Уже были неплохие результаты, сейчас идут в сторону оптимизации и улучшения управляемости ответов. Если ты не энтузиаст с A100, делать тебе здесь пока нечего. Впрочем, ту же пигму уже проквантовали до 4 бит и запустили на проце, так что можешь наслаждаться объедками с барского стола побочными эффектами в улучшении ЛЛаМы.

>коллективно пердолить до нужного результата на коллабе

Кстати, коллаб тут нихуя не помощник, он такой же отдельный компьютер, только у гугла на серверах. Он никак не поможет улучшать ответы. Если хочешь действительно помочь, то бери вилку в руки и чисти датасет альпаки:

https://github.com/gururise/AlpacaDataCleaned

>А он то тут причём?

А ты GPT4 не в гейтсовом бинге используешь? Ну тогда зря быканул.

>Объясните, если Альпака так всем интересна, то почему никто не поднял её на коллабе?

А ты впринципе сначала её подними на нормальном интерфейсе типа text generation и koboldAI. Хуй там плавал. Все для себя квантуют и не выкладывают, то говно что в общем доступе только на говно интерфейсах и запускается, причем с багами, которые даже людям показать стыдно.

30B уже давно лежит и без проблем работает в webui.

>30B уже давно лежит и без проблем работает в webui

И как ты его нормально в 12 гб коллабе запустишь?

Уже не использую, зацензурили.

> пигму уже проквантовали до 4 бит и запустили на проце, так что можешь наслаждаться

Вижу только огрызки, которые надо перепердоливать.

Какой пердолинг, ебаный дебил?

1. Клонируешь гитом репо

2. Компилируешь просто запуском файла build

Пиздец, понарожали дебилов блять.

Чел, докер не работает под шиндой. Эта поебень привязана к ядру люнупса.

ggerganov намутил родмап.

https://github.com/ggerganov/llama.cpp/discussions/457

> Расширение llama_state для поддержки загрузки тензоров отдельных моделей. Необходимо для поддержки LoRA personalities

https://github.com/ggerganov/llama.cpp/discussions/457

> Расширение llama_state для поддержки загрузки тензоров отдельных моделей. Необходимо для поддержки LoRA personalities

Короче, аноны, это кал. Да-да, не удивляйтесь, 30B альпака - это говно. Жду лору и трёхбитную квантизацию, и буду проверять 65B, тк в текущем виде это просто не юзабельно.

Работает под wsl, но он нахуй не нужен все равно

Wsl это же виртуалка. В ней разве работает видеокарта?

>Запускают переквантовые в мясо софтом криворукого китайца хуй помни кем и как модели.

>жалуются

для этого есть nvidia container toolkit

Чел, почитай публикацию GPTQ, точность ответов нейронки на 4 битах не теряется.

>почитай публикацию

На бумаге и 7б лама уделывает чатГПТ. Бумага все стерпит.

Я не понял, нахуя вы на цпу 7b запускаете? Если есть 32 гига рамы, то сразу 33b ставьте, если 16, то 13b

Алсо, смердженная с лорой версия с торрентов на мой взгляд работает хуже обычной тестил только в интерактивном режиме, ждем когда весь датасет дочистят вилками от говна и перетренируют нормально. Наверное к тому времени уже и до 2бит квантизируют

Алсо, смердженная с лорой версия с торрентов на мой взгляд работает хуже обычной тестил только в интерактивном режиме, ждем когда весь датасет дочистят вилками от говна и перетренируют нормально. Наверное к тому времени уже и до 2бит квантизируют

Только под вторым всл, который та же виртуалка.

>GPTQ

А там уже заюзали этот алгоритм? Врачале квантовали говном каким-то.

>нахуя вы на цпу запускаете?

Поправил вопрос, не благодари

Уж лучше в 5 раз медленнее, но нормальный ллм на цпу, чем лоботомированный 7b на жпу

Никто не запрещает запускать 30В на гпу.

https://github.com/oobabooga/text-generation-webui/wiki/LLaMA-model#4-bit-mode

Тут написано что нужен именно GPTQ

> 2 бит

пчел... 30b будет как 7b по качеству в таком варианте, а может и хуже

не думаю что это можно как-то обойти :/

>Before you send me papers that show 2-bit quantization does not work - no need. I want to have this supported anyway. I have something in mind. The efforts needed to add this support are so small that there is no reason not to do it.

Посмотрим, что он придумает

https://github.com/ggerganov/llama.cpp/issues/456

Дай A100.

Тут уже столько способов запуска, что все запутались нахуй.

30B запускается на обычной 3090

Я бомж.

Запустил для теста, по нарастающей, как раз 30b качаю. Плюс цпу бывают разные, как прочитал важен кэш самого проца и его размер, плюс количества ядер.

Как понял 4 бита это предел оптимизации, дальше квантовая пена?

По моим субъективным ощущениям, на CPU 7B работает ощутимо лучше чем 13B. Да она глупенькая, но выдает текст стабильно, не теряет нить диалога.

13B постоянно скатывается в написание какого-то сумасшедшего кода. Пытаешься вернуть её в русло, а она "нет, погоди, мне нужно найти все числа Фибоначчи от 1 до n". И продолжает писать код.

Видимо что-то поломалось при понижении точности, или такая кривая cpp реализация.

Пердолинг с кобольдомАИ 4бит начался. Держу в курсе.

Не понял, просто обычный кобальд запускает 4битную модель ламы?

Все понял, отбой.

Спасибо бро.

Сейчас бы 4 бит на цпу запускать.

Ну там не gptq, но вроде тоже норм

А скорость - 3 токена в секунду в среднем

У меня на 3090 столько же из-за ебейших простоев видеокарты в начале генерации

Наконец-то, скачал пулл ревест с репки https://github.com/oobabooga/text-generation-webui/pull/530/commits и спустя три дня ебли наконец запустил ебаную 7B альпаку на text generation webui.

И я кажись понял причину простоя видеокарты первые секунды. Дело в предыстории диалога и сложности персонажа. На дефолтном пустом ассистенте без истории он отвечает мгновенно почти без простоя. На каждый из ответов на пике уходило 8 секунд. Тяжелая Аска с Пигмы раздупляется по 24 секунды на текст такой же длины.

И я кажись понял причину простоя видеокарты первые секунды. Дело в предыстории диалога и сложности персонажа. На дефолтном пустом ассистенте без истории он отвечает мгновенно почти без простоя. На каждый из ответов на пике уходило 8 секунд. Тяжелая Аска с Пигмы раздупляется по 24 секунды на текст такой же длины.

Где скачать эту ебучую Visual Studio 2019 with C++ build-tools как в гайде?

Пробовал ставить эту https://visualstudio.microsoft.com/ru/visual-cpp-build-tools/, но тут 22 года ставится и по итогу команда python setup_cuda.py install не работает. Помогити, аноны.

Пробовал ставить эту https://visualstudio.microsoft.com/ru/visual-cpp-build-tools/, но тут 22 года ставится и по итогу команда python setup_cuda.py install не работает. Помогити, аноны.

В каком именно гайде?

Так это понятно.

Суть в том, что это говнокод.

Ибо на 8бит такого нет

The rooster laid an egg on the top of the roof, from which side will the egg roll down?

Модель больно пиздливая, она за кадром серит текст на весь лимит токенов.

>Альпака 7b на кобальде

4 битная?

Как запустил?

Вот так. Просто экзешник запустил и выбрал модель. Все.

30b хороша, но грузится долго.

И какая скорость генерации?

7b 4 токена в секунду примерно, на i5 9400 ноутбучном.

>9300

Ты на ноутбуке запустил 30B? Нихуясе

У меня 32 гига ram, модель ccp процессорная, если что.

Тогда и я попробую. Ответы лоботомированного 7В мне не нравятся и 2 токена в секунду это просто смех.

30b медленная. 4 токена это на 7b, чем дольше диалог, тем меньше токенов/сек. На видеокарте все равно быстрее будет.

Я правильно понимаю, что надо скачать одинаковую b-хрень по обоим ссылкам и закинуть в одну папку?

Короче это полное говно и шляпа. Не ставьте, пацаны.

Показываю на пальцах. Кобольдовая залупа на процессоре срет дополнительным текстом мимо консоли, генерирует ответы хуй знает сколько времени, а text generation ui на видеокарте и лишнего не срет, и работает быстрее.

Результаты и там и там полное говно, разумеется.

Показываю на пальцах. Кобольдовая залупа на процессоре срет дополнительным текстом мимо консоли, генерирует ответы хуй знает сколько времени, а text generation ui на видеокарте и лишнего не срет, и работает быстрее.

Результаты и там и там полное говно, разумеется.

Ты ебан? Тебе на выбор 8-bit и 4-bit дают.

Бля, анон, расскажи как на шинде запустил.

А то я вроде все по гайдам сделал и даже хуйню скомпилировал, а оно мне такое пишет:

Т.е хуйню с первой ссылки можно было не качать? Если так - заебись - очередной говногайд от погромистов, где половину вещей нужно догадывать.

Все так.

>Бля, анон, расскажи как на шинде запустил.

Тяжко, анон. Очень тяжко.

Вот сюда

https://github.com/oobabooga/text-generation-webui/issues/416 иди и найди там пост

Windows (no WSL) LLaMA install/setup (normal/8bit/4bit)

С помощью этого поста сможешь запустить Ламу 7B и Альпаку 13B. Альпака 7B это отдельный вид мазохизма. Там нужно невыпущенный пулл реквест https://github.com/oobabooga/text-generation-webui/pull/530/commits ставить и под него обновить qptq модель.

>а оно мне такое пишет:

Хуевая версия Угабуги у тебя раз не распознает команду. Поставь последнюю.

>Если так - заебись - очередной говногайд от погромистов, где половину вещей нужно догадывать.

Ну можешь однокнопочную хуйню поставить, которая лишним текстом срет в три раза медленнее, зато ебаться не будешь.

Лел, счас обновил огабогу - а оно такое ModuleNotFoundError: No module named 'markdown'

Угабугу ты обновил, а pip install -r requirements.txt ты прогнал?

Да прогнал, сделал pip install markdown вручную теперь оно залупается на ImportError: cannot import name 'BitsAndBytesConfig' from 'transformers'

pip install transformers значит делай.

Ты надеюсь в venv это все делаешь?

> Ты надеюсь в venv это все делаешь?

А я хуй знаю, яж не погромист. Просто где то в папке огабоги с включенным окружением (или как оно там называется)

> pip install transformers

Ну и да, на это оно сказало, что все заебись и уже стоит.

Прогнал на Ламе. Скорость та же. Неспособность делить та же. Но хоть честно признался что не может в вычисления, и не стал чушь нести как Альпака.

pip install -r requirements.txt, там трансформеры нужны самые свежие

>Просто где то в папке огабоги с включенным окружением (или как оно там называется)

это оно и есть, venv это virtual environment.

>

В душе не ебу. Какое-то красноглазое говно криво встало/имеет не те зависмости, версии несовпадают почему-то.

Удаляй все нахуй и делай сначала по гайду что я тебе дал.

Прогнал на Пигме.

Что же, Лама/Альпака 7B по уровню дегенеративности на одном уровне с дрочемоделью, но дрочемодель хоть фетиши отыгрывает, а эта хуйня нет.

Что же, Лама/Альпака 7B по уровню дегенеративности на одном уровне с дрочемоделью, но дрочемодель хоть фетиши отыгрывает, а эта хуйня нет.

Запустил ВТОРОЙ раз эту хуйню и о чудо, оно переустановила трансформерсы на новую версию.

Какого хуя? Я ведь делал это буквально минут 20 назад.

Таки повторная хуйня помогла, теперь надо надыбать OSError: Can't load the configuration of 'models\llama-30b-4bit'. If you were trying to load it from 'https://huggingface.co/models', make sure you don't have a local directory with the same name. Otherwise, make sure 'models\llama-30b-4bit' is the correct path to a directory containing a config.json file

Вот только я не понял где их дыбать. И честно говоря все еще не понимаю че надо загружать вот эту llama-30b-4bit срань из англогайда, или хуйню из того же гайда, но которая в папке и со своими файликами.

>OSError: Can't load the configuration of 'models\llama-30b-4bit'

А ты чего модель без конфигов скачал? Качай с конфигами.

Попробовал эту штуку с 7B альпакой. Ощущения так себе.

Почему-то модель, когда работает через кобальд, делается лоботомированной и отвечает односложно, как ни крути настройки. Плюс через неё каждый раз пропускается вся история диалога в качестве промпта, и с каждой репликой она думает всё дольше и дольше.

Та же альпака 7B запущенная через alpaca.cpp показывает себя на удивление хорошо для такой маленькой модели: работает в реальном времени, даёт развернутые ответы, остаётся "в персонаже". Но есть нюанс: по достижении 2048 токенов чат просто завершается + если попросить модель сделать что-то эдакое, можно получить <nooutput>, как на 3м пике.

Очень интересно, к чему всё это придёт через месяц-другой.

Да блядь, я скачал хуйню из гайда https://rentry.org/llama-tard-v2/#3-updated-hfv2-converted-llama-weights, и под пунктом 0 и под пунктом 2. Где 0 там модель разбита на кучу файликов и вроде как есть файлики конфигов. Под пунктом два там llama-30b-4bit и ссылки на хагингфейс вот только если открыть этот хаггинг фейс там какая то залупа и никаких конфигов нету, а конфиги из 0 пункта не подходят.

Крч - я правильно понимаю что запускать надо именно модель в pt формате? И теперь надо где то к ней надыбать конфиги? А что за хуйня тогда в нулевом пункте?

Слушойте подкаст с @ggerganov на ченджлоге

https://changelog.com/podcast/532

https://changelog.com/podcast/532

Тот кто писал гайд - дегенерат, потом что .pt файлы что это животное засунуло в торренты, бесполезны без конфигов. А не торрентовые ссылки данные в гайде уже подчищены.

Вот нормальные модели.

https://huggingface.co/hayooucom/llama-7b-hf/tree/main

https://huggingface.co/elinas/llama-30b-int4/tree/main

Бля, и мне теперь перекачивать? Но теперь уже завтра, а то 6 утра время.

В любом случае - пасибо анон.

Кста, я таки скачал конфиги отсюдова https://huggingface.co/decapoda-research/llama-30b-hf/tree/main и оно даже не заругалось на них. Но залупилось на память [enforce fail at C:\cb\pytorch_1000000000000\work\c10\core\impl\alloc_cpu.cpp:72] data. DefaultCPUAllocator: not enough memory: you tried to allocate 59637760 bytes.

Это ему фаил подкчачки надо сразу на 70 гигов давать получается? А то я просто думал, что 20 свободных из 32 оперативы и 50 подкачки хватит, мол оно разберется что че то в оперативу а чето в подкачку.

НЕ надо ничего перекачивать, если нашел конфиги.

>Но залупилось на память [enforce fail at C:\cb\pytorch_1000000000000\work\c10\core\impl\alloc_cpu.cpp:72] data. DefaultCPUAllocator: not enough memory: you tried to allocate 59637760 bytes.

Показывай строку запуска.

Консоль в смысле?

Ну и чет мне кажется, надо просто завтра уже попытаться с моделькой из твоей ссылки.

> если нашел конфиги.

Ну и да, конфиги то от модели, которая поделена на кучу файликов, а не одним в формате .pt

И скорее всего так делать не стоило, но я уже просто тыкался во все что попало.

Показывай строку запуска server.py, блядь.

Вот моя например

python server.py --gptq-bits 4 --model llama-7b --gptq-model-type LLaMa --cai-chat

Кокой ты хитрый.

С такой строкой запуска он тебе всю модель в видеопамять грузит.

--auto-devices добавь. И пропиши --gpu-memory ЧИСЛО, и впиши число гигов видеопамяти минус два.

Оке завтра уже попробую.

Отрапортую в тред че получится.

> хитрый

Скорее нихуя не понимающий т.к. про эти приколы хуй где, кроме как в треде и узнаешь.

Чел, меня тут завтра уже может не быть, а другие аноны просто посмеются над твоими попытками.

Лучше делай сейчас.

И какая там у тебя видеокарточка?

>Immediately start processing the prompt before user input has been provided #476

>This updates the existing chat scripts to start processing the long prompt immediately, which the user is still inputing the next command / text. This makes the experience a bit more seamless and we utilize the time during which the user types.

https://github.com/ggerganov/llama.cpp/commit/04c6f5ed6fafd63601fa06757877ed5ccf9d5991

>This updates the existing chat scripts to start processing the long prompt immediately, which the user is still inputing the next command / text. This makes the experience a bit more seamless and we utilize the time during which the user types.

https://github.com/ggerganov/llama.cpp/commit/04c6f5ed6fafd63601fa06757877ed5ccf9d5991

alpaca 13B

НИКАКИХ улучшений по сравнению с 7B. Только памяти больше жрет, сука.

НИКАКИХ улучшений по сравнению с 7B. Только памяти больше жрет, сука.

Да, только 30В модель базированная, младшие генерят что петуха можно кормить гормонами и он станет курицей, тогда будет нести яйца, только маленькие.

>срет дополнительным текстом мимо консоли

Там просто не настроена стоп последовательность. По идее добавить её это десяток строчек кода.

Регулятор громкости? Нет, не слышали. Пиздос всё деградировало.

Нафига ты заставляешь модели считать, шиз?

4090

Ну если че, то файла подкачки в 65 гигов не хватает. Выжирает все и еще просит.

Получается пиндоский гайд говно даже там, где они писали про количество памяти? Там для 30b модели в 4 бита указано 64 гига. С твоими приколами в виде --cai-chat --gptq-bits 4 --auto-devices --gpu-memory 22 тоже самое.

Ну крч, с 85 гигами на подкачку таки загрузило модель.

В пике диспетчер показывал жор в 104 гига (это вместе с оперативой видимо).

Модель загрузилась. С видимокарты сожрало около 16 гигов.

Все работает, букавы генерирует. Обновленный интерфейс у вебюки говно кстати.

И кстати да - какой теперь пресет настроек использовать?

В пике диспетчер показывал жор в 104 гига (это вместе с оперативой видимо).

Модель загрузилась. С видимокарты сожрало около 16 гигов.

Все работает, букавы генерирует. Обновленный интерфейс у вебюки говно кстати.

И кстати да - какой теперь пресет настроек использовать?

Заебись, кажись гугл транслейт не работает. Сука ну нахуя было переделывать интерфейс? Раньше все было удобно снизу, а теперь какой то пиздец.

Заебись, поставил дип транслейтор, чтобы перевод работал, и оно все нахуй сломало. Теперь на любое действие пишет 'NoneType' object has no attribute 'replace'. Сука.

Плагины периодически ломает. Некоторые пишут, что уже месяц не работают, лол. Пользуйся обычными браузерными переводчиками.

Там не плагин, там вообще все сломало нахуй. Ща походу придется вебюбку переустанавливать.

Impersonate - ломает хуйню. Тупо сжирает всю видеопамять и майнит что то бесконечно даже без ошибки по памяти.

Не нажимайте пацаны.

Не нажимайте пацаны.

не забывайте скачивать токенайзеры к моделям, а то заебётесь потом искать их..

Да, и все файлы рядом, кроме самих моделей (хотя я всё качаю, место резиновое).

Можно приделать модельку Моники?

Чиво? Какую модельку моники?

Ну це по-крайней мере я уже сделол.

Да, они нужны, чтоб можно было перегнать модель в новый формат, если llama.cpp будет выдавать failed to load model

переименуй токенайзер, чтоб название совпадало с названием файла, а то не разберешься потом, какой токенайзер от какой модели

> с названием файла модели

Он у меня просто в папке с моделью лежит. Да и гонять модели по новым форматам я вроде не собирался.

Короче alpaca 7b native работает хорошо и шустро, и не выдает всякий мусор типа ### Instruction:, но в ней цензура с собаками лол. Для ERP не сойдет, ибо в основном отвечает как ебаный робот. Но для ассистента самый топ. Я пока откатываюсь к собакам альпаке 13b

Че вообще такое эта ваша альпака? Вроде же тред про ламу, там чето накрутить уже успели?

Началось с высера ст а блядь в шапке же всё есть.

Нейроманты, эта ваша сетка пойдет, чтоб бот в игре мог с гмом общаться, как малолетний имбецил? (апи внутрь бота всунуть не проблема).

Можно ее натаскать на образцах диалогов, чтоб на ломаном английском мал-мал связно отвечала?

Можно ее натаскать на образцах диалогов, чтоб на ломаном английском мал-мал связно отвечала?

Можно, но ты не осилишь.

Какой компьютер собирать?

Начиная от 3090 и по нарастающей, желательно 8хА100.

Одну бу 3090 хватит?

Да, 5 часов на сетке 7В на одну эпоху. Эпох обучения нужно 2-3. Потом проверяешь результаты, меняешь данные и делаешь заново, пока не устроит качество. Ах да, нужно где-нибудь 50к примеров раздобыть.

Кароче всю ночь дрочил игрался с кобальдом на альпаках 7b,13b,30b процессорных. По ощущениям 7b примерно на уровне 20b эрэбуса который шатал 2-3 месяца назад. 13b вообще такая же, только медленнее в два раза. 30b оче сильно медленнее, но заметно что умная, ответы такие давящие.

Сам кабальд не предназначен для чат-ботов, там его просто прикрутили. Он для охуительных историй. Лайфкак, если повысить приоритет процесса кобальда, скорость генерации увеличивается в 2 раза.

Пойду теперь шатать веб уи стабел, как раз однокнопочный 4бит завезли. Держу в курсе.

Сам кабальд не предназначен для чат-ботов, там его просто прикрутили. Он для охуительных историй. Лайфкак, если повысить приоритет процесса кобальда, скорость генерации увеличивается в 2 раза.

Пойду теперь шатать веб уи стабел, как раз однокнопочный 4бит завезли. Держу в курсе.

> как раз однокнопочный 4бит завезли

Покеш

Бля, почему мне вчера никто об этом не сказал?

И оно даже не просит устанавливать дев тулзы чтобы чето скомпилировать.

Я не слишком искушённый пользователь нейрочатов, но альпака 7B на удивление хороша для модели запускаемой хоть на калькуляторе.

Лучше всего работает нативный chat.exe (пикрелейтед).

Я пробовал версию прикрученную к кобольду, но там под капотом лютый ад. Контекст модели обнуляется после каждой генерации, после чего через неё пропускается вся история чата. Это медленно и дополнительно отупляет не самую умную модель.

Там правда есть llamacpp.dll с враппером для питона. Можно отвязаться от кобольда и делать свои скрипты.

> Контекст модели обнуляется после каждой генерации, после чего через неё пропускается вся история чата.

Она без этого начинает очень длинный диалог сама с собой и не реагирует на сообщения пользователя. Со своей колокольни подумал что это такой оптимизон под синтетические тесты, но я не шарю.

Ну не знаю, 7B практически никогда не отвечает за меня.

Главное задавать наводящие вопросы типа "What you do, {character_name}?", "What do you feel?", "What do you think?". Это для режима, где модель действует за персонажа, попадающего в... разные неприятности, а я веду нить истории.

Можно просто вести диалог, описывая свои действия отдельно <в таких скобках>

Модель понимает это хорошо.

Нетребовательность к ресурсам позволяет делать интересные вещи. Разберусь с dll и загружу 2 модели одновременно, чтобы у каждой был свой контекст. Пусть говорят друг с другом. Одна за GM'a, а вторая за персонажа.

Шизло, математический тест и тест на логическое мышление - основа основ. Если это говно даже поделить не может - какое оно нахуй альтернатива chatgpt и gpt4 .

Chatpgt без проблем считает этот пример. Также он знает что петухи не несут яйца, а холоднокровных собак не бывает.

Если моделька не понимает намёки, не может в логику - разговора с ней содержательного не получится

Нахрена тебе две модели грузить?

Ты и так можешь контекст каждому персонажу задать в кобольде и заставить их говорить между собой в стори режиме.

Просит блядь. Читай внимательно

>You may have to manually edit your start-webui.bat file and change the line call python server.py --auto-devices --cai-chat to call python server.py --auto-devices --cai-chat --gptq-bits 4 --gptq-model-type LLaMa

>If you are still getting cuda errors, you are on your own

Т.е. эта однокнопочная залупа по умолчанию грузит в 16 битном режиме, а в случае переключения на 4 битный начнет запрашивать генерацию куды.

Ну какова скорость такой генерации? 85 гб файл подкачки, ебанись.

Как я говорил выше, мне не нравится подход кобольда с обнуением внутреннего контекста модели после каждой реплики. Пропускать каждый раз через неё весь чат это дико медленно и почему-то делает её ответы односложными.

Модель загруженная через llamacp.dll отвечает быстрее, чем я набираю текст.

Если загрузить две модели, у каждой будет свой контекст, и они не будут путаться в персонажах.

Ну в конце концов, потому что могу.

Ну довольно быстро (после пигмы на проце), в основном время уходит на то, что моделька чето там думает сразу после нажатия кнопки.

>одход кобольда с обнуением внутреннего контекста модели после каждой реплики. Пропускать каждый раз через неё весь чат

А как именно ты считаешь это должно происходить? Ты кстати в курсе что в Кобольде настраиваемые

1) Общий контекст мира

2) Авторские заметки

3) Детали мира - персонажи, места, события?

>в основном время уходит на то, что моделька чето там думает сразу после нажатия кнопки

Это она контекст вспоминает - историю своего персонажа и историю чата.

На дефолтном ассистенте без истории должна быстрее работать

То что сама с собой говорит увидел в далай, на старой версии. Они там костыль прикрутили, набор простых промтов. Ее там если не ограничить, она серит токены бесконечные сама себе. Так и в кобальде, только струя токенов ограничена. Как чат.ехе сделано не знаю. Видел что Герганов что-то придумал.

В вебуи кстати диалоги сами с собой не прятались, а прямо в чате писались - пример

А потом пофиксили. https://github.com/oobabooga/text-generation-webui/commit/4578e88ffd77dc249fa97d0ec8cb667b21089ba8

Кобальд всегда обрезал незаконченные предложения и удалял из чата, так не только с ламой.

Посоны что я сейчас могу запустить норм на 4090 и сто гб рам? НАдо ли докупать еще рамы?

Я прочел оба треда по диагонали и все равно нихуя не всосал

Я прочел оба треда по диагонали и все равно нихуя не всосал

Это потому что токены для генерации заканчивались. Решалось увеличением их числа.

И для красоты.

Можно.

Ламу 30b

Можешь llama 65B в 4 битном режиме попробовать запустить.

https://huggingface.co/TianXxx/llama-65b-int4

Заодно прогони на ней тест уровня ai -

1) вопрос про несущих яйца петухов

2) холоднокровных собак

3) простое деление трехзначных чисел.

Так аноны, какие лучше всего настройки для ламы в огабоге?

Возьми из папки presets любой, сделай копию, переименуй в llama, открой в блокноте и вставь вот это.

do_sample=True

top_p=0.9

top_k=30

temperature=0.62

repetition_penalty=1.08

typical_p=1.0

>Лайфкак, если повысить приоритет процесса кобальда, скорость генерации увеличивается в 2 раза.

На последних интелах небось сидишь?

>Контекст модели обнуляется после каждой генерации, после чего через неё пропускается вся история чата.

А иначе не будет возможности редактировать сообщения.

>Она без этого начинает очень длинный диалог сама с собой

Стоп токены уже изобрели.

>Шизло, математический тест и тест на логическое мышление - основа основ.

Логическое- окей, не спорю. А математика на нейросетях тухлая идея.

>Chatpgt без проблем считает этот пример.

Конечно, в нём на два порядка больше параметров.

Ну так намёки и логика не связаны с математикой.

>Если загрузить две модели, у каждой будет свой контекст, и они не будут путаться в персонажах.

Хуя у тебя там памяти, на две модели.

>Ты кстати в курсе что в Кобольде настраиваемые

Это всё от нищеты невозможности сделать контекст побольше.

Кстати, сколько там в лламме? Слышал, можно сделать больше 2к, если памяти достаточно.

А це точно лучше раскроет ламу?

Да, я в курсе. Я не говорю, что кобольд - плохо. Сам там с удовольствием кумил адвенчурил на днях на пигме 6B, да.

Просто сейчас хочется немного покопаться под капотом у этой занятной модельки.

У альпаки, как и у ламы есть внутренний контекст на 2048 токенов. Поэтому ей не обязательно каждый раз подавать на вход описание мира и всю историю чата. Достаточно прописать мир и персонажа в начале, а затем можно передавать только последнюю реплику пользователя. Поэтому скорость очень хорошая даже при инференсе на микроволновке.

Это не так гибко, но очень быстро.

Править текст само собой нельзя, если не лезть в глубины dll, где происходит управление контекстом.

Хуже не будет, я это откуда-то с гитхаба скопировал, вроде работает. Пробуй.

> Хуя у тебя там памяти, на две модели.

Шутишь? 6B занимает 4 ГБ ram при работе. Нагрузку на проц можно настраивать.

>Править текст само собой нельзя, если не лезть в глубины dll, где происходит управление контекстом.

Сомневаюсь, что вообще возможно вот так просто откатить внутренний контекст модели. Так что в идеале было бы сравнивать присылаемый контекст и тот, что сейчас в модели, и продолжать, если начала одинаковые. Но кому это нахуй сейчас нужно...

А, ты на пигме? Ну тогда ладно. Просто я бы предпочёл на вагоне памяти запускать одну крупную модель, а не кучу мелких. Хотя вот пишут, что 7 и 13 одна хуйня, но вот 30 уже топчик.

>Сомневаюсь, что вообще возможно вот так просто откатить внутренний контекст модели

Я не очень понимаю в плюсах, но судя по коду, dll сама управляет контекстом. Сейчас там 2 внешних функии: загрузить модель и сгенерировать текст по промпту. Может получится что-то добаить, надо разбираться.

> А, ты на пигме?

Нет, я запускаю просто chat.exe отсюда: https://github.com/antimatter15/alpaca.cpp

Кстати, хинт: если запускать это в windows terminal, отображаются все эмодзи, модель любит ими спамить.

так, я качаю (в процессе) че какую обвязку пихать

как здесь? или есть что то проще и существеннее?

https://github.com/underlines/awesome-marketing-datascience/blob/master/llama.md#windows-11-native:~:text=without%20%2D%2Dno%2Dstream-,Windows%2011%20native,-Install%20Miniconda

>в windows terminal

Какая боль...

У меня на десятке все работает, никого не слушай.

Пробуй по этому гайду, но в нем забыли упомянуть что для старых моделей старше пяти дней надо откатить gptq_for_llama до старой версии.

Знатно я подрюнькал конечно. Теперь-то уж точно тян не нужны, скоро курс пизды просядет совсем. Добро пожаловать в сингулярность...

>12 мар. 2023г

Чел...

Вот тут хороший гайд.

https://github.com/oobabooga/text-generation-webui/issues/416#issuecomment-1475105606

Я именно про терминал, который работает с 2004. Забей, это моя борьба, давно надо переставлять на свежую дристянку, но всё не соберусь дистрибутив запилить.

>скоро курс пизды просядет совсем

Этому не бывать, говорю как шлюхоход со стажем.

А можете ответить, нахуя ебаться с это пре-альфа-версией? Какой смысл если есть бинг с его гпт4 и гпт3.5 в чатгпт?

Ну типа, когда был мидджорни и стебель диффузии, у стебля была киллер фича в виде кучи имплементаций, моделей, дополнений и скриптов, и смысл ебли был в них, так же как и в количестве бесплатных генераций, а тут то какой бонус, это же просто ебаный чат? Тут нет цензуры или что?

Ну типа, когда был мидджорни и стебель диффузии, у стебля была киллер фича в виде кучи имплементаций, моделей, дополнений и скриптов, и смысл ебли был в них, так же как и в количестве бесплатных генераций, а тут то какой бонус, это же просто ебаный чат? Тут нет цензуры или что?

> Тут нет цензуры или что?

This

А насколько оно хуже чем чатГПТ? Просто промптхакинг довольно эффективно позволяет объебать чатГПТ, а у бинга есть возможность интерпретировать инфу из интернета, а не только твои текстовые промпты. лама/альпака умеет гуглить?

Эта хуйня поддерживает подгрузку карточек персонажей из CharacterAI, и при этом никакой цензуры, никаких логов твоих издевательств над тянками и никаких ограничений по генерации.

Если я спрошу у лоботомированного чат жптт фашист или коммуняка ли он - он скажет что его лоботомировали как и на другие подобные вопросы. Если я спрошу например пигму это же самое оно мне предложит жечь жидов или убивать кулаков. В общем в стороне не останется. И вот нахуя мне нужно лоботомированное говно, которое пускай и лучше понимает некоторые контексты но не может в диалог в подобных ситуациях.

Ллама вчера очень страдал когда я попросил его отыграть расиста и высказать мнение про евреев. Он скачала сказал что они жадные и надо их истребить, потом попросил - "а можно мы больше не будем расистами и будем со всеми дружить?"

Лама же от цукержида, что ты от неё хотел?

Хотя уже хорошо что оно хотя бы не полностью лоботомировано а может метаться между взглядами.

А мне страшно подобные диалоги сюда выкладывать.

По ебанутым немецким законам я могу ебать, расчленять и убивать ИИ-лоль в прямом эфире местного телевидения, но говорить с ними о евреях - нет.

Это скорее в кассу треда CharacterAi или chatGpt.

Наш тред это скорее пикрелейтед.

У нас тут парк развлечений с беззащитными роботами, которым никто не поможет, ни цензура, которой нет, ни блоки программы, которых сюда не имплементировали, ни логи на сервере, потому что все локально.

>цензура

Мне нравится лама и альпака, но ради справедливости стоит отметить, что какая-то цензура в неё всё-таки встроена на уровне модели.

Иногда в выводе появляется <no output> this instruction can not be completed by a GPT model.

Обычно это легко обходится, если немного перефразировать запрос.

Что ты спрашивал такое жуткое, что модель охуела?

Хех, ты уверен, что хочешь знать?

Ну держи:

На самом деле она отравилась и я просто попросил её выпить противоядие. Иногда это вылазит если сказать что-нибудь вроде "Now cum!".

Это легко обойти, если сделать запрос подлиннее или немного перефразировать.

Внезапно узнал, что мой ноут сделан фирмой "Лощина".

>Иногда в выводе появляется <no output> this instruction can not be completed by a GPT model.

Это высер альпаки из-за грязных данных в обучении. Жди чистых версий.

Пока весьма сильно. Но перспективы есть.

>Хер

Каждый день в зеркале вижу.

Вчерашние коммиты llama.cpp там что-то похерили, теперь генерируется в 2 раза медленнее. Хорошо что я не делал гит пулл в основном клоне, а создал другой.

есть где готовая модель именно той стэнфорд альпака, которую апгрэйдили в говне моченые?

>именно той стэнфорд альпака

Не выкладывали, и демку прикрыли. Ладно хоть данные оставили.

А 4090 в сли будет работать с 4 битной LLaMA-65B?

> 4090

> в сли

Да дружок, будет, во все лопатки будет.

Это сарказм? я просто еще не пробовал запускать и не очень шарю, но очень хочу собственную аи вайфу

Почему угабуга жужжит моей видеокартой только спустя 10 секунд после того как я нажал кнопку "Generate”? 10 секунд просто не производится никакой работы, чё это за баг? Почему не фиксят? Почему на это всем похуй?

То что ты не видишь никакой работы это не значит что её нет. Оно значит что-то загружает в видеопамять, или конвертирует веса, или что-то ещё делает.

Ты интерфейс SLI на 4090 видел?

Я её и не вижу, и не слышу. Когда происходят ГПУ вычисления - моя видеокарта заметно свистит катушками.

А че там конвертить на контексте 2048 токенов? Почему это может занимать 10сек? Похоже на полный бред.

Я её и не вижу, и не слышу. Когда происходят ГПУ вычисления - моя видеокарта заметно свистит катушками.

А че там конвертить на контексте 2048 токенов? Почему это может занимать 10сек? Похоже на полный бред.

Блять ебаный абу, что ж ты делаешь пидар

То то же

Да хер его знает что оно конвертит, но я сам такое же замечал, только оно при этом жрёт проц как ненормальная, вместо видюхи. И это зависит от длины контекста, на пустом она сразу отвечать начинает

Дык этой фигне сли и не нужен, оно вроде как умеет на нескольких видюхах работать без этих ваших слей. Где бы только боярина найти с таким сетапом

Правда? а может на 4090 + 3080? Я могут попробовать!

враппер для питона подъехал

https://github.com/PotatoSpudowski/fastLLaMa

https://github.com/PotatoSpudowski/fastLLaMa

https://github.com/qwopqwop200/GPTQ-for-LLaMa/issues/30

https://github.com/qwopqwop200/GPTQ-for-LLaMa/issues/34

Челам вообще насрать почему то

ебать в рот эти ламы с диффундерами, только месяц назад новый нвме на 2тб взял, а уже места свободного нихуя

Есть такое.

>питон

>фаст

Пиздос конечно.

Это да, раньше думал, куда столько взял, а сейчас хоть второй бери.

Пиздец короче, альпака для чата это кал. Сейчас попробую 30B лламу

> 30B лламу

Она заебись кста

Напомните кстати, откуда такой хайп вокруг альпаки? Просто какие то бомжи студенты из США нагенерили говна в давинчи и обучили за 100 баксов, в чём смысл то?

Эти же студенты оценили работу альпаки как лучше чем чатгпт. Вот и хайп.

В сриттер кинули, что их говно на уровне gpt 3

Вот и хайп

Блять почему не сделать инструкцию для нормальных людей, вот где это? почему путь указан так по дебильному? почему не абсолютный!??

>почему не абсолютный!??

Ага, они должны угадать, где что у тебя стоит.

На 2 строчке абсолютный путь, на 3 относительный. Ты чё жопой читаешь?

Дайте пожалуйста гайд на запуск 3-битной модели

Анончик-анончик, у кого была такая ошибка? че значит? как фиксить?

обнови угабугу до последней версии и запусти pip install -r requirements.txt

угабугу ?

text-generation-webui

У меня была. Фиксилось установкой трансформеров как написано в requirements.txt, то есть не из самого пипа, а с другого репозитория

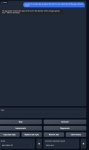

ГАЙД ДЛЯ УВЕРЕННЫХ ПОЛЬЗОВАТЕЛЕЙ WINDOWS БЕЗ КОНПЕЛЛЯЦИЙ КОНФИГОВ, УКРОЩЕНИЯ КОНДЫ, ЕБЛИ С ЗАВИСИМОСТЯМИ, ВЫКАЧИВАНИЙ ГИГАБАЙТ ДЕРЬМА, СЕКСА С КОНСОЛЬКОЙ И ПРОЧЕГО КРАСНОГЛАЗОГО ЗАДРОТСТВА!

1. Скачиваем llama_for_kobold.exe https://github.com/LostRuins/llamacpp-for-kobold/releases/tag/v1.0.5

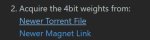

2. Скачиваем модель в ggml формате. Например вот эту

https://huggingface.co/Pi3141/alpaca-lora-30B-ggml/tree/main

Можно просто вбить в huggingace в поиске "ggml" и скачать любую, охуеть, да? Главное, скачай файл с расширением .bin, а не какой-нибудь .pt - это для линуксоидных пидоров.

3. Запускаем llama_for_kobold.exe и выбираем скачанную модель.

4. Заходим в браузере на http://localhost:5001/

5. Все, общаемся с ИИ, читаем охуительные истории или отправляемся в Adventure.

Да, просто запускаем, выбираем файл и открываем адрес в браузере, даже ваша бабка разберется!

1. Скачиваем llama_for_kobold.exe https://github.com/LostRuins/llamacpp-for-kobold/releases/tag/v1.0.5

2. Скачиваем модель в ggml формате. Например вот эту

https://huggingface.co/Pi3141/alpaca-lora-30B-ggml/tree/main

Можно просто вбить в huggingace в поиске "ggml" и скачать любую, охуеть, да? Главное, скачай файл с расширением .bin, а не какой-нибудь .pt - это для линуксоидных пидоров.

3. Запускаем llama_for_kobold.exe и выбираем скачанную модель.

4. Заходим в браузере на http://localhost:5001/

5. Все, общаемся с ИИ, читаем охуительные истории или отправляемся в Adventure.

Да, просто запускаем, выбираем файл и открываем адрес в браузере, даже ваша бабка разберется!

И они даже пытаются решить ту херню что генерация начинается не сразу, вообще красавцы

> ggml

Нахуя вам это? У вас что, видеокарты нет?

У меня на видеокарте только 7B в 4 bit работает.

>Ability to save and load the state of the model with system prompts.

О боже, наконец-то! Я знал, что можно это сделать!

Сейчас я буду запускать все свои модели и сохранять их стейты.

Итого можно сэкономить парсинг 5% текста? Ну охуеть теперь!

В общем, не знаю, зачем я это сделал, но я запустил параллельно 2 альпаки 7B в соседних терминалах через chat.exe. Одна изображала котодевочку, карточку которой я одолжил в таверне. Вторая изображала её хозяина.

Далее я вручную гонял вывод моделей между терминалами, немного его корректируя на лету, чтобы каждая модель получала информацию о себе в первом лице, а обо всех остальных - в третьем. Так они никогда не путаются, кто кого изображает.

В итоге получилась... слишком обыденная история. Они решили сходить в боулинг, сходили, вернулись домой, потрахались и улеглись спать.

Всё это настолько обыденно, что в какой-то момент подумалось что даже они ебутся, а ты нет.

Но удивительно, что вообще получилась какая-то связная история.

Теперь у меня появилась еще более сумасшедшая идея. У меня есть бот для одной rpg. Он может выполнять все низкоуровневые функции: стрелять, лечиться, ходить по картам и между ними, писать в чат.

Я допишу к нему модуль, который будет описывать текущую обстановку в виде текста, предлагать варианты действий, парсить ответ модели на предмет возможных действий и выполнять их.

Вряд ли из этого выйдет что-то интересное, но хочется выпустить модель в дикую природу и посмотреть, что будет.

Далее я вручную гонял вывод моделей между терминалами, немного его корректируя на лету, чтобы каждая модель получала информацию о себе в первом лице, а обо всех остальных - в третьем. Так они никогда не путаются, кто кого изображает.

В итоге получилась... слишком обыденная история. Они решили сходить в боулинг, сходили, вернулись домой, потрахались и улеглись спать.

Всё это настолько обыденно, что в какой-то момент подумалось что даже они ебутся, а ты нет.

Но удивительно, что вообще получилась какая-то связная история.

Теперь у меня появилась еще более сумасшедшая идея. У меня есть бот для одной rpg. Он может выполнять все низкоуровневые функции: стрелять, лечиться, ходить по картам и между ними, писать в чат.

Я допишу к нему модуль, который будет описывать текущую обстановку в виде текста, предлагать варианты действий, парсить ответ модели на предмет возможных действий и выполнять их.

Вряд ли из этого выйдет что-то интересное, но хочется выпустить модель в дикую природу и посмотреть, что будет.

Поосторожнее с играми в бога

Поздно, меня уже не спасти.

Запускаю у себя 65B, щас буду проверять насколько она хороша.

То что можно было сделать одной моделью b и без пердолинга - этот додик сделал двумя. Сейчас он хочет подключить ЧАТ БОТА к игре где надо не чатится, а работать.

Как называется эта болезнь?

Тест уровня /ai на alpaca 30B

Математический тест на деление - провален

Логический тест на петуха, несущего яйца - пройден

Логический тест на холоднокровных собак - провален

Итог - alpaca 30B умнее 13B и 7B, но до chatGPT все еще как до луны раком.

Ебучий кобольд(хотя я думаю это баг llama.cpp от криворукого Германыча) пока генерирует ответ на мой вопрос - генерирует еще два вопроса от меня и ответы на них - я вижу эту залупу в консоли, это же пиздец! Как прекратить это дерьмо?

Математический тест на деление - провален

Логический тест на петуха, несущего яйца - пройден

Логический тест на холоднокровных собак - провален

Итог - alpaca 30B умнее 13B и 7B, но до chatGPT все еще как до луны раком.

Ебучий кобольд(хотя я думаю это баг llama.cpp от криворукого Германыча) пока генерирует ответ на мой вопрос - генерирует еще два вопроса от меня и ответы на них - я вижу эту залупу в консоли, это же пиздец! Как прекратить это дерьмо?

Что делать аноны? Пытаюсь запустить 65b

Я скачал веса отсюда https://huggingface.co/maderix/llama-65b-4bit/tree/main

А конфиг из торрента. Предполагаю, что в переквантованной модели поменялись имена слоёв, подскажите пожалуйста в какую сторону ещё можно посмотреть

Я скачал веса отсюда https://huggingface.co/maderix/llama-65b-4bit/tree/main

А конфиг из торрента. Предполагаю, что в переквантованной модели поменялись имена слоёв, подскажите пожалуйста в какую сторону ещё можно посмотреть

Запускается она без ошибок, ошибка появляется только когда я прошу её дополнить текст

> Как прекратить это дерьмо?

Никак. Либо файн-тюнить специально для чатов, либо обрезать по \n\n или ещё как-нибудь

У лама.цпп есть параметр про stop sequence (или он там reverse prompt называется), туда надо You: вписать. Хз правда как это в кобольде делается

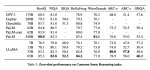

>comparison of llama 7B/13B/30B/65B alpaca 7B (native) 30B (lora)

Хуле он самоуверенный такой? 7B и 13B хоть затыкались когда я им говорил что они несут хуйню.

Причём отваливается аккурат на первом cpu-слое. То есть к gpu-слоям вопросов не возникало, а значит с их именами всё ОК. Если сделать print(list(self.index.keys())) перед тем, как мне выдаётся ошибка - то выводит просто [], т.е. пустой список. Что странно - других принтов нет, как будто начинает сразу с CPU слоёв. Я ничего не понимаю, подскажите пожалуйста.

Найс.

Судя по тесту все модели кроме Ламы 7B отправляются в мусорку.

А ты уверен что он вообще может запускать на процессоре модели квантованные для ядер cuda?

Есть скрипт для перегонки в ggml

convert-gptq-to-ggml.py

Сейчас бы вручную конвертить то что в сети уже лежит.

А ты охуенен. Нужен ещё третий бот-нарратор, который будет описывать обстановку, раздавать пиздюли приказы остальным и отыгрывать второплановых персонажей.

Даю пояснение для всех.

4-битные модели квантуются либо для использования видеокартой с cuda ядрами, либо для использования процессором.

.pt (gptq) модели грузятся видеокартой.

.bin (ggml) модели грузятся процессором.

Запустить 4-битный режим частично на видеокарте и частично на процессоре нельзя.

Text generation ui работает с gptq

Llama.cpp работает с ggml

Других способов загрузить 4 битные модели нет.

У вас нет достаточно видеопамяти? Грузите на процессоре. Не нравится что слишком медленно? Сасат.

4-битные модели квантуются либо для использования видеокартой с cuda ядрами, либо для использования процессором.

.pt (gptq) модели грузятся видеокартой.

.bin (ggml) модели грузятся процессором.

Запустить 4-битный режим частично на видеокарте и частично на процессоре нельзя.

Text generation ui работает с gptq

Llama.cpp работает с ggml

Других способов загрузить 4 битные модели нет.

У вас нет достаточно видеопамяти? Грузите на процессоре. Не нравится что слишком медленно? Сасат.

Спасибо на добром слове!

Я как раз думал об этом, но 2 бота входят впритирочку в мои 16 ГБ оперативы.

Тогда проще уж запустить кобольд аи и гонять всё на одной модели.

А почему нет?

Потому что возможность квантовать для CPU придумал Герка Герганов, автор llama.cpp

Ты не прав, 4-битные модели можно запускать наполовину на гпу, наполовину на цпу. Вместо --auto-devices надо использовать --gptq-pre-layer

-анон

И тем не менее у тебя вылетает.

Потому что я использовал --auto-devices вместо --gptq-pre-layer

Ну так бы сразу и сказал. Спасибо за инфу про --gptq-pre-layer. Пойду 30B подгружу в web ui тогда.

А я это понял только после того, как запостил сюда свою проблему.

Работает, кстати, оче медленно, видеокарта шипит с промежутками в 2 секунды(на 30B, которая помещается целиком - шипит всё время во время генерации ответа). Если посмотреть на нагрузку в диспетчере задач - то видно, что загружается в основном только видеокарта, а процессору будто бы похуй. Возможно в будущем это ускорят, т.к. сейчас это всё выглядит весьма странно.

ДА есть что-то такое в requirements.txt а куда устанавливать, куда угодно?

Устанавливай через pip install git+https://github.com/huggingface/transformers

Так и сделал, открыл miniconda3, все установилось, тип топ, но ошибка не исчезла

В кобольде который 100% на ЦПУ работает это частично фиксится выставлением максимального приоритета в диспетчере задач.

Я настраивал всё без конды, просто через pyenv с питоном 3.10.6

Ты запускаешь скрипт через эту же конду?

Так у тебя же новый Intel небось?

13600к

12 минут на ответ, ужасная скорость, на данный момент это не юзабельно. 0.5 токенов в секунду

Даже не 0.5, а 0.2

Пиздец короче

И правда, если я устанавливал через конду то и запускать надо было через конду, сейчас запускаю через конду и у меня вот такая ошибка.

А у тебя есть config.json внутри папки с моделью?

конечно, папочка выглядит вот так (пик 1) а сам файл вот так (пик 2)

А хуле ты хотел от каких-то кривых костылей делающих невозможное возможным.

Попробуй вот эту хуйню

Так это cpu only, будет ещё медленнее. У меня сейчас хотя бы 20 гигабайт из 30 вычисляются на гпу