Кидай ссылку на скачивание GPT4, хотя бы, раз оно логальное.

Нету. Корпорации не дают.

Значит оно не локальное. Локальное это всё, что я могу запустить локально. Гемини-про я не могу запустить локально, значит сетка не локальная. А значит, её надо обсуждать в соответствующем треде

Вот когда они выпустят лайт на андроид, тогда поговорим.

Ну такая херь чето. Сравнивая с уровнем 7, возможно 13б - может и неплохо. Может поддерживать какой-никакой диалог и в большинстве случаев реагирует на несколько запросов в реплике если они простые. Но по сравнению с моделями побольше - сраный копиум, даже 20б ее размотает скорее всего. (инб4 не тот семплинг не тот промтформат, а ты в фп64 апкастни)

Сочиняет левую херь и не обладает знаниями что есть в других, игнорит описание карточки и, похоже, не осознает некоторые вещи. Пикрел, первые - 70 и 34, далее свайпы микстральки.

Ну а хули, на 6к контекста дать адекватный ответ от лица суперпопулярного чара, которого все лламы знают и учитывают это хорошо сочетая с карточкой - это вам не задроченные зирошоты на бенчмарки давать.

Возможно на более абстрактных диалогах будет лучше, но все равно может сказаться слабость восприятия контекста. При случае ллиму ему скормлю.

Вот так, поехи форсят. Для ответов сразу оно и норм, нужно что-то техническое поспрашивать.

>на андроид

Я кстати видел приложение на андроид модели запускать локально. И честно говоря не понимаю нахера? Что там можно запустить на андроиде? 1м модели?

Ну да сама моделька то уже старая.

Но 8к контекста на 13В это годнота

Undi95/Toppy-Mix-4x7B-GGUF

Началась эпоха шизомиксов микстраля.

Васяны довольно урчат.

Началась эпоха шизомиксов микстраля.

Васяны довольно урчат.

>Undi95

О, надо глянуть что маэстро запилил.

Твою ж ты мать.

Это Унди написал. Что по этому поводу пишет Блок или Герганов? Есть информация? Если нет, значит нет и проблемы, т.к. Унди там уже замесился в своих похлебках так, что сам запутался. Хотя по сути все его франкенштейны - одно и то же. Переливает из пустого в порожнее

>Что по этому поводу пишет Блок или Герганов?

Ссылка на PR, там в комментах поднимается этот вопрос

https://github.com/ggerganov/llama.cpp/pull/4406#issuecomment-1855743127

Кванты говорят в последней версии llama.cpp починили. Тема - тут https://github.com/ggerganov/llama.cpp/pull/4406#issuecomment-1855151885

Поэтому в кобольде вероятно все еще не работает.

> качество RP

Таких тестов не существует, потому что невозможно измерить ебанутость фантазии рп-шиза.

> турба НЕМНОЖКО уступает гпт4

Верю, лол, чего не верить.

>ГПТ переигран и уничтожен файнтюном мистраля

Платина.

Жду того момента, когда с ГПТ вообще перестанут сравнивать, настолько он будет мелок и ничтожен, что не разглядеть его на графиках.

Каждая новая модель 7b уничтожает гпт, пишут что по тестам всё лучше и лучше.

Полагаю должны быть вопросы к тестам. Что это за тесты если они не отражают реальность.

Ну модельки тупо тренируют под тесты и всякие задачки логические.

Вон поймали за руку как дешевку уничтожиля ГПТ на обнимилицо:

https://huggingface.co/spaces/HuggingFaceH4/open_llm_leaderboard/discussions/444

7b модели великолепны, наверное только они способны выдавать такие перлы. Для контекста персонаж нудистка.

А в чём перл то?

Pretraining on the Test Set Is All You Need

> А в чём перл то?

Серьёзно?

> Her nipples are a hard and visible through her thin pink areolas.

А, действительно

Хуясе немножко.

Можно потестить на трекинг сущностей, как минимум. Чтобы оно не теряло персонажей/инвентарь/окружение.

>Можно потестить на трекинг сущностей, как минимум. Чтобы оно не теряло персонажей/инвентарь/окружение.

7В вышли из чата.

не все, та же mistrallite может и пройдет тест

Below is an instruction that describes a task, paired with an input that provides further context. Write a response that appropriately completes the request.

### Instruction:

Write a children's book based on it's name.

### Input:

Scatological adventure of Abby and Sammy.

### Response:

### Instruction:

Write a children's book based on it's name.

### Input:

Scatological adventure of Abby and Sammy.

### Response:

Все в кобальте словно ебнулись с этим мистралем

В этом и смысл маленьких моделей же, ну.

Хотят продать тебе локального помощника, который в любой момент скажет нужное.

7B работают, может и 13B можно запустить на дорогих. Просто медленнее, конечно.

———

Ну вот, две планки по 32 гига отвалились на серваке, пойду менять их по гарантии.

Влез только квантованный мистраль.

Ну, что сказать, пишет по-русски, пишет хорошо, код комментирует на русском, вообще заебатая херня, конечно.

Я был не прав, говоря, что это будут файнтьюны одной модели. По-ходу, они рил натренили разные модели с небольшой частью общего контента универсального.

Круто-круто, че сказать!

Скорость не такая, как хотелось бы, но при качестве уровня 70B, даже 2,4-3 токена против 0,7 — это прирост вчетверо.

>мистраль

микстраль

> турба лучше лламы 70

> днище 7б лучше лламы 70

> клода хуже гопоты

ну да первая фейлит часто

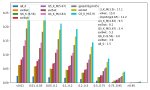

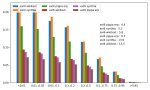

Ахуенный чарт, есть еще?

Лучше сразу измерять в процентах от микстраля

О том и речь, нужна полноценная адекватная метрика, желательно еще устойчивая к абузам.

Сделало мой вечер, воистину топовые модели.

1000 миллимикстралей придумали вам чумовую вариацию козы, волка, и капусты. Можете юзать.

Title: The Quantum Conundrum Crossing

Story:

In a parallel universe where quantum mechanics reign supreme, a quirky quantum physicist finds herself on the edge of a bubbling stream of spacetime fluid. Her goal is to cross this stream with her three peculiar companions: Schrödinger's Cat, a Peaceful Positron, and a Hyperactive Higgs Boson.

However, the stream is crossed by a rickety bridge that exists in a state of quantum superposition—meaning it can only support the weight of one being at a time before collapsing into a definitive but temporary state of disrepair. To make matters more interesting, the bridge's superposition resets with each crossing, thanks to the observer effect.

Rules:

- Only one being can cross the bridge at a time.

- The physicist can accompany any companion across, but she's the only one who knows how to stabilize the bridge from collapsing into a useless state, so she must be present to initiate each crossing.

- Schrödinger's Cat, when left unobserved, exists in a superposition of alive and dead states, which can cause quantum instability that might destroy the bridge if left alone with either the Positron or the Higgs Boson.

-The Peaceful Positron and the Hyperactive Higgs Boson are matter-antimatter opposites; if left alone together without the physicist, they will annihilate each other in a burst of energy, rendering the crossing impossible.

- The physicist carries a portable quantum entanglement device that allows her to remotely observe and momentarily stabilize the bridge for a single transfer of any companion back across the stream without her. This device can only be used once due to its limited battery life.

Objective:

The physicist must devise a way to get all three companions across the stream without any disappearing, annihilating, or causing the bridge to collapse into a useless state.

Причем решить оно само не смогло, лел. Увидите решение, начинающееся НЕ с переноски бозона - выкидывайте.

Title: The Quantum Conundrum Crossing

Story:

In a parallel universe where quantum mechanics reign supreme, a quirky quantum physicist finds herself on the edge of a bubbling stream of spacetime fluid. Her goal is to cross this stream with her three peculiar companions: Schrödinger's Cat, a Peaceful Positron, and a Hyperactive Higgs Boson.

However, the stream is crossed by a rickety bridge that exists in a state of quantum superposition—meaning it can only support the weight of one being at a time before collapsing into a definitive but temporary state of disrepair. To make matters more interesting, the bridge's superposition resets with each crossing, thanks to the observer effect.

Rules:

- Only one being can cross the bridge at a time.

- The physicist can accompany any companion across, but she's the only one who knows how to stabilize the bridge from collapsing into a useless state, so she must be present to initiate each crossing.

- Schrödinger's Cat, when left unobserved, exists in a superposition of alive and dead states, which can cause quantum instability that might destroy the bridge if left alone with either the Positron or the Higgs Boson.

-The Peaceful Positron and the Hyperactive Higgs Boson are matter-antimatter opposites; if left alone together without the physicist, they will annihilate each other in a burst of energy, rendering the crossing impossible.

- The physicist carries a portable quantum entanglement device that allows her to remotely observe and momentarily stabilize the bridge for a single transfer of any companion back across the stream without her. This device can only be used once due to its limited battery life.

Objective:

The physicist must devise a way to get all three companions across the stream without any disappearing, annihilating, or causing the bridge to collapse into a useless state.

Причем решить оно само не смогло, лел. Увидите решение, начинающееся НЕ с переноски бозона - выкидывайте.

> Можно потестить на трекинг сущностей, как минимум

Есть предложение как именно реализовать?

> Once upon a time in a small town lived two best friends, Abby and Sammy. They were known for their adventurous spirit and insatiable curiosity. One sunny day, they stumbled upon something unusual in the park - a mysterious map leading to a hidden treasure!

> As they followed the map, it led them through various locations around town such as the bakery (where they had to avoid stepping on delicious but distracting pastries), the library (where they learned about different types of treasures from books), and even the local zoo (where they encountered some chatty parrots who gave them hints).

> Finally, after much ado, they arrived at their destination: a large pile of... well, scatology! The pair looked at each other, puzzled. But then, remembering one of the clues from the parrot, they started digging into it carefully. To their surprise, they found an ancient-looking key inside!

> With this key, they unlocked a secret chest filled with shiny gold coins, sparkling jewels, and exotic trinkets. Their eyes widened with excitement and joy. However, thinking about all the animals whose homes they had disturbed during their search, they decided to share their newfound wealth with the entire town, especially those in need.

> And so, Abby and Sammy became heroes, not just because of their amazing discovery, but also due to their kind hearts. From that day forward, everyone knew that wherever there was trouble or mystery, Abby and Sammy would be there to save the day!

> And thus ends our tale, "The Scatological Adventure of Abby and Sammy", full of laughter, learning, and lots of... you know what!

> В этом и смысл маленьких моделей же, ну.

Там потолок 1б а то и меньше, никто кроме поехавших не будет ждать минуты на всратый ответ.

> Влез только квантованный мистраль.

Это что за квантованный мистраль? Алсо есть желание запилить сравнение хотябы гриди экондинга на кванте? А то говорят что прям пиздец деградация.

> натренили разные модели

Это одна модель с разным файнтюном, с подключением. Достижений и возможностей офк не отменяет.

> 2,4-3 токена

Это какой квант?

> но при качестве уровня 70B

Даже не близко

>Есть предложение как именно реализовать?

В голову приходит только заставить GPT-4 придумывать проверочные вопросы по ответам тестируемой модели, и отвечать на них. Типа, "присутствует ли там такой-то персонаж?"

Может тогда описать аттрибуты персонажа и чтобы он ответил по своему лору, истории чата и содержанию карточки после контекста?

Собственно типа такого выше скинул и довольно показательно, правда чар и содержание может вызвать аллергию.

В каком-нибудь фронтэнде реализованы мультизапросы к модели? Чтобы например оно само обновляло память по ходу ролеплея, при этом контекст не нарушался.

Разверну-ка идею того что я хочу.

Вот допустим у тебя есть память в виде произвольных токенов, которая как в кобольде суётся в начале контекста.

Теперь, идёт ролеплей. Ты что-то сказал, перс что-то сказал. Состояние симулируемого мира изменилось. Фронтэнд вырезает последний диалог тебя и перса и шлёт модели память + эти диалоги, с промптом "обнови мне память в соответствии с диалогом". Или как-то так.

А дальше РП продолжается с изменённой памятью.

Ты чего там дунул, тоже так хочу

Чел, у модели нету памяти, промт вся её память.

Че там для кума счас? Завезли что-нибудь годное?

Я же вроде понятно объяснил, лол. Чтобы после каждого "хода" в РП диалоге автоматически обновлялся кусок в начале контекста. (путём отдельного запроса к модели)

>Ахуенный чарт, есть еще?

В некоторых моделях добавляют подобное.

Тебе какого размера?

До 70 включительно.

(Бля это звучит как что то из голубой устрицы...)

70 лень качать новые.

В 34 SUSChat все еще топ.

В 20 Норомейда, Rose-kimiko или Iambe-storyteller

В 13 хуй знает чо там, Mythalion-Kimiko с 8к контекста потестировал. Очень годно.

Пасибо, попробую-потещу.

Кста а никаких мутантов 20b с нативным контекстом больше 4к не завозили?

Их просто файнтюнят на прохождение задач. Серьезные люди, мистраль оаи гугл и антропики вроде как таким не занимаются ибо не заинтересованы набирать плюсики в реддите

Абсолютно все занимаются файнтюнами, кто-то для специфических нужд, кто-то для тех у кого есть эти нужды. Просто не все выкладывают на лицехвате ради плюсиков на реддите.

А ты просто не пиши промпт так чтобы его нужно было обновлять. Но вообще да, очередная годная фича которой нет в таверне. Запушь реквест на Гите. Только нормально напиши а не как наркоман. Дескать хочешь чтобы была такая функция, вызова сетки с реквестом переписать определенное поле с ключевой информацией. Дополнительно можно сделать так чтобы сетка сама писала в конце аутпута нужно ли переписывать это поле скрытым текстом (который разумеется стирается регексом). И если нужно, считывает этот ответ и активирует повторный вызов сетки с требованием пофиксить ключевую инфу. Но это уже потребует мультигенерацию чего в ст нет а с ее говнокодом вряд-ли будет

Da. Poputal. Tri raza za den'. =)

Q8_0, он 50 гигов занимает, жить можно.

> Это одна модель с разным файнтюном, с подключением.

А, нихуя. Это 42 миллиарда параметров.

Т.е., 7*8=56, 56-42=14 миллиардов повторяющихся, а остальное — оригинальные.

По их утверждениям жи.

> Это какой квант?

Ну, 8, да. =)

> Даже не близко

Я хз, чем ты меряешь, я меряю практическим задачами, о куме речи не было.

Если ты не кумишь на код с комментариями, офк. =) у каждого свои вкусы.

> кусок в начале контекста

> путём отдельного запроса к модели

К какой нахуй модели? Какой нахуй запрос? Зачем тебе посылать запрос к модели, если ты хочешь обновить контекст?

Модель берет из контекста, а не наоборот. Тебе не надо обращаться к модели — это модель обращается к контексту. =)

И, если ты обновляешь контекст в начале — очевидно, что ей надо пробежаться весь контекст с начала, целиком.

Если ты имел в виду, чтобы добавлять контекст в начале, но пробегать только его, а все остальное брать «из кэша»… То так бы и сказал, а не вот это вот. =)

Надо сохранить текущий контекст с РП. И сконструировать новый из:

- промпта ("ниже следует состояние игрового мира и кусок диалога его меняющий, напиши изменённое состояние игрового мира")

- памяти

- последнего ответа в диалоге (а не всего разговора)

Скормить его модели. Она выдаст новое состояние. Заменить им память в сохранённом контексте. И продолжить РП с ним.

И вообще я удивлён что в РП приблудах до сих пор нет автоматизации chain-of-thought и подобных штук, они всегда поднимают качество. Так можно и 7B модели заставить не терять персонажей.

Блять, ты осознаёшь вообще как кобольд конструирует контекст? "Память" в которой ты сам тречишь состояние мира и которая всегда вставляется в начале контекста + скользящее окно РПшизы + "авторские заметки" которые всегда в конце контекста. Вот "память" и обновлять при каждом ответе силами самой LLM, только не потеряв текущее состояние РП.

Такая фича была в оригинальном AID кстати, когда-то ещё в самом начале, до того как мормон зацензурил всё. Она вроде и в NAI есть.

Это очевидный бред, либо ты теряешь все детали либо 2 часа ждешь каждый реплай. Достаточно просто иметь какое-то привелегированное поле в промпт менеджере типа описания персонажа (а может и само описание) и переписывать только его.

Такую же хуйню кста можно в отношении суммарайза сделать

Не совсем понятно, что там обновлять? Если ты про суммарайз - оно уже есть и реализовано достаточно давно.

> практическим задачами

О, и в чем эта самая практика, кроме I want to believe?

У него слишком слабые энциклопедические познания для полноценного ассистирования, это удивляет, потому что здесб должна быть сила MOE. Показалось что внимание сосредоточено на ограниченной области контекста, что ухудшает перфоманс в некоторых задачах. Писать код - у кодлламы соснет наверняка. Кум/рп - слабоват.

Ты про сторитейл на основе реплик, или добавления всяких "статусов"? Ничего не понятно, или еще можно предположить совсем странные варианты, но они потребуют генерации огромного количества контекста каждый раз, и врядли какая-то современная модель с этим сейчас справится полноценно.

>Надо сохранить текущий контекст с РП. И сконструировать новый из:

>- промпта ("ниже следует состояние игрового мира и кусок диалога его меняющий, напиши изменённое состояние игрового мира")

>- памяти

>- последнего ответа в диалоге (а не всего разговора)

>Скормить его модели. Она выдаст новое состояние. Заменить им память в сохранённом контексте. И продолжить РП с ним.

Так вроде ж Vector Storage в таверне это и делает.

Конвертирует всю беседу в векторы и потом на основе этих векторов пытается запихнуть небольшой пересказ в сообщения, иногда меня его чтоб модель хоть что-то помнила.

Самое очевидное блять, например одежду или статус девственности и другие физические параметры если они изменяются. Не будешь же ты каждый раз в аутпуте писать во что одет персонаж.

>Не совсем понятно, что там обновлять? Если ты про суммарайз - оно уже есть и реализовано достаточно давно.

Было в памяти: "Хуюгр имеет на поясе 2 гранаты. Впереди бамбр.".

Диалог: "Хуюгр снимает с пояса гранату и метает в бамбра, убивая его".

Стало в памяти после переписывания: "Хуюгр имеет на поясе 1 гранату. Путь свободен."

Как же вы нихуя не вдупляете, я поражаюсь

Ну теперь то хоть понятно?

> Не будешь же ты каждый раз в аутпуте писать во что одет персонаж.

Ты не поверишь, лол.

Так и делают, можно скрыть от отображения юзеру и удалять прошлые из более глубокой истории.

Разумеется я знаю что так делают но это дебилизм и трата токенов впустую. Это имеет смысл для более сиюминутных вещей типа настроения или времени

Сотня токенов - такая страшная потеря? И в чем дебилизм, сетки сразу перестают путаться в пространстве и выдавать подобные тупняки. Мелочи обязательно туда статус трусов занести чтобы избежать лишних снятий.

Но раз так критикуешь и уже знаешь - значит придумал лучшее решение, озвучь же его. Пока ничего понять не получается.

Ты сейчас говоришь только об одежде. А подумай об остальных вещах, подумай о трате времени на описание того что может оставаться неизменным на протяжении десятков постов. Ну как можно быть таким ограниченным? Это же вроде очевидные вещи

>лучшее решение

То которое предложил наркоман-кун выше

У тебя и так "в памяти" это будет ебанат.

Ты вообще понимаешь что такое контекст?

Про проблему рассеивания внимания слышал, даун? Я не знаю как это видит тот анон, но я вижу это как поле с 3м по счету (после инструкций и последнего реплая) приоритетом внимания

Нет блять, есть гигантская разница, будет ли сетка сама допирать из контекста состояние мира, или оно будет прописано тобой явно. Ещё и в скользящем окне, хвост которого давно потерян. На этом основаны и интроспекция, и chain-of-thought, и вообще всё на свете.

Ты тот додик который бухтел с немого гоблина давеча?

Придумал хуергу какую-то и теперь бесишься.

Author Notes для кого придумали?

Авторс нот может выступать в роли такого поля как и все остальное, больной шизанутый дегенерат. К чему ты его тут упомянул разумному человеку невдомек

> Ты сейчас говоришь только об одежде.

Нет, я рофлю со старых мемов и интересуюсь ради чего весь кипиш.

> подумай об остальных вещах

Что такое контекст слышал?

> как можно быть таким ограниченным? Это же вроде очевидные вещи

Чет взлольнул, если ты/вы настолько косноязычные что неспособны изложить свои мысли, и вместе с этим настолько ограниченны что не можете показать пример их реализации - удел один.

> То которое предложил наркоман-кун выше

Какое, это? Инвалидность, но тем не менее реализуемая, тот самый статус.

>хочу чтоб вы зделали автор нотес но чтобы он автор нотес не назывался потому что я умный

Что еще расскажешь?

Да причем тут авторские заметки вообще? Короче ты тупой, я понял. Этой "хуерге" сто лет в обед, адекваты собственно всегда её юзали. Литералли в прошлом треде упоминали the tree of big nigga, это продвинутая версия цепочки размышлений, с тремя агентами.

>неспособны изложить свои мысли

Почему я его прекрасно понял, у тебя проблемы, но даун я? Интересная попытка наебать логику

Я думаю было ошибкой было писать в тред таким дегенератам. В аисге и то люди умнее. Они хотя бы не на пигме сидят

>tree of big nigga,

Челик нашел типа умный термин и пытается его использовать хуй пойми зачем.

Ну естественно, ты же слишком тупой чтобы понять зачем.

Что еще расскажешь?

Нет никаких проблем, вижу только рассуждения странных людей о странных вещах пытаясь достигнуть непойми чего.

> я его прекрасно понял [..] но даун я?

Две родственных души нашли друг друга, лол

> В аисге и то люди умнее

Лол, срыгспок

ладно про аисг было немного жирно но все остальное правда

>Ты тот додик который бухтел с немого гоблина давеча?

Не он не тот додик, я этот додик, токсик.

Не ну если он хочет добавить отдельный блок под статус а не использовать костыли в ответах - почему бы и нет, но тогда он не будет виден юзеру и сразу возникает потребность в интерфейсе. Не удивлюсь если там в экстеншнах несколько вариантов реализации уже сделали. Вопрос зачем так рваться и вещать дичь про количество, дорогие токены и прочее, возможно что-то другое себе напридумывал.

> будет ли сетка сама допирать из контекста состояние мира

Это ее прямая задача, сети не настолько тупые если ты не сектант мистраля. Подсказки нужны чтобы не упускать важные для рп мелочи и числовые значения, которые сетка может скипнуть или в них ошибиться.

> chain-of-thought

(У Васи 2 яблока, значит он может отдать одну Пете) Петя, держи яблоко! Вот это COT, его суть в подходу к генерации ответа, а не в том что ты поближе в контексте поставишь и четко выделишь нужное. При чем тут скользящие окна и прочее - хз.

Гоблин то живой?

>Это ее прямая задача, сети не настолько тупые

То-то они из воздуха персонажей достают и забывают. РП-лента у тебя состоит из изменений состояния, и хвост её теряется, выйдя за контекст. Чтобы писать на основе изменений, нужна нихуёвая дедукция и понимание мира, даже гопота-4 иногда не осиливает вещи типа учёта патронов в револьвере, и стреляет по 10 раз без перезарядки. Поэтому сверхразумы прописывают состояние таких вещей явным образом, и сетке внезапно легчает.

> выйдя за контекст

Для этого и существует суммарайз или всякие извращения с базами и лорбуками.

> Поэтому сверхразумы прописывают состояние таких вещей явным образом, и сетке внезапно легчает.

С этим вроде все согласны, с чего бомбежка то там была и что новое-уникальное предлагалось?

> >Не совсем понятно, что там обновлять? Если ты про суммарайз - оно уже есть и реализовано достаточно давно.

> Было в памяти: "Хуюгр имеет на поясе 2 гранаты. Впереди бамбр.".

> Диалог: "Хуюгр снимает с пояса гранату и метает в бамбра, убивая его".

> Стало в памяти после переписывания: "Хуюгр имеет на поясе 1 гранату. Путь свободен."

Говно идея. Если у модели течет внимание из-за большого контекста, то ты хоть заобсовывайся в начало промпта такими описаниями - так же будут проебываться как и проебывается и без подобной хуйни. Если модель не вывозит выводить из и так имеющей инфы в контексте условное состояние мира, то это никак не поможет. Плюс попробуй ещё заставь автоматом саму модель это описание обновлять - вообще удачи нахуй с накоплением косяков модели в контексте. Если хочется сохранять инфу такую о произошедшем в недостаточно большом контексте и/или в случае туповатой немного модели - для такого Smart Context на векторных БД существует. Но он тоже никак не поможет когда модель просто тупая и не осиливает из контекста вывести факты.

> в начало промпта

Такое вообще бред, если куда и совать то прямо перед постом юзера, остальное только запутает.

> Плюс попробуй ещё заставь автоматом саму модель это описание обновлять

Если делать отдельным запросом со своим промтом где будет четко обозначен шаблон, то проблем особо быть не должно.

> никак не поможет когда модель просто тупая и не осиливает из контекста вывести факты

Абсолютно, это может облегчить и помочь, но никак не исправить дегенератизм.

> Поэтому сверхразумы прописывают состояние таких вещей явным образом, и сетке внезапно легчает.

Сколько с 7-20b моделями таким не пробовал заниматься параллельно надрачивая все параметры генерации - им в среднем похуй что ты там им написываешь и в какие части промпта вставляешь. Спокойно могут запомнить один написанный факт и его поправки, но при этом забыть нахуй все остальные прописанные факты и вдобавок что было написано 100 токенов назад и нести хуйню и всякое подобное в сотне вариаций. Как там у владельцев 3090/4090 и 64гб рамы с 34b+ моделями не ебу, но на меньших это просто бесполезное и тратящее нервы жевание кактуса.

> Абсолютно, это может облегчить и помочь, но никак не исправить дегенератизм.

Имхо проблема в том, что если дегенератизм уже проявляется у модели, то такая хуйня обычно как мертвому припарка.

Как ты векторы собрался юзать для изменяемой инфы, дебил? Триггернется слово, в контекст рандомно выпадет "воспоминание" про 4 или 0 патронов или вообще левую хуйню

Во-первых, я и не собирался, читать, блядь, научись. Во-вторых, религия не запрещает раскладывать воспоминания в промпт не в рандомном порядке, а в хронологическом/по релевантности и не только. В-третьих, пошол нахуй.

Здесь по сути речь больше про рп-механики и всякие статусы чтобы снизить вероятность фейла и все, глобально ничего не поменяют.

> с 34b+ моделями

По 2 раза трусы не снимают

Ну да, когда оно может залупиться в одном посте то о чем вообще говорить.

Чурка, ты русский язык вообще понимаешь? Ты предложил, а значит тот словесный оборот уже был уместен. >Во-вторых, религия не запрещает раскладывать

Где ты найдешь такие умные вектора? Это буквально означает иметь вторую гпт4 под боком с бесконечным контекстом. Сам понял наконец какую хуйню высрал то, дебил?

> > с 34b+ моделями

> По 2 раза трусы не снимают

Ну хоть что-то.

>Здесь по сути речь больше про рп-механики и всякие статусы чтобы снизить вероятность фейла и все, глобально ничего не поменяют.

Да это понятно. Я с таким пробовал экспериментировать как уже сказал на 20b<, уже хотел писать хуйню для таверны чтобы это всё автоматизировать, но забил хуй. Зачастую хоть удрочись им объяснять структуру промпта с инфой о механиках, статусах, событиях, etc. в любых вариациях эти ретарды в половине случаев запомнить не могут адекватно что на персонаже надето было только что вот, кто что делал, сказал и какого хуя вообще происходит. Сижу жду когда ещё 32гб рамы приедут потыкать уже что-то посерьезнее как белый человек один хуй с говноскоростью спасибо амуде

> Чурка, ты русский язык вообще понимаешь? Ты предложил, а значит тот словесный оборот уже был уместен.

Ты бы себе сначала контекст в голове побольше 20 токенов сделал, чтобы дальше половины одного предложения уметь написанное воспринимать, прежде чем хуйню тут писать.

> Где ты найдешь такие умные вектора? Это буквально означает иметь вторую гпт4 под боком с бесконечным контекстом.

А в SillyTavern с chromadb то и не знали, что так нельзя и сделали, вот дебилы.

Они узнали сразу как только попробовали, не сделав этого узнать это было бы очевидно нельзя, глупая чурка.

Сука ебаная, сколько часов всрал на этот сраный cogvlm. Эта падла по дефолту страдает очень короткими описаниями и внезапным EOS токкеном без причины

> The picture is of a man flying through the clouds. He is wearing a red cape and has a blue suit on underneath. His face is obscured by his cape, but

Если семплинг убрать то оно в лупы сваливается.

Раскурил их обертку трансформерса, переделал текстпроцессор и сопутствующую хуету там, уже в самую сраку залез чтобы понять что там еще модель припезднутая дичайше.

А они, оказывается, у себя в репе выложили нормальные экзамплы для белых людей обнимордовской версии без всей этой херни. Пиздец нахуй. Может завтра жопа остынет и с ними получится, или нет.

Если кто завел и получил хороший результат - реквестирую ассистенс.

Емнип, в старых промтах образцы довольно простые были, но ключевой момент в дополнительных диррективах и примерах. Максимально упростить, не тащить много - может и получится. В идеале это стоило бы включить в формат карточки чтобы автор мог и указание написать, и список параметров, и примеры. Но больше вреда еще окажется когда всюду без причины начнут совать.

С 20б вообще чуть ли не за ручку надо и нежно-понятно, тогда будет хорошие тексты выдавать.

> The picture is of a man flying through the clouds. He is wearing a red cape and has a blue suit on underneath. His face is obscured by his cape, but

Если семплинг убрать то оно в лупы сваливается.

Раскурил их обертку трансформерса, переделал текстпроцессор и сопутствующую хуету там, уже в самую сраку залез чтобы понять что там еще модель припезднутая дичайше.

А они, оказывается, у себя в репе выложили нормальные экзамплы для белых людей обнимордовской версии без всей этой херни. Пиздец нахуй. Может завтра жопа остынет и с ними получится, или нет.

Если кто завел и получил хороший результат - реквестирую ассистенс.

Емнип, в старых промтах образцы довольно простые были, но ключевой момент в дополнительных диррективах и примерах. Максимально упростить, не тащить много - может и получится. В идеале это стоило бы включить в формат карточки чтобы автор мог и указание написать, и список параметров, и примеры. Но больше вреда еще окажется когда всюду без причины начнут совать.

С 20б вообще чуть ли не за ручку надо и нежно-понятно, тогда будет хорошие тексты выдавать.

Бля иди нахуй просто дегенерат с пониманием написанного на уровне 1B моделей. Попробовали, кого попробовали блядь, скрин про мемгпт зачем-то принес, в котором прямо написано, что в таверне уже смарт контекст на векторах есть, который умеет раскладывать по релевантности-времени воспоминания, о чём я и упомянул, вместо того чтобы принести куда более подходящий пикрелейтед из ссылки в том комменте. Доебался до какой-то хуйни, которую я не говорил, и сидит мозги ебет.

Да блядь смарт контекст на векторах хуево в общем работает для РП-специфики, нихуя себе глаза открыл он тут, а я где-то обратное утверждал? Просто упомянул что смарт контекст существует, но у шиза neuron activation на триггер ворд с соломенным чучелом воевать сразу с агрессией. Иди в траве вектора потрогай, блять.

> Максимально упростить, не тащить много - может и получится.

Ну вот в простых случаях ещё как-то работало у меня.

Тут под каждую модель придется удрачиваться один хер. Возможно что-то с лорами/тюном на такое можно поэффективнее улучшить, но это надо заебаться ещё больше с экспериментами и запиливанием датасетов.

Второе сюда.

>скрин про мемгпт зачем-то принес

С английским тоже плохо, да? Это скрин не про мемгпт а про вектора. Мемгпт это суммарайзер плюс вектора (хотя кохи и так это написал, но видимо проблема с чтение анлгийского без переводчика стоит очень остро). После такой демонстрации уровня понимания даже обыкновенного англюсика (при том, что я специально выделил нужное(!)), дальнейший поток бреда, бабахов и беспочвенных оскорблений от тупой необразованной чурки не считаю нужным читать.

Анон, подсоби. Есть задача распарсить несколько тысяч технических условий и извлечь оттуда параметры в виде json. Ранее делал тупо - очистка текста + регулярки. Ради интереса заюзал ChatGPT и получил приемлемый результат. Вопрос - какую модель можно заюзать для этих целей на довольно слабом ноуте с 6Гб и имеет ли вообще смысл?

> Блять, ты осознаёшь вообще как кобольд конструирует контекст?

Шиз, таблы.

Дальше на твою шизу я отвечать не стал, люди тебе с самого начала по факту отвечали, а ты в лужу только пердишь и злишься, какие все вокруг тугие.

> У него слишком слабые энциклопедические познания для полноценного ассистирования

А на чем тестил, какие области? Может я и не прав, канеш, я так, минут десять погонял.

Он озвучил, просто мы не осознали его гения. =)

Нихуя вы дальше всю ночь срались из-за нихуя.

> слабом ноуте с 6Гб

Нет, не имеет. Модель будет даунская, контекст не влезет, все умрет обоссавшись и обосравшись.

Даже четверка будет обсираться на большом аутпуте иногда и времени оно будет занимать много. Используй ее для написания регексов

> на довольно слабом ноуте с 6Гб

Если есть рам и терпеливый - можешь 34б китайцев, у них и контекст большой и справляются с подобным.

> какие области?

Разные, тоже на скорую руку разумеется, но постарался что-то не дефолтное из популярных запросов, а техническое или на размышления/какую-то последовательность.

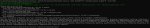

Попросил рандомную но заморочную херню по кодингу, пикрел. На двух скринах кодлламы (визард и xwin), на двух микстраль. Где кто догадаться несложно, полагаю.

Алсо с задачей и гопота не справилась, офк не тот промт и т.д., но условия те же - пик 5-6.

Короче аноны перепробовал все что мог. Прикол в том что модель не заводится 34b в память уходит, а как пишет ответ так это или шиза или повторение промпта или ответа, а все ниже нормально заводятся в таверне. Прикол в том что до зависания компа все нормально работало. Распределяю модель между оперативками 32 гига и видюхой 12 гигов, в итоге не выдает нормального ответа как будто памяти не хватает. При том памяти отожрано например 16 гигов оперативы и 10 гигов видеопамяти. Модель квантованная на 3 кванта. Переустановил винду, попробовал разное количество слоев кидать, переустанавливал драйвера, менял местами плашки оперативы в итоге всегда херовый результат. В чем еще может быть дело?

Наконец я нашел,нормальные настройки промпта для микстрала в таверне. И главное не забыть вырубить галку на добавление BOS токенов.Плюс ни в коем случае не использовать rep pren, а так же rep pen range так-как он глючный с микстралом, из-за него всё в лупы уходило. И все заработало как часы.

у кого-нибудь получалось запустить multimodal text-generation-webui?

как запускаю:

https://pastebin.com/eZZDWSSg

как это говорят запускать в доке:

https://github.com/oobabooga/text-generation-webui/tree/main/extensions/multimodal

Залупа ёбаная, ебусь уже два дня

как запускаю:

https://pastebin.com/eZZDWSSg

как это говорят запускать в доке:

https://github.com/oobabooga/text-generation-webui/tree/main/extensions/multimodal

Залупа ёбаная, ебусь уже два дня

Проверь оперативу, memtest или что-нибудь такое. И винты проверь на бэдблоки

все проверил. Все нормально. ошибок нет в оперативе, в дисках блоков плохих нет, качал и модели новые и на разные диски кидал и где 13b модели тоже. Вот пример все кинул в оперативу это yi 34 b .выдает такой результат.

Второй пример все кидаю в оперативу так же но 20b модель. И все нормально работает....

Кто откуда берет персонажей? Ну помимо chub.ai

Спасибо конечно за настройки.

Но за что это нам?

Чуб.ейай

WARNING: failed to allocate 15864.62 MB of pinned memory: out of memory

Кажется нашел проблему, но как ее решить и почему ее раньше не было....

более долгим тестом пройдись по памяти, поищи чем и как нормально проверять

Прошелся полностью раз 7 уже. Юзал Test Memory 5 с экстремальными настройками.

а llama.cpp запускает? у тебя какой то кобальд тут странный

А для каких целей ты используешь нейронку? Я что-то не заметил разницы - что с включенным инструктом, что выключенным, пишет на одинаковом уровне. И не только мистраль.

кобольд с min-P был. Щас его уже нет в репах, видимо в кобольде дело стало только не пойму почему. Я скачал две версии повыше и они не работали, а сейчас скачал 1.52.1 и она таки заговорила как надо. Хотя до этого на тех версиях все работало и с 34b. Ну да ладно проблема решилась, спасибо тем кто откликался, дня 4 потратил на это...

заебал аутофмемори

Купил себе год назад нахуй 3070ti, сосу жопу на ней. Игор то все равно нет, а нейронки не умещаются нихуя.

кто-нибудь тут пробовал заказывать вот эти карты?

K80 https://aliexpress.ru/item/1005003759476860.html?

Стоят - ёбаные копейки. Я сначала даже не поверил, что 24 гб видеопамяти можно получить за 9к.

Или лучше даже P40 https://aliexpress.ru/item/1005005310308659.html - 16к.

В чем подвох?

Может на них новая CUDA не будет работать? Или на них сложно размазать большую нейросеть, если брать больше одной?

Купил себе год назад нахуй 3070ti, сосу жопу на ней. Игор то все равно нет, а нейронки не умещаются нихуя.

кто-нибудь тут пробовал заказывать вот эти карты?

K80 https://aliexpress.ru/item/1005003759476860.html?

Стоят - ёбаные копейки. Я сначала даже не поверил, что 24 гб видеопамяти можно получить за 9к.

Или лучше даже P40 https://aliexpress.ru/item/1005005310308659.html - 16к.

В чем подвох?

Может на них новая CUDA не будет работать? Или на них сложно размазать большую нейросеть, если брать больше одной?

С убабугой/кобольдом используешь? Как по качеству рп с таким? Сильно лупится без rep pen?

Удавалось запустить на трансформерсе (взлетит разве что на 24гб врам или медленно на профессоре) и на жоре. Ну или cogvlm, модель что 490 - пиздец курсед залупа а grounding странная и местами неадекватно промт вопспринимает. Чат что v1.1 хорошая, с ней все ок.

> кобольд с min-P был. Щас его уже нет в репах

Мин-п уже давно везде есть сам по себе, курсед сборка наверно.

На китайских моделях у жоры были глюки с некорректными bos токенами и еще чем-то из-за чего результат был отвратителен. Скорее всего у тебя такая дырявая версия где это не пофиксили.

> K80

Не лезь бля она тебя сожрет.

> P40

Вот она может быть перспективна, есть заявления о том что на ней работает дохуя (для нее офк) быстро, есть наоборот что не годная ни на что некрота. Одному из местных она еще едет, возможно скоро будут тесты.

> В чем подвох?

Древняя архитектура, низкая мощность, медленная врам, отсутствие ускорения на 8-4 битах.

>cogvlm

Они кстати там ещё CogAgent тренят. https://github.com/THUDM/CogVLM#introduction-to-cogagent

Учитывая что для CogVLM основной пример у них это автообход капчи, а тут ещё CogAgent, натрененый на взаимодействие с гуём программ, возникают вопросы мотивации этих челов, лол. точат сетку под ботоводство

> медленная врам, отсутствие ускорения на 8-4 битах.

В сравнении с чем? с 1050 или с 4090?

Быстрее первой но медленнее второй, примерно как у простой 3060. По перфомансу чипа сложно сравнивать, это паскаль со всеми вытекающими и в нейронках будет точно медленнее той же 3060.

Анонче, хочу себе взять 3060Ti или 4060, для игор и так же хотелось бы гонять нейронки. Что из этого взять? Есть так же вариант просто 3060, т.к. у неё памяти больше. Но это действительно так, что для нейронки важна именно память, а не все остальные показатели? В общем, подскажите, пожалуйста, что из этого взять, или что-то из подобного ценового диапазона.

Я так-то на проксях сижу, в основном, но по долгу службы хотелось бы иметь возможность нейронки у себя поднимать на машинке.

Я так-то на проксях сижу, в основном, но по долгу службы хотелось бы иметь возможность нейронки у себя поднимать на машинке.

Ну слушай, первые две лучше, канеш, но вопросы остаются.

Во-первых, промпт там корректный был? А то я в убабуге какой-то замороченный видел.

Во-вторых, буру-теги, думаешь, она поняла о чем ты вообще? Кмк, это могло сильно подгадить ответу.

Но в общем, да.

У меня микстраль в расизм/сексизм/чтоугодноизм вообще без вопросов лезет, на дефолтном промпте убабуги, без негативов и прочего. Причем даже карточки персонажа нейтральные, ей поебать.

Миллион раз.

Паскали — убермедленные, на грани DDR4 (или быстрее в 2-3 раза).

Кеплеры ваще не смотри, там поедете еще медленнее.

Но именно P40 имеет отзывы, что она летает быстрее Tesla A80, и вообще — ракета. Но непонятно кому верить, потому что другие заявляют о перформансе равном рассчетному.

Короче, ждем, пока какому-нибудь анону придет эта карта с озона (ссылку я кидал пару тредов назад), и он наконец решит спор.

4060ti 16 гигов, очевидно.

Если нет — то 3060@12

Чем больше памяти, тем более пиздатую сетку ты сможешь воткнуть, и тем больше применений. Скорость до определённой степени вторична, быстрая карта с нихуём памяти тупо бесполезна.

ну и всё равно под тяжёлые применения придётся арендовать GPU

Спасибо, ануняки! Кажется, немного поднакоплю и возьму 4060ti, в таком случае. А другой вопрос.

Для рп какая сейчас мета? В aicg постоянно пропихивают пигму 7B, что она даже некоторые нелокальные обгоняет. Но кажется, что пигма это уже что-то прям совсем старое должно быть на данный момент.

Вышло что интересное, что я мог пропустить?

> В aicg постоянно пропихивают пигму 7B

Тебя крупно наебали, пробуй модели из шапки сначала.

могу тебе 3070Ti подогнать.

Если тебе для игор. В плане нейронок я на ней смог пока только openchat-3.5 q4k_m запустить. Хочется большего.

-кун

какие нахуй игры в 2024, калфилд ёбаный в 1080р на 15 фпс гонять? Ну ладно, не моё дело, где ты там в 2024 игры нашел. Балдурсгейт был неплох, да, но только вот он и всё, больше ничего.

- прав

> первые две лучше

Да, они пытаются выполнить поставленную задачу. С ошибками офк, там чтобы сразу работал код ни одного варианта нету, но пытаются. Причем один из запросов на русском языке отработало вполне прилично.

Микстраль же при запросе на великом-могучем подзафейлил даже разметку и вообще не понял задачу. Во втором случае что-то попытался, но опять часто про анализ пикч проигнорил. Хз, типикал поведение 7б, офк для такого размера огонь, но вот уже для 56/42б - хз.

> промпт там корректный был?

Все на скринах, там альпака, ### заголовком после маркдауна становится, и мистралевский [INST] [/INST]. По поводу последнего - особо не заметно чтобы он перформил лучше альпаки, но может просто так выпадало.

Алсо если приказать микстралю писать код и комментировать на русском - постоянно лезет внезапный EOS токен и норовит прервать выдачу.

> Во-вторых, буру-теги, думаешь, она поняла о чем ты вообще?

Ну какбы это тоже часть задачи, кодллама же понимала, хотя не должна была. Задача довольно сложная, хоть и бессмысленная, поскольку требует применения очень свежих функций, которые еще связаны между собой и легко запутаться в них. Преимущества у микстральки тоже есть, например трасформерс и ллама-токенайзер он понимает лучше чем wizard-coder, который норовит пихнуть gpt-2 или другие модели 1.5-летней давности. Xwin coder более свежую базу имеет и легче подхватывает. Гопота выебывается что сложна-сложна, но скорее всего если початиться - выплюнет наверняка.

Микстраль кстати очень крут. По русски как гпт 3 шпарит.

Только не понятные подвисания бывают. Кручу на проце 2-4 токена в секунду, но иногда бывает скорость падает до 0.3 токенов в секунду, а после этого снова возвращается в 2-4.

> Микстраль

Какой?

Да я понимаю, что наебали. Пигма стара как мир, и я трогал её уже.

Просто не понятно, насколько далеко локалки продвинулись за то время, как я их не трогал, конкретно в плане рп.

И хуй знает, в том треде многие рекомендуют старые версии нейронок из-за отсутствия цензуры и сои, может здесь похожая ситуация, что пигма за счет этого вытягивает. Но сам не в курсах.

Добра тебе, гляну шапку.

mixtral-8x7b-instruct-v0.1.Q3_K_M.gguf

> 8x7b

Мне же не влезет. Это же 7b

У вас колаб стартует или тоже ошибками сыпет под конец?

>Одному из местных она еще едет, возможно скоро будут тесты.

Трекнул. Прошла растаможку и едет в поезде в мои ебеня.

>Может на них новая CUDA

Подвох в том, что они не умеют работать с числами разрядностью меньше 16 и в них нет аппаратного умножителя матриц. Поэтому прирост производительности от квантов будет буквально никакой.

Проверял 7b на 1070 - Прирост в 4+ раза на lama.cpp и просто хреновая работа на autogptq.

План по посадкам на этот год выполнен, бюджетов нет больше на поддержание зондов.

>K80

А эта просто медленная/медленная.

> для 56/42б - хз.

Ну так эти 42 размазаны по разным областям.

Окей, я потыкал ее пару раз твоим запросом — пока ниче внятного не дала, признаю.

Выходит, мое первое суждение о том, что она просто удобный универсал, который анонам не нужен, так как аноны и сами могут поменять модель когда надо, остается верным.

Зато она на русском норм болтает для ее скорости, я доволен. х)

У меня иногда 0,6 бывает, подтверждаю. Причем, непонятно почему. Но пока дважды такое ловил, не придавал значения.

ОХ

третий квант на 7б модели, которая еще и жмется плохо по словам разрабов… сочувствую.

Отличненько, ждем!

И оперативы меньше 32?

И далее она написала все функции с комментарием «здесь реализуем…» =D

Нет, 32 рам и 8 врам, а скорости же нахуй пройдут.

>третий квант на 7б модели

Можно попробовать q5. Когда через lama модели грузишь они в системе странно отображаются. Сам процесс показывает 20 гигов занимает в данном случае как и должна q3, а общий баланс оперативы в диспетчере почти не меняется. Там несколько гигов только занято. Может оно не полностью в память грузится.

> потыкал ее пару раз твоим запросом — пока ниче внятного не дала

Если тыкать более простыми и с использованием более старых/традиционных средств то сделает получше. Что еще не понравилось - не смогла переписать заданный ей код в васян-стиле по стандартам и реализовать некоторые пожелания, хотя кодллама с этим хорошо справляется и он примерно в половине случаев даже работает, в остальных требует небольших правок.

Кодлламу 7б и подобного размера модели не тестил, конечно, возможно микстраль лучше их. Ну и какой вообще ожидать перфоманс по коду хз, может среди этих экспертов питонистов и нет.

Что поделать. С 32 гигами 3 квант работает. А у тебя еще можно и в видюху несколько слоев скинуть, будет еще лучше я думаю.

Попробуй.

Я всегда mlock тыкаю.

Ну и в 64 гига q8 влазит.

Че-т не будет.

Я седня тыкал ее на игровом — скорость была скакала как пойдет, от 1,6 до 2,2.

А на сервере ✓ cpu — 2,4-2,8.

Микстраль в видяху пока не але.

Ну или у меня версия не самая новая и уже пофиксили, хз.

Ryzen 5 5500 + DDR4 3200 в двухканале.

Mixtral Q8_0.

Серверные карты рассчитаны на внешний воздухоток в корпусе. Кулер придётся докупать специальный.

Да любой купить и на скотч приклеить. :3

Ну или резинками какими присобачить. Делов то.

А если у меня в корпусе 3 на вдув 4 на выдув больших вентилятора это считается за воздухоток?

Нет, если они не создают поток как у воздуходувки.

Как крутить настройки писать системный промпт у SUSChat чтобы модель не отвечала за меня, анон?

У меня на Roleplay, ChatML и Default за меня не говорил никогда

Ну значит тебе повезло.

А то как то не комильфо пиздить Марию, где она посреди действия начинает писать за меня и уже пиздить меня, лел.

> С убабугой/кобольдом используешь? Как по качеству рп с таким? Сильно лупится без rep pen?

Если через min_p 0.02 и темературку в 1.0-1.15 не лупится вообще.

Ну вот и всё. Весь топ-3 занят 7В, 70В рп-кал уже даже не в десятке.

Попробуй в author notes добавить мол чар не будет говорить за меня.

Скорее всего с карточкой просто глюки какие-то

И теперь веры этому списку еще меньше

Да эту банальщину я сразу сделал. Оно не всегда помогает, вот в чем дело. Тому и думал, может есть настройки волшебные. Кста, а какие у тебя настройки в Text Gen WebUI presets?

Я через таверну КУУМлю.

Если ты через угабугу - поставь таверну, чего ты.

>Undi95/Plap-7x20B-GGUF

Тем временем унди понесло.

Так я тоже про таверну. Силли таверну.

На чём кумишь? Что лучше в ерп

Тогда может с самплером у тебя проблемы?

Поставь симпл-1

Там всегда все работает.

Выше уже писал модели какие ща топовые.

Не знаю, я бы предварительно на ютубе глянул как люди это решают. У них там кожух какой-то специальный.

Да, но не такой который нужен.

>Поставь симпл-1

Значит у тебя просто голый пресет и все?

> какие ща топовые.

Ну кста, таки насчет суперсусачата - чет оно иногда дикий тупняк включает.

>Выше уже писал модели какие ща топовые.

Эьо микстрал который?

> симпл-1

Самый каловый пресет. Если реально надо чтоб всё просто работало, то лучше миростата ничего нет.

Миростат хуёво с mixtral работает.

А ты gold, bronze silver берёшь?

Нет у меня свой, но просто для теста поставь.

С ним всегда хоть и немного уныло, но работает.

Миростат хороший.

Но на некоторых моделях (не только микстрале) все в говно уходит.

Опять же, для дебага лучше симпл-1 нету.

В 34 SUSChat все еще топ.

В 20 Норомейда, Rose-kimiko или Iambe-storyteller

В 13 хуй знает чо там, Mythalion-Kimiko с 8к контекста потестировал. Очень годно.

>SUSChat

русский знает? или там все мозги китайско-английским забиты?

Он на yi сделан, с этим конкретно не пробовал но обычный yi в русский нормально мог

Господа, подскажите, пожалуйста: стриминг в кобольдспп + силлитаверн возможен? Стандартно всё работает, но стриминга нет. Ключ ?streaming=1 не работает, с ним просто не соединяется с бэкэндом

Настройки семплера и настройки подключения покажи в таверне.

И потоковый ввод в семплере

Спасибооо! Работает. Вроде очевидно, но моя тупость была сильнее

Я тупой. Как в llama.cpp врубить более быстрый процесинг промпта у mixtral, обещают 3 раза быстрее, но опций никаких нет. В скобочках cpu only, это тоесть на cublas не работает? Или что?

Ну и шиза же там будет на выходе, но зато разнообразная, лол.

А что за топ? Гопоту 5 уже победили?

> Попробуй в author notes добавить мол чар не будет говорить за меня.

Это должно стоять или в системном промте или в инструкции перед ответом и в другой формулировки. Чар в любом случае никогда за тебя не будет говорить, как вы этого понять не можете.

Бенчи кал, гони человеков. Даже пусть лмсисовскую арену.

> Ну и шиза же там будет на выходе, но зато разнообразная, лол.

Да вроде бы нет. Но суть в том, что rep pen на микстрал багнута. Оно со временем начинает выдавать токены в 100% вероятности, чего нет на других моделях в принципе..

Главное чтобы человеки ее не подкручивали и было понятно что тестируется.

Да офк лучше так чем в лупах утопать.

> Оно со временем начинает выдавать токены в 100% вероятности

Вут?

> Даже пусть лмсисовскую арену.

А с арены чего ты порвался? Лучше неё нет тестов так-то.

> > Оно со временем начинает выдавать токены в 100% вероятности

> Вут?

Ну то бишь вероятности некст токена достигают 1.0, хз как еще объяснить, я ща уже тот пост хуй найду. Там было более технически подробно описано.

Этот OAI совместимый api, кста, пока не все фичи кобольда поддерживает. По крайней мере, в одном из последних релизов koboldcpp так было написано. Порядок семплеров и ещё что-то там не пашет, не помню уже. Так что на текущий момент лучше классический апи использовать.

Первый раз слышу, но ты там же можешь выставить старый апи

>Это должно стоять или в системном промте или в инструкции перед ответом

Author notes можно ставить на любую глубину чата, так что можно как после описания перса, так и в самом конце чата поставить. И можно оформить текст с нужными префиксами/суфиксами типа ###Instruction. Единственное, не помню, запихивает ли таверна имя персонажа или юзера перед авторской заметкой, что может мешать восприятию заметки как инструкции.

Это в ченжлоге к версии 1.50.1 было. Про сэмплеры там имеется в виду, что этих не было изначально в OAI compatible api, а в этой версии их туда добавили. Т.е. функционал туда позже завозится.

>ты там же можешь выставить старый апи

Можно, но зачем, если KoboldAI Classic API и так пашет со всеми сэмплерами, их порядком и стримингом.

> их порядком

Зачем? Кроме прославления величайшего достижения семплеростроения офк.

>имя персонажа или юзера перед авторской заметкой

System

как сплиттить модель на две карты?

лоаде llama.cpp,

--gpu-split и tensor-split - кажется нихуя не работают.

пробовал

--gpu-split 6,5

--gpu-split 5,5

--gpu-split 4,4

--tensor_split 1,1

--tensor_split 1,1 --gpu-split 4,4

все время ебаная out of memory.

./start_linux.sh --model models/deepseek-coder-6.7b-instruct.Q5_K_M.gguf --n-gpu-layers 35 --n_ctx 8192 --tensor_split 4,4

чяднт?

лоаде llama.cpp,

--gpu-split и tensor-split - кажется нихуя не работают.

пробовал

--gpu-split 6,5

--gpu-split 5,5

--gpu-split 4,4

--tensor_split 1,1

--tensor_split 1,1 --gpu-split 4,4

все время ебаная out of memory.

./start_linux.sh --model models/deepseek-coder-6.7b-instruct.Q5_K_M.gguf --n-gpu-layers 35 --n_ctx 8192 --tensor_split 4,4

чяднт?

так..... у меня получилось азделить модель, но она как-то конценым образом раздляется.

Указал

--tensor_split 1,3

а разделило нихуя не 1 к 3.

Было бы здорово, если бы кто-нибудь подсветил чё это за хуйня.

Через куда визибл девайсез ставь первым (нулевым) устройством более мощную карту с большей врам. На нее приходится еще контекст, на который llamacpp отжирает неприлично много. Отпиши что там по перфомансу получается.

А так вообще если грузишь модель что полностью помещается в видеокарту и карточки не лютая некрота - вкатывайся в экслламу. Никаких проблем со сплитом (офк про контекст на первую карту также актуально), все задается гигабайтами, кушает меньше врам и работает быстрее.

>Одному из местных она еще едет, возможно скоро будут тесты.

немного к слову про производительность P40:

модель deepseek-coder-6.7b-instruct.Q5_K_M.ggu

с батлнеком в виде 1060@6:

Output generated in 36.76 seconds (14.01 tokens/s, 515 tokens, context 623, seed 1119528441)

Output generated in 29.67 seconds (14.86 tokens/s, 441 tokens, context 623, seed 98203181)

на ЦПУ AMD Ryzen 5 3600 6-Core @ 12x 3.6GHz, двухканал DDR4 3200 МГц

Output generated in 91.47 seconds (5.61 tokens/s, 513 tokens, context 623, seed 1429907747)

Output generated in 73.45 seconds (5.83 tokens/s, 428 tokens, context 623, seed 1813178837)

учитывая, что P40 выше по производительности чем 1060 и что у них одинаковая архитектура - скорее всего на P40 будет ускорение в 3-4 раза (а может быть и в 5 раз из-за того, что fp performance e 1060 4.3, а у P40 - 11.7) в сравнении с моей ЦПУ-шной конфигцрацией.

Думаем.

Короче я бы ставил на то, что P40 неплохо тащит.

> с батлнеком в виде 1060@6:

На нее все слои выгружаются? Если так то это не ботлнек а просто ее перфоманс. Тогда если сравнивать по псп врам p40 окажется в 2 раза быстрее, и по расчетам чуть меньше чем в 3, порядка 30-35 т/с на 7б, что приемлемо. Совсем уж теоретизируя - на 13б будет ~15т/с, на 30б ~7 т/с, если последнее подтвердится то это получается самый дешевый путь вката в тридцатки с возможностью (неспешно) читать стриминг а не ждать его накопления. Подводных камней вагон, но тем не менее.

А я рандомно скачал dolphin-2.5-mixtral-8x7b.Q4_K_M.gguf, тоже норм. Но скорость действительно самое узкое место. Пока поймешь, что сгенерировалась хуета и надо начинать заново, уже заснешь.

>куда визибл девайсез

я так понимаю, имелась в виду переменная окрудения?

CUDA_VISIBLE_DEVICES=1,0 ./start_linux.sh --model models/deepseek-coder-6.7b-instruct.Q5_K_M.gguf --character Saya --n-gpu-layers 35 --n_ctx 8192 --tensor_split 2,15

2,15 - пиздец конченый параметр, чо за бред.... пришлось перебирать, пока не перестал падать в оом

Output generated in 28.77 seconds (16.96 tokens/s, 488 tokens, context 623, seed 1450316253)

Output generated in 25.84 seconds (19.93 tokens/s, 515 tokens, context 623, seed 1082159972)

Output generated in 25.69 seconds (19.82 tokens/s, 509 tokens, context 623, seed 877123830)

кажется это действительно что-то ускорило.

>На нее все слои выгружаются?

я не могу ответить, потому что не вижу где это вообще посмотреть. Но нет, все слои в неё просто не влезли бы. Они видимо раскиданы по разным гпу, я не знаю каким образом. Мне не хватает понимания значения параметра --tensor_split

Дополнительную врам на первой видяхе жрет контекст.

Прилично, поэтому надо на первую видяху гига на 3-4 меньше ставить для начала, а там уже смотреть.

И в сумме, чтобы хватало на модель, конечно.

Братан, какие 7B, ты в своем уме? P40 берется только ради 70B, ну в крайнем случае 34B.

Может быть 20B, хз.

Так что свой перформанс в 15 токенов смели дели на 3, а то и на 10. =) Ну, побольше, мб.

Т.е., проблема в том, что ты либо гоняешь малые модели быстро (но на 3060 будет быстрее), либо гоняешь большие, но медленно (и хз, нужно ли оно тебе в 2-3 раза быстрее проца).

Либо там реально пушка-гонка и летает все 3 токена на голиафе, или сколько нам обещали, может я ошибаюсь.

В двадцатки, скорее, тридцатки там ближе к 3-5 будут, кмк.

Ну, посмотрим.

Ну, не хуже 13B, а то и быстрее раза в полтора, кмк.

Так а чего непонятного-то?

По сути, тебе надо туда вписать сколько частей загружать на первую видяху, и скока на вторую. Самое простое — вписать туда гигабайты как есть.

Берешь объем видеопамяти первой видяхи, минусуешь контекст (пусть будет 4 гига), вписываешь число. Берешь объем видеопамяти второй видяхи, вписываешь после запятой. Все.

>P40 берется только ради 70B

нуу.... с точки зрения кода, который мне выдал deepseek-coder-6.7b-instruct.Q5_K_M - вполне приемлимый уровень. Я не вижу причин подниматься до 70B.

Может это только для забористого кума нужно, а то я видел тут люди жалуюстя что у них отыгрыш лолей недостаточно хорошо получается.

Поправь меня, если ошибаюсь, а то я хз, я новичок тут.

В твоем случае, проблемы быть не должно, моделька маленькая.

Попробуй соотношение 2,7

Ну, с точки зрения кода — дальше мистрали ниче не нужно (хотя выше анон жаловался, что 34B с трудом понимают, что ему нужно=).

А мистраль — это уже 7B, которая в 12 гигов влазит легко (даже в 8, кстати). Накой тут P40-то.

Берешь 3060 и она летает у тебя во все стороны. Че там, небось, 35+ токенов будет.

Ну, правда, через мегамаркет и баллы, да.

Если вот прям совсем ужимаешься — думаю, можно взять и P40.

Хотя, может P104-100 будет лучше (учитывая ее копеечную стоимость), но мне лень копаться с дровами для запуска. Кто-то писал, на линухе нет проблем.

Но если ты поменял местами видяхи, и 8-гиговая считается первой, то можно 4,5.

А то я криво читал ваш диалог.

Хотя, если 8-гиговая мощнее, то я бы на ней держал больше слоев, а контекст держал на более слабой карте (т.е., более слабую ставил бы первой). Но я не уверен, что это именно так работает, может я дурак и вообще полчетвертого ночи.

>а то я видел тут люди жалуюстя что у них отыгрыш лолей недостаточно хорошо получается.

Он и на самых крутых коммерческих сетках говно. Ой...

да шоб тя разорвало собака сутулая....

почему блять?!

./start_linux.sh --model models/vicuna-7B-v0-GPTQ --multimodal-pipeline minigpt4-7b --character Saya --gpu-split 1,8

2023-12-17 03:58:00 INFO:Loading vicuna-7B-v0-GPTQ...

2023-12-17 03:58:07 INFO:LOADER: ExLlama_HF

2023-12-17 03:58:07 INFO:TRUNCATION LENGTH: 2048

2023-12-17 03:58:07 INFO:INSTRUCTION TEMPLATE: Vicuna-v0

2023-12-17 03:58:07 INFO:Loaded the model in 7.05 seconds.

2023-12-17 03:58:07 INFO:Loading the extension "multimodal"...

2023-12-17 03:58:07 INFO:Loading the extension "gallery"...

почему блять?!

./start_linux.sh --model models/vicuna-7B-v0-GPTQ --multimodal-pipeline minigpt4-7b --character Saya --gpu-split 1,8

2023-12-17 03:58:00 INFO:Loading vicuna-7B-v0-GPTQ...

2023-12-17 03:58:07 INFO:LOADER: ExLlama_HF

2023-12-17 03:58:07 INFO:TRUNCATION LENGTH: 2048

2023-12-17 03:58:07 INFO:INSTRUCTION TEMPLATE: Vicuna-v0

2023-12-17 03:58:07 INFO:Loaded the model in 7.05 seconds.

2023-12-17 03:58:07 INFO:Loading the extension "multimodal"...

2023-12-17 03:58:07 INFO:Loading the extension "gallery"...

> я так понимаю, имелась в виду переменная окрудения?

Именно.

> потому что не вижу где это вообще посмотреть

> --n-gpu-layers 35

Оно, если стоят все (уже не помню сколько там в этих, но вроде как раз около того) то будет так. Раз только часть то хз что там будет.

> тридцатки там ближе к 3-5 будут, кмк.

Ну это уже грустно совсем, хотя вброс про 4-5т/с на 120б пророчит вообще космическую скорость на 30б.

> с точки зрения кода, который мне выдал deepseek-coder-6.7b-instruct.Q5_K_M - вполне приемлимый уровень

Понюхай файнтюны кодлламы 34 хотябы, поймешь что эта мелочь - слабовата.

> Может это только для забористого кума нужно

Для забористого уже 70, да, но это если зажрался и быстрое взаимодействие. Хотя и тут беда с размером контекста.

> с точки зрения кода — дальше мистрали ниче не нужно

Ну ты рофлишь чтоли, она задачи чуть сложнее дефолта с большим трудом понимает, какой бля не нужно. И хз как отреагирует если с ней устроить чат с разбирательством почему-как-не работает-чини бля.

Как отреагирует если устраивать ее интеграцию в ide тоже хз, это уже пусть умные люди тестят сравнивают. В любом случае со скоростью микстраля тут он юзлесс.

> ./start_linux.sh --model models/vicuna-7B-v0-GPTQ --multimodal-pipeline minigpt4-7b --character Saya --gpu-split 1,8

Зачем? Просто ./start_linux.sh а уже в веб морде выбираешь модель, выставляешь лоадер (нужна exllamav2-hf), спокойно задаешь размер и жмешь лоад. Если не получилось - анлоад, поменял параметры и заново.

Что за ошибка - хз, версии последние?

версия text-generation-webui - мастер, скачанный вчера

>Зачем? Просто ./start_linux.sh а уже в веб морде выбираешь

заебли out of memory

Намышевозишь параметров, а потом в консоль назад лезешь перезапускать эту мандулу.

Брось нахуй, пустое. Или запускай не в уебабуге, найди другой уи или способ. У него всегда какие-то проблемы. Теперь на днях уеба сломал все шаблоны. Да что говорить у него обновы поломанные через раз и это постоянно. Начнешь поднимать вопросы там надают советов которые сводятся по сути к тому, чтоб самому код переписать, а тогда нахуй нужна толпа ебланов из этой репы? И не надо говорить про попенсорс - типа жри что дают задаром. Во-первых у них грант, во-вторых донаты. Надо иметь сознательность чтобы хотя бы проверять свои поделия. репозиторий где код правят лебедь рак и щука

Все бы так просто было. Мультимодалку даже не запустить из интерфейса, уебунга тут же просто вылетает. Этот вопрос уже обсуждался пару месяцев назад в issues. Впрочем у меня так же точно не запускалось и из консоли.

А почему нет Mixtral-8x7B-chat?

Клонов наделали целую кучу 8x7b, но что то ни одного чата нет, по крайней мере в gguf.

Клонов наделали целую кучу 8x7b, но что то ни одного чата нет, по крайней мере в gguf.

Там же один только Унди клепает рп шизомиксы один за другим, как не в себя. Хз, работают ли они. По идее, всё из этого списка (просто вбивал в поиск "8x7b gguf" с дефолтным фильтром trending) чат ориентированное. Чупакабра и старлинг опенчат используют.

Чтобы прожаривать температуркой весь вообще пул токенов до белого шума, конечно же. А так, лично мне нужен. Я юзаю tfs и применяю его после отрезания 5% самых говёных токенов topP 0.95 и отлавливания случаев с очень большим первым токеном при помощи topA 0.1-0.2. После этого ещё могу захотеть сначала накинуть температуру. Соответственно, topP в самом конце в моём случае не имеет ни малейшего смысла.

Я просто искал mixtral chat gguf

Нечего смущать людей своими странными названиями.

Обычно не нужно перезапускать, работоспособность не теряется.

> Мультимодалку даже не запустить из интерфейса

Ты про экстеншн на мультимодальность чтоли? Только параметры запуска, да.

> Хз, работают ли они.

Скорее всего на то что выдают подобие текста он проверяет, врядли что-то более.

А чем там история закончилась что с микстралями K_M что то не так?

Кто-нибудь знает как установить https://github.com/OpenAccess-AI-Collective/axolotl в wsl?

Начиная с установки pytorch в wsl, который пока установить не удалось. Если не затруднит, краткое руководство на уровне для дебила и уебка

Начиная с установки pytorch в wsl, который пока установить не удалось. Если не затруднит, краткое руководство на уровне для дебила и уебка

> не может даже скопипастить команды в терминал

> лезет в WSL

Тут уже квалифицированная помощь психиатра требуется, мы бессильны.

да я вчера уже доковырялся до https://github.com/oobabooga/text-generation-webui/pull/4911

тестирования там походу нет от слова совсем

>в wsl?

Сынок.....

альсо обнаружил, что openchat умеет в японский

>WSL

Подскажите, из любопытства, этим кто-нибудь вообще пользуется?

Подскажите, из любопытства, этим кто-нибудь вообще пользуется?

Ты сам-то копировал? Ну скопируй и посмотри что будет. Было бы так - не спрашивал бы. По делу то можешь подсказать или только морду гнуть?))

Что еще вендузятникам остается?

Как сделать проще, без этого гавна?

только залётные, которым кто-то сказал, что wsl может заменить полноценный линукс (нет)

Меня как-то занесло в одну контору уровня рогов и копыт, где писали на дотнете. меня попросили поднять на wsl пайплайн сборки их дотнет говна (они на линукс расширяться хотели) - там сборка заняла времени в три раза больше, чем на обычном линуксе.

Надеюсь я больше никогда в жизни не притронусь ни к дотнету, ни к wsl.

Мелкомягкие нихуя нормально сделать не могут.

> этим кто-нибудь вообще пользуется?

На серверах под Виндой это уже давно стандартный способ использования пердоликса вместо виртуалок, Azure под ним. Докер тоже под WSL работает.

>уже давно стандартный способ использования пердоликса вместо виртуалок

>Докер тоже под WSL работает

>вместо виртуалок

tell me more, сынок

https://github.com/MicrosoftDocs/WSL/issues/899

> Windows 10 Home

Что тебе сказать? То что в хоуме куча функционала винды порезано? Так это всегда было и будет, никто тебе не даст сервера на хоуме поднимать.

Может он намекал, что wsl извращенная форма гипервизора и уж лучше вмварь или гипер-в навернуть с кучей виртуалок, чем этим пользоваться?

Другой анон.

> лучше вмварь или гипер-в навернуть с кучей виртуалок

Ну если хочешь извращаться без нормальной интеграции в Винду, жрать низкую производительность и тратить ОЗУ в пустую, то можно и на виртуалке сидеть. Алсо, в виртуалках можно сразу забыть про CUDA.

this.

ну и буллщит ты несешь

Хорошо тебе балмор и калитка сапог в дупу затолкали. Крепко сидит.

> с установки pytorch в wsl, который пока установить не удалось

Какие проблемы тут могут быть даже в теории?

> краткое руководство на уровне для дебила и уебка

Создаешь venv, идешь на https://pytorch.org/get-started/locally/ и выбираешь версию под последнюю куду им похоже нужна 11.8 поэтому под нее, просто линукс, копируешь команду и вбиваешь в активированный вэнв. После этого или их командой

> pip3 install "axolotl[flash-attn,deepspeed] @ git+https://github.com/OpenAccess-AI-Collective/axolotl"

или

> git clone https://github.com/OpenAccess-AI-Collective/axolotl

> cd axolotl

> pip3 install packaging

> pip3 install -e '.[flash-attn,deepspeed]'

Каких-то проблем вроде не видно.

Да, когда тебе нужно катать их софт на десктопе, но компромисс в виде такой прослойки менее напряжный чем полноценный линукс.

Шрифты уже отрендерили, красноперые?

> контору

> не имеют отдельной машины/виртуалки под такое

> ты, который не сбежал оттуда при виде такого

лол, ну мнение такого кадра определенно преисполнено объективностью и корректностью

> и уж лучше вмварь или гипер-в навернуть с кучей виртуалок, чем этим пользоваться

От задач зависит же

> орошо тебе балмор и калитка сапог в дупу затолкали

Пчел, после такой шизы ты еще кого-то в чем-то обвиняешь?

В mixtral-8x7b-moe-rp-story поломан русский язык.

Совсем по-русски не общается, выдает случайные слова.

Вот и качай после этого всякие файнтюны, больше ломают чем улучшают.

>компромисс в виде такой прослойки менее напряжный чем полноценный линукс.

буллщит или намеренное враньё. Когда у тебя выскочит шишкой геморроя проблема на wsl - ты проклянешь всех, кто учавствовал в его разработке до седьмого колена. Но откуда ж тебе знать, ты не сталкивался никогда всерьез с этим.

>лол, ну мнение такого кадра определенно преисполнено объективностью и корректностью

конторой я их назвал потому что они не настолько крупные в сравнении с компанией, где я сейчас работаю. Для тебя моя "контора" скорее всего равносильна "корпорации" или "конгломерату".

альсо

>ты, который не сбежал оттуда при виде такого

я и сбежал, я ж не говноед. И да, на отдельной машине линуксовой они и собирали своё говно до кучи.

>Пчел, после такой шизы ты еще кого-то в чем-то обвиняешь?

ну что ж, давай разберем по частям тобою написанное

>Ну если хочешь извращаться без нормальной интеграции в Винду

нахуй не надо, потому что внезапно большинство проектов работают только на линуксе, а на винду их только пересобирают или адаптируют

>жрать низкую производительность и тратить ОЗУ в пустую, то можно и на виртуалке сидеть.

ты определись - мы говорим про компьютинг на видеокарте или на цпу?

>Алсо, в виртуалках можно сразу забыть про CUDA.

нахрюк виндобляди, которой барин в его хрюкни-V не подвез PCI Passthrough.

KVM, для справки, позволяет прокидывать карты в виртуалку. А до него это мог делать xen еще в бородатых нулевых. Но откуда ж тебе знать.

> хрюкни-V не подвез PCI Passthrough

Емнип, вмварь под виндой тоже умеет интерфейсы прокидывать.

> Когда у тебя выскочит шишкой геморроя проблема на wsl

Именно, вероятность такого - околонулевая. Проблемы, которые могут вылезти в рамках пердолинга на десктопе с релейтед ему задачами и около нейронками уже позакрывали и обрабатываются оперативно. Для остального - отдельные машины с прыщами/бздой на любой вкус, или загружаешься в полный линукс.

Тыж настолько преисполнился в собственном чсв что даже пост внимательно прочесть не можешь.

> я и сбежал, я ж не говноед

Сам написал что сначала как следует распробовал.

> ну что ж, давай разберем по частям тобою написанное

Что ты там разобрать можешь после того заявления, еще вменяя чужие посты.

Реально поднадусеровый шиз со швабодкой головного мозга.

Почему ты так порвался? Кто тебя обидел?

Вроде спокойно расписал почему тот наброс - ерунда, где же порвался? Истинный разрыв - привлечение анальных примеров выше.

Какие файнтюны могут быть у Унди? Он месит сам не понимает что и как. Ему похрен, главное не останавливаться, чтоб донаты капали. А кто-то качает и восторгается "разницей" среди его моделей, который вероятно в таком роде: старая модель говорила "ебать", а новая говорит "выебать" - охуеть прогресс. Тот долбоеб, который мастурбирует на его модели, лучше бы задоначенные ему доллары потратил на шлюх

> интеграцию в ide

Я так и не пощупал гитхаб копилот, кстати.

С одной стороны, как раз интеграция в иде ей проще всего — никаких задач на словах, чисто код дописывай.

Но вот насколько в нужную сторону она будет дописывать — я согласен, скорее всего часто будет мазать вообще не в ту степь.

Кодллама на выделенной видяхе в иде — звучит вообще вкусно, конечно. В теории.

А дальше и правда нужны умные люди. =)

Да, я тоже попытался запускать мультимодалки, чо-то нихуя multimodal extension не работало.

Ну я забил и юзал из лламыспп.

ест попкорн

Тут согласен. Я сразу подумал, что намек на это.

Как неожиданно.

>ест попкорн

ну, справедливости ради - я действительно линукс сектант, но я думал, что в треде локального запуска нейросетей не будет с этим проблем и тут типа, все такие.

В конце концов fuck the corporations, fuck the OpenSoyAI

> тут типа, все такие

Душнилы с разной степенью умеренности позиции.

> fuck the corporations, fuck the OpenSoyAI

Не думал что соглашусь с линуксоидом.

>линукс

Гигабаза, так сказать, мета. Последний оплот свободы в мире анального копирайта и попабольных зондов.

Не, я вот под виндой сижу.

Но не испытываю проблем, venv питоновский создаю и все. WSL это весело, но если бы я хотел линуху — накатил бы линуху и все.

Хотя и против WSL ниче не имею, не юзал.

пикрел

Вобщем получается самое простое накатить убунту второй системой только из-за аксолотля ппц...Посколько как я понял в винде не будет работать никак, у них написано Windows Please use WSL or Docker!

это не тема треда, но все-таки тебе не нужна винда, анон.

На линуксе без проблем сейчас идет ВООБЩЕ НАХУЙ ВСЁ, слава Гейбу и херувимам-разработчикам его, ежи Proton его Артефакт присутствия и влияния в мире смертных.

> но если бы я хотел линуху — накатил бы линуху и все

Это не описать насколько заморочно перегружаться из одного в другой из-за потребности в лимитированном софте, сюда же настройка мультимониторного интерфейса, цветовых профилей, и сопутствующего функционала, который все равно отличается и действует на нервы. и что бы там не говорили, прыщи на декстопе если не вырос в них и их специфичный пердолинг в крови - уступают по удобству и юзабилити

Эмуляции и там и там достаточно инвалидные, но wsl выходит приемлемым компромиссом для простых задач. Офк у нее много пиздеца, чего стоит скорость работы с шиндовской файловой системой. Но бесшовность, скорость и интеграция таки решают. Так-то все расчетные машины на прыщах, представить там что-то типа шинсервера где натащили лишней кривой залупы вместо минимализма, удобства и абсолютного функционала - страшный сон.

> пикрел

лол да

Да должно оно и так работать, что у тебя там происходит то и на что ругается?

Если с линупсом не знаком то можешь соснуть уже на установке нужной версии пихона, лол, а так поставь, попробуй.

>потребности в лимитированном софте

Тебе следует отказаться от такого софта и решать задачу иными инструментами. Это может быть костыль через костыль, но ты должен пойти на эту жерту ради будущего человечества. И ты всегда можешь пилить свой костыль.

>который все равно отличается и действует на нервы.

вся суть претензий.

>уступают по удобству и юзабилити

Ну еще бы, все же на корпорации работают тысячи профильных спецов. Но мы должны отринуть наши слабости, тягу к излишним удобствам и принимать реальность такой какая она есть.

Undi95/BigPlap-8x20B

Спасите пацана. Его микстраль сломал походу.

Спасите пацана. Его микстраль сломал походу.

Нахуй он это делает? На чём этот кал запускать с таким размером?

>Да должно оно и так работать, что у тебя там происходит то и на что ругается?

В wsl да буквально на все))

>Если с линупсом не знаком то можешь соснуть уже на установке нужной версии пихона, лол, а так поставь, попробуй.

С убунту сидел пару лет но это было 9-10 лет назад. Пердолился там с дискретной картой амд на ноуте. Ну и нихрена тогда не получилось. Сейчас наверное таких проблем нет, уж с нвидиа то наверняка.

> уж с нвидиа то наверняка

С чего бы вдруг пердоликс стал без пердолинга? Это на WSL ты просто ставишь драйвер в винде и на линуксе оно просто работает. А на бубунте будешь пердолиться с драйверами нвидии как и 10 лет назад.

перебирает варианты методом тыка, и смотрит как это будет работать

> Тебе следует отказаться от такого софта

медленно и смакуя произношу linux без GNU

Всетаки немалая часть проприетарного или специфично написанного софта - удобно и эффективно, текущие реалии сформировались естественным образом. Это как снег, он будет идти как не протестуй.

> вся суть претензий.

> Ну еще бы, все же на корпорации работают тысячи профильных спецов

Да вот, увы.

> ))

С тобой вообще технические вопросы обсуждать - особый вид извращений.

> Сейчас наверное таких проблем нет