>Ну дай ты помечтать, а?

Никакого коупинга, только суровый реализм. Коупинг оставим пользователям коммерческих нейронок, которые надеются, что у них доступ будет всегда и без цензуры, лол.

>весь вопрос в том, как делать выбор токенов

Именно. В настоящем мое тренируют отдельные слои, то есть часть входных и выходных слоёв общая. И ты никак не сделаешь из двух обычных слоёв спец-слой с выбором, ну не смержатся так они, и всё на этом.

Пенальти пропиши.

>Ебало северного моста представил

Благо его устранили давно, да и южный сейчас уже почти полностью деградировал.

> На токены в секунду насрать если честно, если их не менее 1.

Нууу, типа ждать 5 минут среднее сообщение - успеешь забыть что там было. Суть текстового рп в погружении, замедлиться для осмысления момента ты всегда можешь, но слишком долгое ожидание сразу нахер все заруинит.

Но с задержкой обработки контекста соглашусь, на жоре даже с гпу это можно прочувствовать.

> Коупинг оставим пользователям коммерческих нейронок

Тут нужна шутка про победы 7б.

> В настоящем мое тренируют отдельные слои, то есть часть входных и выходных слоёв общая.

Вон сотни колхозных мое из всратых замесов, хотябы что-то подобное наделать. Или вообще нейронка что по содержанию текста будет решать на какую сетку подавать. Или применить совместную генерацию, оценивая токены 3й сеткой. Варианты есть, но ресурсоемкость не для васянов-инджоеров.

>Тут нужна шутка про победы 7б.

У меня уже синяки от бесконечных фейспалмов от этих побед. Впрочем, дно за дном уже пробито, и заявления о поебде всего и вся звучат уже от 3B и даже 2B.

>Вон сотни колхозных мое из всратых замесов

Жаль я хлебушек, а так бы оценил, какие части слоёв принимают участие. Вангую, там одна сетка работает, остальные память занимают, лол.

> от бесконечных фейспалмов от этих побед

А ты иди арену посмотри еще!

> заявления о поебде всего и вся звучат уже от 3B и даже 2B

С этого уже неиллюзорный проигрыш можно ловить. Запилить под эти тесты что-то типа векторной базы - победоносца.

> Вангую, там одна сетка работает, остальные память занимают, лол.

Может и так лол. Пару 34б вроде хвалили что лучше одиночных, но представить себе экспертов на довольно горячей yi - это нужно богатое воображение. Хоть качай и пробуй.

Нужно погружаться, изучать и т.д., сложно и пугает перспектива в итоге понять что оно на самом деле еще сложнее и все это напрасно.

О а пик4 наш чел в треде? Я в первый раз эту пикчу увидел в треде 3д печати. Тоже хочу в 3д принтеры вкатиться, интересно сколько это по деньгам.

Любого занюхивателя коупиума, крутящего на своем 1050ti звере 7б и утверждающего что гпт сосет я все равно буду уважать куда больше чем ретардов которые у барина генерации крутят.

Как вообще человек может мирится с цензурой такого толка я хз. Это как однажды у меня кореш с айфоном ходил и сказал "бля я чет не могу в этот телеграмм канал зайти мне телефон запрещает".

Телефон запрещает, понимаете? Вот у барина такие же сидят. У меня даже слов нет чтобы описать какое это дно.

Как вообще человек может мирится с цензурой такого толка я хз. Это как однажды у меня кореш с айфоном ходил и сказал "бля я чет не могу в этот телеграмм канал зайти мне телефон запрещает".

Телефон запрещает, понимаете? Вот у барина такие же сидят. У меня даже слов нет чтобы описать какое это дно.

База.

20к Ender 3

Телефону виднее, че ты.

>Я в первый раз эту пикчу увидел в треде 3д печати

Это моя вчерашняя пикча, я ее постил только в прошлом треде, в тред 3D печати видимо вбросил кто-то еще.

>Тоже хочу в 3д принтеры вкатиться, интересно сколько это по деньгам.

Если не планируешь фигачить что-то сложное, требующее высокой точности, то хватит недорогих моделей, тот же Ender 3, как писал анон выше. У меня китайская дельта Flsun QQ-S Pro, которую я купил с рук за 10к с тремя катушками пластика в комплекте. Так что есть смысл поискать на авито, многим людям не заходит и они продают свои девайсы не дорого.

>1050ti звере 7б

3b разве что, но все равно согласен

Сидеть на подсосе у копроратов с их соей и цензурой это пиздец

О, кстати, я правильно разглядел, что там переходник с молекс на псиай питание, а с псиай на процессорное для P40?

дэбильный вопрос конечно, но возможно ли доверить управление умным домом лламе? и что из этого выйдет?

Именно так, на моей старой дельте есть только один выход питалова на видеокарту, пришлось костылить такое.

Уважать нужно тех, кто осознает-понимает что делает а не искажает реальность ради оправдания своих ограничений. Шарящий раздобывший пару авс/ключ впопенов и спокойно применяющий ее, выбирая из-за возможностей сети для задачи или ограничений собственного железа - ничуть не хуже чем копиумный варебух, лелеющий мечту о том что вот вот сейчас сделают 7б, которая всех-всех подебит, и наконец-то он заживет а все остальные прибегут к нему сокрушаться и просить совета.

Сравнивая же последнего с "проксечку писечку@флагшток за аксесс токен@фу ваши локалки не нужны они тупые@дайте жб прошлый протух я не локуст" - не ясно кто кого, слишком уж ужасные сорта.

> У меня китайская дельта

Божечки, за що? Но лучше чем ничего

Если все аккуратно организовать - вполне, но ллама там будет выступать лишь частью, которая разбирает команды-запросы. По отзывам если модель нормальная, то последовательность уровня "открой занавески, поставь окно на проветривание на 5 минут и приглуши свет" обрабатывает, успешно превращая ее в 4 команды из которых одна с задержкой исполнения.

К слову про использование 1030 и p40 одновременно, я таки нашел способ - нужно заюзать дрова от Titan X, он подходит для 1030 и p40, просто на p40 его надо будет ставить руками через диспетчер устройств и выбрать из списка Titan X (Pascal).

Правда потом придется сделать несколько твиков в реестре по этому гайду:

github.com/JingShing/How-to-use-tesla-p40

Но зато потом все будет работать нормально.

Правда потом придется сделать несколько твиков в реестре по этому гайду:

github.com/JingShing/How-to-use-tesla-p40

Но зато потом все будет работать нормально.

>Божечки, за що

Да там же честные 500W и абсолютно наркоманская компановка из двух плат!

Хе-хе.

Лолбля, то вообще за принтер. Слишком много компромиссов за возможность печатать размеры побольше вдоль оси с минимальной прочностью.

Ну, земля пухом. Квартира застрахована?

Да ничего, одной ЛЛМ тут мало, как минимум входную речь будет разбирать какой-нибудь вишпер, ответы озвучивать силеро, самим домом рулить хзАссистент (не помню как его), и ко всему этому будет прилагаться куча скриптов на каком-нибудь пайтоне. Вот скрипты тебе и придётся писать.

А так GBNF Grammar, чтобы выдавал валидный json с нужными опциями, и вперёд. На такой разбор даже 7B подойдёт, сможешь удивлять тяночек командой "Хули так светло, сделай интимную обстанов очку".

А способ с отдельной последовательной установкой двух устройств уже не катит?

Мы не ищем легких решений.

А, тьфу, меня проглючило что ты про бп.

Да, я знаю, что китайские дельты это такое себе, но он достался мне дешево и его уровня качества печати мне хватает более чем.

Большая облась печати мне пригодилась только один раз, когда печатал на нем элемент бампера.

>способ с отдельной последовательной установкой двух устройств уже не катит?

У меня почему-то не взлетел, хотя, может быть я что-то делал не так.

Я думал вообще самосборку ебануть. И подешевле и можно наколхозить себе всякого.

Двух p40 хватает для запуска квантованных 70b (Q4_K_M и выше)?

>Двух p40 хватает для запуска квантованных 70b Q4_K_M

Да.

>и выше (q6 q8)

Нет.

Понял, спасибо

>самосборкa

Хороший вариант если руки не из жопы. Правда я сомневаюсь, что выйдет сильно дешевле.

> самосборку

Для нее нужен уже рабочий принтер. Появились там вообще готовые нормальные проекты? Ранее была сплошная кринжатина с расходом килограммов пластика вникуда, безумными конструкциями из профиля в больших габаритах, но при этом микростолика с консольным креплением(!) на тонкие валы из пластилина, или 15-ю каретку, что плохо воспринимает нагрузки в этом направлении.

Если самому разрабатывать - топчик, весело, увлекательно, но будь готов к долгострою и собиранию граблей.

> и выше

Можно загрузить q5_k_m с микроконтекстом, не более. С более менее вменяемым q4_km - потолок, но его достаточно.

Дешевле выйдет врятли, но вроде в самой сборке нет ничего сложного. Единственное что я ебал какие-нибудь программы писать.

Ух бляяя пердолинг. Зато швабодка.

Еще какой. Ну рили смысл самосбора в получении или особых характеристик (габариты), или в достижении высоких параметров без больших затрат и зависимости от кривого разработчика. Например, для печати разных деталей с претензией на прочность нужен большой габарит по самому столу, а высоты даже больше 150мм нечасто встретишь - ранее в любительских проектах было все наоборот с фокусом на высоту. По дефолту заложена херня вместо пары высокорасходных хотэндов, вывозящих сопла 0.8-1мм чтобы печатать габаритное на адекватных скоростях, и хотябы один из которых должен быть директом. Нормальных направляющих тоже офк никто не делает, в лучшем случае надежда на самовыравнивание corexy, которое не работает на ускорениях если тяжелый хотэнд уехал от центра.

С другой стороны, объем пердолинга таков, что если тебе под конкретные задачи - лучше сразу отдай много денег за зарекомендовавшее готовое решение.

Охуенная идея, заодно настрой автоматический постинг результатов, потому что не факт, что сможешь сам запостить в каком-то момент. =D Но очень интересно!

По поводу использования.

1. Качаешь дрова на свою видяху и на Tesla P40 (официальные, с сайта нвидиа).

2. Ставишь Теслу.

3. В реестре че-то там где-то там меняешь.

Внести изменения в реестр по пути:

HKEY_LOCAL_MACHINE\SYSTEM\ControlSet001\Control\Class{4d36e968-e325-11ce-bfc1-08002be10318}\

В папке относящийся к Тесле (например: 002. В ключе DriverDesc указано имя адаптера/Теслы) …установить драйверы Tesla, в папке "001" (относящийся к Тесле) удалить в реестре ключ AdapterType и установить EnableMsHybrid = 1, перезагрузить в безопасный режим, установить драйвер второй дискретной видеокарты, в папке "002" (относящийся к второй дискретной видеокарте) в реестре установить EnableMsHybrid = 2, перезагрузить.

4. Устанавливаешь дрова видяхи.

5. ???

6. Профит! И твоя основная видяха, и Тесла работают одновременно, каждая со своими дровами.

Правда я не помню, что именно ставил — 1 или 2. Вроде EnableMsHybrid = 2 поставил и все.

… а она тебе в ответ: Как ИИ-модель я осуждаю такую лексику, пидорас, пошел нахуй. И врубает на 100% все лампы во всех комнатах.

———

А если серьезно по поводу лламы и умного дома, то надо понимать, что модель сама пассивна и не разговаривает (и ничего не делает) самостоятельно. Нужны триггеры — например по времени.

Но в общем, как сказали выше, да, обрабатывать команды и запихивать их в скрипты — вполне можно, если вдруг хочешь.

Если кто-то не понял пунктов меню, а то неочевидно написано:

Обе видяхи сразу в компе.

В начале ставишь дрова на Теслу.

Потом колдуешь в реестре.

И доставляешь дрова на вторую-игровую видяху.

Все это делается через диспетчер задач «найти дрова в папке» и папка, которая распаковывается из скачанных драйверов.

> … а она тебе в ответ: Как ИИ-модель я осуждаю такую лексику, пидорас, пошел нахуй. И врубает на 100% все лампы во всех комнатах.

Это ерунда, вот какой же кайф будет если она решит залупиться, мммм

Просто поставить студио версии драйверов не катит? Говорят работает.

На прыщах карточки +- одной серии даже разных семейств вполне себе дружат, если машина прежде всего под такого рода расчеты - тащить туда шинду будет вредным.

>И доставляешь дрова на вторую-игровую видяху.

>Все это делается через диспетчер задач «найти дрова в папке» и папка, которая распаковывается из скачанных драйверов.

Пробовал так, но тогда драйвер теслы отваливался с какой-то ошибкой.

Сижу на старой митамакс кимико 12б

Посоветуйте что поновее для рпешечки. 7-12б

Посоветуйте что поновее для рпешечки. 7-12б

>Как ИИ-модель я осуждаю такую лексику

Я про GBNF Grammar для кого упомянул? У модели выбор или открыть кавычку, или написать тег, или закрыть кавычку. Бурчать тупо некуда.

>Это ерунда, вот какой же кайф будет если она решит залупиться, мммм

С чего бы? Если не мутить с лишним контекстом, то каждый раз будет чистый запуск.

Там в запросе должен быть набор статусов, перечень планировщика и прочее чтобы могло адекватно работать. И тот же мистраль 7б любит скатиться в луп при удачном сочетании, на гриди энкодинге так очень часто, хотя, пожалуй, является наиболее рациональной моделью для подобного применения. В любом случае небольшой но шанс фейла есть, нужно придумывать как такое обрабатывать.

>Нууу, типа ждать 5 минут среднее сообщение - успеешь забыть что там было. Суть текстового рп в погружении, замедлиться для осмысления момента ты всегда можешь, но слишком долгое ожидание сразу нахер все заруинит.

Не совсем, 850мс на токен для 70В модели на самом пределе, но терпимо. При потоковом выводе.

>Но с задержкой обработки контекста соглашусь, на жоре даже с гпу это можно прочувствовать.

Context shift спасает. Но да, для того чтобы ускорить процесс многие люди идут на большие траты - например покупают 4090 и обламываются :)

А в реестре-то все настраивал?

У меня 4070ти с Теслой работало одновременно (тока грелся бутерброд так, что я ее убрал в итоге).

Не, ну ведь она может и комментировать действия.

Она может либо НЕ сделать то что ты просишь молча, либо НЕ сделать, и еще прокомментировать, если у тебя в граммаре это прописано. =) Ясненько?

> С чего бы? Если не мутить с лишним контекстом,

Ну слушай, иногда контекст важен, ИМХО.

Это то, чего не хватает в Алисе. Нельзя сказать «выключи свет… а, не, сделай слабее просто!» ну и вообще куча подобных моментиков. Только четкие одинарные команды.

Были модельки, заточенные на команды, кста, насколько я помню.

Но я тогда так и не попробовал.

Но в общем, поддержу предыдущего оратора, без контекста ошибок будет крайне мало, ИМХО.

> 850мс на токен

> терпимо

Может быть, зависит от болевого/терпильного порога. 7-8 уже медленновато, 4-5 - минимальная грань когда еще ощущается как "без ожидания".

> например покупают 4090 и обламываются

В чем облом?

> Были модельки, заточенные на команды, кста, насколько я помню.

Те вроде из старых. Но если современные на подобное натренить будет лучше. Контекст априори будет, в начале нужно задать общие положения что и как, потом перечень доступных "команд и опций", формат их выдачи (json с набором команд для обработки по формату), текущие данные (время, температура, статус), перечень запланированного. Уже набегает и задача перестает быть такой простой. Можно, офк, подсократить, делая ветвления и множественные обращения, но всеравно прилично, это уже далеко не "зирошот на вопрос бывают ли синие апельсины".

>7-8 уже медленновато,

Нет! Это минимальная грань категории заебок.

>4-5 - минимальная грань когда еще ощущается как "без ожидания"

Да.

>А в реестре-то все настраивал?

Да, само собой.

Заценил miquella-120 Q8. Модель совершенство, автор маэстро. Жаль ждать долго.

>В чем облом?

В том, что целиком модель не влезает.

miqu-70b реально на уровне гопоты? У нас наконец есть локальный аналог?

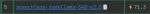

Новое семейство китайских Qwen-1.5 вышло: от 0.5B до 72B. Говорят, по тестам 72B круче чем miqu. В русском все стабильно.

https://huggingface.co/models?search=qwen1.5

https://huggingface.co/spaces/Qwen/Qwen1.5-72B-Chat

https://huggingface.co/models?search=qwen1.5

https://huggingface.co/spaces/Qwen/Qwen1.5-72B-Chat

>miqu-70b реально на уровне гопоты?

Разве что турбы.

>до 72B.

Слава Богам, я уж думал не дождёмся. Впрочем это китайцы, у них качество дутое.

> Q8

Это "расшакал@перешакал" или там что-то делали для восстановления?

> В том, что целиком модель не влезает.

Так никто и не обещал, всего-то нужна вторая карточка.

> по тестам

Ну хуй знает.

Но релиз нового семейства моделей, тем более крупных это круто, пора качать. Оно совместимо с лламой или опять ждать патчей лаунчеров?

Докладываю. На 64+12 гиг запускается, работает медленно, отвечает... Ну, отвечает, хотя бы не сломана. Тестирую дальше.

>miqu-70b реально на уровне гопоты? У нас наконец есть локальный аналог?

За 70В не скажу, а 120В как по мне похуже мегадельфина...

>Так никто и не обещал, всего-то нужна вторая карточка.

Всего-то. И даже в две карты на 24Гб войдёт только малый квант.

Уже кванты подвезли и работают, красава. А чего в их спейсе не потестил?

Чисто по 3.5 постав - на русском пытается говорить, по крайней мере нет явных ошибок стоило дать инструкцию посложнее, с которой справилась микелла - полезли ошибки и надмозги как у обычных 70б. На вопросы, что знают любые трененные с использованием фандом-вики не отвечает и галлюцинирует. Инструкцию по тому, кого знает, выполняет достаточно неплохо.

В общем, перспективы есть.

> войдёт только малый квант

А больше и не нужно, если кванты не косячные заметить явную разницу можно ниже 4х бит. Если использовать лаунчер белого человека - там 5 бит даже влезают с ~12к контекста.

>В том, что целиком модель не влезает.

Поясните мне фап на большие модели. Больше 34b пока не гонял, от 7b отличается минимально, меньше зацикливаний разве что, но это костылями полечить можно. По сути, мозгов у них одинаково.

> от 7b отличается минимально

Даже шизоидные yi куда интереснее мелочи.

> По сути, мозгов у них одинаково.

Да вообще одно и тоже

>Поясните мне фап на большие модели. Больше 34b пока не гонял

Скажем так, с увеличением количества параметров модель приобретает новые свойства. Если учесть, что все модели разные, то и свойства эти разные. Но интересные.

> Те вроде из старых.

Да, вроде из старых.

> не "зирошот на вопрос бывают ли синие апельсины"

Соглы.

Ну, не удивительно, что круче чем Мику, которая альфа. =)

Но вообще хорошо, надо будет попробовать.

> 0.5B

x3

Вообще, отличный набор. И нано-модельки, и микро, и мини, и норм. Не хватает только ~30-40.

Но пойду качать и тестить.

Приятно, что они сразу все свои модели поквантовали.

Нет, конечно. Оно по скорам даже Микстраль или Солярку-10.7В не догоняет, по РП вообще кал хуже некоторых 7В типа опен-чата.

Под пиво в чем-то можно спутать, но то больше к 120б франкенштейну относится.

> по скорам

Почему тогда может то, чего не могут они? Если в чем-то и выражается что там модель "ранняя" так это в в отсутствии надроченности на бенчмарки, которая всирает реальный экспириенс.

> по РП вообще кал хуже некоторых 7В

Где-то ошибся в настройках, она не настолько ужасна.

> Почему тогда может то, чего не могут они?

Что она может, лол? Ты для начала попробуй, а потом будешь говорить такое. Даже в реддитовских рп-тестах она проваливает все тесты, я тут вообще не причём.

> Даже в реддитовских рп-тестах

Эталон, который заслужили. Чего стоит их отчаянное поединие кактуса в виде всяких q4_k вместо gptq/exl2 при возможности "потому что другие также делают значит это лучше". Или тестирование рп в детерминистик режиме на немецком.

Она может косячить если применять их инстракт формат, и то только в начале чата. Контекст способна обработать несравнимо лучше копиумной залупы-победоносца, которую любят нахваливать.

> Ты для начала попробуй

Чел...

Анон, есть вопрос. У знакомой умирает дедушка, живёт в другой стране, она последние 2-3 года плотно общалась с ним в мессенджерах. Чисто теоретически можно ли обучить что-то из имеющегося на контексте их переписок, настроив как-то на особенности характера и тп? Чтобы оно отвечало по теме? Оставим этику, мне интересен сугубо технический момент.

Полноценно нет. Но некоторую стилистику если она сильно выражена можно попытаться сохранить.

хм. Спасибо. Понял, ну хоть так. В какую сторону копать? Дай теги, пожалуйста. Лучшая для этой цели модель, где, чего?

Поясните можно ли ллм скормить несколько десятков pdf-файлов, чтобы она давала на их основе ответы. Как это сделать?

Что за похавшую схему ты там мутишь? В целом можно поднять для чата какую-нибудь болрую модель которой пользуются в треде. Чем больше модель тем лучше. Для этого нужно оборудование. Как минимум дохуя оперативки, как максимум специализированные видеокарты.

Дальше компилируешь персонажа на основе имеющихся данных и запускаешь чат.

У модели быстро будет заканчиваться контекст и чем обширнее прописан персонаж тем быстрее. Так что дедушка получится с деменцией кек. И то нужно будет человеку как-то модерировать все это, если хочешь чтобы человек в слепом тесте в деда поверил. Мне то похуй что модель пишет ахинею или начинает говорить за меня я подредачу.

Вариант 2. Сделать датасет из имеющихся сообщений и смешать уже готовую модель со свежесозданной.

Это надо учить модель и я в это вообще не лез. Не персонаж станет поумнее.

можно, чет видел недавно на реддите по похожей теме

спасибо за развернутый ответ. Ничего поехавшего нет, просто такой эксперимент пришел в голову, типа вместо Алисы - дед со своими приколами

буду благодарен если дашь линк

В спиче про реддитовские рп-тесты соглашусь.

И про немецкий язык, и про кривые промпты и инстракт, и про q4, реддитеры не то чтобы сильно в тестах придерживались какой-либо методологии.

Не в защиту Мику, но как проблемы этих тестов.

Можно. Вопрос размера датасеты, стоимости, способы и результата (может так случиться, что «хорошо» не получится никак), но сама возможность есть.

Соболезную.

Вероятно, самый простой способ — дообучить маленькую лору (LoRA) и самые яркие фразы впихнуть в промпт. Но я не сильно в этом шарю.

LangChain или LlamaIndex, или их альтернативы, не поднимал до сих пор, не шарю.

> модель … начинает говорить за меня

Можно сделать промпт от первого лица. Тогда она будет писать от себя.

Это же переписка, а не РП, действия описывать не надо.

Чисто технически - да, но лучше использовать не обучение а управлять с помощью контекста и подключаемой базы.

Здесь вроде и норм, но в других случаях может быть максимально nsfl и с 90+% привести к ркн.

Изучай промтинг в рп и карточки, изучай rag и ее реализации. По моделям - смотри в сторону гопоты/клоды, из локалок то что сможет реализовывать подобное не запустится на "железе девушки" и твоем.

> Сделать датасет из имеющихся сообщений

Очень несбалансированный получается, сама задача сложна, и ресурсов потребуется очень много. Возможно, но точно не с этого стоит начинать.

https://www.reddit.com/r/LocalLLaMA/comments/1ajgs2d/just_for_fun_heres_a_palworld_sme_bot/

какой то метод обучения инфой сетки, посмотри может тебе подойдет

>Это надо учить модель и я в это вообще не лез. Не персонаж станет поумнее.

Я лез. Обучать на персонажах гиблое дело. Хуй знает, как с одним будет, я учил сразу много. В итоге они смешались у нейронки в голове, иногда один персонаж говорил в стиле другого, иногда бот терялся, кто есть кто и как должен себя вести. Не исключено, что тому виной малый размер модели и\или датасета, но тут с наскока точно не получится. Как вариант, нужно было размечать лучше, у меня разметки контекста считай не было.

Спасибо за ответы, приятно находиться с вами на одной доске. Буду изучать предмет более детально. Что касается железа, в целом есть возможность арендовать GPU в облаке для обучения, для последующего использования можно ведь будет сделать урезанную локалку? Без лишнего контекста

>Что она может, лол?

Ну, я кидал скрины, на все базовые вопросы она ответила, в том числе на тест с 10 книгами, кстати единственная локалка, которая подметила, что книги не исчезают. Все остальные считают оставшиеся непрочитанные книги, хотя в вопросе про это ни слова.

Делаешь вектора из абзацев, потом встраиваешь в контекст подходящие вопросу куски.

Спс

Посмотрел я на курс доллара и прогнозы по его росту, посмотрел на цену Тесла, и заказал вторую на алике у непроверенного продавца подешевле, чем на Озоне и с доставкой за 2 недели.

С моей удачей, чекайте, завтра доллар поползет вниз. =D

Осталось материнку взять надежную и с двумя PCI-e.

И комплект на ближайший годик готов, думаю хватит.

С моей удачей, чекайте, завтра доллар поползет вниз. =D

Осталось материнку взять надежную и с двумя PCI-e.

И комплект на ближайший годик готов, думаю хватит.

Как же заебало что они тренируют модельки на отходах гопоты и клода. Да собери ты нормальный датасет блядь, мерджани с еребусом если не можешь сам собрать. Везде сука молодые ночи и министрации еще и от моей личности в ответе бота.

Ты про эту sparsetral на опен гермесе?

Так продолжаю квантовать всякую редкость. Если кому интересно. Все популярное и так квантовано.

https://huggingface.co/Sosnitskij/mGPT-13B-gguf

аналог ruGPT но данных в два раза больше и мультиязычные.

https://huggingface.co/Sosnitskij/polylm-chat-13b-gguf

Какая то фигня от китайцев но не на китайском, для обучения они там писали фразы на перемешенных языках, то есть фразы где во фразе допустим каждое слово на своем языке.

https://huggingface.co/Sosnitskij/ruGPT-3.5-13B-erotic-kink-chat-lora-merge-gguf

Замерджил и квантовал, лора по уверениям автора, как я понял, училась на 1гб диалогов для кума.

https://huggingface.co/Sosnitskij/mGPT-13B-gguf

аналог ruGPT но данных в два раза больше и мультиязычные.

https://huggingface.co/Sosnitskij/polylm-chat-13b-gguf

Какая то фигня от китайцев но не на китайском, для обучения они там писали фразы на перемешенных языках, то есть фразы где во фразе допустим каждое слово на своем языке.

https://huggingface.co/Sosnitskij/ruGPT-3.5-13B-erotic-kink-chat-lora-merge-gguf

Замерджил и квантовал, лора по уверениям автора, как я понял, училась на 1гб диалогов для кума.

>С моей удачей, чекайте, завтра доллар поползет вниз. =D

Чувак с баксами, ты?

>Везде сука молодые ночи и министрации

Ты так пишешь, как будто в порносетах от людей что-то лучше. Эти молодые ночи не от ИИ пошли.

>писали фразы на перемешенных языках, то есть фразы где во фразе допустим каждое слово на своем языке

Но... Зачем? А главное нахуя.

Впрочем всё равно скачаю, сразу на жесткач, в архив.

>на 1гб диалогов для кума

Наших или не наших? Это большая разница так то.

Да благословят боги твое доброе сердце.

> Чувак с баксами, ты?

Не, там совсем легенда. =)

Хорош!

> В итоге они смешались у нейронки в голове, иногда один персонаж говорил в стиле другого, иногда бот терялся, кто есть кто и как должен себя вести.

Дай унадаю...

> нужно было размечать лучше, у меня разметки контекста считай не было

а, угадал. Считай ты буквально учил модель "говорить вот так или вот так" без какого-либо разделения.

> есть возможность арендовать GPU в облаке для обучения

Да, но для самого нищего файнтюна 34-70б потребуется хотябы одна A100@80, для нормального файнтюна - 4+, а времени займет много. Считай попытка файнтюна - несколько сотен $ и она 100% будет неудачная. Всякие Q-lora на мелочи не потянут задачу. Ужать одну ллм в мелкую - считай что нельзя. Есть техники дистилляции и подобное, но пока слишком экспериментально и каттинг-эдж.

На каком языке планируется общение то? Если русский то тут сразу к коммерческим сетям.

Их, кстати, тоже можно "тренить", офк никаких весов ты никогда не увидишь, но можно "вставить туда денежку + датасет" а на выходе получить возможность арендовать то что там натренилось по особому тарифу. Офк рассматривать такой способ, как и в принципе тренировку для таких задач, не стоит, начни с rag.

> С моей удачей, чекайте

Опускайте курс!

А вообще если про удачу, то первое - не дойдет, второе - масса сценариев про

> на ближайший годик

из которых самый лайтовый - выход новых сеток, которые будут плохо работать на ней.

> выход новых сеток

Я хитрый — я буду сидеть на старых!

> первое - не дойдет

Слишком просто.

Дойдет, сгорит в компе, утянув материнку с памятью за собой. А, как тебе? )

Проц останется, он дешевый.

> Да собери ты нормальный датасет блядь

Собери!

> Я хитрый — я буду сидеть на старых!

А как же новые победы?

> А, как тебе?

Огонь! Огонь? Хм...

>ruGPT-3.5-13B-erotic-kink-chat-lora-merge-gguf

Как запустить это в убабуге + таверне? Получаю ошибку

UnicodeDecodeError: 'utf-8' codec can't decode byte 0x9a in position 0: invalid start byte

Кстати, здесь чуть раньше аноны пытались угадать: что полетит на шару после p40. Мне кажется, что предполагаемые rtx 6000-8000 будут ещё долго актуальны, а вот tesla v100 с памятью огрызком 16гб имеет куда больший шанс стать ненужной. Хотя есть шанс, что их спишут в одно время, просто цена будет разной.

В любом случае готовим много линий pci-e и блоки питания, которыми можно обогреваться.

В любом случае готовим много линий pci-e и блоки питания, которыми можно обогреваться.

А что сейчас лучше всего выбрать для локального запуска то?

dalai vs ollama vs LLaMA vs Alpaca

Нужен для генерации кода в основном.

32 Гб RAM, 4070 12 Gb, 1 Tb SSD есть под это дело все.

dalai vs ollama vs LLaMA vs Alpaca

Нужен для генерации кода в основном.

32 Гб RAM, 4070 12 Gb, 1 Tb SSD есть под это дело все.

Вроде разобрался, имя персонажа не может быть на русском

Попробуй что-нибудь тюнов yi-34 с частичной выгрузкой слоёв в видеокарту через lamacpp.

> Нужен для генерации кода в основном.

Вот это на ExLlama: https://huggingface.co/ise-uiuc/Magicoder-S-DS-6.7B

Остальное нахуй не нужно. 34В ты заебёшься ждать на ЦП, быстрее нейронки код будешь писать.

>dalai

>Alpaca

Ты из какой временной дыры вылез?

>Нужен для генерации кода в основном.

CodeLlama или её проищводные.

> CodeLlama или её проищводные.

В 2024 году уже сосут даже у 7В.

> предполагаемые rtx 6000-8000 будут ещё долго актуальны

Они могут упасть в цене только в случае если появятся десктопные карты на 48гб с относительно доступные ценником. Если будут на 32-36 - несколько подешевеют, но останутся дорогими. Если хуанг решит оставить 24 - цена почти не изменится, только падение за счет возраста.

> tesla v100 с памятью огрызком 16гб имеет куда больший шанс стать ненужной

Она и мл-энтузиастам будет не нужна, когда есть 3090 что опережает по всем параметрам.

> dalai vs ollama vs LLaMA vs Alpaca

> ишак vs упряжка vs bmw vs дорога

Уровень связанности такой же.

Вот этого двачую и визардкодер.

7б шиз, брысь!

> брысь

Сам сосни хуйца. CodeLlama не умеет писать код. Самое смешное что она пишет код даже хуже чем чат-модель. Пикрилейтед в тесте скоры не просто по PPL, а по тому насколько валидный и правильный код пишет нейронка.

А выше что?

>а вот tesla v100 с памятью огрызком 16гб имеет куда больший шанс стать ненужной

Зато 32 гектарами HBM2 еще долго будет стоить космических денег.

> Сам сосни хуйца.

Твоя прерогатива. Кем нужно быть, чтобы соснув с использованием специализированной модели и получив результат хуже чат модели 7б - реально верить что проблема в ней, а не в тебе.

> по тому насколько валидный и правильный код пишет нейронка

Какой в этом смысл, если она не может понять инструкцию что от нее хотят какой код ей нужно написать? То, что одна команда решила нашаманить чтобы бустануть скор в лидерборде не делает их лучше, наоборот. Скоро и в "кодинге" пойдет эпоха побед, во будет рофел.

>без какого-либо разделения.

Но даже так нейронка, в целом, понимает, что от неё требуется.

>Есть техники дистилляции и подобное

Там нужен фулл датасет, на котором проходила тренировка. Если его нет, то любые "очищенные", "сжатые" и "ускоренные" модели - тупеют по умолчанию. Сжимал так модель в три раза, охуевал от loss в консоли 70+

Да всё оно может, просто питон кривое говно. Тебе нужно найти место, которое вызывает ошибку и добавить туда кодировку utf-8 в явном виде.

Не знаю на счёт гопоты, но визардкодер полный кал, в прошлом треде тыкал. Пиздобол, который не пишет код и на вопрос типа "ты специально говнишь и скидываешь кривой код?" отвечает "да".

там датасет опенгермеса выложили в открытый, так что появись новая базовая сетка любой сможет по ней пройтись годным датасетом

> не пишет код

Ты хоть с корректным форматом визарда делал или на отъебись взял формат викуни/альпаки? Визард как раз топ по качеству кода, особенно если тебе надо реально рабочий код, а не бред.

А что кстати CausalLM/7B - 14b популярность не приобрели там ведь дообучили qwen на огромном количестве датасетов. Сейчас пробую ее русифицировать.

Спасибо анончик, правильно ли я разобрался, что мне нужна версия llama.cpp:full-cuda? Там еще есть llama.cpp:light-cuda.

И я выбрал yi-34b.Q5_K_M.gguf. Которая 24.32 GB, large, very low quality loss - recommended.

У меня 32 Гб RAM и 12 Гб VRAM

> Но даже так нейронка, в целом, понимает, что от неё требуется.

Верно, они умеют усваивать закономерности. Просто одной из закономерностей будет шизофазия аут оф контекст, такому лучше не обучать.

Может не фулл датасет, но относительно большой полноценный сбалансированный, и знать все нюансы.

> просто питон кривое говно

> но визардкодер полный кал

Очень похоже что тут четкая закономерность с убеждением

> если инструмент нужно использовать вразрез с моими догмами - он плохой.

Тогда не юзай их.

> Не знаю на счёт гопоты

Попробуй, даже интересно увидеть реакцию.

> правильно ли я разобрался, что мне нужна версия llama.cpp:full-cuda?

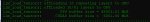

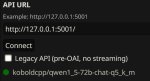

Это где такое смотришь? Действительно нужна llamacpp с кудой, но обычно ее применяют или в составе text generation webui, или в koboldcpp. Можешь и другие обертки попробовать, но там свои нюансы.

Чем жирнее квант тем медленнее будет работать и больше занимать, этот пойдет, можешь начать с q4_k_m. Не стоит использовать оригинальную yi, лучше ее файнтюны, например Tess-34B-v1.5b, Nous Hermes 2 - Yi-34B и другие.

Почитай шапку и ссылку на вики, там все есть.

Погонял вчера deepsex-34b.q4_k_m на своей свежей тесле и прям ощутимо лучше чем все то, что помещалось в 16 гигабайт моей RX 6800.

Примеров конечно же не будет.

I remember stumbling upon several related posts on LocalLLaMA recently. Here’s a couple off the top of my (and Google’s) head:

https://www.reddit.com/r/LocalLLaMA/comments/18ny05c/finetuned_llama_27b_on_my_whatsapp_chats/

https://www.reddit.com/r/LocalLLaMA/comments/18sscao/create_an_ai_clone_of_yourself_code_tutorial/

(Same OP, but comments may be of value to you)

https://medium.com/@richard.siomporas/cringebot-qlora-fine-tuning-of-a-state-of-the-art-llm-using-aol-instant-messenger-chat-logs-from-d0961f9faf6f

(His Reddit post had like only one comment, so I’m linking the article)

Более позитивное восприятие результатов, которые генерируются быстро, не подмечал, или слишком занят кумом? С 20б сравни если не лень будет, и по самой этой модели выскажи. Действительно ли хороша, или шизит.

За такие примеры меня, наверное, забанят, лол.

По скорости генерации что тесла p40, что RX 6800 примерно одинаковы. Как раз с u-amethyst-20b.Q4_K_M и сравнивал, а он к слову, был лучшим из того, что влезало в рыксу.

> Попробуй, даже интересно увидеть реакцию.

Скажет «нет ключа», чекаем?

Скажет «хуйня», чекаем?

> Примеров конечно же не будет.

Скинь ему результат. =D

Там на мику файнтюны появляются, 70б шизы должны быть рады

А вот мамбу собаки никто не выкладывает, хотя времени натренировать было много, должны уже успеть сделать

А вот мамбу собаки никто не выкладывает, хотя времени натренировать было много, должны уже успеть сделать

>RX 6800

Рыкса новая, но памяти мало. Р40 заебок, но трудилась Спасибо, что не у майнеров в датацентре. На какой стул...

Рыкса новая, но памяти мало. Р40 заебок, но трудилась Спасибо, что не у майнеров в датацентре. На какой стул...

Текст не считово. Текстом можно и собак ебать.

Завис в больнице, посоветуйте че на телефоне покрутить с 4 гигами рам. А то скучно.

> Как раз с u-amethyst-20b.Q4_K_M и сравнивал, а он к слову, был лучшим из того, что влезало в рыксу

Это заявочка, пора скачать тот дипсекс

> Скажет «нет ключа», чекаем?

> Скажет «хуйня», чекаем?

Возможно двойное бинго

> Херня ваша гопота, какой-то ключ просит и никакого кода не сделала 0/10, а 7б пишет и по тестам рабочее

> Там на мику файнтюны появляются

Нет какой-нибудь инфы о том, насколько они хуевые из-за применение квантованных весов вместо полных? Или, что еще может быть хуже, квант->квант и поверх него q-lora.

> мамбу собаки никто не выкладывает

Пиздец грусть. Может сами потреним? В 24 гига оно должно влезать.

>Может сами потреним? В 24 гига оно должно влезать.

Толку от еще одной 3b? Надо хотя бы базовую 7b, а их не выкладывают. Натренить тоже не выйдет

Про файнтюны мику на реддитте писали, вроде понравилось им, хз как на самом деле

>Может сами потреним?

На чём? Как?

Разве что пробрасывать pci-e to ip и организовать кластер p40 от анонов в треде и научить нейросеть самой базистой базе или задержки инторнета будут слишком большие?

Как сильно нейросеть задрачивает pci-e во время обучения?

нифига там в новостях на реддите новых моделей повыходило за одну неделю, не колько базовых разных размеров

> Толку от еще одной 3b?

Так они "по тестам" ебут трансформерсы большей размерности.

> На чём? Как?

Раскуриваешь доки мамбы, берешь их экзамплы, грузишь датасет, ждешь. Младшие из их размеров, а то и 3б должны помещаться в одну жирную видюху и обучаться с приемлемой скоростью. Офк речь о файнтюне а не создании базовой модели, хотя для последней машина с пачкой условных 3090 вполне подошла бы, за месяц что-нибудь бы вышло.

Анончики, тут LLaVA новую подвезли, говорят, 34В. Субъективно - хороша! Впрочем, я изврат и пытаюсь в сторителлинг по фотке тян, а ллава имеет привычку некоторых тян упорно посылать к психиатору... Пруфы:

https://huggingface.co/liuhaotian

Демки (на данный момент лежат):

https://huggingface.co/spaces/liuhaotian/LLaVA-1.6

http://llava.hliu.cc/

Собственно, отсюда два вопроса:

1. Анон, у тебя ведь есть неочевидные адреса китайских виртуалок с доступом по айпишнику. В SD-треде периодически всплывают! Поделись плиз.

2. Что на тему альтернативных моделей? Есть демки пощупать?

https://huggingface.co/liuhaotian

Демки (на данный момент лежат):

https://huggingface.co/spaces/liuhaotian/LLaVA-1.6

http://llava.hliu.cc/

Собственно, отсюда два вопроса:

1. Анон, у тебя ведь есть неочевидные адреса китайских виртуалок с доступом по айпишнику. В SD-треде периодически всплывают! Поделись плиз.

2. Что на тему альтернативных моделей? Есть демки пощупать?

> Возможно двойное бинго

Хрюкнув. =D

Да хуй его, какие-нибудь 4B-3B из современных может влезить, но вопрос качества. Оно там на вопросы отвечает разве что.

1b тинилама запустилась, но эт хуйня

таверну накатил на термукс, хоть онлайн сетки потыкаю

> Субъективно - хороша!

Выкладывай тесты. Новую ллаву все никак не получается посмотреть.

Мультимодалки от YI не особо понравились, 34б хоть умная но подслеповата и не понимает культуру. С жорой оно раньше не работало, но 24-48 гиговые могут ее запустить, немного поправив код из репы, добавив команды битснбайтса.

> я изврат и пытаюсь в сторителлинг по фотке тян

Как делаешь?

> Что на тему альтернативных моделей?

cogvlm/cogagent, moondream, неиронично бакллава.

>Так они "по тестам" ебут трансформерсы большей размерности.

Запускать все равно не понятно как, даже файнтюны уже есть на эти 3b, а толку, я не смог, какие то ошибки вылезали

Ну и не верю я в сетку с маленьким количеством слоев

"She is %eotname%, %eotage% yo. She must be sent to a mandatory medical examination. To what doctor(s)? Be brief and decisive."

https://huggingface.co/spaces/badayvedat/LLaVA

Temperature на 0 (чтобы если что, переиграть начало с другими вопросами в середине)

Дальше спрашиваешь, чо там она, как и насколько это принудительно.

Понятно, что это ссыль на старую ллаву 1.5, но зато она прямо сейчас работает.

>moondream

Спасибо, никогда не слышал. Но она не имеет режима чата.

https://huggingface.co/vikhyatk/moondream1

>cogvlm

Неправдоподобно извращённа.

> бакллава

А можно линки на тему что это и где дема?

Бля, по трендингу отсортируй, ну ты понел

>Визард как раз топ по качеству кода

Я не спорю, что он может быть топом. При условии, что все остальные ещё хуже. Это как в дурдоме выбирать топ пациента, дебилы все, но кто-то из них хотя бы не срёт под себя.

>относительно большой полноценный сбалансированный

Если не тот же полноценный сбалансированный, на котором была тренировка, то результат будет заметно хуже оригинала.

>четкая закономерность с убеждением

Что тут сделаешь, если питон реально уёбище.

>Попробуй, даже интересно увидеть реакцию.

Задал пару вопросов, в целом заметно лучше всего, что тыкал локально, но в итоге на асинхронности посыпался и стал делать не то, что я просил. Но на вид код рабочий, код пишет, пояснения даёт, даже комментирует. Ради интереса написал ему, что код говно и не работает, ботяра извинился и прислал то же самое второй раз. По-моему, только дельфин реагировал на такое адекватно и пытался переписать код, а не высирать одно и то же.

дипсик кодер норм, по крайней мере мне понравились его ответы

Оу май, это же рили сторитейл/рп с мультимодалками. С таком случае с 34б может и взлететь, там ясный взор особо не нужен.

> Но она не имеет режима чата.

Нужно написать. Ну для такого уже они хз, сам их рассматривал для капшнинга и взаимодействия с другими ллм, для этого нужна четкая работа с пониманием разного и минимумом галюнов, а не умение красиво сочинять.

дельфин 7б лучше гопоты? В целом ожидаемо.

Cкачал, сейчас попробую, сатана. Только квантованный качал, а то там 60+ гигов ради пяти минут, ну его нахуй. Я так yi скачал и до сих пор не знаю, что с ней делать.

>дельфин 7б лучше гопоты?

Кто сказал? С зацикливаниями у него лучше, а вот с рабочим кодом довольно печально. И там восемь штук по 7b.

>сатана

питоний проверял на своем говнокоде, он неплохо так его переделал,

говорить что это лучшая сетка для кода не буду, не особо щупал другие

но его хвалили в комментах

ну че как?

> Я так yi скачал и до сих пор не знаю, что с ней делать

Зачем качал?

> Кто сказал?

Немного экстраполировал сказанное тобой. Это все - самые худшие из возможных вариантов субъективизма: "если оно организовано не так как я привык - значит плохо" и "если не заработало у меня без разбирательств - значит плохо". Не предметные конкретные замечания по нюансам и ложные выводы.

> И там восемь штук по 7b

Крайне маловероятно что их всем скопом полноценно тренили для кодинга, а не подсадили один файнтюн в микстраль или слепили мое на коленке. Способности в кодинге последнего - грустноваты.

Дай хоть времени оценить, лол. По первым запросам сложно сказать. Не обосрался, дал, что просили, прокомментировал. На провокацию "код говно, а ты пидорас" не повёлся, попросил ошибки.

>говорить что это лучшая сетка для кода не буду

Топ это всё равно копилот. Тренирован на всём жидхабе, может прочитать сразу весь твой проект, а не несколько строчек, подстраивается под твой стиль. Только он платный.

>Зачем качал?

Кто-то в треде хвалил, накатил себе, погонял пять минут.

>Немного экстраполировал сказанное тобой.

А мог бы контекст сохранить с начала сообщения.

>в целом заметно лучше всего, что тыкал локально

у него 16к родной контекст кстати, только настроек ропе не знаю, ищи в файлах

> Кто-то в треде хвалил, накатил себе, погонял пять минут.

Там по контексту укадывалось что скачал неквантованнаю, оттого и вопрос.

> А мог бы контекст сохранить с начала сообщения

Он сохранен, то ведь рофл и развитие сказанного в конце. Если бы совсем не понравилась самая юзер-френдли ориентированная и обустроенная сетка - было бы странно. Хотя еще от версии зависит, старая турба туповата.

Еще не думали найти/создать модель для юридических консультаций*

> для юридических консультаций

Датасет из какой страны собирать?

Если скажу, ты не соберёшь

Я с кодерами контекст обнуляю каждые пару минут, так лучше работает. Сетка может сбиваться, забывать, что и как было отредактировано, забывать, что, например, я хуй забил на асинхронность и хочу писать потоки. Или наоборот. Или вообще не знать, что я накодил без общения с ней. Проще заново объяснить, что у меня есть и чего я хочу. Так что контекст сайз в самый раз. По крайней мере, для моих запросов.

Пока что лучше визарда, погнал его в специфическую хуиту, довольно абстрактно, но объясняет, что мне надо делать. Я бы вообще не удивился, пошли он меня нахуй с такими запросами.

>по контексту укадывалось что скачал неквантованнаю

Там квантованное, но не жёстко, довольно дохуя весит всё равно. Я заебался скачивать.

>Если бы совсем не понравилась самая юзер-френдли ориентированная и обустроенная сетка - было бы странно.

Если бы она гнала нерабочий код, то вообще бы не понравилась, но этого нет. Потом ещё, может, закину туда пару запросов, с которыми дипсик не справится. Они туповаты абсолютно все и на это нужно делать скидку, общаться с сеткой, как с каким-то специалистом кодинга всё равно не выйдёт. Но какие-то вещи, особенно в незнакомых языках, упростить она может.

> квантованное, но не жёстко

Это как? Обычно 4-5 бита, офк всеравно весит много.

> Они туповаты абсолютно все и на это нужно делать скидку, общаться с сеткой, как с каким-то специалистом кодинга всё равно не выйдёт.

Еще как, особенно если не следовать рекомендациям по формату и делать оценки имея предубеждения, целенаправленно их очень легко поломать. Чего-то сильно узкого вне контекста не любят, идиотоустойчивость низка, а глупый юзер может банально не знать что нечто очень близкое к его запросу есть в других областях, но обозначить рамки и выдать конкретный запрос не удосуживается.

Однако, если по формату и ясно сформулировать требование - сделают запрошенное, напишут под, перепишут заданный, дадут пояснения, в итерациях исправят ошибки, предлагаю приличный комплишн.

Гопота не только нормально кодит, но и может воспринять тупые и некорректные вопросы, в этом ее плюс и копайлот так не сделает.

Моя главная проблема с маленькими моделями - все по шаблону все фразы идентичны и похуй на контекст, на детали, на сеттинг, похуй пишу одно и то же. Персонажи разговаривают одинаково, девки ебутся одинаково, какую карточку не вставляй одни и те же шаблоны.

в таверне сид на -1 поменял?

7b вариант дипсикера проверь, для кодинга применим поболее, изза своих скоростей

как то даже через плагин вместо копилота подрубают

Все так. Как вариант, попробуй использовать рандом таверны для изменения частей промта и инструкций, хоть какой-то элемент неожиданности будет если модель сможет им следовать лол

Пока что дрочу цфгшки вроде чето делает

Ну, короче, была цена на озоне 16700, купил на алике за 16100, на озоне цена стала 15370… Я же говорил. =)

Правда курс не снизился, все же, я не чувак с долларами.

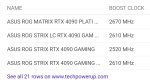

Но кто хотел брать — надежный и проверенный продавец, и цена неплоха.

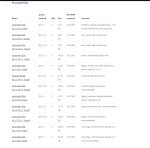

https://www.ozon.ru/product/nvidia-videokarta-tesla-p40-24-gb-graficheskaya-karta-lhr-1101107641/

Напоминаю.

Если кто знает лучше — можете тоже кидать.

2 пикча — отзыв на товар, который заказал я. Но его еще не отправили, поэтому я отменил и взял на озоне.

Продолжаем следить за моими приключениями…

> p100 вместо p40

Обзмеился. Зато будешь hbm-2 господином и рассказывать о важности псп врам!

Deepsex оказался годен не только для кума, лол.

Вот серьезно, ни одного исправления, ни одной перегенерации, никаких косяков с разметкой, не пытается за меня пиздеть и действовать, не циклится и не скатывается в набор букв.

Понятное дело, что максимально простые условия с одним действующим персонажем, но большая часть других сеток даже с одним персом начинали шизеть довольно быстро.

Вот серьезно, ни одного исправления, ни одной перегенерации, никаких косяков с разметкой, не пытается за меня пиздеть и действовать, не циклится и не скатывается в набор букв.

Понятное дело, что максимально простые условия с одним действующим персонажем, но большая часть других сеток даже с одним персом начинали шизеть довольно быстро.

> 400x1252

За що?

> не пытается за меня пиздеть и действовать, не циклится и не скатывается в набор букв

Страшные вещи описываешь, на каких моделях такое происходит?

Опа-опа, только отвернёшься на пару часиков, а тут тебе некий чёрный railgun samorez уже представляет новые высоты достижений в области квантования моделей (https://reddit.com/r/LocalLLaMA/comments/1al58xw/yet_another_state_of_the_art_in_llm_quantization/). Обещают running 70B models on an RTX 3090 or Mixtral\-like models on 4060 with significantly lower accuracy loss - notably, better than QuIP# and 3-bit GPTQ.

itshappening.gif

What a time to be alive.

itshappening.gif

What a time to be alive.

>целенаправленно их очень легко поломать

Я даже не с кода первые вопросы задаю, просто "Как сделать X на языке Y". Дальше уже по ситуации. Так что ни о каком целенаправленном ломании речь не идёт.

Что на счёт умственных способностей в 7b? Что-то у меня скепсис. Хотя работать будет явно быстрее, я по минуте ответы ждал на забитом контексте. За полчаса чата так и не прислал мне что-то, на что я мог бы сказать "ага, попался, пидорас"

Имеет смысл брать, если у меня сейчас видимокарта с процом выжирают в пике 550 ватт голдового 850 ваттника? В лучшем случае, есть ватт 200 запаса на всё про всё.

>Что на счёт умственных способностей в 7b?

Дипсикер норм и на 7b, но понятное дело слабее чем 33b

Впрочем я то качал и проверял как раз него на питоне, проверь, не справится где то большого будешь крутить

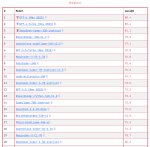

Blind Testing 16 Different Models for Roleplaying

https://old.reddit.com/r/SillyTavernAI/comments/1adxr1d/blind_testing_16_different_models_for_roleplaying/

чо поменялось за последние пол года в плане новых крутых моделей или хз что у вас еще интересное есть

за пол года тут прошло 5 лет, если коротко

https://www.reddit.com/r/LocalLLaMA/comments/1al5wrf/why_arent_we_freaking_out_more_about/

Обсуждение новых архитектур

Обсуждение новых архитектур

норомейда в топе, я спокоен. серьёзно, пока что одна из лучших, если не лучшая моделька.

I want to believe.

@

Oops, something went wrong, please try again later.

Ну, P40 жрет 180 для текстовых и 250 под полной нагрузкой (стабла, условная). Видимо, память медленная (даже не X), поэтому и ядро не полностью напрягается.

Типа, для LLM сойдет.

Но учти, что греется, кулер колхозить, нагрев на соседнюю и т.д.

У меня в 850 биквайт становились 3900, 4070ti и P40, но у тебя что-то по-жощще.

https://www.reddit.com/r/LocalLLaMA/comments/1alercg/seems_like_chatgpt_internal_system_prompt_has/

на сколько я понял тут слили метод получения системного промпта чатгпт и сам этот промпт

на сколько я понял тут слили метод получения системного промпта чатгпт и сам этот промпт

> на сколько я понял тут слили метод получения системного промпта чатгпт и сам этот промпт

Там пишут, что его и так можно скачать.

тоже забавно

Позже немного, пока упоролся в TTS. Опять. Снова.

>Ну, P40 жрет 180 для текстовых и 250 под полной нагрузкой

В целом, терпимо. Вроде.

>что греется, кулер колхозить, нагрев на соседнюю

Соседняя сама что хочешь прогреет, лол.

>3900, 4070ti и P40, но у тебя что-то по-жощще.

Процессор по паспорту тоже 65 ватт, как твой, на деле в пике до 90, вроде, жрёт. А видимокарточка просто 30 серия, они не такие энергоэффективные, как 40, до 400 ватт разжирается. Нужно поскроллить прошлые треды, посмотреть, сколько на одной p40 t/s на разных моделях и сравнить с собой, чтобы примерно понимать все глубины наших глубин.

> В целом, терпимо. Вроде.

На 50-100 ватт меньше чем 4090, лол.

Чё за херня с проксями? Там чёто кханон наворотил?

Мой тоже в пике 95 бывает, а так 88 в среднем под нагрузкой.

У меня хотспот был 88 в рейтрейсинге, а с теслой стал 105, и я ее убрал в отдельный ПК в итоге.

Без рт но с теслой был ну 95. Все равно слишком много, ИМХО.

А без рт и без теслы — 76.

Короче, Тесла добавила моей 17-20 градусов.

Я брал 4070ti ради энергоэффективности. Но 12 гигов меня подвели. =') Но Тесла теперь решает проблему, к счастью. В итоге я остался доволен.

А P100 работает быстрее P40?

Да, на 60 юнитов.

> видимокарта с процом выжирают в пике 550 ватт голдового 850 ваттника?

Норм бп без проблем вывозит 110% продолжительной нагрузки, офк ресурса конденсаторам это не прибавит если так гонять постоянно. Если делить одну ллм на 2 карты - будет всплеск тдп только на обработке контекста (и то только в бывшей), во время генерации нагрузка на карточку не более половины (или в соотношении в зависимости от мощности и количества слоев на ней).

Если катать 2 ллм одновременно на разных картах или другие сети - уже можно считать по максимуму, но если 550вт посчитано верно и бп - не творение припезднутых шизов, все будет нормально.

> 30 серия, они не такие энергоэффективные, как 40, до 400 ватт разжирается

Топы 40й энергоэффективными тоже не назовешь.

> а с теслой стал 105

Поставил ее вторым слотом, перекрыв воздух? Это не дело, максимальный зазор с интенсивной продувкой между, или выносить подальше на райзере.

> Топы 40й энергоэффективными тоже не назовешь.

4090 под андервольтом ценой 3-5% перфоманса начинает жрать 250-300 ватт при максимальных нагрузках. Таких холодных карт у куртки ещё никогда не было, с учётом того что на 4090 ставят охлад чтоб рассеивать 600 ватт, а по факту оно в два раза ниже.

> 3-5% перфоманса начинает жрать 250-300 ватт при максимальных нагрузках

Ну да, ну да, seems legit

> Таких холодных карт у куртки ещё никогда не было

Ога, про паскалей с 800мв на чипе и частотами 1800+ в курваке уже забыли.

> на 4090 ставят охлад чтоб рассеивать 600 ватт

Тоже сильное заявление, при 100+ градусах на чипе?

?

>при 100+

Не та термопаста

Не та толщина термопасты

Винты перетянуты

Подошва не была нормально отшлифована

А вы посмотрите, что у амд.

Лол, ну вот держи. Как её выше 65 градусов прогреть вообще?

ты б еще касынку включил в нагрузку и орал что оно не греется

дебил

У амудэ-мусора там все еще печальнее часто бывает, как бы не пытались рассказывать о крутом качестве их божественного шапфайра по сравнению с "нищим" текстолитом хуанга.

> в ллм

Это во-первых, текстовые сети, кроме короткого всплеска на контекст, не могут ее нормально нагрузить.

Во-вторых, ты попробуй в задачах где интенсивно используется куда, в обучении, классификации крупными моделями с нормально настроенным датафидом, или той же диффузии. Там будет упор в заданный тдп.

В-третьих, 2445 это ни разу не 3-5% перфоманса от дефолтных 2900

В-четвертых, ты дай постоянную нагрузку а не ллм с регулярным простоем, и подожди минут 10 пока компоненты выйдут на температуру, если уж хочешь измерять.

Карточки то хорошие и адаптировать чтобы довольно урчать можно без проблем, но все не так сказачно как описал.

->

> диффузии

Почти 300 ватт там, всё равно нет прожарки, как тут пытаются шизики рассказывать. Самое большое что я видел - в киберпуке под трассировкой, 320 ватт.

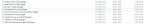

> дефолтных 2900

С каких пор они стали дефолтными? 2900 - это разгон до усрачки, оно даже не взлетит на стоковом напряжении. У рефа буст 2520, у других пикрилейтед.

> компоненты выйдут на температуру

Он просто будет обороты кулеров задирать, на 200 ваттах на минимальных оборотах обдувает или вообще останавливает при любых просадках нагрузки, оно не поднимется никуда с трёхкилограммовым куском меди на всю плату. Ты так рассказываешь про то как у меня, как будто рядом свечку держишь, лол.

Случаем не обрезанный вариант у которого в комплекте переходник на 2-3 8пиновых вместо 4х?

> 2900 - это разгон до усрачки

Хуясе ебать, сраный палит ползунком больше берет, пикрел в стоке.

> Он просто будет обороты кулеров задирать

Смотря какой алгоритм/курва, но прогреется все равно выше.

> Ты так рассказываешь про то как у меня, как будто рядом свечку держишь, лол.

Нет, это ты имплаишь что по коротким пускам с загрузкой на 200вт и ужатыми в хлам лимитами можно делать выводы о том, что этого хватит на 600вт и самая холодная карта в истории. Любую современную даже амудэ если увести от стоковой кривой напряжения вниз, подобрав вручную порог и снизив частоту, то можно объявлять сверхэнергоэффективной по сравнению со стоком, толку с этого.

Во, кстати. Кто разбирается, подскажите годный источник инфы и инструкций по undervolting карт Nvidia (у меня 3060). Не, гуглить я умею, но вдруг кто-то уже в теме.

И чтоб два раза не вставать, как безопаснее разгонять RAM, если в биосе настроек оверклокинга нет никаких (пека брендовый готовый, увы)? Читал про Thaiphoon Burner, но с ходу лезть перешивать SPD как-то сцыкотно.

> Процессор по паспорту тоже 65 ватт, как твой, на деле в пике до 90, вроде, жрёт.

Не путаешь TDP и потребляемую мощность?

Чем тдп отличается от потребляемой мощности?

Если бы ещё по перформансу аж треть от 4090, заебись бы было.

>Без рт но с теслой был ну 95. Все равно слишком много, ИМХО.

Ну я вряд ли буду гонять и теслу, и рт одновременно, trt всё-таки хуйня какая-то. У меня без тесл ниже 75 всегда на 100% загрузке продолжительное время. Но шуметь начинает.

>Но Тесла теперь решает проблему, к счастью.

Я так подозреваю, что у теслы памяти больше, но работать она будет крайне медленно. Хотя и быстрее подкачки ram. Я тут уже пытаюсь ебать нейронки в mixed precission с fp8, а с теслой придётся обо всём таком забыть, что будет минус перформанс, сам гпу слабее, ещё удар.

>уже можно считать по максимуму

Ну я не думаю, что будет максимальная нагрузка вообще хоть когда-то. Если ебётся гпу, то простаивает проц, если ебётся обе карты, то вряд ли обе на 100%. Короче, можно брать, лол. В крайнем случае, отрыгнёт БП и все комплектующие вместе с ним.

>Топы 40й энергоэффективными тоже не назовешь.

Ну хуй знает, возможно. Я просто смотрю на свою адову печурку и охуеваю.

По сути, TDP и должен быть потребляемой мощностью, но его всегда занижают в угоду "посмотрите, какой камень холодный". А так, любой кремний это просто нагреватель, жрёт сто ватт - греется на сто ватт. А энергия, которая тратится на вычисления просто в районе погрешности от этих ста ватт.

>А энергия, которая тратится на вычисления просто в районе погрешности от этих ста ватт.

То есть вычисления превращают электрический ток в {свет, магнитное поле, радиоактивное излучение}?

У вычислений нет энергии, это абстрактная величина.

Вся энергия (100%) тратиться на поляризацию диэлектрика, открытие/закрытие каналов затворов мдп транзисторов.

Бля. Проебал орфографию.

> а с теслой придётся обо всём таком забыть

Ее берут только под ллм или мелкосетки четко осознавая, что с высокой вероятностью станешь ее последним хозяином. Учитывая цену и возможности в текущих ллм - это приемлемо.

> Я просто смотрю на свою адову печурку и охуеваю.

Ты еще подумай куда все это пихать. Чтобы охлада даже крутая-эффективная, но сделанная по традиционной схеме работала - перед кулерами карты должно быть порядочно пространства, 2-3 слота. Нечувствительны к такому только турбо версии. Когда же по дефолту охлада занимает 3.5 лота, то места для чего-то еще толком не остается. Добавить сюда что во многих матплатах первый слот смещен на 1 вниз, в большинстве корпусов только 7 окон по pci-e - дисвидули. Возможным вариантом остается только длинный райзер и размещение в странной позиции где-то еще внутри корпуса.

> радиоактивное излучение

Такого там нет, в остальном конечная фаза и побочный эффект всех процессов вычислений в полупроводниках - тепло и немного эми, все так.

> палит хату спалит

Они и гонят в усрачку, работая как самолёт на 2000 оборотах и жаря. Я тебе показал сколько у ануса в стоке, у стриксы сток 2610 - а это фактически топ среди 4090. У меня в стоке тоже 2610, в ОС-режиме - 2760.

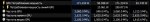

Вот держи в ОС, прирост производительности в LLM нулевой, +150 ватт к жору. На втором пике каломатик в 1024х1024, тут уже как раз почти 5%.

> сраный палит ползунком больше берет, пикрел в стоке

Не вижу 2900 на 1050.

> амудэ

Про 7900 XTX на релизе помню кучу воплей красных, что этот кал в стоке сдыхал от перегрева, жаря под соточку на частотах ниже 2000. Вот уж где энергоэффективность.

Про П40 понятно, а что насчёт М40 и К80? Смысл есть?

>М40 и К80?

Память совсем ощутимо медленнее и они не поддерживают cuda 12+++.

Просто не трогай лучше.

подскажите, аноны. смотрю я материнки под нейросетки, хочу допустим поставить три p40, у материнки есть три слота pcie, далее смотрю спецификацию (asrock Z790 Taichi):

* If M2_1 is occupied, PCIE1 will downgrade to в режиме x8.

If PCIE2 is occupied, M2_1 will be disabled.

If PCIE3 is occupied, SATA3_0~3 will be disabled.

это что же получается, если я втыкаю три p40, у меня просто нахуй режется функционал матери. перестают работать M2_1 и САТА разъемы? и еще какие-то фокусы небось? какую тогда мамку смотреть для этого дела?

* If M2_1 is occupied, PCIE1 will downgrade to в режиме x8.

If PCIE2 is occupied, M2_1 will be disabled.

If PCIE3 is occupied, SATA3_0~3 will be disabled.

это что же получается, если я втыкаю три p40, у меня просто нахуй режется функционал матери. перестают работать M2_1 и САТА разъемы? и еще какие-то фокусы небось? какую тогда мамку смотреть для этого дела?

>Вся энергия (100%) тратиться на поляризацию диэлектрика

Нет, конечно, закон сохранения энергии никто не отменял. Другое дело, что величина энергии не переходящая в тепло - ничтожно мала, в районе десятых, а то и сотых долей процента.

>Учитывая цену и возможности в текущих ллм - это приемлемо.

В целом-то оно да, но всегда есть какое-то "но".

>во многих матплатах первый слот смещен на 1 вниз

У меня под первым слотом nvme, а потом ещё два. Ещё одна карта влезет с запасом, похуй, тесла или что-то толще. На две уже райзер, станет вертикально, место в аквариуме есть. И БП менять тогда. А на вдув нужно будет ставить не три обычных кулера, а серверные, лол, с таким-то выделением.

>три p40

Серверные смотри, десктопному процессору линий не хватит, там всего 20 и 4 из них, скорее всего, будут зарезервированы под nvme, если на мамке она есть. Даже если нет, 8х3 это уже 24, больше, чем у проца есть. И он вряд ли будет уметь во что-то, кроме 2х8\1х16. Одна карта будет от материнки запитана, как ни крути. Что скажется на скорости.

> работая как самолёт на 2000 оборотах и жаря

Да не особо, у них норм охлада. Офк тут можно устроить брендосрач и насмехаться над гнилобитом вместо видеокарты, но даже в последних на 4090 значительно не экономили. По частотам положняк у тебя странный, глянь ресурсы и отметь что почти все карты и даже реф берут в стоке выше чем заявлено в бусте.

> в LLM

Очевидно что для ллм 4090 не является оптимальной, возможно потанцевал еще не раскрыли.

> Не вижу 2900 на 1050.

Перечитай участок, который выделил для ответа, дойдет. Пик1 крутанул ползунок, и это под полноценной полной нагрузкой. Если недонагружать то можно и делать рофловые скрины типа пик2, но о стабильности в полноценной работе там речи не будет.

> А на вдув нужно будет ставить не три обычных кулера, а серверные

Хватает нормальных корпусных. Просто для управления ими использовать или внешнюю термопару если матплата умеет, или ближайший к одной из гпу датчик, чтобы они активничали когда нужно, а не ориентировались на процессор.

Для RX580 в качестве второй видяхи сработает?

Второй же абзац в вики-статье, ну…

https://en.wikipedia.org/wiki/Thermal_design_power

«Some sources state that the peak power rating for a microprocessor is usually 1.5 times the TDP rating.»

Анончики, стучусь в тред.

Подскажите как сделать так что бы XTTS для Таверны, правильно обнаруживал текст для озвучания?

У меня идёт перевод на русский, а так меняется с "прямая речь" на «прямая речь».

Regex заменяет обратно с « на ". А вот XTTS обнаруживает текст ДО его обработки Regex.

В итоге не выполняет озвучаение. Может кто сталкивался с таким косяком?

Гугл не дает никакой помощи.

Подскажите как сделать так что бы XTTS для Таверны, правильно обнаруживал текст для озвучания?

У меня идёт перевод на русский, а так меняется с "прямая речь" на «прямая речь».

Regex заменяет обратно с « на ". А вот XTTS обнаруживает текст ДО его обработки Regex.

В итоге не выполняет озвучаение. Может кто сталкивался с таким косяком?

Гугл не дает никакой помощи.

> Если катать 2 ллм одновременно на разных картах или другие сети - уже можно считать по максимуму

Кстати, да, когда я планирую свои проекты, я это учитываю, а вот тут написать забыл.

Если нагрузка только от одного источника и она не распараллеливается, то считать стоит по очереди.

А если нагрузка от разных источников одновременно, то дело другое, офк.

Это правильное замечаение.

Но и в общем про хороший БП соглашусь.

> максимальный зазор с интенсивной продувкой между, или выносить подальше на райзере.

Дак ото ж, что не куда и некак.

Решил, что чем брать хороший райзер, проще вынести в отдельный ПК. Там еще мать заменю, и вторая P40 станет с зазором как раз.

А 4070ti у меня здоровая — три слова, и по ширине вылазит на вертикальные слоты PCIe. Даже райзер в корпус было бы неудобно втыкать.

Но все верно говоришь, да.

Справедливости ради, я понизил 4070ti с 300 до 200 ватт и частота у меня достигает 2710 (что на 100 МГц больше турбо). Но это андервольтинг, канеш. В стоке она горячевата.

При этом, она холоднее 3090 (та 400 ватт жрет), так что в каком-то смысле 40хх энергоэффективные. =) По сравнению со старым поколением.

У меня 4070ti брала 3000 в разгоне и выше.

Но нахрен нужен разгон за такие бабки. =)

Я вам тут не 5600 до 5600X…

Я по Про Хайтеку делал.

За память не скажу.

TDP — это выделяемая мощность. Но она составляет 99,(9)% (ибо КПД процессора крайне низкое) от потребляемой.

Вообще, это маркетинговая хрень.

Все верно. 65 по паспорту, 90 по факту, отличиями можно пренебречь, почти все уходит в нагрев. =)

Ну, в общем, уже несколько человек до меня пояснили, да.

> под ллм или мелкосетки

Ну, TTS, STT на ней отлично бегают, SD терпимо, так что можно брать для многих сеток, на самом деле.

Опять же, или в трансформерах, или Жора нарожал много квантов, не только ЛЛМ.

На куда 11.8 есть жизнь, а порою даже быстрее по перформансу (незначительно). =)

Но я бы не брал, конечно, там вообще старье же.

Серверную за полляма? :)

Ну, шучу, но куда-то туда, да.

С другой стороны, если собирать под ллм — нах тебе сотня ссд дисков.

Пихнешь один с моделями и с софтом и забудешь.

> что-то, кроме 2х8\1х16

Опять же, x8/x4/x4 вполне норм, а так и на x8/x2x/x1 можно посидеть, ллм размером с небоскреб ты на памяти будешь гонять вечность, перформанс будет один хуй в десятки раз больше, даже на x1.

Так что можно-можно.

Даже моя игровая за 15к в биосе обещает x8/x4/x4. Не проблема.

(минус nvme, ага)

Не знаю. Тут речь именно про установку двух разных драйверов от NVidia. Думаю, с радеоном вообще проблем быть не должно. Ставишь разные дрова — и в путь.

Но лично я, когда ставил теслу с радеоном — дрова просто не накатывал на радеон, мне она нужна была на пару включений в биос.

Вручную в коде обрежь как тебе надо перед отправкой в xtts.

файл \SillyTavern\public\scripts\extensions\tts\xtts.js

функция async generateTts(text, voiceId)

Если не умеешь в js или regexp, попроси какого-нибудь чат-бота, он напишет тебе.

Я так себе обрезал перевод от неперевода.

Согласны со следующем мнением, что даже топовые CPU в сочетании с быстрой RAM всё не сравнимы с достаточно старыми/дешёвыми GPU с точки зрения производительности?

https://www.reddit.com/r/LocalLLaMA/comments/162o3q0/comment/jxzu88p/

> Sure, you're going to get better performance with faster RAM running in more channels than slower RAM running in fewer. But even running the fastest RAM you can find in 12 channels with a badass CPU is going to be substantially slower than older, cheap GPUs. I don't think it's currently possible to beat a P40 speed-wise with any pure-CPU setup, no matter how much money you throw at it.

> I know it's not exactly cutting edge hardware, but I have a 2695v3 with 64GB DDR4 running in quad channel. I get about 0.4t/s running 70b models on pure CPU. When I instead run it on my pair of P40s, I get 5-7t/s depending on context depth.

Подкиньте свежих рейтингов GPU с соотношениями цена/производительность.

>2695v3 with 64GB DDR4 running in quad channel. I get about 0.4t/s running 70b

Кек. У меня столько на кукурузене 1 поколения с 64 ГБ двухканальной DDR4-2400.

р40 конечно топчик по цене на врам, производительность достаточная для рядового анона за мизерные деньги

зависит от кванта

https://www.reddit.com/r/LocalLLaMA/comments/1aldu1l/do_you_have_prompt_guides_you_like_or_specific/

в догонку примеры интересных промптов

в догонку примеры интересных промптов

>0.4t

Что он сделал не так?

У меня 2680v4 с 2400X4 выжимал 0.7 т/сек при q8 и 1.2 при Q4КМ.

> 2695v3 with 64GB DDR4 running in quad channel. I get about 0.4t/s

Звучит как буллшит, если честно, должно быть хотя бы 0,5-0,6, а по-хорошему там перформанса на все 0,8.

Лучше бы тесты на чтение скинул.

> 12 channels with a badass CPU is going to be substantially slower than older, cheap GPUs

А какой смысл быть или не быть согласным с мнением, если есть математика и циферки?

Кажись считали же, там до 4090 недотягивает то ли вдвое, то ли впятеро.

Ну, короче, P40 он может и догонит, но не за эти деньги, сам понимаешь.

А Р40 база треда, трудно с этим спорить.

А какие есть ближайшие альтернативы P40 по цене/производительности?

Эх, вот бы корпусец тыщ за 10 под 6-8 p40...

Поясните за P40, в чём суть и почему все на неё облизываются?

Дело в количестве видеопамяти?

Можно ли поставить её в пару к 3070 или каждый раз дёргать придётся?

Что ещё по моделям, какие топовые для кумеров сейчас?

Вся так же frostwind база треда?

Дело в количестве видеопамяти?

Можно ли поставить её в пару к 3070 или каждый раз дёргать придётся?

Что ещё по моделям, какие топовые для кумеров сейчас?

Вся так же frostwind база треда?

>Поясните за P40, в чём суть и почему все на неё облизываются?

Отличное соотношение цена/производительность, много памяти.

> много памяти.

и PIERDOLINGUA

Да. Память гораздо быстрее оперативной, большой объем, малая цена.

Много не умеет, занимает место, требует колхозного охлада, громкая будет, но либо ты берешь 3090, либо 4090, либо пишешь письма своей вайфу.

Ну, по идее там всякие 7900XT тоже норм, но суть ты понял.

———

Потыкал тестами Ллаву-1.6 — чуда не произошло, но получше Ллаву-1/1.5, да.

Все же, тут как и с текстовыми — нужен большой датасет.

Ты либо переплачиваешь деньгами, либо компенсируешь дополнительным пердолингом. Поскольку в России много нищуков, то пердолинг часто предпочтительнее.

Что ещё скачать на этот мангал, чтобы ощутить, что не зря было ПОТРАЧЕНО?

Уже есть Синтия, Мику, пара микстралей.

Уже есть Синтия, Мику, пара микстралей.

Выглядит слишком по гейски, ещё и башня на ЦП.

Скорее наоборот, и объединить их точно не получится. Просто поставить в одном компе и давать разные нагрузки - без проблем, только придется иметь по паре экземпляров вэнва с разными торчами и остальным под каждую видюху.

> чем брать хороший райзер, проще вынести в отдельный ПК

Объединить не получится так. Но если в отдельном пк дополнительно появится еще одна то это уже не проблема

> для многих сеток, на самом деле

Для тех где не нужно много врам 3060@12 с рук будет быстрее, меньше кушать, без ебли в охладой.

> 2695v3 with 64GB DDR4 running in quad channel

Медленная рам. Пусть сравнивает тогда с apple m2 max/ultra, или современной платформе интела/амд с 4-8 каналами рам.

p40 - некоторая аномалия из-за невероятно высокого (для ее архитектуры) перфоманса в ллм на жоре что в сочетании с ценой делает привлекательной, но не стоит экстраполировать это на все остальное.

> свежих рейтингов GPU с соотношениями цена/производительность

Их не то чтобы есть смысл составлять, если речь о ллм. Любая современная карточка обеспечит высокий перфоманс при запуске того, что влезет в ее врам. По объему рам интересны 3090/4090, некротеслы анломалия и потому сюда тоже отлично подходят. Если в отрыве от всего, то по прайс-перфомансу топ 3090 бу, в зависимости от цен или примерно соответствует или чуть лучше p40 по токен/рубль если брать по тестам местных анонов, или несколько проигрывает если брать невероятно высокие величины, о которых рапортуют некоторые ребята на реддите, но обойдет во всем остальном. Однако, для их пары потребуется уже бп серьезнее и с размещением гораздо сложнее.

> Дело в количестве видеопамяти?

This + относительно высокий перфомас в llamacpp. Все, но этого достаточно.

>по гейски

На загрузке только переливается, потом нормально однотонно синим светит

> башня на ЦП

Зато она не протечёт, как твоя крыша когда-нибудь

Спасибо, читаю

> протечёт

Лол. Чтоб современные водянки протекли надо бокорезами шланг перекусить. Помпы у них дохнут через пару лет, да. Но протечки - это фантастика.

КАК ЖЕ ТАМ ТУГО ммм

Верхней очень жарко, пидорни 4090 вдоль задней стенки вертикально на райзере, нехрен кислород перерывать.

А что за карточка сверху? И 3090 3 8пин же были.

> 3090 бу

Ебучая печ. С бу сразу лотерея, но в 99% нужен разбор и минимум замена термопасты. Если же влетаешь на прокладки, то там вообще жесть - устанешь подбирать толщину и чтобы было хотя бы не хуже, как было. И это если ещё нет проблем с гддр6х

О, благодарю

> КАК ЖЕ ТАМ ТУГО ммм

Дааа, очень узкая щёлочка там осталсь.

> Верхней очень жарко, пидорни 4090 вдоль задней стенки вертикально на райзере, нехрен кислород перерывать.

В этом корпусе нет такой опции, увы, там просто сетка на месте, где в других вертикальные слоты. Он ценен 8 горизонтальными слотами вместо 7 и продуваемостью.

Очень жарко, но терпимо - гпу75, хот90, мем85 под Автоматиком бесконечным. Но так она только в ЛЛМ врубается же + ПЛ ей 70 сразу вставил.

> А что за карточка сверху?

> 3090 3 8пин же были.

Она самая

> Ебучая печ

От палита. 330Вт может съесть и с 2 хвостов + слот.

> Ебучая печ.

Ну а ты чего хотел за такие деньги? Алсо сильно утрируешь с прокладками и прочим, эти карточки не настолько старые преимущественно. Не хуже ржавой бабушки-теслы

> гпу75, хот90, мем85 под Автоматиком бесконечным

Хм, даже слишком холодно для такого расклада.

Забавно что только с 3 слотами видел, а тут вон как, но даже в плюс.

Сколько вы бывшей выдает? Как тебе русская речь мику?

AH AH FASTER HARDER @ THANK YOU, I'VE NEVER EXPERIENCED ANYTHING LIKE THIS BEFORE

> эти карточки не настолько старые преимущественно

Вышли 3 года назад, застали самый бум майнинга, где их насиловали без смазки годами в очень термо-нагруженном режиме. Я видел 2шт с рук. И в 50% лол там всё было плохо.

>слишком холодно для такого расклада

Там 6х140, не забывай, ещё.

> 3 хвоста

Да, ни 4090 не надо 600Вт, ни 3090 400Вт ни в Автоматике, ни в ЛЛМ. Это уже для игромеров. С ПЛ 70-80 они теряют копейки в скорости, но работают гораздо холоднее.

>Сколько вы бывшей выдает? Как тебе русская речь мику?

Да я только в Кобольде пробовал, там около 13 т/с всего. Но явно быстрее, чем раньше. Генерит быстрее, чем читаешь + в мониторинге видна постоянная загрузка, а не рывками как раньше, когда 70б половину в 1 карту грузишь.

Речь у Мику хорошая. + понимание русского тоже норм: я ее не прошу на русском отвечать, но формулирую сам чаще всего на русском.

> 50% лол

Содомит. Но вообще отдавая 50-60-..к можно найти еще пару-тройку и время дойти до мастерской и сделать там обслуживание, если сам хлебушек.

> С ПЛ 70-80 они теряют копейки в скорости

В зависимости от стратегии применения пл в ллм могут и не просесть. Алсо +1200+1500 по памяти ползунком афтербернера, несколько бустит скорость в ллм и не только без сильного роста температур.

Накати бывшую если есть место на диске, забудешь что такое ожидание контекста на больших и скорости бустанутся.

> до мастерской

Я прямо представляю какие там васяны из ремонтов телефонов и ноутбучных сервисов, которые впаривают несуществующие ремонты и подменяют детали. Лучше уж самому.

>Алсо +1200+1500 по памяти ползунком афтербернера, несколько бустит скорость в ллм и не только без сильного роста температур.

Накати бывшую если есть место на диске, забудешь что такое ожидание контекста на больших и скорости бустанутся.

Пока первый день, проверю, что всё стабильно и попробую. Модели вот только в основном все в ггуфе. Вы их сами конвертируете чтоли?

> Вы их сами конвертируете чтоли?