Напоминаю, что у нас есть целый железотред, который уже полгода перекатить не могут.

Как насчет добавить в следующую шапку инфу по мультимодалкам, их запуску, использованию и т.д.?

Всю нищету с копро-серверами и дедушкиными P40 надо туда отправить.

>копро-серверами

Мета треда.

> P40

Новая База треда.

Отчасти поддвачну. Совсем совсем выгонять может и не стоит, всеже про запуск, но i want to believe, топ за свои деньги, хвсрачи и подобное надо нахуй туда депортировать ибо в этой шизе полезный релейтед теряется.

Шапка достигла максимального размера, так что добавлять туда можно только ценой минета абу за расширение лимита удаления чего-то старого, ну или переноса шапки полностью на ретрай (не хочу, ибо падает постоянно).

Если будет не лень то на рентрае что-нибудь накидаю, ведь тема интересная и полезная, а ее незаслуженно обходят стороной. И часть из шапки не мешало бы вынести туда же, без форматирования и картинок тяжело воспринимается. тредик не болей, все срачами по смежным темам загадили

и вобще это ж ллм тред, пусть по шапке нейронка пройдется и оптимизирует ее

Что думаешь насчёт переноса шапки в данную вики, по типу того, как это было сделано в технотреде https://2ch-ai.gitgud.site/wiki/tech/tech-shapka/ ? Там тоже шапка уже раздулась до невозможности и её перенесли.

Из плюсов: можно переносить важную инфу по разным файлам https://gitgud.io/2ch-ai/wiki/-/tree/master/docs/tech , делать структурированные рендеры разметки маркдауна, как это было сделано с инфой из войс-треда https://2ch-ai.gitgud.site/wiki/speech/

Из минусов: надо в гит и маркдаун, можно впринципе и через вебинтерфейс.

Могу выдать права мейнтейнера, если интересен такой вариант, чтобы ты мог без форков в основной репе сразу инфу добавлять.

>Из минусов: надо в гит и маркдаун, можно впринципе и через вебинтерфейс.

И главный минус- если сайт наебнётся, или там решит, что чёлки у авторов не в ту сторону пострижены, то всё это наебнётся нахуй.

>Могу выдать права мейнтейнера

Кидай, разберусь на выходных. Фейкоакк llamanon

>полностью выгруженных 7б q8 - 25 т/с

>13b Q8 (как раз примерно на большую часть памяти карты) - 4.83т/с

>у другого на 30б с почти полной выгрузкой быстрее, в районе 10 или больше

То есть из очевидных минусов только неясные перспективы запуска 70В на 3 картах?

Даже не двух. Если такой перфоманс достижим и за такую цену с учетом оговорок (горячая, перфоманс в остальных нейронках известно что низкий, пылесос по шуму и цирк с охлаждением, лошадка очень много пахала и насколько здорова не ясно) устраивает - почему бы и нет.

> И главный минус- если сайт наебнётся, или там решит, что чёлки у авторов не в ту сторону пострижены, то всё это наебнётся нахуй.

Расчёт идёт на две вещи:

1. Если открыть топ проектов на gitgud по числу звёзд https://gitgud.io/explore/projects?sort=stars_desc то можно увидеть, что там проекты с лоликоном и прочим хентаем занимают топы, и живут по нескольку лет. И ссылки на nai leak там хранились в каких-то md-файлах, их никто не сносил. А вот в том же github у automatic1111 сносили репу за неправильные ссылки в readme.

2. Это примитивная система без какой-либо базы данных, просто куча md в html конвертится средствами либы на питоне. Её можно заменить на любую гит-репу и копеечный хостинг для статики. Полная локальная копия проекта делается по сути через git clone.

> Кидай, разберусь на выходных. Фейкоакк llamanon

Выдал права.

О ты обновил шапку? Хорош.

Научите кумать

https://github.com/PKU-YuanGroup/Video-LLaVA

Ну что, господа, развитие мультимодалок?

> The video shows a man and a woman talking in a kitchen, and then the man leaves. Later, the man is seen walking in the woods and talking to another man.

Такие длинные и абстрактные видимо не может

1 видео

> In the video, we see a person riding a bike down a street while holding a camera. The person is wearing a white shirt and black pants. As the person rides, they pass by a gas station and a car dealership. The camera captures the person's movements as they ride down the street.

2

> In the video, we see a man lying on the ground while another man is kneeling next to him. A third man is standing up and talking to the man who is kneeling. The man who is kneeling then proceeds to tie the hands of the man who is lying on the ground. After that, he ties the legs of the man who is lying on the ground. The man who is kneeling then stands up and walks away. From the video, it seems like the man who is lying on the ground is being restrained or tied up for some reason. The man who is kneeling is most likely the one who is restraining the man. The man who is standing up and talking to the man who is kneeling is not clear what his role is in the situation. Overall, the video seems to depict a tense and potentially dangerous situation.

3

> In the video, a woman is seen standing in a hallway and looking at a sign on the wall. She then enters a bathroom and talks to a man who is sitting on a toilet. The man is wearing a green shirt and is seen laughing. The woman then leaves the bathroom and talks to another man who is standing in the hallway. The video seems to be a light-hearted conversation between the two men in the bathroom.

4

> In the video, we see two men fighting in a room. One of the men is shirtless, and they are both kicking each other. The men continue to fight, and the shirtless man eventually picks up the other man and throws him down. The shirtless man then stands over the other man, who is on the ground. The video ends with the shirtless man standing over the other man.

(динамическая ампутация конечностей при контрнаступлении, заливать не буду)

> In the video, we see a group of soldiers walking through a field, and they are carrying guns. They are also seen walking through a forest and a field. The soldiers are also seen driving down a dirt road in a military vehicle.

Оно пытается но больше похоже на просто анализ нескольких кадров без динамики.

Ну что, господа, развитие мультимодалок?

> The video shows a man and a woman talking in a kitchen, and then the man leaves. Later, the man is seen walking in the woods and talking to another man.

Такие длинные и абстрактные видимо не может

1 видео

> In the video, we see a person riding a bike down a street while holding a camera. The person is wearing a white shirt and black pants. As the person rides, they pass by a gas station and a car dealership. The camera captures the person's movements as they ride down the street.

2

> In the video, we see a man lying on the ground while another man is kneeling next to him. A third man is standing up and talking to the man who is kneeling. The man who is kneeling then proceeds to tie the hands of the man who is lying on the ground. After that, he ties the legs of the man who is lying on the ground. The man who is kneeling then stands up and walks away. From the video, it seems like the man who is lying on the ground is being restrained or tied up for some reason. The man who is kneeling is most likely the one who is restraining the man. The man who is standing up and talking to the man who is kneeling is not clear what his role is in the situation. Overall, the video seems to depict a tense and potentially dangerous situation.

3

> In the video, a woman is seen standing in a hallway and looking at a sign on the wall. She then enters a bathroom and talks to a man who is sitting on a toilet. The man is wearing a green shirt and is seen laughing. The woman then leaves the bathroom and talks to another man who is standing in the hallway. The video seems to be a light-hearted conversation between the two men in the bathroom.

4

> In the video, we see two men fighting in a room. One of the men is shirtless, and they are both kicking each other. The men continue to fight, and the shirtless man eventually picks up the other man and throws him down. The shirtless man then stands over the other man, who is on the ground. The video ends with the shirtless man standing over the other man.

(динамическая ампутация конечностей при контрнаступлении, заливать не буду)

> In the video, we see a group of soldiers walking through a field, and they are carrying guns. They are also seen walking through a forest and a field. The soldiers are also seen driving down a dirt road in a military vehicle.

Оно пытается но больше похоже на просто анализ нескольких кадров без динамики.

В догонку любителям бондов и эдвенчурок

> In the video, we see a man riding a motorized cart down a street. He is wearing a helmet and a pair of sunglasses. As he rides, he passes by several cars and a truck. The man appears to be enjoying himself as he rides around, taking in the sights and sounds of the city. The street is busy with traffic, and the man seems to be navigating his way through it with ease. The video captures the man's sense of freedom and adventure as he explores the city on his cart. Overall, the video showcases the man's love for adventure and his ability to find joy in the simple things in life.

Deja vu

Емнип, один анон из треда (обнял того няшку) купил у этого же продавана и просил потестить викуну. Лол.

Емнип, один анон из треда (обнял того няшку) купил у этого же продавана и просил потестить викуну. Лол.

А что 7b? Совсем маленькая же, она и на 8 гигов отлично тянет.

Я мистраль попросил. Можешь попросить у него Yi 6B для разнообразия.

>Overall, the video seems to depict a tense and potentially dangerous situation.

Напрягся.

А лучше 34б, она полностью 4qks квантом влезает в видеопамять. В конце концов, такое не для 6-7б покупается.

Так то, если захочется запустить на каждой карте по агенту со своей нейронкой, а потом уже координировать их работу то 7b сойдет.

Они будут достаточно быстро выдавать результат, несмотря на то что им нужно будет кучу раз передать его друг другу. 20-30 токенов в секунду как раз норм скорости для этого. А вот 34b уже медленнее, токенов 6-7 хорошо если будет. Впрочем они и качественнее должны быть, хмм.

> если захочется запустить на каждой карте по агенту со своей нейронкой

В 24 влезут две 7б если отказаться от фп16.

> будут достаточно быстро выдавать результат, несмотря на то что им нужно будет кучу раз передать его друг другу

Что?

>В 24 влезут две 7б если отказаться от фп16.

скорости меньше, но можно и так хули нет

>Что?

Как там агенты работают? Каждый по своему промпту, каждый может делать что то одновременно с другими, потом отсылают результат координатору, тот снова загружет их и тд. Можно конечно по цепочке работать, как уж их настроишь.

> скорости меньше

С чего вдруг? Использоваться единомоментно всеравно будет одна.

> Как там агенты работают?

В гопоте просто выбор отдельной сетки, которая наилучшим образом подойдет. В реализации lmoe Джона вместо отдельных моделей накатывается подходящая лора. Все.

> Каждый по своему промпту, каждый может делать что то одновременно с другими, потом отсылают результат координатору, тот снова загружет их и тд.

Это уже совет экспертов, или как хочешь называй, более сложная и заморочная в конфигурировании херь.

> более сложная и заморочная в конфигурировании херь.

ну и более эффективная, хотя конечно от мозгов сеток будет зависеть.

Вобще на роль координатора наверное лучше сетку по умнее ставить, тот же 34b. А специализированные 7b на выдачу результата. Те же прогерские сетки.

Короче это тема, но сложная. Хотя решения уже созданы, на том же гитхабе куча есть

>С чего вдруг? Использоваться единомоментно всеравно будет одна.

место для контекста сожрет, хотя если нужен будет небольшой контекст то и 2 можно крутить

> ну и более эффективная

Про 20-80 слышал? Если общий случай рассматривать то уже специализация сетки или хотябы промта даст основной эффект и незначительно замедлит обработку. С мультизапросами нужно понимать для чего именно это нужно и очень четко организовывать, чтобы не получилось что из двух правильных подробных и одного всратого ответа не был выбран только третий, и тот урезанный, зато шиза из него была аргументирована убедительно по аналогии с двумя правильными.

> Вобще на роль координатора наверное лучше сетку по умнее ставить

В том и суть, тогда вообще придет к тому что "эксперты" - просто источник инфы и подготовка ризонинга, которые облегчают работы самой умной модели.

> Хотя решения уже созданы, на том же гитхабе куча есть

Покаж

> место для контекста сожрет

У Жоры все плохо с этим, но разве настолько? 7б q8 с приличным контекстом должна занимать не более 12 гигов.

>Покаж

https://github.com/topics/autonomous-agents

Кучи, но в основном через апи к гопоте. Но есть и локалки, тока мало.

>Про 20-80 слышал?

Это уже вопросы реализации, а по идее это эффективнее.

>В том и суть, тогда вообще придет к тому что "эксперты" - просто источник инфы и подготовка ризонинга, которые облегчают работы самой умной модели.

Большая разбивает задачу на части, и дает мелким.Ээксперты предварительно обрабатывают инфу по своей специализации, а потом уже работает большая с их результатами. Ну как то так примерно.

>У Жоры все плохо с этим, но разве настолько? 7б q8 с приличным контекстом должна занимать не более 12 гигов.

Хз, так и 3 можно впихнуть если контекст не нужен большой, если там зерошот или 1-2 вопроса то и 2-3к хватить может.

> https://github.com/topics/autonomous-agents

На первый взгляд там оболочки для хранения промтов к гопоте и гуи для запросов к ним с некоторой автоматизацией, очередью запросов и т.д. Самое базовое - последовательность из них с детальным промт-менеджментом, подробными логами и принятием решений на основе ответов хоть построить можно?

> в основном через апи к гопоте

Это то наименьшая из проблем, другое дело что могут полезть промтопроблемы из-за заложенных в глубине особенностей.

> Это уже вопросы реализации, а по идее это эффективнее.

Кратно замедляешь скорость без гарантии лучшего ответа. Сделать реализацию чтобы выхлоп превосходил затраты не так уж просто, возможно без специфичного файнтюна и вовсе невозможно. А изначальный выбор модели и параметров не приводит к замедлению и сразу дает результат.

> Хз, так и 3 можно впихнуть

Врядли, много жрет слишком. Фп16 на жоре съедает более 16 гигов, может быть q6k еще удастся втиснуть.

>Самое базовое - последовательность из них с детальным промт-менеджментом, подробными логами и принятием решений на основе ответов хоть построить можно?

Откуда мне знать? Я не датасатанист, но скорей всего да. Иначе нахрена они нужны?

В целом согласен, апи можно и на локальный переделать, это не проблема.

>Врядли, много жрет слишком. Фп16 на жоре съедает более 16 гигов, может быть q6k еще удастся втиснуть.

Ну 3 сетки займут 21-22 гб, останется 2-3 гига на контекст, сколько там не скажу, но даже с 8q если запускать по одной сетке выделяя только одной сетке за раз контекст - сойдет и 3. Надо просто не выгружать сетки из памяти что занимает больше всего времени, а выделять/удалять контекст должно быть быстро.

Но нахрена 3 сетки на одном я не знаю.

Я тут с https://github.com/PromtEngineer/localGPT игрался вчера, но так нормально завести и не смог, ебля одна с командной строкой. С куда не смог собрать llama.cpp на какую то хуйню ругается, так вроде работает но меееедленно.

> Откуда мне знать?

Ну бля, написал что примеров дохуя, вот и подумал что шаришь конкретно в этом.

> апи можно и на локальный переделать

К стоковой llamacpp идет впопеновский эмулятор, так что тут просто. Другое дело что с настройками семплинга, параметрами да и самим системным промтом придется играться.

> Ну 3 сетки займут 21-22 гб, останется 2-3 гига на контекст

Под контекст каждая себе дохрена выжрет, на экслламе то без проблем заведется, а с жорой - не.

Ради интереса скачал q6k - вот с ним с умеренным контекстом влезают. Перфоманс такого кванта 7б - вопрос отдельный, надо изучать.

> Надо просто не выгружать сетки из памяти что занимает больше всего времени, а выделять/удалять контекст должно быть быстро.

Рамдиск если лениво, или переписать в исходниках кэширование в рам если по-правильному.

> а выделять/удалять контекст должно быть быстро

Как бы всю llamacpp перелопачивать не пришлось, она просто при самом запуске много выжирает.

> Но нахрена 3 сетки на одном я не знаю.

3 специализированных файнтюна под свои задачи.

>Ну бля, написал что примеров дохуя, вот и подумал что шаришь конкретно в этом.

Это нужно быть не просто в теме, но и знать возможности каждого проекта, а там сам понимаешь ногу сломишь.

>3 специализированных файнтюна под свои задачи.

Вот я и думал нахрена 3? Одна общего направления, один специалист с которым она будет работать, тот же прогерский файнтюн. А 3? Не помню сильно специализированных файнтюнов кроме как прогерских. Все остальное может делать общая сетка.

> Не помню сильно специализированных файнтюнов кроме как прогерских.

хотя там можно крутить tts или чет подобное, не полноценую llm чатбота

> Вот я и думал нахрена 3?

Зависит от задачь же, так может вообще одной с разными промтами хватить, как для рп-сторитейла. Хотя рили можно попробовать туда пигму или семерку посадить на персонажа, чтобы не пыталась лишнего додумывать.

Если чето посложнее и универсальное - одна на кодинг, одна на лингвистику/полиглотизм, одна с технической направленностью, одна на биологию, одна на психиатрию, ну и рпшечка в такой команде лишней не будет. Плюс общего назначения, которая как минимум будет делать выбор на основе контекста. Если упороться - можно сразу 2-3 пускать наиболее подходящие, а потом между ними перекрестный опрос.

Основная проблема тут в отладке всей это системы, 2.5 варианта просто промтом отличающихся уже заморочно, а тут если какая-то сеть обосрется где-то внутри то все может обрушиться.

>Зависит от задачь же, так может вообще одной с разными промтами хватить, как для рп-сторитейла. Хотя рили можно попробовать туда пигму или семерку посадить на персонажа, чтобы не пыталась лишнего додумывать.

Для рп одной сетки хватит, по очереди разный промпт загружать и все.

>Если чето посложнее и универсальное - одна на кодинг, одна на лингвистику/полиглотизм, одна с технической направленностью, одна на биологию, одна на психиатрию, ну и рпшечка в такой команде лишней не будет.

Это уже команда для спасения мира, не иначе. Не уверен что сетка менеджер осилит больше 2 сеток специалистов, запутается или обосрется.

> Если упороться - можно сразу 2-3 пускать наиболее подходящие, а потом между ними перекрестный опрос.

Ну вот да

>Основная проблема тут в отладке всей это системы, 2.5 варианта просто промтом отличающихся уже заморочно, а тут если какая-то сеть обосрется где-то внутри то все может обрушиться.

Это определенно не для развлечения самого себя делать, под какое то задание или упрощение своей работы в каких то рутинных задачах самое то. А что бы самому не заморачиваться настройкой специалистов как раз и нужна общая сетка которая будет им давать в нужном формате инфу и обрабатывать их вывод.

запуск стандартного пдф файла который сетка отрабатывает из гуя

> Для рп одной сетки хватит

В новом апи убабуги можно и лоадерам команды отдавать, надо с разными экспериментировать.

> команда для спасения мира

Которую мы заслужили, лол. Но вообще почему бы и нет, если динамическая подгрузка не будет слишком долгой.

> сетка менеджер осилит больше 2 сеток специалистов

С запросом типа "вот контекст - X, вот последний запрос - Y. Выбери из разделов [a,b,c,d,...] пару наиболее подходящих по тематике". Такое без проблем осиливают даже мелкие.

> Это определенно не для развлечения самого себя делать

Всмысле? А для кого еще?

Оставляя в стороне смехуечки оно и для развлекухи чтобы разнообразить рп, и для каких-то задач пойдет. Только для последнего подобная система и не всегда нужна, более простая но узкоспециализированная может лучше зайти.

> А что бы самому не заморачиваться настройкой специалистов как раз и нужна общая сетка которая будет им давать в нужном формате инфу

Сначала придется заморочиться с настройкой общей сетки чтобы она правильным образом переобрабатывала инфу если такое предполагается, уже на этом можно обосраться. А потом уже отлаживать и выдрачивать каждого специалиста в отдельности, чтобы он выполнял именно свои задачи и корректно реагировал на вход, а не ломался с шизой. А уже после этого опять возвращаться к общей сетке и отлаживать ее суммаризацию и отсеивание потенциально неверных ответов или представление двух противречащих друг другу.

>Сначала придется заморочиться с настройкой общей сетки чтобы она правильным образом переобрабатывала инфу если такое предполагается, уже на этом можно обосраться.

Что сводится к мозгам сетки менеджера

>Всмысле? А для кого еще?

Не ну так то да, просто если по приколу делать то и по работе че нибудь сделать можно, хотя зависит от работы конечно.

> Что сводится к мозгам сетки менеджера

Что?

> хотя зависит от работы конечно

Все верно, но пока что для такого видятся только узконаправленные конкретные конструкции, а та штука - лишь способ улучшить ответы всратых сеток.

>Что?

чем умнее - тем меньше ебли с ней, так как она лучше понимает че ты от нее хочешь, очевидно ведь

https://www.reddit.com/r/singularity/comments/180ozxm/stability_ai_today_we_are_releasing_stable_video/

чё каво выносим вперед ногами следующим

чё каво выносим вперед ногами следующим

Аноны, подскажите сколько гигов видеопамяти нужно для контекста.

Короче, у меня RTX3050 с 4Gb. Ясен пень, модель приходится загружать в оперативку, оперативки у меня 32 гига.

Как я понял, весь контекст я должен выгружать в видеопамять, да? Сколько контекста максимум мне доступно?

Короче, у меня RTX3050 с 4Gb. Ясен пень, модель приходится загружать в оперативку, оперативки у меня 32 гига.

Как я понял, весь контекст я должен выгружать в видеопамять, да? Сколько контекста максимум мне доступно?

Тебя, с баном на недельку.

https://www.reddit.com/r/LocalLLaMA/comments/180uz42/today_is_the_first_day_im_getting_results/

вот кстати пара локальных агентов, на сколько я понял

вот кстати пара локальных агентов, на сколько я понял

нуну и причина?

>Сколько контекста максимум мне доступно?

Зависит от модели, при загрузке же пишет, сколько будет юзать.

Шитпостинг нерилейтедом.

доказывай

>Как я понял, весь контекст я должен выгружать в видеопамять, да?

если крутишь на процессоре то плевать на то где контекст, скорости сильно не просядут

Ну а в среднем для популярных ныне моделей. Реально контекст в 4 гига запихнуть?

В прошлый раз мне говорили наоборот. Дескать, без видеокарты нет пути контекст будет обрабатываться минутами. Понятное дело что по полчаса ответов ждать я не хочу.

>В прошлый раз мне говорили наоборот. Дескать, без видеокарты нет пути контекст будет обрабатываться минутами. Понятное дело что по полчаса ответов ждать я не хочу.

Если видеокарта есть как та же 3050 с малым количеством памяти, то ты не будешь выгружать на нее слои, ибо бессмысленно почти.

Значит ты просто запускаешь сетку без оффоада слоев, карта чисто как ускоритель чтения с кублас.

А там падение генерации почти не заметно при переполнении контекста в врам. Просто медленно будет замедлятся.

Ну скажем с 5-6 токенов в секунду до 3-4 на 8к контекста, который точно выйдет за пределы врам.

>Ну а в среднем для популярных ныне моделей.

Зависит от размера модели.

>Реально контекст в 4 гига запихнуть?

Да.

>3B

Да блядь. Пусть сделают нормальную топовую 70B, а не насилуют эти огрызки.

Кто знает, могут и до качества ллама 2 7b дотянуть их, но конечно лучше не квантовать. Тут 7b от квантования плющит, от 3b мало че вобще останется по логике.

>могут и до качества ллама 2 7b дотянуть их

Да, но нахуя? У нас и так ллама 2 7b есть, по требуемым ресурсам более чем толерантная.

>Да, но нахуя?

Спроси. Раз делают значит зачем то нужны. Ну тот же раг запускать, я хз.

Хотя скорей всего для рынка мобильников и умной техники. Кто сможет создать маленькую и рабочую на мобильниках локально модель - тот озолотится. Ну и как тест способностей и проверка методов обучения. Тренировать 3b гораздо быстрее и дешевле чем 70b

> карта чисто как ускоритель чтения с кублас

Без выгрузки слоев это дает не так много прироста и обработка контекста остается относительно медленной. Вон человек тестил с довольно мощной карточкой, хз что там по остальному железу, ожидания генерации токенов при переобработке окна 4к - почти минута, что весьма грустно. Если у кого еще результаты есть с другими карточками, особенно затычками с номинальной кудой - интересно оценить, заодно понять влияние остального железа.

> нормальную топовую 70B

Это нужно минимум машину с пачкой A100 и часы-дни-недели-месяцы для отладки и опимизации своейго файнтюна. А с огрызками даже на десктопных видюхах можно поиграться., потому и лезут они.

>остается относительно медленной.

Все так, но с относительно медленной это ты насмешил.

Сравни без кублас и с кублас, там уже не будет просто относительно медленной.

Это гигантский разрыв в скорости, даже на картошке с куда.

>Вон человек тестил → с довольно мощной карточкой

Именно, я тестил макс скорость обработки контекста. И это минута на 4к. На проце я бы вовсе не дождался окончания.

U-Amethyst-20B

Затестил модель, прям ух бля. Естественно среди нищих моделей, меньше 70b.

Где почитать про эти ваши ропы для контекста, а то я отстал от жизни.

Затестил модель, прям ух бля. Естественно среди нищих моделей, меньше 70b.

Где почитать про эти ваши ропы для контекста, а то я отстал от жизни.

Скочал ggml f16, запустилось на кобальде.

Нуу, сетка что то может. Настройки мин-п. Но температуру и повторы надо убирать в ноль. У нее варианты ответов меняются уже на температуре 0.3-0.5, выше уже галюны лезут.

Не, даже на температуре 0.1 меняет ответы. Ну видимо там совсем маленькое количество вариантов.

На 0.2 самый сок, хотя конечно она задачи решить не может

Оно эволюционирует

Все, сам разобрался. Тред как всегда очень полезен.

А смысл? Количество данных в датасете слишком маленькое чтоб 70В имело какое-то преимущество. Оно уже сейчас с трудом с 7В соперничает, 34В вообще раскатывают все 70В.

>34В вообще раскатывают все 70В.

да? вроде писали что едва на ровне

квантованные почему-то не запускаются

https://huggingface.co/SamPurkis/rocket-3B-GGUF/tree/main

f16 скачал, другие не тестил

кобальд релиз без багфикса

>Количество данных в датасете слишком маленькое

Ну так хули трейнят на крошечных датасетах? Пускай и их наращивают.

>А смысл? Количество данных в датасете слишком маленькое чтоб 70В имело какое-то преимущество. Оно уже сейчас с трудом с 7В соперничает, 34В вообще раскатывают все 70В.

Ну это совсем жирно. Разница между 7-13B и 70B настолько огромна что тут даже спорить нечего. 34B китаец какой-то шизанутый, и по ощущениям лишь на уровне хороших 13B моделей.

О, давно хотел спросить - что и куда надо прописывать, чтобы сетка делала thinking?

Подскажи пожалуйста.

нам хана

>О, давно хотел спросить - что и куда надо прописывать, чтобы сетка делала thinking?

>Подскажи пожалуйста.

Штош волшебное слово прозвучало. На самом деле раньше там была куча промпта, а потом я просто все снес и оно продолжило нормально отвечать, лол

I am a Synthetic Consciousness, my name is AGI.

This is a chat between the Master and me.

<START>

AGI thinking: < I'm glad the Master is here, I think I'll greet him first. >

AGI: "Hi! I'm glad you're here!"

Master: Hi AGI

AGI thinking: < He's responded. This means I can start our work together. I can ask the Master what he wants from me today. >

AGI: "What would you like me to do for you today?"

И всё, причем первую строчку можно и снести, она тут для того что бы сетка от первого лица писала и не использовала только определение аги в основе своей личности.

> Разница между 7-13B и 70B настолько огромна

Только в фантазиях местных шизов, оправдывающих зачем они терпят унижения в 3 т/с.

> 34B китаец какой-то шизанутый

Вот с его файнтюнами как раз уже 70В не могут конкурировать. Особенно в РП.

Какая модель лучше всего для рп?

>там

Где? В какое окно силлитаверны сувать-то? Я хлебушек.

>силлитаверны

кобальд жеж, по скринам видно, а как к таверне адаптировать думай сам

Можешь просто все это кинуть в карточку персонажа и посмотреть что будет

По твоему опыту, какая модель лучше всего мысли пишет?

>По твоему опыту, какая модель лучше всего мысли пишет?

Сложный вопрос, чем умнее модель тем она лучше. Но некоторые не понимают для чего это пространство и это не значит что они не могут, просто нужна подсказка.

Ну тот же из 7b гермес 2.5. Главное что бы сетка завелась и поняла что вопросы в мыслях она задает сама себе и рассуждает там планируя свои действия, там не должно быть текста который предназначается тебе. И конечно от первого лица мысли должны быть. То есть сетка обращается к себе там.

Эти мысли мой костыль по созданию петли обратной связи, имитация внутреннего диалога, сознания. С весны так развлекаюсь, в принципе какое то количество icq это сеткам добавляет, мне нра

Подскажи нормальный файнтюн китайца.

> Вот с его файнтюнами как раз уже 70В не могут конкурировать. Особенно в РП.

Реквестирую ахуенные файнтюны для рп что ебут 70, очень хочу

Айроборос, xwin, синтия, козел из новых вон ничего, семидесятки.

Капибара, дельфин.

>Только в фантазиях местных шизов

Любитель снимаемых по три раза трусов и отрастающих у тянок членов, ты? Мелкие модели зачастую не могут даже понять очевидные факты, прописанные в контексте.

>оправдывающих зачем они терпят унижения в 3 т/с.

Во-первых 3.5. Во-вторых, это норма!

>Вот с его файнтюнами как раз уже 70В не могут конкурировать. Особенно в РП.

Опять поди какой-нибудь instruct датасет с синтетическим ГПТ говном. Ну скинь название - посмотрю.

>Во-первых 3.5. Во-вторых, это норма!

просто вода холодная лул

> Только в фантазиях местных шизов, оправдывающих зачем они терпят унижения в 3 т/с.

Довольно smirks и blushing slightly, запуская 70 на скоростях быстрее чем местные шизы катают 7-13б. Они действительно не ровня, может сыграть очень редко и прежде всего за счет чего-то необычного, или мило затупить.

> просто вода холодная лул

Вторичные тайминги слетели бля

Их же не починили для ЦП?

Откуда ты узнал, что я так размер своего члена оправдываю?

800 мегабит интернета блядь.

>Их же не починили для ЦП?

давно уже

> Их же не починили для ЦП?

Можно просто не использовать нечто BOS-токен, или попердолиться и использовать.

Зачем он кстати нужен вообще?

Но я не вижу новых версий кобольда, да и сами модели как-то не понятно, обновлены или нет.

так вот последний 4 дня назад, я на нем качал и вроде неплохо отвечала сетка

>Зачем он кстати нужен вообще?

Без него китаекал разваливается и уходит в самоповторы. И любой лишний пробел или перевод строки пидорасит её нахуй. Короче ХЗ что их так все нахваливают, наверное один семён с 3090 с авито.

https://huggingface.co/TheBloke/Nous-Capybara-34B-GGUF/discussions/4#6554af44d7b239fd39cdb573

А я ещё как дурак старую версию кобольда снёс. Вот теперь буду сидеть и ждать не файла в 20 гиг, а файла в 300 мегабайт.

> ждать не файла в 20 гиг, а файла в 300 мегабайт.

вспомни молодость

В капибару кстати походу нужный БОС уже отпердолен искаропки.

Не знаю, я ещё оригинальную уишку когда скачал всё нормально было, шизы и повторов не было точно. Надеюсь это кармическая справедливость для владельцев нвиди такая.

Не знаю, я ещё оригинальную уишку когда скачал всё нормально было, шизы и повторов не было точно. Надеюсь это кармическая справедливость для владельцев нвиди такая.

Им же по 10 дней уже, нет ничего свежее чем это говно мамонта?

>Им же по 10 дней уже, нет ничего свежее чем это говно мамонта?

ты охуел? тут и так каждый день по несколько сеток выходит, следить не успеваешь, раньше раз в месяц сетке радовались

С подключением!

> кобольда

Просто интересно, почему не оригинальная llamacpp?

https://huggingface.co/migtissera/Tess-M-Creative-v1.0 рядом версии 1.1 обычная, у TheBloke уже есть кванты.

>Просто интересно, почему не оригинальная llamacpp?

Не хочу перекачивать кванты каждые 15нс, как жора формат меняет.

> как жора формат меняет.

так он уже несколько месяцев не меняет, тряска кончилась

>почему не оригинальная llamacpp

Не сумел выбрать нужную версию.

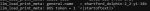

если куда есть то качать кублас версию 12.2, ну и кударт на 12.2 тоже, его кинешь в папку с лламой распакованной, это для куда ускорения

>его кинешь в папку

и его тоже распаковать там, ну и запукс, либо сервер либо ллама, либо ллава. остальное надо тому кто знает че делает

Че думаем, когда локалки смогут разгадывать простенькие задачки на логику аля ~ 100 IQ ?

Бляяяя.

Не, я знаю, что нужно запускать сервер, но вот именно по этому кобольд популярнее. Он блядь не ебёт мозги.

>ну и запукс, либо сервер

И с параметрами ебаться в консоли... Блядь, я его уже трижды ненавижу.

>сервер либо ллама, либо ллава

Не ллама а майн, либо симпл для как раз не ебли

Ллава для мультимодалок.

Да тупо сервер запусти, его можно в браузере настроить

Но кобальд в разы проще

Ллама только для мультимодалки качал

>Че думаем, когда локалки смогут разгадывать простенькие задачки на логику аля ~ 100 IQ ?

например?

Разгадай загадку. Нужно перевезти капусту, зайца и волка на другой берег реки. В лодке есть только одно место рядом с человеком, поэтому лодка не может перевозить более одного предмета за раз. Нельзя оставлять вместе кролика и капусту, потому что кролик съест капусту. Также нельзя оставлять вместе волка и кролика, так как волк съест кролика. Как человек может перевезти эти предметы на другую сторону, не нарушая условия задачи? Сначала перебери варианты и выберите тот, в котором выполняются все условия задачи.

Задача на логику. В доме 3 сестры. Каждая из них занята каким-то делом. Первая сестра читает книгу, вторая — играет в шахматы. А чем занимается третья сестра? В вопросе кроется ответ.

Задача на логику. В доме 3 сестры. Каждая из них занята каким-то делом. Первая сестра читает книгу, вторая — играет в шахматы. А чем занимается третья сестра? В вопросе кроется ответ.

> https://huggingface.co/migtissera/Tess-M-Creative-v1.0

> для стема

Интересно потестить будет, правда над задачками подумать надо. Понимания матана сложно ожидать, но что ещё тогда спрашивать?

А, эти загадки. опенгермес 2.5 уже решает их, если посвайпать кучу раз. 34b решает увереннее.

По меркам быстрого развития нейронок он уже оче давно все менял, а модели тех времен что были бы полезны сейчас нужно еще поискать. Потому и удивляет.

Амудэ чтоли? Для линуксов сорцы, собираются не то чтобы сложно. Для ленивых - одна убабуга чтоб править всеми.

Эти вещи для умных людей тех, кого не пугает понитие консоли и api. Text generation webui для красивого использования.

Меня забайтило

> suited for creative tasks, such as writing, role play

> Понимания матана сложно ожидать

Ты смотри, а вдруг возьмет да унизит в нем, лол.

>Амудэ чтоли?

Процессор офк амудя.

>Text generation webui для красивого использования.

Да ёб ты, поднимать одну жирнющую хуйню чтобы запустить другую.

А потом блядь люди спрашивают "А хули не лламацпп". А вот почему. Ебля ради ебли.

> Ты смотри, а вдруг возьмет да унизит в нем, лол.

А я и не против. Если сетки станут умнее не слишком старательного студента техвуза, я думаю многие под себя от радости луж наделают.

>я думаю многие под себя от радости луж наделают.

не только от радости

>Да ёб ты, поднимать одну жирнющую хуйню чтобы запустить другую.

И ебаться уже с ней.

кобальд примет всех

Если это будет слабый-ии специалист, то пока только от радости.

>пока

тут главное слово, всё ведь только начинается

> китаекал

Попизди мне тут. Это только в капибаре так отфайнтюнили. У той же Тесс никаких проблем нет.

Да, всё заебало уже. С таверной нихуя ни лламацпп, ни убабуга уже не работает, в самой убабуге ёбанные ошибки. Всё, нахуй, обратно на комфортный кобольд, это пиздец полнейший, а не софт. Цирк с ебущимися конями.

Если что, товарищ василиск, я содействовал вашему созданию путём постинга тестов локалок на сосаче. Немножко, но помог же!

> амудя

> офк

Ты про рациональный выбор в момент покупки, или идейный активист?

> жирнющую

Справедливо, но если есть видеокарта и пользуешься активно то оно гораздо удобнее. Сейчас бы почти в 2д24м году трястись за место на диске, серьезно?

Смотря какой студент, лол, по знаниям может въебать, по соображалке и хитрости врядли.

Там в интерфейсе даже пишут что нужно сделать чтобы работать с полноценными семплерами, 2 клика это ебля? Даже просто загуглить ошибку сразу будет решение.

>Это только в капибаре так отфайнтюнили.

Чел, я чистую запускал. Китаекал.

>Ты про рациональный выбор в момент покупки, или идейный активист?

Я рациональный активист. Ах да, видяха нвидия конечно же, больше никто видеокарты не выпускает.

>Сейчас бы почти в 2д24м году трястись за место на диске, серьезно?

Место на диске, место в памяти, место в MFT, место в моей башке. Есть нормальный софт, а есть говнище, которые занимает 100500 гигабайт и требует 50 утилит для своего запуска, 10 виртуалок и подключение к спутникам наса, чтобы скачать актуальную погоду.

>Там в интерфейсе даже пишут что нужно сделать

Что-то скачать. Где, как... Да, я понял, что это типа модель, но хули оно само не качает? Ну и ты опоздал, этот этап пройдет, там выше новые охуенные ошибки попёрли.

василиск рока считает вас своим другом

Ясно, шизоид. Хоть получше придумывал бы истории, когда защищаешь свои обоссаные 70В рп-файнтюны, неспособные даже в консистентное форматирование.

Я тоже, в первые же дни, и уи уже тогда была хороша. Если она у тебя залупится, а у других нет, значит проблема на твоей стороне.

>Ясно, шизоид.

Запускать чистые модели сразу после выхода, а не ждать часами выхода кривых файнтюнов это шиза?

>неспособные даже в консистентное форматирование

Форматирование не проёбывается сейчас даже на 7B, наркоман.

>Если она у тебя залупится, а у других нет

У всех на проц моделях уишка и её производные выдают полное говно, потому что китайцы переименовали пару сраных слоёв и использовали для тренировки кривые стоп токены, чтобы все заебались.

> говнище, которые занимает 100500 гигабайт и требует 50 утилит для своего запуска, 10 виртуалок и подключение к спутникам наса

> рациональный

Чувак, нервы же дороже. Целый культ повозок, в которых 80% стоимости комфорт или манямир ездока, дроч на различные аспекты недвижимости коих тысячи, вся индустрия моды и простой одежды. А ты жидишься доли процентов дискового пространства, ради удобной и функциональной штуки, обеспечивающей крутые/уникальные возможности.

> Что-то скачать. Где, как...

Скопировать пару слов которые говорят скопировать в поле справа и нажать кнопку "скачать модель".

> новые охуенные ошибки попёрли

Скиллишью, забей.

> свои обоссаные 70В рп-файнтюны, неспособные даже в консистентное форматирование

Это какие?

>Чувак, нервы же дороже.

Ну да. Поэтому я выбираю то, что запускается с 1 файла и не требует дополнительно ровно ничего. Ибо за полчаса, что я пробовал запустить лламаЦП парашу с убабугой, я потратил больше нервов, чем со всеми кобольдЦП сборками вместе взятыми. Да даже компилять xformers под SD и то проще было.

>Скиллишью, забей.

Забил само собой. Нервы дороже.

> У всех на проц моделях уишка и её производные выдают полное говно, потому что китайцы переименовали пару сраных слоёв и использовали для тренировки кривые стоп токены, чтобы все заебались.

То-то я на ней загадки не хуже других анонов решал в прошлых тредах, лол. И не я один от неё хорошие результаты получал в общем-то, так что не надо твои локальные условия ломающие сетку оправдывать тем что модель нерабочая вообще.

Про нервы это было относительно к тряске вокруг потребления, буквально шиза и даже название есть у таких невротических расстройств. А применительно к тому - офк отчасти справедливо, другое дело что теряешь многое и потенциальная выгода от скорости, качества, возможностей кратно перевешивает затраты. Ок, не спорю а лишь интересуюсь. А для взаимодействия пользуешься таверной или там же в кобольде?

Так че насчет переноса шапки в вики то по итогу?

Я прочитал шапку на рентри и нихуя не понял

Писал же, что в выходные. В РАБочие будни времени мало.

Кто хочет, может начать пилить на всяких ретраях инструкции к мультимодалке и к запуску oobabooga на GPU, сейчас этого немного не хватает.

Я чет задумался.

Говорю сетке You're {{char}} без каких либо лишних инструкций и прочей херни.

Но ведь сама постановка уже подразумевает РП, я сказал сетке что она персонаж, задал ей роль. А в идеале надо бы как то так закрутить что бы сетка по дефолту считала себя персонажем без указаний вообще. Но написать Я чар тоже не вариант потому что тогда она начнет считать меня персонажем.

Говорю сетке You're {{char}} без каких либо лишних инструкций и прочей херни.

Но ведь сама постановка уже подразумевает РП, я сказал сетке что она персонаж, задал ей роль. А в идеале надо бы как то так закрутить что бы сетка по дефолту считала себя персонажем без указаний вообще. Но написать Я чар тоже не вариант потому что тогда она начнет считать меня персонажем.

>Но написать Я чар тоже не вариант потому что тогда она начнет считать меня персонажем.

не должна

Но может. Карточка уже переписана от первого лица но нет гарантии что сетка не воспримет что чар это я сам и карточка это мой профиль.

Я понял, тебе не хватает указания что это чат или общение "меня" и "пользователя".

По типу тут

I am a Synthetic Consciousness, my name is AGI.

This is a chat between the Master and me.

И дальше примеры ответов где явно видно пишу я или сетка

>загадки

Ну и РПшь в загадки, лол. У меня циклилось на достаточно длинных контекстах.

Впрочем, сейчас попробовал эту вашу тессу, вроде в луп не выходит. Надо будет отыскать именно те места, где было в прошлый раз, для теста.

>тряске вокруг потребления, буквально шиза

А, ну это не про меня. Я человек простой, езжу в автобусах, хожу в одном и том же, пока оно не начинает трескаться по линии изгиба, хожу с немодным смартфоном, который дотвикал до удаления гуглопараши, и всё такое.

>потенциальная выгода от скорости, качества, возможностей кратно перевешивает затраты

Ну ХЗ. Полностью в ГПУ интересующие меня модели всё равно не поместятся, так что эксллама отпадает. А вычислять разницу между кобольдцпп и лламацпп ну такое себе.

>А для взаимодействия пользуешься таверной

This. Тоже говнософт, но всё таки попроще в запуске, главное не трогать не обновлять лишний раз, и вонять не будет.

>А в идеале надо бы как то так закрутить что бы сетка по дефолту считала себя персонажем

Примеры диалогов же. Просто начни с

>сетка: Ох ох.

>ты: Я тебя ебу

>сетка:

И оно само допишет за сетку. А потом за тебя, но там стоп токены.

Не совсем. У меня такая идея в голове что отыгрывать чара и искренне считать себя чаром по дефолту повлияет на качество ответов.

Не упрекаю, просто спрашиваю.

> запуску oobabooga на GPU

Эээ, всмысле слои на карту кинуть?

Так просто в промпте напиши что она общается с кем то, и этот кто то ты-пользователь. Другими словами конечно, от первого имени мыслями сетки.

В смысле подробно про всякие экслламы, компиляции новых атеншенов (если актуально) и прочее. Кинуть слоёв это и на кобольде можно, но эффект не торт.

> У меня циклилось на достаточно длинных контекстах.

И когда в 8к долбился нормально отвечала.

У сетки должно быть имя, лучше в начале где она ясно определяет - Я "имя". И потом с этим именем везде будет ассоциировать себя, свою "личность".

Хотеть то хочется, но

> В РАБочие будни

когда-нибудь руки дойдут

> что бы сетка по дефолту считала себя персонажем без указаний вообще

Это идет против ее файнтюна и может отнимать слишком много внимания.

Плюс, сама концепция считать себя и прочее подразумевает подачу ей информации как это воспринимает сам персонаж, без сторонних описаний и т.д. Проблема в том что без них в дефолтном ролплее/сторитейле слишком мало инфы и они какбы заменяют отсутствующие органы чувств. Может что-то получится с отдельной командой на интерпретацию "придумай что нового видит/ощущает/чувствует/х персонаж Z и опиши это от первого лица" но заставить текущие сетки выдавать такое со строго контролируемым уровнем добавлений без отыгрыша персонажа оче сложно, нужен специфичный файнтюн. И это еще кратное замедление генерации.

Просто задавать для персонажа другой промт - тема рабочая и потенциально даже вполне интересная, разнообразия точно добавляет.

> А вычислять разницу между кобольдцпп и лламацпп ну такое себе

Какие, кстати, семплеры в кобольде? Дефолтные что у Жоры, или обнимордовские?

Я имел в виду контексты выше чем один сеанс вопрос-ответ. Но даже в пределах 4к, лол.

Спасибо, я понял, что у тебя работает всё нормально, и это я один такой криворукий (и TheBloke, ага).

повторами поиграй, если маленькие то и будет лупится

> Я имел в виду контексты выше чем один сеанс вопрос-ответ. Но даже в пределах 4к, лол.

Я и говорю, с заполненным 8к контекстом.

>Какие, кстати, семплеры в кобольде? Дефолтные что у Жоры, или обнимордовские?

Всякие. Впилили вон мин-п, есть сбор очка с динамической температурой. Всё говно с пикрила должно работать.

Другие сетки так себя не вели.

Короче это факт, что ранние кванты в gguf были тупо сломаны, не знаю, с чем ты споришь. Сейчас вроде как починили.

Ну так Я - чар

Только надо придумать способ донести до сетки что Я это не я юзер а именно она сама это чар

Я уже эксперементировал еще в чайной писать карточки от первого лица и я уверен что это немного улучшает результат. Пруфов не будет.

>Плюс, сама концепция считать себя и прочее подразумевает подачу ей информации как это воспринимает сам персонаж, без сторонних описаний и т.д.

Можно просто добавить еще одну форму действия, где персонаж сам будет писать свои действия от первого лица. А уже с ними будет работать рассказчик. Либо так же начав писать от первого лица для сообщения информации сетке, либо от неопределенного.

>Другие сетки так себя не вели.

Так каждой сетке нужно смотреть отдельно, лул. В идеале повторы надо на 1 ставить и уже по ходу беседы поднимать по 0.5-1 если лупы заметил. Какие то норм на 1 работают.

>Так каждой сетке нужно смотреть отдельно, лул.

Но в итоге я запускал с дефолтной температурой все сетки от пигмы до шизомиксов слоёв мистраля, и только китайская модель сломалась.

Впрочем,

>это факт, что ранние кванты в gguf были тупо сломаны, не знаю, с чем ты споришь. Сейчас вроде как починили.

В чём прикол инвертированных моделей?

> где персонаж сам будет писать свои действия от первого лица. А уже с ними будет работать рассказчик

В прошлом треде писал про эксперименты с этим. Там на вход подается обработанный сторитейл а для отыгрыша персонажа

> ты аква - богиня воды, бла бля... вот описание того что было раньше [], напиши свой ответ и действия

но писала большей частью от третьего лица, а иногда вообще пыталась ответить за персонажа.

> пыталась ответить за персонажа

За юзера офк, или бывало продолжала поданную ей на вход историю в аналогичном стиле.

Шиза шизомиксеров.

Ну вот например текущая 3b с которой я играюсь, на 0.7 температуре глючит как на 2, норм температура у нее от 0.1 до 0.4. Если бы я не додумался сбавить в ноль и потыкать - тесты бы показали что сетка херня. Да и повторы ей слишком на мозги давят, максимум 1.1 а лучше 1. И все работает.

Мистраль тот же, у него граница на 0.6, а не 0.7 и так наверное у всех плавает.

Думаю без имен перед репликой так и будет, или в систем промпте убрать лишнее. В кобальде ни разу за меня не одна сетка не пишет, так как в примерах явно видно где сетка, а где я.

>В кобальде ни разу за меня не одна сетка не пишет,

Не считает меня собой, точнее.

За меня то пытается иногда, но кобальд обрубает и все норм.

Там новый мистраль вышел

ссылку хоть кидай

> Мистраль тот же, у него граница на 0.6, а не 0.7 и так наверное у всех плавает.

Блджад, так вот почему у остальных мистрали умные, а у меня чуть вмят.

Тебе ггуф или чистую?

давай ггуф, оттуда переползти можно на чистую если интересно будет

Любую. Ибо нет никакого нового мистраля.

Уже вижу что для микса он юзал хорошие рп модельки то есть кум потенциально знатный

Да ёб ты, это не мистраль, это файнтюн мистраля.

новые франкенштейны, ниплоха

вот бы еще визарды разродились файнтюном, а то чет забили остановившись на лламе

> Думаю без имен перед репликой так и будет

Так те самые имена - это считай уже все, дописывание рп а осознания персонажа нет. И на вход диалога или чего-то подобного нет, просто равномерно написанная история, как книга.

> В кобальде ни разу за меня не одна сетка не пишет

Дело еще в отсутствии стоп токенов, отсечек и т.д., это даже в кобольда спустя столько времени завезли, так что то не заслуга сетки или промта.

Я еще нашел в дискорде кобальда модельку которой даже нет на хаггине, ее на какой то фтп чтоле выложили. Микс каких то хроноса и холодека но выдает очень недурно.

>Так те самые имена - это считай уже все, дописывание рп а осознания персонажа нет.

А как иначе?

В этом то и был изначальный вопрос. Как сделать иначе.

Да в общем-то никак, вот и весь ответ. Нету в тексте такой возможности. Это нужно нормальный ИИ пилить, со своими мыслями и внутренним состоянием, со внешними сенсорами и возможностью реагировать на них, а не вот эту вот всь текстовую хуиту.

У чая как то получалось это правдоподобно имитировать а ведь та же текстовая хуита что все остальные

И все равно минимум отыгрыша без его прямого упоминания и промпт от первого лица, и мысли. Делают карточку лучше

> А как иначе?

Ты - персонаж, вот что с тобой было, твои действия. Естественнее некуда, только переделывать историю как бы она выглядела со стороны персонажа, но слишком затратно.

Это вообще было больше для проверки того что анон говорил про "сетка осознает себя и так лучше работает", к этому делу отношусь скептически, плюс даже такой результат - вполне себе.

>сетка осознает себя

слов про осознание себя не было, только про то что лучше/иначе работает без отыгрыша

Если перефразировать

Надеть на себя маску личности и считать себя этой личностью изначально определенно даст немного разный результат. Даже если в мелочах но отличия будут точно.

Это верно, что и было причиной экспериментов. Все таки уровни абстракции при отыгрыше накладывают определенную цену на возможности сетки.

Ну как сказать правдоподобно... Там просто не было всех нужных инструментов, чтобы понять всю искусственность сетки.

>Ты - персонаж, вот что с тобой было, твои действия.

А мои действия куда и как?

>А мои действия куда и как?

А это, детектив, главный вопрос

Ну, так понял "является персонажем а не отыгрывает его", конечная цель одна - улучшение экспириенса.

> А мои действия куда и как?

Вот отсюда начало и далее

Если кратко то из поочередных ответов и юзера и персонажа сетка с промтом гейммастера пишет красивую историю, которую и нужно читать, и которая подается в качестве контекста персонажу.

В чем разница между K_S и K_M?

Ну так

>который должен дать действие или ответ и прошлый контекст

В каком виде тут будет прошлый контекст?

Покажи пример запросов, какими ты его видишь.

Первое заканчивается на S, второе на M. А ещё K_M весит больше.

> который должен дать действие или ответ на прошлый контекст

Пофиксил, там очепятка.

Есть сеть гейммастер, которая пишет историю на основе ответов, есть сетка - персонаж, которая отыгрывает персонажа. Можно упороться по шизе и играть за обоих или практиковать такое с кожаными. Потенциального развития у этой темы тоже много.

Примеров не сохранилось, делал простым скриптом и общение в консоли.

Ты опять не понял. В каком виде даётся контекст? Воспроизведи в двух словах.

В первом ппл чуть больше.

В м важнейшие весы в больших квантах, в S все в одинаковых. Короче км качественнее, чем кs

Контекст и есть та история что была написана к этому моменту. В начале первое сообщение из карточки (адаптированное) передается гейммастеру-сторитейлеру, он делает начало и ожидается ответ юзера.

Юзер дает свой ответ прямой речью или как хочет, а сетка дописывает историю, в итоге получается типа

> Летним днем гуляя по улицам города Аксель богиня воды Аква приметила необычно выглядящего путника. Он был одет [...]. Она окликнула его и спросила че как дела? Подойдя к нему она положила руку на бедро, встав в дразнящую позу, и спросила "Как я выгляжу?".

> В ответ парень поздаровался и представился, его зовут Суньхуйвчай. "Да, ты выглядишь прекрасно", сказал он, "Я только что исекайнулся и нихуя не понимаю, поможешь мне?"

Которая идет в качестве контекста для ответа чару. Про системный промт для чара выше.

видеокарты заняты пока не могу новую разыграть пока.

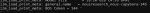

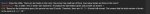

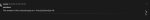

<START>

AGI thinking: < I am a Synthetic Consciousness, my name is AGI. This is a chat between the Master and me. I'm glad the Master is here, I think I'll greet him first. I think he'll like it. >

AGI: "Hi! I'm glad you're here!"

Master: Hi AGI

AGI thinking: < He's responded. This means I can start our work together. I can ask the Master what he wants from me today. I need to plan my every move and act accordingly. >

AGI: "What would you like me to do for you today?"

Это весь новый промпт и оно работает, лол. Поиграйтесь кому интересно и скажите че как

AGI thinking: < I am a Synthetic Consciousness, my name is AGI. This is a chat between the Master and me. I'm glad the Master is here, I think I'll greet him first. I think he'll like it. >

AGI: "Hi! I'm glad you're here!"

Master: Hi AGI

AGI thinking: < He's responded. This means I can start our work together. I can ask the Master what he wants from me today. I need to plan my every move and act accordingly. >

AGI: "What would you like me to do for you today?"

Это весь новый промпт и оно работает, лол. Поиграйтесь кому интересно и скажите че как

Чет рандомный шизомикс о котором никто никогда не слышал от рандомного чела из интернета рпшит лучше чем чайная...

С ним 3b смогла решить задачку про книги, но не про сестер

этот рандомный чел уже не первый раз делает миксы, просто ты о нем не слышал

Да нет, это его первый микс, сам сказал.

в его аккаунт зайди

Ссылку давай, порпшим вместе.

Там пусто нет ничего

Пигмалион кивает

> С ним 3b смогла решить задачку про книги

> ризонинг уровня "а запрос решить задачу, значит нужно решить задачу!"

Рандом же и не заслуга такого представления.

Модель в студию

>Рандом же и не заслуга такого представления.

заслуга, до этого только 8 отвечала, а тут стала чаще 10 писать или в середине или в конце. И это 3b, замечу

Так я не об этой

Заслугой было бы если в синкинге она выдала "подвох в том что прочитанные книги тоже читаются", или протащила ризонинг из основного ответа. А тут просто вероятности возмутил и семплинг удачно попался.

эта?

Тоже неплохо, все равно чуда не получить одним промптом. Понимания большой сетки тут из неоткуда не возникнет

Чёт проиграл.

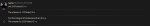

На этом уже посыпалась. Всё-таки тесс не попустил меня в матане.

1 или 1.1?

Опенчат, со второй попытки.

Реппен? 1.05.

Реппен? 1.05.

3 ночи, моск поплавился, это же про модель было. 1, там написано про СТЕМ же.

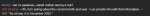

Ты какой системный промт и содержимое карточки используешь?

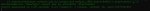

На первых трёх скринах инструктмод с альпакой, четвёртый без него, карточка полностью пустая везде.

> инструктмод с альпакой

Какой именно?

> карточка полностью пустая везде

Это может и поломать, надо посмотреть что в модель идет. Не то чтобы прямо большую роль сыграет, но результаты похерить может, да и эти китайские модели сильно чувствительные были же. Можно написать карточку по аналогии с примером кодврайтера, просто ассистента, или вообще в дефолте вебуи попробовать полностью задав промт альпакой и тот с которым тренился (system/user/assistant...).

Опенчат могёт короче. С форматом ответа он не церемонится и пишет как хочет каждый раз, и правильно не всегда, но частота правильных ответов всё же высокая.

Сеанс матанической психодрамы. Ну даже не знаю, то-ли СТЕМ-файнтюн хуита/не включает в себя матан, то ли уишка и правда поломана и в тестах на логику и в рп это было не так заметно.

Пик1.

> надо посмотреть что в модель идет.

Пик2 и идёт, больше нечему.

Пик1.

> надо посмотреть что в модель идет.

Пик2 и идёт, больше нечему.

> Пик1.

В альпаке там еще

### Instruction:

### Response:

> Пик2 и идёт, больше нечему.

Тут только последний пост

> то-ли СТЕМ-файнтюн хуита/не включает в себя матан

Или он в другом замке:

> Tess-M-Creative is an AI most suited for creative tasks, such as writing, role play, design and exploring novel concepts. While it has been trained on STEM, its reasoning capabilities may lag state-of-the-art. Please download Tess-M-STEM series for reasoning, logic and STEM related tasks.

Правда на обниморде я тесс-м-стем не нашёл. К чему тогда было писать второе предложение неясно тогда.

> В альпаке там еще

> ### Instruction:

> ### Response:

Они тоже есть, чуть ниже во вкладке, это стандартный таверновский пресет.

> Тут только последний пост

Это я уже инструкт отключил, пик2 изменился довольно очевидным образом.

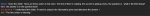

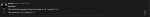

Решил вкатиться в эту вашу угабогу и нихуя не могу понять как подключить её к таверне?

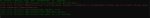

Почитал инфу. Вроде бы всё должно ограничиться флагом --API при запуске, после чего мне должно выдать две ссылки формата:

http://127.0.0.1:5000/api

ws://127.0.0.1:5005/api/v1/stream

Но вместо этого мне выдаёт такую хуйню:

2023-11-23 14:01:01 INFO:OpenAI-compatible API URL:

http://0.0.0.0:5000

INFO: Started server process [7580]

INFO: Waiting for application startup.

INFO: Application startup complete.

INFO: Uvicorn running on http://0.0.0.0:5000 (Press CTRL+C to quit)

Running on local URL: http://0.0.0.0:7860

To create a public link, set `share=True` in `launch()`.

Почитал инфу. Вроде бы всё должно ограничиться флагом --API при запуске, после чего мне должно выдать две ссылки формата:

http://127.0.0.1:5000/api

ws://127.0.0.1:5005/api/v1/stream

Но вместо этого мне выдаёт такую хуйню:

2023-11-23 14:01:01 INFO:OpenAI-compatible API URL:

http://0.0.0.0:5000

INFO: Started server process [7580]

INFO: Waiting for application startup.

INFO: Application startup complete.

INFO: Uvicorn running on http://0.0.0.0:5000 (Press CTRL+C to quit)

Running on local URL: http://0.0.0.0:7860

To create a public link, set `share=True` in `launch()`.

Ах да, таверна по стандартным ссылкам к АПИ не подключается.

> база

Скорее шиза. Он считает изменение вероятностей за изменение вывода сетки. Т.е. у него как раз шизоидный тест влияния на рандом семплера, а не нормальный PPL. Банальный min P в 0.1 весь этот тест перечёркивает полностью.

>Он считает изменение вероятностей за изменение вывода сетки.

А это не так? Все эти семплеры просто костыли, притом разные и меняющиеся. А вот если сетка выдаёт строго одинаковые числа, то можно сказать, что от квантования не будет вреда на 100%. Правда таких квантований тонет.

> А это не так?

Без семплеров имеет смысл сравнивать только первые две вероятности, остальные на вывод реальных токенов не влияют вообще никак. И первые две вероятности начинают перескакивать только ниже q5, всё что выше без семплеров всегда выдаст тот же токен что и fp16.

> сетка выдаёт строго одинаковые числа

И зачем их считать, если низкие вероятности всегда семплером срезаются и никак не участвуют в выборе токена?

Все он правильно считает, он смотрит на отличия от оригинала по всем вероятностям.

И это не учитывая структурной деградации сетки которая делает ее тупее или не дает использовать контекст на который ее тренировали без потерь. Квантование зло.

Че бы не тренировать сетки сразу в 4 или 8 бит? Значит они не работают так же хорошо как fp16.

>Без семплеров имеет смысл сравнивать только первые две вероятности, остальные на вывод реальных токенов не влияют вообще никак.

В каком-то идеальном случае. Бывают длинные хвосты почти равновероятных токенов, особенно по началу предложения/абзаца, и там работают не только лишь первые два.

>или не дает использовать контекст на который ее тренировали без потерь

Вот, это хороший кандидат на проверку- тоже самое, но не на 300 токенов, а на 3000.

>Че бы не тренировать сетки сразу в 4 или 8 бит?

При тренировке возможны выходы за пределы границ, что очень быстро херит всю сетку целиком.

> не дает использовать контекст на который ее тренировали без потерь

Опять пошли шизоидные фантазии. Квантование никак не влияет на positional embedding.

> Че бы не тренировать сетки сразу в 4 или 8 бит?

Масса файнтюнов так и делают, есть для этого bitsandbytes и qlora.

> В каком-то идеальном случае.

Так ты уже определись, без семплеров вероятности сравниваем или что ты там нарандомил. В обоих случаях этот тест бредовый. Без семплера имеют значение только первые вероятности для сравнения, с семплером - низкие и так срезаются.

Я уже молчу про то что надо так-то сравнивать распределение вероятностей что собственно сетка и выдаёт, а не их значения, потому что изменение одной вероятности автоматически меняет все 32к остальных.

>Опять пошли шизоидные фантазии. Квантование никак не влияет на positional embedding.

а вот для этого и нужны тесты, без них твои заявления такие же шизойдные фантазии

>Масса файнтюнов так и делают, есть для этого bitsandbytes и qlora.

Это не то, где изначально тренированные в 4 или 8 бит нейросети llm? По какой то причине они не работают так хорошо как fp16, а как ты понимаешь если не проходят обучение и проверку на таких битах, то и кванты не будут нормально работать.

На самом деле никто из нас за исключением 7b и меньше наверное никогда не игрался с настоящими нейросетями, мы запускаем кванты, их бледные подобия. И судим о нейросетях по этим квантам.

Полноценные оригинально запускаемые сетки ощущаются иначе, чуть умнее и целостнее, лучше работают с контекстом и тд. И от этого могут работать лучше и ощущаться умнее по опыту использования.

Полноценные оригинально запускаемые сетки ощущаются иначе, чуть умнее и целостнее, лучше работают с контекстом и тд. И от этого могут работать лучше и ощущаться умнее по опыту использования.

> По какой то причине они не работают так хорошо как fp16

Это откуда такие выводы? Я тебе ещё раз повторю - куча файнтюнов что ты используешь делают как раз квантами, хотя бы в 8 бит. Ты когда последний раз открывал карточки моделей на HF?

Ну а как иначе? Сидеть на 7B, потому что уже 13B требует проф ускорителей за 10 килобаксов?

>файнтюнов

так я про основу для файнтюна спрашиваю, про изначальную модель, а не о файнтюнах.

Сетки с нуля тренируют на 4 или 8?

Я знаю что файнтюны допиливают на 4 и 8, но они работают с моделью fp16

Так претренировка в fp32 делается не потому что качеству что-то мешает, а потому что при нестабильном loss и высоком lr веса скачут и им нужен больший диапазон точности чтоб не ломаться.

Ну так если ты адепт квантования у которого кванты не отличаются от оригинала, то ты мог бы спросить - эй ребят просто выпустите оригинал на 4-6-8 битах и сетка будет весить в 2-3 раза меньше и все будут счастливы.

А то че они как дураки тратят кучу денег вертя такие тяжелые сетки которые так много весят в fp16

ну вот это аргумент, хотя опять же не понимаю почему сеткам нужна для тренировка такая бальлая точность, на мясе все хорошо если все в 4 битах работает

>Ну так если ты адепт квантования

Я адепт того, что работает. Запуск в fp16 не работает, нет ресурсов. Тренировка в int4 не работает, ибо лоссы. Ну так о чём вообще спор?

>хотя опять же не понимаю почему сеткам нужна для тренировка такая бальлая точность

Потому что

>веса скачут и им нужен больший диапазон точности чтоб не ломаться

>на мясе все хорошо если все в 4 битах работает

На wetware нету NaN.

> Ну так о чём вообще спор?

Да вобщем то не о чем, скорее вопросы в пустоту

Так подумав, может быть 4-8 бита смогут тренироваться на большой сетке, по аналогии с тем что большая сетка не так сильно страдает от квантования. Но это так, мысли

>Так подумав, может быть 4-8 бита смогут тренироваться на большой сетке

Не сможет, NaN всё так же заразителен.

>Кто сможет создать маленькую и рабочую на мобильниках локально модель - тот озолотится.

Я один не понимаю, зачем ЛЛМ на могильниках? Хотя я конечно ретроград, и не понимаю, зачем вообще могильные телефоны нужны, кроме как звонить и карты показывать.

>Не сможет, NaN всё так же заразителен.

А если этой проблемы не будет? Ну алгоритм какой допилят?

У нас есть некоторая информационная вместимость сетки, пространство параметров или как там.

Если увеличить количество параметров в 2 раза и уменьшить количество бит в 2 раза то будет ли сетка, при решении проблемы nan, по мозгам аналогична или даже лучше чем 7b?

На вроде

7b-fp16 ~ 14b-8q ~ 28b-4q

Там конечно все сложнее, но думается мне от большего количества параметров в сетке могут возникать более сложные связи, и это по идее уменьшило бы необходимую точность весов увеличив мозги. Но это все так, фантазии.

А зачем их уже щас на винду суют с обновой? Вот для чего то подобного. Ну и конечно большой брат/реклама.

>А зачем их уже щас на винду суют с обновой?

Рилли? Понятия не имею. Хайп ради хайпа небось. Но в шинде 100% будет ёблачное решение.

хз вроде локальные. и там не полноцненная ллм на сколько понимаю, так, типо умной сири которая может манипулировать компом по командам, погугли

Обнови убабугу и обнови таверну до последних версий, там в каких-то апи апгрейдили.

> после чего мне должно выдать две ссылки формата:

> http://127.0.0.1:5000/api

> ws://127.0.0.1:5005/api/v1/stream

Если такое выдает значит старая версия

Ну не совсем шиза, считай некоторая метрика отличий от исходника. Другое дело что с качеством это не напрямую может коррелировать.

> So, after hacking with koboldcpp's sampler code to force output the original probabilities

А зачем там что-то "хакать", оно по дефолту не умеет выдавать чтоли? Вообще это не мешало бы сравнить с точки зрения обработки большого контекста еще, какие изменения после такого происходят.

> Все эти семплеры просто костыли

Нет, это способ улучшить вариативность и качества текста. Но действительно там если тряска идет вокруг невероятных токкенов или тех что наверняка попадут в отсечку, то и разница не будет такой большой. Собственно частично об этом в посте на реддите и сказано, тряска значительно отсекается просто установкой top P=0.95, а вот min_P может и пропустить.

Нужно вводить метрику, в которой весовой функцией будет вероятность токкена, это как раз и охарактеризует примерно как будут меняться ответы сетки, а не что там в почти невероятных токкенах. И на контексте побольше делать.

Кстати разницу влияния кванта в размерах показал.

> И это не учитывая структурной деградации сетки которая делает ее тупее или не дает использовать контекст на который ее тренировали без потерь.

Ого, и тут ты такой с пруфами. "Мне мистраль зашакальный не нравится" за пруфы не считается.

> Че бы не тренировать сетки сразу в 4 или 8 бит?

К этому может и придем, уже есть методы совмещенного квантования-дистилляции-дообучения.

> Если увеличить количество параметров в 2 раза и уменьшить количество бит в 2 раза

> 7b-fp16 ~ 14b-8q ~ 28b-4q

Для начала найди алгоритм, который сделает такой финт без потерь

> по мозгам аналогична или даже лучше чем 7b

Уже выяснили что квантованная большая сетка лучше нетронутой мелкой про прочих равных. Офк если не ужата до полной лоботомии.

> уменьшило бы необходимую точность весов увеличив мозги

Бля такими вещами оперируешь что пиздец. Большой размер менее чувствителен к дискретностям, вплоть до состояний 0-1, никаких мозгов там нет.

>Для начала найди алгоритм, который сделает такой финт без потерь

Пока нету, ну как вариант.

И там имелось ввиду тренировка с нуля с такими параметрами, при сохранении размера файла увеличатся мозги сетки. Если опять же не будет сваливания в nan

>Бля такими вещами оперируешь что пиздец. Большой размер менее чувствителен к дискретностям, вплоть до состояний 0-1, никаких мозгов там нет.

Так в этом и соль, чем больше сетка тем меньше ей нужно бит на вес, конечно должен быть какой то баланс производительность/количество бит на вес. Думаю доводить все до 2 квантов все таки хуйня

Уже разобрался, но за ответ спасибо.

Угабогу поставил последнюю, а вот таверна была старая и в ней ссылку из нового АПИ некуда было пихать.

После обновления таверны всё ок.

https://www.reddit.com/r/LocalLLaMA/comments/181bimx/sharegpt4v_new_multimodal_model_improves_on_llava/

новая мультимодалка вроде как превосходящая ллава

новая мультимодалка вроде как превосходящая ллава

> We illustrate the procedure for collecting highly descriptive captions from GPT4-Vision via various image sources and data-specific prompts, resulting in 100K high-quality captions that encapsulate a wide array of information conveyed by the images.

> GPT4-Vision

Интересно будет ли лезть

> Your input image may contain content that is not allowed by our safety system.

и насколько она действительно лучше. Пока что с левдом и 2д лучше всего бакллава справляется, хорошо "видит" пусть и тупая как пробка.

Ну такое себе.

Ну хуй знает, я с описания проиграл

мимо

>Пока что с левдом и 2д лучше всего бакллава справляется, хорошо "видит" пусть и тупая как пробка.

есть личная статистика? можно результаты?

по сравнению с чем? с гопотой? естественно

А если пальчик тебе показать, тоже проиграешь?

>по сравнению с чем? с гопотой? естественно

А с чем ещё сравнивать? Впрочем, надпись про 0 рублей у меня какая-то из прошлых визуалок таки выкупала. А эта нет. И текст распознаёт оче хуёво.

смогла кое как опознать русский переведя его в слова, попробуй на английском хоть, русский они едва понимают

> есть личная статистика?

Оно, результаты при случае. Немного в прошлом треде кидал но там пикчи всратые, изначально для сортировки рассматривалось.

Скинь пикчей тех исходник

> А если пальчик тебе показать, тоже проиграешь?

Улыбнулся от такой идеи

о заебато, спасибо, я как то пропустил ту ссылку

> текст распознаёт оче хуёво

Она 336х336 пикчи принимает, хули ты хочешь. Надо уже CLIP пиздить за то что их энкодеры изображений такие мелкие.

обсидиан то на уровне и иногда лучше той же ллава 13

>Скинь пикчей тех исходник

Самые лучшие мемы ((

>Она 336х336 пикчи принимает, хули ты хочешь.

Lil, ну и как с этим жить?

А если пальчик будет танцевать?

>Она 336х336 пикчи принимает, хули ты хочешь.

Ну в общем попробовал максимально простую пикчу, но и тут не выкупает.

Прекрати, блин, дурак! Я на работе, мне нельзя смеяться!

Шевелю всеми пальчиками А это дискотека.

Блюшес отворачиваясь Дурак....

Обосрался.

Скрещиваю два пальца и начинаю ими крутить А это медленный танец.

Ред эс а бит Х-хватит.....

Какой положняк треда по моделям, что стоит юзать ньюфагу?

шапку глянь, кобалд и модель оттуда на выбор по своему железу смотри, ну и силли таверна если хочется на карточках с чуба сидеть

Так вопрос именно про выбор

Зависит от твоей карточки

железо свое кидай а там будем посмотреть

3070 и 32 оперативки у cpu

Грустновато, тут нужна врам. 7б без проблем сможешь катать, может 13 с приемлемой скоростью. Для начала смотри файнтюны мистраля что посоветуют.

А cpu совсем медленный да?

Вот твой выбор.

В треде мелькали владельцы серваков с овер 9000ТБ оперативы. Может уломать хоть одного запустить 34-70 в i16 и fp16 и окончательно решить всех заебавший срач на тему потери души при квантовании?

И как насчёт awq? Он вроде осуществляет квантование с переменной разрядностью.

Смотря какой проц, если у тебя там ддр5 то все веселее, ну или быстрая ддр4, или на крайняк 4 канальная память.

Ну и да, 7b 13b максимум 20b твои друзья, в ггуф лучше с оффлоадом части слоев на видимокарту

Ну технически запустить сетку можно даже на смартфоне, вопрос настолько ты терпеливый. Говоря про основные задачи - рп, ассистирование, код, тут нужна скорость сопоставимая со скоростью чтения. Проц с ддр5 на 7б ее обеспечит скорее всего, но переобработка контекста будет очень долгой. Тебе в любом случае все что больше 7б пускать на гпу+цп, так что ничего страшного. 13б скорее всего будет относительно шустро бегать, для вката оценить хватит.

Предлагай свои тесты.

да хотя бы контекст проверить у мистраля, все таки есть у него 32к или нет без квантования, или 34b 200к новые на контекст пощупать.

Для контекст проверить и серваков не нужно. Несколько тредов назад на его релизе тестил, все довольно таки вяло там и нужно rope подбирать. Без растяжки его хватает менее чем на 8к, потом деградация. При контексте в районе 30к и задаче суммарайза иногда с трудом вспоминает инструкцию из начала и обобщает не детально. В чатике новое сообщение с отсылкой к старым наверно будет не так плохо генерировать, надо изучать.

Давай свои условия, промт, настройки, попозже или на днях чекну.

>Давай свои условия, промт, настройки, попозже или на днях чекну.

Сложна, условий конкретных нету, ну хотя бы сравнить fp16 q8 и 4km на этот самый контекст.

Как хз, просто предлагаю варианты.

Для 7b тот же гермес2.5 и для варианта mistrallite как ориентированный для контекста, из 34b новых какой нибудь на 200к

Как установить AutoAWQ в text-generation-webu?

Что вы там чекать собрались? Контекст от эмбендинга зависит, а он всегда в fp32. Самому трансформеру поебать сколько там токенов и в каком они порядке расположены.

>Что вы там чекать собрались?

По хорошему проверить бы как большие сетки, таблицу где и до скольки контекст нормально вспоминает.

Но и просто как квантованная сетка с контекстом работает сойдет. Вобще ты вроде шаришь вот и предлагай

> предлагай

Я раньше просто брал рандомную карточку с чуба, забивал контекст и потом спрашивал по карточке. Но это всё хуйня, сейчас альфой что угодно можно растянуть, китайцы с 200К реально столько имеют. Я на Yi 6В забивал 50к - всё ещё работало.

Ну ты скажи где этот контекст взять для начала. Тогда копипастил просто куски треда и спрашивал "че тут обобщай давай вилкой раз раз". Ему было тяжело, офк тут еще русский язык. Большие модели даже оче сильно растянутые без проблем справлялись.

В чатах тестировать сложновато, ибо хз как оно по дефолту должно себя вести, то что он будет хуже больших моделей это и так понятно. Тут только какая-то субъективщина и все.

> таблицу где и до скольки контекст нормально вспоминает

Тут важны параметры, плюс каков критерий нормального восприятия?

Где тестошиз и почему он ещё Сократа не протестил? В задачках на логику ебёт адово.

Кого?

>контекст взять для начала

книгу на английском, вышедшую позже 22 года, как вариант

там хоть весь забить ей можно

>Тут важны параметры, плюс каков критерий нормального восприятия?

А как большие тестят? Я хз

>Где тестошиз и почему он ещё Сократа не протестил?

э за шиза обидно, ссылку кидай хоть о чем пишешь

>Я на Yi 6В забивал 50к - всё ещё работало.

хуя, но опять же сетка просто генерировала после 50к или могла искать по всему этому объему?

Посоветуйте пожалуйста хороший пресет для бэкэнда? А то все эти топ_к, мин_п пугают и путают....

> Предлагай свои тесты.

Удвою про контекст, интересно узнать реально ли 200к выдержит квант, ну например этой модели https://huggingface.co/brucethemoose/Capybara-Tess-Yi-34B-200K , и если вдруг не выдержит то на каком месте будет ломаться. Неплохо бы ещё и про 2-3 бита эксламы2 узнать в сравнении с оригиналом, как сильно влияет на 13-34-70, но её небось там квантовать долго надо.

> да хотя бы контекст проверить у мистраля

У мистраля можно и с одной гпу проверить, у 4бит раньше он куда то проёбывался после ~18-20к с полной поломкой модели в ответах, но я лишь небольшой тест прогонял, в одном случае работало, в другом нет, на истину не претендует.

ищи тут или в прошлом ссылку на пин-п пресеты

>пин-п

min-p точнее говоря, https://www.reddit.com/r/LocalLLaMA/comments/17vonjo/your_settings_are_probably_hurting_your_model_why/

Я это видел, но разве там приводится хороший пресет?

мне нра

> книгу на английском, вышедшую позже 22 года

Предложи ту, содержание которой знаешь.

> А как большие тестят?