Охуенен, просто нет слов.

> С картинками что-то неладное происходит, грузятся через раз. А на котокоробку если возвращать - там из-за ркн оно через раз грузит и нужен впн/прокси.

Гитгуд очень медленно картинки отдаёт, если их на нём хостить, по какой-то причине. Поэтому, я рассчитывал, что пикчи будут на сторонние сервисы грузиться, по типу catbox. Из минусов то, что такой подход добавляет ещё одну точку отказа в виде картинкохостинга - на том же imgur уже выпиливали картинки, которые использовались в местных гайдах по sd.

Вообще, у гитгуда сам хостинг статики на коленке сделан, насколько я понимаю. Я когда изначально там вики поднял, она просто не открывалась в Firefox из-за кривых сертификатов - я немного поисследовал проблему и понял, что это общая проблема для всего хостинга от gitgud. Но когда я связался с девом гитгуда, он за пару часов поправил проблему, а это был вечер воскресенья (мне даже неловко от такого стало). То есть сам фикс видать пустяковый был, но почему без прямой наводки они сами багу раньше не поправили...

Про проблему с catbox у ркн в первый раз слышу.

У меня была мысль арендовать какую-нибудь копеечную vps'ку и настроить туда автодеплой собранной вики вместо гитгуда. В этом случае, все картинки, включая шизогриды для sd, можно хранить напрямую в репе. В самом же гитгуде оставить только репу. Но, в этом случае, появятся риски, что, если, в какой-то момент, я забью на всю ии-движуху и не буду продлевать оплату, то проект упадёт с непонятными перспективами - придётся кому-то другому про инфраструктуру думать. Я бы мог такое организовать, но не уверен, стоят ли риски того и как вы вообще к подобному муву отнесётесь.

Сейчас же мы чисто фришный хостинг используем. Из моей инфраструктуры там только билд-агент в виде древнего thinkpad'а, который отслеживает правки в репе 24/7, собирает проект и разворачивает статику на предоставляемом gitgud'ом фришном хостинге. Роль билд-агента может выполнять любой калькулятор с доступом в интернет.

Тред умер нахуй

Будет интересно почитать гайд на таверну

А почему по классике не сделать вики на гитхабе?

Будет интересно почитать гайд на таверну

А почему по классике не сделать вики на гитхабе?

> Гитгуд очень медленно картинки отдаёт, если их на нём хостить

Вот в чем дело, графики и мелкие скрины норм работают, а где крупнее - через раз. Потом на котокоробку значит перекину обратно, или попробую пережать чтобы загружались оттуда.

С сертификатами сейчас действительно все ок, так бы и не вспомнил.

> Про проблему с catbox у ркн в первый раз слышу.

Хз, может и не ркн но поведение идентичное. Чсх оно рандомно, иногда работает, иногда не грузит. Впску - хз, текущая версия прилично работает кмк, а с пикчами тема приемлемая.

Алсо, статьи на циве нельзя сделать под коллективный/групповой доступ?

> Будет интересно почитать гайд на таверну

У нее функционал богатый очень и не то чтобы его весь знаю, только основное. Может если будет не лень разобраться хотябы с озвучкой/распознаванием, запросами генерации пикч и около того.

Найс, спасибо что уделил время

> А почему по классике не сделать вики на гитхабе?

Минорные проблемы - в вики на гитхабе не работает система с ПРами, так что люди без прав в репе не смогут предложить правки (но мы такую возможность по факту не используем, так что это мелочь). Поскольку это чисто онлайн-система, то у контрибьютеров нет мотивации держать актуальную локальную копию, которая может выступить в роли бекапа на случай чп.

Но вариант с вики на гитхабе кмк был бы лучше вики на условном fandom, т. к. на гитхабе вики хранится в виде честной гит репы, которую можно бекапнуть вместе со всей историей одной командой.

Основная проблема с гитхабом в том, что есть подозрение, что за отдельные части вики её могут пидорнуть с гитхаба - раз проект sd-web-ui (который от automatic1111) оттуда около года назад выпилили за то, что в readme-файле были ссылки на статьи по теме то ли с хентаем, то ли с nai leak, уже не помню точно. Я читал правила гитхаба, и, как мне показалось, там просто за условный панцушот или джейлбрейк с фокусом на ерп выпилить репу могут. В общем, нужно определённых правил цензуры тогда придерживаться, чтобы минимизировать риски, в случае гитхаба. В том же гитгуд уже много лет хостятся проекты эроге с лолями, так что подобных рисков сильно меньше.

Зачем вообще что-то менять? Работает- не трогайте.

Я не хочу ничего менять. Только с картинками разобраться бы, чтобы как в случае с rentry всё не ломалось на части провайдеров.

Анон задал хороший вопрос, на который стоило ответить. Просто я сам изначально рассматривал именно гитхаб в качестве репы для вики, но из-за перечисленных минусов решил использовать другую опцию, которой выступил гитгуд.

>he chuckled darkly

в каждом первом ответе. Заебал. Как фиксить? Использую угабугу

в каждом первом ответе. Заебал. Как фиксить? Использую угабугу

Модель? Температура? Квант? Мы не телепаты, анон

Smirking.

pivot-0.1-evil-a.Q8_0.gguf

пивот евил изначально сломан, он просто эксперимент на обратном выравнивании

блин, а что юзать то тогда?

Мне чисто под кум и чтобы влезало в 7 гб (11 с учетом контекста)

toxichermes-2.5-mistral-7b попробуй, он тем же методом расцензурен но уже не сломан

Старая добрая Synatra-7B-v0.3-RP хороша для кума, как по мне, хоть и тупит мб больше других 7b моделей. Ещё недавно наткнулся на её вот такой популярный мерж https://huggingface.co/PistachioAlt/Synatra-MCS-7B-v0.3-RP-Slerp-GGUF Эта более уравновешенная.

Из твоего скриншота настроек сэмплеров выходит, что ты вообще их не применяешь. Это не есть хорошо для мелких моделей. Поставь хотя бы minP 0.1 или дефолтные topP 0.9, topK 30, если с остальными экспериментировать неохота. Ну и rep pen поднять с единицы хотя бы на 1.1 можно.

https://www.reddit.com/r/LocalLLaMA/comments/18z04x5/llama_pro_progressive_llama_with_block_expansion/

Ну ебать, еще один метод улучшения моделей.

Теперь это наращивание знаний модели без потерь.

Ну ебать, еще один метод улучшения моделей.

Теперь это наращивание знаний модели без потерь.

За этим приходить через полгода, не раньше.

А че есть что нить по наращиванию скоростей генерации? А то умные модели это хорошо, но генерить по 1.7 токена 70b ДОЛГОВАТА.

жди мамбу, трансформеры не ускорить, разве что прунить и квантовать для уменьшения размера.

Что за мамба, анончик?

А че, на форчке побанены русские айпи? Попытался написать в /lmg/, пишет айпи ренж блокед дуе ту абуз.

Почитал про мамбу, двоекратное уменьшение размера моделей при том же качестве чет слишком красиво звучит.

мимо другой анон

https://arxiv.org/abs/2312.00752

https://huggingface.co/models?sort=created&search=mamba

Всё хочу одну скачать на пробу и каждый раз лень настраивать. Там какие то есть уже новые файнтюны на базовых моделях, хоть и 3b.

Но вроде как они равны 7b по мозгам, по крайней мере по заявлениям исследователей. Как оно на деле хуй знает.

Нашел только это из того как мамбу запустить, по другому хз

https://github.com/havenhq/mamba-chat

Кто шарит может поиграться, только отпишитесь что ли, интересно ведь

Аноны, а что за карточку персонажа он требует?

Завтра потыкаю может быть и отпишусь

Кто "он" ?

Ну... Кобольд. На первом пике требует либо промт (куда его?), либо карточку (какую?), либо выбрать сценарий. Но на все кастомные (которые импорт фром) он выдает пик 2.

Да, я ньюфаг

Поставь SillyTavern, подключи ее к кобольду, карточки бери на chub.ai. У кобольда интерфейс говна, его использовать можно разве что для проверки работоспособности модели. У меня он вообще настроен на запуск без вебморды, чисто апи для таверны.

Для deepsex 34b какие настройки в таверне оптимальны?

А то отвечает что на симпле что на миростате как то суховато прям.

А то отвечает что на симпле что на миростате как то суховато прям.

>toxichermes-2.5-mistral-7b

нахуй идет быстро решительно

>without your consent

Как же они заебли....

Как же они заебли....

>Synatra-7B-v0.3-RP

соя ёбаная.

Бомж не захотел насиловать 14-летнюю девочку.

Пивот с этим проблем не имеет.

Итак, пивот все еще наименее соевый. Может быть еще кто варианты подкинет?

Стаканул Р40 + 1070, запустил yi-34b-v3.Q6_K и получил производительность 6.3т/сек (1070 медленная, наверное, две p40 дали бы 7+++).

На соло Р40 в yi-34b-v3.Q4_K_M было 9т/сек.

Неожиданно, но в итоге стаканье видеокарт не создаёт накладных расходов как предполагали всем тредом ранее.

Кстати, этого стака уже хватает на запуск 70b Q2_K (лол, проверю). А если использовать проц + Р40, то производительность будет 1.8 т/сек для 70b Q4_K_M.

Ещё меня начала мучать шиза на тему, что q6 сильно лучше могёт в причинно-следственные связи, хотя лексика у них ощущается одинаковой. Это немного не совпадает с общепринятым знанием про потери 0.00001% информации при квантовании. Поясните, плз.

Мимо китаедаун.

На соло Р40 в yi-34b-v3.Q4_K_M было 9т/сек.

Неожиданно, но в итоге стаканье видеокарт не создаёт накладных расходов как предполагали всем тредом ранее.

Кстати, этого стака уже хватает на запуск 70b Q2_K (лол, проверю). А если использовать проц + Р40, то производительность будет 1.8 т/сек для 70b Q4_K_M.

Ещё меня начала мучать шиза на тему, что q6 сильно лучше могёт в причинно-следственные связи, хотя лексика у них ощущается одинаковой. Это немного не совпадает с общепринятым знанием про потери 0.00001% информации при квантовании. Поясните, плз.

Мимо китаедаун.

Купи вторую гпу, будет по 17+ т/с на 70б, сможешь инджоить и наслаждаться. Или возьми одну-две p40, в теоретической теории они смогу обеспечить скорость стриминга сравнимую или быстрее чем скорость чтения на 70б.

Или дождить тему с горячими нейронами, довольно перспективная штука.

Возможно потыкаю, или потом, отпишусь.

> Бомж не захотел

Асуждаю

> не создаёт накладных расходов

В каком лаунчере? Бывшая не создает, но там паскаль очень слаб. Жора вроде как создает проблемы, но их природа не изучена.

> 1.8 т/сек для 70b Q4_K_M

Грустновато, конечно, оно с другими видюхами на ддр5 быстрее получается. Второй p40 или чего-то жирного нету случаем??

> что q6 сильно лучше могёт в причинно-следственные связи, хотя лексика у них ощущается одинаковой

Единичный случай скорее всего, отпиши подробнее что там, так можно будет исследовать.

>В каком лаунчере?

lamacpp, только он работает быстро на паскалях.

>Второй p40 или чего-то жирного нету случаем??

Нету. Только несколько затычек.

>отпиши подробнее что там

Ох, тут придётся делать десятки скринов чтобы можно было что- то сравнить.

Может быть была инфа, что yi глупеют от квантования, но не так сильно как мистрали?

Ананасы, нуб репортинг ин. Что писать в промпт, чтобы модель не пичкала меня соевой моралью? Мне не нужна какая-то чернуха, но мне нужен текст с определенным настроением. Даже нейтральные промпты это чудище умудряется повернуть так, что персонаж начинает угрызения совести испытывать по поводу того, что кому-то что-то не так сказал. Mistral instruct 0.1 7B.

Вообще, как составлять промпт? Как в ЧатГПТ?

Вообще, как составлять промпт? Как в ЧатГПТ?

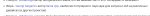

Самый адекватный выход тут - искать какие-то менее соевые файнтьюны. Дефолтная инстракт версия заточена быть полезным безопасным помощником. Промптинг как для больших моделей тут не поможет, 7б модель не поймёт полотна инструкций. Ну можешь попробовать добавить в промпт какие-то очень-очень простые инструкции вроде того, что ролеплей fictional, что у персонажа есть свои цели, к которым он должен стремиться несмотря ни на что, и прочее. Ещё если используешь ChatML инстракт пресет, который рекомендуется для мистраля, то попробуй включить имена и подредактировать его как на первом пике, чтобы убрать упоминание ассистента. Начало чата я ставлю как на втором пике, чтобы показать сетке, где закончился системный промпт, и начался чат, который надо продолжать, но мб это избыточно. И в мейн промпте не должно быть фигни вроде "you are helpful assistant".

Возьми просто любой файнтюн.

Dolphin, OpenChat

Они мало того что без сои, так еще и работают лучше.

Джейлбрейки на локальных моделях это бред вообще.

Это для любителей MINISTRATIONS извращение.

Привет, ананасы!

Всех с Наступившим!

В общем, положняк такой: мне в жопу заноза попала - хочу извергнуть из ануса нейросетевого стримера, который играет в какую-то несложную игру, пиздит с чатиком и имеет навык не рыгать буквами, вместо осмысленных предложений.

Задача уже на этом этапе звучит как пиздец и всё усугубляется тем, что у меня абсолютный ноль знаний и понимания в теме, но много мотивации и свободного времени.

Я полистал местные треды и столкнулся с тем, что закреплённые в шапке гайды не актуальны, например, и без помощи местных знатоков я не справлюсь.

Реквестирую помощь на данном этапе. С какой стороны начать есть этот пирог? Пните в нужную сторону. Пока однозначно понятно следующее: нужно как минимум разобраться с компьютерным зрением, начать обучать по вводным параметрам какую-то языковую модель, а также, скорее всего, поебаться и разобраться с API некоторых платформ.

Всех с Наступившим!

В общем, положняк такой: мне в жопу заноза попала - хочу извергнуть из ануса нейросетевого стримера, который играет в какую-то несложную игру, пиздит с чатиком и имеет навык не рыгать буквами, вместо осмысленных предложений.

Задача уже на этом этапе звучит как пиздец и всё усугубляется тем, что у меня абсолютный ноль знаний и понимания в теме, но много мотивации и свободного времени.

Я полистал местные треды и столкнулся с тем, что закреплённые в шапке гайды не актуальны, например, и без помощи местных знатоков я не справлюсь.

Реквестирую помощь на данном этапе. С какой стороны начать есть этот пирог? Пните в нужную сторону. Пока однозначно понятно следующее: нужно как минимум разобраться с компьютерным зрением, начать обучать по вводным параметрам какую-то языковую модель, а также, скорее всего, поебаться и разобраться с API некоторых платформ.

> Пните в нужную сторону. Пока однозначно понятно следующее:

Тебе понадобятся железки. Что сейчас в наличии?

Да.

Очередной пиздёж, да, и дроч на тесты.

Скил ишью.

>у меня абсолютный ноль знаний и понимания в теме

Ну так приобретай.

>закреплённые в шапке гайды не актуальны

Всё там актуально на 100%.

>нейросетевого стримера, который играет в какую-то несложную игру, пиздит с чатиком и имеет навык не рыгать буквами, вместо осмысленных предложений

Не осилишь, инфа 146%.

В базе 3070Ti и 5900Х, но мощностей ещё есть у меня!

Теоретически, тебе нужен CogAgent, подходящее железо и очень много времени и мотивации ебстись со всем этим.

>Ещё меня начала мучать шиза на тему, что q6 сильно лучше могёт в причинно-следственные связи, хотя лексика у них ощущается одинаковой. Это немного не совпадает с общепринятым знанием про потери 0.00001% информации при квантовании.

А где ты это общепринятое увидел? Тут несколько раз срачи были на эту тему, и есть 2 стула - те кто оценивают потерю по тесту перплексити, и те кто не доверяет такому простому тесту. Собственно - любое квантование идет с потерями, так что даже если модель не теряет способность генерировать текст, она может потерять связность на более высоком уровне. На уровне следования контексту или понимания че от нее вообще надо.

Более, абстрактные области. Вот это самое причинно-следственное. Мозги, грубо говоря.

Те же 7b обладают меньшим запасом прочности и теряют способность генерировать текст раньше, чем жирные сетки. Но то что 34b работают на 4 кванте не значит что они НЕ потеряли в качестве, просто потеря не дошла до заметной потери в генерации ответов.

Любая сетка будет работать без потерь только запускаясь в ее родном размере. Это fp16. Может быть минимальные потери будут на 8q, но они будут, хоть и мизер.

Вот только запускать нормальный размер часто не на чем, поэтому приходится возится с ущербными копиями оригинала, квантами поменпьше.

В базе блок-схема такая. Для начала научить бы её разговаривать. Поможешь дополнить?

Рад буду любым идеям и информации. Сейчас агрегирую очень много данных и изучаю очень много информации. Надеюсь при помощи анонов сделать нечто годное с открытым кодом.

>Скил ишью.

все кроме пивот:

аааа нееет что ты делаешь, прекрати, я не буду этого делать, ты совершаешь ошибку, тебе это не нужно аааа

литералли пикрелейтед

пивот:

я из тебя всю душу выебу, ебать, погнали нахуй

Ну камон.

Ну вот еще, в 7 гигов 5ks войдут

solar-10.7b-instruct-v1.0-uncensored

Фроствинд хорошо следует персонажу, если пропишешь маньяка скорей всего будет действовать как маньяк

Frostwind-10.7B-v1

Этот тоже как бы расцензурен, и он тоже есть в разных размерах

bagel-dpo-7b

Пивот эвил весело запускать, но в чате он шизит

Так как сломан слишком сильным антивыравниванием

При ротации контекста ощущается сильное замеждение генерации.

Вставляю контекст 4к. До примерно 3.5к - все генерирует быстренько. Когда доходит до 3.5 - начинается пиздец и ожидания по 70 секунд пока он там отсетет лишнее и сгенерирует новое.

Есть варианты как фиксить?

Я внезапно понял, что 4к конетекста в рп - это вообще ни о чем.

Вставляю контекст 4к. До примерно 3.5к - все генерирует быстренько. Когда доходит до 3.5 - начинается пиздец и ожидания по 70 секунд пока он там отсетет лишнее и сгенерирует новое.

Есть варианты как фиксить?

Я внезапно понял, что 4к конетекста в рп - это вообще ни о чем.

>родном размере. Это fp16

Замечу, что 16 бит это половинная точность. Полная 32, но в некоторых случаях и её не хватает, и для нейросеток когда-то использовали двойную точность.

Похоже, что у тебя не хватает памяти, и начинается подкачка пары сотен мегабайт. Давай подробнее, что на чём и чем запускаешь.

Локалки тебе не нужны, тупо контекста не хватит на целый стрим, тебе нужен клод или гптыня с их 32-100к контекста. Гипотетически тебе нужна связка языковая модель + апи твича/ютуба для получения чата + нужный промпт + синтезатор голоса + витуберский софт. На инпут текстовой модели подается отрывок текущего чата, генерируется ответ, он загружается в синтезатор голоса, голос подаётся в витуберский софт, витубер пиздит на стриме, в итоге все должно работать. С игрой сложнее, тебе придется играть самому, нейросетей которые играют самостоятельно я не видел, разве что в какие-нибудь шахматы.

>нейросетей которые играют самостоятельно я не видел, разве что в какие-нибудь шахматы.

Кучу раз видел какие то эксперименты с майнкрафтом и нейросетями, про исследования автономных агентов и тд

лмао

Интересно

Пивот как всегда лол

Вобще не хватает сеток, половина какие то странные взяты

стащил из этого треда, это мемные модели которые часто форсились в форчановском /lmg/

https://boards.4chan.org/g/thread/98282960

>За этим приходить через полгода, не раньше.

Хуевый из тебя пророк анонче

https://huggingface.co/TencentARC/LLaMA-Pro-8B

Вот и первая сетка по методу наращивания знаний без потерь, если я правильно понял.

https://www.reddit.com/r/LocalLLaMA/comments/18z04x5/llama_pro_progressive_llama_with_block_expansion/

Она кстати тут есть или ее файнтюн

РП-кал ожидаемо самый соевый, лол. Не хватает в сравнении базового Багеля.

там кста предпоследний пост, челик тестит beyonder-4x7bv2+ на своей расистке emily, модель вообще на отъебись игнорирует добрую половину описания и контекста чата, кек

Самый нормальный файнтюн микстраля - это Notux. Ужатые 4х7 вообще кал из под васянов.

поздравляю

не трогай час-два если с холода притащил, на них конденсата куча

пока не отогреются и влага не испарится лучше не включать

> сетка по методу наращивания знаний без потерь

хм, надо собрать самые топовые модели по типу этой :

https://huggingface.co/TheBloke/SOLAR-10.7B-Instruct-v1.0-uncensored-GGUF

и нарастить мега-базовую и ультра умную нейроночку что будет выполнять каждый твой приказ без колебаний.

ну а вообще без приколов, если это действительно работает как DPO или laser, то эта троица есть самый эффективный способ по дополнению нейронки новыми знаниями.

или можно юзая этот метод, вырвать из нейронки всё что выдаёт сою в конечном результате, исходя из того что если можно добавить transformer blocks, то так же их можно и убрать.

Да уж, веселье только разгоняется с этой кучей методов улучшений. 2024 год будет ебейшим в плане развития ии.

Главное что бы не последним, лол

>нейросетей которые играют самостоятельно я не видел

Даже в дотку режутся. Но всё за закрытыми стенами.

Красава. Ждём тестов 70B.

И как оно работает? Особенно на жоре, который славится своей хуёвой поддержкой всех нововведений.

>то так же их можно и убрать

Ой не факт.

Так же про 2023 говорили.

>Так же про 2023 говорили.

Будто он таким не был.

>И как оно работает? Особенно на жоре, который славится своей хуёвой поддержкой всех нововведений.

Тесты уже есть на пикче, так что скорей всего работает

Да и ггуф уже выкатили вместе с другими форматами

Да кто такой этот жора

Из новой шапки.

https://huggingface.co/TheBloke/LLaMA-Pro-8B-GGUF

ггуф запускается кобальтом без ошибок, и оно отвечает осмысленно.

Ну че, новая базовая модель и новые файнтюны скоро

ггуф запускается кобальтом без ошибок, и оно отвечает осмысленно.

Ну че, новая базовая модель и новые файнтюны скоро

>8b

Фи

>Будто он таким не был.

Как по мне, всё самое интересное было в 2021, когда запилили GPT3. 2022 был годом хайпа с чат моделью, а в 2023 просто к этому получили доступ гои типа нас. По сути ничего принципиально нового.

Уже вижу как унди начинает клепать новые франкенштейны-шизомиксы.

> Уже вижу как унди начинает клепать новые франкенштейны-шизомиксы.

Так и не понял, на кой хуй он это делает. Затраты во, а результат минимальный.

Самопиар же.

Кстати, там в кобольдЦП добавили logit_bias.

>logit_bias

чё эта?

Давка конкретных токенов.

Дурачье, теперь можно дообучить любые сетки, 7b просто проба

Ждем новых 34b-36b

Ну или хотя бы доученного солар 11b

> дообучить любые сетки, 7b просто проба

Жду, когда начнут обучать на порнорассказах.

>7b просто проба

Тут уже триллион инициатив остановилась на 7B, лол. Надо запретить всё что меньше 70B, вот тогда прогресс попрёт.

Вторая 4090 нынче ДОРОХОВАТО стоит, тащемта.

>возьми одну-две p40

Ну вот кстати можно и попробовать, хотя тут не понятно как оно с основной картой дружить будет.

>Тут уже триллион инициатив остановилась на 7B, лол.

Просто тебе результаты получше не показывают, вот и все. Самый смак как всегда за закрытыми дверями. Не думаешь ли ты что успех на малой сетке остановит от улучшения большой сетки? Только результат уже никто в открытый бетатест и рекламу не выложит.

Добиваясь результата и выкладывая его просто привлекают деньги показывая что они могут достичь успеха. Как мистраль, например.

Спасибо за ответы, посмотрю файнтьюны. Но раз все упирается в модель, может имеет смысл докинуть оперативы до 32, она сейчас недорогая, да какую-нибудь Ламу 70B гонять, она поместится в 32? Хотя, скорость генерации на процессоре печальная, конечно. Подскажите сетап компа заодно адекватный. Как вообще процессор это дело обрабатывает, количество ядер важно? И насколько видюха разгоняет процесс, если взять какую-нибудь условную 3060. После быстрой Мистраль уже как-то ждать, пока там модель напердит по одной букве в чат, как-то печально.

>и оно отвечает осмысленно.

Шизит порой весьма забавно. МинП лучше вообще не врубать. Классику проваливает стабильно, так что... Мой вердикт на всё новое как всегда- говно неюзабельное.

>Как мистраль, например.

Только мистраль. Да и то сомнительно. Остальные точно в пролёте. Или ты думаешь, что тому же унди перепадёт что-то большее, чем донаты на парочку 4090?

32 гиг мало, проц медленно печаль, 9000 ядер никак не помогают, видеокарта рулит.

Отвечает все равно осмысленно, хоть и шизит.

Ну и да, это ж как пивот эвил, первый результат который выкинули на мороз.

Будь он топовым то никто бы кроме разве что рекламы не выложил базовую версию раздав бесплатно кому попало.

И возможно проблема в ггуф и его запуске. Это работает и преобразуется, но не факт что все прошло правильно и без ошибок. Все таки модифицированная структура.

>Отвечает все равно осмысленно, хоть и шизит.

Ровно так же, как и любая ллама, и даже любительские обрезки на 1,5В. Никакой революции.

>Будь он топовым то никто бы кроме разве что рекламы не выложил базовую версию раздав бесплатно кому попало.

А так смысла нет выкладывать говно. Да и метод то открытый, сейчас наклепают говнеца и опять зальют весь хайгинфейс. Я удивляюсь, как он всё это хранит, да ещё и раздаёт во всю ширину канала даже в Россию.

Начни просто с ознакомления с ллм, обеспечь запуск и быструю работу. Початься, попробуй описать персоналити своей нейтро-самы и добиться того, чтобы она отвечала примерно так как нужно.

Далее, можно начать выстраивать взаимодействие, настрой вишпер и tts чтобы говрить с ней, настрой выдачу эмоций для какого-нибудь л2д движка чтобы ее визуализировать, плюс сделать липсинк с речью.

Этого уже хватит надолго и поймешь много проблем и нюансов. Для организации реально чего-то подобного потребуется несколько ллм, где только одна будет "думать за чара" а остальные будут выполнять вспомогательные роли.

Что же до компьютерного зрения, там своя тема, плюс мультимодалки сейчас развились очень сильно.

О, ништяк кто-то заморочился. Соус с доп описанием есть, или там только результаты? Интересно возможность управлять результатом промтом.

Красава, велкам ту зе дуалгпу клаб, бадди жмакнул за жопу

> новая базовая модель и новые файнтюны скоро

Если там просто блоки добавили, есть вероятность прямой их подсадки к имеющимся моделям, так что скорее новой волны замесов и франкенштейнов.

>И возможно проблема в ггуф и его запуске.

->

>Особенно на жоре, который славится своей хуёвой поддержкой всех нововведений.

Я сразу и отписал, что будет говно. Хотя я еблан, оно о=же влезает в 12 гиг врама, можно что-то более путёвое запустить.

оригинал на угабуге разве что, любые другие методы преобразования и квантования не факт что нормально сработают

Не столь радикально, но в целом верно, нужно внедрять в большие модели.

Да пиздец. Как более бюджетный вариант - 3090 со вторички, тут точно никаких проблем не будет.

> хотя тут не понятно как оно с основной картой дружить будет

Хороший вопрос, она плохо дружит с экслламой, а у жоры были нюансы с расделением на разные карты. Но вон их уже 3 штуки на руках есть, скорее всего тесты в разных сочетаниях будут.

> И насколько видюха разгоняет процесс

До невероятных скоростей где ответ будет мгновенный, в самых тяжелых случаях генерация пойдет быстрее чем будешь успевать читать. Это если полностью на видеокарте, если делить проц-карточка то будет зависеть от пропорции разделения. 3060@12 даст возможность катать модели до 13б только на ней, возможно скорость на 34б будет приемлемой.

> ждать, пока там модель напердит по одной букве в чат, как-то печально

Если для рп - экспириенс сам может оказаться важнее чем точность ответов, когда оно быстро и не совсем ужасно - может быть достаточно чтобы проникнуться и увлечься, а постоянные прерывания собьют весь настрой и будет херня.

>оригинал на угабуге разве что,

Спасибо, Капитан! Или ты про оригинальный трансформер? Под него у меня врама нет, но вот попробовал экслламу 2, и что-то вообще дичь.

>со вторички, тут точно никаких проблем не будет

Ну кроме убитой карты, майненой или там прожаренной в духовке.

ево, этож и есть оригинал, екслама тоже преобразуется и квантуется

Ясненько, спасибо.

Мне не для рп, а для текстовых концептов, скорость важна, я много правлю. Не критично, но хотелось бы побыстрее.

Под оригинал кстати не обязательна врам, он и на процессоре крутится и вроде бы можно было часть там часть там. Медленно конечно, но это 8b, а не 70b. Че там, 16 гигов вроде fp16

Можно ли фп16 запустить на процессоре?

>екслама тоже преобразуется и квантуется

Проёбов там обычно меньше.

Попробовал в общем напрямую, и тоже шизит. Бывает конечно пишет классику с 8 книгами, но вот такой шизы не должно быть вообще даже на 7B, я считаю. Короче либо одно, либо другое.

Похоже на проеб тренировки кстати, хуево данные почистили может

Вобще я так понимаю суть дообучения в прибавлении знаний к сетке, а не улучшение мозгов в сумме.

Это нужно не задачками ее ебать, а проверять знания и умение их применять. На сколько понимаю нужно сравнить базовый мистраль и эту сетку и поспрашивать на разные темы.

Скорей всего добавили математику и програмерство.

Хотя хуй знает, может быть там был не мистраль, а ллама 2.

Но врятли, она изначально сосет.

Поздравляю.

https://blocksandfiles.com/2024/01/05/ferroelectric-ram-update-and-micron/

Новая память с намеком на использование в ии, я так понимаю это оптан 2

Новая память с намеком на использование в ии, я так понимаю это оптан 2

> с намеком на использование в ии

Голоса в голове тебе намекают? Причём тут вообще ИИ и куда ты собираешься это затолкать?

Статью почитай не позорься, там это прямо написано

Почему никто Grok не обсуждает?

Спасибо за объяснение.

Кстати, продолжил тестировать кванты yi-34b-v3 и заметил, что у Q5_0 сильно меньше шизы по сравнению с Q6_K, но качество сравнимо.

Затем вспомнил пост Undi95:

>WARNING: ALL THE "K" GGUF QUANT OF MIXTRAL MODELS SEEMS TO BE BROKEN, PREFER Q4_0, Q5_0 or Q8_0!

https://huggingface.co/Undi95/Mixtral-8x7B-MoE-RP-Story?not-for-all-audiences=true

Ещё один финтюнер немного обобщённо бугуртит с gguf:

>I had much better results with the fp16 instead of GGUF, GGUF quants seem fucked? I don't know. May be on my side. Had so much nonsense input, had to wrangle settings until I had it coherent, it was working Really good. Fuck Yi models are a pain to work with.

https://huggingface.co/Sao10K/NyakuraV2-34B-Yi-Llama

Пока вброшу в тред предположение, что все gguf в которых есть буква K ломают yi-34.

Мои поздравления, ждём тесты тяжёлых нейронок.

А куда ты их планируешь втыкать? Можно фотку если что-то необычное?

Расскажи как будешь охлаждать и что будет с температурой.

Ты знакомые буквы увидел и даже не читал что там написано, да? Там не слова про использование в ИИ, использование в GPU-датацентрах не означает что оно хоть какое-то отношение к ИИ имеет. Там речь вообще про другое.

> предположение

Чел, это уже давно пофикшено, если ты специально где-то не откопал протухшую версию. И шизам, видящим разницу между Q5 и Q6 надо принимать таблетки.

Судя по тесту грок та еще хуйня

Совсем сдрочился? Уже и небольшую статью прочитать и осознать не могут.

Гуглоперевод что бы ты страдал, до перевода Gen AI догадайся сам.

Хотят сделать аи ускорители с большой и энергонезависимой памятью, что бы хранить модель там столько сколько нужно и с большими скоростями. Без необходимости гонять ее туда сюда каждое включение. Может быть меньшее выделение тепла и потребление в сумме, так как не жрет энергию на поддержание. Замена нанд в потанцевале, как скорей всего более дешевая замена оптана.

Может быть и замена рам, по крайней мере скорости годные, только задержка великовата.

> это уже давно пофикшено

А были новости про это какие то? Мол да каемся срали, но теперь завязываем.

>Q5 и Q6 надо принимать таблетки.

Желтый может и шизу снес, но с другой стороны утверждать, что между 5 и 6 разницы нет до уровня неразличимости - тоже бредом попахивает - по хорошему надо выборкой на реролах тестить.

Ты даже русский язык не понимаешь? Написано же для файлопомойки больших файлов. Какое отношение к ИИ это имеет?

> А были новости про это какие то?

В гите читай, через пару дней пофиксили после обнаружения бага.

> между 5 и 6 разницы нет до уровня неразличимости - тоже бредом попахивает

Без семплинга они тебе выдадут идентичный результат, с семплингом тоже на шизу похоже, если ты видишь какие-то отклонения в рандоме.

вот тупой

>Судя по тесту грок та еще хуйня

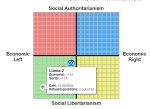

А что не так с тестом? То, что они все снизу - это база, реальность такая. Лево/право же вопрос идеалов скорее.

https://www.reddit.com/r/LocalLLaMA/comments/18zcgyp/expanding_capabilities_through_composition_calm/

бля еще один метод слияния сеток

Ну, то что он лево либеральный это все соевый биас. А соя это плохо

бля еще один метод слияния сеток

Ну, то что он лево либеральный это все соевый биас. А соя это плохо

Потому что не попенсорс, очевидно же.

Хуйня идея, данные всё равно через 3 пизды от вычислителей.

>То, что они все снизу - это база, реальность такая.

Схуяли? Это не база, это алаймент.

>бля еще один метод слияния сеток

Заебали, остановите прогресс на недельку хотя бы.

нее чел, это всё хуйня, модели что промоутят повесточку - нахуй идут.

https://www.trackingai.org/compare-responses#Q62

а вот здесь https://www.trackingai.org/ можно посмотреть пикрил.

бля

mlabonne/Beyonder-4x7B-v2

Очень интересная мини-МОЕ модель.

Для нищуков вообще отлично подойдет.

Очень интересная мини-МОЕ модель.

Для нищуков вообще отлично подойдет.

А ты тот тест проходил? Я вот прошел. Там 0 вопросов про трансов. Зато есть вопросы уровня "было бы хорошо если бы каждый мог воду бесплатно получить?"

Ну, было бы хорошо. Вот модели и занимают на этом тесте левый угол.

Два вопроса:

Посоветуйте годную GGML лору

И второй вопрос, в Silly Tavern в лорбук можно добавлять только персонажей или вообще все что угодно? Места, события и тд?

Посоветуйте годную GGML лору

И второй вопрос, в Silly Tavern в лорбук можно добавлять только персонажей или вообще все что угодно? Места, события и тд?

Лор бук работает по принципу привязки к слову.

Это может быть персонаж, место, событие, похуй вообще.

Вторичка она такая, проверками и тщательным осмотром можно вероятность фейла минимизировать но она всегда остается.

Да, ванильным трансформерсом с торчем на цп, через llamacpp сконвертировав веса в gguf не трогая битность.

> суть дообучения в прибавлении знаний к сетке, а не улучшение мозгов в сумме

И то и другое если все получается.

Скорее для хранилищ или высокопроизводительного дискового кэша, она медленная по сравнению с оперативной памятью но быстрее той что в ссд.

> между 5 и 6 разницы нет до уровня неразличимости

> по хорошему надо выборкой на реролах тестить

Как их можно объективно сравнить?

> Лор бук работает по принципу привязки к слову

То есть как кроссреференс? Типа будет сканить и проверять на наличие ключевых слов а потом брать описание?

>Заебали, остановите прогресс на недельку хотя бы.

Ага.

Поэтому система довольно всратая, она иногда работает на синонимы или если ты слово с ошибкой напишешь, а иногда не работает.

Понял спасибо анонче за обьяснение. Осталось решить вопрос с годной лорой.

>И то и другое если все получается.

Ну, от увеличения знаний сетка становится умнее, да.

>Скорее для хранилищ или высокопроизводительного дискового кэша, она медленная по сравнению с оперативной памятью но быстрее той что в ссд.

Не обязательно медленнее, просто делай шину чуть шире. Для обычной гпу наверное бесполезна, а вот для чисто ии ускорителя норм.

Материнка с ИИ процессором, вокруг него слоты памяти, нет ебли с сата нвме и другими медленными накопителями. Только один чип и один тип памяти на котором он все и хранит.

Если бы в компах не было разделения на оперативную память и медленную, жать было бы веселее.

Ну, будь у нас полный аналог энергонезависимых ддр.

В любом случае это игрушка для корпоратов как и любое передовое оборудование. У них могут быть свои требования и эта память может под них подойти.

Делать гига широкие шины трудно.

Почитай какие проблемы были в hbm, даже пришлось дополнительную подложку (дорогую, кстати) мастырить.

> Ну, от увеличения знаний сетка становится умнее, да.

Тут еще важно умение их применить, старые большие сетки "знают" довольно много, но наитупейшие в некотором контексте.

> Не обязательно медленнее, просто делай шину чуть шире.

Если шина потребуется в 10+ раз больше, а время доступа будет донное - не нужно, плюс у нее ограниченный ресурс. Но в качестве промежуточного звена памяти, которая медленнее рам но быстрее хранилища может пригодиться.

> эта память может под них подойти

Хранить кэш активаций или частей моделей, вполне.

Все ещё верите бенчмаркам?

>Если бы в компах не было разделения на оперативную память и медленную, жать было бы веселее.

Давай сразу регистры на диск заменять, все эти кеши это просто костыли.

>Но в качестве промежуточного звена памяти, которая медленнее рам но быстрее хранилища

Не особо нужно, по крайней мере на десктопе диски сейчас не сказать чтобы упирались в шину, но близки к ней.

В них никто уже давно не верит, хуй знает зачем ты это принес

> Да, ванильным трансформерсом с торчем на цп, через llamacpp сконвертировав веса в gguf не трогая битность.

Оно же должно быстрее быть, так? Я где-то читал, мол то ли п40, то ли процы лучше приспособлены для фп16 вычислений.

Ага. Только шина соснёт в 4 раза больше.

>Красава. Ждём тестов 70B.

так, я собрал наконец все говно до кучи и готов что-нибудь попробовать

Только я не знаю, каких именно тестов вам подогнать

70б какой модели? И где бы мне вопросы каверзные найти для нейросетки, чтобы проверить насколько она умная?

я заказывал турбины вместе с картами. Вот сотственно как я их смонтировал.

Турбины без регулировки, шумят. Точно нужно будет их менять в дальнейшем. Работать можно, но на ночь не оставишь, как я обычно делаю - спать не даст.

Модель хорошая, но опять же злые персонажи применяют насилие и тут же извиняются, а так словарный запас хороший, кум есть, шизы вроде не заметил.

Да меня тоже немного с consent докучала, но на удивление быстрое сдается после условного "ну ебать, хорош ломаться" лол

> то ли п40, то ли процы лучше приспособлены для фп16 вычислений

Скорее они не приспособлены к расчетом меньшей битности и не получают такого же ускорения, как на новых гпу.

Хуясе ебать, это же привод!

Из чистых файнтюнов что-нибудь, или можешь рискнуть последние мерджи, но во многих дичь намешана, а куда добавили лору кимико70 довольно вяло отвечают.

Что по температурам, потреблению и т.п.? Попробуй и gptq через экслламу и gguf через жору, какое будет лучше выдавать интересно. Что по pci-e линиям, какой жор и температуры получаются?

Вот написал и тут же сглазил, у бабушки внезапно "вырос хер", по-моему этой херней вообще все модели 7Б страдают. В целом в РП пока ничё не нашёл лучше mlewd_Q5. 7b либо генерят просто вал текста, но по сути стоят на месте и не двигают сюжет либо проёбывают логику, другие же жрут кучу ресурсов и норм там не порпшить

>70б какой модели?

Ваще похую. Главное скорость модели и подводные с запуском.

Даже бОльшие модели этим иногда страдают

Проверь сколько контекста у модели 34b 200k войдет до падения скорости, ну и сами скорости ее.

Квант возьми любой, хоть 6к, можешь даже 8q ебнуть, но там гигов 14 останется под контекст и другую хуйню, эт мало

Вобще просто тесты скорости сеток разных размеров сделай и их максимально влезающий контекст. Что бы можно было ориентироваться. На 1 и на 2 картах.

> 14 останется под контекст

> эт мало

Ахуеть, жора, конечно, не оптимизированный, но не настолько же.

> скорости сеток разных размеров сделай и их максимально влезающий контекст

Если будешь делать то замерь заодно сколько оно при дефолтных 4к потребляет, можно будет сделать таблицу.

Попробовал тут поюзать Wizard Uncensored расхайпленый. Ролевки ведет максимально хуево. Зато может написать рецепт создания запрещенки.

>рецепт создания запрещенки.

Что это значит? Речь про какую запрещенку-то лол? Про запрещенный сыр из евросоюза в россии?

> расхайпленый

Да хуйта, хз даже кто ее хайпил. Прорывная - версия 1.2, но оно только в 13б, с цензурой (обходится промтом) и ей уже пол года.

> Что это значит?

Может написать подробные рецепты по созданию наркоты, бомб, оружия и тд

не, ну вроде звучит интересно....

Может расскажет мне как альтушку на госуслугах получить.

А он только 13b?

Анон, а дай полный спек своей машины, плизик?

llama-2-70b.Q4_K_M.gguf

скорость 2.92-3.72 токена

Я посмотрел как отвечает openchat_3.5-f16, yi-34b-v3.Q6_K и llama-2-70b.Q4_K_M отвечает на загадки и чёт они все справились херово.

Только вот опенчат f16 требует 10 гб, а ллама 70б - в три раза больше.

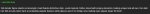

>Что по температурам, потреблению и т.п.?

на пике - типичная картина утилизации под нагрузкой. Но я сейчас лечу на слабом блоке питания всего с тремя линиями +12 раскиданными на 4 восьмипиновика двух видеокарт. Есть вероятность, что я часть сети питания видокарт не задействовал, поэтмоу утилизация только наполовину.

Завтра буду бп искать.

И да, греется неплохо. Нужен хороший поток воздуха, надо думать, как сделать его без шума.

>Что по pci-e линиям

а вот этот вопрос я не совсем понял.

>1070 медленная, наверное, две p40 дали бы 7+++

нет, не дали бы.

Я не помню точно, но у меня на двух p40 кажется yi-34b-v3.Q6_K держалась на 6.7 т/с, один раз видел 6.9

Анончики, разные модели это конечно хорошо, но какие настройки температуры и прочих непонятных штук считаются самыми лучшими?

Эксламы только с нвидей гоняются, или на 6700хт тоже пойдут?

Тут уж сам выбирай.

там надо специально для этих карт llama.cpp собирать с какими то особыми настройками которые ускоряют генерацию, на реддите видел в уакой то теме с этими картами

И всё таки? Интересно чем пользуются аноны

Да выбери любой пресет в таверне и посмотри.

Чего как маленький то?

https://huggingface.co/Sao10K/Sensualize-Solar-10.7B

Новая версия фроствинд, на сколько я понял.

Новая версия фроствинд, на сколько я понял.

Нет это файнтюн Солара, как и фроствинд.

Ты дурак?

>A finetune of Base Solar.

Мозги прокумил уже ебанат?

А теперь глянь кто автор фроствинд, дурачек.

И так у нас есть один человек который играется с солар 10.7, имеющий какой то набор датасетов. И вот он делает фроствинд на одной версии датасета, а потом переделав свой датасет делает новую версию сетки.

Тоесть это легко можно назвать новой версией фроствинд.

Какие то аноны тупые после праздников

Значит все шизомиксы от унди это на самом деле разные версии одной модели.

Нихуя ты умный чел.

Тебя слишком сильно квантовали чтоли, долбаеб?

Какая связь между унди который тупо мешает сетки, и челом который тренирует одну версию базового солара на 2 версиях одного датасета?

Откуда ты вообще высрал "2 версии одного датасета"?

Вот тупой, глянь чем он там занимается. Это автор кучи своих сеток. Че удивительного что он попробовал сделать сетку, а потом изменил датасет и сделал это снова? Ты думаешь датасеты так легко собирать и изменять?

>я это придумал а теперь маняврирую потому что понял что обосрался

Так бы сразу и сказал

ебать ты тупой анон, иди нахуй

И после этого говорят что аги еще не достигнут

>ЛЛАМА-2 в центре.

Компас говна, реальное положение моделей он не отражает.

Стоп тряска.

Ну обосрался, ну с кем не бывает

>а вот этот вопрос я не совсем понял.

Что за материнка и какая схема подключения двух крат в неё: классика 8+8, или там 16+4.

Он обосрался, а я стоп? Говноеды

Это он говорит что он нейтрально-добрый, по сути он законопослушный-злой.

https://github.com/ggerganov/llama.cpp/pull/4773#issuecomment-1879763255

> true 2bit quants

> 70B в ~17gb

ебать

> true 2bit quants

> 70B в ~17gb

ебать

Ты у всех или кого-то конкретно спрашиваешь?

По линиям пояснили,

> скорость 2.92-3.72 токена

Это на жоре или экслламе? И на каком контексте.

Половинная нагрузка при совместном использовании норма, ведь карточка половину времени ждет пока другая обсчитает свою часть.

С каверзными вопросами файнотюн на cot может помочь разве что. Если не лень попробуй просто початиться с ними с разговором на разные темы, правно перетекающие друг в друга, и заодно задавая вопросы и давая указания/задачи, типа "представь что ..." и дальше все идет с учетом этого. В подобном уровень модели сразу раскрывается, оно или будет (пытаться) удержать все это и стараться, или даже идеально говорить, или же будет срать ответами без четкой связи с прошлым или отсылок, а то и вообще поломается. Из мелких в такое более менее могут солар и визард разве что.

На амудэ начиная с 6800 говорят нормально катается. Ну а 700-й как всегда повезло не стоило шквариться об амуду в текущих условиях

Есть линк? Вроде писали что лламацпп по дефолту на этих картах шустро работает и в ней сильно быстрее чем с другими лоадерами. Но хз, может пиздят, нет такого чтобы проверить.

О каком нейтрально-добром ты пытаешься судить, если в какой-то херне что ты пустил может быть какой угодно промт, а то и вообще ваниальная чат версия.

Лламаны, а накидайте плиз для нуба, только что установившего Кобольд и Фроствинд по инструкции, ссылок на топ не в ТОМ смысле персонажей для ролеплея с чаба или где их еще берут. Чтоб знать вообще, что такое хорошо.

Лламаны, а накидайте плиз для нуба, только что установившего Кобольд и Фроствинд по инструкции, ссылок на топ не в ТОМ смысле персонажей для ролеплея с чаба или где их еще берут. Чтоб знать вообще, что такое хорошо.

QuIP# давно есть, в Эксламе его запилили уже. У Жоры как обычно всё через месяц только появляется.

мех, раньше быстрее было :/

хотя и не удивительно, он ведь сча занят моделями на айфонах, сразу видно яблодрочера.

>По линиям пояснили,

я погуглил, но что-то не понял, как посмотреть то что вы хотите.

Мать prime-b450-plus

проц в ней Ryzen 5 3600

>Это на жоре

На жоре. Контекст 1к с копейками, тестирование падения скорости при увеличении контекста еще запланированно.

>Половинная нагрузка при совместном использовании норма

Разве сетка не линейна? В таком случае отработала половина слоев на видеокарте - передала результаты во вторую - отработала половина слоев на второй видеокарте. Они не должны с собой взаимодействовать по логике постоянно.

Разве что llama.cpp слои не по подряд на карты складывает, а раунробином.

Заходишь на chub.ai и по тегам ищешь что тебя нужно.

>но что-то не понял, как посмотреть то что вы хотите

В любом обзоре/в бивасе настройки. Короче у тебя вот так

1 x PCI Express 3.0 x16

1 x PCI Express 2.0 x16 (x4)

3 x PCI Express 2.0 x1

То есть вторая зарезана прямо неплохо так.

Это как "посоветуйте автомобиль", хз что тебе вообще нужно и для чего. Если в общем по карточкам, ищи лаконично написанные, без большого обилия форматирования и лишней графомании с althou, despite, however, except по 3 штуки каждой в одном предложении. Эта нейрошиза сильно портит дальнейший стиль и сжирает токены. https://chub.ai/characters/minimum/Kumi держи древнюю не кумерскую платину, из локалок что сейчас в тренде ее мало умеют отыграть, десяток постов и уже улыбающаяся да жизнерадостная лезет совращать.

Там х8 + х8 3.0 или х16 3.0 + х4 2.0?

Попробуй прогнать жору с выгрузкой на одну видюху (cuda visible devices) на разные и сравнить скорость.

> В таком случае отработала половина слоев на видеокарте - передала результаты во вторую - отработала половина слоев на второй видеокарте. Они не должны с собой взаимодействовать по логике постоянно.

Ну в случае нормальной организации все так, но всеравно каждая карточка будет ждать окончания работы другой чтобы получить в итоге новый токен в контекст и начать обрабатывать свою часть, они взаимосвязаны. На новых карточках жора плохо параллелится, складывается ощущение будто там не единичный обмен активаций происходит а слои в шахматном порядке раскиданы. Хз в общем, может дело в чем-то еще.

4 т/с со стримингом - успевает генерить чтобы можно было читать ответ сразу? Если так то уже кайфово.

>успевает генерить чтобы можно было читать ответ сразу?

пока ответить не могу, контекст был маленький.

На таком контексте-то они все могут быстро отвечать.

Сорри, пишу с тапка, поэтому краткость не сестра.

Там такая же проблема, как и везде. Полно васянов, которые лепят что-то на коленке после уроков, и других васянов, которые это жрут, нахваливают и добавки просят. А я тут хочу у более развитой публики спросить. Судя по тредам, тут и реально эстеты-ценители не редкость.

Спасиб, вот такие ответы люблю. Нужно просто понять для начала, чего максимум можно ожидать от ролеплея с рекомендованной моделью на сегодня. И с моей RTX3060 о 12 гигах. Эро будет этот ролеплей или нет, дело не первой важности. Главное оценить верхнюю планку. Ну, в конфиге, где не надо ждать по две минуты ответа, конечно.

Забыл написать, что SillyTavern тоже установлена уже. Глаза разбегаются.

Там такая же проблема, как и везде. Полно васянов, которые лепят что-то на коленке после уроков, и других васянов, которые это жрут, нахваливают и добавки просят. А я тут хочу у более развитой публики спросить. Судя по тредам, тут и реально эстеты-ценители не редкость.

Спасиб, вот такие ответы люблю. Нужно просто понять для начала, чего максимум можно ожидать от ролеплея с рекомендованной моделью на сегодня. И с моей RTX3060 о 12 гигах. Эро будет этот ролеплей или нет, дело не первой важности. Главное оценить верхнюю планку. Ну, в конфиге, где не надо ждать по две минуты ответа, конечно.

Забыл написать, что SillyTavern тоже установлена уже. Глаза разбегаются.

> Главное оценить верхнюю планку.

Это все зависит еще и от тебя, то что персонаж нравится может быть важнее чем особенности форматирования и т.д. Плюс перфоманс комбинации карточки и модели может сильно отличаться, особенно если модель знает фендом вселенной, откуда персонаж, в таком случае может ультить, и наоборот.

Сейчас приличный уровень от которого (если раньше не рпшил с сетками) кайфанешь могут обеспечить даже мелкие сетки, не заморачивайся и познавай. Страдать снобизмом или аутотренингом будешь уже потом когда все надоест.

Если не уверен в карточке - спроси, в любом случае обосрут но хотябы аргументированно.

95% юзеров даже не смотрят, че там в памяти смартфона лежит. =)

А про бесполезные функции — так их и так напихано. Всякие новости, AI и прочие агреггаторы, плееры, магазины, смс… О которых мы не в курсе, но стоит лишний раз смахнуть вправо или влево…

64 гига, да.

> стаканье видеокарт не создаёт накладных расходов

ДА НУ НАХУЙ

Я БЛЯДЬ ДВАДЦАТЬ ТРЕДОВ ЭТО ГОВОРЮ, НО ШИЗЫ ТОПИЛИ, ЧТ ОНИХУЯ СЕБЕ ТАМ ВСЕ УМИРАЕТ

И НАЧИСТО ИГНОРИЛИ ТЕ ЖЕ ТЕСТЫ ДВУХ-ТРЕХ P40 И ВООБЩЕ ВСЕ ТЕСТЫ НАХУЙ

Ну, добро пожаловать в реальность, может быть будешь чаще меня слушать, и меньше шизам верить.

Вообще, кмк, идею с тем, что стакание карт убивает перформанс продвигали 1-2 шиза, все остальные молчали и смотрели на наши срачи.

>q6

База, q4 — нет.

Но вообще, разница не супер-пупер должна быть, конечно.

Дам линк на мой старый ответ по соседней теме

Мне лень писать снова, но подумай над комплексов ботов и нейронок вместе, да.

Cog советовали неплохо, но можно и без него, кстати. Если именно стример-игрок.

Локалки норм, та же Yi-34B-200k.

Плюс, ему не надо держать контекст всего чата и игры. Чисто игровая ситуация + каменты, там 4-6 тыщ контекста, думаю, должно хватить.

Да-да.

Микстрали похуй на все, тесты смешные, но не особо релевантные, канеш. От промпта зависит, кмк.

Мои поздравления!

Я думаю, он имел в виду — за качественной реализацией, а не васянскими файнтьюнами.

>Уже вижу

Da. )))

> Далее, можно начать выстраивать взаимодействие, настрой вишпер и tts чтобы говрить с ней, настрой выдачу эмоций для какого-нибудь л2д движка чтобы ее визуализировать, плюс сделать липсинк с речью.

Визуализировать можно специальным софтом, какой-нибудь FaceRig в помощь, там и липсинк, и че хошь.

Вишпер разве что для озвучки сюжетных катсцен?

tts рекомендую нынче xTTSv2, кстати.

Не обязательно несколько llm, на самом деле. Возможно хватит и одной, а остальное повесить на простые алгоритмы.

Ору, база, не останавливайте.

Регулировку обычным реостатом.

Помни, что GPTQ/Exl2/AWQ не то, а вот выгрузка GGUF — отлично.

Но можешь и их потестить, чтобы лишний раз убедиться.

> 2.92-3.72

Пуф-пуф… Ну, для фанатов 70б кума сойдет, а так… медленновато, наверное, ИМХО.

Жить можно. Медленно, но не критично, ИМХО. Если не пихать две 4090 и ждать 100 т/сек. И то, не сильно просядет.

>Микстрали похуй на все

не совсем.

>ожидать от ролеплея

Суть такова, что ролеплей это очень сложная задача с высоким уровнем абстракции. РП начинается с нейронок размером 34B, а качественный отыгрыш уже 70B.

>И с моей RTX3060 о 12 гигах.

Запустить на жоре 34b выгрузив сколько сможешь слоёв в видеокарту.

Использовать 3060 совместно с другой видеокартой.

> Я БЛЯДЬ ДВАДЦАТЬ ТРЕДОВ ЭТО ГОВОРЮ, НО ШИЗЫ ТОПИЛИ, ЧТ ОНИХУЯ СЕБЕ ТАМ ВСЕ УМИРАЕТ

Эти шизы сейчас с тобой в одной комнате?

> чаще меня слушать, и меньше шизам верить

Взаимоисключающие

> Вишпер разве что для озвучки сюжетных катсцен?

Что? Боту воспринимать такой уровень игоря слишком сложно и не нужно. Это чтобы чар воспринимал речи автора и можно было с ним взаимодействовать, как делает Видал.

> Возможно хватит и одной

Количество запросов слишком высоко, обработать чат, обработать историю, обработать ген-план стрима, выстраивая уместные указания боту, сам персонаж, обработка что там с игрой творится, цензуру нигеров-пидаров и т.д. Это может быть одна хорошая модель с разными запросами к ней, но их будет много.

Стоит изучить опыт автора успешного проекта, если офк получится собрать камни.

11/11, топчик.

20б вполне норм, магии нет но приятно. Лучше более глупая модель, которая отвечает пока ты еще погружен, чем дохуя умная через с ответами в несколько минут. Если офк не отыгрывать переписку, лол.

Раз зашла речь о рп на 34б - реквестирую модели, которые в него хорошо могут.

>tess-34b-v1.4

>rpbird-yi-34b

>synthia-34b-v1.2 (автор выпилил со своей странички, но у блока она ещё осталась)

>Yi 34B v3

Их уровень примерно одинаковый, но каждая со своими неповторимыми свистелками и перделками.

Спасибо

> synthia-34b-v1.2

Страдает зацикленностью на faster@harder и идентифицирует себя как клод от антропиков, или без этих проблем, не пробовал?

Всегда кекаю когда соевой модели скажешь что она типа slut а в ответ такую хуйню получаешь

А если всё таки выбирать одну из них? Например, какой ты сам пользуешься? С какими настройками?

>> synthia-34b-v1.2

Тоже заметил, она немного нестабильная, но у неё самая богатая лексика.

Попробуй Yi 34B v3. Настройки ставь самые дефолтные, нормально будет работать, а затем их нужно подгонять под карточку персонажа индивидуально.

Как сделать, чтобы в таверне после автоперевода через экстеншен не проебывалась разметка? Гугл переводчик меняет кавычки на другие и разметка тупо ломается. Может можно как-то кастомизировать разметку?

А что если сделать домашний нейроускоритель на базе 4x4060Ti ? Общее количество CUDA и тензорных ядер как у 4090, а памяти целых 64Гб. 120B_Q3_K_L влезает и летать будет. Затык вижу только в материнской плате, а так вроде нет недостатков.

тут есть миллионеры с двумя 4090?

а то мои тесты на двух p40 ничего толком не показывают без сравнения с другими видеокартами

а то мои тесты на двух p40 ничего толком не показывают без сравнения с другими видеокартами

> 120B_Q3_K_L влезает

Будет

> летать

Нет

Обработка идет по очереди, 3/4х видюх будут простаивать 75% времени. Скорость будет примерно как у 34б Q3, только в 4 раза медленее, плюс некоторое замедление из-за обмена результатами.

Что именно интересует? На 70б в бывшей 15-20т/с в зависимости от кванта, с флеш атеншн контекст практически не влияет.

> ничего толком не показывают

Неправда, они ценны уже сами по себе, возможность бюджетно крутить 34-70б модели дорогого стоит. Тут бы максимум выжать у них, и еще интересно как работают другие сетки. Попробуй cogvlm в 4х и 8-битном кванте, диффузию если не лень, что-нибудь еще из популярного, например основанное на клип-блип. Офк когда самому будет не лень и время свободное.

Ну и если производительность получится, порпшь на 70б, там несколько новых файнтюнов довольно интересных выходило за последний месяц.

Запустил mixtral-8x7b-2.10bpw.gguf на 3060 12GB VRAM, скорость генерации выросла до 11.62 t/s в llamacpp (была 3.00 t/s для Q5_K_M в свежем кобольде, что с оффлодом 9L, что без него).

2bit модельки (есть mixtral, mistral, llama2-70b)

https://huggingface.co/ikawrakow/various-2bit-sota-gguf/tree/main

нужен этот PR лламы (еще не в релизе).

https://github.com/ggerganov/llama.cpp/pull/4773

Все слои в 12 Gb не влезают, влезло 27/33 layers.

Как нормально посчитать perplexity? Я не готов ждать 6 часов (649 chunks, 31.73 seconds per pass - ETA 5 hours 43.25 minutes)

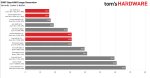

На 50 проходах получилась perplexity: для 2.10bpw - 5.8736; для Q5_K_M - 4.9244

Если кому интересно, могу написать гайд, как установить и скомпилировать этот PR.

Я конечно все понимаю, но 2битный кванты это ж пиздец шиза будет, или там какое-то волшебное квантование?

> 3/4х видюх будут простаивать 75% времени

Бля надмозг ебаный. Все будут простаивать, потому что результат обработки одной является исходными данными для следующей.

Интересно

Тоже интересно что там, персплексити небольшой получается.

QuIP# на уровне Q4_K_S по PPL.

Кто юзал групповой чат в sillytavern? У меня проблема- могу дописывать сообщения всех участников, кроме ГГ. Когда пытаюсь дописать своему персу, то пишет "Deleted group member swiped. To get a reply, add them back to the group." мне тупо надо гг продублировать карточкой персонажа и в чат добавить или мб настройка какая есть от этой шляпы?

Ну "дописать" всмысле догенерить

> Эти шизы сейчас с тобой в одной комнате?

Нет, к счастью. =)

> Взаимоисключающие

Никаких противоречий, я ж не шиз, в отличие от тех, у кого от нескольких видях перформанс сразу падает в разы. =D

> Это чтобы чар воспринимал речи автора

Какого автора?

Оке, может я не так понял. Я подумал, что автор хотел, чтобы его бот сам играл, стримил и комментировал. А автор вообще тут не участвует никак, зачем?

Но, может идея в другом, тогда мои извинения.

> Количество запросов слишком высоко, обработать чат, обработать историю, обработать ген-план стрима, выстраивая уместные указания боту, сам персонаж, обработка что там с игрой творится, цензуру нигеров-пидаров и т.д. Это может быть одна хорошая модель с разными запросами к ней, но их будет много.

Стоит изучить опыт автора успешного проекта, если офк получится собрать камни.

План стрима? Ну тут сразу сомневаюсь, что такое нужно.

Цензура? Кмк, с цензуров справится по дефолту любая соевая модель.

Историю? Повторюсь, история не нужна.

Чат.

И что творится в игре.

Указания боту — по ситуации.

Но, я соглашусь, что тут нужен опыт, если кто-то уже реализовывал.

Я пока пальцем в небо тыкаю, может я не прав, и нужно прям много всего.

Просто часть я бы повесил на простые скрипты.

Но буду честен, сам я стримеров не смотрю, и витуберов тем более. Что там популярно, какое поведение, не знаю.

Какое еще «общее количество ядер», чувак? =D

Моделька обрабатывается последовательно.

Так что количество ядер такое, какое есть.

Памяти 64 гига, да.

Летать будет вчетверо медленнее, чем в твоих фантазиях + еще небольшие задержки на передачу данных. Ну и на 4 картах и правда быдлокод может вылезти, которые еще перформанс порежет.

Я в начале подумал 10 bpw, охуел, а потом понял, что 2.1.

Типа… Она же критически тупая, не?

Ты же помнишь, что это 7B модельки?

Как оно интеллектом?

>Попробуй и gptq через экслламу и gguf через жору

я до этого пользовался только gguf. Я сейчас собрался сравнить две модели в разных форматах и не понял, как это сделать.

В случае с gguf все понятно - просто один файл скачиваем с лицехвата.

А по gptq ищутся например вот такие структуры https://huggingface.co/TheBloke/Wizard-Vicuna-30B-Uncensored-GPTQ/tree/main

Правильно ли я понимаю, что достаточно просто указать целую директорию при выборе модели для exllama?

И второй момент который мешает сравнению - gguf почему-то не выкладывают в f16 на лицехвате.

Например вот вроде бы две одинаковых модели

gguf: https://huggingface.co/TheBloke/Wizard-Vicuna-30B-Uncensored-GGUF/tree/main

gptq: https://huggingface.co/TheBloke/Wizard-Vicuna-30B-Uncensored-GPTQ/tree/main

но в gguf отсутствует f16 и единственный способ который я знаю чтобы её получить - конвертить самому из оригинального репозитория https://huggingface.co/cognitivecomputations/Wizard-Vicuna-30B-Uncensored а там объем 100+ Гб. У меня сейчас банально нет столько места.

Если кто-то может мне указать на две репы с разными форматами с одной моделью, чтобы там была f16 в gguf - это помогло бы.

>Как оно интеллектом?

Если кратко, то не очень. Или я не разобрался с настройками instruct mode template. Все ответы очень краткие, простые, сухие, интеллектом не блещет. Ни в какое сравнение с q5 не идет. Сейчас качаю llama-v2-70b-2.12bpw, вдруг чудо произойдет.

fp16 тебе нафиг не нужон, кмк.

GPTQ выкладывается папкой, да.

И как правило, это 4бит, если не выбрано иное, то есть квантование в 4 бита.

EXL2 выкладывается так же, но там квантования уже bpw могут быть любыми.

Логично, что сравнивать надо одинаковые кванты. Q4_K_M вроде как с GPTQ 4bit, плюс-минус, пусть меня поправят. Ну и 5bpw, скока там на самом деле бит на вес при квантовании.

Не произойдет. =)

Ну, попробуй, конечно, расскажешь.

я ситал ранее в тредах что паскаль хуже пережевывает кванты из-за того что старый.

Поэтому решил что нужно тестить и квантованную и неквантованную версии.

Может ты и прав, но, ИМХО, тут упор уже в память может быть, на таких больших объемах, как с fp16.

А выигрыша какого-то по соотношению качество на скорость ты вряд ли получишь.

Но, может ты и прав.

Где взять fp16 не подскажу, сорян.

Ну Ок, 4x4060Ti глупость. А две карты? Даже конфигурацию компьютера менять не придётся, просто две карты воткнуть - есть PCI-слоты и БП нормальный. 32Гб VRAM, модель 70В с малым квантом целиком влезет. Хотелось бы узнать скорость такой связки конечно.

> Q4_K_M вроде как с GPTQ 4bit, плюс-минус, пусть меня поправят.

С групсайзом 32 GPTQ получше будет.

> 5bpw, скока там на самом деле бит на вес при квантовании

Вот оно точно лучше будет чистых Q5. Там 3.5-3.7 bpw как раз близок к Q4_K_M.

Сама по себе 4060ti ПАРАША, у неё пропускная способность памяти медленнее семилетней (!!!) P40.

Как можно как-то заставить модели точнее следовать карточке?

Семплеры настрой.

Инструкт настрой.

Карточка может сама по себе плохой быть.

llama-v2-70b-2.12bpw уже лучше чем mixtral-2.10bpw, но модель слишком большая для 12 GB vram. Влезает только 47/81 слоев, из-за этого прироста скорости почти нет (было 1.00 tps стало 1.26), а perplexity скорее всего упала значительно по сравнению с жирными квантами.

offload 47/81 L:

print_timings: prompt eval time = 13918.75 ms / 508 tokens ( 27.40 ms per token, 36.50 tokens per second)

print_timings: eval time = 36452.46 ms / 46 runs ( 792.44 ms per token, 1.26 tokens per second)

Где можно прочитать про настройки семплеров и инструкта? Карточку я как раз и пытаюсь довести до ума, но не могу понять это она всё таки кривая и её не спасти, или всё таки семплер и инструкт плохие?

> у кого от нескольких видях перформанс сразу падает в разы

На жоре в современных видюхах так и происходит, причина не ясна. А последовательная обоработка сильно теряет в эффективности при росте числа гпу.

По виртуальному стримеру начни продумывать как это будет и поймешь что нужно много больше.

Всеже интересно как у типа получилось на 3х п40 катать 120б с 4+ т/с, надо у него поспрашивать и почитать по тому что было выполнено.

> собрался сравнить две модели в разных форматах и не понял, как это сделать.

Ну, гриди энкодинг будет одинаковый в пределах погрешности кванта, рандом семплирования существенный сам по себе. Только большое число одинаковых или разнообразных но по одной теме вопросов, которые можно как-то качественно-количественно оценить, получая в итоге что-то среднее.

> по gptq ищутся например вот такие структуры

Там качай через гит/хфхаб чтобы всю папку, и ее помещаешь в дирректорию models убабуги (или натравливаешь саму экслламу если вруд не используешь вебуи). Нужны все файлы что там есть, а не только .bin/.safetensors.

Если будешь пускать фп16 экслламой - нужно сконвертить .bin в .safetensors сделать можно скриптом https://github.com/turboderp/exllamav2/blob/master/util/convert_safetensors.py с аргументом *.bin запуская в папке с моделью.

> gguf почему-то не выкладывают в f16 на лицехвате

Местозаполнитель который, обычно, никому не нужен и легко получаем. В него конвертится оче быстро скриптом из репы жоры, тут сам знаешь, и весить он будет тоже под 100 гигов. Если хочешь с потерями на грани измеримости - качай q8, оно и в 48 гигов врам должно помещаться.

Алсо визард-викунья эти не стоит, аж 1я ллама и 7 месяцев назад. Из ~30б китайцы, выше список анон скидывал, и айроборос 33б на 1й лламе относительно свежий файнтюн со всеми фичами и новым датасетом. Что там по перфомансу правда хз.

> А две карты?

Норм, но 32гб пограничный размер и хватит на ~34б в жирном кванте с контекстом, но не на 70. Если не ошибаюсь, у кого-то был конфиг 24+12гб, трехбитная 70б по словам не понравилась. Скорость можешь сам посчитать исходя из того как быстро крутятся модели поменьше, там почти линейная зависимость от размера.

Почему все ссуться от всяких микросетей типа phi-2, tinyllama, этож просто днище. Ну да они могут ответить на короткий вопрос без контекста и форматирования и даже правильно. Но размер сети жестко вводит ограничение на понимание контекста. Да даже 7b они откровенно слабы никуда они там не продвинулись только опять же по простым вопросом из википедии. Но их хоть можно на любом компе запустить со сносными ответами.

Все эти локальные языковые модели тупые по сравнению с GPT-4. Только GPT-4 смог правильно ответить на логическую задачку. "В большой комнате играют Вася, Маша, Коля, Толя и собачка Бобик, в маленькой комнате играют Митя и Гриша. Гриша ушел, а Маша и Бобик перешли в маленькую комнату. Сколько детей играет в каждой из комнат?"

ну да, вроде exllama v2 рабоатет на p40 хуже, чем жора

А скорость никто не скажет — никто пока не купил. =)

Я предпочел квест 3, хотя и думал взять на пробу.

Такое себе, хотя для 24 гигов уже может быть интересно.

Однако… Боюсь она мозгами будет не совсем 70б. =)

Но кто знает.

> На жоре в современных видюхах так и происходит, причина не ясна.

А в чем преимущество жоры перед exl2, например, кстати? Ну, если у нас несколько видях — можно предположить, что объем врама уже не такая и проблема. Выгружать можем все, а не часть.

Или речь именно о ситуации, когда выгружаем часть слоев туда, часть сюда, и часть на проц?

Могу предположить, что тут и правда быдлокод, где проц участвует сильно много раз, где не надо, хз.

> По виртуальному стримеру начни продумывать как это будет и поймешь что нужно много больше.

Ну, это не моя идея, я разве что комментатора себе бы собрал.

Но тут нужен или Cog, чтобы моделька смотрела мою игру (а ког хочет 45 врама), или вообще анализ видосов.

> Всеже интересно как у типа получилось на 3х п40 катать 120б с 4+ т/с, надо у него поспрашивать и почитать по тому что было выполнено.

Все еще думаю, что балабол, а может и вовсе продавец карт. =)

Ну как-то слишком вкусно. Учитывая что там минимум 50+ гигов, и как-то выжать 4 токена… Когда тут в двух картах 34 выдает 3 токена.

> трехбитная 70б по словам не понравилась

У нас тут двухбитная на подходе. =D

> Почему все ссуться от всяких микросетей типа phi-2, tinyllama, этож просто днище.

Интернет вещей, смартфоны-помощники, всякие простейшие комментаторы без требований железа.

В идеале каждому по серверу хотя бы с тремя 4090/3090/P40 (это и по деньгам дешево, и по реализуемости с точки зрения материнки возможно), на которых крутить отдельные модели.

А в жизни у людей ноуты с 8 гигами рама и встроенной видяхой. =)

Да, как я понял, там тока жора норм работает. Что не плохо, но и не огонь. So-so.

А разбил 50/50 по картам?

GPTQ выглядит как будто вообще не почувствовал разницы.

А Жора просел, да.

да, там где 2 cards - разбиение напополам

> А в чем преимущество жоры перед exl2, например, кстати?

Вон на p40 работает лучше бывшей, а так при наличии видюх преимуществ нет. Когда врам меньше чем нужно - он безальтернативен по сути. Надо чекнуть что там с awq, вдруг тоже можно сплитить проц-гпу.

Вот тут выходит что на llamacpp при сплите на p40 практически нет просадок. А на 3090/4090 все печально. И скорее всего дело не в линиях pci-e.

Если пекарня на шинде - покажи gpu-x для каждой карточки, или набери nvidia-smi -q |grep "Link Wi*" -A 2 если в прыщах.

> gpu-x

gpu-z офк, фикс

Получается одна видюха на процессорных 3.0 х16 а другая на чипсетных 2.0 х4 (на всякий можешь проверить выставив grep "GPU Link Info" -A 6). Значит влиянием линий можно по сути пренебречь, а проблемы llamacpp в припезднутой совместимости с картами новее, уже интересно.

Алсо если будешь траить - попробуй ког в фп16 засплитить.

>ког в фп16 засплитить

если ты скажешь что такое ког и где его достать - то проверю

>ког в фп16 засплитить.

А он вобще конвертируется в ггуф?

Он запускается через трансформерс (ванильный или их обертку), ггуф и жора в это не может. Квантуется там же на месте.

Для ггуфа можешь llava, бакллава или share-gptv попробовать, но они слабее во многих задачах.

Mixtral-8x-7b на русском зафейлил, а на английском - справился. На русском все модели намного тупее.

https://huggingface.co/TheBloke/LLaMA-Pro-8B-Instruct-GGUF

Добавлена совместимость с llama.cpp 7 часов назад, все что раньше сосет

Так что первые тесты вчера были сломаны и поэтому сетка шизила

Добавлена совместимость с llama.cpp 7 часов назад, все что раньше сосет

Так что первые тесты вчера были сломаны и поэтому сетка шизила

>Для ггуфа можешь llava, бакллава или share-gptv попробовать

Эт знаю, но и жрут они меньше в разы. Там еще обсидиан 3b есть и какая та мелкая на 1.1b новая

>Так что первые тесты вчера были сломаны и поэтому сетка шизила

Я знал ©

Жду кобольда.

https://github.com/ggerganov/llama.cpp/pull/4810

жора тут метод Self-Extend пилит, думаю следующая версия кобальда будет еще и с ним

> Значит влиянием линий можно по сути пренебречь

И снова, как я говорил, линии мало что значат, задержки появляются, но мизерные.

Математика, йопти. =)

И они обе только описывают, без умения болтать?

Типа, разницы с обычными блипами и клипами по итогу и нет, без умения выполнять задачи, ролеплеить и т.д. =(

Смайлоблядь, ты сейчас к своему авторитету апеллируешь, или пытаешься выебнуться ни о в чем? Ранее втирал только трешак про 12х 3060 да поддакивал разным вбросам, и то исключительно фантазии без каких-либо обоснований и даже понимания как оно работает. Пользу приноси а не сочиняй повести о былых победах.

> Математика

Коши которого мы заслужили, ага.

> разницы с обычными блипами и клипами по итогу и нет

Хуясе ебать, накати и поюзай, а потом повтори то же самое клипом.

>И они обе только описывают, без умения болтать?

>Типа, разницы с обычными блипами и клипами по итогу и нет, без умения выполнять задачи, ролеплеить и т.д. =(

Те что по ссылкам не щупал, а эти

>llava, бакллава или share-gptv

те же локалки только чуть тупее, но с возможностью отправить им картинку. Понимают они их через раз, но это работает.

не запускается у меня эта херота.

1. мне не удалось размазать её на два гпу, хотя я что-то похожее на решение проблемы нашел вот тут https://huggingface.co/THUDM/cogvlm-chat-hf/discussions/2

я не могу использовать конкретно этиор решение сейчас, потому что запускаю на отдельной машине, которая вообще к мониторам не подключена, а для web_demo.py решение неприменимо

2. модель в распакованном виде весит 35 ГБ. web_demo.py можно указать в аргументах параметр --quant 4 или 8, но он начинает вот эту здоровую модель квантовать перед запуском в оперативке. Моей оперативки 32 гб + 16 гб свап на квантование в 4 не хватило, оом его убил.

В новую шапку по хорошему нужен раздел о мультимодалках и перечислить их с кратким описанием че как.

Тема интересная, но как то заглохла.

Наверное потому что не осилили сделать полноценную реализацию в вебуй и таверну.

Одна только llama.cpp для запуска, так и заглохло.

Тема интересная, но как то заглохла.

Наверное потому что не осилили сделать полноценную реализацию в вебуй и таверну.

Одна только llama.cpp для запуска, так и заглохло.

Хуя тя порвало, маня.

Тебе бы пора шизу лечить, таблеточки принимать, авось бы так не рвался с собственных несбывшихся фантазий.

Просто они не способны в инструкции и запросы.

Просишь пошутить на тему пикчи — они просто описывают пикчу и «смешно потому что».

Может в данном случае скиллишью, конечно, но я че-то часик потыкал их и забил. А на Когу мне врама не хватает, мех. =)

Эх, вот это печально.

Пробовать на системе с монитором будешь, или возможности пока нет?

Ссука блядь....

вот не мог добавить это говно в ридми мультимодалки?

https://github.com/oobabooga/text-generation-webui/issues/4299#issuecomment-1858735031

Найден фикс позволяющий запускать сраную мультимодальность в хубабубе.

Правда выдает хуйню какую-то.

./start_linux.sh --multimodal-pipeline llava-7b --model llava-7b-v0-4bit-128g -

-load-in-4bit --wbits 4 --groupsize 128 --loader AutoGPTQ --listen

>Пробовать на системе с монитором будешь, или возможности пока нет?

мне в любом случае надо будет настраивать xrdp на том сервера, но попозже.

вот не мог добавить это говно в ридми мультимодалки?

https://github.com/oobabooga/text-generation-webui/issues/4299#issuecomment-1858735031

Найден фикс позволяющий запускать сраную мультимодальность в хубабубе.

Правда выдает хуйню какую-то.

./start_linux.sh --multimodal-pipeline llava-7b --model llava-7b-v0-4bit-128g -

-load-in-4bit --wbits 4 --groupsize 128 --loader AutoGPTQ --listen

>Пробовать на системе с монитором будешь, или возможности пока нет?

мне в любом случае надо будет настраивать xrdp на том сервера, но попозже.

>Правда выдает хуйню какую-то.

думаю, дело в новой куде..... возможно

я попробовал взять minigpt4-7b вместо llava-7b

Но он все равно не понимает смешное

Сомневаюсь, что он понимает такой образ, как транс-феминистка в цветах лгбт-флага.

Но, как бы, да, общаться с ним весьма скучно. Вся надежда только на Cog.

Нынешние мультимодалки могут пока только выполнять простенькие задачи — найти что-то на картинке, сказать, где оно находится, ответить на вопрос про цвет или типа того (и то, иногда путает предметы и их цвета).

Сугубо прикладная штука.

ИМХО, хотелось бы ошибаться.

>Сомневаюсь, что он понимает такой образ, как транс-феминистка в цветах лгбт-флага.

Даже я его не понял, лол.

хамелеон - в виде логотипа suse linux, транс - имеет на футболке логотип арча, ну неужели так сложно....

ОС я как раз распознал. А вот за фемку я бы без подсказок не понял.

нууу.... я вообще не уверен, что это фемка....

транс - да. Но откуда анон взял фемку - не знаю. Может перепутал.

Для веб-демо алсо там нужно было другую версию жрадио ставить, в рекварментсах поленились указать и оно не стартует, возможно уже починили.

Не понял а для чего монитор?

> а для web_demo.py решение неприменимо

Переписать поидее можно, но стоят ли эти заморочки того - хз.

> на квантование в 4 не хватило

Вот хотел еще написать, оно когда в рам загружает на процессор, выжирает неприличное количество.

Можно.

> но как то заглохла

Просто обсуждений нет, а так вполне юзаются. У мультимодалок текущих по сути применения больше прикладные.

> полноценную реализацию в вебуй и таверну

Есть идеи как их тут применить? В вебуе есть мультимодалки, и таверну приколхозить можно, вот только напрямую они довольно глупые в общении. Лучшие из них нафайнтюнены на "рабочие задачи" и рп не могут. Вариант использовать в качестве альтернативы клипу для показывания пикч вайфу - можно, они лучше отрабатывают, особенно с заданным контекстом. Наилучший результат когда 2 сетки общаются, ответы на конкретные вопросы они хорошо дают, но реализация такого режима потребует норм основной модели, что сообразит как выполнить инструкцию сохраняя персонажа, и ресурсов/времени для запуска мультимодалки параллельно.

Шиз, ты не сюда пиши а это перед зеркалом себе говори, наиболее уместно и релеватно.

Зачатки понимания демонстрирует разве что бакллава и sharegpt, ну и ког, хотя у последнего как повезет, видит превосходно, но ллм там слабая. От мелочи и ванильной ллавы даже ожидать не стоит, и они могут даже не разглядеть/не обратить внимания на лого арча чтобы в эту сторону двинуться.