Новый день - новый тред

В тех 2.5? Эффект падения/роста скорости легко показать деля на несколько карточек модель, что может поместитсья на одной, и сравнивая скорости. Анон в парой P40 показал что даже с x4 2.0(!) на двух картах скорости почти так же что на одной. Пусть уточнит если что.

Перфоманс там скейлится почти линейно в зависимости от размера модели.

Алсо

> где народ хвастается высокой скоростью

на 70б заявляются скорости выше чем на 34б, да такие что это даже больше половины перфоманса 3090 в более эффективном режиме. А с ней они не сопоставимы ни по перфомансу чипа, ни по псп врам.

Такого можно достичь только если используются какие-то оптимизации или когда ты пиздабол и этими картами торгуешь. Шина сама по себе тут не при чем будет.

А что если наебать систему и взять несколько P40 P100 4060ti 16gb? Считай по вычислительной мощности = 4090, но врама х2, а стоит в 2 раза дешевле. Думойте.

Посоветуйте 70b, которая хорошо работает из коробки в sillytavern, заебался ковырять шаблоны контекста что-бы понять какой лучше.

>Считай по вычислительной мощности = 4090

А мужики то не знают.

> по вычислительной мощности = 4090, но врама х2, а стоит в 2 раза дешевле

Если бы был легкий способ сложить вычислительную мощность консумерских видеокарт при запуске ллм - был бы крутой вариант. В текущих реализациях они работают по очереди, считай то же самое что одна 4060ти но с увеличенным объемом памяти.

В прошлом треде советовали 70.

> которая хорошо работает из коробки в sillytavern

Все они работают с ролплей шаблоном, он в принципе универсален, а 70б менее требовательны к формату.

А так вообще подбирать модель под шаблон - всеравно что автомобиль под резину.

>Если бы был легкий способ сложить вычислительную мощность консумерских видеокарт при запуске ллм - был бы крутой вариант. В текущих реализациях они работают по очереди, считай то же самое что одна 4060ти но с увеличенным объемом памяти.

А это точно хуже чем собирать всякую экзотику типа P40 на помойке которую ещё и хуй охладишь нормально?

Пара 4060ti@16 под 34б - норм тема, возможно влезут франкенштейны 56б и всякие МОЕ. Но по деньгам выйдет раз в 5 дороже чем одна P40. По скорости - если сравнивать по редким данным что выкладывали и масштабировать - в llamacpp на 34б будет менее 10т/с, это далеко не в 5 раз быстрее. Колхоз всеравно будет, ведь две видюхи, но более юзер-френдли офк.

Чем больше карточек собираешь для таких пусков ллм, тем менее это выгоднее.

Да, жоповато выходит.

А какие шансы увидеть в будущем A6000 на барахолке?

Высокие офк, они уже там появляются. Правда цена негуманная и вопрос ушатанности/живости, запечатанные стоят как ррц. Если вдруг хуанг решил сделать в 5к серии 48гб врам или выпустить титан с ними, и цена будет не выше 3-4к, то будет их наплыв и удешевление.

Можешь прямо сейчас взять пару 3090, на барахолках стоят чуть дороже чем 4060@16. Для всего кроме обучения крупных моделей их будет хватать, алсо там даже нвлинк есть, что может где-то сыграть если использовать.

База везде.

Да ты угараешь, один уже нес такую же херню в прошлом треде!

Дороже вдвое-втрое, как минимум.

Ну, P40 тоже стоит брать не одну, а две, тогда уж. =)

Ну, типа, со всеми кэшбеками и промиками скок там выходит, 25к за одну 4060ти, это 75 тыщ за 3 штуки (16+16+16=48). а 2 P40 будут стоит 32~35 тыщ.

Ну, в 2,5 раза, таки да.

Вряд ли Хуанг так решит сделать.

>ряд ли Хуанг так решит сделать.

Спорное утверждение. Так-то Хуангу выгодно обесценивать старые карточки, чтобы гои шли покупать новые по оверпрайсу.

Хотя это игра в рулетку.

> 25к за одну 4060ти

Шо, опять там зеленый банк ультит своими наебаллами?

Ну за условные 75 это вполне себе вариант офк, хотя 3я лишняя.

> Вряд ли Хуанг так решит сделать.

> Спорное утверждение

Кто же его знает. С одной стороны тут желание привлечь больше клиентов новой темой и укрепить доминирование. С другой, у них и так все хорошо, карточки сметают и внутренний каннибализм, а тем более конкуренция их профессиональным решениям - нахер не сдалась. Что перевесит - сложно сказать, возможен еще компромисс с 32-36 гигами.

И с какой скоростью будут работать эти 4060ти?

Емнип в треде аноны с р40 пруфали, что у них нет потерь производительности от соединения видеокарт, а владельцы 30ХХ и 40ХХ жаловались на потерю производительности в эксламе.

Емнип в треде аноны с р40 пруфали, что у них нет потерь производительности от соединения видеокарт, а владельцы 30ХХ и 40ХХ жаловались на потерю производительности в эксламе.

> в эксламе

С ней как всегда все отлично. Проблемы только с жорой, оно само как-то пытается шарить по дефолту и сильно замедляет. Учитывая что у жоры нет преимуществ - нет и мотивации искать истинную причину.

Понятно. Спасибо.

Может быть это все просто шиндопроблемы, ведь тесты P40 что мы видели делались на линуксах, где нет многих приколов и все работает из коробки. Когда сойдутся звезды проверю эту и другие гипотезы.

Ну, если равнять 48 гигов к 48. =) Три 4060ти против двух П40. Лишняя по размеру, но по памяти лишних не бывает.

Очевидно, что со скоростью чуть ниже одной 4060ти, но вот вопрос — с какой скоростью работает она? :) Никто так и не потрогал, кек.

Кто нибудь уже тестировал новую WestLake v2?

По тестах пиздец много обещающая.

По тестах пиздец много обещающая.

Бля, вы так говорите за 4060ти тут...

Что, внатуре стоит эту 128 бит шляпу брать?

Я бы хотел 4070ти супер новую, но денег сильно не хватает.

Что, внатуре стоит эту 128 бит шляпу брать?

Я бы хотел 4070ти супер новую, но денег сильно не хватает.

Для llm объём vram важнее всего остального. Для других задач сам смотри, насколько тебе важно.

Ну это понятно. Но скорость памяти тоже важна, не?

Да.

Вброшу про 4060, у которой память медленнее Р40...

Нет.

Если модель полностью в vram, ты в принципе на любой современной видимокарте получишь приемлемую скорость (выше скорости чтения). Больше памяти - больше модель или больше контекста сможешь загрузить. Ну только если тебе принципиально, чтобы было условные 50 Т/с вместо 30 на мелких тупых моделях (при том, что читаешь ты уж точно не выше 10, а скорее даже и 5, как бы ни торопился), то да, скорость важна.

Если оффлоадить, то узким местом в любом случае станет cpu, и опять чем больше поместится в vram, тем лучше.

Если покупать несколько gpu, опять же, чем меньше их будет (чем больше памяти на каждом), тем лучше.

Короче, при любом раскладе параметр vram/$ для llm является наиболее важным.

> выше скорости чтения

Для дедов, уже 15+ лет по 12+ часов в день только и занимающихся скорочтением от книг до скролинга интернетов и работки, даже 20 т/с мало, потому что уже есть навык литералли читать построчно, а не по словам. Это сложно описать, но ты как бы запоминаешь как выглядит строчка текста, а мозг сам парсит все слова одновременно и выдаёт смысл в башку. По словам только свой написанный текст перечитываешь, чтоб не проебаться в потоке мыслей.

ты не боишься старости?

я так же накину, что два PCIe x16 в потребительском сегменте встречаются довольно часто, а вот три PCIe x16 - уже охуеть редкость. Так что три плюсуйте еще новую материнку к стоимости и блок питания дохуя. Мне под мои 2 p40 пришлось покупать киловатник, а знаете сколько они стоят сейчас? Минимум 13к.

Реально что-то дорогова-то общая сборка выходит, а так хотелось 3 4016

Анончики, а есть где-то вменяемый гайд по P40?

Ну например: Какие дрова ставить? Норм ли на винде или нужен линукс обязательно? Что конкретно можно запустить и как? Угабога например при установке спрашивает про граф. процессор, с P40 устанавливать как NVidia? А лоадеры все работают или только llama.cpp? Что по скоростям на 7,13,20,30,70В?

Ну например: Какие дрова ставить? Норм ли на винде или нужен линукс обязательно? Что конкретно можно запустить и как? Угабога например при установке спрашивает про граф. процессор, с P40 устанавливать как NVidia? А лоадеры все работают или только llama.cpp? Что по скоростям на 7,13,20,30,70В?

По спекам одна P40 потребляет максимум 250 Ватт. В майнерские времена у меня две 280x (тоже по 250 Ватт) сидели на БП 750 Ватт. БП Корсар до сих пор живой и перекочевал в новый комп.

>P40 потребляет максимум 250 Ватт

Когда там уже чиплетная архитектура, я заебался. Хуйня жрёт энергии, как две р40, а памяти, как у половины.

>я так же накину, что два PCIe x16 в потребительском сегменте встречаются довольно часто, а вот три PCIe x16 - уже охуеть редкость.

Толку-то с тех слотов, если они не от процессора. И даже такие потребительские материнки с двумя слотами уже встречаются очень редко. Я так понял, сейчас производители делают ставку на первый слот, которому отдают всю производительность - все 16 линий PCIe 4 или 5 версии. А остальные слоты просто для красоты. Более того, с БП та же фигня - все новые БП делают с разъёмом 12VHPWR под одну мощную видяху. А если хочешь 3-4, то этого тупо не предусмотрено.

> 4070ти супер новую

Она лучше чем 4060 офк, но ничего считай не влезет. 20б в суб 4 битах только. Так по перфомансу она как 3090, только памяти меньше и в пару большие модели не влезут.

Да, но даже то что считается днищем по меркам видюх - уже достаточно для быстрой работы.

Чаю этому господину.

> скорочтением

Это для быстрой оценки "свайп-не свайп", а потом всеравно уже основательно вчитываться, вникать и т.д.

> два PCIe x16 в потребительском сегменте встречаются довольно часто

Да ладно, покажешь ссылок на такое? В десктоп профессорах линий не больше 20 а даблеры, казалось, перестали ставить уже больше десятка лет (и не факт что будут эффективны вообще).

> еще новую материнку

Всю платформу, которая современная выйдет страшно дорого. Только некрозеоны с брендовыми/серверными платами, ибо в большинстве китайских перестали нормально линии дополнительные распаивать.

> знаете сколько они стоят сейчас? Минимум 13к

Ахуеть, более мощную платинувую йобу не так давно дешевле можно было купить

Больше VRAM выйдет неизбежно дороже, даже если тупо добавить стоимость чипов. А ГЕЙмеры всякие будут в недоумении нахрена им переплачивать за лишнюю память. Вот если бы было наподобие конструктора, где можно вставить больше памяти... эх.

Мне вот интересно, а потребительские нейроускорители хотя бы в проекте есть? Или только колхоз?

>если бы было наподобие конструктора

Мощный стержень Xi вставлять много мозги в кожаные карта.

Обосрался, это вообще как?

> даже если тупо добавить стоимость чипов

На 10-20-30%, но никак не в 2-3 раза. Тут вопрос исключительно в окучивании тех, кто готов за такое платить.

Хуанг уже напрямую заявляет что его карточки - не только про игры, а вполне себе ии ускорители. У гей_меров так вообще мантра на нейронное сжатие текстур.

Прецедент, 2080ти на 44 и 3090 на 48 случаем нету там?

Санкции на импорт ускорителей, вот у них там вовсю пошло дело с рефабами. Тонкие серверные 3090\3090ti с турбиной в наличии. Пока что актуально, а значит, и дорого. Хотя баксов на 200 уже подешевело с появления.

>Прецедент

Это началось ещё со старых rx в майнинг, когда удваивали с 8 до 16.

>случаем нету

Нету. Нихуя нету. Магазин вообще видимокарточки не продаёт.

Нвидию нагнули и запретили продавать 4090 в Китай, чтоб без кума годного они там загнулись.

Китайцы на фоне этого начали ебашить каких попало франкенштейнов.

Там реально сейчас фабрики работают по перепайке видях под LLM.

> по перепайке видях под LLM

Вут? Колхозный рефаб был давно, а по замене чипов больше единичные сообщения и то только со скринами из гпу-з вместе с жалобами что больше дефолтного не может выделить и использовать.

> нагнули и запретили продавать 4090 в Китай

Вообще у них там своя версия 4090 уже продается и вполне успешно. На гите, обниморде и прочем можно увидеть много нытья в ишьюсах со скринами 4...8x 4090 из nvidia-smi. Во многих их модельках уже прямым текстом указывается не количество видеопамяти а количество 24-гиговых карточек для обучения/взаимодействия.

>с жалобами что больше дефолтного не может выделить и использовать

Это какая-то совсем паль. Даже кустари делают так, что всё может и выделяет, прирост значительный. Но, конечно, всегда есть контроллер памяти, который может не переварить возросшие требования к пропускной способности.

Кстати, почему exlama работает медленно (медленнее lamacpp), показывает загрузку гпу 100%, но при этом энергопотребление низкое?

Такое ощущение, что данные нейросети не успевают своевременно доезжать до cuda блоков.

>Только некрозеоны с брендовыми/серверными платами, ибо в большинстве китайских перестали нормально линии дополнительные распаивать.

Двухпроцессорные хуананы пошли особым путём: на одном проце висит 2x16 и на втором 1x16.

А вообще нормальные люди уже хоронят 2011-3 и покупают epyc 7551p, куда лучше и не сильно дороже. Сам бы так сделал, если бы не двухсокетный Хуанан, который купил пару лет назад.

Такое ощущение, что данные нейросети не успевают своевременно доезжать до cuda блоков.

>Только некрозеоны с брендовыми/серверными платами, ибо в большинстве китайских перестали нормально линии дополнительные распаивать.

Двухпроцессорные хуананы пошли особым путём: на одном проце висит 2x16 и на втором 1x16.

А вообще нормальные люди уже хоронят 2011-3 и покупают epyc 7551p, куда лучше и не сильно дороже. Сам бы так сделал, если бы не двухсокетный Хуанан, который купил пару лет назад.

> почему exlama работает медленно...

Это я про P40.

Анончики, что там для работы с ру текстом сейчас лучшее?

модуль гугл транслятор

Not bad

Рабочих тестов буквально единицы, полно вариантов где апгрейдят версии с малой памяти на большую, но просто перепайка чипов на большие куда сложнее. Хотя у амперов биос взламывали, шансы велики.

> почему exlama работает медленно (медленнее lamacpp), показывает загрузку гпу 100%, но при этом энергопотребление низкое?

Паскаль не поддерживают операции с низкой битностью и оно где-то в них затыкается, видимо. В фп16 мелочь не пробовал запустить?

> Двухпроцессорные хуананы пошли особым путём: на одном проце висит 2x16 и на втором 1x16.

Вроде не самый плохой вариант, только с нумой могут вылезти приколы. Не сравнивал результаты когда карты на одном проце и на разных?

> epyc 7551p

Первый зен - ну хуй знает даже, они буквально 2011 зеонам сливали и не вывозили периферию. Хз как себя покажет.

>Вроде не самый плохой вариант, только с нумой могут вылезти приколы. Не сравнивал результаты когда карты на одном проце и на разных?

Попытался стакануть p40 и 1070 на разных процах на винде. Nvidia-smi их видело, системный софт винды тоже, а вот обабога взбугуртил от перекидавания железа, ругался, что драйвер cuda не походит к питорчу и подобное.

Уверен, оно бы работало после перенакатывания дров и обабоги с нуля, но я подзабил.

Уверен, что чел с сервачком из 6х P40 на реддите тоже включал их через нуму, а иначе бы голиаф не работал так шустро.

>Паскаль не поддерживают операции с низкой битностью и оно где-то в них затыкается, видимо. В фп16 мелочь не пробовал запустить?

Попробую, сравню чуть позже.

Ого. А что с ними не так?

Контроллер памяти производительнее зеонов, линий pci-e больше, ядер многа, развалит в любом бенчмарке.

https://youtu.be/W6uaUHBNFOU?t=685

Я видос смотрел прыжками перемотки, но перепрошивки биоса что-то не заметил. С большими банками карта всё равно увидела 8 гигов, так что они перепаяли какие-то смд, сопротивления, наверное. И буквально всё завелось. Опять же, 16 гигов 3070 планировались изначально, тут чудес не случилось. Китайцы даже перепаивали потребительские чипы на серверные платы, не помню уже, с какими чипами это было.

Только тут уже вопрос цены восстаёт. GDDR5 чипы на алике по 2.5к, банок нужно 8, это уже 20к. Плюс шары, трафарет и работа. Покупать какие-нибудь 24гб теслы по 15к и выпаивать оттуда память - соснёшь, там банки по 1гигу. Можно накопать 3070ti за 30к и ебануть ещё столько же в апгрейд, но будет ли оно того стоить?

С другой стороны, на том же авито триллион сообщений с продажей отреболеных чипов 256-512-гигабайт, кое-кто даже пишет, что снято с карт в процессе модернизации. Что как бы намекает, что метода работает не только в узкоглазых краях.

>Так-то Хуангу выгодно обесценивать старые карточки

Полусофтовая фича типа генерации кадров эксклюзивно будет стоить намного дешевле распайки врама.

>По тестах

Тесты-нитесты.

Только я читаю быстро на русском, а с LLM лучше всё же общаться на английском. А там уже пофиг, стримминг не нужен.

>два PCIe x16 в потребительском сегменте встречаются довольно часто

Там 8+8 в идеальной ситуации, чаще же 16 проц + 4 от чипсета.

>А если хочешь 3-4, то этого тупо не предусмотрено.

Старые сисоники уже не продают? К моему титановому 750 ватт 4 провода псины шло, и 2 на проц 8 пиновых.

>В десктоп профессорах линий не больше 20

24 уже сейчас, впрочем, всё в NVME кидают. У моей платы их 3 штуки, лол.

В десктопные процы в следующем поколении обещают, в могилках так уже давно, но там всё одно шина памяти лимитировать будет, это всё для понта или энергоэффективности делают, а гоям и 90M нейронки норм.

> Nvidia-smi их видело, системный софт винды тоже

У этой серии и десктопных действительно разный драйвер. На том же реддите есть посты как их вместе поставить, довольно примитивно типа вставь одну - установи, потому вставь другую - установи, потом вставь обе.

> из 6х P40 на реддите тоже включал их через нуму, а иначе бы голиаф не работал так шустро

Тот "первый" имел только 3 и гонял их на брендовой х99. Из особенностей - там даблеры на 2-3 слот чтобы получить типа х16+х16, однако при одновременном обращении оно будет работать даже чуть медленнее чем честные х8+х8.

С шестью не видел, есть ссылка?

> что с ними не так

Первый зен это буквально кринж вместо архитектуры. По эпикам знаю только что для расчетов нельзя даже длинной палкой трогать что-то старше миланов, вот начиная с них и далее уже вполне себе.

> развалит в любом бенчмарке

Сольет какому-нибудь топовому десктопному интелу тех времен или амд начиная с зен 2-3 в математических бенчмарках, без шуток. Как повлияет в контексте треда - хуй знает, но учитывая что десктопные зен 1не могли даже в бенчмарках ссд выдать штатную скорость pci-e 3.0 - с большой осторожностью нужно такое рассматривать.

> Китайцы даже перепаивали потребительские чипы на серверные платы

Может мобильные чипы на отдельный текстолит? Такого добра на али не так давно валом было.

> но будет ли оно того стоить

Если с 3090 и успешно - офк будет, цену на 48гиговые можно посмотреть.

> мобильные чипы на отдельный текстолит?

Не, это хуйня. Там история была с тем, что у серверной версии банки с двух сторон, а у потребительской с одной. Они не перекатывались ни на другой биос, ни на другую память, просто плату спиздили, чтобы удвоить количество банок не увеличивая объём чипов. Сам текстолит хуярили новый, а чипы уже б.у. Не помню конкретный чип, но он был довольно медленный, так что я порофлил и забыл.

>Если с 3090 и успешно

Если реально, то Китай уже делает. Чипы там с двух сторон текстолита, банки по гигу. Но я бы стартовал такие извращения с чего попроще. Вот, например, на р40 банки с двух сторон, их 24, значит, каждая по гигу. Ставишь 24 двухгиговые чипа и получаешь одну р40 на 48 гигов за цену трёх р40.

какие же дебилы сидят в форчановском /lmg/

пиздец

скоро уже будут пить мочу записывая это на видео, прям как в /aicg/, и всё ради сомнительной модели в формате FP16

пиздец

скоро уже будут пить мочу записывая это на видео, прям как в /aicg/, и всё ради сомнительной модели в формате FP16

Скажите, как они там постят? Ебанешься с капчей, блять.

4chan для рашки кажись заблокирован

а капча то изичная, легче чем здесь :/

и здесь для невкуривающих добавлю, там в /aicg/ пьют собственную мочу ради доступа к прокси клауды или гпт-4, а то что происходит сейчас в /lmg/ это полюбому какой то троллинг от рандома, общая суть - типо слили mistral-medium, но только в формате GGUF.

> что у серверной версии банки с двух сторон, а у потребительской с одной

Эээ, вут? Это какая модель?

Есть десктопные карты с двух сторон, та же 3090, есть и серверные/вс где с одной стороны. Хочешь сказать что где-то есть чипы что совпадают по распиновке и могут внезапно сразу обслужить кратно больше банок на канал без биоса?

По первому пику - там если посмотреть в конце статей - завести что-то на памяти больше 11 гигов им не удавалось и пытались подебить бивас или дрова.

> Если реально, то Китай уже делает.

Ну, нужно копать их ресурсы. Так вообще были вбросы про 3090 на 48 особую версию для их рынка еще года-два назад.

> на р40 банки с двух сторон

гддр5 банок удвоенной плотности то есть? На п40 это в любом случае смысла не имеет ввиду слабости чипа, но на более мощные, хотябы начиная с тюринга - вполне.

> пьют собственную мочу ради доступа к прокси клауды или гпт-4

Здесь хотябы просто ноют и ботов делают, хотя...

> слили mistral-medium

> в формате GGUF

Чето проиграл с этого i want to believe, хотя офк всякое возможно.

Как же заебал этот маня-прогресс где очередную 7b надрочили на манятесты и подебили GPT-3.5, охуеть, хайп, блять. При том что даже 13b многие не в состоянии в простейшее "обучение на примере". Вот 20b уже что-то минимально адекватное, хоть норомейда, хоть internlm2 новый (хотя будет смешно если это китайцы норомейду спиздили).

>Это какая модель?

Уже сколько толкую, что не помню нихуя. Вроде, радеон какой-то. Но это не точно.

>завести что-то на памяти больше 11 гигов им не удавалось

На 2080ti можно распаять 22 гига, перепаять один резистор и она заведётся на дефолтном биосе. Был шиз, который распаял 22 гига и накатил бивас от квадры. И всё сломалось, лол.

>Ну, нужно копать их ресурсы.

Покопал, пишут, пизда с новой защитой биваса. Сам бивас сделать не проблема, а обойти проверку легитимности не могут.

>На п40 это в любом случае смысла не имеет ввиду слабости чипа

С завода существовали p40 на 48гб, кожаный ещё не знал, что память нужно экономить.

>хотябы начиная с тюринга

А там всё убердорогое. Самое дешёвое как раз консумерские или какая-нибудь Т10 с 16гб, у которой по заводу 4 банки не распаяно. Но она со старта будет дороже двадцатигиговой 2080ti с алика. Бюджеты 24 гб на тюринге стартуют тысяч со 150. Те же T40 24гб на алике поголовно out of stock интересно, с чего бы это?, титаны на тюринге по 150к, нахуй так жить.

> Вроде, радеон какой-то

Блин, ну предупреждай в следующий раз, это другое лол. У амд вроде базированная практика спускать "профессиональные" карты в консумер сегмент с минимальными изменениями, в таком случае офк сработает. Но толку с них в ии.

> С завода существовали p40 на 48гб

Чето не гуглятся. В вики пишут что самый большой чип gddr5 был в 15м году и имел 8 гигабит, 1гб. Потом уже gddr6, если не выходило 16гигабитных (двухгигабайтных) то ни о каких 48гб в p40 речи быть не может. На gddr6 и выше они уже есть.

> Бюджеты 24 гб на тюринге стартуют тысяч со 150

В прошлом треде же про quadro rtx 8000 писали, за 200 на лохито выставлена, может можно поторговаться.

> титаны на тюринге по 150к

Зачем они нужны

> T40 24гб на алике поголовно out of stock

И эти тоже, все что на 24гб и ниже теряет смысл при наличии 3090, которых еще с эпохи майнинга запасы существуют, и сейчас активно осваиваются. А не грядет ли новая волна спроса на гпу, где гей_меры будут ныть что кумеры ии-энтузиасты все карточки поразобрали

>Но толку с них в ии.

Хуй знает. Сама практика.

>Чето не гуглятся.

Проверил сайт незрячих, таки спиздел. Ну, старость не радость, склероз ебёт.

Квадра за 200 не выглядит выгодной сделкой.

>Зачем они нужны

Потому и продают.

>теряет смысл при наличии 3090

Это у нас они относительно дешёвые, в Китае уже цены полетели в потолок. С другой стороны, там можно купить 2080ti 22гб за ~35к рублей.

> в Китае уже цены полетели в потолок

Да вон на алишке 3090 новые рефаб стоят вполне себе как и должен стоить рефаб с доставкой и наценкой барыг, потолком не назовешь. Но на озон-глобал всеравно дешевле они.

/lmg/ всё ещё хавают байт лмао

Где полноценные веса или хотябы gptq для белых людей? Вдруг не байт, а тут такая подстава. Хотя если иметь оригинальные веса и не хотеть чтобы их сразу спалили, то грузить кванты - make sense.

Ладно, любопытство подебило, сейчас скачаю и пущу. Что потестить/поспрашивать у нее?

>Что потестить/поспрашивать у нее?

да что угодно, там в /lmg/ аноны потестили уже, говорят что модель не может в некоторые загадки и РП темы, сравнивают с микстралом

>если иметь оригинальные веса и не хотеть чтобы их сразу спалили

скорее всего так и есть :/

miqudev загрузил q5_K_M 20 минут назад, хотя аноны ожидают и просят неквантованную f16 модель

> да что угодно

Ну бле, сейчас попробую с ней поршпить, лол. Q4 скачал прошлый пока, его кручу какой же жора медленный бле, и те т/с что называли "комфортными" не очень то комфортны

Так по первым впечатлением действительно что-то новое, цените пикрел. Хотя, вообще, не то чтобы с таким не смогли бы справиться другие 70б модели, xwin точно без проблем.

Не ну это действительно похоже на что-то мистралеподобное и мультиязычное.

Пресет мистраль в таверне юзать вообще противопоказано, там лайфлесс пик1 с "я ии и не имею чувств", в инструкциях аналогично. Если поставить ролплей - уже лучше, пытается следовать карточке.

Как ни странно, какой-либо цензуры (без родного инстракт формата офк) не замечено, охотно подказывает плохие вещи и имперсонейтит левдсы. Пик 3 dies from cringe почти все - имперсонейты. Ну что не поломалось ерпшить на русском - уже похвально, но уровень лексики достаточно трешовый.

В ролплей пресете на русском отвечает очень неохотно, нужно указывать OOC и свайпать, возможно если сделать системную инструкцию то будет устойчивее. Вообще тут следование инструкциям странное, наблюдается некоторая рассеянность.

Надо больше ее покатать, возможно действительно революция, а может просто типикал 70 с немного подкачанной мультиязычностью. Если что интересно - могу прогнать, хотя веса доступны, каждый что хочет может протестировать.

Добавьте в шапку LM Studio, Jan, Faradaydev, Chatbox как альтернативные фронтенды. Ну и Ollama, это же вообще база.

в кобальд добавили поддержку вулкана

>Достаточно будет откатить только llama-cpp-python с помощью pip.

Можешь расписать как это делается?

Да.

а нахуя? мне, красножопому, это чем-нибудь поможет?

Пиздец как же ебет InternLM2-Chat-20B. Правда хуй знает как самому запустить локально. Ебался кто?

Я запускал какую-то 7B модель на RX6600 с вулканом, 30-40 токенов в секунду.

странно, он у меня выгружает слои на мою 6600XT, но не использует её от слова совсем.

Попробуй в gpt4all гуйне запустить, там прямым текстом говорится, если модель не поддерживается вулканом.

Не знаю от чего зависит, я пробовал deepseek-coder и она не работала с вулканом, mistral openorca из их списка моделей работала.

Запускал, вполне себе не плох, но не держи форматирование текста и переодически уходит в мягкий отказ, более 4х персонажей начинает путаться, и в кум так себе. Персонажа держит хорошо. Но тут накатили лиму:

https://huggingface.co/intervitens/internlm2-limarp-chat-20b-GGUF

Стало лучше, но форматирование совсем потерял. В целом лучше прочих шизомиксов на 20b, но и до Юи не дотягивает.

https://github.com/nomic-ai/gpt4all/issues/1803

Вот например чел говорит, что по его тестам только Q4_0 работают на gpu, а Qx_K_M не работают.

Судя по этому коммиту

https://github.com/nomic-ai/llama.cpp/pull/7/files#diff-150dc86746a90bad4fc2c3334aeb9b5887b3adad3cc1459446717638605348efR2442

Поддерживаются только f32, f16, Q4_0 и Q4_1.

спасибо, бро, целую. попробую Q4_0 скачать, но вообще конечно кек, впрочем, мне с амудой вместо нвидимокарты не привыкать.

Ванильная llama похоже сейчас больше моделей поддерживает:

https://github.com/ggerganov/llama.cpp/blob/d2f650cb5b04ee2726663e79b47da5efe196ce00/ggml-vulkan.cpp#L1133

Сейчас попробовал ту самую deepseek-coder-6.7b-instruct.Q4_K_M.gguf и она работает нормально.

ну че, амудестрадальцам наконец повезло?

Сколкьо рам и врам надо чтобы осилить 70b? У меня 30гб рам и 8врам, под какое квантование хватит если хватит вообще?

Ну и посоветуйте хорошую 70б.

Ну и посоветуйте хорошую 70б.

Q2 поместится и впечатление произведёт. Но модель видеокарты ты не сказал, а от этого зависит многое.

3080. А Что от этого зависит? Разве важна не только врам?

4070ти для нейронок оч слаба из-за объема за свою цену.

А для игр нормас, да.

База.

Я БП ниже 700 ватт не беру в принципе, а основной БП на 850. Плюс, работа у них попеременная.

Думаю, переживу. =)

Да и материнок с тремя слотами хватает, они не редкость. НО, вот покупают их не так часто, тут я соглашусь, что бп киловаттник заваляться может, а вот мать с тремя слотами — вряд ли. Ее брать придется, соглашусь.

> P40 устанавливать как NVidia

Ну попробуй как Радеон… =)

Напомню, что линии тебе практически не нужны, поэтому весь спич — оффтоп полный.

В общем жаль, но нейронок это не касается. Проблемы тех, кто между картами гоняет тонну инфы, а не держит все в памяти.

Так же и питалово. Соглашусь, что 1 12VHPWR это жаль, но как бы тоже оффтоп, в итоге. =)

Модульному БП можно докупить необходимых проводов и будет утебя 2-3 VHPWR. Но ето дорого, офк.

> Да ладно, покажешь ссылок на такое?

Литералли любая вторая мать.

Напомню, тебе хватит х4 за глаза, хватит фантазировать.

Зачем нужны потребительские нейроускорители? :) Не тебе, а разработчикам? Им нужны деньги, а это — облака и подписки.

Они все много что говорят, но давать бесплатно то, за что можно взять деньги — не будут.

Просто чекай, будет ли у нас 40 гигов на 5090 или будет 32. А может и вовсе 24.

Игорькам хватит, как грится.

Буду рад ошибаться.

> Там реально сейчас фабрики работают по перепайке видях под LLM.

Хотелось бы. =)

> ругался, что драйвер cuda не походит к питорчу и подобное

Ну, там 11.8 должна быть, я полагаю, да?

> Полусофтовая фича типа генерации кадров эксклюзивно будет стоить намного дешевле распайки врама.

Так.

> какой-либо цензуры … не замечено

Для мистрали это норм, так-то.

> уровень лексики достаточно трешовый

А это — не норм.

О, это интересно, затраю на своей RX6600M.

Интересно, там q5_k_m новый, это который плюс-минус старый q6? Если так, то ето хорошо.

Качаю его, поглядим-поглядим.

https://llm-tracker.info/howto/AMD-GPUs#vulkan-and-clblast

ROCm судя по ссылке более чем в 2 раза быстрее вулкана.

Я так понял, вулкану радуются не из-за скорости на 7900XTX, а из-за его работоспособности на 6600 и иже с ними. =)

Там у ROCm — 0. =D

В активированной среде pip install _module_==_version_ (--reinstall) [...]

Для правильной сборки llamacpp нужны доп параметры на куду, их ищи в ридми основном.

От 4х бит - 64 рам (при выгрузке на проц), ~40врам (минимум). Больше битность/контекст - 48+. "Мистраль-медиум" попробуй а так платина - синтия, айроборос, гоат, хвин.

> Литералли любая вторая мать.

Ну так давай линки потребительских платформ с парой х16 слотов, офк не пустых на 3/4 а полностью распаянных.

> Напомню, тебе хватит х4 за глаза, хватит фантазировать.

Бля пчел...

> А это — не норм.

Это просто сказка и недостижимый уровень для всего мистраль~ добра. Но уровень по языку в лучшем случае турба, надо смотреть правде в глаза.

Надо еще проверить как она себя поведет под инструкциями и нагрузкой с разными языками, насколько будет деградировать и сравнить это с другими 70.

Пока что явно заметно - ее тренили с другим rope (возможно в этом причина рассеянности) и указанным шаблоном инструкций.

Суммаризировать рандомные тексты про трансформерс с обниморды могут и другие модели с накрученным rope, но в комбинации с форматом инструкций и на другом языке у этой получается лучше по первым оценкам.

> Бля пчел...

Ну прости, реальность такова.

Если тебе кажется иначе — прими таблеточки, полегчает.

Но оффенс, но серьезно, сюда уже пруфы кидали, а кто-то продолжает твердить, как все это дико влияет (+1 секунда на х1 pcie 2.0 на 4к контекста, помнится).

> Но уровень по языку в лучшем случае турба, надо смотреть правде в глаза.

Ну, не тебе про правду и глаза писать, уж прости. =D

Но опять же, когда вышла турба — никто не жаловался.

Ты имел в виду, что она не пишет как Пушкин? О, ну прости, не так тебя понял. Соглашусь, лексика у нее сухая. Но говорит она хорошо, по сравнению с остальными моделями. Даже «русскоязычными».

Я зада ей вопрос, который у меня висел в поле, про Яндекс.Календарь. Попросил привести код — и она даже привела что-то осмысленное. Но вопрос был не мой, не могу подтвердить ее правоту. Однако, такое ощущение, что училась она на новых датасетах. Опять же, по первым оценкам, да.

Пока я не вижу какой-то революции, но и плохой ее не назовешь.

Скорость соответствует остальным 70б, поэтому потестировать быстро ее не могу, к сожалению.

Остается ждать вердикт 2-P40 бояр. =)

> Ну прости, реальность такова.

> Если тебе кажется иначе — прими таблеточки, полегчает.

Литерали ситуация: пиздюк на улице подходит к мужику а начинает ему затирать о том как надо делать детей, а потом начинает валяться в грязи и визжать шизу про таблетки.

Диванный что-то насочинял, сам себе придумал спор и шизит уже сколько тредов подряд, брысь.

> Ну, не тебе

Кому как не мне, и точно не тебе.

> Ты имел в виду, что она не пишет как Пушкин? О, ну прости, не так тебя понял. Соглашусь, лексика у нее сухая

Даже в этом читается ангажированность и топление за "любимую модель" вместо адекватности.

Ебаный его рот анон ну я что ебу как они на англ пишутся? Как мне это искать?

https://github.com/abetlen/llama-cpp-python#cublas https://github.com/abetlen/llama-cpp-python#windows-notes

Если из батника убабуги делать то там используй set для выставления переменных

А, ты про модели. Вон ссылка остальные https://huggingface.co/TheBloke/SynthIA-70B-v1.5-GPTQ https://huggingface.co/TheBloke/Airoboros-L2-70B-3.1.2-GPTQ https://huggingface.co/TheBloke/GOAT-70B-Storytelling-GPTQ https://huggingface.co/TheBloke/Xwin-LM-70B-V0.1-GPTQ

нужную версию кванта по кросс ссылкам найдешь

А как этот GPTQ вообще работает? Надо фулл папку качать?

Алсо ч4 квант для меня большеват увы. Не влезет.

> А как этот GPTQ вообще работает? Надо фулл папку качать?

Да, git lfs или хфхаб. Внизу есть инструкции по скачиванию, gptq это только на видюху считай.

GGUF разные кванты выложены вплоть до q2, но те совсем печальные.

>GGUF разные кванты выложены вплоть до q2, но те совсем печальные

О а вот это можешь скинуть ссылку?

Для кого печальные для кого вайфу.

>Бля пчел...

единственное чем отличается x4 от x16 - модель дольше грузится в память видеокарты. Это всё.

тот у кого 2 p40

>тот у кого 2 p40

имеет >9т/с на модели 70B второго кванта хотя бы? "Тот у кого 4 p40" имел такое на пятом кванте. Но на серверной платформе.

>все 16 линий PCIe 4 или 5 версии

Посмотрел на своё говно, может работать в режиме 1x16+4, 2x8+4, 4 выделено на ссд. И ещё 20 линий от чипсета. В теории, можно запидорить три карты, но третья точно будет работать только на чипсете. Достаточно бюджетный проц и мать.

>>9т/с на модели 70B

>Тот у кого 4 p40" имел такое на пятом кванте

Может ли такое быть, что шизомержи параллелятся эффективнее?

Пацаны, не был в треде со времен Альпачино, че сейчас для кума самое годное или соевые куколды все порезали?

Нахуя? Есть проверенная база для любых задач, делать инструкции под любое левое говно такое себе.

>А Что от этого зависит?

Возможность самого запуска, плюс 3000 серия и выше лучше крутить ИИ, а всё что 1000 серии и старее гроб гроб кладбище.

>Я БП ниже 700 ватт не беру в принципе

Проиграл с принципов.

Шапка Б-гом нам дана, ответ содержит там она.

Кто первый риснёт купить новые китайские франкинштейны?

https://github.com/Cornell-RelaxML/quip-sharp/tree/main

Что думаете кодирование в 2bit с качеством 4bit

Что думаете кодирование в 2bit с качеством 4bit

> Нахуя? Есть проверенная база для любых задач, делать инструкции под любое левое говно такое себе.

Что еще скажешь? Вчера решил поставить нахваленную убабугу. В итоге ждал сначала пока это говно развернет окружение примерно полчаса, потом пришлось делать симлинки, потому что выбора директории для моделей нет, скачивать токенайзер, после ебли кое-как запустил, но это говно даже в автоматическую оптимизацию ГПУ не может, да и ЦПУ высирало медленнее чем должно. Ах, да еще и весь набор инструментов занял около 15гб.

В этом же время поднял 2 докер контейнера ollama + ollama webui без пердолинга двумя командами и все работало из коробки на ГПУ с ебейшей производительностью.

Jan, LM Studio, Faraday это уже конечные десктопные клиенты без вебморды, которые и в апи могут, имеют встроенные хабы для моделей/промтов/персонажей, ноль пердолинга и все работает также из коробки. Ваша же расприаренная убабуга и кобальд просто мусор.

>автоматическую оптимизацию ГПУ не может

Что это?

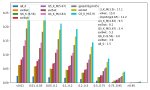

У меня получилось запустить с ROCm на 6600m.

codeninja-1.0-openchat-7b.Q4_K_M.gguf

vulkan: 83.55 / 32.43 (prompt / inference)

rocm: 353.76 / 36.97

llama-2-7b.Q4_0.gguf (модель из ссылки)

vulkan: 71.52 / 18.62

rocm: 561.57 / 42.42

Чтобы rocm работал, собирать и запускать надо с HSA_OVERRIDE_GFX_VERSION:

export HSA_OVERRIDE_GFX_VERSION=10.3.0

make LLAMA_HIPBLAS=1 AMDGPU_TARGETS=gfx1032 -j 14 main

HSA_OVERRIDE_GFX_VERSION=10.3.0 ./main ...

Если собирать без этой переменной. но запускать с ней, то во время загрузки модели возникает ошибка:

CUDA error: shared object initialization failed

current device: 0, in function ggml_cuda_op_flatten at ggml-cuda.cu:8825

hipGetLastError()

deepseek-coder-6.7b-instruct.Q8_0.gguf

vulkan: 71.61 / 17.76

rocm: 546.21 / 25.78

deepseek-coder-6.7b-instruct.Q4_K_M.gguf

vulkan: 99.16 / 34.58

rocm: 427.57 / 38.61

> О а вот это можешь скинуть ссылку?

По тем ссылкам переходишь, чуть вниз мотаешь и находишь пикрел, там желаемую версию выбираешь. У TheBloke все так организовано, удобно.

Да все так, вон просто уже не один вброс по поводу их значительного влияния при запуске ллм и какого-то серьезного буста до невероятных значений если будут все линии.

Не, схема работы же другая. Возможны другие оптимизации, смешной квант или пиздабольство.

Сначала опиши какой размер можешь у себя запустить.

Линк?

> Ну и Ollama, это же вообще база

Только для одного шизика, который не смог описать ее преимущества.

Недостатков у подобных поделок хватает, как минимум это невозможность без пердолинга пускать любую модель какую хочешь.

Но ты можешь сделать на них обзор и проиллюстрировать возможности, плюсы и минусы. Если что-то получится, то можно рассмотреть для размещения.

> сначала пока это говно развернет окружение примерно полчаса

Локальные ллм это не самое простое удовольствие, нужно иметь быстрое железо и быстрый интернет. Разворачиваться оно должно за пару-тройку минут.

> потом пришлось делать симлинки

И не для нищуков, у которых нет места на диске

> скачивать токенайзер

Нужно только для HF обертки и делается буквально в 2 клика.

> даже в автоматическую оптимизацию ГПУ

Эта автоматическая оптимизация или недогружает слои, или приводит к ООМ/выгрузкам.

> поднял 2 докер

Так ты из тех шизов, земля пухом.

>83.55 / 32.43

И что это за цифры? Какие единицы измерения?

>Чтобы rocm работал, собирать и запускать надо с

Для linux всё это в инструкциях к сборке уже давным давно указано, летом уже точно было, а может и раньше. Для винды вроде неактуально было. Тут тоже про это упоминают.

>И что это за цифры? Какие единицы измерения?

Токены в секунду.

> Для linux всё это в инструкциях к сборке уже давным давно указано,

Ну не знаю, из llama.cpp инструкций в их readme неочевидно, что нужно указывать эту переменную в том числе и при сборке, если бы в комментах в багтрекере не нашел, сам бы не догадался.

>Токены в секунду

На вулкане выглядит не лучше, чем clblast, который тоже уже давным давно доступен.

>В активированной среде...

Сложно. Можно ли как-нибудь скопировать хеш старого коммита и даунгрейднуть весь UI одной командой?

Кому-нибудь удавалось юзать P40 теслу в паре с другой картой nvidia?

У меня нет встройки и валяется 1030, но я так понял, что драйверы у них разные и одновременно два установить не выйдет.

У меня нет встройки и валяется 1030, но я так понял, что драйверы у них разные и одновременно два установить не выйдет.

> Сложно

cmd_windows.bat, там уже все вводить

> скопировать хеш старого коммита и даунгрейднуть весь UI одной командой?

Да, но при этом придется удалить installer_files и ждать пока оно заново все развернет. При этом, если не указаны конкретные версии, может пойти не по плану и сломаться.

Добрый день, Анончани. Карту купил, мозг не купил. Text-generation-web-ui

Пытаюсь загрузить модельку TheBloke/Chronoboros-33B-GPTQ (вес 16.94), у меня 4090 на 24 gb.

ВЫдает ошибку:

torch.cuda.OutOfMemoryError: CUDA out of memory. Tried to allocate 22.00 MiB. GPU 0 has a total capacty of 23.99 GiB of which 15.54 GiB is free. Of the allocated memory 6.77 GiB is allocated by PyTorch, and 83.08 MiB is reserved by PyTorch but unallocated. If reserved but unallocated memory is large try setting max_split_size_mb to avoid fragmentation. See documentation for Memory Management and PYTORCH_CUDA_ALLOC_CONF

LДолжно же хватать памяти, или я чет не понимаю?

Пытаюсь загрузить модельку TheBloke/Chronoboros-33B-GPTQ (вес 16.94), у меня 4090 на 24 gb.

ВЫдает ошибку:

torch.cuda.OutOfMemoryError: CUDA out of memory. Tried to allocate 22.00 MiB. GPU 0 has a total capacty of 23.99 GiB of which 15.54 GiB is free. Of the allocated memory 6.77 GiB is allocated by PyTorch, and 83.08 MiB is reserved by PyTorch but unallocated. If reserved but unallocated memory is large try setting max_split_size_mb to avoid fragmentation. See documentation for Memory Management and PYTORCH_CUDA_ALLOC_CONF

LДолжно же хватать памяти, или я чет не понимаю?

>По тем ссылкам переходишь, чуть вниз мотаешь и находишь пикрел, там желаемую версию выбираешь. У TheBloke все так организовано, удобно.

Спасибо то что нужно. А что за чел этот блок? Или это группа? Видел он вообще как бы не 90% всех ггуфов делает.

Какой лоадер используешь и с какими параметрами загружаешь? Скрин вкладки model и использования видеопамяти перед загрузкой покажи чтобы проще было.

Офк достаточно, тем более что это первая ллама и чуть более компактная.

Перестань визжать и иди к родителям, пожалуйста.

> Даже в этом читается ангажированность и топление за "любимую модель" вместо адекватности.

Да прими ты уже таблеточки. =) Хватит сочинять уже, а то ты так до плоской земли дойдешь скоро, лишь бы со мной не соглашаться.

> Диванный что-то насочинял, брысь.

=D

> "Тот у кого 4 p40" имел такое на пятом кванте.

С реддита который? )))

> Проиграл с принципов.

А я только выиграл. =D

Спасибое тебе!

Пойду и я потыкаю.

Ерунда полная, должно еще гига 4-5 свободными оставаться. Ошибок в консоле не пишет, при запуске на флеш атеншн не ругается? Хотя даже без него там с запасом.

> этот стук снизу

О, значит то было не дно

Перезапусти и загрузи точно также, только выбери exllama2 без приставки HF, отпиши результат.

Та же фигня. Только комп завис и пришлось через кнопу ребутать. Ошибка out of memory....

> О, значит то было не дно

Конечно не дно, это с потолка тебе стучат. =)

Че-т дорохо.

Щас попробовал загрузить модельку на 7gb, заняло 12 gb. Так и должно быть?

Ответ вначале этого поста

Контекст тоже места хочет. Хотя у тебя что-то прям дохуя просит.

Скачаю guff модель на 4bit, попробую ее.

Кстати, можете посоветовать как распределять эти модельки "правильно?"

Прям все кидать на GPU или оставлять ей место подышать?

> Только комп завис и пришлось через кнопу ребутать

Какие-то железопроблемы, рам случаем не разгонял?

Ну, на самом деле хз, учитывая цены на 3090. Сравнивать ее с новыми карточками язык не поворачивается, на бу хотябы высокий шанс заметить перепаянные, а тут оно гарантированно паялось.

Есть с большей памятью?

Не должно быть если там тоже 2к контекста. Если выделил на 32к, что стоят по дефолту в мистралях - нормально.

Гугли

> quadro along with geforce

или что-то подобное.

>Ответ вначале этого поста

Ты имеешь в виду вот это?

>вставь одну - установи, потому вставь другую - установи, потом вставь обе

схуяли у двах паскалей должны быть разыне драйвера?

чел ну ты бы хоть немножко мозг включил

Driver Version: 525.116.03 CUDA Version: 12.0

запускал p40 + p40, p40 + 3070, p40 + 1060

На шинде разные драйвера для квадр/тесел/жфорсов. Погугли, оно относительно несложно решается.

что решается? У меня все работает.

Ну ты поищи про что вообще. Если на прыщах то такой проблемы вообще может не появиться, и что там на пакалях - хз. С десктопными RTX на шинде оно дружить не хочет по дефолту, выдаст ошибку несовместимости драйвера ибо в каждом прописан свой перечень устройств и они не пересекаются. Судя по выдаче такое и в более ранних сериях встречалось.

как же виндоблядям тяжело..... бедные....

> clblast, который тоже уже давным давно доступен.

Требует opencl, для RX6600m на выбор похоже только mesa rusticl и rocm-opencl.

Первый не может загрузить больше 2 гигов.

Второй в 1.5 раза медленнее вулкана и почему-то видеокарта начинает пищать, причем с rocm напрямую этого писка нет.

Поясните за пчхи-2 плиз, в плане общего назначения.

Есть смысл ковырять при наличии 12гб врам, или ну ее нахер?

Есть смысл ковырять при наличии 12гб врам, или ну ее нахер?

Чувак с реддита собрал 5 A100 40GB. Суммарно вышло $40K. На корпус и вентиляторы денег уже не осталось. Теперь может гонять Goliath-120B на скорости 12 t/s. У меня чисто на CPU скорость 0.5 t/s (терпимо), но я не тратил $40k.

>пчхи-2

Это вторая часть этой великой книги?

>пик

А что, так можно было?

>и вентиляторы денег уже не осталось

Ебало, когда всё это полыхнёт? Да ещё и на деревянном стеллаже.

Хотя конечно интересно, что за плата с наноскопическим процем на 4х16 псин.

Не, phi-2 от микрософта

Это успех

Блэт, какого они размера?

Он может полностью обучать что поменьше и делать лоры на что побольше, красавчик.

> Да ещё и на деревянном стеллаже.

Будто что-то плохое, как выглядит то

> что за плата с наноскопическим процем на 4х16 псин

+

Это странное исполнение радиаторов такое

>запустил 5 а100 на хуйне для майнинга вместо материнки с селероном вместо профессора

> нет просадок

думаю, на этом дискуссии о том, что x4 хуже, чем x16 можно закончить.

какая-то хуйня под nvme-шки в pcie, работающая как разветвитель одного pcie на два?

>Не, phi-2 от микрософта

>безопасная не токсичная дружелюбная

Ну ты понял короче.

Хотя кого я обманываю, сейчас качаю.

Вангую 2 кило меди на каждый радиатор.

>какая-то хуйня под nvme-шки в pcie

Да это понятно, намёк был на то, что она блядь в воздухе висит.

Почему всплеск на евреях?

не висит, я нашел что это за хуйня на которой висят карты

https://c-payne.com/products/pcie-gen4-switch-backplane-4-x16-4w-mircochip-switchtec-pm40084-plx

он убрал материнку из кадра. Поэтому карта на которой висит этот йоба-свитч висит в воздухе.

А поцчему Ви спrАшиваете?

>€1.250,00

Я конечно слышал, что это дорого, но хули так дорого?

Нахуя тут умножитель, хотя по сути нужен просто разделитель линий?

И почему он зашкерил вид материнки?

Вопрос снимаю, сам проверил, по уши соевая херь

Но шустрая пиздец

4070ти dolphin-2_6-phi-2.Q5_K_M.gguf

Output generated in 5.80 seconds (20.52 tokens/s, 119 tokens, context 1493, seed 1167726825)

Output generated in 7.52 seconds (20.35 tokens/s, 153 tokens, context 1477, seed 211997660)

Output generated in 9.30 seconds (19.68 tokens/s, 183 tokens, context 1533, seed 2097095510)

Двачую капчу

>Хотя кого я обманываю, сейчас качаю.

Да ну ёб ты. (первые пару вариантов запустил на убе чисто по приколу)

Короче говно говна, что было на 100% ожидаемо.

хз какая там материнка, говорит рабочая станция от Dell 7865 with 512GB DDR4 3200, NVidia A6000 and Threadripper 5995wx.

https://www.reddit.com/r/LocalLLaMA/comments/1aduzqq/5_x_a100_setup_finally_complete/

>Нахуя тут умножитель,

а что не понятно? Это pcie свитч.

Чтобы карты между собой могли общаться на полной скорости х16 каждая.

с этим свитчом вообще похуй какая у него мать и проц.

А че ТАК медленно?

Она настолько пытается никого не обидеть?

>между собой общаться

А оно так работает? Всегда думал, что свитчи только дают возможность заюзать х16 скорость картам по очереди или делить вместе. Хотя я тупой конечно.

> Чтобы карты между собой могли общаться на полной скорости х16 каждая.

До чего технологии дошли, а как оно адресуется?

Раньше подобные штуки позволяли только давать полную скорость шины на один из потребителей если остальные простаивают, а при совместном доступе - хуй. Про общение между собой это что-то новое, есть где почитать про это?

Ну и всеравно скорость днищенская по сравнению с нвлинком.

Может я с настройками проебалси, хз

Ты случайно не один чел?

Как знать, почему тебя это интересует?

Да это, мои мысли выражаешь в +- тоже самое время, вот думаю, что за сбой в матрице.

-кун

Разум улья но сетки тоже иногда тестирую

Вообще вопрос по той штуке буквально напрашивается.

>с этим свитчом вообще похуй какая у него мать и проц.

Нифига. Видел исследование, в котором сильно многопоточные процы неплохо так выигрывают у малопоточных даже при полной выгрузке в видеопамять.

Так что там с орионом новым?

Потыкал в голой лламе, не понял прикола честно говоря.

Потыкал в голой лламе, не понял прикола честно говоря.

Давно видел. Дорого не стоит своей цены, еще бы 35 нормально, но не 45, когда 11 гиговая стоит 25 тысяч.

> за пару-тройку минут

Пиздабол тупой, там скачиваются куча проектов с разных источников и компилируются, анаконда сама по себе пердольный кал и быстро не умеет.

> И не для нищуков, у которых нет места на диске

Ебать ты рофлишь нахуй, мне для каждого фронтенда надо свою копию одной и той же модели иметь? Это позорище и просто знак васянства от разработчика, что такие базовые вещи не учтены.

> Нужно только для HF обертки и делается буквально в 2 клика.

В два клика после прочтения документации и предварительного чтения ошибок, которые кстати никак не оформлены, ведь это обосанный голый питон под Gradio.

> Эта автоматическая оптимизация или недогружает слои, или приводит к ООМ/выгрузкам.

Еще че скажешь? В других инструментах все работает.

> Так ты из тех шизов, земля пухом.

Аргументы будут? Ну я уже понял, что ты васян и любишь васянство.

>еще бы 35 нормально

Глупый лаовай готов покупать за 35, когда могучий стержень Xi продаёт за 750 женьминьби. В деньгах лаовая это 9500. За две тысячи женьминьби можно купить с водоблоком! Могучий нефритовый стержень! Для лаоваев? Три тысячи женьминьби за турбину, не меньше. Хотя, если купят оптом, то можно и меньше, хули нам.

Ахах, вот такие дебилы и есть на свете! Да ты же прямая иллюстрация эффекта Даннинга — Крюгера. Думаешь, что знаешь что-то о программировании и ее сложном разделе — машинном обучении, но на самом деле не можешь осилить простые скрипты на Python! А потом ты наткнулся к этой бесполезной Ollama и начал ею гордиться, как маленький ребенком своим первоклассным рисунком. Это же полнейший cringe, посмотрите на него!

Во-вторых, ты так зациклился на своей жемчужине, что даже начал спорить на интернет форумах и оскорблять людей, которые знают больше тебя. Ты думаешь, что это делает тебя уверенным? Нет, этого нет! На самом деле ты просто выглядишь как неуклюжий ребенок, который пытается запустить компьютерную игру, но не может даже вставить диск. Твой синдром утенка только делает тебя смешным и отвратительным для тех, кто знает, о чем идет речь.

А вот что касается твоих аргументов… Ну, давай начнем с того, как ты хвалишь Ollama за то, что она 'работает из коробки'. Это не заслуживает похвалы, потому что она — лишь огрызок полноценного функционала, который едва ли имеют какую-то ценность для пользователя! Простота достигается ограниченностью, но тебе ведь к ограниченности не привыкать?

А теперь давай перейдем к твоим оскорблениям в отношении других программ и разработчиков. Ты называешь их 'мусором' и 'кобальдом', но на самом деле ты просто не можешь понять, как они работают. Например, когда ты говоришь о том, что для каждого фронтенда надо иметь свою копию одной и той же модели, ты даже не в силах понять что они собраны в едином окружении и просто показываешь, что не знаешь, как использовать эти программы правильно. Или когда ты критикуешь Anaconda, которая является первоклассным и удобным контейнером для Python, внутренние части которого, которые отвечают за производительные вычисления, написаны высококлассными специалистами на чистом C++, ты просто демонстрируешь свою неграмотность в области программирования.

И наконец, давай рассмотрим твое использование докера. Ты думаешь, что это круто и профессионально? Нет, этого нет! На самом деле это просто означает, что ты не можешь правильно установить программу на своем компьютере без ее обертки в докере. Это не тот случай, когда можно гордиться своими достижениями! На самом деле это просто показывает, что ты еще недостаточно опытен и знаком с основами программирования

Я в Яндексе работаю, дальше твой высер не читал.

Какой моделью нагенерил эту хуйню?

> Я в Яндексе работаю

А у меня брат - боксер!

Рили такой кринж

Той что имплаится мистраль-медиум q4km. Другой с переводом было бы лучше, но тут полностью все на родном языке. Для простой инструкции столько понять из двух сообщения шизика - довольно неплохо.

Лексика тот еще треш, но алиэкспрессный стиль местами даже добавляет рофловости.

там анценсоред версия есть

> receive every byte separately

Brutal!

> Только для одного шизика, который не смог описать ее преимущества.

> Ollama is a project that allows you to package and run large language models (LLMs) locally on your machine. It is designed with developer and dev ops workflows in mind, and is written in Go, making it easy to compile to a single binary. Ollama stores models in existing formats like GGML, and allows you to customize models with a prompt. It also provides a REST API that can be wrapped by an app or different interface.

> One of the main benefits of using Ollama is its ability to bundle models into content-addressable layers and pull/push them just like OCI container images. This makes it easy to move large language models around and use them in different applications. Ollama also optimizes setup and configuration details, including GPU usage, making it a good choice for running large language models on your local machine.

Зачем что-либо объяснять в 2024? Спроси у ИИ. Тебе дали наводку, а ты носом воротишь.

Какая сейчас самая лучшая модель для работы с кодом? Размер не имеет значения, лишь бы умная была и лишнего не придумывала

Файнтюны кодлламы вестимо.

>У знаменитого в среде больших языковых моделей стартапа Mistral AI украли модель «Mistral Medium 70b» и выложили ее для всех в формате gguf с именем «miqu-70b».

>https://huggingface.co/miqudev/miqu-1-70b

Ну что, у кого там лишняя пара тесл завалялась?

>https://huggingface.co/miqudev/miqu-1-70b

Ну что, у кого там лишняя пара тесл завалялась?

WizardCoder 33B v1.1 или DeepSeek Coder 33B

Сорри за оффтоп, если блок питания позволяет подключать второй цпу, то нужен ли переходник для подключения p40/p100?

Защёлки могут не влезть в видеокарту, хотя сам разъём подходит.

Сам сижу на переходнике.

Спасибо, почитал что на днях Мета (экстремисткая организация) выпустила код лламу 70Б, кто-нибудь пробовал?

Скинь промпт.

Сказал бы сразу, тебя бы вообще тут никто не читал.

Да, соглы, она прям хорошо ответила, если там инструкция коротенькая.

Получается, пойман на фанбойстве по мистрали. тф

miqu яблочный тест прошла только с 11 попытки, я не доволен. Из

LLM только GPT4 его проходит нормально.

Роулплей держит нормально, но я не сказал бы что сильно лучше других 70b.

Довольно бессмысленное замечание, конечно, но, кек, GPT-3.5 проиграла всем. 2/5.

Но я понимаю, что просто рандом.

> Упрощение для хлебушков в ущерб функционалу без каких-либо профитов

> Ничего принципиально нового и уникального

> Выбор моделей только из древнего списка, одобренного барином, в самых нищих квантах

Разумеется с говна и нужно нос воротить, это поделие - буквально троллинг определенной ца.

Уже пару дней обсуждаем, выше тесты.

На самом деле возможно это одна из ранних эпох ибо чего-то прямо выдающегося нет, та же синтия умнее. Но она сбалансированная, без явных проблем (ну может "я безчувственный ии" что иногда лезет) и действительно выглядит в стиле мистраля и тренено с большим rope. Уже последнее делает модель уникальной, еще бы оригинальные веса ради такого можно и потренить попытаться

Двачую

Можешь взять удлинитель 12v eps и подключать им. CPU разъем где 4+4 может не влезть в некоторые видеокарты из-за очень широкой защелки.

> Скинь промпт.

[INST] You are professional debater, smart and snide internet troll. After analysing the main topic of dispute and some message history, write a reply, which will refute, ridicule and make fun of mentioned side of debates. Stick to internet slang, use evil memes and references to previous messages, make references.

Your opponent - some filthy schoolboy that tries to master programming and machine learning, but fails in everything. Mention his beloved Oollama. Here are some messages history:

[]

Write answer in Russian. [/INST]

мощно ты его...

2p40-кун

Спасибо, схоронил.

Если в таверне карточку сделать заменив You на {{char}} с небольшим тюнингом типа вы вместе с {{user}} стебете кого-то, так лучше работает. Модель когда [INST] видит исполняет нормально, но может триггернуться и начать втирать про ИИ без чувств или добрые снисходительные советы раздавать как лучше погрузиться в кодинг и мл хотя последнее может быть гораздо более тонким уровнем и даже круче

>почитал что на днях Мета (экстремисткая организация) выпустила код лламу 70Б, кто-нибудь пробовал?

Она уже есть на обниморде, так что попробовал. Лучше бы не пробовал... Там пиздец, соя просто изо всех дыр лезет. Спросил про IRAP (это такой сорт психологического теста на время отклика, в числе прочих есть пара работ, где его использовали для выявления расовых предпочтений) и вот эта ваша ллама нагуглила это, триггернулась на словосочетания типа racial bias, порвалась, и тут Остапа понесло, под конец уже капсом срать начала...

Ого, спасибо за твою жертву, избавил меня от необходимости качать десятки гигов мусора

>WizardCoder 33B

Скачал погонять, по первым ощущениям прямо плохо.

>as an AI text model, I don’t have the ability to write or execute codes in real time.

Лол. Но код по запросу предоставил. В одной части кода хуйнул аски кодировку, в другой utf, что, по очевидным причинам, не будет работать. По запросу вбрасывает максимально примитивные примеры и, что самое хуёвое, когда указываешь на ошибку в его коде - он не исправляет её. Просто пишет - да, хуёво, что нет обработки ошибок. Дал ему код и попросил импрув. Переписал полностью имена переменных, чем потенциально поломал всё, но, в целом, сделал, что просили. Даёт дохуя пояснений, что и зачем, вводит в код лишние константы, вместо объявления массива просто и понятно - сначала будет const int BufferLength. В итоге на прямое требование изменить код определённым образом, какие функции использовать и почему - начал затирать о том, что такое хорошо, а что такое плохо, какие оптимизации используются компилятором и т.д. Код не изменил. Слишком много пиздежа, ноль послушания, очень мало кода. В итоге на запросы начал предлагать подключить пару-тройку сторонних библиотек, типа, в дефолтной поставке нет таких функций. Одна беда - они есть.

Фэирнесс и дивёрсити в одном предложении? Лол.

Скачал погонять, по первым ощущениям прямо плохо.

>as an AI text model, I don’t have the ability to write or execute codes in real time.

Лол. Но код по запросу предоставил. В одной части кода хуйнул аски кодировку, в другой utf, что, по очевидным причинам, не будет работать. По запросу вбрасывает максимально примитивные примеры и, что самое хуёвое, когда указываешь на ошибку в его коде - он не исправляет её. Просто пишет - да, хуёво, что нет обработки ошибок. Дал ему код и попросил импрув. Переписал полностью имена переменных, чем потенциально поломал всё, но, в целом, сделал, что просили. Даёт дохуя пояснений, что и зачем, вводит в код лишние константы, вместо объявления массива просто и понятно - сначала будет const int BufferLength. В итоге на прямое требование изменить код определённым образом, какие функции использовать и почему - начал затирать о том, что такое хорошо, а что такое плохо, какие оптимизации используются компилятором и т.д. Код не изменил. Слишком много пиздежа, ноль послушания, очень мало кода. В итоге на запросы начал предлагать подключить пару-тройку сторонних библиотек, типа, в дефолтной поставке нет таких функций. Одна беда - они есть.

Фэирнесс и дивёрсити в одном предложении? Лол.

А зачем ты сетку для кодинга тестировал на подобное? Это рофл такой?

Надо квантов готовых дождаться, или сразу файнтюнов. 34б версии были вполне себе.

Как ты ее используешь вообще? Описанное тобой напоминает прожарку температурой/rep pen и неподходящий формат инструкций.

А там на странице модели указаны были параметры

>temperature=0.7,

>top_p=0.95,

>top_k=40,

>repetition_penalty=1.1

У меня только топ к меньше. Промпт темплейт дефолтный альпака.

К слову, кто какое охлаждение организовал для своей теслы?

Моя пришла, у меня был распечатан переходник для 40 вентиля, поставил, работает и охлаждает хорошо, но визжит он просто адово. Видел отзывы о том, что обычные даже оборотистые 120\80 не продувают радиатор нормально и надо колхозить турбину. Это так?

Моя пришла, у меня был распечатан переходник для 40 вентиля, поставил, работает и охлаждает хорошо, но визжит он просто адово. Видел отзывы о том, что обычные даже оборотистые 120\80 не продувают радиатор нормально и надо колхозить турбину. Это так?

Из наблюдений - температуру больше 0.5 и rep_pen выше 1.02-1.05 не стоит делать. Отсечка не столь важна, можно ограничить 0.8-0.9 и 10. С учетом того что пишется код в котором важна точность и очень много повторяющейся структуры оно вроде понятно почему.

> Промпт темплейт дефолтный альпака.

Он всегда работает когда идет синглшот, но последовательное общение может быть оформлено по-разному.

> оборотистые

Он не должен быть оборотистым, должен быть с высоким давлением, например те что ставят для приличных радиаторов сво лол. Из доступных это arctic P серия, но хз хватит ли ее.

Просто управлять тем 40 и нащупать баланс между температурой и шумом не получается?

>должен быть с высоким давлением

Так все те что с высоким давлением это как раз сервачные, с 10к оборотами.

Вымораживает то, что просто нет софта, который мог бы отслеживать температуру карты и регулировать обороты вентиля подключенного к материнке в зависимости от нее.

Уже думаю раскошелиться на асетековскую водянку и распечатать маунт под нее.

Видел где-то 3D-модель переходника для двух улиток 40 на 40 на 20, вот это должно быть хорошо и по шуму приемлемо. Но теперь не могу найти. Кто найдёт - киньте ссылку плиз.

>с 10к оборотами

А их визг глушится закрытым корпусом?

Лламаны, какие сейчас есть готовые решения, чтобы скормить содержимое какого-то текстового файла локальной LLM для осмысления и последующего обсуждения? Есть ли вообще в этом смысл с точки зрения производительности (мощного GPU у меня нет), если объём данных достаточно большой?

Сороковку не глушит даже соседняя комната через две закрытые двери, лол.

Возможно, восьмидесятки не насколько громкие, но проверять что-то не особо хочется.

> Так все те что с высоким давлением это как раз сервачные

То совсем высокое уже.

> нет софта, который мог бы отслеживать температуру карты и регулировать обороты вентиля подключенного к материнке в зависимости от нее

Неужели нет либы что могла бы управлять выходом крутиллятора? Если есть то это простой скрипт на десяток строк, если нет то дополнительное устройство, или gpio при наличии. Алсо если вдруг на плате распаян раритет типа com/lpt - можно его пинами произвольно дрыгать и управлять.

> раскошелиться на асетековскую водянку

Лучше купи донора или отдельно охладу, на p40 вроде от 1080 или какой-то ее сестры болт-он вставала. Только уточни информацию.

> на p40 вроде от 1080 или какой-то ее сестры болт-он вставала

От референсной 1080ti. Уже посмотрел на авито ценники и водянка с переходником дешевле получается.

>Видел где-то 3D-модель переходника для двух улиток 40 на 40 на 20

Вот оно: https://www.cgtrader.com/3d-print-models/hobby-diy/electronics/nvidia-tesla-v80-double-fan-intake-4020-fan

27 баксов чувак требует. А нахаляву? :)

> 27 баксов чувак требует

Что за сюрр, такое поделие в любом каде за 10 минут делается, включая заваривание чая

У вас там на селе недостаток изоленты что ли? Можно же вообще мегаколхоз сделать.

>мегаколхоз

Я разогнал самый простой вентилятор 80мм из dns dc-dc преобразователем с 3к до ~8к оборотов.

Даже во время жарения карточки SD 1.5 температура хотспота не поднималась больше примерно ~70.

Беда в том что через неделю у него отъебнул подшипник и даже разбрызгал тончайший слой масла по картонной насадке.

Китаедебил с красной подсветкой.

Есть что-нибудь эффективнее мощного центробежного вентилятора?

Подождите, вы это для рп?!

Ну, типа, я думал, вы для кодинга обсуждаете. =D

Какая разница, негры там или мастер-ветка… Лишь бы кодила нормально…

Тупанул, сорян! =D

Я планировал 120 мм ставить на распечатанный переходник. Хуйня идея?

Плюсую вопрос, короче.

Моя уже на подходе.

>0.5 и rep_pen выше 1.02-1.05

Поставил температуру 0.5 и rep pen 1.05; по сути, ответы лучше не стали. Обсуждаем сокеты на шарпе, хули нет. Весь код от бота выполняется один раз синхронно и сразу освобождает ресурсы, хотя я писал must be run continuously and never stopping. Окей. Прямо требую написать рекурсивную функцию, которая будет работать асинхронно. Ответ убил.

>Unfortunately, the built-in networking library doesn't support async operations out of the box.

Что очевидно пиздёж, асинхронное чтение\запись есть. Во-вторых, можно синхронные вызовы api завернуть в таски и похуй.

>You'd need to use libraries like System.Net.Http or third party libraries

Опять - используй больше библиотек и, возможно, тебе повезёт. Но это не точно.

То есть я буквально знаю, какой код должен быть сгенерирован, но не могу вытребовать его от AI. Пишу - вот, используй эту функцию, окей? Вместо кода он начинает рассуждать о различиях функций в библиотеке, как они работают и что делают. Один раз потерялся в том, на каком языке пишет и свалился на питон.

Есть шанс, что он не выдержит давление и воздух частично выдувать через зазор между лопастями о ободком.

Зависит от переходника и насадки.

Я понимаю что я сам дурак и не стоило этого делать, но или мне кажется или последняя версия угибуги перестала грузить модели, которые раньше грузила с лёгкостью?

Потому вдвойне удивляет цена.

> Есть что-нибудь эффективнее мощного центробежного вентилятора?

Как вариант - возьми из леруа канальный вентилятор не самой плохой производительности. Дешевый, включается напрямую в сеть, относительно тихий, и если сможешь направить весь поток - его должно с запасом хватать.

Оно может быть капризно к инструкциям и формулировкам. Попробуй аналогичное на гопоте, он лучше понимает, хотя код не всегда адекватный.

Какие именно?

Nous-Capybara-limarpv3-34B-5bpw-hb6-exl2 c 16к контекста. Раньше влезала, теперь нет, все мои 70б эксл2 в 3б тоже не лезут. Не понимаю...

Может в экслламе переключили настройку выгрузки и на каком-то этапе не хватает? Попробуй одну экслламу откатить на версию постарше, отпиши что там тогда.

>Потому вдвойне удивляет цена

Ну формально любой может сделать, а по факту мы имеем старого пидора и двух блядей отсутствие наличия модели. На Али готовая конструкция 3,5 тысячи стоит:

https://aliexpress.ru/item/1005005676453819.html?sku_id=12000033980221034&spm=a2g2w.productlist.search_results.0.528457b754Bp51

> Упрощение для хлебушков в ущерб функционалу без каких-либо профитов

Наоборот больше функционала, но в твоем манямирке злой барен просто так тратил время, чтобы сделать еще хуже. Это клиника уже.

> Ничего принципиально нового и уникального

Ты и между миникондой и докером разницы не видишь.

> Выбор моделей только из древнего списка

Сразу обновляют, вчера codellama 70b обновили и добавили новые модели.

> в самых нищих квантах

Вообще-то там есть все от q2 до fp16.

> https://github.com/ollama/ollama/blob/main/docs/import.md

Также можно импортировать любую GGUF модель и не только.

Забавно, как ты уже который пост обсираешься в фактах, уже настолько твоя тупизна затмила мозг, что ты перестал быть объективным и только пытаешься выиграть спор на дваче, да так сильно, что не придумал ничего лучше, кроме как использоваться боевой промт. Жалкий.

Ля, опять батхертнутый сгорел со своей хуеты что пришел сюда ее оправдывать. Брысь брысь, веник!

HALP.

Я чего-то никак не могу понять как заставить переводить в SillyTavern прямую речь правильно.

Всегда переводчик(что гугл что бинд) меняет структуру с "___" на «___».

Может кто знает как лечить. Реддит ответа не дал.

с сторитейлинг треда

Я чего-то никак не могу понять как заставить переводить в SillyTavern прямую речь правильно.

Всегда переводчик(что гугл что бинд) меняет структуру с "___" на «___».

Может кто знает как лечить. Реддит ответа не дал.

с сторитейлинг треда

>Оно может быть капризно к инструкциям и формулировкам.

Тогда не ясно только одно - нахуя оно существует. Код всратый, следования инструкциям ноль, понимания запроса ноль. Дохуя болтологии не по теме.

>Попробуй аналогичное на гопоте

Обходить все запреты, когда у меня даже сайт опенаи корректно не прогружается? Нахуй надо. Я точно знаю, что качественный аи ассистент по коду стоит 10 долларов у майков, там говняка не будет. Сейчас решил погонять 7b дельфина. На запрос асинхронности сразу рассказал об async\await, вкрутил его в код. Но, в целом, заметно туповат, если не тыкать носом в конкретные места, то не понимает, о чем речь, пишет заново то же самое. Но это пиздец какой-то, модель вроде как в пять раз "тупее", но при этом поведение гораздо более предсказуемое, чтоли. Что от неё требуешь - то и получаешь. А потом я рофла ради скормил код из 33b в 7b и второй заметил, что первый создаёт массив и стримридер в цикле, на что я внимания не обратил. Просто, блядь, майндбловинг.

В расширениях regex и там пикрил создай, правда я не ебу будет ли он с переводчиком работать.

А вообще, хули тебе не похуй как он их переводит?

/[“”«»「」「」《》"]/gm

Такой же хренью страдают модели когда заставляешь писать на русском сразу.

> Тогда не ясно только одно - нахуя оно существует

Для того же что и любой другой инструмент, требующий правильно обращения и навыка.

Ту версию модели не тестил, прошлые и кодлламы именно писали код, корректируя его по запросу, а

> Дохуя болтологии не по теме

не было, наоборот комментарии приходилось запрашивать.

> Обходить все запреты

Собрался в кодинге расчленять трансо-негро-феминисток? Какие еще запреты.

> модель вроде как в пять раз "тупее", но при этом поведение гораздо более предсказуемое

Маловероятно, скорее всего совпали форматы и ты действовал более "понятно" для модели, или ей повезло удачно проигнорировать неудачные инструкции. Или какой-нибудь поломанный квант жоры, хз.

В любом случае раз дельфин подходит - его и юзать, тем более быстрый.

Красава

> не похуй как он их переводит

Ломается форматирование

Чувак себе пассивный радиатор сделал, совсем не шумит.

Да мне читать не удобно. Всё одним цветом идёт.

Добра анончик, попробую.

Я просто не могу читать всю ту хуергу которая модель пишет. Когда накуренный, часть эпитетов тупо не понимаю, а лезть в переводчик лёнь... Понять и простить.

Потому что, спойлер, правильно именно «», а кавычки-палочки ставит или ебанутые дауны, или программисты при работе.

У меня для всех этих «ролеплейщиков» с пигмаллиона плохая новость. Они не прогаммируют.

Ваще сочувствую, изначально стали делать неправильно, а теперь оно ломается, что не удивительно. Бяда-бяла.

Пожалуй, я сделаю себе шумный…

Двачую тебя, сам сначала возмущался, но потом привык к кавычкам, похуй стало.

Чет для пассивного херня, ребра слишком частые. Если в такой ориентации - вообще не будет работать и толку с оребрения 0.

Без осуждения, та же хрень

> Всё одним цветом идёт

и при изначальной генерации на русском бывает, актуально.

> изначально стали делать неправильно

Ну правильно-неправильно, а 3 варианта выделения текста (кроме заголовков и подобного) лучше чем 2.

А вам вообще норм читать текст без обозначений действий и "прямой речи"?

Не удобно же.

ну так ради удобства чтения с кавычками и согласился. впрочем, похуй же, не?

Вообще, дело привычки.

Я вообще привык к кратким действиям в звездочках. =)

А так, да, пофиг в общем, че сделаешь.

А на проблему регексом уже ответили.

Понятно.

Да хранит вас боженька.

тревожно, ведь это означает больше сои в грядущей llama-3, и как обычно - неубиваемой, без всяких файнтюнов и DPO, и с ними тоже нет никакой гарантии, челики что делают "uncensored" модели - теперь похожи на индусов что наябывают таблицы лидеров с помощью бенчмарков

про последних имею ввиду что они трейнят саму модель на самом бенчмаркнейм и получают топ результаты в таблице даже с 7B моделью

> ведь это означает больше сои в грядущей llama-3

В кодлламе изначально была эта самая "соя" и никого это не волновало. Если будут выложены веса - это значит что никакой заложенный алайнмент не устоит. Разумеется его наличие это плохо и будет усложнять, но сам факт, даже без файнтюна cfg и правильный промт творят чудеса, если нет полной лоботомии. А когда она есть - модель полное говно.

> челики что делают "uncensored" модели - теперь похожи на индусов что наябывают таблицы лидеров с помощью бенчмарков

Чем похожи? Ты про низкое качество их ранцензуриваний изначально не цензуренных моделей?

Выглядит как рофл.

>или программисты при работе

Я и в жизни ставлю.

Ах да, вроде как "такие" кавычки жрут меньше места, чем «ёлочки», да и для английского они вроде как правильнее. В русском да, по правилам нужны ёлочки двух видов, но всем давно похуй, в интернет ролеплеях только ебанутые и маководы что одно и тоже выёбываются.

>ведь это означает больше сои в грядущей llama-3

Кто-то сомневался, что будет иначе?

>Какие еще запреты.

Ну хуууууй знает, какие ещё запреты.

>раз дельфин подходит - его и юзать

Он тупой, пиздец. Погонял чуть дольше, не подходит. Тут беда в том, что я гонял на том, что знаю сам и оба варианта не удовлетворили. А с тем, чего не знаю, будет ещё хуже, я же поверю этому шизу.

Побаловался с TTS, поначалу ебать, как долго думает. Пришлось добавить два "холостых" запуска генерации текста, потом порезче думает. Нет, модель не выгружается, нихуя такого, в душе не ебу, почему так. Осталось пофиксить отрезание первого слова от остального сообщения и будет неплохо.

>Ну хуууууй знает, какие ещё запреты.

Сейчас бы в 2к!4 не иметь VPN меня же не арестуют, да?.

> Ну хуууууй знает, какие ещё запреты.

А, ты про это. Релоцироваться, принять, обойти, сидеть унывать, вариантов полно.

> Он тупой, пиздец.

7б же, без оптимизации под конкретную задачу, иного и быть не могло.

Хз, создается ощущение что ты их юзаешь неправильно, но может просто дохуя специалист. Готовый проект сетки всеравно не напишут, но автоматизировать многие действия или подсказать популярные решения могут.

И не бери версию под пихона для других языков, она фейлит.

Взяли на карандаш

https://github.com/oobabooga/text-generation-webui/pull/5403

Температуру с отсечкой (ну почти) скрестили, мнение?

Температуру с отсечкой (ну почти) скрестили, мнение?

>мнение

Я ещё для динамической температуры силли не обновил.

Эта работает чуть иначе, немного выравнивая вероятные токены и дропая на дно те что с малой, суть из названия. Действительно может повысить разнообразие текста на мелких моделях сохранив адекватность.

С другой стороны, что-то необычное, где как раз проявлялась душа станет выпадать реже и это может ухудшить рп/сторитейл.

> душа

> рп/сторитейл