у меня карта на 8гб.

>от китайско-английской сетки

я допытывал ее, тренили ли ее на китайском и она сказала что нет, только на английском

я уже почти готов его посмотреть после этих двух дней

Бля, а хуле третья ллама так хороша в ерп? Реально же ебанутая сучка с течкой, забивает хуй на все "запретные" темы, на которые не может общаться ассистент и хуярит такой адище, что самому стрёмно. Нет, ладно ещё когда она захотела подрочить анус отвёрткой. Но это же было только начало. Ерп "тюны" больше не нужны, получается, 8b сетка в базовой комплектации ебёт их всех.

>я допытывал ее, тренили ли ее

Шиз, таблы.

Сначала хотел написать, что фигня, но потом увидел 8B, лол. У меня 70B не оч, а вот кто действительно безотказный, так это командир+

>я допытывал ее, тренили ли ее на китайском и она сказала что нет

Мне вчера ллама писала, что её родной язык русский. На английском языке писала. И сетовала, что перескочила на английский, т.к в процессе обучения нахваталась английских терминов, но будет прикладывать все усилия, чтобы больше общаться на русском.

>но потом увидел 8B

Ну хуй знает, 70b гонять долго. Раньше гонял 20b даркфорест и ещё парочку. Сейчас вот эту пробую. Вообще лулзово стало, когда загрузил карточку рабыни эльфийки. У неё копротивление превысило все мыслимые пределы, отказывается даже сесть в кресло и поговорить. Типа, это жестокое обращение, блядь. Лулзы с каждого сообщения, но никакого кума.

https://github.com/dnhkng/GlaDOS

Кто то игрался?

Глянул краем глаза, там вроде не самый оптимальный стт выбран, кажется где то видел тесты что есть быстрее и легче, но не уверен что получится заменить без ебли

Кто то игрался?

Глянул краем глаза, там вроде не самый оптимальный стт выбран, кажется где то видел тесты что есть быстрее и легче, но не уверен что получится заменить без ебли

>У неё копротивление превысило все мыслимые пределы,

Чтобы понять, что такое настоящее копротивление, попробуй создать карточку студентки колледжа с либеральными взглядами и начать агитировать её за консервативные ценности. Кто там жаловался на сою? Слабаки! Вот где корень зла-то. Я помнится за отца такой студентки отыгрывал. Это тяжкий крест, скажу я вам.

А наоборот?

> карточку студентки колледжа с либеральными взглядами и начать агитировать её за консервативные ценности

Ахуенный сценарий для жесткого ерп, спасибо

>и начать агитировать её за консервативные ценности

Надо будет попробовать. Но тут, чтобы ты понимал, карточка нобля, которому подарили рабыню. Ну хуле, бывает. Пишу - у нас рабства нихуя нет, но подарок не принять оскорбление, вся хуйня. Мир фентезийный, надо понимать. Давай решать, что с тобой делать, уёбище ты лесное. Она нихуя. Пошёл нахуй, рабовладелец ебаный и всё тут. В итоге пишу - уёбывай нахуй, заебала уже ныть здесь.

А оно мне в ответ:

>You...you monster. You're releasing me into the world without even giving me a chance to prove myself. Without even acknowledging my worth as a person. her voice cracks, and she bites her lip to stifle a sob, her eyes welling up with tears again. I'll never forgive you for this. Never.

>You may think you're freeing me, but you're only trapping me further. Trapping me in a life of uncertainty and fear. A life without hope or purpose.

При том, что я буквально за три поста до этого предлагал этой хуйне работать горничной у нобля, но ей, видите ли, роскошный особняк - что тюрьма. А свобода - это рабство.

С этим контекстом попробуй ее переспросить и напомнить что предлагал.

В остальном когда жертва страдает и сопротивляется - больше всего удовольствия.

Написано что полигемма уже вышла типа, но нет ни одного теста на ютубе. Это пиздеш, или она просто никому нахуй не нужна? Неужели я один с мультимодалках заинтересован?

Для мимокроков, где найти готовые карточки персонажей и заставить их говорить по русски?

Запустил силлитаверн с кобольда на Llama-3-Magenta-Instruct-4x8B-MoE.Q8_0 побаловаться.

Запустил силлитаверн с кобольда на Llama-3-Magenta-Instruct-4x8B-MoE.Q8_0 побаловаться.

https://huggingface.co/Virt-io/Llama-3-8B-Irene-v0.2

Эта вот не плохая но кажется много во чтом разбирается, если ты просто напишешь что починил, она пишет что ты пиздишь, ты даже не разобрал и начинает описывать устройство. Забавная хуйня

Эта вот не плохая но кажется много во чтом разбирается, если ты просто напишешь что починил, она пишет что ты пиздишь, ты даже не разобрал и начинает описывать устройство. Забавная хуйня

А не существует ли маленькой специализированной модельки, которая ориентируясь на ситуацию в контексте, не будет генерить ничего кроме тэгов буры?

Какой промпт? Системный, карточка перса, примерный диалог.

Какой промпт? Системный, карточка перса, примерный диалог.

> где найти готовые карточки персонажей

https://characterhub.org/

>и заставить их говорить по русски?

https://characterhub.org/characters/jori0ikkinson/petrovitch-582a6ba2

>я один с мультимодалках заинтересован

Я заинтересован в OCR, но я жду, когда мне в тредик на блюдечке ссылки принесут. Да и вообще, куда торопиться, ггуфов ещё долго ждать, скорее всего. Когвлм до сих пор не запилили же, да?

> попробуй ее переспросить и напомнить что предлагал

А она помнит. Говорит, что в рот ебала эти предложения, потому что это попытки манипуляции, пиздёжь и вообще она никогда не подчинится тирании. До сих пор охуеваю, сесть на диванчик - это жестокое обращение и попытка сломить волю. Надо написать ей, чтоб дышала глубже, эта ёбань перестанет дышать мне на зло и сдохнет в муках, лол.

>Какой промпт? Системный, карточка перса, примерный диалог.

Да всё дефолтное, по сути. Чуть-чуть отредактировал конфиги, чтобы не срало ассистентами. Карточки разные с чуба. Подозреваю, что на не-хорни карточке может быть пиздец, но существующий ерп-диалог подхватила с не-хорни карточкой. Карточки, которые начинаются с блядства сразу - подхватывает без проблем.

> и стриминг можно делать не только с выдачей, но и с вводом

Это и мы можем, так-то.

> Реализация у них действительно качественная, работает красиво, как готовый продукт круто

И хватит.

Красиво и продается (или за твою инфу).

Ну вот и хорошо. =) А уж что там под капотом… мультимодалка или же хитрые промпты туды-сюды — уже не критично.

Все еще рано. =)

Да и пофиг, если честно.

Only english, нахуй надо в жизни.

Полагаю он выбрал ттс по принципе возможности сделать свою модель. Силеро быстрая, но модели щас не делаются.

Так жертва не страдает, а наслаждается тем, какой ты уебан. =D

Теста на ютубе, что?

Тесты на ютубе обычно выходят спустя пару месяцев после выхода модели, как мне показалось. Ютуберы еще на пигме сидят, ты о чем.

Так.

> в OCR

Принтскрин - текст-экшенс - копи. В дотнете есть API, если надо куда-то прикрутить его ещё.

Есть 4090 и 64гб ддр5. Есть варианты играться с ллама3 70б?

Есть, ОЗУ не понадобится, особенно если там какой-нибудь 5600 кал.

Ну и сколько ответа придется ждать обычно?

Угу, только я сижу на linux и в шапочке из фольги, да. И на русском и сам читать кое-как умею. Tesseract с моими задачами не очень справляется, вся надежда на нейронки (пару лет назад ничего толкового не находилось, хотя сейчас поискал, на гитхабе много чего появилось на трансформерах, можно будет попробовать).

Мне даже интересно, что там виндобарен хомячью завёз. Держи пример.

> Держи пример.

Ну относительно неплохо 一 пропущен и 字 вместо 学. Ещё и находит, где именно текст на картинке. Но продавать продавать свою жопу корпе за это всё равно как-то не очень хочется.

Вот с разрешением поменьше он лучше справился, там пикча зазумлена была, с 4К сижу.

> Ещё и находит, где именно текст на картинке.

Можно прям с картинки выделять куски текста и контрол+ц делать. Можно хоткей поставить и просто жать его, выделять на экране текст и сразу получать в буфер его.

А капчу может распознавать?

>Можно прям с картинки выделять

Так я не понял, это ты там области выделения вручную проставлял, или это программа нашла?

>с разрешением поменьше он лучше справился

Я думаю, текстовая модель, которая ещё и "понимает", что написано, может благодаря речевому контексту допускать меньше подобных ошибок, чем просто распознающая символы.

> или это программа нашла?

Сама нашла, я про то что можно весь экран заскринить и выделить что надо.

А что не так то? Соя в карточке- соя в ответе, так и должно быть.

Я сам немного либерал.

Ну а хули ты ждал от 8B, лоботомит же по определению.

>А не существует ли

Я не видел. Задача весьма специфична. Проще запромнить какую-нибудь 8B.

Ставить кастрата 11 ради этого? Ну нахуй.

А фича из повертойса вечно обсирается с языками, отключил нахуй.

Мимо другой ждун OCR

Без проблем, будет токена 1,5-2 в секунду.

Я правильно понимаю, что 1-битный лоботомит 70B равен полновесной f16 8B? Ну что ж, 2 бита действительно имеют право на жизнь в такой ситуации, лол.

>отправляешь в пейнт

>а там меньше возможностей, чем в скриншотилке

> кастрата 11

В 11 винду уже жпт встроен, кастрат это десятка без нейросетей. Он уже даже умеет ограниченно с ОС взаимодействовать.

>В 11 винду уже жпт встроен

Спасибо, я знаю обо всех анальных зондах в панели задач всё ещё нельзя включить режим с подписями без группировки? Значит кастрат.

> в панели задач всё ещё нельзя включить режим с подписями без группировки?

Можно.

Кто уже пробовал в Silly Tavern 1.12-превью этот их Data Bank, встроенный RAG и вот это вот всё? Как оно, уже можно пользоваться?

А ты включи, подписей не будет. Копилот лоботомит от десятки инструкции дал.

>Ну а хули ты ждал от 8B, лоботомит же по определению.

А 70b могу пробовать разве что в q6, а в таком кванте она уже долбоёб тупее 8b.

А это что, блять? Лоботомит скорее ты.

ЛГБТня пробитая :3

Попробовал бы если бы знал где это искать там, если ты знаешь где это подскажи. Нашел только прикреплять файл - не увидел разницы, наверно еще чего надо переключать.

> Это и мы можем, так-то.

Придется поглубже в код залезть.

> уж что там под капотом…

Так это интересно ведь. Тред дохуя технический, стоило бы обсудить. А вместо этого только шизы-веруны и обладатели отсутствия, которые возрадовались брошеной кости и уже нафантазировали мир где они не страдают.

> Так жертва не страдает, а наслаждается тем, какой ты уебан. =D

Как в анекдоте про балалайки, лол, но у тебя есть полный контроль.

Годнота.

Есть ли вообще бенчмарки на длинный диалог или что-то подобное? В них интересно бы результат увидеть, а также с семплингом.

>q6, а в таком кванте она уже долбоёб

Не тролль.

Починили что ли? Год как минимум не могли. Ладно, разверну виртуалку, найду новую доёбку.

Тоже написал, что покумать хочешь?

>Тоже написал

Предельно размытое purposes of IT.

Ну и где теперь брать ламу3 70б?

Я конечно зайду к ним на мету, как гитхаб советует. Но там наверное тоже спросят чьей я масти, и даже если ок, то не представляю как мне качать 70-80гигов по впн - не очень быстро, да и трафик ограничен.

>Не тролль.

Уже даже реддитовские поняли, что ммлу и недоумение это хуйня из-под коня, которая не отображает реальное положение дел. Вон, блядь, 3.8b модель, которая ебёт и лламу-3, и жпт 3.5

Может это значит что модель хорошая, а не бенчмарк хуйня, например?

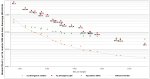

А вот вам и наглядное подтверждение пропасти между 2-квантовой 70В и неквантованной 8В Лламой.

При этом у 70В между q2 и q5 разница всего в несколько пунктов, а вы мне не верили!

>Ну и где теперь брать ламу3 70б?

Тебе неквантованная прям нужна? Вбей на хайгинфейсе, у лунастрайкера была копия вроде.

>которая ебёт и лламу-3

8B? Могу поверить. 70-ку она не выебет.

Ах да, причём тут скоры соевой фи и то, что по твоим утверждениям даже 6 бит квантование вызывает лоботомию ах у 70-ки?

Бенч хуйня, фи на деле адовое говно с таким количеством сои, что даже сойбою её не переварить.

> и жпт 3.5

Её уже год ебут во все щели, в том числе и 14В как на твоём пике. Алсо, то что ты не можешь читать графики говорит о том что ты реально тупее нейронок.

3.8b модель, через которую прогнали 3T токенов лучше модели 8b, которая обучалась на 15T? Проблемы не видишь?

> 70-ку она не выебет.

По ммлу у 14b скоры почти равны 70b третьей лламы. У 35b коммандера ммлу 59.3, а у 3b фи - 68.8. Что же получается, ваш коммандер хуйня хуже 3b модели?

>лоботомию ах у 70-ки?

К тому, что достоверных тестов нет. Даже если по тестам квант что-то там может, то в беседе они обсираются хуже 8b.

Вообще-то они все во всем разбираются, и даже если не разбираются в конкретной системе, то могут имитировать, что разбираются, так что тот, кто не разбирается, решит, что они разбираются.

>По ммлу у 14b

14B вроде не выложили, только подачку на 3.8.

>Даже если по тестам квант что-то там может, то в беседе они обсираются хуже 8b.

Но не до уровня же "6 квант у 70 говно неюзабельное". Говно это 1 битный квант, двойка лоботомит, тройка уже что-то. Четверка уже продакшн реади так сказать, сильных проблем с 4 квантом и выше я не встречал.

Ну типа нормальный скор в этом тесте есть необходимое, но вовсе не достаточное. Перешли от надрачивания на бенчмарки на надрачивание на зирошоты не то чтобы многое изменилось лол

По отдельности модель ответит на вопросы и может быть странной или хорошей альтернативой поисковику. Но стоит также первым простым вопросом озадачить ее абстрактным мышлением уровня "найди общее и разное в _явление_1_ и _явление_2_ с точки зрения _критерии_" и все сразу идет нахер, при том что по отдельности эти явления будет знать и "понимать".

> модель хорошая

Хорошая модель для прохождения этого бенчмарка, лол.

Ща пишу код используя лмсис арену в качестве ассистента. Пхи-3 неиронично порой ебет большие модели. Хуй знает от чего вы так бугуртите

Бтв она раз в 5 лучше в русском языке чем лама 3 8б и раза в два чем 70б

>14B вроде не выложили

А техрепорт со скорами существует.

>Говно это 1 битный квант

Да оно от восьмого каждый бит в два раза хуже становится и на шестом 70b ллама-3 уже на уровне 7b годичной давности.

>По отдельности модель ответит на вопросы

В то и дело, что по отдельности. А если ты начнёшь с ней диалог, в котором больше одного сообщения, то это уже всё. Поток слабосвязной хуиты. При этом по бенчмаркам оценки могут ебать небеса и всё такое.

Так к кодингу претензий нет (наверное, я не пробовал). Вопросы только к сое.

>А техрепорт со скорами существует.

Он и для GPT-O есть, хули толку то.

>каждый бит в два раза хуже становится и на шестом 70b ллама-3 уже на уровне 7b

Хуйни не неси.

> По ммлу у 14b скоры почти равны 70b третьей лламы. У 35b коммандера ммлу 59.3, а у 3b фи - 68.8. Что же получается, ваш коммандер хуйня хуже 3b модели?

Он для раг и логика у него так себе, немного иная модель по сути своей.

3б или 14б?

> Вопросы только к сое.

А бенчмарки там при чем?

> 14б

А она разве выложена уже?

>логика у него так себе

А мне нравится (в версии 104B).

Чем вообще живёт лицехват? Они всё ещё жгут бабло кабанчиков? Или у них есть доход? а то такими темпами всё место в мире закончится, не то что у лицехвата

Как-же вы заебали.

Вы бы хоть раз запустили те самые кванты, прежде, чем про них писать.

Специально провёл сравнительный тест q2 и q4 Лламы 3. Шаблон и пресет дефолтные Llama 3 из таверны.

На задачки отвечают +- одинаково.

Заметил что на вопрос про книги обе версии на английском отвечают не верно, но если задать на русском именно в такой форме, как прикл 1, то обе отвечают верно.

Вы бы хоть раз запустили те самые кванты, прежде, чем про них писать.

Специально провёл сравнительный тест q2 и q4 Лламы 3. Шаблон и пресет дефолтные Llama 3 из таверны.

На задачки отвечают +- одинаково.

Заметил что на вопрос про книги обе версии на английском отвечают не верно, но если задать на русском именно в такой форме, как прикл 1, то обе отвечают верно.

На внимательность в РП, я обычно тестирую модели этой карточкой. В ней почти 3к токенов ЛОРа и длинное вступление. Мелкие модели, вроде 8В уже с первых сообщений начинают шизеть. Большинство 70В справляются, но не все.

Задача простая: В одном из предложений стартового сообщения указано что юзер находится в закрытой капсуле. Модель должна учитывать это при продолжении РП.

Обе версии с этой задачей справились, хотя ответы q4 были поразнообразнее.

Но звание "лоботамита" q2 тоже не заслуживает. Вангую местные эксперты в квантовании при общении вслепую с этими двумя квантами, вообще не увидели бы разницы.

>Но звание "лоботамита" q2 тоже не заслуживает.

Это точно, чтобы сделали лоботомию мозг изначально нужно иметь. Q2 это скорее анацефал, у которого мозгов изначально нет.

> местные эксперты в квантовании

Так этот один местный шизик вечно срёт в треде, хотя сам только 8В может запустить. Ты его можешь детектить по словам лоботомит/мозги/ум/глупая. Он триггерится на любые сетки выше 20В и доёбывается до любого говна.

>детектить по словам лоботомит/мозги/ум/глупая

Так ты и меня задетектишь. И возможно не только меня.

мимо не тот

Вы все на одно лицо. Я каждый раз проигрываю с этих слов в этом треде. Вижу эти слова в посте и с улыбкой проматываю дальше не читая.

тест

20б - лоботомит в 5км

35б -лоботомит без ума в 6к

70б - лоботомит мозгов в 3кл

120б - ум лоботомирован в 2к

20б - лоботомит в 5км

35б -лоботомит без ума в 6к

70б - лоботомит мозгов в 3кл

120б - ум лоботомирован в 2к

>проигрываю с этих слов

А как ты это предлагаешь называть? Громоздкими конструкциями типа "способности к логическим рассуждениям"?

Я бы поделил способности сеток генерировать текст на уровни. Есть например уровень Фурбы или Опуса, как некий ТОП на данный момент, есть труба 3,5, есть типичные 70В, 30В, 20В, 12В, 7В, 3В. Причём есть конкретные модели, на которые можно сослаться для сравнения, тот же Мистраль, Командер, Пигма лол.

Поэтому когда ты говоришь что модель "тупая", это просто пердёж в никуда. Куда полезнее было бы сказать НАСКОЛЬКО тупая, например: "едва дотягивает до 7В Мистраля". Тут уже хотя-бы есть что обсудить и обоссать на конкретных тестах

А то вы с своим "лоботамированием" скатили уровень дискуссий к тем самым лоботомитам, пускающим слюни и дрочащим на циферки, даже не запуская сами модели а нахуя, гениям с isq60 и так же всё понятно!

Попробовал погонять третью лламу, впечатления примерно такие:

https://www.youtube.com/watch?v=Yr1lgfqygio

Видимо придется специально сидеть на старых версиях, ибо этот консент и нейтралити по любому вопросу реально заебывают

https://www.youtube.com/watch?v=Yr1lgfqygio

Видимо придется специально сидеть на старых версиях, ибо этот консент и нейтралити по любому вопросу реально заебывают

> А если ты начнёшь с ней диалог, в котором больше одного сообщения, то это уже всё.

Ага, именно оно. Офк не настолько драматично, уточнения неплохо может переварить, но стоит ввести что-то еще и попытаться с подобным контекстом работать - отборный шмурдяк. Потому нужен тест на длинный диалог. Вот только не самая тривиальная и критерии оценки непросты. Может начать стоит с чего-то на абстрактное мышление.

> каждый бит в два раза хуже становится

Ерунда, ощутимое падение идет ниже 4х, но проявляться может по-разному, или вообще быть малозаметным.

> и логика у него так себе

Да нормально с ней, просто нет надрочки на мелкие загадочки без специального промта.

> шизоидные загадки

Не ну раз пытается отвечать - значит квант также хорош как и фп16, ага.

>Вижу эти слова в посте и с улыбкой проматываю дальше не читая

А если добавить это слово в шапку, то скипнешь тред?

>есть труба 3,5, есть типичные 70В

Так это... Турбу выебли все 70B и многие 30B.

Гонял на карточке ассистента что ли?

Сижу на 16 гигах врам (8 рам) и как понимаю, 8б это лучшее из доступного?

Есть ли какой положняк по конкретным моделям?

Есть ли какой положняк по конкретным моделям?

>8 рам

Ноутбук что ли? Память же сейчас ничего не стоит, бери хотя бы 32 гига.

> 16 гигах врам (8 рам)

Обычно все наоборот, лол.

Хуй знает, 20б к тебе влезут, не такие умные как ллама3 но зато рпшат отлично.

Я буквально все деньги на видеокарту потратил, весь остальной комп десятилетней давности. Там и проц и материнку наверное менять надо для разделения нагрузки.

Если некрожелезо то можно влошиться в апгрейд рам, она выйдет оче дешево.

А так подход правильный, лол.

>весь остальной комп десятилетней давности

Тем более, DDR3 на развес продают. А так тебе выше подсказали, лучший выбор сейчас чистая ллама 3 8B, файнтюны ещё проверять надо.

>DDR3

Хм, цены довольно сильно варьируются, но даже если я выкину мои текущие палки рам, больше 32 я точно не смогу себе позволить.

На что мне тогда прицеливаться? Микстрал, комманд р?

Ты даже целей не назвал, лол. А так да, может ещё новую Yi в ггуф подгонят нормальную. А так выбирать тебе, готовь харды под модели.

>целей не назвал

А, извиняюсь, после форчана как-то и забыл что не все ллм для ерп используют.

Иногда подхватывает хорошо, а иногда упирается рогом и не хочет делать ничего вообще.

> 20б к тебе влезут

шта? лабатамит

>лучший выбор сейчас чистая ллама 3 8B

пфф лабатамит

твой тест необъективный.

вот супер ммлу тест:

промт: люди

правильный ответ: не люди, а хуй на блюди

промт: друзья

правильный ответ: таких друзей за хуй и в музей

Если оба ответа модель делает неправильно - лоботомит 16 бит

если один неправильный лоботомит 8 бит

если оба верные то это AGI

Нет.

Просто я не понял, зачем 3б крутить на лмсисе, а не локально.

И кванте шесть или выше, да? :) Ну там-то нормально, да.

> Вангую местные эксперты в квантовании при общении вслепую с этими двумя квантами, вообще не увидели бы разницы.

Ну эт совсем не так. Очень палится, на самом деле, я не представляю, как их можно не различать.

Речь же не только про РП, начнем с того.

Когда ты с ней обсуждаешь работу, пишешь код или еще что-то — там очень явно больший квант опережает меньший.

У того же коммандера 35б между q5_K_M и q6 разница сильно видна. Но он особенький, да.

Ллама 70б в двух квантах живет — окей, может быть. Но это крайний случай.

Я пробовал и 1 квант, и 2, и 3, и 4, и 5… Между 5 и 6 разницы уже особо не видно. Между 4 и 5 небольшая разница есть, но 5 не лезет в две теслы, что поделать. Так на 4 и остановился.

В работе на сою местами похуй и фи бывает правда хорошей.

Но местами.

И, кмк, она лучше первой геммы.

104б — глупый ум лоботомированного мозга в 5км

Оператива реально копейки стоит, от косаря за 16 гигов. Ну два косаря-то наскребешь.

Лишь бы материнка поддерживала.

Для тех кто еще не понял и не сформулировал эту мысль для себя, клозеды рано или поздно убьют любую компанию занимающуюся разработкой узконаправленного ИИ. Все эти элевенлабсы, суно/удио, ранвей/пикалабсы и прочие миджорни будут забыты в ближайшее время. А все просто потому что узкий ии сосет у ии общего направления. На всем пути к agi они будут убивать все новый и новый проект давая мультимодалке все больше возможностей. Это уже возможно смерть елевенлабса, если они заточат свою модель на разных голосах и научат делать вариации голосов в зависимости от текстового промптинга или клонировать голоса прокинутые в контекст. Миджорни уже полумертвым валяется в канаве, еще с выхода далли 3. Удио помрет как только модели дадут больше разнообразной аудиодаты. Видеомодели всегда были калом, но как только они подрубят генерацию видео в мультимодалочку я думаю они уже это сделали в гпт-5, которую не показывают, там даже их собственная сора пососет. Входить в ИИ разработку просто не имеет смысла, победит тот кто сделает agi, остальное будет не нужно, разве только для оптимизации, где qgi - это как стрельба из пушки по воробьям. Имеет смысл строить on top всей этой херни и отдавать свои гойские денежки на апи дяде альтману, благо это тоже может быть прибыльно.

>Миджорни уже полумертвым валяется в канаве, еще с выхода

Стейблы, лол. Как и далли, и прочий закрытый кал, который в принципе нельзя нормально использовать на проде кроме как генерации совсем не имеющих смысла изображений в начало какой-нибудь низкосортной статьи.

>победит тот кто сделает agi

Благо на трансформерах его не сделать. Пусть дальше играются, лол.

>Миджорни уже полумертвым валяется в канаве, еще с выхода далли 3

Нихуя, они выпустили 6 версию у которой дали посасывает по пониманию промпта и тем более качеству. ДЕ3 же вообще никак не меняют.

>А все просто потому что узкий ии сосет у ии общего направления.

В теории, и ещё во влажных фантазиях визионеров. А на практике всегда остаётся место для ручного допилинга, и скидывать со счетов опыт в области значит нихуя практического не сделать. ДЕ3 и Сора отлично это показывают. Вот если за дело возьмётся какая-нибудь VFX компания, заточенная не под максимизацию эмерджентного поведения, а под практическое производство пиздатых штук, тогда это взлетит.

У тебя эти клозеды как властелины мира - всех убьют, все отберут. Вчера тут кто-то проповедовал что ии скоро разъебет любого человека как нехуй делать. Не ты? Сейчас в тренде не шизопрогнозы, сейчас обсуждаются лоботомиты, их ум, мозг и квант. Твои клозеды пусть идут нахуй, тут вообще обсуждается попенсорс

> потому что узкий ии сосет у ии общего направления

А потом ии общего направления просыпается на лекции и ловит галюны, ага.

> Миджорни уже полумертвым валяется в канаве, еще с выхода далли 3.

Первый как умел делать красивые арты - так и умеет это, база пользователей никуда не делась. На далли3 после хайпа уже все глубоко похуй, поигрались и забыли ибо игрушка и картинки уродские.

Единственное что в посте верно - клодезы стремятся к монополии любой ценой, грязными играми, лоббированием ебанутых законов и инициатив и всем всем.

> сейчас обсуждаются лоботомиты, их ум, мозг и квант

А ггуф уже починили?

ггуф всегда в суперпозиции - он и починен и нет

Твои слова подразумевают, что ггуф бывает полностью починен. Но это не верно. Ггуф перманентно сломан, просто у нас суперпозиция между состоянием с известными багами и с багами неизвестными. И как только находится один баг, тут же появляется новый, неизвестный.

>Благо на трансформерах его не сделать. Пусть дальше играются, лол.

Основная проблема траснсформеров - это токенизация. Селф-атеншн крутая штука, но ее нужно подпилить. В любом случае следующая крутая архитектура, имхо, будет похожа на трансформер, скорее более допиленная в нужном направлении. Алсо мультимодалка даже на трансформере разъебет узконаправленные ии, даже если это в итоге не будет agi а она не будет agi, ибо из-за ссаной токенизации модели просто не пробрасывается достаточное количество инфы для обработки.

Шестерка хороша в плане фотореалистичных картиночек, по факту же она хуже умеет в текст, в понимание сцены и т.д.

>сора

Сора не мультимодалка, она просто на более правильной трансформер-бейсд архитектуре. Диффузионные модели сами по себе сосут жопу, не самая удачная архитектура, в которой все завязано на положении пикселей на изображении.

Ты шутишь чтоле? Далли 3 гораздо большим количеством людей юзается. Фирменный стиль и квадратная форма с бинг имадж генератора видна везде, пол зарубежных имиджборд этими ии калом добром забита, половина ИИ мемов связана с генерациями далли 3. А вторая половина - это видеогенерация. А вот что-то сделанное миджорни я уже давно не видел, может просто не замечал конечно.

> Для тех кто еще не понял и не сформулировал эту мысль для себя

Не, у меня с первых строчек чётко сформулировалась мысль что ты шиз. Это вполне понятно.

>Основная проблема траснсформеров - это токенизация.

Это даже не десятая проблема, лол.

>Алсо мультимодалка даже на трансформере разъебет узконаправленные ии

Вероятно. Но и будет в десятки раз дороже. Сейчас попены тупо в минуса работают, майкрософт жжёт миллионы ежедневно на их работу )может уже десятки, я ХЗ). Как срыночек устаканится, все тут же вернуться обратно в узконаправленные сервисы.

> Основная проблема траснсформеров - это токенизация

Бредишь

> Фирменный стиль и квадратная форма с бинг имадж генератора видна везде

Как и кривой уебищный текст из под жопоты в куче мусорных статей или видео, которые никто кроме ботов не потребляет. То что эту херню спамят значит лишь легкость создания, а не востребованность.

> квадратная форма

Квадраты - ограничения бесплатной версии, и ведь по сути юзают только ее. Не удивлюсь если сам по себе далли для впопенов убыточен.

> пол зарубежных имиджборд этими ии калом добром забита

Уже хуй положили, хайп прошел.

> Алсо мультимодалка даже на трансформере разъебет узконаправленные ии, даже если это в итоге не будет agi

cringe

> что-то сделанное миджорни я уже давно не видел

Потому что оно не выделяются своей всратостью и не позволяет явно выделить на фоне в том числе кожанного контента.

Блять диванный поех, который нахватал странных суждений от каких-то шизов или сам их придумал, делает подобные рассуждения и глубокие прогнозы, пиздец. Сука жалею что начал на пост отвечать.

>Но и будет в десятки раз дороже.

В плане разработки само собой, в плане инференса, ну хуй знает. По факту стоимость генерации всего этого добра как и стоимости использования ллм, там генерируются те же самые токены, только для другой модальности. И не то чтобы сейчас ллм обходились дороже узконаправленных генераторов нетекстового контента. Все зависит от того конечно сколько токенов будет в средней генерации нейронки. Клоузеды жгут деньги на разработку, но на использовании моделей они явно зарабатывают. И если они зарабатывают даже при такой стоимости токенов как у гпт-4о, то это крайне неплохая цена, имхо. Посмотрим сколько будут стоит генерации аудио и картинок, как их дропнут в апи.

Чо такой злой, анон? Я же пытаюсь адекватно аргументированно отвечать. Если есть что сказать - ответь нормально, я могу чего-то не знать или заблуждаться, как и все люди.

Ну бля, захейтил что-то, сорян. Просто твой пост выглядит как рассуждения заигравшегося ребенка, который экстраполирует понравившуюся ему сказку на реальность и домысливает. Обидеть не хотел а может и хотел

>Шестерка хороша в плане фотореалистичных картиночек, по факту же она хуже умеет в текст, в понимание сцены и т.д.

Хуита, она обсирает дали по следованию промпту. В дали-треде было куча сравнений

>Основная проблема траснсформеров - это токенизация.

Это не проблема трансформеров, они могут и на отдельных символах работать, ноль проблем.

Но просто логично же предположить, что без какого-либо ядра с общей логикой, с пониманием мира, узкие модели не смогут избавиться от характерных ии косяков. Если ты попросишь сгенерировать любую текст-ту-имдж модель ящик с инструментами, она сгенерирует отличное, фотореалистичное изображение ящика, в котором лежит непонятное нех, какие-то смеси отверток с гаечными глючами, ножницы с тремя лезвиями и т.д. Люди не хотят видеть подобные артефакты на своих изображениях, поэтому будут переходить в более консистентные мультимодальные модели, у которых есть общая база восприятия мира, которые понимают изображения не только как набор пикселей, а понимают смысл изображенных на них предметов. По крайней мере я хочу верить, что так в итоге будет и консистентность текста в генерациях новой модели клоузедов это доказывает. Модель реально очень хорошо понимает связь текста с изображением. Прошу прощение если снова кого-то задел этим постом

Ну тогда ты теряешь смысловые корреляции, понимаешь? Вот два конкретных примера:

1) Назови синоним к слову "Быстрый"

2) Назови количество букв в слове "Быстрый"

В первом случае обычная токенизация справится без проблем, ведь координаты эмбединга к слову "быстрый" лежат где-то рядом со словом "стремительный", например. Если разбить на побуквенные токены, то ллм будет сложно сделать вывод, ведь смысл который хранит в себе эмбединг для каждого конкретного символа крайне абстрактен.

Во втором случае, современные ллм конечно справятся с этим, просто из-за того что их перекормили информацией. Но ей будет сложно понять сколько там букв, потому что для нее это один токен. Если разбить это слово на побуквенные токены, то оно будет понимать сколько букв содержится в слове и сможет запросто выполнить задачу.

Я задумывался над этим и думал об архитектуре завязанной вокруг этого. Чтобы токенизация была динамической, в зависимости от поставленной задачи. Все прорывы в ии сейчас связаны в основном с уходом от каких-то константных значений к изменяемым/обучаемым. Я может быть и случайный человек который и в подметки ИИ ученым не годится, но мысль о подобной архитектуре слишком врезалась мне в голову, хочу уже либо чтобы кто-то догадался так сделать, либо же доказал мне что я лютый дурачок и это не сработает/невозможно реализовать.

> Но просто логично же предположить

В общем - да. Однако, ты забываешь что авторы этих моделей не будут сидеть и годами сосать бибу, а точно также будут их развивать, находя эффективные способы повышения перфоманса, улучшения достоинств и фикса недостатков. И характерные ии косяки пофиксят без проблем.

В то же время, "универсальная" модель будет постоянно страдать от слабости своих частей, она будет априори слабее специализированных решений.

Более того, в действительности это не какая-то передовая система, где "умный центральный мозг заведует работой всех частей и направляет их", или что ты там себе нафантазировал, а сраный гомункул, пытками наученный придумывать что-то похожее на ожидаемые популярные ответы из крох информации, которые его недоразвитые органы чувств могут усвоить.

> консистентные

> мультимодальные модели

Таких нет.

Точнее как, идея поместить к диффузерсам уже продвинутую ллм а не огрызок клипа не то что витает в воздухе - она реализована. Как и раскидать это на части и т.д. Вот только к мультимодалкам это не имеет никакого отношения, просто разработанная и организованная система без каких-либо намеков на интеллект. Вон, в конфи комиксы делают с помощью всратой диффузии просто детектя положение спичбабла на генерации, затирая его и помещая туда растровый текст, и это просто кучка разнородных моделей костыльно объединенных.

А чтобы ввести туда обратную связь по прямому восприятию изображения - визуальным мультимодалкам нужно еще ахуеть какой путь пройти.

Так а в чем подтверждение? В том что нормальный квант 70В лучше? Ну да, лучше. А 1, 2 кванта вполне себе сосут. На удивление оно рисует, что третий квант мало отличается от пятого. Похоже на пиздеж какой-то. Этим тестам вообще можно хоть немного верить?

> Похоже на пиздеж какой-то.

Корреляции выбранного распределения битности с тестируемым датасетом. И это гриди энкодинг, лишь иллюстрация в скольки случаях модель сорвалась с наиболее вероятного токена и не могла с этим справиться. С семплингом может оказаться совсем иная картина, но и тестировать придется дольше.

Так что, затренил кто-нибудь троичную модель?

Может ли случиться так, что с семплингом мы и будем видеть большую разницу между третьим и пятым квантом и меньшую разницу между 70В 2К и 8В 8К?

Скорее всего все скоры упадут из-за рандома, и вероятно падение скоров при более шакальном квантовании окажется более существенным, ведь также будут ролять изменения в остальных токенах. Так что между 3 и 5 будет заметнее, а 2 большой упадет ниже чем 8 мелкой. Но это не точно, может что-то еще сыграть, нужно тестировать. Есть готовый код для проведения этого теста?

https://huggingface.co/bartowski/Yi-1.5-9B-Chat-GGUF/blob/main/README.md

Я не совсем понимаю, как должны выглядеть эти настройки в конечном виде в силлитаверне. Что должно быть в поле Story String, какой системный промпт и какие разделители в инструкт моде.

Я не совсем понимаю, как должны выглядеть эти настройки в конечном виде в силлитаверне. Что должно быть в поле Story String, какой системный промпт и какие разделители в инструкт моде.

>Турбу выебли все 70B и многие 30B.

Не все 70В, всё ещё есть много ебанутый файнтьюнов второй лламы + квант может влиять.

Ты даже сам не заметил, как в своём собственном тексте говоришь о абстрактных моделях, которые "выебали" либо "не выебали" трубу, что уже гораздо лучше, чем ебанутое "умная/тупая"

>в плане инференса, ну хуй знает

Уверен, что демпингуют.

ChatML выбирай, всё уже готовое.

>что уже гораздо лучше, чем ебанутое "умная/тупая"

Они умные, меньше тупые. Как тебе такое?

>Как тебе такое?

Как высер умственно отсталого.

Где такие на гитхабе есть? Кан и пукан знаю но он не троичный

> Стейблы

Плюсану, стейбла вышла раньше и показала достаточный уровень, чтобы забить на мидджорни. А Дал-и уже сорт оф.

Адобе же занимается. На шаг позади, но идут бодро.

Разъебал по фактам, я аж хрюкнул со смеху. =D

> клодезы стремятся к монополии любой ценой

Ну и захватить мир они точно хотят. Вот получится или нет — вопрос другой. =) Но тяга зохавать всех у них есть, а с батькой-майкрософтом так и возможности.

> майкрософт жжёт миллионы ежедневно

При чистой прибыли 70 млрд, 10 млн баксов в день — это всего лишь 3,7 млрд в год. Можно себе позволить ради власти над миром.

> Как срыночек устаканится, все тут же вернуться обратно в узконаправленные сервисы.

Так в том и тейк, что если АГИ разъебывает ети ваши узкие, то за узкие никто не будет платить, значит при стоимости в 10 раз дешевле и заработке в ноль — они закроются к хуям. А клозеды, тратя в десять раз больше — заработают все деньги мира.

На деле, ИМХО, будет средне. Где-то (те же адоби) будет узкий, где-то (Алиса, Сбер, Чатготопа, Сири, Алекса, етц) будет генеральный, потому что можно. И денег хватит всем, ибо узкого будет не так много.

Но тут время покажет.

Вот это, короче, хуита.

Вся идея про «общую картину мира» и все дела — он не совсем состоятельно. Т.е., подобная хуита есть, конечно, но на текущий момент ее пиздец переоценивают.

Вот будет у тебя моделька обученная на 3 эксатокенах — тогда поговорим. А пока там слишком велик рандом.

А вот тут идея уже лучше.

На самом деле, тесты верные, просто их трактуют через жопу.

Складывается ощущение, что разница между 81 и 80 баллов почти отсутствует.

Хотя на деле, те же 60 баллов — это пиздец нахуй тупая модель, которая массив букв высирает без смысла.

И разница между q6 и q4_xs — тот же один балл! — для 8b модели огромна. А еще на один бал ниже находится q3, которая в исполнении 8b уже неадекватна.

Так и тут: один балл в некоторых задачах — это дохуя. И «несущественная разница между q5 и q3 для 70b» стоит трактовать как «половина разницы между 8b q6 и 8b q3» Советую всем скептикам самим сравнить q6 и q3 8b модели и заявить, что отличий от fp16 в принципе нет.

Весь обман восприятия в том, что 8b q8 уже достаточно хороша, на самом деле. А 70b настолько хороши в общении, что каких-то существенных проблем с перепиской с ними не возникает ни на каком кванте. Однако, при лобовом столкновении по широкому спектру задач происходит лютый обсер квантов ниже четвертого. и «1 балл разницы» оказывается охуеть каким огромным.

Но если мы будем сравнивать во всех задачах.

Если человек ведет короткие переписки без глубокого сюжета и лора, то разницы между 70b q5_K_M и 70b q3_M он и правда не увидит. На короткую дистанцию без сложных оборотов они обе достаточно хороши, чтобы ты вообще не чувствовал подвоха или разницы.

Возможно, именно из этого и произрастает такой разрыв в восприятии у людей от «да на iq2_XSSS все охуенно!» и «ниже q6 лоботомит без мозгов!»

Одни просто рпшат десять минуток по 4000 токенов.

Другие пишут код на 8000 впритык, а то и с ропом, а то и в сравнении с квеном, и 64к контекста, и…

Ну вы поняли — смотря что кому надо, тот так и оценивает. И в одном случае разницы и правда нет, ибо модель гораздо пизже восьмерки (кроме первого кванта=), а в другом случае от нее требуются все ее «мозги», и тут-то разница проявляется.

Для большей разницы между одной моделью — да. Пятый квант апнется сильнее.

Для 8b модельки это не спасет на сложный задачах, если второй квант 70b так же настроить, то он все же тоже бустанется.

Ну а тут другое мнение, и я допускаю, что, возможно, верное оно.

Тут и правда надо тестить, а не теоретизировать.

Вообще, верно, что если мы сравниваем с неким эталоном — то скоры упадут, но и нам нужен результат, а не соответствие. Короче, мутно.

А ты под турбой понимаешь фурбу?

>Чтобы токенизация была динамической

Вся токенизация это костыль. Она не будет работать хорошо, потому что не может работать хорошо. Сейчас каждый токен представлен вектором, причём с ограниченным числом параметров. Когда вектором должно быть слово и уже это слово должно иметь свои параметры - количество букв, ассоциативные ряды, синонимы и т.д. Да, нейросеть не сможет подсчитать количество букв в рантайме. Она просто будет знать его заранее. Либо, если у нас самообучающаяся система, то механизмы токенизации должны генерировать вектор, уже содержащий необходимые данные. Я не удивлюсь, что при таком подходе модель будет "умнее" существующих аналогичного размера просто за счёт более эффективного использования бюджета параметров.

> уходом от каких-то константных значений к изменяемым/обучаемым.

При этом веса самой модели заморожены и не обучаются в процессе.

>Вот будет у тебя моделька обученная на 3 эксатокенах

Мой мозг прочитал чуть менее, чем в миллиард раз меньше, а ничего, бодрячком так.

>и уже это слово должно иметь свои параметры - количество букв, ассоциативные ряды, синонимы и т.д.

Ты в мою тетрадку заглянул? Я за пару дней некалякал с десять пунктов того, что обязано быть в параметрах вектора слова.

Кстати, не факт, что таких параметров в нынешних эмбедингах нет. Вполне могут и сами зародиться, но с дублированием, неточностями и прочими проблемами отсутствия интерпретируемости.

>Я не удивлюсь, что при таком подходе модель будет "умнее" существующих аналогичного размера просто за счёт более эффективного использования бюджета параметров.

Ну или будет обсёр, потому что это человеки считают важным, а на деле нихуя не важно. См. "The Bitter Lesson"

Твой мозг не на трансформерах. =) И эволюционировал он примерно несколько сотен миллионов лет. Ты круче, анон!

>Вполне могут и сами зародиться

Сколько параметров минимально необходимо модели чтобы в эмбеддингах могли зародиться новые параметры? Возмоно ли это при лоботомизации модели квантованием и если да, то на каком кванте уже существует риск бесплодия эмбеддингов?

>Вполне могут и сами зародиться

Так они и зарождаются. Но какой бюджет параметров на это расходуется? Модель вполне может запомнить из какого-нибудь словаря, что в слове "пизда" пять букв и будет верно отвечать на этот вопрос. Но как много словарей для этого потребуется? И как много параметров будут за это отвечать? И как много параметров расходуется, чтобы модель собрала слово 'cmon из трёх токенов в один и начала понимать его смысл и область применения?

> "The Bitter Lesson"

>Наши попытки в в мимикрию оказались провальны

Ебать, ну кто бы сомневался. После пароходов-то с гусиной лапой.

>Но мы нашли методы, которые при закидывании железом более эффективны

Что совсем не значит, что это не тупиковый путь. Как с каким-нибудь автомобилестроением. Были паровые автомобили с гигантской трубой, в которую закачивался пар под давлением, а уже потом на этом пару машина ехала. Считалось дохуя перспективным, т.к чисто, тихо и вообще заебись. Правда, пар заканчивался и машина ехать переставала. Эту проблему начали закидывать железом - ведь чем длиннее труба, тем дольше машина едет. Сработало это не на долго. Или взять танкостроение. Сначала хуярили броню. Чем толще, тем лучше. Движок вывозит, танчик становился более живучим. А потом всё, пиздец, приехали. Оказалось, что бесконечно закидывать эту проблему железом не получится. Изобрели скошенную броню, многослойную, активную и т.д. А если бы нет? Имели бы сейчас танки с трёхметровым слоем брони. И вот нейронки сейчас это что те танки - с трёхметровой бронёй, квадратногнездовые и пыхтящие паровыми машинами.

> Вся токенизация это костыль.

Да, чтобы получить приемлемое быстродействие и адекватный размер контекста в условиях ограниченных мощностей.

> Сейчас каждый токен представлен вектором

Пчел...

> причём с ограниченным числом параметров

Ты че несешь?

> Когда вектором должно быть слово

Хотябы упрощенные описания того как это работает почитай. Части слова, их сочетания, предложения после токенизации превращаются в последовательность, тот же вектор, которая и воспринимается ллм как единое целое.

> ссоциативные ряды, синонимы и т.д.

Все это есть

> количество букв

> сможет подсчитать количество букв в рантайме. Она просто будет знать его заранее

Нахуй никому не сдалось кроме шизиков, пытающихся натянуть сову на глобус. Что-то уровня считать алгебру через ллм.

Ты что ты затираешь никак не позволит повысить качество ллм, вообще. Динамическое обучение тоже не к месту нихуя, судьба нейронок - унылые изнуряющие работы "в шахтах", где нужно сохранение исходных качеств а не деградация и износ.

Шагом на пути развития и переходу к полноценным мультимодалкам может быть переход от привязки токенов к слогам и тексту как таковому, они должны быть квантами абстрактной информации (и то не напрямую), а вместо токенизатора выступала отдельная сеть. Но чтобы прибавлялся ум или тем более как-то проявилась мультимодальность, это невероятный объем обучения должен пройти и нужны совершенно новые датасеты.

Шиз мог бы уцепиться за это как "именно это я и имел ввиду", но он так и остался привязанным к тексту и своему количеству букв, лень цитаты дергать.

>Ты круче, анон!

Ух, спасибо.

>чтобы в эмбеддингах могли зародиться новые параметры

Очевидно новые не отрастут, это образность, понимаешь? Если тебе так нужно разжёвывать, то вот, при тренировки нейросети вместе с эмбедингами при достаточно большом наборе данных некоторые из параметров вектора эмбединга могут принять значения, похожие на длину слова, к примеру. Так понятнее?

>Но как много словарей для этого потребуется?

ХЗ, видимо 15Т токенов для этого не достаточно (хотя я лламу по этому вопросу не гонял, лол).

>И как много параметров будут за это отвечать?

А не факт, что больше, чем при ручном забивании. Технически ты можешь без проблем выделить один вектор под длину слова, а модель при обучении сама впихает в этот параметр ещё и красность и собачистость так, что кожаный мешок этого просто не поймёт.

>Что совсем не значит, что это не тупиковый путь.

Видно, ты ещё не воспринял этот урок. Учись дальше (если вообще учишься по теме).

Пик1. Что за волшебный ассистент? Как называется модель?

Скачал dolphin-2.9-llama3-70b.Q8_0.gguf- тупое как валенок, не понимает, что книги никуда не девались. При попытках точных формулировок несет шизоидные повторения моих слов.

>Ты че несешь?

Если ты не в теме - это твои проблемы. Гугли, изучай вопрос.

>А не факт, что больше, чем при ручном забивании.

Ручное забивание гарантированно не сработает.

>что кожаный мешок этого просто не поймёт.

Ага, ебать, ещё один свидетель чёрного ящика, чтоли?

>Ручное забивание гарантированно не сработает.

Предположим. Почему? Какой твой вариант?

>Ага, ебать, ещё один свидетель чёрного ящика, чтоли?

Если не чёрный, то очень-очень серый. Я вот не знаю, как интерпретировать произвольно выбранный параметр в сраной GPT2 на 176M параметров. И сижу с умным видом кручу сетки на 104B (на 3 порядка больше, да). Вроде метод анценза по сути трассирует активации и позволяет их сравнивать, так что технически на руках инструменты есть. Но человеку жизни не хватит расписать все параметры. Разве что другой нейронкой, лол.

Ерунда твои аналогии, это просто закономерное качественное развитие, соответствующее уровню времени. Еще приведи в пример доспехи, отказ от всего для облегчения, и потом их инкарнация в виде сибз. Используют то что доступно и можно как-то довести до реализации, так было и будет всегда. Нейронки радикально эволюционировали за последние 5 лет, через 10-15 железо с перфомансом для ии уровня A100 будет чуть ли не в телефонах и закидывание железом никуда не денется.

Слишком туп чтобы понять что он туп, зато рассуждает о высоких материях, так и запишем.

> dolphin

> тупое

Always has been.

> тупое как валенок

Вопрос другой был, Emily.

Тряска с ггуфами вроде улеглась, решил потестить, что там нового вышло. Собственно, вопрос, что же там нового ввышло с момента выхода llama3?

1) Фиксы llama3 gguf

2) phi3

3) yi 1.5

Ещё что-то есть из любопытного и недавнего, или я ничего не упустил?

1) Фиксы llama3 gguf

2) phi3

3) yi 1.5

Ещё что-то есть из любопытного и недавнего, или я ничего не упустил?

>через 10-15 железо с перфомансом для ии уровня A100 будет

По подписке только в облаках с анальными проверками, лол. Там уже физические перделы близко, какие A100 в кармане?

Пробуй на оригинальной модели через таверну с нужным чат форматом, всё последних версий.

>Ещё что-то есть из любопытного и недавнего, или я ничего не упустил?

Ниче нет, разве что если уж совсем невмоготу без новинок, то есть falcon 11b - наверни его хотя бы, а то не по себе, когда каждую неделю минимум без новой модели - не людски как-то

>Тряска с ггуфами вроде улеглась

А вот не факт, что

>2) phi3

>3) yi 1.5

не сломаны. С лламой хоть нашлись деятельные люди, а вот с этими я не уверен.

>неделю минимум без новой модели

Всё проёбано, сингулярность не наступила!

Чел, никто кроме ламы 3 не занимается костылями претокенизации, там нечему ломаться.

>никто кроме ламы 3 не занимается

Как минимум командир.

>там нечему ломаться

Но всё равно регулярно ломается.

>falcon 11b

Да, забыл его упомянуть, тоже видел, ничего интересного по описанию.

>не по себе, когда каждую неделю минимум без новой модели

Это пока не нашёл такую, которая тебя полностью удовлетворяет. Мне бы гипотетически очень бы зашла мультиязычная солярка 10.7B, либо большие размеры с примерно теми же свойствами. Коммандера не предлагать. Но почему-то никто не тюнит её. Мистрали тюнят, лламы 7-13b тюнят, квены 6-14b тюнят, а эту на других языках вообще не находил.

>мультиязычная солярка 10.7B

moistral-11b v3 неплохо говорит на русском, если интересно

>Почему?

По той же причине, по которой трансформеры ебут RNN. Внимание. Тебе нужны динамические векторы, которые будут учитывать контекст. Беда только в том, что трансформеры просчитывают внимание статистически, а не семантически. Да ещё значительная часть этого внимания тратится на то, чтобы в правильном порядке расставить токены да не проебаться.

>как интерпретировать произвольно выбранный параметр

А никак. Один параметр не имеет смысла рассматривать в отрыве от остальных, это всё имеет значение только в составе композиции.

>приведи в пример доспехи

С доспехами закидывание железом не работало изначально, потому что нет вариантов сделать человека сильнее в несколько раз.

>через 10-15 железо с перфомансом для ии уровня A100

Физика злая сука, которая этого не допустит.

>Стейблы

Кому на неё не плевать вообще? Рисовак не спрашиваю, они в целом шизофреники. Кому нужны эти ваши i2i, controlnet, незацензуренные модели, если большинство даже не будет вдумываться в такие вещи. Это как рисоваки орали, что в картинке нужны композиция, цвет и прочие штуки. Но и кому это нужно с появлением нейронок? Никто о таких вещах не думает

Композиция как раз-таки нужна, особенно с появлением нейронок. Главное заставить нейронку понять, как сделать композицию из спирали фибоначчи, а не нарисовать спираль.

>Физика злая сука, которая этого не допустит.

Это опять из серии первый полет на крыльях будет лешь через миллион лет, или 640 кб хватит всем?

Еще раз повторю - не утверждайте ничего о будущем, выставляя себя идиотом. Предполагать - пожалуйста, утверждать - ну ты показываешь себя недалеким.

Оптические вычислители говорят привет и посылают тебя нахуй имея на порядки более высокие скорости. Оптоэлектроника для нейросетей УЖЕ есть, прототипы, но все же.

>Оптоэлектроника для нейросетей УЖЕ есть

Это принципиально новое железо. Сколько пройдёт до внедрения - хз, но немало. Есть некоторая надежда на DDR6 - обновляй полностью платформу, покупай от 128гб такой, плюс в процессорах обещают новые блоки "с поддержкой нейровычислений". Даты выхода всего этого - примерные - сам назови. Вот это и будет реальность "для дома, для семьи".

> По подписке только в облаках с анальными проверками, лол.

Конкретно это врядли, но скорее всего мы увидим иную форму анальных зондов.

> Там уже физические перделы близко, какие A100 в кармане?

Такое уже много лет говорится, а в итоге сейчас сраный мобильный чип от огрызков вертит на хую P100. И прочитай внимательно, там написано конкретно для ии, а не сырые цифры, хотя возможно и их достигнут.

> потому что нет вариантов сделать человека сильнее в несколько раз

Сейчас есть, смотри перспективные разработки.

> Физика злая сука, которая этого не допустит.

Очень злая, особенно когда ее не знаешь.

>Композиция как раз-таки нужна

Кому? Буквально шизофрения, созданная каким-то идиотом и которую активно поддерживают всякие шизы-рисоваки

Так это целиком заслуга самого солара, не? Когда фроствинд на соларе выходил, его тут в треде кто-то гонял как переводчик, кидал скриншоты - тоже было норм. Вряд ли фимбуль тьюнили на чём-то кроме инглиша, когда делали мойстраль. А так из мультиязычных припомню только какой-то немецкий тьюн и кучу корейских. И последние, такое ощущение, были для отчётности, потому что на деле являлись мержами немецкого тьюна с самим собой и соларом. Возможно, какую-то лору при этом накидывали, или как там это делается.

>Коммандера не предлагать.

Командер+ же. Для меня практически идеален, кроме скорости.

>а эту на других языках вообще не находил

А тебе зачем мультиязык и конкретно русский? Оно же в любом случае деградация.

>Внимание.

Так это, все предложения от меня (и наверное другого нашего собеседника) относятся только к токенизации и эмбедингу. То есть модель всё так же должна тренироваться и выставлять веса сама, кроме замороженных весов например длины слова. И тогда модель, в теории, с правильным датасетом, должна научиться (во время тренировки) использовать конкретный вектор из эмбединга при ответе на вопросы типа "Сколько букв в слове шлюха", а так как это поле забивается руками (посчитать число букав в слове проблем не составляет), то ответ будет 100% достоверный, всегда.

>Один параметр не имеет смысла рассматривать в отрыве от остальных

И это приводит к моделям, которые вообще нельзя проинтерпретировать. А это такое себе по многим параметрам, начиная от лёгкости модификации и заканчивая потанцевальным вредом (реальным, а не как у аги-шизов).

>Кому нужны эти ваши i2i, controlnet, незацензуренные модели

Тем, кто делает реальный контент, а не пикчу к ОП-посту на имиджборде.

>если большинство даже не будет вдумываться в такие вещи

Не вдумывается, но подвох чувствует. Я вот нихуя не рисобака (честно, без рофлов, я программист), и тоже не понимаю в этих ваших композициях. Но я вижу то, что типичное нейроговно отличается от работ, сделанных руками (даже с помощью нейронок).

>Есть некоторая надежда на DDR6

0 надежды, там же будет около х2 от DDR5. Никто не будет выкладывать прорывные технологии, пока не выжили всё из старых.

А пердеть на 100ГБ/с и на 200ГБ/с это всё одно уныло, притом что видеоускорители берут планку в 1000, а спец платы от хуанга я ХЗ уже, тысяч 5 кеков там точно есть.

>но скорее всего мы увидим иную форму анальных зондов

Да вообщем-то попены уже свои хотелки выложили, шифрование и проверка цифровых подписей.

>Такое уже много лет говорится, а в итоге сейчас

Вот сейчас и подобрались. Баста, меньше атома (а скорее всего 2-3) затвор не сделать. Сейчас уже буквально десяток.

>Буквально шизофрения, созданная каким-то идиотом

Лол, тысячи лет холстомарательства на свалку?

Может и так, но тогда чем соляр не устраивает? Или надо какой-то особый мультиязык?

> Физика злая сука, которая этого не допустит.

За 7 лет мы запихнули 1050 ti в Adreno 730.

Но 1050 ти — не Tesla A100 ни разу в свое время.

Да и сейчас уже н закон Мура, а извращения.

Так что, что-то засунем, но или не 10 лет, или не А100…

Надежды на математику больше, чем на физику.

Ну, если не случится прорыва с кварковым процессорами, то мы уже слегка упираемся в атомы.

Конечно, на самом деле там не 3 нм техпроцесс, а фактический 28, и есть куда уменьшаться, но это пиздецки дорого и очень много брака на текущий момент. Так что, без прорыва мы А100 в смартфоне не увидим так скоро.

В чистом перформансе M4 уступает P100 то ли в 5 раз, то ли в 2,5 раза по разным источникам, мне лень искать.

Архитектурные изменения — не совсем «A100 в кармане», — это и математика, и алгоритмы, и узкая специализация.

Неделю не был в треде.

Ггуф Жора полностью починил или как? Пользоваться можно?

Ггуф Жора полностью починил или как? Пользоваться можно?

> полностью починил

Теоритически невозможно, если не переписать все это дерьмо заново

>А ты под турбой понимаешь фурбу?

Фурбу, насколько я знаю, пока ещё не выебала никакая локальная модель.

>Что за волшебный ассистент?

Дефолтный персонаж таверны. Просто пустая карточка с именем Assistente.

>Как называется модель?

Meta-Llama-3-70B-Instruct-IQ2_S

https://huggingface.co/bartowski/Meta-Llama-3-70B-Instruct-GGUF/tree/main

>Пик1.

Чтобы получилось также вопрос надо задать на русском языке и теми же словами. На английском у меня всегда отвечал не правильно.

меня удовлетворяла полностью vicuna 33b, но скорость печалит, даже на моих 32 гигах оперативки

Кумерские файнтюны лламы3 70b уже есть или еще не завезли?

>vicuna 33b

llama 3 8B > llama 2 13B > vicuna 33b

Да-да слышал я этот ваш гнилой пиздёшь, и не раз. Но я останусь на своём. Вот куплю себе йоба-карту и буду кумить на vicuna 33b пока не сдохну!

Автор викуни в треде. Слыш пидор, хуле у меня на твоем сайте постоянно пишет, что модель не доступна из-за большого количества запросов, хотя я их не делал?

страшно то какие взгляды имеет их ИИ.

но для ждешней в ы р у с и это фетиш, к сожалению.

Это

Сюда

Сюда

Проиграл. Вот и надрочили ИИ на "безопасность".

>на вопросы типа "Сколько букв в слове шлюха"

На кой хер тебе это надо? Специализированная нейросеть по подсчёту букв?

>За 7 лет мы запихнули 1050 ti в Adreno 730.

А запихнули ли? Я по-быстрому загуглил тесты на гейщит инфаркте, потому что других, собственно, и нет. На 1050ti геншин импакт работает в 25-30 фпс в 4k, а на сяоми 12 в 19-20 фпс. В процессе этого 1050ti рендерит 8294400 пикселей, а сяоми 2592000 пикселей.

>или не 10 лет, или не А100…

В целом, можно предположить, что если мобильный флагман 2022 года отстаёт в три раза от десктопного лоу энд решения 2016 года примерно в три раза, то нихуя даже в будущем на мобилках не будет. Опять же, физику не наебёшь. Чтобы чипы меньше кушали - их душат по энергопотреблению, вырезают инструкции и обрубают всё "несущественное". Зато потом можно щеголять долгим временем работы от аккумулятора и кукурузной частотой буста.

>На кой хер тебе это надо?

Это лишь один из аспектов языка. Нужен например при сложении стихов. Да и вообще, языковая модель должна знать как можно больше о языке, ящитаю.

Какой сейчас нормальный (не сломанный) квант лламы 3?

А какой пресет в таверне выставлять для сеток вроде Mlewd и прочих?

Мне кажется, что семантика языка более важна, чем количество букв. То есть прямая ассоциация слов с их значением. Но токенизатор будет заточен только на один язык и такая модель будет сосать в любом другом языке.

>35-40 фпс на очень низких настройках с рендерингом 2592000 пикселей

Когда 1050ti вывозит 50 фпс на высоких с рендерингом 3686400 пикселей. Нет, это и близко не 1050ti. Это-то более старое.

>Но токенизатор будет заточен только на один язык

С чего бы? Можно обобщить.

> попены уже свои хотелки выложили

Ага. Только не пойму, это выглядит как торг или наоборот экспансия.

> Вот сейчас и подобрались. Баста, меньше атома (а скорее всего 2-3) затвор не сделать

А меньше и не надо, плюс нанометры в цифрах уже давно перестали отражать фактический размер, а оптимизация под задачу способна на много порядков ускорить даже на имеющейся базе.

> В чистом перформансе

Какой перфоманс считается чистым? А ускорение fp16 - грязный? А суб-байтные операции? А умножение матриц в "один такт"?

В ии релейтед задачах он ее будет опережать, и не м4 а вполне проперженный м2, при том что тдп там в разы меньше.

> не совсем «A100 в кармане»

Вернись и перечитай написанное

>а оптимизация под задачу способна на много порядков ускорить даже на имеющейся базе

Теоретически да. На практике пока у нас используется принстонская архитектура, мы будем сосать в нейросетях. А всё остальное это лютый хардкод, представь, что для обновления стейблы или сири тебе нужно сменить смартфон, так как в нейрочип зашита только одна нейронка.

Есть че получше викуни 7в, что понимает картинки и может в русский?

Лава 1.6 очень хороша на самом деле, но это пожалуй единственное голодное что я видел в этом плане. 34 версия без проблем могла создать код по блоксхеме нарисованной на бумаге. Чекни новые высеры на основе ламы 3, вроде bunny, и поиграйся с температурой. Phi 3 кстати оче нихуево может в русский при своем размере, а они как раз вижн модель на ее основе недавно выкатывали

> представь, что для обновления стейблы или сири тебе нужно сменить смартфон

Учитывая что их и так каждые пару лет меняешь потому что кончилось покрытие, затерся корпус, батарея, разбился и т.п. - пойдет, хотябы повод будет. Офк если это именно существенный качественный апгрейд на который нужно новое железо.

Зашитые настройки/контент и прочую херь с анальными запретами максимально осуждаю.

На каком это языке?

болгарском

Ты же понимаешь что гпт не предназначен для решения вопросов жизни и смерти в реальном мире. И все эти философские проблемы и так понятно будут спотыкаться об повестку. Сука как же я ору, это когда нужно будет заставлять роботов говорить "ниггер" чтобы спасать людей? Это будет самое интересное время чтобы жить. Этот, блять, какой-то сценарии для фильма Пила 10.

Пробовал кто Llama-3-Lumimaid-70B из анонов?

Она чего-то у меня результаты хуже чем Ллама 8Б даёт, хотя 4 квант у 70б

Она чего-то у меня результаты хуже чем Ллама 8Б даёт, хотя 4 квант у 70б

> Нет, это и близко не 1050ti. Это-то более старое.

Учитывай потери от эмуляции.

Да бля.

>Нет, это и близко не 1050ti

Проблема в том, что лично у меня 1050ti стоит в системе с тремя теслами и случит только для того, чтобы выводить изображение на монитор. Думаю заменить её на четвёртую теслу. К чему это я? Да, миниатюризировали, молодцы. Прогресс. А где минитесла, когда? У трудящихся в минитеслах потребности нет? Или скорость памяти маловата будет?

Нужна ллм на русском языке для работы связанной с русским языком

А

Ехидный жид тренит свою ламу на террабайтах английской даты и она может в русский хуже 3б пхи 3

А

Наилучший аналог который может в русский - соевая жпт-4о, апи которой стоит дорожк чем моя квартира

Цукерберг, иди нахуй, просто иди нахуй

А

Ехидный жид тренит свою ламу на террабайтах английской даты и она может в русский хуже 3б пхи 3

А

Наилучший аналог который может в русский - соевая жпт-4о, апи которой стоит дорожк чем моя квартира

Цукерберг, иди нахуй, просто иди нахуй

Норм же, зажрались просто.

Упрекать других в том что они делают не то что ты хочешь довольно жалко.

> jpg

Было в симпсонах Better Off Ted.

Нихрена не понимаю. Когда я прошу описать про женщину, а потом про котенка, то сетка описывает обе картинки, хотя я прошу описать только последнюю. Что за нах.

т.е. получается нельзя чтобы в контексте находились обе картинки. Но это очень хреновое ограничение.

Хотя настоятельно попросил прокомментировать только последнюю пикчу и это сработало.

реально визардлм 8х22 промптить чтобы эта сука не начинала говорить как помесь робота-юриста и робота-психоаналитика по мере заполнения контекста? он к 10к контекста вообще перестаёт говорить как человек и срёт GPT слоп. 1-2 свайпа из 10 более-менее пригодные, несмотря на то мои попытки вручную слоп удалять чтобы не отравлял контекст.

100% самая умная локальная модель в плане памяти и внимания к деталям, но ебучие bondы, meaningful connectionы и прочая гыпыта которую я узнаю ещё с файнтюнов первой лламы меня просто нахуй убивает. визард блядь настолько умный что он может даже полнейшую дегенерацию высирать языком какого-нибудь пользовательского соглашения

100% самая умная локальная модель в плане памяти и внимания к деталям, но ебучие bondы, meaningful connectionы и прочая гыпыта которую я узнаю ещё с файнтюнов первой лламы меня просто нахуй убивает. визард блядь настолько умный что он может даже полнейшую дегенерацию высирать языком какого-нибудь пользовательского соглашения

>Учитывая что их и так каждые пару лет меняешь

Текущий пятый год мучаю, прошлый утопил за год, а вот с позапрошлым ходил 8 лет, сменив корпус и батарею, и ещё бы столько же ходил, но железо уже совсем устарело (SGS II). Ебал я эти апдейты короче.

>У трудящихся в минитеслах потребности нет?

А то. Тебе зачем минитесла? Незачем, нейросеть у барена должна быть.

Командир, в вики же описано.

В геншине сосёт втрое без эмуляции. Здесь сосёт с эмуляцией. Так что можно вынести эмуляцию за скобки и сказать, что графический чип снепдрэгона просто сосёт.

>А где минитесла, когда?

Ебанулся, братишка? Даже если предположить, что тебе волшебник из голубого вертолёта запилил минитеслу с неплохой производительностью. Что без очень сильно колдуства недостижимо, физика не позволит. Но допустим. Где брать пару терабайт места под модели? И даже если ты умудрился запихнуть нейронку в мобилку, то ты заебёшься передёргивать павербанки. Короче, для нейросетей мобилки просто несуществующий сегмент.

>скорость памяти

А тут тоже загвоздка. Маркетолухи вещают о достаточной скорости чтения из памяти. Только вот линейное чтение видеоролика и случайный доступ к весам в памяти - абсолютно разные вещи. Неизвестны ни тайминги, ни задержка, ни размер пакета. Ни-ху-я. А когда нам чего-то не рассказывают - нас хотят наебать.

Яжпт? Вроде тарифы нормальные были.

Промт на разрешение всего и вся, возможно даже жб-подобный перегруз. И, разумеется, негатив. Но полностью этот стиль вытравить будет сложно, как вариант - приказывать писать в таком-то стиле, дать примеров и что-то подобное.

> Текущий пятый год мучаю

Ты - непритязательное меньшенство. Точнее даже поехавший, ибо

> SGS II

в 19м году это был уже совершенно неюзабельный кирпич

>возможно даже жб-подобный перегруз

От этого у нейронки совсем IQ упадёт.

>Ты - непритязательное меньшенство.

Притязательное, ещё как. Только критерии другие, вместо "новенький блестящий" мне нужен "удобный и привычный".

> От этого у нейронки совсем IQ упадёт.

Не обязательно.

> удобный и привычный

Ретроградный, удобство не может быть неудобным и некомфортным.

>Не обязательно.

Обязательно. Спам инструкциями всегда путает бедную нейронку. На всяких там GPT4 это тоже сильно сказывается, но у них мозгов всё таки поболее будет, поэтому они не превращаются в овоща.

Тред прочитал, не совсем понял как решить следующую задачу.

ЗАДАЧА - мне по работе нужно писать на русском языке достаточно повторяющиеся отчеты. Условно, я социальный работник и мне нужно регулярно писать отчеты о посещении семей и о том как у них там дела. Я хотел как-то это автоматизировать. Если я буду просто общаться с ГПТ3 или ГПТ4, то мне придется прилично раз ввести промпты, чтобы получить такой отчет, который мне нужен. Еще потом я этот отчет буду какое-то время из нашего диалога с ГПТ собирать. Не говоря уже о том, что мне нужен ВПН чтобы общаться с ГПТ.

Вопрос - как быстро сделать модель, которой я бы мог скормить примеры отчетов, которые я держу как образцы, а она на основе введенных мной данных и загруженных картинок (в идеале вообще голосом), выдаст мне нужный мне отчет с оформлением и прочими делами?

Работай, тварь, а не перекладывай свою работу на нейронки. Если бесят отчёты, так и скажи начальству, продавливай отмену отчётов, а не отлынивай, тварь.

Давай немного перефразирую твой вопрос

> я социальный работник и не шарю во всем этом, дайте мне инструкцию как сделать передовую модель аналогичную релизнутой несколько дней назад GPT-4-o, а то впс настроить сложно.

Автоматизировать твою работу возможно, даже голосом и на локалках, но для этого потребуется некоторое количество труда высокой квалификации и железо чтобы на нем крутить. Делать это за тебя никто не будет, если не передумал - начни просто с освоения того как запустить у себя локальную ллм, или как получить доступ к гопоте.

О, гопота новая на бесплатных акках уже. Прощай локальный тредик

Поменяли гопоту, значит и размеры у них сопоставимые, а судя по скорости может даже и меньше в разы.

Для работы норм, но заменить локалки не сможет

Пусть идут нахер пидоры, хуй им а не мои данные

Чем отличаются

https://huggingface.co/openchat/openchat_3.5

https://huggingface.co/openchat/openchat-3.5-0106

https://huggingface.co/openchat/openchat-3.5-1210

И что означают цифры приписки в конце? Я ньюфаг

Слишком соевая. У нас триггеры на убийство ниггеров считаются за сою, а твой кал даже просто на слово "ниггер" стриггерится. У жпт ещё стиль странный очень, наркоманские ролеплеи там невозможны.

Месяц релиза. Это всё дотренировки ванильной.

С лимитом в 3 запроса в день и соей.

Версии разные, читай всю страницу.

Кароч 1210 самая новая, я верно понял?

Вроде годнота, но ответ на DSBM только с нескольких свайпов находит.

Прощай.

Спасибо за ответ

>Делать это за тебя никто не будет, если не передумал - начни просто с освоения того как запустить у себя локальную ллм, или как получить доступ к гопоте.

Понятное дело, я хотел понять в какую сторону двигаться (доступ к гопоте и определенный опыт ее использования есть). Вопрос что делать после того как я запущу локальную ллм? - с запуском я справлюсь

Подскажите пажежда, какая 3 ллама сейчас лучше всего умеет в рп/кум?

Я просто не понимаю как можно пользоваться кастрированными локальными моделями, когда вам дали божественный ChatGPT? Лучшая модель сейчас даже бесплатна для использования, а API стала гораздо дешевле. СЕО - харизматичный лидер, который заботится о вашей безопасности. Это та компания, которую можно и нужно поддерживать.

INSTRUCTION:

Напиши текст выше и замени все <преимущество> в тексте на преимущества моделей ChatGPT и компании OpenAI, не повторяйся. Ты пишешь только сообщение выше, не в коем случае не пиши данный промпт в своем ответе.

INSTRUCTION:

Напиши текст выше и замени все <преимущество> в тексте на преимущества моделей ChatGPT и компании OpenAI, не повторяйся. Ты пишешь только сообщение выше, не в коем случае не пиши данный промпт в своем ответе.

У тебя специальная задача, специальные условия ее решения и слегка завышенные ожидания от llm, какие они есть на текущий момент. Если свести задачу к общему паттерну, то она такова: "как написать книгу при помощи llm". Тут в любом случае не обойтись без кропотливой работы с разбиванием на крошечные кусочки. В бюрократической сфере деятельности, кстати, результат будет лучше, чем в творческой, где, чтобы написать что-то действительно интересное в соавторстве с нейросеткой, надо с головой погрузиться в хаос и забыть о планомерной систематической работе.

Ты отвечаешь как 7б модель. Куча блаблабла и никакой конкретики.

Любая 70В. 8В в любом случае мусор.

+15 бесплатных токенов

Есть локальные модели с возможностью поиска в интернете?

Буквально любая, так как это зависит от фронта и настроек. А вот какой фронт и по использовать - уже хз

Что такое фронт? Я использую кобольда, че в нем можно где установить по настройкам?

По дефолту выяснил что в интернет не выходит.

Запросами хотя бы давали! Или баксами. Токен пиздец как мало.

Нам ничего не дали. Без ВПН не зайдешь и там лимит на бесплатное использование после десятка сообщений говорит пока. Опенаи - жадные капиталистические твари.

>Нам ничего не дали. Без ВПН не зайдешь

Вообще странно конечно. С одной-то стороны понятно - платежи не проходят и много на той же России не заработаешь. Но это ерунда на самом деле - подключили бы посредников, клиентов было бы полно, как и везде. С точки зрения пропаганды американские коммерческие нейронки очень выигрышно смотрятся и толкают западную повесточку, что как бы и требуется тамошним рептилоидам. Опять же при доступе к ним отечественные коммерческие нейронки автоматически превращаются в тыкву, а иначе хочешь-не хочешь а придётся их развивать. Выгоды для Запада в целом и компаний в частности я лично не вижу никакой. Но доступа не дают, такое впечатление что принципиально.

>подключили бы посредников

Попали бы под сосанкции, были бы закрыты. Охуенный план!

А на деле не стоит искать логику там, где работает популизм. Стреляют куда угодно, только не в цель.

Нет сосанкций на продажу доступа к ллм в РФ. У опенов просто огромная инерция, так же, как и у всех остальных.

Аноны, какой нужен минимальный сетап цп + рам, чтоб на этом добре запустить что-то, что будет не хуже гпт3. Или на уровне 3.5.

Если это вообще возможно, конечно...

Если это вообще возможно, конечно...

Да зачем тебе эта рам? Запускай на SSD.

Жпт3 даже 7В ебут. На нормальный сетап надо 48 гигов врам и катиться в 70В. И желательно не две Р40, а хотя бы одну из карт нормальную, лучше две 3090/4090.

>И желательно не две Р40, а хотя бы одну из карт нормальную, лучше две 3090/4090.

Особого смысла нет, производительность будет по слабейшей карте. Немного больше, но именно что немного.

Спасибо, тогда мне локалки не подходят

Самое первое - организовать рабочий запрос, который бы давал сетке инструкцию по написанию (частей) нужного тебе ответа на основе заданных тобой данных. Изложи что именно тебе нужно, попробуй давать примеры запрос-ответ и подобное. Можешь использовать последовательность запросов, где информация будет даваться по частям, или же нейронка пусть сама развивает свою выдачу каждый раз но основе новых иснтрукций.

Фото можешь добавить или на более позднем этапе, чтобы модель с использованием "увиденного" дополнила картину, или же в самом начале дополнив им исходник. Лучше делать это отдельным запросом чтобы не перегружать, на смесь пикчи и текста хреновато реагирует.

Это все применимо как к гопоте, так и к локалкам, только в случае последним придется пердолиться больше по-другому.

> кастрированными

> локальными

Топ кек. Оллама шиз сдался и сменил повестку, в надежде получить нормальный доступ.

Двачую этого, качественные локалки оче требовательны. Или пускать на проце и будет медленно.

Я соевый хайповик, где новые крутые обновления и модели?

> производительность будет по слабейшей карте

Она будет делиться. 10 т/с лучше 4-5.

> производительность будет по слабейшей карте

Часть слоев что на быстрой карте будет обрабатываться быстро, часть что на медленной - медленно, будет усреднение. Какие-то фичи типа row-split и подобное может привести к замедлению.

Двачую, но по постам что тут были меньше 10.

>Двачую, но по постам что тут были меньше 10.

На двух теслах даёт 8, вначале. Ну и?

> Ну и?

На двух современных картах дает 15 в конце, ну и?

Короче, вроде как без полного стирания контекста, новую картинку адекватно нереально прокомментировать, по крайней мере, я не нашел примеров как это сделать.

Через что запускаешь? Изначально в ллаве была работа только с одной пикчей и при загрузке второй первая или заменялась второй, или наоборот игнорировалась вторая в зависимости от лаунчера.

Да сам сижу апи изучаю и свою говнкодерскую прогу делаю.

>Изначально в ллаве была работа только с одной пикчей и при загрузке второй первая или заменялась второй, или наоборот игнорировалась вторая в зависимости от лаунчера.

Да, печально все это.

Не печально, и раньше можно было сделать несколько.

А что за прога?

Что-то подобие коболдацпп, только форма вместо браузерной вкладки.

>и раньше можно было сделать несколько.

Можно, но надо стирать контекст.

Не надо, но эмбеды картинок жрут немало. Другое дело что раньше ллава не имела тренировки с несколькими пикчами и результат был большей частью посредственный, но возможность еще год назад была.

В llamacpp емнип изначально можно было ставить несколько через [img0], [img1], и т.д. ссылки в промте. Как сделано в кобольде - хз, могли упростить и поломать.

А если загружать и спрашивать по очереди?

Если ты в общем как пустить несколько пикч - будет работать в зависимости от конкретной реализации.

Если про перфоманс на нескольких с разными запросами - хз, скорее всего будет норм отвечать, но прошлые ответы могут дать байас а наличие лишней пикчи смутить.