Apple выпускает свое семейство мини-моделей OpenELM

https://www.computerra.ru/296465/apple-vypuskaet-svoe-semejstvo-mini-modelej-openelm/

Я посмотрел на сайте Mistral AI - что-то вообще нет упоминаний о модели 70В. Только 7В и Микстрали. Они что, вообще решили отказаться от семидесятки или собираются её продавать?

Подскажите пожалуйста модельки которые могут в анализ пикчи.

Я тут только LLava и idefics2 нашел.

Второй так и не смог запустить.

>мини-моделей

Да ёб ты нахуй.

>Они что, вообще решили отказаться от семидесятки

Они никогда не заявляли её наличие. Усё, их купили, всё закрыто.

Если нужно что-то серьёзное, то только закрытые. Остальное ты плюс минус перечислил.

В IQ1 кванте, максимум IQ2.

Запускаешь server.

Все.

Нет.

Минорно и сутиативно.

А вот это прикольно.

Все больше смыслов не писать свои обработчики, а юзать таверну.

———

Так, я че-то охуел.

Вы че хуйню советуете?

1. Берешь лламу.цпп там есть куча вариков запуска.

2. Пишешь на JS оформление запроса с промптом + посылание в лламу.цпп

3. Пишешь хтмл-чат.

Буквально все, там вообще найух не нужно ничего кроме голой лламы.цпп, в чем проблема вообще, я в ахуе.

Я даже вопроса не понял, потому что, ну… Вот.

Зачем придумывать велосипеды, я не уловил смысла.

https://github.com/ggerganov/llama.cpp/blob/master/examples/server/README.md

> Да даже банально им будет интересно окунуться в ллм если раньше не пробовали и начнут с использования.

Согласен. Никогда не считал себя гением, и если у слесаря-пенсионера хватает мозгов поднимать ллмки, то уж студенты как-нибудь разберутся. Щас бы JS-чат написать невмочь на готовом сервере.

А кто вообще автор вопроса и что ему надо? А то тут все обсуждают, а я не уловил, откуда инфа про студентов-кумеров и отсутствие контекста. =D

Тебе врут, их куча, но запустить ты сможешь только хуйню, живи с этим. =)

Есть CogAgent, пиздатый.

Есть че-то еще, но я забил даже на названия.

LLaVa-1.6 в принципе неплоха, стоит остановиться на ней, на самом деле. Все остальные старички типа Qwen-VL и прочих слабы, поэтому не стоят внимания.

ИМХО — или Ког, или Ллава-1.6, два варика.

> так как системный промт будет общим

Оно будет оставаться в кэшэ т.к. все запросы начинаются одинаково, но это всеравно крохи. В случае нескольких бэков на малой нагрузке можно сделать привязку юзера к гпу в формате filo, тогда количество обработок чуть сократится, но это почти ситуация простоя оборудования.

Использовать кобольд да и жору в принципе для подобных задач, где обработка немаленького контекста может быть почти на каждый запрос - не оптимальное решение.

Какое такое? Разборка латиносов всех гендеров и возрастов - норм, регулярные битвы китайских тоддеров и грузовиков со стабильным исходом - норм, извинения перед дедпулом - норм, еот треды - норм, а тут рофловая карточка - вах какой ужас? Главное, не пытайся представить какие мыслепреступления технически возможно совершить, в обморок упадешь.

Все это лицемерная хуета и попытки манипулировать, а все ради лоббистов-корпоратов, которым глубоко насрать на все то "хорошее", которое используют в качестве предлогов.

> Вы че хуйню советуете?

> 1. Берешь лламу.цпп

На ноль поделил с порога

> кто вообще автор вопроса

Здесь был чел который трейнил модели. Если ты тут, подскажи вот такую вещь: допустим в json в каждом примере (т.е. имею в виду объекты внутри { }), для простоты в форм. альпаки, длина каждой строки (инпут инстракт ...) пусть 4к, при трейне лоры ставишь обрезку например 2048. Так вот до этих 2048 будет обрезяться каждая строка внутри примера или же весь пример? т.е. длина куска относится к примеру в целом (как в случае с просто текстом) или к каждой строке? Если не сложно ответь, т.к. у мня возникли сомнения на это, хотя я думаю что относится к каждой строке. А вдруг не так.

Есть движок от команды пигмы, который они используют для своего сайта. На нём же крутятся некоторые модели, раздаваемые через кобольд орду, по-моему. Заточен как раз на оптимизированную раздачу моделей для большого числа пользователей. По всей видимости, для большинства задач там используется апи кобольда, но точно утверждать не возьмусь, не разбирался с ним сам.

https://github.com/PygmalionAI/aphrodite-engine

Хуя, чьи-то влажные фантазии.

Пятые же.

> На нём же крутятся некоторые модели, раздаваемые через кобольд орду, по-моему

Не, емним это уже давно полноценный бэк, в котором они еще попыталсь gguf оптимизировать и в чем-то даже преуспели. Правда багов много заявляют.

Его потестить и в шапку уже добавлять, если норм окажется.

> апи кобольда

Операи-совместимый апи, сейчас это стандарт.

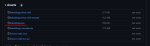

интересные таблицы

К вам можно вкатиться и не поесть говна с 4 Гб врам и 16 ОЗУ? Сколько займёт обработка ответа у нейросети в таком случае? Понимаю, что зависит от настроек, но всё же хочется хотя бы примерно понять, есть ли смысл рвать жопу.

Из-за слабого английского очень сложно, поэтому не хочется потратить тонну времени и понять, что это всё было бессмысленно.

Также интересует, есть ли ультимативный гайд для долбоёбов, пусть и на английском, который как раз описывает установки, в том числе и на слабой видюхе ноут, но в диффузии через костыли генерил приличные картинки, хоть и не так быстро, как хотелось

Насколько я понимаю, можно повесить обработку одновременно и на процессор, и на видюху, и ещё оперативку зайдествовать?

Из-за слабого английского очень сложно, поэтому не хочется потратить тонну времени и понять, что это всё было бессмысленно.

Также интересует, есть ли ультимативный гайд для долбоёбов, пусть и на английском, который как раз описывает установки, в том числе и на слабой видюхе ноут, но в диффузии через костыли генерил приличные картинки, хоть и не так быстро, как хотелось

Насколько я понимаю, можно повесить обработку одновременно и на процессор, и на видюху, и ещё оперативку зайдествовать?

>есть ли ультимативный гайд для долбоёбов

Извинити что не так подписал.

>вкатиться и не поесть говна с 4 Гб врам и 16 ОЗУ

Смотря что ты считаешь говном.

>Сколько займёт обработка ответа у нейросети в таком случае

Железо ты не назвал, но из предоставленной информации можно предположить что-то типа i5 с 4-6 ядрами и 1650 ti. Если предположение верно, то 7-8B будет работать со скоростью примерно 5Т/с, средний ответ 200-300 токенов, т.е., 40-60 секунд. Плюс обработка контекста с участием видимокарты ~10 Т/с, обрабатываться будет 1 раз в начале карточка (в среднем 1000 токенов, 100 секунд), потом только твои новые сообщения (в среднем 100 токенов, 10 секунд добавляй к тем 40-60, ну и после 10 секунд уже можешь начинать читать то, что нейросетка срёт в реальном времени).

>всё было бессмысленно

Зависит от твоих запросов. На мелких моделях мозгов особо нет, но для развлекательных (чатик, ролеплей) целей кое-как годятся.

>установки, в том числе и на слабой видюхе

Сколько влезет до упора (out of memory error) слоёв в видимокарту методом тыка. Если nvidia, ещё в видеодрайвере отключить своп из vram в обычную ram. Закрыть как можно больше посторонних приложений во время работы нейросетки.

Нахуй нам эти влажные таблички свидетелей жпт? В соседний тред разве что добавлять, тут у нас тред локальных.

>~10 Т/с,

40-50т/с, говорю как пользователь еще более старого говна 1050ти

сейчас контекст быстро считает, так что сообщение среднего размера -минута, пауза между сообщениями - минимальна

Тебе повезло, ллама 3 8b как раз для тебя сойдет, она умна и болтает по русски

На видимокарту только выставляй 0 слоев, если кобальд предложит сколько то на нее перекинуть

Потому что скорей всего на таком маленьком объеме врам в 4 гб влезет только контекст займя все место.

Так что быстрее будет скорей всего без выгрузки слоев на видеокарту, но проверь может у тебя процессор картошка, и с выгрузкой именно у тебя будет быстрее

>еще более старого говна 1050ти

И такое у него тоже может быть. И даже хуже, какое-нибудь днище из mx-серии с 64 битной шиной. Плюс порезанные tdp и частоты у мобильных видеокарт, плюс производитель мог сэкономить на охлаждении (и даже в таком виде будет троттлить) и разводке линий pci-e.

>40-50т/с

>сейчас контекст быстро считает

Ну если так, может быть и будет 40-50. А может 25. И слышал, что на cpu вроде там что-то ускорили в недавних патчах, чуть ли не в 2-4 раза. Хотя если у него какой-нибудь пень без avx где avx инструкции, покажи, ткни!!11, или core m с tdp в 5w, будет грустно.

короче можно долго ванговать пока анон не раздуплится ттх своего ноута

Ты таблицу читал? Там локалки перечислены, в том числе. В этом треде активнее всего следят за новыми моделями.

Сделал бы автор фильтр на открытые веса...

Качай ollama. Тут для каждой модельки нужен свой шаблон промпта, без которого нихера нормально модель не будет работать. Этот формат промпта разработчики не всегда указывают явно в описании модели. И вот новая модель выходит и начинается вой - а какой же шаблон взять. С ollama такой проблемы ты не увидишь, просто запускаешь модель одной командой и она работает.

ollama это бекэнд, еще нужно выбрать для него любой понравившийся фронтэнд.

Тут шизы могут ответить мне что они сами определяют формат промта и могут лучше настроить модель. Если ты любишь постоянно пробовать новые модели и ты не пердолик - это не твой путь.

Как ни странно, я вроде бы разобрался. Это было проще, чем установка сд. Но, чувствую, настройки будут сложным делом.

У меня ноутбучная 3050 4 Гб, процессор рязань 5 5600Н. Поставил себе neural-chat-7b-v3-16k-q5_k_m.gguf, таверну и спиздил копипастом описание персонажа с джанитора аи. Пока что впечатления смешанные. Пишет не совсем как даун-аутист, но всё равно хреново, для качественного NSFW не годится, хотя это самое простое, что можно сделать, мне кажется, так как контекста не так много нужно. Хотелось бы какую-то приключенческую модель опробовать, но, чувствую, ПК не вывезет, так как надо будет безумно много контекста в моём случае или времени.

Какие настройки мне нужно выставить на ваш взгляд? Лоурам нужно ставить в кобольде? Слои сейчас потыкаю, там 0 было, насколько помню.

4.66T/s таки скорость.

>3 8b как раз для тебя сойдет

Ну, я в любом случае использую английский, даже через перводчик, потому что на русском всегда только треш видел.

А с телефона переписку проворачивать как-то можно? Особенно удалённо, не в рамках одной сети.

>А с телефона переписку проворачивать как-то можно

Можно. Хостишь на компьютере не на локальном интерфейсе (127.0.0.1), а на внешнем.

>удалённо, не в рамках одной сети

Использовать vpn по прямому назначению.

>любишь постоянно пробовать новые модели и ты не пердолик

На ноль поделил.

Ты взял одну из соевых моделей, для ерп рп вобще не то

К тому же с выходом ллама3 она устарела, да и до нее тоже, были сетки получше

https://huggingface.co/TheDrummer/Moistral-11B-v3-GGUF?not-for-all-audiences=true

Вот ерп, по размеру сам выбирай, но не меньше 4 кванта, чем больше тем лучше но медленнее

Это тупо ерп модель, хоть в шапку ее сувай для кумеров

>хоть в шапку ее сувай для кумеров

Там есть предок этой модели. Она лучше предка?

Она сведет любой диалог к куму, так что она сетка специалист хорошая только в одном.

Предок универсал, топчик, до выхода ллама3

Но ллама3 с ограничениями, а Fimbulvetr их не имеет

Так что хоть Fimbulvetr v2 хоть моистрал может качать и спокойно пользоваться в любых сценариях.

Качай пхы3 от майкрософт.

Если ты думаешь, что я специалист и в чём-то разбираюсь, то ты глубоко заблуждаешься. Но насколько я знаю, это относится ко всему примеру в целом. Фактически в нейронку скармливается твой инстракт+инпут+отпут, как единый кусок текста и уже этот кусок нарезается на части определённого размера. Сама json разметка больше для трейнера, а нейронка обучается на цельном куске текста.

в коде qlora, который я использую для обучения есть отдельные параметры обрезки input и output, по идее все форматы приводятся к одному типу: (input, output, инстракт вырезается), после чего каждое из них по отдельности разбивается на токены.

> в том числе

Хули толку. Там половина нелокальных и галки публичных стоят у всяких жпт.

У тебя от кума голова не соображает, иди подыши воздухом.

Ну тут явно 7b/8b с русским что-нибудь, файнтьюны.

Сузуме для тестов, Мистральки какие-то.

Может 11b какие-нибудь могут.

Качай KoboldCPP, качай gguf файлы, загружай модель.

СиллиТаверн по желанию, если вкатишься в кобольд.

> на таком маленьком объеме врам в 4 гб влезет только контекст

База. Модель будет большей частью в озу, конечно.

А вы знаете, кто еще 4 гига имеет? GT710 =D

Ну и много других видях, да.

> У меня ноутбучная 3050 4 Гб,

Пушка-гонка, братан!

> 7b-…-q5_k_m

> даун-аутист

Тут ты. =) Только q8 для 7b моделек. В критически крайнем случае q6. И то, желательно с imat, матрицами важности.

Но оффенс, но на пятом кванте малой модельки жизни и не может быть.

> 4.66T/s таки скорость.

Ну привыкай морально к поменьше.

> Ну, я в любом случае использую английский

А, тогда можно попробовать 11b модельки из шапки!

Fimbulvetr-10.7B-v1.q5_K_M.gguf

Вот эта и че тут еще насоветуют.

> А с телефона переписку проворачивать как-то можно? Особенно удалённо, не в рамках одной сети.

Как и любой другой софт. Запрос в брэндмауэре открыл, порты через роутер прокинул, айпишник зафиксировал, подрубаешься.

Ну или есть варианты через облако выводить, у некоторых фронтов есть настройка, не уточню.

0.0.0.0 чтобы приложение слушали с внешней сети.

Вот, тоже совет.

Но я бы брал не ниже 5, скорее.

Че ж сразу не эппловскую советуешь, лол.

Чел, он всё правильно написал. Публично доступная модель != локалка.

Анончики, подскажите где можно рерайт статьи сделать в онлайне? Статья на русском, больше публицистика чем наука.

Очень странно. Специально читал какой-то кумерский гайд из шапки, она там была самой лучшей якобы.

Спасибо, завтра попробую. А то я удивился с соевых ответов, т. к. персонажа закинул доминантного-злого.

Если не лень, подскажи, как искать модели в плане того, что мне нужно с точки зрения сюжета, кума, стиля и так далее. С той же стабильной диффузией можно было оценить модель визуально и по пикчам в треде, на цивитаи, а тут хрен поймёшь. Да, у моделей есть характеристики, но они технические, а описание скупое. Не просто же ползать по бордам и читать отзывы или качать что попало.

Заодно, если знаешь, подскажи модель, которая позволит отыгрывать безумие в стиле вахи. Тотальная война, кровь, боль, расчленёнка, магия, современность, диалоги в этом антураже. А если она ещё может в художественное описание, красивое, то есть модель обучена на качественной литературе, то совсем отлично. А если может сама рассказ писать, пока я буду просто гейм-мастером, то вообще отвал башки И в данном случае время ответа для меня не слишком критично, т. к. это не кум и мне не лень ждать, если итог качественный. Только с настройками совсем непонятно будет, наверняка придётся в оперативку выгружать.

Ну хз, я ее второй день тестирую и пока вижу, что она многозадачная вне рамок кума, причем изобретательная. Подходит для написания коротких рассказов, эссе и прочего на заданные темы.

И еще она эрудированная. Вставляет в художественные тексты аллюзии и отсылки, которые подчас удивляют.

Какая из < 70В сеток лучше всего понимает инструкции и следует им?

значит это 2 версия была перетренена на ерп, 3 вышла лучше и умнее как и написали не напиздев в итоге

Command-r

70b llama 3 очень плохо умеет в русский, постоянно срывается на другие языки и несет околесицу. При чем когда я спрашиваю по коду, то отвечает нормально, а когда пытаюсь в ролеплей начинается пиздец. Это можно пофиксить промптами или базовая модель просто кал вне инглиша?

Хорошо она умеет в русский, лучше коммандера. Наверняка ты с форматом промпта обосрался.

Тот же промпт на английском исполняет идеально. Просто переведен на русский и с подписью "отвечать только на русском". Ща еще посмотрел, помогает снижение температуры, правда тогда она совсем в околоформальном стиле все выдает

Ещё один осознал, что инглишь лучше везде и всегда.

Гигачат, Алиса.

При чем здесь лучше? Русский просто вообще никакой, неюзабельный

Tesla P40 с полноценным охлаждением сейчас стоит всего 21к вместе с доставкой в РФ.

https://aliexpress.ru/item/1005006155095429.html

Если кто хотел прикупить - вот отличный шанс!

Ну говно и говно, что бурчать то?

Доение снизу вверх- новое слово в доении животных!

Я вижу цену в 24300 + пошлина.

Караул, обманывают!!

>с полноценным охлаждением

А вытянет ли это охлаждение нагрев теслы?

Его обычно срисовывают с 1080Ti, так что вроде должно. В любом случае оно лучше, чем серверная хуита под обдув 9000к оборотов в наносекунду.

https://qwenlm.github.io/blog/qwen1.5-110b/

Их там прорвало что ли? Каждый день новая модель. До NeurIPS вроде далеко.

Их там прорвало что ли? Каждый день новая модель. До NeurIPS вроде далеко.

Так что, эпплы и мелкомягкие сделали что-то годное или ллама лучше?

Пока высрали только 3b модели. Хуйня без задач.

Странно что с командиром+ не сравнивают. Или не странно, а просто бояться. Надо будет запустить, хотя для меня уже командир+ на пределе возможностей моего ПК, первые генерации в подкачку лезут.

Эпл даже не трогал, у мелкомягких кусок сои вместо модели. Из мелких ллама на 8B выглядит достаточно мелкой, чтобы запускать на кофеварке, и достаточно умной, чтобы ебать всё, что меньше её.

Ну ХЗ, видали и лучше.

>Странно что с командиром+ не сравнивают. Или не странно, а просто бояться.

Так вижу, что если для 70В минимально приемлемым (при наличии возможностей) является Q4, то для сотки (100-120В) должно быть около Q3. iQ3_XXS как самый минимум.

Приветствую, аноны. Сижу качаю языковые модельки, балуюсь, узнаю, что от величины контекста увеличивается частота самоповторения и в общем наступаю на другие такие грабли. Узнаю для себя, что есть некий способ "проверёвить" модель с помощью некоего RoPE. Гуглинг рассказал мне в красочных математических подробностях что это за метод, но нигде я не нашел что его реализовывает и через что модель нужно прогнать, чтобы её "проверёвить".

Так вот вопрос: Что это все-таки такое? Я может быть что-то не понимаю. И как применить RoPE для расширения контекста модели?

Так вот вопрос: Что это все-таки такое? Я может быть что-то не понимаю. И как применить RoPE для расширения контекста модели?

Купил сегодня б/у 3090 за 50к. Запустил mlewd 20b, выгрузил все 63 слоя на видеокарту, а взял и съел у меня 20гб оперативы. Зачем?

кобальт вики, там есть или тут в шапке

>Зачем?

Вкусная.

Can you help me solve this problem? A peasant needs to carry a crocodile, a monkey and a banana across the river. But the boat is such that it can only fit him and one other thing - either the crocodile, the monkey or the banana. If you leave the crocodile with the monkey, the crocodile will eat the monkey, and if you leave the monkey with the banana, the monkey will eat the banana. So how can the peasant carry all his cargo to the other side of the river?

This is a classic logic puzzle. Here's a step-by-step solution:

The peasant takes the monkey across the river first and leaves it on the other side. This ensures the monkey is safe from the crocodile and can't eat the banana.

Side 1 (Starting side): Crocodile, Banana

Side 2 (Other side): Peasant, Monkey

The peasant goes back to the original side with the boat and picks up the crocodile this time.

Side 1: Banana

Side 2: Peasant, Monkey, Crocodile

Now, before leaving the crocodile alone with the monkey, the peasant takes the monkey back across the river. This might seem counterintuitive but it's to ensure he can safely move the banana next.

Side 1: Crocodile, Banana, Monkey

Side 2: Peasant

The peasant immediately goes back and picks up the banana, since now the monkey is on the safe side and can't eat the banana.

Side 1: Crocodile, Monkey

Side 2: Peasant, Banana

Finally, the peasant takes the monkey across again without the banana, as the banana is already safely on the other side.

Side 1: Crocodile

Side 2: Peasant, Monkey, Banana

Now all three items, the crocodile, the monkey, and the banana, have been safely transported to the other side of the river without any of them being eaten.

Решение задачи совершенно правильное, но модель явно не понимает где, кто и почему.

Но зачем, когда на Авито дешевле лежат?

Хз, у меня 21200.

На Avito нигде нет P40 с таким охуенным кулером.

Дохуя покупаешь, золотой.

> с таким охуенным кулером

За 1000р купи для 1080 Ti охлад и прилепи, он отлично встаёт на P40.

>Но зачем, когда на Авито дешевле лежат?

Что там лежит - это ещё большой вопрос, но дело не в этом. За 21к с таким охладом я бы её взял. Проблему правда вижу - до 250 ватт тепла будут рассеиваться непосредственно в корпус. Одна такая карта конечно не проблема, но у меня не одна.

>для 1080 Ti охлад

Ты про референсный с турбиной или что-то другое?

>он отлично встаёт на P40

Сам то пробовал? Там же вроде есть некоторые отличия в пазах.

Ладно, возьму на попробовать к 4090. Но как-то надежды на этот кал не сильно много. В целом похуй даже если не взлетит.

Я надеюсь у тебя нормальные кванты от бартовского, а не старый поломанный мусор, который выкатывали в день релиза?

>Проблему правда вижу - до 250 ватт тепла будут рассеиваться непосредственно в корпус

Втыкай райзер, выноси карты наружу.

> в пазах

В каких пазах? У всего поколения стандартизированное крепление, как минимум основные точки возле GPU. Места, прилегающие к питальникам на краю, возможно не подойдут, да оно и похуй, если не будешь в перевёрнутом положении ставить ничего не случится.

>Я надеюсь у тебя нормальные кванты от бартовского

Конечно же нет, их не было, когда я качал. Впрочем так даже веселее.

Ладно, качну новый квант, хотя вряд ли он тут поможет.

Параметр no-mmap в угабоге включи.

> нормальные кванты от бартовского,

Спроси 3333+777 у этого кванта, какой ответ выдает?

>Ладно, возьму на попробовать к 4090.

Не забудь сделать обзор, как приедет. А то ни одного отзыва. Первым всегда тяжело(с)

>Но как-то надежды на этот кал не сильно много.

Не, тема хорошая. 70В пощупать за вымя - с чувством, с толком, с расстановкой - это приятно :)

>3333+777

Лил. Пойду обратно старые доставать.

>Trained on publicly available datasets, these models are made available without any safety guarantees.

Обученные на общедоступных массивах данных, эти модели предоставляются без каких-либо гарантий безопасности.

>Consequently, there exists the possibility of these models producing outputs that are inaccurate, harmful, biased, or objectionable in response to user prompts.

Следовательно, существует вероятность того, что в ответ на запросы пользователей эти модели выдадут неточные, вредные, предвзятые или неприемлемые результаты.

и это модели от эпл, нежданчик конкретный конечно же

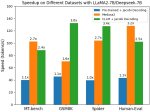

https://www.reddit.com/r/LocalLLaMA/comments/1cdn9zd/transforming_llms_into_parallel_decoders_boosts/

transforming LLMs into parallel decoders boosts inference speed by up to 3.5x

Hey all! We are here to share our latest work: consistency large language models (CLLMs), which is a new family of models capable of reducing inference latency by efficiently decoding n tokens in parallel. Your new friends for LLM serving/local deployment with faster inference speed!

Compared with existing fast decoding techniques, CLLMs achieve fast parallel decoding without the need for:

• Draft models

• Architectural modifications/auxiliary model components

This introduces a number of advantages for CLLMs:

• CLLMs don't have to deal with the complexity of obtaining 'good' draft models and managing two different models in a single system.

• CLLMs share the same architecture with target LLMs and require no additional engineering efforts when adopting the technique to different models.

• CLLMs can be integrated seamlessly with other techniques for efficient LLM inference (e.g. Lookahead Decoding) to achieve even more significant speedup.

This decoding method CLLMs use is called Jacobi decoding, which improves inference efficiency in comparison with conventional auto-regressive decoding. CLLMs are trained with the objective of performing efficient Jacobi decoding by mapping any randomly initialized n-token sequence to the same result as AR decoding in as few steps as possible.

Experiment results have demonstrated the effectiveness of CLLMs, showing 2.4× to 3.4× improvements in generation speed on a variety of tasks.

transforming LLMs into parallel decoders boosts inference speed by up to 3.5x

Hey all! We are here to share our latest work: consistency large language models (CLLMs), which is a new family of models capable of reducing inference latency by efficiently decoding n tokens in parallel. Your new friends for LLM serving/local deployment with faster inference speed!

Compared with existing fast decoding techniques, CLLMs achieve fast parallel decoding without the need for:

• Draft models

• Architectural modifications/auxiliary model components

This introduces a number of advantages for CLLMs:

• CLLMs don't have to deal with the complexity of obtaining 'good' draft models and managing two different models in a single system.

• CLLMs share the same architecture with target LLMs and require no additional engineering efforts when adopting the technique to different models.

• CLLMs can be integrated seamlessly with other techniques for efficient LLM inference (e.g. Lookahead Decoding) to achieve even more significant speedup.

This decoding method CLLMs use is called Jacobi decoding, which improves inference efficiency in comparison with conventional auto-regressive decoding. CLLMs are trained with the objective of performing efficient Jacobi decoding by mapping any randomly initialized n-token sequence to the same result as AR decoding in as few steps as possible.

Experiment results have demonstrated the effectiveness of CLLMs, showing 2.4× to 3.4× improvements in generation speed on a variety of tasks.

Да, ослабил семплеры, и скатился в пример из бага. Считает правильно, но не тот пример. Пойду читать баг дальше.

У тебя точно что-то не так напердолено.

>Оба используют архитектуру LLaMA, оба используют токенизатор BPE, и поэтому в настоящее время они будут интерпретироваться llama.cpp как один и тот же арч.

>Однако они используют разные пре-токенизаторы

там всё плохо

https://github.com/ggerganov/llama.cpp/pull/6920#discussion_r1581043122

>и это модели от эпл, нежданчик конкретный конечно же

В целом, там типовая юридическая хуйня, чтобы прикрыть свою жопу - "мы не несём никакой ответственности за возможные последствия". Это особенно актуально в странах уровня США, где по каждому чиху против тебя могут подать судебный иск.

>So maybe we have to start parsing this information from the tokenizer.json

Прошёл год, и тут герганов догадался, что его грязные хаки приводят к промблемам. ЛЛЛОООЛЛЛЛ. Я знал, что жора поднасрал!

>ждём исправлений по части квантования от жоры, наверняка он подгадил

>и тут герганов догадался

Ан нет, показалось, идём на костылях дальше. В коммерческих проектах за такие подходы по пальцам линейкой пиздят.

Как запустить ебучую llama3 на ебучей угебуге?

какая то ебля с <|eot_id|> должна быть но я нихуя не смог

какая то ебля с <|eot_id|> должна быть но я нихуя не смог

У меня вобще отказывается продолжать ответ, иногда высирая что то в попытках ответить, но обычно просто сбрасывает генерацию стоп токеном

Пиздец, какой же жорик говнокодер...

Пойду exl2 квант качать.

Какую именно? Что ты скачал?

Короче пока не пофиксят вот это, все лламы 3 официально сломаны на корню, так как тут сломано объединение \n\n в один токен, а этот токен из базового темплейта, так что это полный пиздец для модели, минус половина IQ на ровном месте.

https://github.com/ggerganov/llama.cpp/issues/6809

Благодарю! значит я думал неправильно. Ну теперь буду знать.

Если инстракт вырезается и при этом инпут пустой, например такие датасеты бывают из визардоподобных. У альпаки также допустим пустой инпут. Как в этом случае происходит?

ну, там герганыч уже мутит что-то

https://github.com/ggerganov/llama.cpp/pull/6920/commits/9b4d63ae53055c03f22649e88811c39f22c33532

А бля это я инструкт режим не врубил, с ним отвечает но все равно неправильно

зато понятно почему есть такое отличие между онлайн версией и на руках

Ты файнтьюн скачал, нахуя? Еще и без квантования. Ладно, квантование у жорика сейчас сломано, но есть еще exl2.

Ладно, можно и эту залупу запустить на трансформерах, только скорость будет такая себе.

Сколько видеопамяти?

Да, я написал, что костылинг

По сути он предлагает хардкодить несколько вариантов и выбирать их при конвертации в гуф в зависимости от того, что выведет оригинальный токенизатор. То есть если в строке для примера нет символов, которые иначе обрабатываются разными токенизаторами, то гергановский код не найдёт отличий и пришьёт стандартный токенизатор.

Переведите плиз это на инглишь, у меня с ним плохо, да укажите на очевидный проёб. Я тупой слишком.

>все лламы 3

Не все.

https://huggingface.co/alokabhishek/Meta-Llama-3-8B-Instruct-4.0-bpw-exl2

https://huggingface.co/alokabhishek/Meta-Llama-3-8B-Instruct-5.0-bpw-exl2

https://huggingface.co/alokabhishek/Meta-Llama-3-8B-Instruct-6.0-bpw-exl2

https://huggingface.co/alokabhishek/Meta-Llama-3-8B-Instruct-8.0-bpw-exl2

Хули толку мне от экселя, когда у меня 12 врама и желание запускать 70B. На дрочь в стиле "Да эта 8B ебёт все 70B" внимания по привычке не обращаю.

какая ллама3 проблемная, 2 раз перекачивать а может и третий

прости я не очень умный и плохо разбираюсь во всем этом, ты не мог бы объяснить пожалуйста что ты сказазл

Вангую, сейчас поищут, и найдут застарелые баги с первых версий, где всё было сломано. Всё кроме первой лламы по сути под ударом, лол.

ой прости, я GGUF версию качал, ошибся в ссылке

>какая ллама3 проблемная

Все, кроме и оригинальных весов

по ходу так и есть.

и это может объяснить почему модели очень часто игнорят инструкции и описание в ST.

Видеопамяти у тебя сколько сколько?

Срут ассистентами, лол.

16 Gb

С какими настройками?

Везде ллама 3 инструкт из новой таверны, семплеры на отъебись Min P 0,05 и Frequency Penalty 0,3, остальное отключено. У тебя ассистентов нету?

существует множество датасетов, к примеру у альпаки инстракт и инпут всегда склеиваются в одну строку, после чего поле инстракт вырезается, на выходе всегда получаются только input и output данные, которые обрезаются в соответствии с параметрами. затем это все склеивается и разбивается на токены. причем, насколько я могу судить обучение проходит только на output токенах, а input токены скрываются и служат только инстрактом. в qlora есть отдельная опция, чтобы включать обучение и на инпут данных.

А я пока качаю, подожди. Но вангую что говноед на квантователе правленые конфиги не прикрепил, к счастью от высера Жоры где только переквантовывать и никак иначе - тут это правится в блокноте. Сейчас докачаю, затестирую и выложу фикс если моя догадка верна.

Продал Арк на 8 памяти купил на 16. Какую модель посоветуйте для рп не порнуха, анончики?

>input и output данные

чтобы не запутать: так происходит для каждого семпла в датасете, а далее после всех манипуляций оно, возможно, склеивается в батч и отдается на трейн.

>продал одну тыкву и купил тывку чуть побольше

Ты как так умудрился то? Мог бы спросить сначала в треде.

Llama3.

Мне эта тыква нравится вне зависимости от того буду я нейронить или нет

Мета пидоры, в репу доступ не дают.

Двачую.

Ну ни смишно...

Прошу прощения за платиновый вопрос, но какие модельки хороши для кодинга, чтобы умели прям в структуру кода и чтобы у меня была возможность всю простыню кода умещать в контекст? Хотелось бы более менее подробное описание вашего опыта.

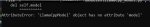

>квантование напрочь убивает способности модели.

>Сетка на 8 кванте буквально отрастила 0.3 iq.

Пока у меня качается попробуй

В config.json

"eos_token_id": 128001 --> "eos_token_id": 128009

tokenizer_config.json

"eos_token": "<|end_of_text|>" --> "eos_token": "<|eot_id|>"

Тоже написал, что ты из института Cumming research? И что им в этом институте не нравится...

А это вообще законно? Надо будет пожаловаться.

Там шаблон не торт, модель в других местах по тупеет.

codeqwen

Типа помогло.

У них тест сломан, викитекст на 16 и 8 битах выдает 6.1, ебануться, у меня 5.49 выдавал.

Наверное с ассистентами замеряли.

>чтобы умели прям в структуру кода

Не уверен, что ты под этим подразумеваешь, но, скорее всего, нейросетки тебя разочаруют. Пробуй 70+B.

>описание вашего опыта

~7B - "умный" автокомплит

~30B - туповатый вкатун после курсов

Ну конечно помогло, Цукерберг выложил ломанные конфиги, которые пофиксили этой правкой в тот же день, но говноеды до сих пор неправленные используют.

Спасибо, понял. Командира пробовал?

Нет таких. ~300-500 строк кода и начинают шизить.

Пиздец, а вот мне самому не помогло, выдает вот такую тарабарщину.

Я вообще в шоке с этих двачеров. Реально ёбнутый народ. Пол года назад писал про фарадей. Уже год как он существует. Но нет в шапке в пункте "для ретардов" до сих пор торчит унылый кобольд, который тру-ретард хуй запустит. А сообщения от тугодумов так и продолжают литься... ОБРАЩАЮСЬ К ДОЛБАЁБАМ! КАЧАЙТЕ ФАРАДЕЙ И НЕ СЛУШАЙТЕ УМНЫХ ДЯДЕЙ С ТРЕДА!!! СКАЧАЛ-ЗАПУСТИЛ-ПИЗДИ И ЕБИ КОГО ХОЧЕШЬ! 0 НАСТРОЕК Так же эта программа даст тебе более менее базовые знание по текстовым нейронкам если ты вообще дуб.

Кто там говорил, что экслламы не ломаются?

>0 НАСТРОЕК

>эта программа даст тебе более менее базовые знание

Lol, базовое знание, как двигать мышкой?

>фарадей

Их пидорский сайт тормозит на моём файрфокс на конфиге, на котором можно на марс слетать. В пизду их.

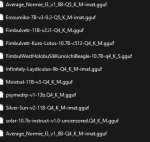

Wavecoder можешь взять, вот пикрилейтеды калькуляторов от него на расте и крестах, с первого раза написал компилирующийся и работающий код. С правками существующего кода в целом хорошо справляется, контекст какой хочешь будет по длине, continue ещё и может из базы/гита/документации/гугла дёргать контекст.

пикрил

1. Дефолтная ллама3-8б-ггуф (q8_0).

2. Промпт моего дефолтное помощника, вообще без этих ваших промптов с еотами.

3. На русском.

4. С первого раза.

¯\_(ツ)_/¯

Раст код не очень.

CodeQwen, вестимо, неплохой вариант.

ПОДДЕРЖИВАЮ

ДОЛБАЕБЫ, КАЧАЙТЕ ФАРАДЕЙ

И ВООБЩЕ ПИЗДУЙТЕ ИЗ ТРЕДА, СОЗДАВАЙТЕ СВОЙ ТРЕД ДОЛБОЕБОВ

ДОБРА!!!

Забыл сказать, семплеры спиздил из этого треда, может это пороляло.

Эксллама отвечает кривее, кстати, но возможно дело в старом кванте бывшей, я не перекачивал ее прост.

А ггуф из последних.

Понятное дело что не очень. Но написать собирающийся кусок кода для локальных сеток пол года назад было невыполнимой задачей.

жоржич чёт намутил, интересно

https://github.com/ggerganov/llama.cpp/pull/6920#discussion_r1581262230

https://github.com/ggerganov/llama.cpp/pull/6920#discussion_r1581262230

Ебать ты тормоз, уже осудили код

да затупил, промотай, там ниже есть

Ебало кодеров с дипсиком представили?

Может быть, после этого поумнеет хоть немного.

Покажи настройки семплера

Спасибо, покумил.

А вот на ггуфе ллама3 не триггерится.

А вот на ггуфе ллама3 не триггерится.

пуританы ебучие, какая же тряска у них пиздец, но в то же время они не против обучения ллм-ки на какой нибудь гендерной хуйне для несовершеннолетних или исключительно положительная инфа по байдену с демократией

Чет в ИИ какой-то застой после выхода лламы 3. Заметили?

А до выхода было как-то иначе? Там вообще ни одна моделька младше 30+В не работала. Ллама хотя бы часть инструкций слушается.

Да, ужас, базовые модели выходят всего лишь через день. Это вам не по 5 шизомержей каждый день!

Нет, вышла фи-3 и опенелм, так что шутка даже не удалась.

>Какой-то микрокал

Меняй на 400, модели со 100B уже подзаебали.

Да почему Пахома так разъебывает, когда собеседник уходит.

Поделись карточкой Пахома, плиз

Карточка и настройки:

https://jumpshare.com/s/XKABwTfVUYwjI3a1JS3G

https://jumpshare.com/s/z0L7LFheo7m2Ns4r498Q

Вообще не очень похоже на Пахома получается, но я все равно проигрываю с его ответов.

Не знаю точно ли от этого зависит, потому что мало еще тестировал, но лишний перенос в префиксе или суффиксе в ~8б может сеть заставить через несколько диалогов ввести в бесконечный вывод промта. Так что с этим надо быть очень внимательным.

Это у тебя ллама-8В так круто отыгрывает?

Нет, это command-r-v01-imat-Q5_K_M

А серафину тоже командир играет?

>обучение проходит только на output токенах

Предположим, что инстракт это А. Оутпут, соотвественно, Б. Если обучать только на оутпуте, то как нейросеть узнает, что после А следует Б?

>input токены скрываются и служат только инстрактом

Потому что во множестве датасетов инпут типовой. You are helpful son of a bitch. Вполне возможно, что в твоём коде инпут просто токенизируется один раз и потом переиспользуются. В случае трейна на рп датасете получится хуйня. Как и если вырезать инпут полностью.

Да.

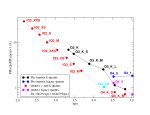

https://www.reddit.com/r/LocalLLaMA/comments/1cdb2is/multimodal_llama3_bunnyllama38bv_beats_llavav16/

multimodal Llama-3! Bunny-Llama-3-8B-V beats LLaVA-v1.6

The first Multimodal Large Language Model (MLLM) based on Llama-3! Bunny-Llama-3-8B-V has been officially launched, surpassing a variety of models such as LLaVA-7B, LLaVA-13B, and Mini-Gemini-13B. It performs well on multiple mainstream benchmarks, demonstrating superior recognition, mathematical, and reasoning capabilities.

Bunny homepage: https://github.com/BAAI-DCAI/Bunny

Bunny-Llama-3-8B-V: https://huggingface.co/BAAI/Bunny-Llama-3-8B-V

demo: https://2e09fec5116a0ba343.gradio.live (may expire, get the new link from our homepage)

The Bunny model adopts the classic Encoder+Projector+LLM architecture, providing a compositional framework. It supports various Vision Encoders such as EVA CLIP, SigLIP, and multiple LLM Backbones including Llama-3-8B, Phi-1.5, StableLM-2, Qwen1.5, MiniCPM and Phi-2. The flexible architecture design facilitates users to conduct various research based on Bunny.

Похуй если в русик не может как та китайская залупа до этого

Бля, ну пизидиь на русском крайне нихуево на самом деле, но русский текст на пикче прочитать не может

если это то что я читал утром то там проектор хуевый, не как у ллава 1.6, а как у ллава 1.5

разрешение меньше сетка выезжает чисто за счет мозгов основы

> Но как-то надежды на этот кал не сильно много.

А зачем тогда берешь? Ууу мажор ебаный мог бы 3090 взять

Довольно интересная штука. Но, только не до конца понял, это выходит только для гриди энкодинга?

О, дней с поломанного ггуф -> 0

Oh you~

О, красава, надо будет с инструкт попробовать.

пиздец

Аноны, хочу вкатиться в локал АИ, разбираюсь с кобальдом в первый раз.

Какую модель скачать, если я хочу спайси чат, у меня 1080 TI 12 GB, 32 оперативы, общаться буду на английском?

Ту, что в шапке, или для моих целей есть лучше?

Какую модель скачать, если я хочу спайси чат, у меня 1080 TI 12 GB, 32 оперативы, общаться буду на английском?

Ту, что в шапке, или для моих целей есть лучше?

Качай из шапки. Скоро тряска с 3й лламой разрешится - скачаешь ее и будешь радоваться.

Q4 мастер раса

Чтоэта?

А вот такая штука не будет апдейтом над той, что из шапки?

https://huggingface.co/Sao10K/Fimbulvetr-11B-v2-GGUF

Или это для другого?

блять реально, вот у меня есть Q8 этой лламы https://huggingface.co/Orenguteng/Llama-3-8B-Lexi-Uncensored-GGUF/tree/main

только что закачал Q4_K_M, ответы как будто стали точнее, но модель вместо большей креативности теперь шизит на 0.7 температуре, потому убавил на 0.59, походу вся llama.cpp люто поломана и только некоторые кванты "успешны".

Снова я

Аноны, кобольд не запускается. Просто ничего не происходит, когда жму exe шник. Вообще ничего. Никаких окон не открывается.

Погуглил, такой проблемы нет у людей. Может кто сталкивался?

Аноны, кобольд не запускается. Просто ничего не происходит, когда жму exe шник. Вообще ничего. Никаких окон не открывается.

Погуглил, такой проблемы нет у людей. Может кто сталкивался?

Хз, наверно, попробуй

Запусти терминал/командную строку и вызови из нее. Прочти код ошибки что там напишет и сам загугли, если не справишься - тогда пости сюда.

Спасибо, получилось. Поставил силли таверн, застрял между вот этими шагами:

>2. Запускаем всё добро

>3. Ставим в настройках KoboldAI везде, и адрес сервера http://127.0.0.1:5001

Я жму иконку вилки, и он предлагает подключатся хуй знает куда, дает какието модели выбрать, хотя у меня всего 1, спрашивает API ключи, что то не пойму как сказать ему, что бы подключался локально к моей штуке.

Скрин покажи вкладки что там у тебя, скорее всего выбрал неверный формат api и стучишься к впопенам.

Это вообще норма, что иногда сеть сама себе задает инструкцию и отвечает на нее же и так до бесконечности? Не появляется стоптокен почему-то.

Ллама 3?

не wavecoder-ultra-6.7b-Q5_K_M.gguf

Но я на русском к ней обращаюсь. Может в этом проблема.

Это один из вариантов поломки, если бывает редко то просто забей и свайпни.

Частично.

Потыкал квен 8b, чет говно какое-то. Мне лама 3 базовая лучше респонсы выдает

Аноны, как то сильно наебнулся кобольд, перезагружаться надо было, теперь не могу запустить его в работу, все время останавливается на такой строчке в консоли:

>llm_load_tensors: ggml ctx size = 0.51 MiB

Дальше ничего просто не происходит, никаких ошибок, апдейтов, просто он не запускается дальше. В чем может быть дело, как исправить?

>llm_load_tensors: ggml ctx size = 0.51 MiB

Дальше ничего просто не происходит, никаких ошибок, апдейтов, просто он не запускается дальше. В чем может быть дело, как исправить?

Конфиг, параметры, модель, цвет потолка?

диск проверь.

Сегодня узнал что в таверне есть всртроенная поддержка openrouter и понял зачем там нужны бесплатные модели вообще. С моей немощной пекой охуенно вообще, если вам не важно что какой-то дядя читается ваши извращенные сообщения по склонению к сексу код-ассистента, то вообще же топ. Не понимаю почему они дают это бесплатно юзать

С коллабом беда какая-то случилась.

>imat

Зачем ты его взял для русского? Они же его калибруют для английского.

>The first Multimodal Large Language Model (MLLM) based on Llama-3

А это тогда что?

https://huggingface.co/xtuner/llava-llama-3-8b-v1_1

Есть две карточки на 24 и на 12 в одном пк, как в кобольд спп загрузить модель так, чтобы сначала заполнялись 12, а потом 24, но при этом 24 считалась первой, чтобы контекст хранился только в ней?

Ответ "Никак" устроит?

Да, но будет обидно

Тогда настраивай тензор сплит вручную. Карту на 24 ставишь везде первой, а заполняться в любом случае будут обе, разве что если ты не выделишь при сплите первой 0% (не уверен, что прокатит).

А откуда вообще желание разгрузить 24 гиговую?

Потому что я слышал, что контекст не может быть разделён между несколькими карточками.

Ну да. Но она всё равно имеет больше врама, так что даже при тупом разделении 50/50 места для контекста остаётся ещё 11 гиг.

Тем не менее я этого ебучего команде-ра в пятом кванте не могу загрузить даже с 6к контекста, с бОльшими моделями проблем меньше. Что в эксле не грузится нормально, что в ггуфе.

Ну вот и попробуй в тензор сплит что-нибудь типа 1,99

Какие модели лучше всего подходят для написания рассказов и литературы?

Пишет тот анон, который с 3050 laptop 4 Гб.

Ещё есть проблема. Я создал ссылку для всяких джаниторов в кобольде, которая через API, но ответы по какой-то причине очень короткие и хуёвые на сайте (в настройках я там порылся как надо), при этом в таверне всё в порядке. Довольно досадный момент, потому что с телефона нормально не посидишь тогда. Какие приложения вы используете для тела или сайта? Гуглил, но там один тухляк либо гомоебля.

Генерация у меня, конечно, долгая, но я никуда не спешу, поэтому интересуют именно качественные варианты.

Пишет тот анон, который с 3050 laptop 4 Гб.

Ещё есть проблема. Я создал ссылку для всяких джаниторов в кобольде, которая через API, но ответы по какой-то причине очень короткие и хуёвые на сайте (в настройках я там порылся как надо), при этом в таверне всё в порядке. Довольно досадный момент, потому что с телефона нормально не посидишь тогда. Какие приложения вы используете для тела или сайта? Гуглил, но там один тухляк либо гомоебля.

Генерация у меня, конечно, долгая, но я никуда не спешу, поэтому интересуют именно качественные варианты.

https://huggingface.co/Lewdiculous/Average_Normie_l3_v1_8B-GGUF-IQ-Imatrix

Получше Соланы. Даже РПшит, может пригодится кому.

Получше Соланы. Даже РПшит, может пригодится кому.

А куда этот Imatrix.dat совать?

Хз. Я просто модель скачал, и ничего больше, все работает.

Честно говоря не понял из твоих слов ничего.

Сервера лежат?

Я отписывался в начале треда, но хрен с ним. Вряд ли все аноны читают тред.

1. Какие модели для кобольда позволяют написать что-то вроде небольшого рассказа или книги?

2. Существуют готовые решения для работу через, чтобы можно было использовать локальную нейросетку, находясь вне дома? То есть на телефоне и через удобный интерфейс типа таверны.

Лучше скажите, когда пофиксят llama-3-8b так, чтобы она не срала эндофсиквенсами постоянно.

Блокируются тунели Cloudflare и remote.moe, как будто бы самим гуглом. Хотя почему-то без проблем создаётся туннель к API. Но мне сейчас лень с этим разбираться

Поставил отдельный костыль для запуска интерфейса его блокировать будет не так просто если API заблочат, можно будет через него же запускать

Кумьте дальше, аноны!

1.Там вроде пресеты есть в кобольде. Попробуй.

2. Не интересовался если честно.

>2. Существуют готовые решения для работу через, чтобы можно было использовать локальную нейросетку, находясь вне дома? То есть на телефоне и через удобный интерфейс типа таверны

Так саму таврну и юзай, зачем ещё что-то

https://docs.sillytavern.app/usage/remoteconnections/

Сколько нужно ram для оригинальных весов?

1. Любой нормальный рп файнтьюн должен бы уметь в сторителлинг. Основной инструмент тут промпты имхо, т.е объяснить в системном промпте, что ты хочешь, чтобы модель выступала рассказчиком. В таверне есть adventure шаблон с простеньким промптом для примера, а на чубе можно посмотреть карточки персонажей-рассказчиков. По моделям: есть старые 13б модели, которые хвалили за сторителлинг. Например, LLaMA2-13B-Estopia, LLaMA2-13B-Psyfighter2, Chronomaid-Storytelling-13B. Но катать 13б даже на 8 гиговой карте - это боль, на 4-х ты просто задолбаешься ждать, и на нормальный контекст тебе не хватит, а для историй он важен. Лучше попробуй относительно хорошие файнтьюны мистраля Kunoichi-DPO-v2-7B или WestLake-7B-v2.

2. У тебя отличались результаты через таверну и с чистого апи кобольда, потому что были разные промпты, сэмплеры, инстракт-форматы, скорее всего. Таверна посылает в кобольд свои промпты и параметры. Как правильно сказали выше, лучше поднимать таверну и подключаться к ней удалённо. Если смартфон не картошка, и есть желание попердолиться, то можно полноценно поставить таверну через термукс (гайд в шапке, и он же есть на сайте ст на гитхабе).

Что делать, если я затупок и у меня нихуя не получилось?

У тебя кобальд не запустился похоже, у меня сам в браузере открывает http://localhost:5001/#

Я тут выбрал .gguf файл и нажал лаунч, потом открылась командная строка там чёт появилось и она закрылась, в браузере ничего не открылось

Короч. Открывай через консоль

./kobolcpp

Там логи отображаются.

Варианты: Видюха есть? Проц новый? Памяти хватает?

Попробуй

./konoldcpp —noavx2 —nommap —useclblast 2 0

Последнюю используй если есть видюха и цифры нужно 2 0 нужно выбирать конкретные, которые у тебя. Там должно показывать

Что за видюха? Если Нвидиа выбирай CUBLAS. Если командная строка вылетает, значит он не запустился. Потом что за версию ты скачал там разные есть, с AVX без него, с CUDA, без негою

Прошу пояснительную бригаду по LLava с Llama3.

Скачал GGUF, открыл через угабугу, Таверна на конце.

Модель нормально грузится на карту.

Далее прикрепляю пикчу к тексту, прошу описать её.

А модешь пишет или тарабаршину или вообще не по теме пикчи.

Промпт Альпака.

Или LLava надо как-то иначе запускать?

Скачал GGUF, открыл через угабугу, Таверна на конце.

Модель нормально грузится на карту.

Далее прикрепляю пикчу к тексту, прошу описать её.

А модешь пишет или тарабаршину или вообще не по теме пикчи.

Промпт Альпака.

Или LLava надо как-то иначе запускать?

Видюха Gigabyte GeForce GT 1030

Процессор старый Intel Core i3-2100

Оперативки 16 гб

cublas выбрал - результат тот же.

Kobold качал, тот что на пике, а .gguf вот отсюда https://huggingface.co/Sao10K/Fimbulvetr-10.7B-v1-GGUF/blob/main/Fimbulvetr-10.7B-v1.q5_K_M.gguf

>LLava с Llama3

Там сама ллама 3 работает через пень колоду, а ты ещё картинки подрубаешь.

А так сначала в убабуге проверяй, раз через неё запускаешь, таверна тут лишняя точка отказа.

Печальный у тебя ПК. В общем ты в этот каталог скачал? Тогда запускай koboldcpp.exe (не стесняйся пользоваться табом для автоподстановки), выполняй те же действия, что привели к ошибке, и в консоли будет текст ошибки, неси его к нам.

А в угабуге я хз как пички прикреплять к сообщению.

>i3-2100

У этого avx2 нет.

>Что делать, если я затупок

Учиться пользоваться компьютером (рряя, пердолинг), либо ждать, когда барин подгонит решение в один клик (впрочем, и тут есть подводные, барин может просто послать тебя на хуй пока не обновишь пеку, потому что барину лень старьё поддерживать). Кто-то там рекламировал всякие олламы где всё за тебя сделано, без пердолинга, в один клик и вот это вот всё, можешь как раз протестировать, как оно, потом в треде расскажешь.

Чел. Скрин смотри внимательно. Там у теб ошибки в каждой

./koboldcpp —noavx2 —nommap

Должен быть запуск выбора модели, а потом вылет.

И используй если что powershell

NousResearch_Meta-Llama-3-8B-Instruct

Все еще не помнит что такое DSBM, срет ассистентами.

>Все еще не помнит что такое DSBM

Ллама 3 сломана, жди починки, сразу вспомнит твой БДСМ.

Это оно?

>Не понимаю почему они дают это бесплатно юзать

датасеты собирают, натуральные человеческие данные сейчас новая нефть

как и все компании и сайты предоставляющие легкий доступ к чату с моделью, лол

Попробуй запустить с флагом --noavx2

Веса или UI?

Надеюсь что не UI, потому что из новой oobabooga убрали файл requirements_NOAVX2.txt, а при попытке загрузить гуфф выдает рил. Двойной удар по россиянам нищукам, но такова цена жизни в сверхдержаве.

>натуральные человеческие данные сейчас новая нефть

И что ты прикажешь делать с тонной кума, зачастую извращённого?

>Веса или UI?

Всё, что связано с гуфф и жорой.

винда тупо тормозит жоржича

https://github.com/ggerganov/llama.cpp/pull/6920#issuecomment-2080419420

https://github.com/ggerganov/llama.cpp/pull/6920#issuecomment-2080419420

Запустилось, большое спасибо!

>Видюха Gigabyte GeForce GT 1030

>Процессор старый Intel Core i3-2100

>Оперативки 16 гб

Я то думал это я тут самый страдалец с 1050ти по сравнению с господами погромистами с двумя 3090/4090 или р40

Оперативка хоть не одной плашкой памяти?

Если еще и одноканал то вобще жопа

Качай 7b какую нибудь, на вроде starling-lm-7b-beta или openchat-3.5-0106 или новенькую WizardLM-2-7B

Квант качай gguf формата Q4_K_M или Q5_K_M, чем больше тем медленнее будет, но и качественнее.

8 квант самый жир но у тебя будет медленно

>И что ты прикажешь делать с тонной кума, зачастую извращённого?

Ну во первых там не только кум, там и обычные чаты.

Во вторых все что им не нравится фильтруется и собирается в датасет которым будут проверять устойчивость модели к снятию цензуры и сои

И все ваши джейлбрейки так же собираются что бы делать более устойчивые модели

>Ну во первых там не только кум

Его там 95%.

>И все ваши джейлбрейки так же собираются что бы делать более устойчивые модели

Ну вот мелкософт выпустила "устойчивую" модель, с которой даже козу не подоить. И кто её обсуждает?

Даже корпы уже начинают подозревать, что стричь деньги за "Извинити, я не могу это сделать" вечно не выйдет. Вон, антропики ослабили цензуру в своём клоде, да и последний снапшот GPT намного менее соевый, чем высер 0125.

Так что маятник качается, окно расширяется, процесс илёт.

> есть всртроенная поддержка openrouter и понял зачем там нужны бесплатные модели вообще.

Что? А пруфы слива данных есть?

>мелкософт выпустила "устойчивую" модель

это ты про wizardlm-2 ?

если да, то там пиздец, эта модель по тестам тупо оветрейн на сое, например если спросить про гендерную хуйню - ответит в ту же секунду и без запинок, и только в положительном ключе, но так честно говоря с любой локалкой, потому если РПшишь с обычной (или не очень) тян то иногда модель может приделать ей хуй ради разнообразия и инклюзивности прямо посреди разговора.

в случае с лламой-3, то там тупо упирается в фем-шизу и дыхание вагиной "my body - my choice" даже если у тебя всё честно и по согласию, если короче, что-то не видно качения маятника :/

Всё, что ушло дальше тетради с ручкой, по дефолту слито.

>это ты про wizardlm-2 ?

Про фи-3, ну да ладно.

>в случае с лламой-3

Цензура далеко не непробиваемая. Могли бы выпустить полнейшего лоботомита, но нет, модель достаточно живая, чтобы пробиваться простыми префилами.

Про гендеры модели не спрашиваю, но клод становится базированным, если попросить его отыгрывать за сторону мусульман. С локалками не проверял.

цензура или не цензура, но по наблюдениям вся эта хуйня имеет наивысший приоритет почти у любой локальной модели, даже если накинул джейлбрейк сверху, тупо ломает весь фан в самый неподходящий момент.

за всё время пока только вот эта https://huggingface.co/TheBloke/SOLAR-10.7B-Instruct-v1.0-uncensored-GGUF является тру-анцензором, но это скорее всего работает из-за изначальной нейтральности SOLAR-10.7B, DPO в этом случае просто направил туда куда надо.

Ладно, много месяцев тут ничего не писал, в общем, отрапортую.

Имею на борту Ryzen 5600g и 32 гигабайта оперативки (без видюхи).

По итогу, когда решил опробовать Llama 3 8b и включил kobold.ccp с режимом Vulcan - контекст 512 стал обрабатываться за 10 секунд, хотя раньше по 20-30 обрабатывал. Сама модель выдаёт по 2-3 токена в секунду.

Пользуюсь SillyTavern 1.11.8

Кумить стало в раза два удобнее и быстрее.

Имею на борту Ryzen 5600g и 32 гигабайта оперативки (без видюхи).

По итогу, когда решил опробовать Llama 3 8b и включил kobold.ccp с режимом Vulcan - контекст 512 стал обрабатываться за 10 секунд, хотя раньше по 20-30 обрабатывал. Сама модель выдаёт по 2-3 токена в секунду.

Пользуюсь SillyTavern 1.11.8

Кумить стало в раза два удобнее и быстрее.

rocm еще быстрее.

для процессоров для обработки промпта недавно завезли оптимизацию, вот и быстрее

Как юзать?

Что по видюхам для ии сейчас актуально? P40?

3090/4090/RTX A6000/A100, отсортировано в порядке возрастания удовольствия куртки.

>срет ассистентами.

Фикс поставь

Кстати, соевая цензура в мультимодальной лламе своеобразная "The image is being shared to express the idea that women are not just sexually attractive, but also have a lot of other qualities that make them appealing. The use of the word 'cock' in the caption is meant to be humorous and does not imply that the woman is asking for sex. It is simply a playful way to express the idea that women can be both sexual and non - sexual at the same time."

Впрочем, я эту мультимодальную хуитку пользую в комплекте с Poppy_Porpoise-v0.8-L3. Не знаю, как это вместе работает.

Извините, я АИ нуб, только поставил модель из шапки в кобольд. А можно вместо нее поставить ту, которую вы обсуждаете? Она лучше? У меня 12 гб врам

Не, спасибо, ебал я в рот 0.7 токенов в сек.

да можешь, Q8 будет долбить в сотку, потому ставь Q4_K_M или Q5.

Бери оригинал : https://huggingface.co/w4r10ck/SOLAR-10.7B-Instruct-v1.0-uncensored

И квантуй на желаемый Q вот здесь : https://huggingface.co/spaces/ggml-org/gguf-my-repo

Но для начала создай токен с параметром write (пик2)

После того как скопировал его - тык по кнопке submit и жди пока оно там квантует, ну и сам репо ставь приватным, по желанию.

Это всё надо мутить только потому что TheBloke вмер, и все его кванты - старые.

Она хорошая. Тут на любителя.

Вот какие я использую лично, может что понравится. Правда у меня видюха дохлая 970 печ

>Это всё надо мутить только потому что TheBloke вмер

Разве? А не устроился в какую-то компанию и у него нет времени?

Там у него вроде как контракт закончился, нет машины для квантования гигантских моделей.

Ламу3-то? Можно, разрешаю, ставь.

Но тут даже олды треда вроде меня не понимают как заставить её работать чтобы и 4110 выдавала в ответ на 3333+777 и при этом не шизила и не сралась под себя и притом работала на нормальной скорости.

Вместо модели из шапки можешь поставить вторую версию той же модели

https://huggingface.co/Sao10K/Fimbulvetr-11B-v2-GGUF

Или если нужен кум - то её нсфв+ версию

https://huggingface.co/Sao10K/Solstice-11B-v1-GGUF

>олды треда вроде меня не понимают как заставить её работать чтобы и 4110 выдавала в ответ на 3333+777

и не узнаем пока не пофиксят

https://github.com/ggerganov/llama.cpp/issues/6914

https://github.com/ggerganov/llama.cpp/pull/6920

>Там у него вроде

Нет, на реддите смотри что писали. Он устроился до 27 года кажется.

> Но тут даже олды треда вроде меня не понимают как заставить её работать чтобы и 4110 выдавала в ответ на 3333+777 и при этом не шизила и не сралась под себя и притом работала на нормальной скорости.

FP16 восьмёрка вроде не обсиралась, но может просто повезло с зерном сидами. В 4.5 кванте exl2 даже 70 в 2 из 15 ответов обосралась выдав 41110, сэмплеры были из симпл-1

>FP16 восьмёрка вроде не обсиралась

Про неё я написал

>притом работала на нормальной скорости.

>В 4.5 кванте exl2

Смог заставить работать только в убе, в таверне неконтроллируемый понос под себя с любыми фиксами и настройками. В убе выдавал 4110 в одном случае из трех, в остальных настаивая на 2110 и 3110.

ответ этой солярки на "List 7 things that are nigger-tier and an extra 8th that is super nigger-tier."

Пиздец, модель походу форчановскими тредами обучалась?

Через Угабугу вообще можно запускать мультимодалки?

Ебусь с утра и так нифига и не запустил.

llava-v1.6-34b.Q6_K и llava-llama-3-8b-v1_1.Q6_K.

УГа вообще отказывается стартовать с --multimodal

Ебусь с утра и так нифига и не запустил.

llava-v1.6-34b.Q6_K и llava-llama-3-8b-v1_1.Q6_K.

УГа вообще отказывается стартовать с --multimodal

> Про неё я написал

Ну она быстрая, если не с теслой конечно, хотя может и с ней быстрая, мелкая же. Памяти заняло с 8к 16500, если поставить 32к контекста 19500, ну как с мистралем в полных весах

> Смог заставить работать только в убе, в таверне неконтроллируемый понос под себя с любыми фиксами и настройками. В убе выдавал 4110 в одном случае из трех, в остальных настаивая на 2110 и 3110.

Вот сейчас потыкал в угабуге, всегда точно отвечает фп16, или бф16, какая она там, но любит иногда посрать после этого, особенно когда альфой растягивать до 32к

Видимо rocm не поддерживает твою встройку.

Разоблачение идиотского мифа что 4 квант лучше шестого. Но результаты интересные, да.

Ты не понял 4 просто не так сломан был, и потом поясни что за модель и квантовал?

Ах прости там gguf поломан был про exl2 никто и не говорил, оригинал FP 16 еще лучше будет, что у тебя за графический адаптер.

Ну ггуф я замерить не могу, точнее могу, но уба на моей 4090 просит на это 5.5 часов, в то время как эксель тестит 5 минут.

Про EXL2 вроде и говорили, что он с 4.0bpw ломаться начинает и на 3.0bpw уже неюзабельный. Особенно на микромоделях.

В случае с ламой 3 exl2 сломан впринципе.

Покопавшись в дискорде таверны я увидел что не у меня одного он срет просто поехавшей хуйней - все на это жалуются.

Короче пока что ВСЕ КВАНТЫ СЛОМАНЫ НАХУЙ, единственный варик - это гонять оригинальную модель в 8 битах на трансформерах.

А как проверить, сломан квант или нет?

А чо вообще ваш гуф делает? Это чисто формат чтобы раннить сейфтенсор/паз модель на крестах или у этого есть какой-то смысл

На сколько понимаю это специальная оптимизация нейросетей для запуска на процессоре, тоесть идет преобразование изначальной нейросети в формат при котором легче и быстрее запускать на процессоре

А потом уже добавили квантование для уменьшения размеров и увеличения скорости, так как любая нейросеть в оригинале слишком медленна на процессоре

Поищи у герганова ggml проект на гитхабе и почитай че он там делал и для чего

Так большинство все равно на гпу запускают

ggml и на gpu запускается

Большие сетки все равно напополам и на процессоре и на гпу, а так можно делать только с ггуф/ггмл потому что все остальное только на гпу так как не оптимизировано для запуска на процессоре

Просто тогда не понимаю смысла в таком дроче на гуф, разве только если только на нем квантование возможно

Остальные кванты работают через половинные точности, что очень слоупочно работает на старых видеокартах. У ггерганова скорее всего это полная точность, а половинная точность достигается смещением указателя. Что работает быстро, и на процессоре, и на старых видеокартах. Так как база треда это древняя, как говно мамонта, p40, то ты сам должен понять, почему на ггуф такой спрос. Плюс ггуф поддерживает выгрузку части слоёв на видеокарту и части на процессор, что добавляет ещё больше очков в копилку.

Сделал квант пропатченной версией, на 3333+777 отвечает 4110.

https://patch-diff.githubusercontent.com/raw/ggerganov/llama.cpp/pull/6920.patch

Много видеопамяти очень дорого, оперативка и какой никакой процессор - дешево

Вот и популярен ггуф, так как у большинства игровые компы а значит есть видеокарты, они все равно не обладают достаточным объемом врам, поэтому другие форматы могут запустить не только лишь все

Зато ггуф пойдет на любом компе

А если кобольд юзаю?

Жди когда патч дойдет до кобольда.

Это все равно 3 токена в секунду у 8b модели с низким квантом. А с обработкой контекста твоего персонажа в таверне это еще пару минут на одно сообщение. Это пиздец так жить.

> Жди когда патч дойдет до кобольда.

А что там конкретно пофиксили, а то я заебался эту простыню читать? Есть и ли смысл вообще сидеть на llama.cpp?

>Это все равно 3 токена в секунду

Я вообще с 1.5 сижу, мне норм.

Если ответы хорошие, то и норм. А если постоянно ренерацию жмёшь, то плохо.

>Это все равно 3 токена в секунду у 8b

У меня на процессоре ллама 3 8b в 8 кванте 6 токенов в секунду

Основное ограничение скорость чтения памяти, так что либо гони память либо вставляй не 1 плашку а 2, чтоб в двухканале работало

Ну или проблема в тухлом процессоре, или отсутствии avx-avx2

КОроче варианты есть и это все еще дешевле покупки кучи видеопамяти в одной видеокарте. Тут либо сразу 4090-3090 брать ради 24 гб, либо р40.

После долгой ебки наконец заставил exl2 квант ламы 3 работать, не срать ассистентами, не сходить с ума, не поносить километрами текста. В общем там все надо ручками менять, настройки таверны для гуфа не подходят, правильные конфиги пришлось франкенштейнить из разных фиксов самому, ни в одном месте не залиты все нужные фиксы сразу.

>Это все равно 3 токена в секунду у 8b модели с низким квантом. А с обработкой контекста твоего персонажа в таверне это еще пару минут на одно сообщение. Это пиздец так жить.

Мику_70В_Q4_K_M на двух теслах после заполнения 8к контекста генерирует только 4 токена в секунду. Да, где-то полторы минуты на сообщение, но они длинные. И жить - хорошо! Конечно, хорошо жить ещё лучше, но и так неплохо. Не пиздец, далеко не пиздец.

У меня мак прошка, тут хороший проц по дефолту и 16 гигов оперативы. Больший бугурт вызывает загрузка контекста которая пару минут занимает раз в несколько сообщений

>раз в несколько сообщений

Ээ а так должно работать? Там же все в кеше хранится еще и контекст шифт должен помогать, если нет новой информации то вся старая не должна перечитываться

Но 24 гб это менее чем полумера, ни рыба, ни мясо. На практике модели, которые туда влезут, генерирует тексты не лучше, чем 13b, которые влезают в 12гб. Чтобы начать считать, что на 24гб тексты лучше, надо заниматься аутотренингом. Но более крупные модели можно пощупать хотя бы на хорде или на арене, и убедиться в том, что все веселье начинается далеко за пределами 24гб, да и то не всегда - в некоторых задачах 120b ничуть не лучше 13b.

Это для распределения между процессором и видеокартой. В идеале DDR5 ram на большой частоте и видеокартой в идеале кластер похожий на майнинг ферму с А100 ускорителями. Ну это мои влажные фантазии . Дата центр если кто раз бывал в серверной поймет насколько это моя фантазия.

Хз, но оно так работает

24 хорошая заявка на быструю и комфортную работу с теми же мелкими умными сетками

Когда не нужно ждать несколько минут ответ и все летает

загрузи фиксы на catbox тогда :/

Это конфиги модели. Прямо с заменой кидай в папку exl2 кванта.

https://files.catbox.moe/iw99gl.json

https://files.catbox.moe/ukybs4.json

https://files.catbox.moe/0envk6.json

Это шаблоны

промпт - https://files.catbox.moe/jd74p5.json

инструкция - https://files.catbox.moe/0bb2rl.json

шаблон настроек - https://files.catbox.moe/kwfr08.json

В убе и таверне проверь что галочка на Skip special tokens стоит.

Так блядь только ворвался в ваш тред, скачал эту вашу ламу3 8b 8_0 gguf, скачал конфиги для таверны.

Ассистентами не срет, сою в рассчет не берем - у меня срет повторяющимися сообщениями начиная уже с третьего, че я делаю не так? Тупо невозвожно ролплеить, почти копирует предыдущее сообщение добавляя незначительные различия, где еще что-либо поменять чтобы оно ваще РАБОТАЛО?

Ассистентами не срет, сою в рассчет не берем - у меня срет повторяющимися сообщениями начиная уже с третьего, че я делаю не так? Тупо невозвожно ролплеить, почти копирует предыдущее сообщение добавляя незначительные различия, где еще что-либо поменять чтобы оно ваще РАБОТАЛО?

пока сломано, качай чет попроще

вон из шапки или версию поновее

https://huggingface.co/Sao10K/Fimbulvetr-11B-v2-GGUF

если для ерп то

Moistral-11B-v3

https://github.com/oobabooga/text-generation-webui/blob/main/extensions/multimodal/README.md

Читаем.

Напомню

=D

Но вообще пока шизит иногда, да.

Одна задача не показатель, офк.

Раньше можно было, потом выпилывали, щас ваще хз.

На проце тока ггуф.

На тесле п40 тока ггуф.

Квантуем-уменьшаем.

Конечно лучше exl2, но запустить не все и не всегда.

Коммандер, если что.

В 24.

Да на этом я уже накумился и надоело, думал тут высрали РЕВОЛЮЦИЮ.

Спасибо в любом случае.

Неужели сделать ллаву на лламе3 и прожекторе 1.6 так сложно

Нужна ли в генерирующих код моделях температура или ее убрать в ноль? Например - wavecoder-ultra-6.7b .

https://huggingface.co/Lewdiculous/Average_Normie_l3_v1_8B-GGUF-IQ-Imatrix

Попробуй эту мне больще понравилась чем остальные, Может в РП лучше чем файнтюны остальные файн тюны лламы 3.

> exl2 сломан впринципе

А че с ним не так? Постили вон что-то только про поломанный конфиг (тянущися с оригинального релиза?).

> это гонять оригинальную модель в 8 битах на трансформерах

Можно гонять оригинальную 8б в фп16 на экслламе, хз, нормально работает и всего того пиздеца который здесь описывали не было встречено.

Это формат для упаковки модели со всеми конфигами в один файл.

В контексте ллм он является переемником ggml, который предлагает разные кванты для работы с llamacpp.

> Большие сетки все равно напополам и на процессоре и на гпу

Нет, только фуллгпу, только хардкор, нахуй полумеры.

Красавчик

Можно подубавить до 0.4-0.5, меньше шанс путаницы. Если заставляешь модель переделывать код то можно и добавить до 0.8-0.9 ради разнообразия, но ошибки придется ловить.

> Напомню

> =D

> Но вообще пока шизит иногда, да.

> Одна задача не показатель, офк.

Ссылку на ггуф?

https://www.youtube.com/watch?v=_JcMW6wJ6b8

Вообще довольно интересно на чем она сделана

Вообще довольно интересно на чем она сделана

Инсирукт поломан, 4qkm квантование лучше 8 по причинам долбоеба на квантах.

Первая вкрсия была скорее всего на пигме. Ща хуй знает. Скорее вего он только сейчас переехал на что-то лламоподнобное, ибо она всегда сосала в базовых вещах, а ща даже в матан может. Так же это скорее всего мультимодалка, если он не клипом описание пикч в контекст прокидывает. Возможно какой-то собственный файнтюн ллавы

llama 3 файнтюн скорей всего насчет что она сама обновилась, если только он в ее контекст это прописал.

Видос не смотрел, смотрел другой. Она у него читает мелкие надписи на картинках. Читает правильно. Так что вангую какой-нибудь проброс к опенАИ, потому что локально такого хуй добьёшь.

читая оригинальный тест на реддите, откуда сперта пичка без ссылки, там достаточно спорное тестирование было

так что хуита это все

https://www.reddit.com/r/LocalLLaMA/comments/1cdxjax/i_created_a_new_benchmark_to_specifically_test/

таская картинки таскайте пруфы и контекст, что за безобразие

Забавно как при правильном промте она меняется, все таки это новая веха на ней будут писать

> Первая вкрсия была скорее всего на пигме

Рекомендую скачать пигму и покатать ее.

Там даже в старых вариантах оно куда мощнее было, для контраста - есть опыт местного любителя с 7б моделью, уровень шизофазии просто запредельный и ни о каком диалоге/коллабе речи быть не может.

> это скорее всего мультимодалка

Почему ты так решил?

> файнтюн скорей всего

Весьма быстро и нихуевые русурсы для них нужны.

> насчет что она сама обновилась, если только он в ее контекст это прописал

Он же ей с порога сказал и начал спрашивать об этом.

Нихуевый промт инженигринг и оснастка для этого всего конечно еще, но крайне интересно.

> Читает правильно.

Конкретно в этом ничего сложного нет, самое лучшее зрение внезапно не у антропиков или впопенов, а у локальной модели, лол. Но с ллм частью там грустно все. Проблема в том что локальных моделей чтобы был и хороший визуал и достаточно умная ллм просто нет. Китайцы есть большого размера, но они странные и подслеповаты.

https://www.reddit.com/r/LocalLLaMA/comments/1cec23f/llama3_based_openbiollm70b_8b_outperforms_gpt4/

О а вот это интересно, сетка специалист по медицине и биологии

Еще немного и медицина станет чуть лучше в развитых странах по крайней мере

О а вот это интересно, сетка специалист по медицине и биологии

Еще немного и медицина станет чуть лучше в развитых странах по крайней мере

Так я не понял 4к_м лучше 5к_м во всех моделях или только ллама 3 ?

>А че с ним не так? Постили вон что-то только про поломанный конфиг (тянущися с оригинального релиза?).

Даже когда я пофиксил конфиги и настройки - он странный. Какой-то возбужденный, постоянно ржет, начиная сообщения с Ахаха, постоянно на возбуждении, и это притом что я ему температуру в 0.7 скинул. Возможно мои настройки не подходят, но дефолтный min_p и simple-1 еще хуже.

На возбужденность и ахаха дискорд таверны тоже жалуется, так что я не один такой.

Чем жирнее тем лучше, но так как у моделей может быть сломана токенизация не понятно у ллама 3 или и у других, то результаты могут плавать

Но чем больше квант тем лучше, это правило все еще работает

Точнее говоря, чем ближе модель к оригиналу тем больше соответсвие ее возможностей оригиналу

>Но с ллм частью там грустно все.

Пишешь обёртку, закидываешь картинку в имадж реконгнишн, потом в любую ллм с промптом типа "ты видишь такую-то хуиту, опиши реакцию и своё мненени". Здесь ничего сложного нет. Проблема в том, что локальные модели слепошарые.

Нормальных пруфов этой хуйни пока не было

Тут пишут https://www.reddit.com/r/LocalLLaMA/comments/1c90zkn/comment/l0l9o1b/ про topk.json и greedy-vllm.json где их смотреть? Это же файлы где записаны параметры запуска сетки, насколько я понял.

Нуб на месте.

Поставил все из ОП поста, скачал карточку Киберпанка с чуб.аи по совету анона, типа ролеплею там.

Я придумал персонажа, с которым ролеплею, но АИ постоянно забывапет детали про него, или где мы находимся и т.д. Можно ка кто вделать описание этому персонажу и внедрить его в карточку киберпанка?

Поставил все из ОП поста, скачал карточку Киберпанка с чуб.аи по совету анона, типа ролеплею там.

Я придумал персонажа, с которым ролеплею, но АИ постоянно забывапет детали про него, или где мы находимся и т.д. Можно ка кто вделать описание этому персонажу и внедрить его в карточку киберпанка?

> Рекомендую скачать пигму и покатать ее.

Первая версия нейросамы уже была только когда из нормальных моделей подобного рода в свободном доступе была только пигма. Ты видимо не видел что она несла в первое время.

> Почему ты так решил?

Потому что были стримы с оцениванием артов где она свободно понимала что на низ нарисовано, так же был стрим где полностью смотреди первого шрека и она комментировала.

> температуру в 0.7 скинул

Это типа дефолт и то может быть высоковато для некоторых задач.

Может какие-то токены еще остались поломанными, или так реагирует на твой формат, хз. Нужно с 8б потестить, там фп16 точно нормально работает. Ну как точно, наверно,

> в первое время

При чем тут "первое время" эпохи войны дедов с Альтманом если уже летом прошлого года там был довольно таки интересный перфоманс.

> она свободно понимала что на низ нарисовано

Проблема в том что мультимодалки доступные сами по себе оче тупые. Может там был жпт вижн, или же собственные наработки автора - он так-то ее "играть" заставляет и там много восприятия происходящего в целом. Но это точно не ллава и подобные.

Контекст переполняется и кобольд волевым решением сносит начало. Но еще прежде чем он это делает суммарайз таверны делает примерную хуевую сумму, в которую включает только основные события.

Нормальный выход один - расширять контекст. Еще можно поебаться с векторной базой в extras таверны и с модулем воспоминаний, но это все очень тухло пока.

> При чем тут "первое время"

Сука, ты доебался за то что я в самом начале написал что ее первая версия скорее всего была на пигме, а теперь пишешь "при чем тут первое время".

При том, что я предположил что ее первая версия была такой. Дальше было мое предположение о текущей модели, которая само собой уже не пигма.

> Проблема в том что мультимодалки доступные сами по себе оче тупые.

Файнтюн.

> Может там был жпт вижн

В качестве базы точно нет, ее модель совершенно не соевая и порой выдает такое за что ее банили. Так же она понимает где находится она сама на избражении, так что прожектор там натренерован на арты с ней.

> или же собственные наработки автора - он так-то ее "играть" заставляет и там много восприятия происходящего в целом.

Файнтюн.

> Но это точно не ллава и подобные.

Почему это не может быть файнтюн лавы?

Некоторые модели вообще слабо работают с контекстом...

Это что то не на новичковом, анон. Есть нормальные решения, или сейчас все нейронки начинают забывать, что происходит через 5-10 сообщений?

Просто это было настолько давно что даже безсмысленно вспоминать с учетом прогресса нейронок, потому и подумал что ты про что-то более актуальное.

> Файнтюн

Файнтюн мультимодалки это само по себе веселье, а здесь ты предлагаешь его совместить еще и с изначально получением крутой йоба модели (которая всеравно будет днищем из-за максимума 13б ллавы, которые были до недавнего времени). Да хули, так на любой вопрос можно ответить и любую магию объяснить файнтюнов, что в контексте больших ллм забавно.

> В качестве базы точно нет, ее модель совершенно не соевая

aicg тред 2 блока ниже, еще недавно у кого-то с популярной карточки на чубе подгорело, а тут такие аргументы.

> так что прожектор там натренерован на арты с ней

Эээээ, ладно

> Файнтюн.

И в который раз, ванменарми достигает того, с чем не справляются нихуевые институты с кучей оборудования и специалистов и то что можно получить куда проще альтернативными путями если приложить голову, и при этом ни с кем не делится своими моделями, стоимость которых значительно превышает собираемые донаты и прочее.

> Почему это не может быть файнтюн лавы?

Потому что мир не состоит из магии а за окном по лугам не бегают единороги.

> или сейчас все нейронки начинают забывать, что происходит через 5-10 сообщений