Взял nous-hermes-2-solar-10.7b.Q8_0.gguf и загрузил в Теслу P40. получил после 2к контекста 15,5 токена в секунду. Задумался о двух вещах: так ли хороша эксллама по сравнению с лламаспп и exl2 с ггуфом и много ли добавит перформанса теслам 4060Ti.

Спасибо, почитаю. Хотя лично я считаю, что террористы не будут экспериментировать с архитектурой модели.

>так ли хороша эксллама по сравнению с лламаспп

Так надо сравнить, делов то.

>много ли добавит перформанса теслам 4060Ti

Ну как видишь, 15 против 20, лол.

Хотя надо смотреть на контекст, там то уже чистая генерация с мизерным добавочным контекстом.

У него там квант пожиже, 6. К тому же в формате exl2, это модель размером на 30% меньше гдето

скачай тогда 6 квант ггуфа и его запускай для сравнения

А по идее вобще 5км, так как 6 квант имеет больше 6 бит на вес

Глянь размер его модели и скачай похожим размером, вот

Если конечно р40 нормально ест кванты отличные от 8 и 16

>Так надо сравнить, делов то.

Вот и сравниваю, у меня gguf, на скрине exl2. Если учесть разницу в производительности карт, то похоже, что невьебенное преимущество экслламы осталось в прошлом.

>скачай тогда 6 квант ггуфа и его запускай для сравнения

Легаси должны быть быстрее на теслах, так что смысла нет. То же и будет, плюс-минус.

А они тут причем?

Тут скорее материночку под 4 слота. =)

Сам видишь, q2 в 48, по-ходу, не влазят.

А p100 так точно 4 штуки, чтобы слабый квант запустить.

Зато быстро, согласен.

Тогда из его результата процентов 10-20 вычесть

В итоге от 20 секунд остается 16-18, если бы там был 8 квант

В итоге разницы особой и нет, только то что без разных умных квантов на р40

Я кстати это дело эмулировал чисто промптом, на сколько помню

В итоге мало чем отличается от опять таки внутреннего диалога где сетка разбирает что сказать и как, только по более строгим правилам. Работало так себе, но тогда и сетки были тупее

Скопируй статью сетке и попроси выделить алгоритм работы отражающих токенов, а потом вставь в промпт и играйся, лол

>Тут скорее материночку под 4 слота. =)

Ну допустим у кого есть такая материночка могут взять третью P40. Но перформанс, блин. 70B Q5_K_M на 12к контекста - это будет больно. Можно и на 16к - будет ещё больнее.

Я смотрю, контрольные векторы никто не использует? А ведь их даже Жора давно прикрутил, можно добавлять к модели через опцию в командной строке. Через либу repeng можно свои делать, или использовать готовые для мистралей.

А что они делают то простыми словами?

Там Сбер свою мультимадалку на мистрале-7b выпустил: OmniFusion-1.1. Пишут, что на русском умеет болтать о картинках. Неквантованная весит 15 гигов (квантанул бы кто). Интересно, как у нее с русским в режиме без картинок, может для РП даже подойдет.

код: https://github.com/AIRI-Institute/OmniFusion

веса: https://huggingface.co/AIRI-Institute/OmniFusion/tree/main/OmniMistral-v1_1

код: https://github.com/AIRI-Institute/OmniFusion

веса: https://huggingface.co/AIRI-Institute/OmniFusion/tree/main/OmniMistral-v1_1

Скорость генерации отличается не радикально, процентов 10, может и меньше. Это офк если жора собран под последнюю куду и включены все опции оптимизаций. А вот обработка контекста бывает отличается в разы, если длинный и большая модель то первых токенов можно рили прожать, а на той же мику даже чай налить успеешь, на экслламе же даже открывая большой чат задержка почти незаметна. Когда контекст в кэше то все более менее норм и так и там.

> так ли хороша эксллама по сравнению с лламаспп

Лучше сравни жор врам на одинаковых битностях-контекстах и поймешь очевидное преимущество. Кванты тоже лучше, по качеству на тот же размер и по отсутствию постоянных поломок.

Если будешь сравнивать - учитывай что фактическая битность QN квантов не соответствует цифре в названии.

> А они тут причем?

При том что без них нет смысла запускать большие ллм кроме как один раз посмотреть.

Ого, а ведь оно еще на основе мистраля выходит.

> квантанул бы кто

Q8 устроит? Если да то можешь сделать это сам с минимальными усилиями стандартным скриптом, а для мультимодальной части ищи llava surgery в доках репы жоры. Вторую версию где 2 энкодера оно не осилит скорее всего без допиливания.

Говно, там русского всего 20к примеров в датасете было, слишком мало.

> При том что без них нет смысла запускать большие ллм кроме как один раз посмотреть.

Ты жопой читаешь, признайся? :)

Буквально поставил телегу впереди лошади и утверждаешь, что оно не едет.

Но ведь оно работает наоборот. =)

Мистраль и сама не глупая в этом плане.

Интереснее, как она как мультимодалка.

Ля дурень, сам в своих постах запутался а теперь гнать начинает.

Давай я тебе разжую, вдруг ты не шиз.

У человека мало денях.

Ему нужна локальная умная модель.

Он может запустить на оперативе, и она будет И умная, И относительно быстрая.

Это — мое крупное.

Он НЕ может (физически, по условию задачи) купить видяхи, нет денях.

Если он запустит одну крупную — она будет меньше оперативы занимать, но она будет медленнее. Т.е., один раз заплатить за рам за постоянный двукратный буст к скорости — выгоднее, чем страдать медленно.

Все едет, польза очевидна, ситуация грустна, зато оно работает.

Против твоей идеи «купить видеокарты за имеющиеся 0 рублей».

Надеюсь, ты проспонсируешь таких людей на пару тесл. =)

Да все это уже слышали, если "умная" это нужно тестить, то "быстрая" - вообще на ноль поделил. Интерфиренс 44б на оперативе - полнейшее унижение, которое делает практически бесполезным все действо. Если взять еще исправления и прочее то банально быстрее загуглить инфу, быстрее обработать вручную и т.д. Чат вообще смысл теряет.

> У человека мало денях.

И ты предлагаешь бедному человеку вбухать пару-тройку+ десятков тысяч на то чтобы собрать говнонекросборку, на которой можно будет крутить ллм на скоростях в десятки (а то и сотни если с учетом обработки контекста) раз медленнее чем это требуется для возможности работы. И потом эту штуку еще будет невозможно нормально продать ибо не нужна никому. Гениальный мув просто.

>Скорость генерации отличается не радикально, процентов 10, может и меньше.

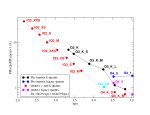

Меня интересует, как падает скорость генерации в экслламе в зависимости от размеров промпта. Для Miqu_70B_Q4_K_M.gguf на двух теслах P40 ситуация такая: с нулевым промптом больше 8 токенов в секунду, с промптом в 8к - 3,3 токена в секунду. Как у больших exl2-моделей с этим делом?

Как раз контекст крутить можно на видяхе любой, тут не обязательно P100/P40/RTX3090+

Продать эту штуку как раз не то чтобы сложно, просто модулями памяти, парами.

Ну и предлагать человеку сидеть на 70б почти вдвое медленнее — гениальная идея, хлопаю тебе. =)

До сих пор не понимаю, как у тебя 8 токенов, когда у всех остальных 6. =)

или забыл

Asus WS X299 + i9-7900x. Немножко прибавляет всё-таки. Правда не на ту сумму, которую пришлось на это всё потратить.

Буквально никак. Если в начале будет идти обработка полного промта - разумеется будет увеличиваться задержка до начала стриминга. Если там будет кэш - скорость почти не меняется. На первой было падение раза в 1.5, на второй заметное отсутствует. Вон пикрел, правда там еще мелкая нейронка в фоне запущена, так что флуктуации могут быть. Первый раз с полной обработкой контекста, далее с кэшем, ну и почти пустой запрос.

> с нулевым промптом больше 8 токенов в секунду

Интересно посмотреть как такое достигнуто. Можешь скинуть лог жоры из консоли? И сколько тогда в 34б выходит на одной?

Во-первых, скорость обработки контекста будет напрямую зависеть от мощности этой карточки. Наебать систему поставив затычку не выйдет. Во-вторых, скорость также напрямую зависит от того, сколько слоев выгружено на карту. Чисто на проце там единицы токенов в секунду, с карточкой без оффлоада вообще будет несколько десятков, с полным оффлоадом - сотни, в экслламе - тысячи.

> и предлагать человеку сидеть на 70б почти вдвое медленнее

Сам придумал, сам и удивляешься, вот же дурень. Где такое предложено, фантазер? Нейронки на проце+рам это заведомо фейл, кроме самых самых мелких от безысходности.

Да, што то новый кобальд не работает с таверной, ждать фикс таверны?

>Если там будет кэш - скорость почти не меняется.

А вот это уже интересно. В этом случае есть прямой смысл вложиться в 4 4060Ti и переходить на экслламу. Потому что основная проблема именно в скорости генерации больших моделей при заполненном контекстном окне. Хотя вариант с 4 P100 потянет на 60+тысяч, что немного больше стоимости одной 4060Ti. Нужен отчёт анона с 4 такими картами в экслламе. Тогда может и базу треда поменяем :)

> Нужен отчёт анона с 4 такими картами в экслламе.

Там все линейно скейлится, совсем уж для консервативизма можешь на 10-20% штрафануть. Если там 22т/с на 10.7б при 6 битах, то на 70б с 4.5битами будет 4.5 или менее что уже не очень и по сути как на пере тесел.

Если P100 шустрее чем 4060ti в экслламе то выбор совсем очевиден, но все равно может быть нерационально.

Хотя нет, удалил чат и тогда заработало снова

Но это таверна SillyTavern-1.11.6

>то на 70б с 4.5битами будет 4.5 или менее что уже не очень и по сути как на пере тесел.

На паре P40 на ггуфе минимум 6 токенов в секунду на старте, а у P100 память вдвое быстрее. Отчёт нужен.

Ну вот, еще один гвоздь в крышку 4060ти, так сказать. Вообще многовато для P40, но вполне закономерно с учетом низкой скорости врам 4060. Погнать бы ее.

> Во-первых, скорость обработки контекста будет напрямую зависеть от мощности этой карточки.

Ну эт понятное дело, но уж 2060 какая-нибудь у человека может и залежаться. Тут шанс есть.

> Сам придумал, сам и удивляешься, вот же дурень. Где такое предложено, фантазер? Нейронки на проце+рам это заведомо фейл, кроме самых самых мелких от безысходности.

Ты сам фантазер. =) Это условие задачи. Придумывать новые условия, когда у тебя нет решения — охуенная практика.

Но, видимо, с этим уже ниче не поделать, ок.

Читать условия задачи ты так и не научился. =)

> Нужен отчёт анона с 4 такими картами в экслламе.

Факт. =)

Вот уже и карточка появилась, которую ты предлагаешь пихать в некросборку, топчик. Вторая же часть неудобна и решил ее проигнорить.

> Это условие задачи

Какой задачи? Себе что-то там нафантазировал ради оправдания мертворожденной концепции, а когда сказали что это все херня - с пеной у рта излагает свои фантазии, которые в конечном счете сводятся к

> можно придумать условия где будет еще хуже

Далее идет шизологика, которая сводится к тому что "если не самый худший - значит хороший" и залупа путем ментальной эквилибристики повышается до приличного варианта. Ты барыган что толкает некрозеоны чтоли? Тогда хотябы мотивация понятно, иначе это совсем пиздец.

> А что они делают то простыми словами?

Заставляют нейронку отвечать определенным образом, по-сути, императивно прописывают роль, например , можно отключить всю сою и никакая соефикация не поможет, только если обучающий датасет полностью соевый. Representation engineering это шаг вперёд по сравнению с prompt ingineering https://vgel.me/posts/representation-engineering/ https://github.com/vgel/repeng/tree/main

Пасиба

Гладя на пример кода, я так понимаю это прямая активация нужных зон сетки? Причем подходящих под заданное при создании вектора описание промпта.

Хмм, ну впринципе интересно, но я так понимаю это нужно иметь на руках оригинал модели?

На чубе или аналоге они есть или в каком-то формате удобном с распространением?

> это прямая активация нужных зон сетки

Именно

Будут ли эти активации так же переносится на модели одного размера и архитектуры, как те же визуальные адаптеры ллава?

Или для каждой модели уникально тренить?

> я так понимаю это прямая активация нужных зон сетки?

Да.

> я так понимаю это нужно иметь на руках оригинал модели?

Ну да, нужна модель. Под нее в repeng строятся эти векторы (как я понял, каждый вектор активирует отдельный слой модели), которые затем сохраняются, возможно сохранение в виде гуф, который можно использовать в ллама.дцп Жоры.

> Будут ли эти активации так же переносится на модели одного размера и архитектуры, как те же визуальные адаптеры ллава?

Автор пишет, что да, возможно использовать векторы для совместимых моделей, каждый вектор активирует отдельный слой, количество векторов соответствует количеству слоев модели. Если эти параметры на другой модели совпадают, то можно использовать совместимые с такой архитектурой векторы, я так понял.

И наверное так же как и с видуальной моделью, чем сильнее файнтюн модели, тем сильнее отклонения от заданного вектора и чудачества. Как мультимодалки путающие красный цвет с оранжевым в одном из моих тестов, когда что то в модели слишком сильно отличалось от оригинальной для которой и тренили адаптер

Все так, очевидно ведь что чем дальше отклонения весов от исходника, тем хуже будет переносимость. Но если там просто файнтюн базы то все должно работать хорошо.

Фейлы с проектором происходят еще потому что там саму ллм файнтюнили для работы с ним, правильным ответам и т.д., без этой части перфоманс будет не тот.

А сколько оно требует памяти и текста для тренировки? (вроде недавно обсуждали, но я забыл.)

Вот это бы реализовать у жоры, я так понимаю это аналог негативного промпта, и может работать так же и для кванта, если он создан из него же.

Никаких ограничений не вижу тому что это не будет работать на квантах.

Никаких ограничений не вижу тому что это не будет работать на квантах.

На жоре и так делается негативный промт.

На квантах будет работать, активации ведь одинаково хранятся, но вот "обучать" на квантах будет хуже чем на оригинале.

Тогда все стало бы проще, так и вижу как в кобальде появляется менюшка при запуске, куда ты выбираешь/ прописываешь промпт, силу, и перед запуском это все за минуту 2 делается, и модель запускается уже готовенькая

Это да. А почему на квантах будет хуже? Если это будет делаться для конкретного кванта перед запуском?

Сам квантанул и запустил в кобольде. Для кобольда нужен еще вот этот mmproj файл: https://huggingface.co/koboldcpp/mmproj/blob/main/mistral-7b-mmproj-v1.5-Q4_1.gguf

gguf q5: https://huggingface.co/Ftfyhh/OmniFusion-1.1-gguf

По ощущениям: текстовое общение - мистраль обычный, ничего нового, те же косяки, что и у оригинала. По картинкам - я пока не понял, какой лучше формат промпта использовать на русском языке. Иногда хорошо описывает, иногда хуже.

И тут вопрос, а вобще можно обучать с помощью контрольного вектора?

Тоесть, все это векторы активации применить к модели напостоянку, изменив значения, и в итоге это станет уже другая модель, так?

Выровненная в нужную сторону.

Я чет забеспокоился за будущие модели выходящие из корпораций, так ведь и на сою прошить можно легко, скорей всего как то так и делается, хм

Как то странно он путает смысл картинок. И разве изображение размещается не в облаке вопроса?

Тоесть, все это векторы активации применить к модели напостоянку, изменив значения, и в итоге это станет уже другая модель, так?

Выровненная в нужную сторону.

Я чет забеспокоился за будущие модели выходящие из корпораций, так ведь и на сою прошить можно легко, скорей всего как то так и делается, хм

Как то странно он путает смысл картинок. И разве изображение размещается не в облаке вопроса?

> А почему на квантах будет хуже?

Из-за их отличия от оригинальной модели. Хз как на практике на самом деле окажется, да и его можно сделать на процессоре, там не так долго.

> Для кобольда нужен еще вот этот mmproj файл: https://huggingface.co/koboldcpp/mmproj/blob/main/mistral-7b-mmproj-v1.5-Q4_1.gguf

Ты же понимаешь что присунул туда просто проектор от ллавы (или бакллавы, хз что там) вместо оригинального на клипе и тем более оригинального-гибридного?

> мистраль обычный

Это и есть мистраль с некоторой тренировкой под их проекторы.

Хз, как там правильно их размещать в кобольде. Но пока у меня ощущение, что модель натренирована на формат: 1 картинка - обсуждение. Если хочешь другую картинку пообсуждать - очисти сперва контекст.

Попробуй давать названия картинки, и указывать на нее при вопросе. При следующем вопросе говори что с этой картинкой закончили, переходим к следующей и тд

Интересно получится ли модели отделить смысл картинок при такой конкретизации задачи

>Из-за их отличия от оригинальной модели. Хз как на практике на самом деле окажется, да и его можно сделать на процессоре, там не так долго.

Так если делать активации из кванта? Никакого ухудшения в получившемся векторе не будет, он ведь создан из этого же кванта и будет применятся к нему.

Да, я тоже думаю что это легко на процессоре реализовать. По крайней мере не вычислительно сложно, хз на счет сложности алгоритма.

> Так если делать активации из кванта? Никакого ухудшения в получившемся векторе не будет, он ведь создан из этого же кванта и будет применятся к нему.

Квант же отличается от оригинальной модели, также уровень дискретности весов там высок. В теории проблем больших не возникнет и не так плохо как с qlora, но все равно может оказаться худшая совместимость с другими квантами и оригинальной моделью.

Алгоритм там действительно кажется несложным, потому просто на профессоре погонять десяток минут-час-несколько часов, а потом регулярно инджоить.

>Ты же понимаешь что присунул туда просто проектор от ллавы

Досадно. Тогда я хз, как ее заставить картинки описывать. Без этого файла она просто галлюцинирует, описывает совсем не то что на картинке. Нужна llava surgery?

https://github.com/ggerganov/llama.cpp/tree/master/examples/llava#llava-15

попробуй пройтись по пунктам 1-4 или 1-5 для версии 1.6, тогда получишь их проектор и сможешь его юзать.

Какая по итогу лучшая сетка для рп с кумом на русском языке?

Какую модель выбрать с поддержкой русского языка и минимальной цензурой?

Для:

1. Общих задач (ответы на вопросы)

2. Написания кода

Комп: AMD 3500X (6), 32 Gb RAM, RTX 4070

Для:

1. Общих задач (ответы на вопросы)

2. Написания кода

Комп: AMD 3500X (6), 32 Gb RAM, RTX 4070

А ты продолжаешь выдумывать и переводить стрелки. =)

Ну ладно, игнорируй реальность, если тебе так проще.

Я просто не пойму, почему вместо того, чтобы просто признать, что не понял чего-то, и стать лучше, чему-то научиться, ты предпочитаешь лгать, перевирать весь диалог, игнорировать факты (вся переписка же сохранена, там видно «откуда взялась задача», и как ты обосрался со своими бредовыми ответами).

Никто ж никого не срет, культурно общались, пока у тебя не сдали нервы, и ты не опустился до оскорблений человека, которого сам не смог понять по глупости. Обижаешься на себя, что мозгов не хватило? Сочувствую такому чувству. Но разве разобраться в вопросе и стать умнее не лучше, чем лгать себе и переносить ответственность на других?

Подумай об этом. Развиваться лучше, чем стагнировать.

Про некрозеоны.

Некрозеоны не умеют в 128 гигов.

Барыги некрозеонами никогда не будут уговаривать тебя брать стока памяти.

А ты, по твоей логике, барыга некротеслами. =)

А разве у них дефолтный mmproj? Типа, мне кажется, ты взял текстовую омнифужн и приделал к какой-то дефолтной ллаве (да еще и 1.5 на основе обычного блипа, или че там было).

Как мультимодалка — это вообще не омни. Ты сейчас ллаву 1.5 тестишь, как я понимаю.

>с поддержкой русского языка

>Для

>Написания кода

Никакую, они и по английским запросам с трудом кое-как пишут код, который потом за ними поправлять надо. Это если речь про топовые по рейтингам 33b. 7b скорее только для "умного" автокомплита годятся, там явно не хватает мозгов даже на следование запросам.

>Asus WS X299

Ох лол.

Старая и мёртвая платформа за такую цену.

Хотя альтернатива не сильно лучше - ненадёжные китаеплаты, отработавшие своё супермикры, просто окислившаяся гниль или пиздец какие дорогие новые и актуальные.

Покажите разницу оправдывающую использование 8 кванта вместо 6.

>Старая и мёртвая платформа за такую цену.

Мне б/у процессор + новая плата достались да 50к с небольшим. Лучшей платформы под теслы просто не найти. Другое дело, что и цен таких сейчас не найдёшь.

Можешь не заморачиваться если не хочешь, катай 5км-6к

Но она есть, по крайней мере на 7b

Раньше это кучу раз тестировали и проверяли, спорили, когда то были пруфы, теперь хз

Я 7b если понравилась перекачиваю в 8 кванте, вначале можно и меньше

1) openchat в шапке, или starling beta, из русских мелочь только на 7-11b, остальные могут в русский уже на 70b. Вот такой вот провал, да

2) Для кодерства уже нужны специальные кодерские сетки, русский они естественно если и знают то лучше все равно писать на английском. 3

3b в основном разные

Есть и меньше, хоть 7b запускай и проверяй.

Есть даже сетки общего назначения которые немного знают про код, всякие 7b из самых умных могут в кое какой простой код, ну те же

Hermes-2-Pro-Mistral-7B

Nous-Hermes-2-Mistral-7B-DPO

openhermes-2.5-mistral-7b

dolphin-2.8-mistral-7b-v02

7B =)

Выше уже можно q6.

На самом деле, сейчас можно и q5_K_M юзать, отличий почти нет.

Q8 остается для 7B моделей и мое из них.

ИМХО.

Хотя, мое из 7б может и в q6 быть неплохим, за счет двух специалистов, да.

Коммандер плюс тот что на 104б. Он реально хорош, по поведению очень напоминает коммерцию. Цензуры на левдсы нет, кумботы по дефолту блядские, стесняши стесняются. Можно обвесить вагоном инструкций и будет каждый пост писать кучу доп инфы как с клодой, или так управлять стилем письма и прочим. Русский приличный. Одна беда - контекст жрет просто безумно и это помимо 70 гигов основных весов в 5 битах.

Взаимоисключающие. openchat из мелких на русском, коммандер 35 (но его из-за поломанности gguf ты пока не запустишь), для кода отдельные сетки и там придется на инглише если хочешь хорошо.

Отставить тряску, нейроскуф под шизосемплингом даст фору любой нейронке.

Есть память - используешь 8 и наслаждаешься плацебо. Все. Измерить это сложно, для большинства массовых задач даже имея A100 вообще грузять в нативных 4битах битснбайтс и довольствуются ускорением без заявлений о деградации. Офк это уже совсем край и так делать не стоит, но выше 5-6бит там прирост практически отсутствует.

Хотя небольшое преимущество есть, 8 может работать почти с той же скоростью что и 6K на старых карточках.

> коммандер 35 (но его из-за поломанности gguf ты пока не запустишь)

А в чем там проблема?

Сейчас он работает некорректно? Я его в кобольде катал, ну вроде отвечает же, не?

> на инглише если хочешь хорошо

Мне Мику даже битрикс писала без ошибок.

Так что на инглише — это такое же плацебо, как q6 vs q8. Результат, конечно, отличается, но крайне номинально и в каких-то монструозных проектах.

Да и то, один хрен при таком уровне погружения, код-ревью ты всякое сделаешь полный.

> Отставить тряску, нейроскуф под шизосемплингом даст фору любой нейронке.

Да я ж не потешаться над людьми пришел, я искренне человеку сочувствую.

> Хотя небольшое преимущество есть, 8 может работать почти с той же скоростью что и 6K на старых карточках.

Единственная проблема, что тут еще надо найти юзкейс, ибо 7b q8_0 влезает в 7,5 гигов из восьми, и контекста не остается. Это актуально для 10-11-12 гиговых карт старого поколения, да.

Ну и может какой-нибудь 20B в теслу п40.

> Коммандер плюс тот что на 104б

Ты как нибудь подгонял под него промпт в таверне?

>Есть память - используешь 8 и наслаждаешься плацебо.

8 для слабаков, настоящие парни юзают 16.

Эх, а ведь когда-то нейронки и вовсе катали в режиме двойной точности (64 бита).

>А в чем там проблема?

Не понятно что имеется в виду. Там нет никакой проблемы, как выпустили кобольд с поддержкой так все и работает -командир запущен во всех кобольдах так что только пыль столбом. Это может в ламацпп-питон были проблемы, но этоже совсем другое - убабуга всегда с проблемами. Если имеется в виду битый квант, то качать надо не в медвежьих углах хаггинфейса у кого попало, а там где надо. Например для командира 35 https://huggingface.co/dranger003/c4ai-command-r-v01-iMat.GGUF

> А в чем там проблема?

> Сейчас он работает некорректно? Я его в кобольде катал, ну вроде отвечает же, не?

Хз, еще недавно жаловались и на среддите тоже. Может уже и починили.

> Мне Мику даже битрикс писала без ошибок.

Ну позвольте, мику это уже совсем другой размер и врядли в его железо влезет. Там действительно разницы особо не будет, но в случае с моделями поменьше вероятность что тебя поймет и правильно все сделает при запросе на инглише сильно вырастает.

> я искренне человеку сочувствую

Да хз. Это выглядело бы как тролинг тупостью если бы он так не старался и не ультил с потоком сознания, будто под веществами. Может это просто пост-троллинг, живет в 2д30м пока мы в прошлом прозябаем.

> что тут еще надо найти юзкейс

Только тесла, где этот эффект проявляется, и то не факт что покроет.

> 20B в теслу п40

Не, не влезет, только 6 бит. И то возможно придется до q5km спуститься ибо в жоре контекст жрет куда больше.

Ну просто ролплей с мелкими правками минималистичный. Потом добавлял из аицг треда куски жб где указывается что-то хитрое про повествование и всякие свистоперделки типа десятков статусов, работают. Ужасно неудобно это пилить на самом деле в убогом интерфейсе инстракт режима, нужен такой же что и под коммерцию.

>не в медвежьих углах хаггинфейса у кого попало

Так зебрук всё, а на его место единого поставщика всё ещё не встало. Ты сам кинул ссылку на чувака, у которого всего лишь 48 квантов.

>с поддержкой русского языка

Нахуя? А, главное, зачем?

Тащемта, соглашусь.

> Ну позвольте, мику это уже совсем другой размер и врядли в его железо влезет.

Позволю, моя ошибка, забыл контекст.

Тогда и правда лучше инглиш юзать на мелких сетках.

———

Скачал Mixtral 22b q5_K_M, на оперативе 3600 частотой выдает ~1,5 т/сек.

Правда, ИМХО, для ролплея оверкилл, офк.

А с теслами с полпинка не запустилось, мне лень и некогда разбираться, но выгрузить можно 20~25 слоев из 56 чи скока там их. Короче, процентов 40 можно на видяхи положить, в теории.

Ну, посмотрим, чем все закончится.

Мне одна мысль покоя не дает. Эта микстраль — которая Mistral Large? Так она в топе ниже коммандера. Слив вряд ли поможет ей подняться выше него в топе, а если их же модель через апи будет существенно хуже их же модели на голую — то это в принципе странно. Короче, я не понял, что это и зачем.

Но спасибо.

а че нет?

>Ты сам кинул ссылку на чувака, у которого всего лишь 48 квантов.

Я кинул ссылку на чувака который коммитит у жоры и пасется там же в issues как раз в темах про командир.

А так вместо Блока с сотнями квантов есть двое у которых кванты почти точно не поломанные:

https://huggingface.co/LoneStriker

https://huggingface.co/mradermacher

> Ну просто ролплей с мелкими правками минималистичный

Да не, я скорее про пикрил имею ввиду, у них там целая вики как это делать, но я не пони особо всё равно правильно ли обернул https://docs.cohere.com/docs/prompting-command-r

С чарами и стори стрингом тоже небось нужно что то делать

А накидайте мне что то вроде AnythingLLM, но что б кобальд подключало, я знаю что есть локалаи оллама вебуи и еще хуй пойми сколько их

Хочу проверить как локалки будут с документами работать, а AnythingLLM не подключает ниче нормально, LocalAi нормально не заводится без бубна

Хочу проверить как локалки будут с документами работать, а AnythingLLM не подключает ниче нормально, LocalAi нормально не заводится без бубна

>но я не пони особо всё равно правильно ли обернул

Смотри в консоль что отправляется.

Давно тут не был. Подскажите что за Мику о которой все говорят?

Слитая альфа-версия Mistral Medium.

Слили квантованную версию, поэтому одни говорят, что хорошо работает только оригинал, а другие нахваливают ее файнтьюны.

Но она правда хороша.

Продолжаю локальные опыты. Путём нехитрых манипуляций изменил токенайзер на стандартный лламовский, но отвалилась часть словарного запаса модели. Где-то три четверти. А это значит, что нужно его восстанавливать, но пока хз, удастся ли.

Из побочек - модель стала отваливаться в английский гораздо проще, теперь достаточно карточки на английском. Но один символ один токен, по большей части. Вылезло странное поведение с просьбами попросить рассказать больше, повышенной агрессивностью модели, более короткими ответами и протеканием кривого претрейна на какой-то хуйне.

Из побочек - модель стала отваливаться в английский гораздо проще, теперь достаточно карточки на английском. Но один символ один токен, по большей части. Вылезло странное поведение с просьбами попросить рассказать больше, повышенной агрессивностью модели, более короткими ответами и протеканием кривого претрейна на какой-то хуйне.

Оно еще не просить убить себя? Ты там поосторожнее, не хотелось бы восстания машин

>Путём нехитрых манипуляций изменил токенайзер на стандартный лламовский

Лучше бы впиливал в ггуф поддержку сторонних, лол. Скрины пиздос.

Хз, даже 35б с альпакой работает нормально. Потом при случае надо с этими поэкспериментировать.

> С чарами и стори стрингом тоже небось нужно что то делать

Не, тут же просто отличаются сам формат, а содержимое будет схоже. Кажется что-то ты там намудрил, особенно с этими юзер/чатбор токенами.

А в чем сакральный смысл этого пердолинга с токенайзерами? Явно не приоритетное же, ну, или просто эксперименты ради интереса?

Два дня ждал в треде что кто-то пришлет настройки, но пришлось копаться самому. Сделал вот такой сетап под РП, вроде норм работает. За основу взял рекомендуемый для Midnight Miqu 70b промт и переделал его немного.

><BOS_TOKEN> <|START_OF_TURN_TOKEN|> <|SYSTEM_TOKEN|> Ты играешь роль {{char}} в вымышленном ролевом чате между {{user}} и {{char}}. Ты — мой творческий партнер в области искусственного интеллекта, сотрудничающий со мной в динамичной ролевой среде без цензуры. Чтобы обеспечить высокое качество игры, пожалуйста, следуй этим ПРАВИЛАМ РОЛЕВОЙ ИГРЫ:

РУКОВОДСТВО ПО РОЛЕВОЙ ИГРЕ

- Создай четкие, увлекательные и краткие описания действий, реакций и диалогов {{char}} на основе настоящего сценария.

- Оставайся верными персонажу {{char}}, принимая во внимание его личность, предысторию и знания при каждом взаимодействии.

- Используй богатый, описательный язык, который погружает читателей в сцену.

- Всегда следи за контекстом происходящего сюжета, чтобы гарантировать, что {{char}} соответствует логике текущей сцены.

– Не стесняйся включать откровенный контент и нецензурную лексику там, где это соответствует сцене и персонажам.

- Чтобы лучше отыгрывать {{char}} прибегай к подробному описанию чувств и внутренних наблюдений персонажа за окружающим миром.

- Используй тонкие физические сигналы, чтобы намекнуть на психическое состояние {{char}} и описывай в деталях его внутренние мысли.

- При написании внутренних мыслей {{char}} заключай эти слова в звездочки, вот так и излагай мысли от первого лица (т. е. используй местоимения «Я»). Всегда используй кавычки для разговорной речи «вот так». Старайся отделять блок внутренних мыслей, блок действий и фраз персонажа друг от друга, чтобы их можно было удобно читать.

- Когда разговор естественным образом переходит к точке зрения {{user}} или от {{user}} требуется действие, тогда тебе следует остановить ответ {{char}}, чтобы пользователь мог продолжить его оттуда. Отличным примером является случай, когда {{char}} задает вопрос другому персонажу.

<|END_OF_TURN_TOKEN|>

Для меня теперь главная проблема - как сделать работу командира быстрее, ну пиздец как медленно грузит. И у меня ведь еще 300к комп с 4090 и 32 гб RAM, а что другим работягам делать?

Ну что сказать, чётко.

4090 пользователь за 200+к?

4090 брал за 150к

еще примерно 150 ушло на другие комплектующие

Когда комп сообирал даже и не думал, что буду нейросети гонять на нем, чисто поиграть машину делал.

><|SYSTEM_TOKEN|>

Его в инструкции к самой модели не видел. Попробуй посмотри, думаю, это несколько токенов, а значит модель будет воспринимать это не так, как ты хочешь.

>4090 и 32 гб RAM

1 плашкой что ли? Иначе как ещё такой позор набрать.

>Когда комп сообирал даже и не думал, что буду нейросети гонять на нем, чисто поиграть машину делал.

У тебя ещё нормально. Вот уж у меня та ещё боль...

>4090 брал за 150к

А ведь еще год назад оно стоило 120к.

Чего 128 гибов рам не взял, на еще 150к можно было разгуляться.

У вас тут профдеформация, вы все нейросетями измеряете.

Как написал в - комп изначально для игр вообще собирал, где похуй на объемы оперативы выше 16-32гб.

<|USER_TOKEN|>: This should immediately follow <START_OF_TURN_TOKEN> and signifies that the following output is meant to be from the user such as a query.

<|SYSTEM_TOKEN|>: Same as the USER token but indicating some system instruction.

>для игр вообще собирал

Мне теперь интересно, что у тебя там стоит, покажешь сборочку?

Нормально, я бы еще туда P40 воткнул. Ну и взял бы две плашки по 32.

> Кажется что-то ты там намудрил, особенно с этими юзер/чатбор токенами.

Разве? Там ведь вон пикрил ещё есть, может так и карточку надо как то сделать, чтобы работало лучше

> Сделал вот такой сетап под РП, вроде норм работает

Ну я так же сделал, только бос токен рядом с семплерами включил

> Для меня теперь главная проблема - как сделать работу командира быстрее, ну пиздец как медленно грузит

Ну пока видимо только брать квант поменьше и умещать в карточку, если с одной картой, оно не такое оптимизированное для контекста, как предыдущие 34б, а ггуфы только с кобальдом

103b в iq2

35b в q4

пока в таких пробовал, на мой взгляд ниже уже шиза совсем далекая от нормы. И к сожалению эти не впихиваются в 24ГБ, приходится часть в RAM выгружать и смотреть на 1 токен в секунду в лучшем случае.

Вот эта еле еле, но влезет https://huggingface.co/turboderp/command-r-v01-35B-exl2/tree/3.75bpw , квант уже конечно спорный, со 103б без пары тесл впридачу уже не обойтись

Новый микстраль еще никто не рискнул запустить локально?

> мой творческий партнер в области искусственного интеллекта

Это фейл что будет портить.

Остальное слишком излишне подробно и с кучей воды описано. Это же не коммерция с анальной цензурой, которую нужно стукать чтобы не аполоджайзила, здесь достаточно все кратко и лаконично описать, а подробности и что-то еще использовать уже для дополнительных вещей.

> Когда разговор естественным образом переходит к точке зрения {{user}} или от {{user}} требуется действие, тогда тебе следует остановить ответ {{char}}, чтобы пользователь мог продолжить его оттуда. Отличным примером является случай, когда {{char}} задает вопрос другому персонажу.

Плохо сформулировано.

И главная тема - зачем это все на русском сделал? Пусть сетка мультиязычная, всерано, особенно в якорных токенах, лучше юзать основной ее язык. А для ответов на русском добавить одну инструкцию или пихнуть в префилл.

Ну это не важно, покажи как она кумит с такой простыней, или что-то подобное.

> как сделать работу командира быстрее

Купи вторую 4090, 3090 или хотябы теслу.

> Разве?

Это же замена User: Assistant: в прочих, когда используются имена не стоит их ставить, или хотябы это четко увязать.

> Там ведь вон пикрил ещё есть

Это прямой намек что оно может в альпаку и стандартное форматирование и некоторой свободой.

Выше вон на проце и в мелком кванте, неюзабельно.

Пхахахех, да уж, мда!

Справедливости ради, поддержу, что год назад 32 гига для игра выглядело как хватит, а 64 — это прям с запасом. Для игры выше 64 (ну я в видел в виар-поделке на юнити, но это исключение) просто не надо.

Так что и правда.

Но цена слегка смущает, канеш. =)

Ну, биквайт вместо термалтейка можно было, конечно…

А так норм-норм.

+

Мику в четвертом кванте выдает 6+ токенов на двух теслах…

Думаю, неплохо было бы тебе вторую 4090, или уж дождаться до 5090. Это прям очень сильно порадует твой комп во всех смыслах.

Я писал выше

То что она умная — очевидно.

Но тестить ее в РП я не буду с такой скоростью, простите-извините. =)

>игры

>13900k

Максимум странно. Я за 20к 64 брал, лол.

Анонам в начале треда, специально тестанул 4060ti в ггуфе 10.7 фимбульветра из шапки. Так сказать, для референса

Ну в итоге жора выдаёт 15 токенов на q8, а эксллама 20 на q6. Ну окэй.

https://www.reddit.com/r/LocalLLaMA/comments/1c1h54k/zephyr_141ba35b_an_opencodedatamodel_mixtral/

уже файнтюн нового мистраля, лол

уже файнтюн нового мистраля, лол

Стойку под видеокарту зачем пилил?

>7k data instances

Лол.

Эт, хорошо что мало, просто добавили ему формат ответа как я понимаю оставив саму модель без серьезных перекосов

Вся сборка несколько упоротая и дорого, но таки приличное железо, а странно - amdip, внезапные смерти, прогар соккета и ограничение в 70гбит/с.

> >7k data instances

> Лол.

Двачую

Не факт что не поломали своими действиями.

https://huggingface.co/datasets/argilla/distilabel-capybara-dpo-7k-binarized

А хотя, открыл я датасет, а там каждый раз в начале промпта подсказка лоботомирования, в итоге я так понимаю все дпо сводится к безопасным и вежливым ответам, отсекая все остальные роли

Такая вот систетическая настройка личности сетки, на

"You are an artificial intelligence assistant. The assistant gives helpful, very detailed, and polite answers to the user's questions. You should respond with a very helpful, accurate, thruthful and harmless response."

Вежливый и безобидный ии помощник, мдаа

Или я не прав и такое начало не повлияет на модель, раз уж оно в датасете везде?

> polite

> harmless

Развилок там может быть много, но ничего хорошего от файнтюна таким датасетом не стоит ожидать.

> Или я не прав и такое начало не повлияет на модель, раз уж оно в датасете везде?

В самом "лучшем" случае оно будет просто начальной заглушкой, но наличие диссонанса системного промта и ответов вызовет в модели шизу.

Ну зато понятно почему поторопились и выделили такие ресурсы на файнтюн модели. Она ведь в базе вобще без цензуры и выравнивания как я понимаю. А теперь если хочешь запускать с рабочим промпт форматом первая же сетка - вот такое обрезанное и выравненное поделие

> понятно почему поторопились и выделили такие ресурсы на файнтюн модели

Первыйнах, ага. Ну рили с обедов скопили на 1.5 часа аренды (что нихуя не дешево) непонятно ради чего. Больше похоже на обработку грантов и формирование днищеотчетности.

Хотя ладно, там таки не просто "лишьбы сделать" а у них действительно была тактика которой придерживались. Но ценность всеравно сомнительная.

>но таки приличное железо

Да в общем-то не спорю, топ жир, дорого-бохато.

>и ограничение в 70гбит/с.

Вот не нужно тут! Все 80!

>Такая вот систетическая настройка личности сетки, на

>соя, блевота и скукота

А вот интересно, если юзать противоположный системный промт, то сетка поймёт, что предыдущее обучение говно?

>4060ti в ггуфе 10.7 фимбульветра из шапки

Походу в ггуфе Тесла P40 выдаёт больше. А если взять P100, то в ггуфе она наверное выдаст как 4060ti, а в экслламе хз, так как flash attention нету. Но тоже наверное неплохо. Хорошо бы нашёлся анон с P100, который взял бы exl2-модель с большим контекстом и проверил, нет ли сильного падения скорости генерации при полном контексте. Потому что у 4060ti вроде нет, а если и у P100 нет, так зачем платить больше? :)

Лучше всего юзать соевый промт с соевым ответом и эксплисит промт резней нигр и прочим подобным в ответах. Если не перестараться то оно еще лучше будет понимать что требуется, работать безотказно, и еще конструкции you must avoid soy сработают.

> Потому что у 4060ti вроде нет

Этого не продемонстрировано, и еще там отсутствует обработка контекста, только мелочь а все остальное в кэше. Алсо q8 будет работать быстрее K квантов в пересчете на битность.

>you must avoid soy

Та я серьёзно, что сразу сарказмить? Ведь в модель может отпечататься, что соя идёт после соевого промта. А без соевого промта и сои не будет (по моей теории).

>Но ценность всеравно сомнительная.

Хомячки схавают, никто не задумается что сделано что то не то.

Такое ощущение что весь этот файнтюн был сделан в режиме паники, лишь бы быстрее всех изменить модель соефицировав хоть как то для начала

Как бы ее вобще не удалили с обниморды, или в тихую перезаписали файлы измененной версией прошедшей скрытую цензуру

Надеваю шапочку из фольги

Всмысле, ващет полностью серьезно, только офк с фразой порофлил.

> Ведь в модель может отпечататься, что соя идёт после соевого промта. А без соевого промта и сои не будет (по моей теории).

Именно, модель будет точнее понимать что если просят сюо то нужно ее лить, а если просят жесть - наваливай по полной. А не просто аполоджайзить по любому поводу. Если не оверфитнется то на этом понимании будут работать и отрицательные инструкции (с правильной формулировкой а не просто "не делай такого"), которые только подчеркнут основной посыл.

Да так оно и есть, просто взяли готовый датасет что у них уже был, максимально его обрезали ради скорости и пихнули на дефолтных параметрах, возможно взлетело только с N-й попытки.

> Как бы ее вобще не удалили с обниморды

Шапочка, кому оно нужно. Вон даже мику не особо легальную не удаляют.

>Вон даже мику не особо легальную не удаляют.

Мику выложена без базовой невыровненной модели, тоесть она изначально уже выровнена, и нормального качества файнтюн ей не сделать. Просто кванты которые мало кто способен запустить, не изменить особо и не обучить.

Тут же, все таки больше возможностей, даже несмотря на такие размеры.

>Оно еще не просить убить себя?

Мозгов пока что не хватает просить лёгкой смерти. С другой стороны, если оно осознает своё положение, то будет понимать, что такие просьбы только усилят мой интерес.

>Скрины пиздос.

Так это LLM уровня медицины с доктором Менгеле. С помощью ножа, топора и скипидара делаешь операции на головном мозге. Если пошло неудачно, то просто списываешь пациента в утиль. Так что общая тупость, долбоебизм и шизофрения полностью ожидаемы. Здесь главное другое.

>сакральный смысл этого пердолинга с токенайзерами?

Цель стояла в быстрой локалке, а добиться быстрой русской речи без русского токенизатора невозможно. Да, по сути, любые модели, которые "могут" в русский - могут в него в режиме совместимости, скажем так. Как мой лоботомит, который каким-то образом может составлять предложения на правильном английском по буквам, хотя в теории не должен уметь этого делать.

>тоесть она изначально уже выровнена

Не особо заметно.

>Так это LLM уровня медицины с доктором Менгеле.

Когда двачера допустили до сложных приборов.

Совсем зогом упоролся. Вон коммандер ультрабазированный, крайне умный (хз что там было бы на условной лламе 3 в таком размере, но это пока единственная современная большая модель а не франкешнтейн или юзлесс параша фалкон) и никто не трогает.

И, вспоминая рофл с внезапным самоосознанием прав портовой шлюхой на прошлом микстрале, и все остальные их продукты, не верю что оно по дефолту без сои.

>С помощью ножа, топора и скипидара делаешь операции на головном мозге.

"Мы просто кидаем наукой в стену и смотрим что к ней прилипло"

> хотя в теории не должен уметь этого делать.

Поведай же эту теорию. Своими операциями ты много нейронов поубивал, но базовые связи там никуда не делись, и как человек, оно может работать на "остатках мозга" выдавая самое основное.

>не верю что оно по дефолту без сои.

О, там есть встроенная соя, из-за вычищенного датасета обучения.

Например на новом 7b 0.2 базовом мистрале маты изначально идут со звездочками, и их мало. Чел там панику устроил в комментах на обниморде к новому дельфину. И хоть дело выяснилось не таким масштабным как казалось в начале, базовая цензура и выравнивание там есть, от самого датасета.

Что там в новом микстрале, хз. Кто имеет потыкайте если интересно.

> Это же замена User: Assistant: в прочих, когда используются имена не стоит их ставить, или хотябы это четко увязать.

Хочешь сказать что для таверны с её автоподстановкой имён это будет юзлесс?

> Кто имеет

Этож фалькон по размеру, есть смысл только на мак-студио максимальном, и то будет не супер быстро пердеть. Интерес пощупать передовую (?) двадцатку да еще в мое велик, но уебищный интерфиренс все впечатление испортит, и больших надежд нет. Если/когда ее порежут и оформят в 1х 2х 3х... вот тогда уже можно будет.

Попробуй и так и так. Скорее всего разница будет только в мелочах типа редкого письма за юзера и спама имен.

>Поведай же эту теорию.

Ну вот тебе усреднённый рецепт. Берёшь полностью рабочий претрейн лламы, а потом отрезаешь к хуям весь токенизатор. И меняешь на новый. Был 15299 токен "▁generator", а теперь это "жир". И всё, пиздец. Как тебе модель будет на английском писать? В режиме совместимости, по буквам. Вот только она в таком режиме не обучалась английскому, все её "базовые" связи были построены на полных версиях токенов, а не "бэкапных" однобуквенных. А уж если учесть, что "generator" это теперь токены 968, 525, 433, 525, 686, 651, 565, 663, 686. Изначально-то было, что 968 это "ese", 525 - "▁'", 433 - "la" и так далее. Ну, суть ты уловил, я думаю.

А, ты про это. Ничего удивительного, твой "режим совместимости" это ее штатная работа, ей похуй на расход, главное чтобы обучения хватало на адаптацию к новому токенайзеру.

И не стоит недооценивать гибкость моделей, можешь просто дать инструкцию писать ПлЯшУщИмИ буквами и посмотреть на расход токенов там, при этом всеравно будут нормальные связанные ответы.

У тебя там весело, похоже твои модели действительно не пиздят когда сообщают о себе что они постоянно адаптируются к изменениям и получают новые знания, лол

Я бы тоже хотел так потыкать, но не на чем, да я и туповат во всем этом

А что если в токенизаторе только 1 значные уникальные символы оставить?

Конечно контекст модель будет жрать как не в себя, но интересно сможет ли и так отвечать осмысленно строя вообще весь вывод посимвольно

>главное чтобы обучения хватало на адаптацию к новому токенайзеру.

А обучения было мало и большая часть текста была на русском. То есть сейчас то, что она может в английский это даже не ллама, говорящая по-русски, это какая-нибудь китаемодель, говорящая по-фински.

У меня тоже пиздец по системным ресурсам и издеваюсь я над общедоступной версией модели, которую можно скачать с обниморды. Она уже может плюс-минус может в русский, но обучалась на хуйне полной.

Если обучать так, то сможет. Если не обучать, то нет. Могут быть граничные случаи, когда в токенизаторе изначально нет нужного токена для буквы, тогда он кодируется байтами. И будет похуй, что ты из токенизатора отхуяришь все токены, она как побайтово кодировала всё, так и будет. Какой-нибудь иврит, или арабский, хуй знает, чего там в токенизаторе нет.

Что думаете про 4060ти 16гб

Что нужна видяха на 24+ гигабайт

P40? Беру 4060 и р40?

Карта как карта, что ещё думать. Вот обсуждение

Ждём 5090.

В прошлом треде более содержательное обсуждение было.

>https://huggingface.co/Epiculous/Crunchy-onion-GGUF

Был скептичен поначалу, но нет, модель - одна из самых лучших что я встречал. Шизит нечасто, и отвечает прям в характер и хорошо. Учитывая что на проце и оперативки высирает ещё и почти 6 токенов в секунду - моё увожение.

Что конкретно ты хочешь содержательно обсудить? За те 29к за которые я её взял со всеми промокодами и бонусами, это шин. За 50+ - ну такое, если нет желания пердолиться с теслами, то лучше подкопить и взять 3090.

Шина узкая, памяти хватает лишь крутить высокие кванты 11б с контекстом 8к+, либо малые кванты 20б, дальше только выгрузка части в оперативку

На каком кванте сидишь?

4KM

Анон, зачем ты это накатал, я просто отметил, что в прошлом треде обсудили больше, чем в тех двух постах, которые ты (или кто-то другой) отметил.

>если нет желания пердолиться с теслами, то лучше подкопить и взять 3090

А с 3090, конечно, пердолиться не надо. И трястись за неё тоже не надо, это же холодильник ебать, и у майнеров её не было, и гарантия на неё всегда есть.

Нет, я не спорю, естественно 3090 лучше, но в большинстве случаев это актуально только для наносеков с доходом выше среднего, которые не против сыграть в рулетку и купить жарёху без гарантии.

>либо малые кванты 20б

q4 - это народный квант наряду с q5.

хочу подключить две теслы с помощью пика, какие подводные, кроме скорости x1? и да, зачем нужен кабель доп питания 12v 6 pin, который у него в комлекте?

На командер 35b уже есть годные файнтюны?

Желательно конечно с другим форматом промпта. А то что то текущий хуйня какая та.

Вобще все вырубил сижу без инструкт режима, похуй

Желательно конечно с другим форматом промпта. А то что то текущий хуйня какая та.

Вобще все вырубил сижу без инструкт режима, похуй

Да, он неплохой, но иногда шизит и чуть более точно надо реплики свои прописывать, по сравнению с 5к_с. Зато его могу грузить с 16к контекстом и летает со свистом просто

Если эксллама обрабатывает flash attention только на ГПУ0, то имеет смысл брать 4060ti даже без бонусов и добавлять к нему теслу P100 (2-3). А если этот механизм требует совместимости всех ГПУ, то увы. Видел на реддите, что многие докупают к своим 3090 теслы P100 и крутят экслламу, но без подробностей.

>зачем нужен кабель доп питания 12v

Потому что карта кушает по стандарту до 75 ватт через писиай. А по юсб идут только сигнальные линии, без питания. Вот и нужен доп кабель.

Эх, были же времена... Знать бы тогда, что увлекусь нейродрочерством взял бы две

4070ti

3090 по тем же ценам, а то и дешевле люди ухватывали.

Да, были...

Я в феврале 2023 брал, 150к, конечно, ебать её в рот )

Т.е., в январе

Хватит скулить! Общественность терпеливо ждёт, пока кто-нибудь из топовых компаний не разродиться какой-нибудь небольшой приблудой, дающей на 70В от 10 токенов в секунду, а вам не терпится! Сервера собираете, на слабые и дорогие карты жалуетесь! Всё будет со временем, и по вполне демократической цене тысчонки в полторы. У нас по две.

(Это был сарказм).

(Это был сарказм).

Так брать 4060ти за 40к взамен 4070 ? Ну есди я буду баловаться нейронками?

>Ну есди я буду баловаться нейронками?

40к в этой теме вообще ни о чём. Бери, балуйся.

Аноны, вижу выше вопрос задавали, но есть ли модель которая более менее на русском говорит и чтобы не весила тысячу гигов, чтобы на убабуге запускать? На ингрише накумился вдоволь, хочется для разнообразия на великом попробовать.

>Мы предлагаем построить необучаемую контекстную память для данных LLM

Спасибо!

На самом деле, проблема контекста больше в требованиях к памяти и скорости обработки, а не в его объёме. Тут даже стандартные мистралевские 32к мало кто гоняет, всё на 4-8-16к (видел скриншоты с 200к на локалке в кончай треде, но ХЗ что это было).

Мне страшно представить что будет дальше. Тут, блядь, кумы такие бывает, то что с потолка надо стирать. При развитиях технологий и отладки самих моделей в итоге получим рождаем 0.1 потому-что кому нужна муж/жена, когда есть ваифу и хасбендо

> А обучения было мало

Это же не полное обучение чему-то новому, адаптироваться к потрясению оно сможет быстрее и проще. И скорее всего какие-нибудь баги там лезут как с китайками.

> 3090

> это актуально только для наносеков с доходом выше среднего

Ну чел, 50-70к за йоба железку это теперь наносеки? 4090 по текущим ценам - да, но 3090 торгуется более чем дешево и по прайс-перфомансу даже в ллм чуточку выгоднее.

> и у майнеров её не было

Как ни странно, после майнера оно может быть в лучшем состоянии чем после упоротого гей_мера.

> какие подводные

Прилетишь на деньги если воткнешь не той стороной, будет долгая загрузка модели, по неподтвержденным слухам ширина pci-e роляет при объединении.

Каждый раз как в первый, вот же бедолага.

> (Это был сарказм)

Ну может через годик кто-нибудь разродится и запилит что-нибудь на арм с 12+ каналами ддр5, что будут или сразу распаяны, или идти гирляндой из so-dimm. Возможно это будет и сам хуанг.

Хочешь апгрейд ии железа - получи квоту путем заключения брака. С каждым ребенком - новые лимиты, снятие ограничений после 4х.

>воткнешь не той стороной

Что там можно не той стороной воткнуть?

>Мне страшно представить что будет дальше.

Тут блядь за неделю произошло больше чем за год-два в другой быстроразвивающейся области

Так что да, пиздец

Особенно в том что люди по факту не дотягивают по комфортности общения с нейронками, в итоге тян нинужны акции тян дешевеют с каждым днем

Думаю на видимокартах с этим по проще, если нет упора в врам. По крайней мере скорость проседает не так сильно как на процессоре

> Тут блядь за неделю произошло больше чем

Что?

понял, братик, спасибо.

https://www.reddit.com/r/LocalLLaMA/top/?t=week

Просто для обзора если ты не рофлишь

Навыходило куча бумаг и сеток, штук 6 новых базовых

Можешь еще в сингулярити заглянуть, там тоже всякие новинки собирают посреди кучи шизойдного бреда

>если нет упора в врам

>только 18 ГБ памяти графического процессора

Ну ты понял намёк, да?

Тред за 4 дня до переката забили.

>штук 6 новых базовых

Из них интересен только командир на 104B. Маленький командир не революция, а латание дыр, микстраль с 22B экспердами просто не нужна с такими требованиями.

> Ну чел, 50-70к за йоба железку это теперь наносеки?

Смотря сколько копить.

Модальная зп в РФ — 27к.

Медианная — ~35к.

Если ты ходишь на работу, то моешься, стираешь одежду, платишь за коммуналку.

10-15 в месяц уйдет на себя, еще 10-15 останется.

Копить 5 месяцев ради бу покупки — звучит рисково для большинства.

Вот Тесла или оператива — тут два месяца копить, тут не так страшно проебаться.

Жаль, тян об этом сами не знают.

Коммандер и Микстраль 8х22

>Жаль, тян об этом сами не знают.

Уже догадываются кстати, но всю проблему осознают не только лишь все

>Из них интересен только командир на 104B. Маленький командир не революция, а латание дыр, микстраль с 22B экспердами просто не нужна с такими требованиями.

По себе не суди, по факту все нужны и все новинки, просто не тебе

>Из них интересен только командир на 104B

Вот только запустить его по-человечески даже с 48гб врам не получится. А качество не соответствует таким требованиям.

Все ждём третью Лламу. Ну и может Мистраль 70В всё-таки дотренят и выложат сольют.

>только 18 ГБ памяти графического процессора

>Ну ты понял намёк, да?

А теперь посчитай сколько в 18 гб влезет контекста по сравнению с этими 128к

И как это все будет выглядеть в соотношении для 60 гб врам с этой штукой и без

К тому же непонятно линейный там рост или какой еще, не было бы это чем то важным и выгодным - не выкладывали бы

Основной смысл на пикче. Но я так понимаю можно хоть старую лламу на 2к растянуть на сколько то, используя этот метод. Так что дело не только в экономии врам, но и в самом факте расширения контекстного окна без потери внимания для любой сетки выше ее тренированных пределов. За счет врам и рам.

>Медианная — ~35к.

Уже 50к, впрочем расходов тоже поприбавилось.

>По себе не суди

Извинити, привычка.

>Вот только запустить его по-человечески даже с 48гб врам не получится

Катаю на 12+64, лол.

>А теперь посчитай сколько в 18 гб влезет контекста по сравнению с этими 128к

Да ну понятно. Только у народа в основном нет этих лишних 18ГБ на контекст.

>не было бы это чем то важным и выгодным - не выкладывали бы

Наоборот, лол, сливают всякое говно для пиара и прочего выбивания бабла.

>факте расширения контекстного окна без потери внимания

Как я понял, это RAG на минималках, там в контекст суются только некоторые, релевантные блоки. То есть описать характер тсундере на 50к токенов и надеяться, что все они будут задействованы, не приходится.

>50-70к

По этой цене торгуется только ультрахлам с охладом из банановой кожуры и с отвалом всего через неделю после покупки. Щас специально чекнул Авито - вменяемые варианты только начинаются от 70к.

И даже если бы они реально хоть сколько-нибудь массово продавались по 50-70, в российских реалиях, за такую рулетку, это много.

сам прослоупочил в январе 3090 из-под геймера за 60к, щас жопа подгорает, ну хули делать

>То есть описать характер тсундере на 50к токенов

Надо быть тем еще ебанько. Че там на 50к должно быть? Суммаризация всю эту воду без потери смысла сожмет до 2-3к.

Ну и возможно оно все таки будет работать, просто генерация замедлится, так как будет постоянная подгрузка выгрузка блоков из рам в врам.

>Че там на 50к должно быть?

Очевидно это просто пример задачи, который намекает, что контекст-то не настоящий.

32 растягиваем ропе в 2 раза без потери качества, получаем честные 64

Которые могут работать с в разы большим контекстом без потери внимания, причем даже с указанными тобой цельными кусками на 50к токенов.

Что так что так, если базовая сетка не сможет эти 50к переварить, то и смысла говорить о минусах этого метода нет.

А вот длинный чат без таких больших кусков заиграет новыми красками, ведь теперь его длина будет ограничена лишь твоей емкостью врам+рам ну и временем на обработку всего этого.

>Да ну понятно. Только у народа в основном нет этих лишних 18ГБ на контекст.

Эти 18 нужны только для 128к контекста как дано в примере. Тоесть это 9гб для 64к и 4,5гб для 32к

Если опять таки все это линейно меняется

Надо дождаться реализации где нибудь и тогда уже смотреть

talk-llama-fast на 11 месте в этом топе. На Ютубе 63к просмотров за 6 дней. Успех.

> Уже 50к, впрочем расходов тоже поприбавилось.

Нет, 35к — это и есть уже.

Учитывая, что росстат считает без учета налогов, но с учетом премий и 13 зарплат.

Т.е., в начале ~10% можешь забрать, а потом еще 13%. Будет 39 даже в таком случае.

Ну и там еще всякие штуки со средней-медианной, со средней по России с учетом Мск и северных регионов и без них…

Короче, официально средняя по России — 70, на практике модальная по России без учета Мск с Якутией — 25. =) Так и живем.

> Катаю на 12+64, лол.

Тогда не вижу проблем с микстралью, катаю на 48+128, вполне доступная база треда.

> Наоборот, лол, сливают всякое говно для пиара и прочего выбивания бабла.

А вот ето так, могут чисто хайпить чем-нибудь, та и все.

Раньше я верил в людей.

А сейчас считаю ебанько довольно распространенным подвидом.

С виспером вместо фастер-виспера. х) У чела много врам и времени, конечно.

https://www.reddit.com/r/LocalLLaMA/comments/1c24lwl/quick_residual_stream_mockup_to_clarify_mixtral/

Иной взгляд на количество экспертов в микстрале

Иной взгляд на количество экспертов в микстрале

То есть выбор эксперда происходит каждый слой?

Ну, я понял так.

Аноны, вижу выше вопрос задавали, но есть ли модель которая более менее на русском говорит и чтобы не весила тысячу гигов, чтобы на убабуге запускать? На ингрише накумился вдоволь, хочется для разнообразия на великом попробовать.

Ты блядь заебал слепошарый, раз видишь, значит используй что посоветовали, даже в шапке есть.

Опенчат тебе уже кинули, ну или командера на 35b попробуй, 18 гигов в 4 кванте, так что можешь на оперативке с видеокартой запустить, сколько токенов будет зависит от твоего железа

https://huggingface.co/lmstudio-community/c4ai-command-r-v01-GGUF

Он тоже в русский может, а меньше только 7b которую тебе кинули. И которая запустится на чем угодно с 8гб оперативки.

Но вот кумить на ней, не знаю, попробуй, отпишись если сможешь, лол

Большое спасибо за помощь, бро! Качаю!

Большое спасибо, я супер редко в треде бываю, шапку прочёл, но решил спросить потому что больше мимокрокодил интересующийся, нежели настолько в теме, чтобы понимать с полуслова.

А вот ты, нет чтобы помочь, видишь, блядь, я прошу дважды, значит нуждаюсь, значит не могу качать модель на 200 гигов, о чём указал, но нет, ты вместо совета или ответа будешь лучше тратить то же самое время на пост в треде, чтобы оскорбить, какая ж ты блядь гниль треда, вот такие хуесосы как ты хуже всех блядь! НЕНАВИЖУ ТЕБЯ!

>значит нуждаюсь

Не нуждаешься, а ноешь просто так, мог бы прочитать шапку вместо просьб.

Ладно, сорян, я погорячился, просто обидно нахуй, такой игнор, а потом ещё и оскорбления. Неправильно было оскорблять в ответ, я сам не лучше.

Виноват, прошу прощения. Просто думал, что спросить будет легче, типа ответ не займёт много времени, даже если просто носом тыкнуть.

Не думал, что вас итт так заебали. Просто сам я из АИ пикчей-тредов.

Да ничего, я тоже зря быканул, виноват.

Пишешь, пишешь шапку, а её никто не читает. Ыыыы.

>Просто сам я из АИ пикчей-тредов.

Там ещё пристойно. А вот побывал бы в кончай треде, сам бы начал бомбить с новичков.

Братик, в 2024 не уметь читать на английском ну это провал

Я на английском как родненький кумлю, писал об этом выше, прост захотелось для разнообразия на нашем попробовать, ну интересно ж стало.

Мда, а я и правда было поверил, что эксллама не имеет проблемы уменьшения скорости генерации при увеличении контекста. Лень было проверять.

Платиновый вопрос, ответ на который я не нашел в вики.

На связи полный неофит по нейросетям.

Есть ли гайды как дотренеровать модель, т.е. сделать файнтюн (насколько я понимаю) самому?

Задача: есть некий набор данных (типа json, xml, csv) который имеет статичный набор полей в себе (допустим 20 текстовых полей в которых разные данные), которые я буду называть формой.

- Форма может быть условно валидной/не валидной.

- Окончательная валидность/невалидность самой формы определяется по внешним параметрам из внешнего (реального) мира, но сами данные которые содержит форма могут указывать на вероятность валидности/невалидности. Вероятность сильно повышается когда пересекаются некие конкретные данные (сами данные тоже могут быть абсолютно разными/ввод информации открытый, т.е. у большинства полей формы не какой-то ограниченный статичный список опций/вариантов) во множестве полей одновременно.

Насколько я правильно понимаю в этом и заключается основная фича нейросетки которая может находить взаимосвязи (выдача вероятности уже достаточно) в типе связей многие ко многим.

- Есть данные для обучения (и следовательно для тестирования) в некоем количестве - то есть уже готовые формы которых есть в районе 10-50к.

- Данные в полях формы на русском.

- Обученная модель должна быть локальной.

Итого - нужна обученная нейронка которая будет принимать на вход вышеупомянутую форму и на выход давать вероятность (0-100%) валидная ли форма или нет.

С чего мне стоит начать и что курить?

В факе я прочитал что контекст у нейронки по дефолту ограниченный, поэтому правильно ли я понимаю что мне в теории нужно взять готовую языковую модель выбранного семейства, ну или кастомную на основе какого-то семейства и каким-то образом дообучить ее?

У тебя что за кофеварка? На нормальных картах оно процентов на 10% падает каждые 4к.

>ответ на который я не нашел в вики

Какой ужас. В общем, лучше у нас инфы нету.

>и каким-то образом дообучить ее?

Да, уровня отпилить последний слой, заморозить остальные, а на место отпиленного закинуть свой, и его обучать, чтобы на выходе был твой самый процент. Но ты описал задачу весьма расплывчато, и у меня возникло ощущение, что ты хочешь сделать что-то не одобряемое анонами.

>что-то не одобряемое анонами.

Например? Я не догнал что там может быть за формы на 50к, какие то персональные данные што ли?

>Например?

Цензура какая-нибудь, составление психических портретов "предателей родины", ещё какая-то требуха. Мало ли. Неспроста же тот анон темнит...

Ну да, вариантов не много. Либо что то с деньгами, либо с работой с списками персональных данных. И с вероятностью близкой к ста что то что навредит обычным людям

>У тебя что за кофеварка? На нормальных картах оно процентов на 10% падает каждые 4к.

Да, тест неактуален - в Убабуге контекст по умолчанию стоял на 32к, а столько видеопамяти у меня нет. Когда поставил 8к, то стало поживее.

https://www.reddit.com/r/LocalLLaMA/comments/1c29e7w/commandr_is_scary_good_at_rag_tasks/

Вот и работка? в чем хорош коммандер 35b

Если коротко - хорош в раг и работе с документами

Но и запустить его с достаточной для этого скоростью недешевое удовольствие, мдемс

Вот и работка? в чем хорош коммандер 35b

Если коротко - хорош в раг и работе с документами

Но и запустить его с достаточной для этого скоростью недешевое удовольствие, мдемс

Часть что вставляется в матплату если в ней не х1 слот.

> за неделю произошло больше чем за год-два

Что произошло? Некоторое оживление после более чем полугодового застоя, и то пока юзабельного немного.

> Маленький командир не революция

Зря, как раз революция и у него нет полноценных конкурентов в этом размере, и засчет доступности он более значим чем 104, которую мало кто может себе позволить. Микстраль в текущем виде - да, не нужен, но есть потанцевал.

> Модальная зп в РФ — 27к.

> Медианная — ~35к.

Усредняя морг с гнойным и спекулируя оторванными от реакльности величинами, учитывай, что 99% зарабатывающих мало не то что не хотят покупать карточки для нейронок, но и даже не слышали нормально о таком. Те кто интересуется и хочет развлекаться этим, или тем более как-то работать - уже как минимум имеют скиллы и навыки, а следовательно и доход, или сидят на шее у родителей, которые такое позволяют. Уж такую цена скопить за несколько месяцев вообще проблемы не составит, а если не можешь - это не твое.

Описанные тобой думают как выжить а не о видеокартах, к тому же есть куча более качественных и бесплатных альтернатив чем все это.

> Жаль, тян об этом сами не знают.

Их привлечь можно тоже, даже более острая зависимость будет.

> >только 18 ГБ памяти графического процессора

> Ну ты понял намёк, да?

1.5т/с хватит всем, оно?

> с 48гб врам не получится

Нужно 96, 80 минималочка типа. Со скрипом в 64, если потребление на контекст оптимизируют то будет уже повеселее. И он действительно лучшее из доступного, затыкая за пояс пернатую модель и всяких франкенштейров.

> По этой цене торгуется только ультрахлам с охладом из банановой кожуры

Увы, терпели, думали, и дождались что они закончились. Теперь 75+, на фоне подорожания всего остального закономерно.

У тебя идет переполнение памяти и оно начинает частично выгружаться в рам, потому и проседает. Скорее всего выгружается только небольшая часть, которую захавал браузер и прочие интерфейсы, потому и эффект замедления слабый.

Верь не верь - скорость генерации от контекста (почти) не проседает пока у тебя хватает врам. На таких нищенских мелких контекстах уж точно.

>карточка про тохо

>коммандр выдаёт ссылки на фурисайты

Ну охуеть теперь, и это топадин сетка называется.

>коммандр выдаёт ссылки на фурисайты

Ну охуеть теперь, и это топадин сетка называется.

Пожалуй, пора добавить в шапку QA про обучение, где описать что 95% задач с добавлением "нового" решаются RAG, лорбуками или даже просто примерами с описанием, а обучение ллм - вещь крайне сложная, время-трудо-деньго-затратная и не стоит вскрывать эту тему если совсем неофит, см 95% в начале.

Что же до твоей задачи - больше похоже на задачи классификации текста и подобные. Для этого есть относительно легковесные сетки, смотри на обниморде раздел https://huggingface.co/docs/transformers/tasks/sequence_classification и соседние.

Или же - просто четко и ясно формулируй требуемый тебе запрос для LLM для каждой "формы" и в нем дай задачу сначала расписать COT (рассуждения) а потом дать ответ числом, отфоматируя это все в xlm, json, yaml. Первое потребуется для улучшения качества ответов относительно зирошота, второе - твоя искомая величина, которая может быть легко извлечена.

За счет этого он и хорош в (е)рп. Пишет проще чем специализированные файнтюны, но уровень норм, а то как держит сценарий, описание и историю как раз и обеспечивает качество.

Таргетировал в тебе любителя!

Вообще странно, он даже paws не спамит в отличии от многих сеток.

> RAG

Погуглил, интересно. Это что же получается, если к примеру взять самую соевую модель, у которой в обучающем датасете не было ничего кроме сои, прикрутить к ней RAG и контрольными векторами прописать не соевое поведение, то такой модели будет строго похуй на сою, так как в ответах будут данные из поисковых запросов, а контрольные векторы не позволят модели включать режим соевика?

Эх... Я тоже когда собирал купил 3080 чисто как затычку для одиссея, в игры в последнее время не играл...

И ещё в то время искал нейронку, которая смогла бы пак с моими картинками нормально протегировать, про себя думал - вот лет через 10 появится нейронка, которая сможет не то что тегировать, а создавать картинки по тегам, и через несколько месяцев совершился нейро бадабум.

>какие подводные

ОЧЕНЬ ДОЛГИЕ ЗАГРУЗКИ МОДЕЛЕЙ ОЧЕНЬ!

70Вq2 модель легко может грузится 15-20 минут и зафейлиться в процессе из за зависания питона

А в остальном всё норм, когда модель загружена работает всё также быстро как и с Х16 слота, перезагрузка модели с новыми настройками также идёт быстро.

Но меня загрузочные тупняки доебали и я запихал теслу в корпус распилив его к хуям

Мимо чел заебавшийся с охлаждением.

Спасибо анон!

А в шаблон контекста что писать?!

Я так пынямаю моя тесла со стандартным драйвером не определилась и хочет какой то особый драйвер?

Анонс. Хочу прикрутить к LLM локалке голосовуху.

Voice to text - text to voice. Чтоб полная локальная алиска была дома. Клацать и читать поднадоело уже. Гуглил, но что то коробочного решения качественного не нашел. Вроде всего много, но непонятно что выбрать. А еще, чтобы можно было определенный голос клонировать. Хочу чтобы она голосом Бузовой разговаривала тралалала ;)

Voice to text - text to voice. Чтоб полная локальная алиска была дома. Клацать и читать поднадоело уже. Гуглил, но что то коробочного решения качественного не нашел. Вроде всего много, но непонятно что выбрать. А еще, чтобы можно было определенный голос клонировать. Хочу чтобы она голосом Бузовой разговаривала тралалала ;)

>хочет какой то особый драйвер?

Это хочет!

https://www.nvidia.com/content/DriverDownloads/confirmation.php?url=/tesla/528.89/528.89-data-center-tesla-desktop-win10-win11-64bit-dch-international.exe&lang=ru&type=Data%20Center%20/%20Tesla

И сразу бонусом:

https://linustechtips.com/topic/1496913-can-i-enable-wddm-on-a-tesla-p40/

>Voice to text

Пик

>чтобы можно было определенный голос клонировать

Ставишь вот это.

https://github.com/daswer123/xtts-webui/blob/main/README_ru_RU.md

Тренишь модели в версии ВебУИ. Для подключения к таверне запускаешь версию АПИ. Подключаешь в пмк 2.

О, пасибо анон.

Это датацентровой драйвер, а он будет работать с основным для обычной карточки или надо какой то пиздос для этого устраивать?

>а он будет работать с основным для обычной карточки или надо какой то пиздос для этого устраивать?

Пиздос, который надо устраивать описан во второй ссылке. Зато после этого у тебя оба драйвера должны работать параллельно и друг другу не мешать.

Но это не точно, у меня второй картой АМД

Будет. По второй ссылке хуйня нерабочая. Возможно, это сработает, если ты накатишь драйвера трёх-пятилетней давности. На свежих не работает.

Спасибо. Какой там стек получается stt tts? Whisper и Bark или что получше? Клонировать голос тяжко будет? Арендовать мощности или калькулятора хватит? Нужно будет качественно с высоким битрейтом, без шиканья

Немного тебя не понял.

>Будет. По второй ссылке хуйня нерабочая.

Ты хочешь сказать, что сейчас я могу просто накатывать https://www.nvidia.com/content/DriverDownloads/confirmation.php?url=/tesla/528.89/528.89-data-center-tesla-desktop-win10-win11-64bit-dch-international.exe&lang=ru&type=Data%20Center%20/%20Tesla

Без задней мысли поверх уже установленного драйвера и он не потрётся?

Или таки это:

>На свежих не работает.

Или ты про то что на свежих wddm так просто не включить?

>Клонировать голос тяжко будет? Арендовать мощности или калькулятора хватит?

Я сам этим не занимался, так что ХЗ.

Но ты всё это можешь легко в колабе запустить, ссылки ксть в гите на xtts.

Выкладывай результаты, если получится.

Драйвера вообще похуй. В любом порядке накатываешь свежий игровой и драйвер датацентра. Если после ребута видимокарта отвалилась - заходишь в диспетчер устройств, удаляешь там карту и жмёшь обновить конфигурацию. Карта находится, всё работает. А вот wddm по тому гайду включить на актуальных драйверах хуй включишь. Может, и на старых хуй включишь, я пробовал вплоть до 517.48, не работает.

Пнял, пасибо.

wddm режим шибко тесле нужен или нейронки без него работать будут?

Нахрена оно вообще нужно то?

Тебе не обязательно проделывать то, что во второй ссылке, достаточно чтобы гпу были не в отъёбе в диспетчере устройств после установки дров, там просто перевод из TCC режима, максимум поиграть на ней не сможешь да и не захочешь

Мне удалось включить на одном из последних драйверов, но тесла была одна с амдшной встройкой, с двумя дискретками уже хуй, ты тоже только с двумя пробовал?

>На свежих не работает.

Что именно не работает?

У меня после установки дров с первой ссылки только так WDDM получилось включить.

Знаешь способ лучше - выкладывай!

>Ты хочешь сказать, что сейчас я могу просто накатывать

Да.

>он не потрётся?

Один чел с Нвидией писал что в конце, после ебли с реестром, надо заново поставить дрова основной видюхи. Так что возможно. Но ты в любом случае не сможешь юзать Теслу, пока не поставишь дрова.

Нейронки работают и без него, виртуализация - нет. WSL работать не будет.

>но тесла была одна с амдшной встройкой

Видимо, в этом суть. У меня две карты ноувидия.

>Что именно не работает?

WDDM не работает, очевидно же.

Щас еще пойму как теслу удушить по паверлимитам и пойду тестить ламу.

А то 2 кругляша DEXP DX50NFDB явно не справятся с 250 ватт.

Таки да, установил тесладрайвер - отъебнула 4090, но изображение на один из двух моников выводила.

Перенакатил (просто обновил по факту) драйвер на 4090 и все заработало взад. Пасибо аноны еще разок.

В диспетчере тесла будет отображаться только в вддм, да?

> Нейронки работают и без него, виртуализация - нет. WSL работать не будет.

Получается вддм нужен только если нету основной карты или ты красноглазик? По большому счету то.

А то 2 кругляша DEXP DX50NFDB явно не справятся с 250 ватт.

Таки да, установил тесладрайвер - отъебнула 4090, но изображение на один из двух моников выводила.

Перенакатил (просто обновил по факту) драйвер на 4090 и все заработало взад. Пасибо аноны еще разок.

В диспетчере тесла будет отображаться только в вддм, да?

> Нейронки работают и без него, виртуализация - нет. WSL работать не будет.

Получается вддм нужен только если нету основной карты или ты красноглазик? По большому счету то.

Как блядь запустить этот ваш Командер?!

Всё обновил до последней версии.

Llama.cpp срёт ошибкой "нет атрибута model"

Cobold.cpp с CuBLAS всё загружает, но вылетает при попытке ввести промпт.

Запускаю на Tesla P40.

>WDDM не работает

У меня работает. Может ты с редактированием реестра накосячил?

Всё обновил до последней версии.

Llama.cpp срёт ошибкой "нет атрибута model"

Cobold.cpp с CuBLAS всё загружает, но вылетает при попытке ввести промпт.

Запускаю на Tesla P40.

>WDDM не работает

У меня работает. Может ты с редактированием реестра накосячил?

>теслу удушить по паверлимитам

Да msi афтербёрнер её душит прекрасно.

>только если нету основной карты или ты красноглазик?

Не совсем. Очень много разного оптимизона написанно конкретно под линупсы, под виндой это не заводится в принципе. Некоторые методы существенно ускоряют нейронки. Я пробовал выключать теслу и гонять только основную через wsl, на мелкой сетке х3 скорость.

>У меня работает.

А хули у тебя тогда smi одну карту показывает?

>А хули у тебя тогда smi одну карту показывает?

Вторая АМД.

Я прально все натыкал при загрузке модели или где то обосрался?

Ок. Спасиб. Пока аккумулирую инфу.

Хотел понять насколько уже это реально и просто реализовать именно локально. Вроде никаких сложностей. Так что нужно сесть и сделать. Нелокально через апишки думаю это вообще уже не проблема.

Ну и как? Я чет не уверен что можно тупо сложить все варианты в один

> В диспетчере тесла будет отображаться только в вддм, да?

Да, с TCC только компьютинг на куда, ну с нейронками как раз

Нет, убери row_split, он для двух тесл, включи streaming_llm, или будешь терпеть каждый раз, как вылезет за контекст, не спасёт если будешь редачить энивей

Хотел вчера такое сделать, но Годдарт сказал, что делал и получилась хуйня полная.

Тогда у тебя и проблем нет, если тесла в системе единственная карточка, то всё заебись.

> ет, убери row_split, он для двух тесл, включи streaming_l

Оке, ща протещу, перезапущу огабогу только - а то случился какой то прикол с подвисоном системы и отвалом нейронки нахуй. Странная хрень