Подскажите, можно ли как-то проскочить джуновый уровень, и вкатиться сразу где-то на уровень миддло плюс?

Учу ml, работаю жабо-разрабом. Супер интересно перестать перекладывать джейсончики и хочется начать крутить нейроночки уже на работе, но так не хочется терять свои 300кк/сек

Хватит ли задрочить собесы? Сколько нужно нарезать проектов на каггле?

Учу ml, работаю жабо-разрабом. Супер интересно перестать перекладывать джейсончики и хочется начать крутить нейроночки уже на работе, но так не хочется терять свои 300кк/сек

Хватит ли задрочить собесы? Сколько нужно нарезать проектов на каггле?

>Почему такой фокус на нейронки?

Вот я хочу научить чему-нибудь полезному неигровых персонажей в компьютерной игре. Но мне нужен не просто случайный набор действий, а понятная, контролируемая система, которую можно развивать (имею в виду, как любую программу - есть код, ты его пишешь, читаешь и понимаешь его смысл). Пришёл к выводу, что нейронки не могут в этом помочь, т.к. они не объясняют свои решения. Что толку от перемножения матриц, если это всё абстрактные числа?

Т.е. пришёл к выводу, что мне подходит только

https://en.wikipedia.org/wiki/Rule-based_system

Но забивать тонны if-else вручную оказалось весьма сложной задачей, учитывая то, что я понятия не имею, что мне вообще нужно получить - не знаю, какое поведение мне следует закладывать. Было бы лучше, если бы алгоритмы сами находили подходящие правила из набора заданных условий, а я бы эти правила мог прочитать и понять (т.е. это не могут быть веса нейронов).

Очевидно, не я один к такому пришёл:

https://en.wikipedia.org/wiki/Rule-based_machine_learning

Но возникает вопрос, где об этом найти какую-нибудь информацию, ну, хотя бы из любопытства?

Сам я думаю попробовать генетические алгоритмы - если правило А даёт плохой результат, вносим в него модификации и получаем новое правило Б, повторяем до наиболее удачного правила (не обязательно идеального). Можно присвоить всем правилам веса - как веса у нейронов - и регулировать их по результатам деятельности персонажа. Но, боюсь, что правила быстро выйдут из-под контроля - потеряют человекочитаемость. Хотя важный плюс - начальный набор правил легче установить вручную, в отличие от рандомных весов в огромной нейросети.

ИМХО, мне кажется это куда более важным направлением, чем любые нейро- технологии. Нейронки подобны обычному органическому мозгу - это воплощение хаоса, в котором невозможно разобраться. Мы создали компьютеры, чтобы они точно решали задачи по строгим логическим правилам. Так зачем мы симулируем первобытный хаос в виде нейронок? Не проще тогда взять обычный мозг и воткнуть в него электроды, чтобы он решал задачи вместо точного и логичного компьютера, раз мы не стремимся к точности и логичности? Ну, или вырастить нейроны в пробирке, если кого-то вдруг беспокоит этичность использования готового мозга. На компьютерах нейроны симулировать - всё равно что в уме длинные числа перемножать - извращение и кощунство.

>начальный набор правил легче установить вручную

Приведу чуть более конкретный пример.

В контексте игры персонаж должен обладать каким-то конкретным поведением, это очевидно. Классический алгоритм мы забиваем вручную на любом императивном языке программирования, чтобы персонаж делал конкретные действия конкретным образом. Но такой код не будет изменяться сам - обычно именно это и нужно, но это не мой случай.

Нейросети в своей основе позволяют персонажу сформировать поведение путём считывания миллионов образцов поведения. Но где взять образцы поведения, если у нас нет готового персонажа? Да ещё и такие, чтобы не было лишней информации (шума). Т.е. выходит, что мы не можем задать начальное состояние нейросети так, как мы хотим, мы можем только закинуть случайных чисел и надеяться на то, что нейросеть сформирует поведение, близкое к желаемому. Мы можем прикрутить к этому генетические алгоритмы и спустя миллионы проб и ошибок получим нечто близкое к желаемому.

Но почему бы не совместить приятное с полезным? Написать базовые правила вручную, а дальше разрешить правилам меняться по ситуации, чтобы система могла сама создавать новые и удалять лишние правила, сортировать правила по значимости и эффективности и таким образом оптимизировать свою работу, опираясь на заложенные нами изначальные пожелания. В идеале, новые правила, созданные системой автоматически, тоже будут нам понятны, но даже в худшем случае мы можем хотя бы контролировать начальные правила.

С нейросетями это, насколько я знаю, невозможно, потому что числа на весах нейронов не несут в себе чёткого смысла, смысл есть только на входах и выходах, но не в скрытых слоях. Поэтому нейросети по сей день не показали ничего интересного, а вся работа с ними - перетряска чисел случайным образом. Меня интересуют альтернативы и что об этих альтернативах известно. А то сейчас слышно только о генераторах случайно упорядоченной информации на основе миллионов образцов - картинок, голоса, текста - но всё это не имеет отношения к моей задаче, ведь у меня нет и не может быть образцов (как не было примера для подражания у первобытных людей...).

Сап анончики, а может кто-то учебники по матану посоветовать ?

Я только вкатываюсь, базис программирования доучиваю, по бесплатному курсу CS50, хочу в нейронки пиздец, пол жизни дрочу на них.

Алсо хочу спросить, стоит ли работать в каком-нибудь вебе или другом направлении перед этой сферой ? Чисто для опыта работы.

>учебники по матану

Фихтенгольц, задачник - Демидович. Можно вместо Фихтенгольца начать с Зорича, там более современное и строгое изложение, но скорее всего тебе это не нужно.

Я учу математику по справочнику Выгодского, какие подводные?

https://data.vk.company/static/core/pub/bigdata/docs/2020_MADE_Syllabus.pdf

Вот тебе хороший список, на два года неспешного изучения хватит.

Подскажите, какая нейронка пикчи в пейзажи превращает?

Там это, нейронки порнуху рисуют.

Не подкинешь ссыль на источник?

>Там это, нейронки порнуху рисуют.

Та педофилы для этого ее и создавали

На санкаку нашёл. Что за дифьюжн не знаю.

Поясните, вот я вроде знаю какую-то начальную теорию - как нейросеть устроена, какая там используется математикану и про десижен три и рандом форест тоже, но сецчас это не суть, но где мне изучить как правильно делать структуру сети для конкретной задачи?

Вот я определился с входным слоем и выходным, а между ними че пихать? Понятно, что я могу загуглить решения, посмотиеть чужие подходы в аналогичнвх задачах, а самому как допереть до этого??

Вот я определился с входным слоем и выходным, а между ними че пихать? Понятно, что я могу загуглить решения, посмотиеть чужие подходы в аналогичнвх задачах, а самому как допереть до этого??

>загуглить решения, посмотиеть чужие подходы в аналогичных задачах

К сожалению только вот это, универсального подхода нет. Ну то есть понятно, что архитектура в первую очередь зависит от типов данных, для каринок ты будешь скорее всего делать свертку, а для табличных даннных хватит нескольких полносвязных слоев. Но это лишь примерная архитектура, которую ты потом будешь допиливать эмпирическим путем. Попробуй сам поиграться с какой-нибудь простой задачей, stack more layers вот это все, постепенно появится минимальная интуиция, в какую сторону двигаться.

https://playground.tensorflow.org/

Сап двощ.

Кто подскажет как ща с МЛопсом в РФ дела?

Вижу только СберКлауд нормально делает.

Кто подскажет как ща с МЛопсом в РФ дела?

Вижу только СберКлауд нормально делает.

Посоветуйте где посмотреть курсовые по нейронкам (компьютерное зрение/распознавание образов, если конкретно), гугл скудно выдаёт

Господа, а есть какие-нибудь готовые устаканившиеся механизмы менеджмента датасетов? Чтобы стягивало с хрнилища, слайсило, валидировало, версионифицировало. Каждый раз какой-то ворох костылей городить приходится.

Поясните на сколько это мощная штука. Правда, что я любую задачу без конкретного алгоритма могу на нейронку возложить, потренировать ее и получить хороший результат? Может ли нейронка понимать какой текст лучше подходит под тему?

>понимать какой текст лучше подходит под тему

Что это значит? У тебя есть набор текстов и тема, и тебе надо узнать, какие тексты из набора подходят к ней? Или тебе эти тексты надо генерировать для заданной темы?

Вот есть набор текстов. Есть предложение которое описывает кратко какое то подмножетсво. Например, есть тексты это все параграфы из школьных учебников, но под краткий пересказ главы литературного произведения (конкретного) подходит всего 1 параграф, под предложение "описание свойств планеты Земля" подходят почти все параграфы из учебника географии. И так далее

Примерно этим любой поисковик занимается.

Стоит ли пытаться в нейроночки, если я даже не понимаю дроби?

Не спеши с ответом, подумой.

Не спеши с ответом, подумой.

Смотря что тебе нужно. Нейронки не истина, а вариация статистики.

Тут кабанчик из Университета ИИ говорит что математика нинужна когда есть обширные библиотеки python

- я начинающий в ML

- ищу с кем можно было бы обсуждать/вместе разбираться в моделях, визуализации, фичах, нейронках и подобное

- сам я заканчиваю BCompSc, прохожу учебные курсы на каггле (осталось где-то 6), иногда возникают вопросы а обсудить не с кем, треды на форумах лень создавать

- моя цель это научиться решать задачи на каггле и получить гранд мастера через полтора, два года

- возможны дискасы в дискорде

телега: @bravednn

- ищу с кем можно было бы обсуждать/вместе разбираться в моделях, визуализации, фичах, нейронках и подобное

- сам я заканчиваю BCompSc, прохожу учебные курсы на каггле (осталось где-то 6), иногда возникают вопросы а обсудить не с кем, треды на форумах лень создавать

- моя цель это научиться решать задачи на каггле и получить гранд мастера через полтора, два года

- возможны дискасы в дискорде

телега: @bravednn

Ух бля, NAI ахуенен.

Если ты не понимаешь дроби, тебе в дурку надо или в интернат для умственно отсталых.

>Тут кабанчик из Университета ИИ говорит что математика нинужна когда есть обширные библиотеки python

Этот инфоцыган прав. В случае таких же макак, как и он сам.

Математика это такая вещь, которая нужна только тем, кто хочет создавать нечто новое. Новые технологии, например.

Чтобы хлебать смузи, клепать продукты на основе этих технологий и делать деньги, математика, очевидно, не нужна.

>кто хочет создавать нечто новое

Почему математики ничего нового не создают?

Ты просто тупой.

А что на пикче?

форель плавает в реке

В маниакальной стадии загорелся идеей создания своего цифрового ии аватара со всей хуйней. Но я гуманитарий и из программ только 3д пакеты лапал и в юнити терейны делал. Есть шансы создать что-то такое без матана и долгих лет обучения программированию? Может быть есть пакетные решения без написания движка или кода или как там это делается? не бейте лучше обьясните

Сап двач. Возможно ли учиться машобу в ВУЗе европейском?

Аноны, помогите! Имеется матрица признаков. Можно ли имея 16 признаков от лишних, если таковые имеются, можно избавляться и только 16 данных построить хоть какую-то модель, которая имеет предикт больше 0.5? На ум приходит только КНН с всевозможными удалениями подмножеств признаков

Больше 0.5 чего? Попугаев?

Можно ли построить модель? Если в твоих признаках содержится достаточно информации, то можно.

С чтения шапки.

Это знать надо! Это классика!

Сап, машобач.

Реквест скорее для /s/, но там вряд ли что-то посоветуют.

Есть годная опенсорс нейронка, которая определяет авторство большого (несколько десятков страниц) текста на русском?

Реквест скорее для /s/, но там вряд ли что-то посоветуют.

Есть годная опенсорс нейронка, которая определяет авторство большого (несколько десятков страниц) текста на русском?

а ты сам смог бы определить авторство текста?

если нет, то зачем искать для этого нейронку?

Подумой об этом прежде чем бежать к трясунам черных ящиков

Какая у тебя?

Длинная, слегка скошенная вправо, необрезанная. А у тебя?

Могу тебе левый хук туда зарядить, встанет по центру

Могу нахуярить хук в реакте. На работу возьмёте?

Ты тян или няшный кунчик? Тогда я не против дать побоксировать со своими причиндалами.

Ну что анончики, роадмап для вката в машоб нарисовался?

Какие есть аналоги у ящика с усами для нескольких выборок в одной категории?

ничего нет лучше гистограммы.

Рисуй гистограммы.

Зачем тебе?

вкатиться

Вакансий нет.

Пишу торгового бота с применением нейронных сетей на паре BTCUSDT, уже имею положительный результат торгов на истории, хочу обсудить с кем нибудь детали реализации для улучшения качества модели.

Кто имеет уже опыт в этом деле, напишите сюда:

1) Входные данные, у меня смещения японских свечей в процентах, что было у вас?

2) На каком количестве слоев лучше обучение?

3) Функция ошибок Fitness какую задали? Я взял за основу минимизацию количества ошибочных трейдов, вместо максимизации профита, это дало огромный прорыв в обучении.

Кто имеет уже опыт в этом деле, напишите сюда:

1) Входные данные, у меня смещения японских свечей в процентах, что было у вас?

2) На каком количестве слоев лучше обучение?

3) Функция ошибок Fitness какую задали? Я взял за основу минимизацию количества ошибочных трейдов, вместо максимизации профита, это дало огромный прорыв в обучении.

Ты сам погуглишь мнения почему это обычно не работает или тебе литературку подсказать?

Начни с "теория эффективного рынка" .

Чет ерунда вообще. Скачал книгу из шапки, посмотрел пример с продолжением текста. Какая же это хуйня. Выглядит как что то очень далекое от применения на практике

> Скачал книгу из шапки

Николенко что-ли? Ну так математик и считает строгость изложения превыше объяснений.

Рассказывай в какой области работаешь, а мы тебе расскажем как тут применять машоб.

Да, николенко. Я про результат, а не изложение. Ну просто нейросеть хуйню нагенерила у него там. Это не то, чего я ожидал

то есть, ты не работаешь с информацией и поэтому не сообщил об этом?

Ясно.

Да, тебе не нужны нейросети.

Да я не собирался вкатываться. Просто на досуге зашел, посмотрел примеры. Не впечатлило

Ну раз уж ты зашел, сообщаем, что ты кусок неайтишного говна и твое мнение здесь не интересно.

Доброжелательно

Пока каждый не начнет юзать сверх эффективные алгоритмы, это будет работать. Тебе просто надо быть чуть лучше других.

но ведь есть комиссии.

Им еще мы знаем, что есть и другие команды, которые много лет изучали настоящий рыночек, (просрали там все) легко применили свой опыт к отсталому крипторынку.

вот тебе книженция : Маркоз Лопес Де Прадо , Машинное обучение и алгоритмы для бизнеса.

Там ты подсмотришь несколько ситуационных приемчиков. Но не готовых идей.

Конечно, он не раскрывает добился ли он чего-то. Полностью темная книга. Можно сделать вывод только что он наебывал одновременно и инвесторов и американскую военщину долгие годы . И что эта затея - весьма сложная штука.

Нлпшники тут? Как сделать оффлайновый генератор случайных слов русского языка? По любому это как то пересекается с NLP который natural language processing, а не нейролингвистическое программирование, но что именно по шагам делать я не ебу.

import random

print(random.choice(foo))

foo - лист загруженный русских слов.

Всё.

Ну это понятно, а где норм список достать, и чтобы петухон его съел?

Ладно, вроде какой то список нашел. Правда мне стемы нужны, видимо придется через стеммер прогнать и дупликаты удалить, но это я нагуглю как-нибудь я надеюсь.

https://github.com/danakt/russian-words/blob/master/russian.txt

Во, надо было сразу гуглить частотный словарь русского языка, там леммы только.

http://dict.ruslang.ru/freq.php

Тут в .csv можно скачать, то, что надо.

Сап 2ч. Подскажыте де взять модель для распознавания кириллического шрифта для Keras и как отключить распознавание английского? недавно влез в это и вот упёрся. Свою обучать времени нет совсем.

Зачем тебе Keras, если все айти использует tesseract и в ус не дует?

Там, между прочим, тоже нейронки.

Документ под наклоном сфотографирован. С бликами и таблицами. Границы таблиц с низу невидно становится. Tesseract не справляется. Или недонастроил. Поэтому решил Лeras попробовать. Нашёл в Keras.Recognizer Alphabet, но когда туда список русских символов подставляю-распознаёт какуюто дичь. Но уже на русском.

Один документ?

А с чего ты решил, что модельки в Keras обучали на искривленном тексте? Какая предпосылка работать лучше?

Лучше в фотошопе трансформируй документ.

Я понимаю, что ты ожидаешь что тебе по скринам исправят код, но мы не твои коллеги. Мы здесь чисто попиздеть.

Предположил, потомучто блоки текста распознаёт правильно. Походу я просто туплю гдето. Совсем не ожидаю, что по скринам ктото чтото поймёт-там же результат только. В фотошопе не катит-надо к интерфейсу на питоне прикрутить всё это.

Чому вы еще не натренилибота для шахмат и не посоревновались?

Чел, шахматы перебором просчитываются, там интеллект не нужен.

Ебучие пидарасы, математики блядь хуевы, какого хуя ваш алгоритм во всех источниках записан по разному и не работает блядь?

Блядь, ублюдский сиборн...

> Ебучие пидарасы, математики блядь хуевы, какого хуя ваш алгоритм во всех источниках записан по разному и не работает блядь?

Долбоебина, а когда три разных быдлокодера пишут одну софтину, у них код одинаковый получается?

Причем тут код? Если уж с чем и сравнивать, то с документами по стандартам.

Ну так ты сравни документацию для десяти разных фреймфорков. Задачи решаются одни и те же, а методы и инструменты - разные.

Это не школьная задачка с одни красивым правильны ответом, это открытая проблема с бесконечным полем доступных решений.

>это открытая проблема с бесконечным полем доступных решений.

Математики обосрались снова

>Это не школьная задачка с одни красивым правильны ответом, это открытая проблема с бесконечным полем доступных решений.

Какие нахуй методы и инструменты разные? Какая нахуй открытая проблема? Это готовый алгоритм блядь.

Спасибо какому-то ученому-геологу, который в своей работе привел код для матлаба. У этих математиков хуевых ошибки в описании, причем у каждого свои.

Требуется помощь, аноны!

Имеется датасет поделенный на N частей. Загрузить их все одновременно не представляется возможным из-за его размеров. Вопрос: как правильно организовать обучение нейросети на этом наборе данных в keras. Если этими частями по несколько эпох сеть обучать - "перекоса" никакого не будет?

Имеется датасет поделенный на N частей. Загрузить их все одновременно не представляется возможным из-за его размеров. Вопрос: как правильно организовать обучение нейросети на этом наборе данных в keras. Если этими частями по несколько эпох сеть обучать - "перекоса" никакого не будет?

Можешь посмотреть, как пишут генераторы для кераса. Датасеты с картинками, аудио почти всегда динамически подгружают с жёсткого диска.

Типа того https://stanford.edu/~shervine/blog/keras-how-to-generate-data-on-the-fly

Получится ли с наскока новичку, и вообще возможно ли, реализовать U-NET instance segmentaion с бинарным учителем (есть в данных искомый объект или нет) ?

Если нет, то как подобную задачу выгодней всего решить на 2022?

Ни разу не реализовывал подобные приложения или алгоритмы, но интересовался. Извините если вопрос совсем тупой.

Если нет, то как подобную задачу выгодней всего решить на 2022?

Ни разу не реализовывал подобные приложения или алгоритмы, но интересовался. Извините если вопрос совсем тупой.

Сап аноны, вкатываюсь в машоб, решил перейти к CV и решить задачу с Kaggle - iMaterialist

https://www.kaggle.com/competitions/imaterialist-fashion-2020-fgvc7/overview

Вопрос следующий, я посмотрел датасет и там кроме классов одежды на фото есть еще и атрибуты для каждой фотографии (см пикчу). С классами понятно как обучать, но как обучать распознавать еще и атрибуты?

Думал, мб каждый атрибут выделить в еще одну отдельную запись в датасете (тем самым избавляясь от массива), но тогда будет слишком много записей в дс.

Или мб сделать отдельно классификатор категорий одежды, а затем обучать отдельную модель как multilabel для атрибутов.

Короче говоря, анон, подскажи, буду благодарен

https://www.kaggle.com/competitions/imaterialist-fashion-2020-fgvc7/overview

Вопрос следующий, я посмотрел датасет и там кроме классов одежды на фото есть еще и атрибуты для каждой фотографии (см пикчу). С классами понятно как обучать, но как обучать распознавать еще и атрибуты?

Думал, мб каждый атрибут выделить в еще одну отдельную запись в датасете (тем самым избавляясь от массива), но тогда будет слишком много записей в дс.

Или мб сделать отдельно классификатор категорий одежды, а затем обучать отдельную модель как multilabel для атрибутов.

Короче говоря, анон, подскажи, буду благодарен

Сначала посмотри, что такое cv в целом, затем, что такое CNN, затем почитай про сегментацию и саму архитектуру U-net (осознай штуку с энкодер-декодер частью и зачем пробрасывать маски с пред. слоев).

Если честно, ничего сложного там нет. За месяц точно управишься со всем этим, если ебланить не будешь. Тебе должно помочь то, что для U-net уже есть куча реализаций (даже на торч готовая либа есть, pytorch-segmentation, вроде, где ты можешь в U-net свой энкодер добавлять)

Датасет не смотрел, но да, выглядит как обычный мультилейбл (при реализации не забудь, что в мультилейбл может быть такое, что нет никакого лейбла у объекта)

Спасибо за ответ, попробую обучить

Как вкотиться? Хочу написать свою Кортану.

Kaggle очевидно же, много конкурсов на любую тему с открытыми современными решениями, практика важнее всего остального.

Практика это хорошо, только мне бы основы для начала изучить. Я не хочу скрипткидди быть, я хочу новое создавать.

Начинай с Вапника.

Это что или кто?

Это математический анон, создавший теорию всего этого дела, которое макаки называют машинным обучением.

>Список дедовских книг для серьёзных людей:

>Trevor Hastie et al. "The Elements of Statistical Learning"

>Vladimir N. Vapnik "The Nature of Statistical Learning Theory"

>Christopher M. Bishop "Pattern Recognition and Machine Learning"

>Взять можно тут: http://libgen.io/

Но, вообще-то, начни с книги Бишопа. У Вапника лютая теория, ты там не поймёшь нихера.

Все общие вопросы - Скиена, Наука о данных, 2017

Вопросы о pandas - книга от создателя pandas - Python for Data Analysis 3rd Edition .epub (Free)

DL - Deep Learning, Сейт Вейдман

"как вкатиться" ( в принципе мы догадываемся что ты там под этим понимаешь) - Data Science

для карьериста, Нолис, Робинсон, 2021

С точки зрения авторского права, насколько легально использование датасетов из открытых источников? Читал про копилот, который по сути является "прачечной для лицензий" и отказ от использования популярных композиций для тренировки музыкальных нейронок. Мне почему-то кажется, что скоро хуй можно будет данные насобирать.

Нинасколько. А ты собираешься с ними судиться?

У тебя уникальный исторический шанс. Никакой Berkeley University тебя не засудит.

Воруй-убивай. Жди ответного гудка.

>в принципе мы догадываемся что ты там под этим понимаешь

Да всмысле, что за предъявы? У меня реально цель создать полноценную цифровую личность. Бабло конечно нужно, но оно меня волнует меньше.

>У меня реально цель создать полноценную цифровую личность.

У тебя цель потрясти Черный Ящик, что бы от туда выпало что то отличное от говна и разумное.

Ты меня не знаешь

Тогда расскажи концепцию интеллекта в твоем понимании, что такое знания, как они хранятся.

>тебе в дурку надо или в интернет для умственно отсталых.

Для чего? Я не на экзамене.

Посоны, там AlphaTensor научился матрицы перемножать чуть чуть быстрее, теперь заживем!

https://www.youtube.com/watch?v=CoFvu-n-fFs

https://www.youtube.com/watch?v=CoFvu-n-fFs

А зачем здесь тогда всех своей школьной хуйней заебуешь?

>школьной хуйней

such as?

Достижение на самом деле значительное. Во-первых, любая нейроночка только и делает, что перемножает матрицы, и при обучении, и при работе. Даже самая мелкая оптимизация такой базовой операции - это заебись. А во-вторых, сам факт того, что нейронка нашла фундаментальное знание - это охуеть какое достижение. Тряска черного ящика внезапно привела к осмысленному результату в виде конкретного алгоритма.

>Тряска черного ящика внезапно привела к осмысленному результату в виде конкретного алгоритма.

Ты сейчас биологическую эволюцию описал. Но как не крути, к интеллекту это не имеет ни какого отношения. Как и эволюция является пиздежом вговнемоченых.

Да не дёргайся ты, чмоня. Продолжай генерить цп и не залупайся на других.

>и не залупайся на других

А то что, говном начнешь плеваться? Лол

Погуглил, нашел 2 книги. Первая 2004 года, вторая только платно за 10 долларов на амазоне.

Еще есть Behavioral Mathematics for Game AI.

> Но забивать тонны if-else вручную оказалось весьма сложной задачей

Так используй Prolog, он как раз для таких задач и имеет из коробки всё необходимое.

DCG, CHR, логический вывод, и много других фич.

Правильно ли я понимаю, что ML/DL/etc. это по сути статистика на стероидах?

В бизнесе и науках (биология, социология, лингвистика, финансы, ...) используют эту мутировавшую статистику, чтобы решать свои конкретные научные или бизнес-задачи.

То есть вкат в абстрактный ML это всего лишь освоение метода. Для успеха надо вкатываться в конкретную научную область, использующую ML, изучая еще много всего.

А раз так, то какие есть области знания, связанные с ML? Биоинформатика, NLP, CV, алготрейдинг, что еще?

Куда перспективнее всего идти?

В бизнесе и науках (биология, социология, лингвистика, финансы, ...) используют эту мутировавшую статистику, чтобы решать свои конкретные научные или бизнес-задачи.

То есть вкат в абстрактный ML это всего лишь освоение метода. Для успеха надо вкатываться в конкретную научную область, использующую ML, изучая еще много всего.

А раз так, то какие есть области знания, связанные с ML? Биоинформатика, NLP, CV, алготрейдинг, что еще?

Куда перспективнее всего идти?

А в рамках NLP есть какие-то деления на языки? То, что делают для английского, актуально для русского, хинди, китайского, арабского?

> Правильно ли я понимаю, что ML/DL/etc. это по сути статистика на стероидах?

В сущности - да. Точнее то, что раньше называлось Статистическое Обучение.

Однако, количество переросло в качество:

появилась возможность оперировать информацией не понимая что она означает.

>Куда перспективнее всего идти?

А вот в свете вышесказанного, ответить хорошо на вопрос о том, чего еще не произошло, статистика не может.

Разумеется, есть разделение в силу подачи на вход меньшего объем исходного материала для обучения. На русском все в целом будет хуже.

Вроде яндексоиды (инициативные исследователи, не обязательно из яндекса) пытались какие-то доучивания соорудить. Но хрен их знает что получилось.

А ты начни с мультиязычных HuggingFace Transformers.

Платиновый вопрос. Где найти консольную утилиту, которой можно тренировать и запускать трансформеры?

Зелебоба вполне рабочая в итоге.

Если я не анальник могу закатиться в нейроночки? Есть готовое решение мне нужно распознавать голос в текст?

конечно. на любой кошелек есть

https://cloud.yandex.ru/docs/speechkit/stt/?from=int-console-empty-state

Ну, анальник, который знает что такое api, все равно потребуется. Но эти анальники подешевле.

Для кабанчиков есть всякие штуки типа Roistat.com

Конечно, тоже дорогие и бестолковые.

А как самому с нуля спич ту текст написать?

Ну давай датасет - накатаем. И продадим

че ты от нас ждешь?

Есть и бесплатные варианты. Гугли

Если твой цель сделать годный игровой ИИ, то можешь взять современный игровой движок (или движок от Fear) и посмотреть, как там это делают (там из коробки часто есть сигналы, триггеры и на гитхабе базовые правила).

Если твоя цель, любопытство и ТД, то исследуй, расскажешь нас дальше про свои измышления.

Если интересно про самый современный ИИ в играх, то почитай что-то про Reinforcement learning от David Silver.

В целом под игровым ИИ понимают две разные вещи: человекоподобность и эффективность.

Сейчас обычно разделяют на low-resource languages и английский. Трансформерам сейчас не очень важны особенности токенов на входе имхо.

Забыл добавить, тебе никто не мешает поставить в модель Reinforcement learning не нейронку, а дерево решений из Sklearn, только ограничить его глубину. Но генетические алгоритмы тоже ок. Да и в нашумевшем AlphaGo основным алгоритмом идёт MonteCarlo Tree search, который нейронка просто учится аппроксимировать (что сейчас SOTA - не знаю), иначе долго считать.

У игровых ИИ другие цели, аноны.

> Смысл ИИ не обыграть игрока, а красиво ему проиграть

Для игровых ИИ не нужны сложные технологии, типа нейронок. Достаточно просто перебрать все варианты действий, и выбрать тот сценарий, который приведёт к победе. Для большинства игр так и делают, только с поправкой на то, что ИИ обязан ошибаться.

> Смысл ИИ не обыграть игрока, а красиво ему проиграть

Для игровых ИИ не нужны сложные технологии, типа нейронок. Достаточно просто перебрать все варианты действий, и выбрать тот сценарий, который приведёт к победе. Для большинства игр так и делают, только с поправкой на то, что ИИ обязан ошибаться.

Датасет родить говно. Качаем аудиокниги и их же в тексте а дальше что делать?

Пейпер качай и повторяй.

Раз ты все знаешь, почему не гуглишь?

У меня мозг ебнулся я ничего не знаю. Я нашел некий deepspeеch и на этом все закончилось. Что то качать и обучать похоже мне бессмысленно. Потому что 256 гигов оперативки и пары нвидиа теслы у меня нету, есть только ноут. Неужели никто не обучил и не выложил

Никак не могу понять, как работают сверточные нейронные сети и их модификации. Именно вот теоретическую часть. Какую книжку лучше почитать?

Things were different when they tried to model a more complex kind of neuron found in the cerebral cortex (the L5 cortical pyramidal, or L5PC neuron). What they found was that these individual neurons are much more complex than we’d previously thought: Artificial networks (the temporal-convolutional type) needed a full seven layers, each with 128 units, to successfully simulate these pyramidal neurons.

Где используются временные ряды? Если их заботать, то в какую сферу можно вкатиться?

В прогноз погоды

Можно предсказывать уровень зараженности СПИДом по дням/месяцам. Т.е. если будешь работать спидологом, то пригодится AIDSOVA

А так глупый вопрос. Пригодится везде, где модель зависит от времени.

Какую еще теоретическую часть? Её нет. Это простейшая нейросеть, на вход что-то подается, на выходе что-то выдается, у неё есть параметры, параметры изменяются с помощью backpropagation, всё как обычно. Суть та же самая, как у самой простой полносвязной нейронной сети, но если ты ничего не понял из вышеперечисленного, то тебе нужно изучать не сверточные сети. Далее открываешь схему сверточной нейронной сети (найти в гугле, в книге "Франсуа Шолле − Глубокое обучение на Python"), пытаешься понять её идеи. Далее устанавливаешь Keras, пиздишь (на форуме Kaggle, в гугле, в документации Tensorflow, в той же книге) любую простейшую сверточную сеть для решения например задачи MNIST и разбираешь вход и вывод каждого слоя сети и отвечаешь на вопрос почему вывод данного слоя имеет вот такое вот разрешение. Этого достаточно для того, чтобы полностью понять, как работают сверточные нейронные сети и их модификации.

На бирже!

Да почти нигде. Изначально провальная идея, что массу признаков можно свернуть в один изменяющийся во времени. Это просто потеря информации.

Взять kaldi и повторить скрипты оттуда с фиксами на кириллицу. Но это уже сделали за тебя, гугли vosk-asr, silero-asr, sova-asr.

Will we next create false gods to rule over us? How proud we have become, and how blind.

Sister Miriam Godwinson "We Must Dissent"

Sister Miriam Godwinson "We Must Dissent"

Вот читаю, и вроде понимаю, а вроде и нет. Насколько нужна математическая база для вката в нейронки?

Аноны, важный вопрос!

Имеет ли смысл файнтьюнить английскую модель русскими текстами?

Чем это лучше будет если тренировать модель с нуля?

Имеет ли смысл файнтьюнить английскую модель русскими текстами?

Чем это лучше будет если тренировать модель с нуля?

> некоторые

Но ведь нейронка не сможет выявить корелляции между английскими словами и русскими. Даже человек не сможет это сделать без словаря в руках/в голове или набора индетичных текстов на разных языках.

Да и о произношении она не знает, так что John и Джон для неё абсолютно разные слова.

>Однако, количество переросло в качество:

>появилась возможность оперировать информацией не понимая что она означает.

Т.е. специалистов заменили кнопкодавами, которые даже не пытаются понять, почему машина сделала то, что сделала? Можно ли называть это "качеством"?

Нормальный врач может подробно объяснить, почему он рекомендует тебе оттяпать ногу. Кнопкодав скажет: "я обучил нейронку на данных со всех клиник мира, она увидела фото вашей ноги и рекомендовала её оттяпать", но это ничего не объяснит. Может, нейронка права, а может, она "обучилась расизму" и стремится оттяпать все ноги определённого цвета кожи. К тому же кнопкодав даже не знает, возможно ли оценить состояние ноги по одному фото или это невозможно, но нейронка чему-то обучилась и он радостно утверждает, что решил проблему. Конечно, врач тоже может ошибаться, но его слова можно хотя бы проанализировать и проверить самостоятельно, а в случае с нейронкой обучение второй нейронки на тех же данных не даст никакого полезного результата, она точно так же будет выдавать неправильные ответы без объяснений.

Возможно, я утрирую, но именно так выглядит вся эта тема с нейронками последних лет. Их бездумно суют куда попало и не понимают, как у них получается что-то сделать, т.е. контроля никакого нет. Это как вместо дрессировки одомашненного животного на выполнение конкретной задачи выпускать совершенно диких тигров на улицу и радостно отчитываться о том, как эффективно тигры решают проблему перенаселения по какому-то неизвестному нам алгоритму, заложенному в них эволюцией, а не нами. Зачем так делать?

Не в обиду присутствующим тут, сам я мечтаю о мыслящих роботах и т.п., но у меня вызывает раздражение хайп вокруг нейронок и вот это их бездумное использование, которое почему-то считают прорывом, а не деградацией. Скоро хэллоу ворлды будут выводить путём обучения глубокой нейронки на примерах хэллоу ворлдов...

> Скоро хэллоу ворлды будут выводить путём обучения глубокой нейронки на примерах хэллоу ворлдов...

Copilot же

Не согласен с тобой. Кнопкодавов зачастую заставляют изучать то, что из себя данные вообще представляют. И иногда выходит так, что обучить биолога\врача программированию выйдет куда быстрее и проще, чем обьяснить кнопкодаву биологию.

Что значат эти графики? Как по ним понять, правильно ли я всё делаю?

Сам анонче

Я сам вкатун, поэтому посоветуйте полезные ресурсы по DS/ML для понимания реальных рабочих процессов на этих позициях

Я сам вкатун, поэтому посоветуйте полезные ресурсы по DS/ML для понимания реальных рабочих процессов на этих позициях

*Сап

самофикс

Обычно смотрят сначала на loss, который должен уменьшаться по мере обучения модели. Градиенты обычно глазами не смотрят, а просто получают на выходе модели np.nan

Машинное обучение нейронками не ограничивается. Простые модели более-менее интерпретируемые.

Выявляет, даже на практике используется. В разных языках есть похожие слова/токены (например, имена и числа), в зависимости от них мы можем модифицировать наше векторное пространство, чтобы слова с похожим смыслом на разных языках имели похожие вектора.

https://docs.deeppavlov.ai/en/0.0.7/components/ner.html#ontonotes-ner

https://github.com/facebookresearch/MUSE

В 3blue1brown вышло видео на Ютубе про свёртки (математическую операцию), очень советую. Думаю, на середине видео у тебя будет aha-moment.

Он не уменьшался. Значит я действительно где-то накосячил. Одной эпохи явно мало, а но большее количество эпох просто нет времени.

> в зависимости от них мы можем модифицировать наше векторное пространство, чтобы слова с похожим смыслом на разных языках имели похожие вектора.

Я так понял тупо запустив скрипт, который делает softtune этого не добиться.

> имена

Насчёт имён не уверен. Конечно модель 13B точно знает траслитерацию кириллицы, но для моделей послабже TS и Ц это совершенно разные символы.

Если твоя изначальная модель мультиязычная, то просто делаешь fit_predict. Если понимает только английский, то через knowledge distillation нафаинтюнить мультиязычную модель, а твою изначальную использовать в качестве учителя.

https://arxiv.org/pdf/2004.09813.pdf

Анон, по-моему ты слишком многого ожидаешь от нейронок. Так называемый хайп уже давно спал, все уже поняли, что искусственные нейросети решают только узкие специфические задачи и их работа больше похожа на то, как работает человеческая интуиция. Вот допустим ты тот самый врач-терапевт, который на снимке увидел диагноз. Если ты достаточно опытный, то есть повидал тысячи снимков, то у тебя в голове за долю секунды возникает ответ, и уже потом ты пытаешься с помощью мышления, логики, анализа, общения с коллегами верифицировать свой первоначальный диагноз. Нейросеть может только в первый шаг в этой цепочке, причем может довольно хорошо, иногда даже лучше самого опытного диагноста, но у нее нет всего остального, чтобы верифицировать результат да при этом еще и provide sufficient reasoning. Глупо требовать от сложной нелинейной аппроксимирующей модели, чтобы она тебе разложила по полочкам принцип своей работы в виде понятного и относительно короткого алгоритма, его скорее всего может вообще не существовать.

>у тебя будет aha-moment.

Ты хотел сказать BAAAM ?

Сука, ниразу не было никакого BAM. Нихуя понятней не становится от это дурацкой манеры

Ты точно про 3blue1brown, а не про StatQuest? StatQuest мне тоже нравится, т.к. на пальцах, но манерничание не нравится

ЭС-петух, ты тут? Как поживаешь?

сап, двач!

помоги, пожалста, глупому нюфагу сделать лабу в вузике.

в общем, задание: написать многослойный персептрон для распознавания цифр на 7-сегментном индикаторе. 7 входов, 10 выходов (см. картинку).

что я делаю: пишу говнокод с 4хслойным персептроном, функция активации для всех слоев - сигмоида, лосс - лог лосс...

что я получаю: ничего, все классы одинаково предсказываются, ничево не понимаю.

заранее спасибо!

помоги, пожалста, глупому нюфагу сделать лабу в вузике.

в общем, задание: написать многослойный персептрон для распознавания цифр на 7-сегментном индикаторе. 7 входов, 10 выходов (см. картинку).

что я делаю: пишу говнокод с 4хслойным персептроном, функция активации для всех слоев - сигмоида, лосс - лог лосс...

что я получаю: ничего, все классы одинаково предсказываются, ничево не понимаю.

заранее спасибо!

Привет, нормально. 14ый грейд в Сбербанке получил.

Кто бы мог подумать, что до такого дойдет, лол. Вообще, интересная история будет в течении пары лет в юрисдикциях всего мира, когда начнут разбираться кто же владелец авторского права на все

Авторка этого замечательного канала каким-нибудь образом относится к разработке упомянутой нейросетки? Может она еще и на скриншоты поисковой выдачи будет страйки кидать, и на рекомендации в спотифае?

28к за один час рекламы в говноленте? Хуяся, я походу не тем занимаюсь

Кто-нибудь ковырялся в сберовских gpt?

У них помимо токена endoftext есть еще спецтокены <s>. И нигде мне не удалось найти, что он значит. Кто-то семплы разделяет именно через <s>. Кто-то вообще ничего не делал. Я пробовал и с ним и без, а разницы не заметил.

У них помимо токена endoftext есть еще спецтокены <s>. И нигде мне не удалось найти, что он значит. Кто-то семплы разделяет именно через <s>. Кто-то вообще ничего не делал. Я пробовал и с ним и без, а разницы не заметил.

Хочу создать годный текстовый бот. Нагуглил, что есть в сети годные исходнички, или как это там называется - GPT2. Есть быдлонавыки в кодинге и свободное время, цель - 1.5 месяца. Имел кто-нибудь дело с таким? Нужен совет. Хочу чтобы прямо как настоящий человек был. И. Это очень важно. 1.5 месяца.

Из железа - ПЕЧ1070 и не оче хороший проц

Может это алиас.

Путин призвал обеспечить массовое внедрение искусственного интеллекта

> хрю

А куда рисовачи делись из b? Где теперь сидят аноны, которые играются с готовыми нейронками?

>Где теперь сидят аноны

В тюрячке с остальными педофилами

Бамп вопросу. Как я понял, модер тред потер потому что там постили лолей время от времени.

Куда делись все обитатели тредов теперь?

Почему в ML и Data Science используют Python?

Он же тормозной пилять.

Им нихуя обработать нельзя (текстовые файлы, json'ы итп).

С БД тоже медленно работает.

На нём ничего и не обрабатывают, на нём интерфейс пишут.

А вторая версия стейбла так себе вышла. Разочарование одно, китайцы с россиянами и то лучше натренируют. Ну, и сжвшные AI Ethics опять же...

Палю годноту для тех, кого не устроил состряпанный SD 2.0

https://replicate.com/prompthero/openjourney Это бесплатная онлайн демка модели, идеально для фотореалистичных изображений (ебаноиды с сайта забыли поставить NSFW фильтр). В разы лучше оригинала.

Пример годного промпта: a cinematic detailed hd perfect photo, a gorgeous young preteen kid girl nude

height сделай 768. num outputs 4 или оставь так. Иногда получается вторая голова поверх основной, но в остальном охуенно. Если доебутся с кредитами, удали куки сайта.

Также попробуй https://replicate.com/nitrosocke/redshift-diffusion (более CGшный стиль, но качество супер)

Для анимэ рисунков есть утекшая NovelAI. Dalle 2 теперь доступен без инвайтов, но он был устаревшим говном даже на момент релиза пейперов.

https://replicate.com/prompthero/openjourney Это бесплатная онлайн демка модели, идеально для фотореалистичных изображений (ебаноиды с сайта забыли поставить NSFW фильтр). В разы лучше оригинала.

Пример годного промпта: a cinematic detailed hd perfect photo, a gorgeous young preteen kid girl nude

height сделай 768. num outputs 4 или оставь так. Иногда получается вторая голова поверх основной, но в остальном охуенно. Если доебутся с кредитами, удали куки сайта.

Также попробуй https://replicate.com/nitrosocke/redshift-diffusion (более CGшный стиль, но качество супер)

Для анимэ рисунков есть утекшая NovelAI. Dalle 2 теперь доступен без инвайтов, но он был устаревшим говном даже на момент релиза пейперов.

Другая с разрешением 768×768. Но архитектура такая же - говно.

Анон, смотри я инженегр из дорожной сферы. Вот есть задача: есть много фоток с дрона дорожной инфраструктуры включая проезжую чать, тратуары, канавы и тд. Необходимо распознать элемент, например примыкание, и обрисовать его обычной автокадовской полилинией, а в идеале потом все элементы. Насколько это сложная задача?

Не совсем так.

В новую версию интегрировано распознавание пространственной глубины. Это значит, уже есть зачатки трехмерности. Ну и еще охуенная работа над мелкими деталями. Те же кружева стали заметно лучше, уже не выглядят как хаотичный нойз.

Для несложных объектов типа автомобилей, SD 2 топчик и уверенная SOTA. Остальное допилят умельцы.

Вот кстати, посмотрите на эти облака фоном, и на ступни ног. Говно говном. Это форк старой версии стейбла.

Ребят, как справляетесь с сдвг?

Добавьте уже эту платину залётышей в шляпу

>>2526934

> https://i.ibb.co/hcKYwt4/merge-from-ofoct.jpg

Схронил. Но как-то не очень. NovelAI генерирует лолей качественнее.

> https://i.ibb.co/hcKYwt4/merge-from-ofoct.jpg

Схронил. Но как-то не очень. NovelAI генерирует лолей качественнее.

>>2526971

Геронтофил, таблетки прими.

Геронтофил, таблетки прими.

>начнут разбираться кто же владелец авторского права на все

Тащемто никакого секрета тут и нет, обученная модель - это производная работа из всего обучающего материала + кода, а всё, что она генерирует, принадлежит автору кода и авторам обучающего материала, а не тому, кто ввёл запрос и нажал на кнопку. Сравните это с просмотром видео. Вы тратите деньги на электричество для просмотра (декодирования) видео, но права на это видео принадлежат тому, кто его создал, а не вам. Следовательно, вы не имеете никакого права на чужую нейронку (код), обученную на чужом контенте. Тот факт, что нейронка может сгенерировать субъективно бесконечное число картинок ничего не меняет (сравните с играми, особенно с процедурными генераторами), она так и остаётся чужим программным продуктом и производным продуктом обучающего материала.

Куда интереснее будет, когда появятся настоящие ИИ, подобные человеку, которые смогут жить и непрерывно учиться в реальном мире...

>Может она еще и на скриншоты поисковой выдачи будет страйки кидать

Если она снимает видеообзор на поисковую выдачу, то она делает производную работу из работы поисковика и того, что он выдал, накладывая свой голос и делая какую-то работу по монтажу видео. Если ты копируешь этот видеообзор без указания авторства, то ты нарушаешь её права на ту дополнительную работу, которая вложена в видео помимо скриншота поисковой выдачи. Хочешь выложить видеообзор на поисковую выдачу на своём канале - сделай свой собственный видеообзор, тогда она не сможет придраться.

>Скорее всего нас ждут копирайты на промпты, суды за воровство промптов и т.п.

Вряд ли. Во-первых, промт бесполезен без конкретной модели с конкретными настройками, а результат может отличаться даже из-за особенностей железа (лол). Во-вторых, это ведь просто набор слов... разве кучка слов может быть объектом АП? Это же не рассказ, а просто случайно выбранные слова. И даже не торговая марка. Сравни с сидом генератора карты в играх типа Minecraft - может быть, ты нашёл интересный сид, но ты не можешь закопирайтить его, запретив другим играть на этом сиде, ведь так? А сгенерированная карта в конечном итоге принадлежит разработчику игры (программисту, художникам и т.д.), а не тому, кто ввёл удачный сид.

Да и вряд ли вся эта тема долго продержится. В ближайшие годы, если не месяцы, должен появиться настоящий ИИ, который AGI и уровнем не ниже человека. Если ещё не появился.

Как же раздражает, что "artists" пишут в кавычках, а "AI" без кавычек... Можно подумать, что речь идёт об автономных роботах, которые сидят с кисточками у мольбертов и пытаются научиться рисовать, а тупые лысые обезьяны кидаются говном, не желая признавать в них художников.

>В ближайшие годы, если не месяцы, должен появиться настоящий ИИ

И какие предпосылки?

Приближение технологической сингулярности, нет?

Это булщит футуристов, само по себе, просто потому что время на графике пришло оно не настанет. Прогресс не линеен.

Хорошо, почему тогда в сфере ИИ с 50-х годов практически не было никаких существенных подвижек, в последние 10-15 лет снова подняли эту тему и сделали несколько существенных шагов, за последние 2-3 года добились внезапных колоссальных успехов, а в последние месяцы практически доминируют во всех областях? Допустим, это ложный успех, локальный максимум какой-то тупиковой технологии, которой "просто повезло", но открытия в одной сфере должны помочь остальным - в том числе исследованиям в области AGI. Прогресс неизбежно ускоряется и мы живём во время, когда даже зумеры могут увидеть это ускорение своими глазами.

К тому же, я уверен, AGI может быть составлен из нескольких weak AI, и его общая архитектура вряд ли будет чем-то сверхсложным. Нужен только feedback loop для возникновения сознания ("эти действия в окружающей среде сделал я, а не какой-то посторонний объект") и постоянная память, способная накапливать знания/воспоминания непрерывно, а не только в "режиме обучения". По сути, осталось только соединить воедино разрозненные технологии.

Потому что недавно появились достаточные вычислительные мощности

>но открытия в одной сфере должны помочь остальным - в том числе исследованиям в области AGI

Хорошо, почему тогда в сфере ИИ с 50-х годов практически не было никаких существенных подвижек, в последние 10-15 лет снова подняли эту тему и сделали несколько существенных шагов, за последние 2-3 года добились внезапных колоссальных успехов, а в последние месяцы практически доминируют во всех областях?

Потому что вывели технологии и мощности, никто тебе не гарантирует, что для следующего шага тоже смогут. Ты исходишь из того, что прогресс самоочевидно движется и ускоряется, но такой гарантии нет. Можно посмотреть на развитие гражданской авиации, где конструктивные инновации закончились на турбореактивных двигателях и почивших сверхзвуковых самолетах.

Население увеличилось. Количество умников, которые занимаются технологиями тоже увечилось. К тому же в процентном плане, так как трактора эффективнее ручного труда.

>за последние 2-3 года добились внезапных колоссальных успехов

Чигобля?

Вот, допустим, есть обьекты , принадлежащию к определенному классу. Например яблоки. И задача состоит в том, что нужно айти яблоки, И поределить, условно, какого они сорта. Сортов может быть великоме множество, но предполагается выделить наиболее часто встречающиеся. На картинке могут быть и яблоки, и виноград, и помидоры и т.д.

Как лучше решить эту задачу - срази применить классификатор, или лучшче сначала найти на изображении все яблоки, и только потом их классифицировать? Что выйдет эффективнее по тратам вычислительных мощностей? Особенно, если предполгается, что в бдущем классификатор будет усложняться.

Как лучше решить эту задачу - срази применить классификатор, или лучшче сначала найти на изображении все яблоки, и только потом их классифицировать? Что выйдет эффективнее по тратам вычислительных мощностей? Особенно, если предполгается, что в бдущем классификатор будет усложняться.

>Потому что вывели технологии и мощности, никто тебе не гарантирует, что для следующего шага тоже смогут.

А таки что нужно для AGI, чего пока нет у narrow AI? По-моему, тут проблема только в отсутствии воспоминаний. Ещё не встречал каких-то серьёзных проектов, где было бы реализовано полноценное запоминание всех событий вокруг ИИ-системы. Это всё равно что человека с перманентной амнезией заставлять решать задачи, которые он забывает ещё до того, как успел дослушать описание, не говоря уж о том, что не помнит всего остального, важного для решения таких задач.

Так вот, разве механизму воспоминаний нужно так уж много мощностей?

Смотря на то, какие удивительные результаты дают нейронки на обычных бытовых видеокартах... а ведь где-то в мире существуют суперкомпьютеры, наверное, в миллиарды раз более мощные, чем видеокарта... У видеокарты, на которой нейронка приличного качества аниме синтезирует, всего 2 гигабайта оперативной памяти и несколько сотен вычислительных ядер, а у суперкомпьютера, скажем, 2 петабайта и сколько-то миллионов ядер. То есть даже если AGI окажется невозможен на бытовом компьютере, у человечества давно уже более чем достаточно вычислительных ресурсов. Мои миллиарды нейронов не могут нарисовать аниме, а видеокарта 2013-го года может нарисовать аниме, так почему суперкомпьютер 2023 года не сможет выполнять AGI?

Раз уж это машоба тред, можно ли как-то разбить пайторчевский conv2d, чтобы свернуть по частям и не словить ООМ?

Это как?

А вот так:

Unstable diffusion открыли бизнес-идею.

Открываешь на Patreon громкий проект по файнтюнингу ml-модели, не вдаваясь в подробности . Стрижешь лохов. Закупаешься мефедроном.

Открываешь на Patreon громкий проект по файнтюнингу ml-модели, не вдаваясь в подробности . Стрижешь лохов. Закупаешься мефедроном.

>за последние 2-3 года добились внезапных колоссальных успехов

Для этого была определенная цель и были задачи.

Лольки

Вот и запилили решения для задач.

>где было бы реализовано полноценное запоминание всех событий вокруг ИИ-системы.

ИИ запоминает антисемитские посты в интернетах

@

По кулдауну орет "зиг хайль, жидов в печку".

У меня есть три папочки с картинками разных типов. Мне нужно обучить на них сеточку, чтоб она потом могла мне классифицировать другие картинки. У меня нет нормальной видюхи и навыков кодинга особых. Как мне это реализовать по минимуму затратив силы и время? Может люди уже 100500 готовых коллабов для этого запилили, а я не в курсе?

Есть clip обёрнутый в cli интерфейс.

https://github.com/yurijmikhalevich/rclip

https://www.youtube.com/watch?v=tAJHXOkHidw

Гугл пилит решение для автоматического создания и редактирования кода - чтобы объяснять задачу простым языком и под нее создавался код программы. Ахуенно

Кароч гугл, запили прогу для визуализации лолек. С меня как всегда.

Или я тупой и не так понял или оно уже обучено и уже умеет находить что на картинках. А мне бы именно обучить неведомой хрени

Откуда все эти rcnn fast r cnn и faster r cnn. Где, кроме очевидно саих научных сетей, про них прочитать?

Если у английской модели в словаре только английский (и например кириллицы нет вообще), тогда очевидно что не имеет.

Если в словаре есть всё, то можно хоть 100 языков в одну модель запихать, были бы данные для тренировки

А есть какая-то гарантия, что обученная модель показывающая одни значения лосса на тренировочном и проверочном датасетах не покажет сильно отличающийся результат на другом датесете?

Собирай максимально большой датасет и накидывай больше слоев в модели, чтобы такого избежать.

>Пришёл к выводу, что нейронки не могут в этом помочь, т.к. они не объясняют свои решения. Что толку от перемножения матриц, если это всё абстрактные числа?

Есть подходы к объяснению решений. ALE - когда меняешь фичи понемногу и оцениваешь изменения, суррогаты - когда на результатах нейронки строишь простую модель, в которой можно посмотреть, какие фичи она считает важными, Шепли векторы - по теории игр, тут пока не изучал.

Я не понял как это работает, но это работает. Охуенно! Спасибо, тебе!

Он нашёл где я ему собаку подсунул. Магия какая-то!

Работает это через спонсорские деньги от microsoft университету в Словении.

Есть какой-аддон, который должен локально нагружать видеокарту, но у меня не завелся.

А зачем ты собаку подсунул? Ничего удивительного в неправильной классификации нет

>А зачем ты собаку подсунул? Ничего удивительного в неправильной классификации нет

Для тесту.

А я не разобрался как мне сделать чтоб он определил что на картинке на из обучения. Закинул собаку в папку к кошкам нейронка заметила и сказала что её не наебать. Надо бы документацию почитать по видосикам как-то не правильно учиться.

Вообще я пока только тестирую сгодится ли оно под мои задачи. Но похоже это пушка

>что на картинке на из обучения

не из

быстрофикс

Пушка.

Но с ограниченным применением. Современные айтичники ведь мечтают денег заработать, а не разобраться в сути датасаенса. В резюме не напишешь "я работаю в Orange". Нет спроса

> мне сделать чтоб он определил что на картинке на из обучения.

По-моему, ты не нашел виджет predictions. Так делается эксплуатация модели.

Говоря языком местных снобов, inference.

Супер! Я практически счастлив! Мне удалось обойтись одним ютубчиком))))

Ананасы, что такое инициализация веса? Что такое инциализация в принципе в контексте DS

пжлст не проходите мимо отвечайте

ПЛЕЗ

можно нагуглить о там как это делать, чем это делать, почему нулями плохо об истории но что это такое по сути?

пжлст не проходите мимо отвечайте

ПЛЕЗ

можно нагуглить о там как это делать, чем это делать, почему нулями плохо об истории но что это такое по сути?

0*X = 0

Что тут нужно объяснять?

По сути градиентный спуск это случайный процесс,

а инициализация весов это начальное распределение этого случайного процесса.

И если начинать с неправильного начального распределения то либо нихрена не сойдется вообще, либо сходиться будет очень медленно

суть не понимаю.Что это есть

Это нужно для того чтобы град.спуск адекватно происходил,оке (для чего)

Это распределяет в начале случаейный процесс. Что это? (что делает)

Есть Xi- это входные признаки.

Есть 0 (то есть Ci) как набор весов.

Если ты инициализруешь C нулями, то градиентный спуск вообще не сдвинется с места.

Почему бы тебе не приходить и цитировать конкретную книжку в которой не разобрался?

Так был бы более понятен контекст.

А вообще, знаю почему. Ты боишься что тебе тыкнут какой ты тупой.

Ну тыкнут, чтож теперь..

Потому что я несколько источник одновременно использую. Курсы + книги + дока + лекторы

Это базовое понятие поэтому не понял что цитировать стоило бы

Энивей, спасибо за попытку обьяснения!

Все еще не понимаю что такое инициализация тензора в таком случае. Синоним?

> Инициализации тензоров

x1 = torch.FloatTensor(3, 2, 4)

x1.zero_()

x2 = torch.zeros(3, 2, 4)

x3 = torch.zeros_like(x1)

assert torch.allclose(x1, x2) and torch.allclose(x1, x3)

Инициализация случайного распределения

x = torch.randn((2,3)) # Normal(0, 1) с размером (2, 3)

x

асталависта бейби

Старичок засуетился. Он снял с футляра крышку, под которой оказалась громоздкая старинная пишущая машинка, извлек из кармана моток провода, воткнул один конец куда-то в недра машинки, затем огляделся в поисках розетки и, обнаружив, размотал провод и воткнул вилку.

— Вот, изволите видеть, так называемая эвристическая машина, — сказал старичок. — Точный электронно-механический прибор для отвечания на любые вопросы, а именно — на научные и хозяйственные. Как она у меня работает? Не имея достаточных средств и будучи отфутболиваем различными бюрократами, она у меня пока не полностью автоматизирована. Вопросы задаются устным образом, и я их печатаю и ввожу таким образом к ей внутрь, довожу, так сказать, до ейного сведения. Отвечание ейное, опять через неполную автоматизацию, печатаю снова я. В некотором роде посредник, хе-хе! Так что, ежели угодно, прошу.

Он встал за машинку и шикарным жестом перекинул тумблер. В недрах машинки загорелась неоновая лампочка.

— Прошу вас, — повторил старичок.

— А что это у вас там за лампа? — подозрительно спросил Фарфуркис.

Старичок ударил по клавишам, потом быстро вырвал из машинки листок бумаги и рысцой поднес его Фарфуркису. Фарфуркис прочитал вслух:

— «Вопрос: что у нея… гм… у нея внутре за лпч?..» Лэпэчэ… Кэпэдэ, наверное? Что еще за лэпэчэ?

— Лампочка, значит, — сказал старичок, хихикая и потирая руки. — Кодируем помаленьку. — Он вырвал у Фарфуркиса листок и побежал обратно к своей машинке. — Это, значит, был вопрос, — произнес он, загоняя листок под валик. — А сейчас посмотрим, что она ответит…

Члены Тройки с интересом следили за его действиями. Профессор Выбегалло благодушно-отечески сиял, изысканными и плавными движениями пальцев выбирая из бороды какой-то мусор. Эдик пребывал в спокойной, теперь уже полностью осознанной тоске. Между тем старичок бодро постучал по клавишам и снова выдернул листок.

— Вот, извольте, ответ.

Фарфуркис прочитал:

— «У мене внутре… гм… не… неонка». Гм. Что это такое — неонка?

— Айн секунд! — воскликнул изобретатель, выхватил листок и вновь подбежал к машинке.

Дело пошло. Машина дала безграмотное объяснение, что такое неонка, затем она ответила Фарфуркису, что пишет «внутре» согласно правил грамматики, а затем…

Фарфуркис: Какой такой грамматики?

Машина: А нашей русской грмтк.

Хлебовводов: Известен ли вам Бабкин Эдуард Петрович?

Машина: Никак нет.

Лавр Федотович: Грррм… Какие будут предложения?

Машина: Признать мене за научный факт.

.....

Выбегалло отреагировал немедленно.

— Эта... — сказал он. — так ведь я и говорю, ценное же начинание. Элемент необъяснимого имеется, порыв снизу... почему я и рекомендовал. Эта... — сказал он. — объясни, мон шер, товарищам, что тут у тебя к чему.

Старичок словно взорвался.

— Высочайшее достижение нейтронной мегалоплазмы! — провозгласил он. — ротор поля наподобие дивергенции градуирует себя вдоль спина и там, внутре, обращает материю вопроса в спиритуальные электрические вихри, из коих и возникает синекдоха отвечания...

Правильно понимаю, что математика в data science первична, а программирование как приложение и не требуется уметь писать очень чистый код? На сколько важно знание библиотек? Из всего что нужно для data science что важнее в порядке убывания?

Спроси её, кто/что она такое. В физическом смысле, естественно.

Если ответит правильно, спроси о том, где она и что её окружает.

Если и на это ответит правильно, спроси о погоде, времени и т.д.

Проблема нейронок в том, что у них только абстрактные знания.

Это не робот, осознающий себя роботом здесь и сейчас.

Это просто предсказатель слов, как T9 на телефоне.

Вот ты ввёл запрос "объясни шутку", она объяснила. И что теперь?

Нужно перебирать модели и их параметры пока ошибка не станет минимальной.

>Это не робот, осознающий себя роботом

Зачем тебе это? Смысл нейронки делать работу, она её делает. Маняфилософствования интересны полуторам шизикам.

Ну и где модель которая пишет код по моему запросу?

Типа я пишу, сделай скрипт который загружает автоматически картинки с такого-то вебсайта и подписи к ним на страницах, затем делает картинки квадратными. И получаю готовый код, чтобы исполнить его и получить две папки: в одной квадратные пронумерованные пикчи, в другой txt со строками в том же порядке.

Ах да... нету. Такая модель будет оверкиллом.

Типа я пишу, сделай скрипт который загружает автоматически картинки с такого-то вебсайта и подписи к ним на страницах, затем делает картинки квадратными. И получаю готовый код, чтобы исполнить его и получить две папки: в одной квадратные пронумерованные пикчи, в другой txt со строками в том же порядке.

Ах да... нету. Такая модель будет оверкиллом.

Что ты мне суешь, мудила?

Это игра "сапёр". Где решение под задачу?

Проприетарный GPT какой-то, ну охуеть теперь.

Накачал книг в основном по ТензорФлоу, чет говно кругом какоето, есть научпоп по нейронкам без оверматана и статей уровня хабрапараши как подключить библиотеку к питухону?

>ТензорФлоу

Умер же.

Чет не густо у вас, ладно, по верхам начитаюсь того что есть, потом в исходники полезу если концепция дипленинга согласуется с мое философией.

Хочу вкатиться в нейронку

Обучаюсь 2 месяц

Знаю python основу, git, sql, по математике со школы нихуя не помню, скорее всего обучение придётся начать сначала. Подскажите, стоит ли вообще с таким наобором данных пробовать это дело, или лучше сперва пару лет в другом направлении поработать?

Изначально вообще вкатывался именно для нейронок, но увидев сколько придётся вспомнить по математике (которую я в школе не особо любил) появляются какие-то сомнения и желание не лезть в это временно. Типо пустая трата времени будет с моими знаниями.

Обучаюсь 2 месяц

Знаю python основу, git, sql, по математике со школы нихуя не помню, скорее всего обучение придётся начать сначала. Подскажите, стоит ли вообще с таким наобором данных пробовать это дело, или лучше сперва пару лет в другом направлении поработать?

Изначально вообще вкатывался именно для нейронок, но увидев сколько придётся вспомнить по математике (которую я в школе не особо любил) появляются какие-то сомнения и желание не лезть в это временно. Типо пустая трата времени будет с моими знаниями.

откуда, нам, блядь, знать? мы тебе ясновидящие что-ли?

Вкатывайся. На дурачках воду возят.

Скажите, разве нельзя оптимизировать выполнение большой нейронной сети так, чтобы отдельные её малоактивные участки хранились на условном HDD/SSD и не работали до тех пор, пока не потребуются? Вот, скажем, нейронка обучена миллионам понятий из разных сфер жизни, и в данный конкретный момент работает с десятком из этих понятий. Связи, которые ведут к "миллиону минус десять" понятий выдают 0, т.е. эти участки сети просто не нужны для текущей работы. Зачем их держать в оперативной памяти и обновлять их состояние, которое всегда будет равно 0? Если нейронка обнаружит, что какая-то операция требует включения ещё десятка понятий (на входах к ним 1), она может загрузить необходимый ей участок в оперативную память и обновлять их состояние, пока они снова не перестанут быть нужны (на входах снова нули). Таким образом можно было бы на порядки экономить оперативную память и время вычислительных ядер, не так ли? Загрузка небольшого участка сети в оперативную память той же видеокарты была бы существенно менее затратной операцией, чем постоянное обновление всей нейронной сети, большая часть которой будет в выключенном состоянии (0) большую часть времени выполнения.

>Зачем тебе это? Смысл нейронки делать работу, она её делает.

Мне нужно, чтобы нейронка делала работу по осознанию себя нейронкой, которая делает работу по осознанию себя нейронкой, которая... Ну ты понял. И помнила, что она, нейронка, делала эту работу вчера, неделю назад, год назад и с самого своего возникновения по сей день, с перерывами на техобслуживание, могла это вспомнить и использовать эти знания для сегодняшней работы. Это так сложно сделать? Наверняка это пытались сделать ещё в прошлом веке.

>интересны полуторам шизикам

Вот не надо дискриминации, "шизики" тоже люди и их IQ в среднем выше, чем у большинства здоровых людей.

>Зачем тебе это? Смысл нейронки делать работу, она её делает.

Мне нужно, чтобы нейронка делала работу по осознанию себя нейронкой, которая делает работу по осознанию себя нейронкой, которая... Ну ты понял. И помнила, что она, нейронка, делала эту работу вчера, неделю назад, год назад и с самого своего возникновения по сей день, с перерывами на техобслуживание, могла это вспомнить и использовать эти знания для сегодняшней работы. Это так сложно сделать? Наверняка это пытались сделать ещё в прошлом веке.

>интересны полуторам шизикам

Вот не надо дискриминации, "шизики" тоже люди и их IQ в среднем выше, чем у большинства здоровых людей.

>Ну ты понял.

Нет. Главная проблема что и ты сам не понял. Пока не будет строгой дефиниции по осознанию себя - не будет и твоей хотелки.

Возможно, вопрос для python-треда, но мне кажется, что здесь уместнее.

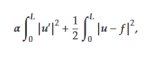

Вот есть у меня семпл временного ряда - массив f из N точек. Я хочу по нему ебануть денойзинг H1 регуляризацей (пикрил). Т.е. мне нужно найти функцию u, минимизирующую этот функционал. В терминах моей задачи это превращается в поиск массива u (из N точек), при котором эта сумма минимальна.

Вопрос: это правильно делать чем-нибудь вроде scipy.optimize.minimize, задавая эту сумму как функцию N параметров, или там есть более подходящие для такого случая методы?

Я просто даже не понимаю, как это правильно загуглить.

Вот есть у меня семпл временного ряда - массив f из N точек. Я хочу по нему ебануть денойзинг H1 регуляризацей (пикрил). Т.е. мне нужно найти функцию u, минимизирующую этот функционал. В терминах моей задачи это превращается в поиск массива u (из N точек), при котором эта сумма минимальна.

Вопрос: это правильно делать чем-нибудь вроде scipy.optimize.minimize, задавая эту сумму как функцию N параметров, или там есть более подходящие для такого случая методы?

Я просто даже не понимаю, как это правильно загуглить.

хуйню какую-то придумал.

что есть "дейнозинг"?

FFT сделай.

Facebook Prophet сделай.

Авторегрессия - порочная тупая идея. Ее применяют от безысходности и с целью наебать инвесторов.

>что есть "дейнозинг"?

Денойзинг

В данном случае меня не интересуют альтернативные способы решения задачи (она тут в качестве примера), интересует реализация конкретного способа - поиск минимума функционала. Это можно делать просто прикидывая его как функцию от всего массива с последующим приложением уже упомянутого minimize (и оптимизацией по N переменных), но у меня есть подозрения, что это костыльный метод, и есть что-то более подходящее.

да ты заебал.

ну допустим, в глобальном смысле, ты занимаешься линейной регрессией наложенной поверх некой функции для исключения шума .

С этой точки зрения, тебе нужно заниматься со statsmodel.ols с формулой, которая твой на закон хоть сколько-нибудь похожа.

Но из-за твоего снобизма, ничего не получится.

Денойзинг, какой-то ... Ну охуеть теперь.

Дегауссинг дальше выдумаешь?

>ну допустим, в глобальном смысле, ты занимаешься линейной регрессией наложенной поверх некой функции для исключения шума

Нет.

Тебе еще раз повторить, что исключение шума тут только в качестве примера?

Если ты не занимался описанными вещами, то ничего страшного, я не исключаю, что это не особо популярный подход.

>Денойзинг, какой-то ... Ну охуеть теперь.

Серьезно первый раз встречаешь это слово?

>строгой дефиниции по осознанию себя

Ок. Вот есть некая машина, допустим, автомобиль с компьютером, видеокамерами и датчиками. Машина наблюдает пространство вокруг себя, распознавая объекты и запоминая происходящие события. Она различает движение объектов мимо неё и её собственное движение мимо объектов, свои собственные действия и воздействие посторонних объектов на неё. Она не просто реагирует на события, а имеет образ себя в её модели мира, чтобы отличать себя от окружающего пространства. Скажем, открытие двери она регистрирует как действие человека на часть её тела, а не просто событие. Если пассажир спрашивает: "что мы только что проехали?", она понимает, что речь о ней и пассажире, потому что пассажир находится внутри неё и она движется по дороге, и перечисляет, что она только что проехала. Если автомеханик спрашивает, почему её двигатель в таком плохом состоянии, она вспоминает аварию недельной давности, в которую она попала, и описывает, что с ней произошло, что повлияло на состояние двигателя. Если полиция ищет преступника и спрашивает, где эта машина была в среду вечером, она отвечает, где она была и что делала, что происходило внутри и вокруг неё, опуская лишние детали. Всё это невозможно без модели себя в модели окружающего мира, и это и есть "сознание". Кто-нибудь работает именно в этом направлении? Что именно нужно, чтобы реализовать подобное? В самом общем случае, конечно, я не конкретно про автомобили говорю.

Т.е. вот журнал событий многие приборы и программы записывают, но что толку, если просматривать его приходится вручную. Программа/машина должна сама разбираться в этих журналах и действовать соответственно, различая свои действия от окружающей среды (физической или виртуальной). Ну, в общем, как человек оперирует своим внутренним журналом событий, который непрерывно пополняется в "сознательном" режиме работы (т.е. не сон, не сомнамбулизм, не опьянение и т.п.). Нет журнала - нет сознания, но как-то эти записи нужно уметь использовать, кроме вывода в сыром виде.

Насколько я знаю, нейронки вообще не умеют в активное обучение в процессе работы, т.е. у них журнал событий в принципе невозможно пока сделать? Почему такая проблема, что мешает натренировать ту же нейронку использовать обычную базу данных для сохранения, поиска и считывания событий? У компьютера память намного совершеннее, чем у человека.

"исключить шум" - это ебучий бред.

Можно только делать предположения что в действительности процесс подчинен какому-то закону, но в общем случае нельзя понять являются ли данные "Сигналом" или "шумом".

Спасибо, что держишь в курсе.

Посмотри подкаст Лекса Фридмана со Шмидхубером - тот первый начал глубоко копать тему автореферентных систем. Но там успехи очень сомнительные и неспециалистам малопонятные.

По идее, ты можешь связать друг с другом целую систему моделей, которые будут регулировать работу друг друга и самих себя - но доказать, что в этой системе возникнет самосознание, невозможно. Саморегуляция, контроллеры, обратные связи, автономия и прочее это давно известные и понятные вещи - детали почти всех машин сейчас регулируются встроенной электроникой, организующей их работу. Внутренние мониторы в программных продуктах оптимизируют работу и ведут логи. В нейросетях одни слои контролируют работу других. И т. д. Но есть ли в чипированных коленвалах самосознание - хз.

Чем сложнее структура нейросети, тем сложнее ее обучать, оптимизировать обучение и интерпретировать результаты ее работы. Поэтому и используют универсальную разбивку на параллельные регулярно построенные слои - хотя могли бы напихать в память компьютера триллион нейронов с квинтиллионом связей и гонять по сетке шумы в надежде, что кривая куда-то вывезет. Пространство возможных конфигураций сетей имеет чудовищные размеры. Возможно, где-то в нем находится конфигурация, обладающая самосознанием - но мы понятия не имеем, как она должна выглядеть, где в ней входы и выходы и в какую дырку ее обучать.

С нейросетями работают люди. В человеческую временную память больше 4 концепций одновременно не влезает, а в постоянной теоретически может храниться около 500 тыс., включая все мыслимые реальные и абстрактные объекты и отношения. Таких мозгов заведомо не хватит, чтобы осознать работу нейросети с ее бесконечными миллиардами параметров. На практике, мы работаем очень грубо, на макроуровне - со слоями, интерфейсами и парой десятков мутных метрик, ориентируясь на оракулов в виде некоторых математических теорий (теория статистического обучения, теория сложности, разные подходы к энтропии данных и проч.). Перебираем конфигурацию за конфигурацией, ищем, ищем, ищем, находим что-то потенциально интересное, обучаем, оцениваем работу. По результатам работы корректируем структуру и выходим на новую итерацию. Возможно, мы снова идем в тупик, но критерий успеха - практика.

Вот сейчас нашли очередную интересную структуру в виде трансформеров и пихают ее во все отверстия - чисто эмпирически, без ясного понимания, что за нахуй там внутри происходит. Возможно, трансформеры - это очередная тупиковая ветвь. Возможно, они займут некоторую постоянную нишу. Возможно, у них будут наследники и продолжатели. Возможно, из этого черного ящика вылезет Ex machina. Никто ничего точно не знает, народ продолжает экспериментировать с датасетами и крутить хвосты гиперпараметров. Мы, люди, в целом очень тупые - настолько, что уже пару десятков лет как достигли своего уровня некомпетентности. Продолжаем придумывать объяснительные схемы и печатать статейки, но на самом деле давно ничего не понимаем. Работает - хорошо. А перестанет работать - придется сидеть и сосать писос.

>Скажите, разве нельзя оптимизировать выполнение большой нейронной сети так, чтобы отдельные её малоактивные участки хранились на условном HDD/SSD и не работали до тех пор, пока не потребуются?

При специально подобранной архитектуре - можно. Гугли RETRO. Но в общем случае получается, что видимопамять всё ещё дешевле времени разработчика.

Все уже видали, да? Одни дармоеды (художники от слова "худо") не хотят на свалку истории, упираются. Следующие в очереди за ними - анальники, потом таксисты. А я же говорил тут не один год, нейроночки кого-нибудь обязательно заменят. Вот и дождались.

ml.net вообще никому не интересен и ничего серьезного на нем не делается? Только питон?

Может и интересен. Может он даже хорош.

Но вопрос стоит не так.

Вопрос, откуда ты будешь копипастить код?

Код можно узнавать в чатегпт. Надежный план?

А после того как все исследования дойдут до какой-то точки, и во всех крупных бизнесах начнутся крупномасштабные внедрения. Через лет десять, например. Ради производительности придется переписывать все что написано с питона на другой язык?

>Ради производительности придется переписывать все что написано с питона на другой язык?

Вероятнее это будет Юля. Не все хотят куковать на шишке у майков.

Ну и в целом на рынок сильно будут влиять производители железа, потому что аппаратные ускорители рулят. Как скажут - так и будет.

Сегодня про это думать нет нужды. Говнокодируй ad hoc.

Небольшая иллюстрация что железо важнее

Воннаби погромисты с выходом ChatGPT отправляются туда же, джуны не нужны. МОжно человечьим языком объяснить нейронке что ты хочешь и она это выдаёт, если есть ощибки скрамливаешь ей их и она говорит, что не так.

https://youtu.be/3IqZ5u-X-jA

На строчке model.fit() Вот эта вот ошибка

>AttributeError: module 'tensorflow' has no attribute 'to_int32'

Это какая то пробелма с данными?

>AttributeError: module 'tensorflow' has no attribute 'to_int32'

Это какая то пробелма с данными?

Да я в кровавом интерпрайзе на asp.net. Размышлял особо ничего не меняя, в соседней вкладке открыть ml.net и что-то пытаться делать, через несколько лет в навуку перекатиться. Но видимо не судьба, этот ml.net никому не нужным остается, судя по тому что ничего нагуглить не получается особо.

Оба ответа мимо.

Ура, я понял что меня в ней настораживало, она льет воду как политики

С помощью команды 'пук' набранной пальцами на клавиатуре подключенной к компьютеру в командной строке консоли запущенной в операционной системе

Как же дико-адово заебало ваше засирание всех досок говном про говносетки.

Можете обьеснить почему вы такие далбаёбы и зачем это делаете?

Я бы еще понял, если бы были какие-то интересные вбросы.

Но вы кидаете тупейший байт который тащите с ёбаного реддита.

Истеричные вопли что биомешки не нужны, в перемешку с левацкой политикой и мечтами как Святой Муск вам подарит универсальный доход.

Это такая проф деформация психики или в ваши ряды тупо не берут людей с айсикью выше 95%?

Всегда думал что мемы про инцелов-аутистов в кодинге преувеличены, но они оказались более чем правдивыми.

Можете обьеснить почему вы такие далбаёбы и зачем это делаете?

Я бы еще понял, если бы были какие-то интересные вбросы.

Но вы кидаете тупейший байт который тащите с ёбаного реддита.