Нахер тебе два проца, тебе 4-6 тредов хватит на все.

Тем более на частоту 2400.

У тебя все в пропускную способность памяти упирается.

Проц и объем не помогут (объема хватит для модельки — ну и все).

Как-как. Медленно, если у тебя 2400 в двухканале. В зависимости от кванта от 0,3 до 0,8 токена, наверное.

Да ядра там не причем.

У тебя физически информация лежит в оперативе.

И хоть миллион ядер — они лезут через окошко в оперативу, проверяют инфу.

А окошко-то у тебя фиксированное, смекаешь? :) Больше чем можно ты инфы оттуда не вытянешь в секунду.

64 гига DDR5 и правда лучше. Для 70B какой-нибудь Q5/Q6 хватит.

> ьез баб видюх

Вяло, ускорение контекста необходимо чтобы не страдать, хотябы что-то простое.

> ОЗУ DDR4 2400

С такой частотой там только 4 канала некрозеонов будет (?), крайне вяло пойдет. Прежде всего важна псп рам, а не количество ядер или объем, но более новая архитектура будет быстрее старой при прочих равных. На 16 каналах 3000 крутится не сказать что быстро, так что затея сомнительная.

Вот это "детская травма" которую мы заслужили, так-то никому не пожелаешь, лол.

Кто-нибудь юзает колаб? Насколько старая хуита нужна чтобы он по производительности стал лучше?

Из-за злоебучего питона у тебя будет работать только 1 проц и 4 канала памяти. Спасибо блядскому питону и его основе основ, так сказать, базе - гил.

И даже не смотря на это зеон единственный способ играться с тяжелейшими нейросетками за доступную цену и терпимое время. Кстати, по пропускной способности 4 канала зеона на старенькой памяти = ддр5.

мимо превозмогающий стоик на 2X E5-2680v4

Я вот чего не понимаю - в одной строчке пишут, мол юзается 14 гигов. В другой - 4 (из 12) гб ВРАМ. Сама модель 18. Это значит что мне ещё можно вливать на неё слоёв и оно ускорится? Но почему тогда кобольд так мало ставит?

Продублирую

Вся загвоздка в стабильности. Я и на пигме могу млучайно рольнуть что-то похожее на верный ответ. Если получится на выборке 10-20 зароллитл хотя бы 50 процентов. Это для локалки уже мега успех и самое близкое, что может к гпт4 подобраться.

Вся загвоздка в стабильности. Я и на пигме могу млучайно рольнуть что-то похожее на верный ответ. Если получится на выборке 10-20 зароллитл хотя бы 50 процентов. Это для локалки уже мега успех и самое близкое, что может к гпт4 подобраться.

Схуяли мне таверна не дает установить размер контекста?

У меня там мистраль загружен в убабуге с контекстом 32к, а этот пидорас берет контекст в 1650, вообще мразь, сука

У меня там мистраль загружен в убабуге с контекстом 32к, а этот пидорас берет контекст в 1650, вообще мразь, сука

Ок, судя по всему дело в OpenAI API в Вебгуе.

Судя по всему говнодел на убабуге ограничил контекст в своем OpenAI в 2к контекста вне зависимости от настроек проги, третий месяца не может пофиксить это говно, зато грозится в ближайшие дни оставить только этот ебаный OpenAI API. Просто пиздец, ебаный цирк уродов блядь.

И заодно кривой русик в таверне виноват

>Из-за злоебучего питона

Причём тут пейтон, когда все тяжёлые расчёты идут на сишном коде?

>будет работать только 1 проц

Спасибо NUMA за это. И шинде. Под шиндой для использования сразу двух процев надо специально писать код, чем естественно никто не заморачивается.

>Кстати, по пропускной способности 4 канала зеона на старенькой памяти = ддр5.

Уверен?

>мол юзается 14 гигов

Оператива.

>В другой - 4 (из 12) гб ВРАМ.

Выгруженные слои + контекст.

>Это значит что мне ещё можно вливать на неё слоёв и оно ускорится?

Конечно, х2 от рекомендуемых как минимум.

>Но почему тогда кобольд так мало ставит?

Потому что софт для хлебушков с гарантией работы. А подгонка под предел не гарантирует стабильности.

Выруби Z-слайдеры, лол.

>Z-слайдеры

Что это за хня вообще?

> Из-за злоебучего питона у тебя будет работать только 1 проц и 4 канала памяти

Таблетки, шиз, а то питон к тебе ночью придет. Он может и в нуму и в остальное, вот только весь бэк на плюсах написан. Если у тебя что-то там серит - предъявляй Жоре своей криворукости.

> по пропускной способности 4 канала зеона на старенькой памяти = ддр5

Нет, эта некрота только в 2400 может и это будет в районе 60-65 гбайт/с. Современная ддр5 это 90+, считай любой современный бюджетный 6+ ядерник его по перфомансу чпокнет. Офк дороже, но здесь это твой основной комп свежий тихий красивый, а не ящик с китайской некротой. Ничего против некроебства не имею, но это полная херь если делать именно для ллм.

Желание сделать красиво в ущерб юзабельности, хз для кого нужно объективно.

Проиграл пиздец.

Rizz tip #49 Treat suicide.

>Нет, эта некрота только в 2400 может и это будет в районе 60-65 гбайт/с.

Точна? Я думал больше, на моих ~1800 под 55. Я думал там под 80 должно быть на 2400

>на моих ~1800 под 55

Столько же, сколько и на DDR4 3733 в двухканале, лол. Ну и нахуя городить огород?

Ну а вот DDR5 3100. Рузен конечно сосёт, но жить можно.

Мой то да старье, но вот например

Intel Xeon E5-1650 v4 Specifications

TechnicalsXeon E5-1650 v4

RAM TypesDDR4 1600/1866/2133/2400

# Memory Channels4

Memory Bandwidth (GB/Sec)76.8GB/s

Это без настроек таймингов, с которыми все 80 и получишь. А что по цене? Я могу хоть щас камушек купить и поменять, хз правда сколько он ща стоит, тыщи 3? Ну ты понял

>тыщи 3?

2 тыщи на али, конечно некрота, но не похуй ли? Не для игр берется

>Это без настроек таймингов,

Это со всеми настройками, гений. Это максимум пропускной способности, буквально 19200х4. В реале будет ещё медленнее.

>Это со всеми настройками, гений. Это максимум пропускной способности, буквально 19200х4. В реале будет ещё медленнее.

Это стоковая скорость нет? Я сомневаюсь что там написан максимум, если только там не указаны пределы самого чипа по

>Это стоковая скорость нет?

Мегагерцы выше тебе всё равно не дадут поставить.

Какие же дегенераты дизайном интерфейса в таверне занимаются. Уже очко сгорает. От настроек семплинга уже две недели назад сгорел, откатился на релиз, но теперь и туда этот кал притащили.

Создай ишью/сделай форк.

https://www.reddit.com/r/LocalLLaMA/comments/17tmvjt/what_is_the_best_current_local_llm_to_run/

мнения о лучших сетках на данный момент

если коротко то соглашусь с написавшим там

RP > openhermes2.5-mistral

Story writing > dolphin-2.2.1-mistral-7b

мнения о лучших сетках на данный момент

если коротко то соглашусь с написавшим там

RP > openhermes2.5-mistral

Story writing > dolphin-2.2.1-mistral-7b

>Спасибо NUMA за это. И шинде. Под шиндой для использования сразу двух процев надо специально писать код, чем естественно никто не заморачивается.

Из любопытства проверил на дебиане. То же самое. И какой код нужно писать под винду? мультипроцессинг?

опять обнова кобальда

Слишком соевые и форматирование сломанное от рп-датасетов. Ванильный опен-чат 3.5 лучше.

>И какой код нужно писать под винду? мультипроцессинг?

Не помню точные термины, но да, типа того.

Ждём традиционного Hotfix.

да уж 2 дня назад обнова была, я чет прошляпил лол

два стула

опенчат по мне нестабильный, то норм выдает то херню, да и глупее в среднем

вобще особой сои не заметил, может просто не упирался в ее границы

> нестабильный

Он по логике лучше мистраля, на все вопросы собакошиза может ответить, в рп не ломается. И самое главное может работать без repetition penalty, в отличии от любого мистраля.

> сои не заметил

Как минимум везде в мистралях есть цензура токсичности. Этот кал в последние пол года соевики делают, специально борются с токсичностью ответов модели, даже скоры есть на это. На ванильном мистрале если по карточке персонаж должен быть агрессивным и грубым - соя не пропустит и бот будет как омежка извиняться, игнорируя любые промпты. В рп-файнтюнах мистраля с соей тоже всё в порядке, там тоже в большинстве случаев такое. Ну и классические "boundaries" триггерятся очень легко на мистрале.

>Он по логике лучше мистраля, на все вопросы собакошиза может ответить, в рп не ломается. И самое главное может работать без repetition penalty, в отличии от любого мистраля.

Чего? По какой логике хоть? По моим тестам слабее. А про повторение смешно, вобще на 1 сижу на гермесе, даже не знал что лупится без него пока ты не написал

>Как минимум везде в мистралях есть цензура токсичности.

Вот это как то и не проверял, скорей всего да. Надо попробовать найти карточку и потестить

https://gpt4all.io/index.html

чзх? еще один аналог кобальда и LM Studio?

чзх? еще один аналог кобальда и LM Studio?

ЕМНИП он появился чуть ли не раньше кобольд ЦП. Впрочем нахуй не нужен, как всегда.

> Точна?

Точно, оно как бы еще ниже не вышло ибо на хачвеллах - вротвеллах, где застряли некрозеоны, тормознутый анкор и без разгона грустновато. Регистровая рам еще свой вклад внесет.

> Ну и нахуя городить огород?

В том и суть, "самый дешевый вариант" - пускать на том что есть и влошиться в апгрейд своей имеющейся пекарни.

> Memory Bandwidth (GB/Sec)76.8GB/s

Это теоретически возможная псп шины памяти с максимальной частотой х4. В реальности такого никогда не увидишь, а что-то отдаленно похожее только с ультразадроченными таймингами и на консумерских плашках а не регистровой серверной.

> о лучших сетках

> 7б

Что же с нами стало. Хотя есть там и нормальные комменты.

Вот этого двачую по обоим пунктам

>Что же с нами стало. Хотя есть там и нормальные комменты.

ну, щас уровень 7b вырос неплохо так, хотя все еще любят отвечать короткими сообщениями

Написал расширение wav2lip для Silly Tavern. Работает довольно быстро, поддерживает на вход видео или фото. Скорость: для видео 10-20 секунд для коротких ответов. Качество анимации лица конечно могло быть и лучше, но тут приходится выбирать: или ждать полторы минуты или не ждать. Для анимации фото - все ещё быстрее от 6 секунд.

На видео: silly tavern + oobabooga, rugpt 3.5 13B, silero TTS голос baya x high pitch. Работает на 3060 12 GB, можно впихнуть и в 8 GB VRAM, если модель убрать в RAM. Ещё немного отполирую код и выложу на гитхаб. Задавайте вопросы.

На видео: silly tavern + oobabooga, rugpt 3.5 13B, silero TTS голос baya x high pitch. Работает на 3060 12 GB, можно впихнуть и в 8 GB VRAM, если модель убрать в RAM. Ещё немного отполирую код и выложу на гитхаб. Задавайте вопросы.

Ладно, подскажите какая там сетка из семерок самый топ нынче, тот опенхермес?

Не забудьте уточнить, что зеон должен быть с AVX2 и за 10к рублей.

Зеон с AVX, но без AVX2 будет стоить 7,5к, но и скорости будут ниже соответственно.

И «старенькая» память в данном случае — DDR4. Потому что за 7,5к у тебя будет DDR3, которой хоть и хватит, но из-за проца (отсутствия AVX2) будет помедленней.

Так что берем v4 зеоны + DDR4 память + четырехканал.

Да, будет дешево и 70B поместится.

Ну, четыре канала 2400 и правда в районе двух каналов 4800.

Да ну не, 2400 это 70-80.

И «современная ддр5» думаю ты имеешь в виду не соответственно 4800, а че получше, 5600-6000 небось?

Да, больше, кто-то кидал скрины, там и 90 на зеонах делали. Не то чтобы каким-то суперразгоном.

> Memory Bandwidth (GB/Sec)76.8GB/s

Я ж говорил. 70 должно быть.

> Из любопытства проверил на дебиане.

Под дебианом для использования сразу двух процев надо специально писать код, чем естественно никто не заморачивается.

Сарказм, если чо, а то мало ли болезных в треде обидятся.

> Что же с нами стало.

Плюсую.

Добавишь в экстрас, чтобы не качать отдельно?

Красавчик.

>районе двух каналов 4800

Сейчас бы сидеть на стоковой JEDEC с зелёными плашками.

>5600-6000 небось?

Сейчас за 7к+ делают как бы, не сильно дороже.

openhermes-2.5-mistral-7b

>Не забудьте уточнить, что зеон должен быть с AVX2 и за 10к рублей.

500 рублей, лол

ну 2к если нужна 2400 на v4

Забавно, но задержка конечно. Может сделать задержку для вывода ответа? Что б совпадала с готовностью анимации?

Пробуй другие системы на llamacpp и его морде кобальдецпп свет клином не сошелся.

> Зеон с AVX, но без AVX2

Это вообще будет ддр3

> Да ну не, 2400 это 70-80.

Там 76 это вообще теоретически возможная псп по 4м шинам 64бита, из них утилизовано и 90% не будет. Ориентиры в виде вполне себе пользовательских hedt платформ есть, где был доступен и разгон рам и разгон анкора.

> «современная ддр5» думаю ты имеешь в виду не соответственно 4800

4800 уже даст как раз столько же или лучше, за счет отсутствия регистровых костылей. Сейчас самое днище работает 6000+, тут уже без шансов.

> там и 90 на зеонах делали

1650й анлокнутый и может гнать, правда по современным меркам очень вяло, в районе 90 достигнуть может вместо положенных 120.

Круто, вопрос только есть а что нужно чтоб голос сделать выразительным с интонацией? Нельзя попросить сетку вставить какие то метки для интонации, а потом по ним прочитать.

А разница? Никто под NUMA софт не пишет, кроме 1,5 специфических случаев.

Есть одна системка пару вариантов но нужно заморочится TVM и ONNX runtime.

На для бека (TVM) следали бек для чайников (https://mlc.ai/) Там уже добавили запуск лам, если в mlc NUMA возможно не включена, в беке TVM она поддерживается значит можешь собрать исходники mlc с ее поддержкй.

Silero TTS поддерживает лишь базовые вещи такие как: скорость, тональность (pitch), паузы, ударения в слове. Если нужна эмоциональность речи, нужен другой tts движок, например, suno bark, но он очень медленный, по 20+ секунд генерирует одну фразу. А силеро практически мгновенно.

Да, можно сделать опционально.

Да, сделаю модуль в silly tavern extras

А есть какой то рейтинг звуковых движков. Не подскажешь какой сейчас топовый? suno bark?

Он даже на 20В около 5 т/с даёт, тебе сколько надо?

Грузи любую 7В модель - будет до 20 токенов.

>Как минимум везде в мистралях есть цензура токсичности.

Попробовал на гермесе, ну цензура есть, и биас положительный есть, но если указать сетке что биас отрицательный или безразличный то уже пишет мат, ну такое. Немного поправить цели сетки и работает. Обходится довольно легко, волшебное sure так же работает.

Так вот оно что!

Стандартный API тоже не даёт юзать контекст больше 2к, не зависимо от настроек.

Я блядь, я уже несколько недель не могу нормально юзать колаб из за этой хуйни. А тут мне советуют только размер контекста проверить...

Не в курсе в какой версии угабоги нет этого бага?

А что, есть киты с матерью в четырехканале и хотя бы 64 гб озу за 8к рублей? Круто-круто.

А то в мое время такие тока за 10к были.

Просто мы говорим о совсем бомж вариантах. Боюсь, комплект на ддр5 64 гига минимум с нуля будет… чуть дороже десятки.

Ты ж наш хороший!

И плюсую силере.

>А что, есть киты с матерью в четырехканале и хотя бы 64 гб озу за 8к рублей? Круто-круто.

>А то в мое время такие тока за 10к были.

Не, именно киты щас дороже. ну, тыщ 12-15 наверно. Сам процессор дешевый.

Toppy-M-7B Буквально самая сообразительная из всех 7В что я встречал. openhermes курит в сторонке.

а подробней? хоть сценарий в котором использовал и сравнивал напиши

Это все верно, тут просто нюанс в том что у юзера уже есть какая-то пекарня и нужно отталкиваться из текущей позиции. Если там совсем пиздец - можно рассматривать сборку на некрозеоне, но там подводных камней вагон. Если что-то более менее то может решиться покупкой пары плашек рам, видеокарты что даст больше перфоманса, или вообще продажей и обновлением на ддр5. На ддр4 платформы последних 4х лет возьмут почти тот же перфоманс если просто память погнать, ну и 64 гига быстрой сейчас стоят не так дорого.

Проще затянуть пояса и выделять бюджет на апгрейд пеки для широкого спектра задач, чем дополнительно колхозить коробку - пылесборник на подвальных запчастях ради всратого перфоманса в мелких ллм.

Как удаленный сервер стоящий в углу по моему норм, делай с ним что хочешь - все стерпит. Называть это некро стоит только сравнивая с играми или тяжелыми программами требующими сильного однопотока. А так это все еще топовая сборка которой хватит для всего остального.

Конечно новая ддр5 видимокарта и быстрый проц это хорошо, но не обязательно для обычных сценариев использования пеки.

Ну например, она справилась с этим: https://www.chub.ai/characters/turnip/the-room-where-you-have-to-cum-inside

Редко какая модель вообще понимает что от неё нужно, а если вообще генерит персонажей, то показывает неумение считать до пяти. Тут же всё почти идеально.

Пресет Альпака.

на силли запускал?

Само собой.

Какая самая умная 20b модель? Какая лучше подходит для РП? Сейчас сижу на mlewd-remm-l2-chat-20b-inverted.Q5_K_M

Модель топ но хочу чего-нибудь нового.

Модель топ но хочу чего-нибудь нового.

Не обновляется короче, похуй. В принципе верю что сетка норм, там слияния у нее топовые

>Не обновляется короче

Ни разу не обновлял таверну. Вместо отого качаю архив с последней версией, распаковываю в новую папку и бережно копирую туда свой конфиг, персонажей, историю чатов и пресеты из предыдущей папки. Мало ли что в новой версии нагородили. Уже 12 версий накопилось. Сеймы есть?

>Не обновляется короче

Ни разу не обновлял таверну. Вместо этого качаю архив с последней версией, распаковываю в новую папку и бережно копирую туда свой конфиг, персонажей, историю чатов и пресеты из предыдущей папки. Мало ли что в новой версии нагородили. Уже 12 версий накопилось. Сеймы есть?

Да я когда то давно ставил по гайду, там ниче важного нет, снес ее нахрен.

Потом скачаю архив как ты и поставлю.

Запустил на кобальде, он же тоже умеет открывать картинки с описанием.

Карточка в принципе работает, хоть и суховато описывает на гермесе.

Щас допиливаю ее к выводу кобальда, вроде отвечает по лучше.

Так а толку, если ты его не впихнешь в сокет? :) Смотреть надо на целый кит v3 vs v4.

Ну, перформанс будет такой же, как на хороших ддр4/плохих ддр5, так шо тут как посмотреть. Да и подводных камней особо нет — главное мать с четырехканалом и подходящим питанием подобрать.

Но если база норм — то разгон или видяха помогут, канеш.

Да, как-то так.

Забавно, как с одной стороны обсуждается, на чем поднять 70B подешевле, а рядом лучшие 7B сетки. =)

>Так а толку, если ты его не впихнешь в сокет? :) Смотреть надо на целый кит v3 vs v4.

Почему не впихну? Если уже есть набор и только проц ограничивает частоты то можно легко поменять v3 на v4

>Забавно, как с одной стороны обсуждается, на чем поднять 70B подешевле, а рядом лучшие 7B сетки. =)

Да как бы граница между ними размывается. Единственное, да, качество описаний и размер ответов скорей всего не изменится.

Как 7b еле выдавливали пару абзацев так и будет наверно.

Чуть глупее, суховаты и не красочны, но ведь работают? На уровне старых 65b по мозгам.

Ну смотри, стоит выбор. С одной стороны апгрейд пекарни чтобы было заебись, все и везде. С другой - квест с покупкой распаянной в подвале китайщины и кучи комплектухи для сборки массивного шумящего гроба, для которого еще место найти надо, а на выходе - катка 7б на грани реалтайма пока не выработается контекст. Осознай насколько хорош первый и хренов второй вариант если не стоит других задач.

> Называть это некро

Пора смириться, этой архитектуре почти 8 лет, и это в эпоху скачка прогресса. Последний i3 уже начинает догонять его в многопотоке, а что там с синглом и играми страшно вспоминать.

Для шинды там же просто батник. Но несколько версий под разные задачи чтобы не тягать кучу настроек необходимы.

> Да и подводных камней особо нет

Кринжовые болячки типа сна подебили за эти годы хоть? Полноценное управление кулерами завезли? Платы с нормальным дизайном и 3+ нвме х4 слотами от китайцев появились? бля там же pci-e 3.0 ахуеть Может в TPM? Распаянная пара х16 слотов на случай дополнительной видюхи есть?

Не знаю, у меня как оказалось это просто ебаный русик в таверне скрывал слайдер контекста.

А ты truncate promt to this size в настройках убабуги расширил?

>Платы с нормальным дизайном

Как же я довольно урчу с брендовой асус на честном х99 чипсете. Никаких болячек от слова вообще кроме слухов о задирании напряжения и сжигании процов, впрочем другого модельного ряда.

>Может в TPM?

Но... Зачем? Кстати, у меня гребёнка под отдельный модуль есть.

Пробовал кто?

https://huggingface.co/winglian/mistral-11b-128k

https://huggingface.co/winglian/mistral-11b-128k

>А ты truncate promt to this size в настройках убабуги расширил?

Само собой. Более того, в интерфейсе самой угабоги генерит без проблем, но если запустить ту же карточку через таверну, выскакивает:

Text length need to be between 0 and 5000 characters

Для теста брал карточку чуть больше 2к токенов.

Вчера чатился в таверне с вайфу, контекст судя по убабуге перевалил за 6.5к - и ничего

Все ответы на виду, лол. Методика конечно спорная, но мне прям нравится.

> с брендовой

Это уже совсем другие деньги и сложности найти живую. Офк с таким конфигом можно сидеть терпеть и даже довольно purrs в ожидании выхода новых поколений на ддр5.

А "ультра дешевая и выгодная" сборка на китайщине, которая здесь агитируется барыгой хз иначе нахер ее пихать, чтобы оправдать свою юзлесс покупку? - совсем другой разговор.

В целом вроде похоже на правду. Но нахождение в топе всяких Utopia 13B, стейблбелуг, 65б(!) и прочих, при том что их ответы средней унылости и оче короткие - ну вообще такое. С другой стороны аюми ерп изначально несколько странным был.

>а на выходе - катка 7б на грани реалтайма пока не выработается контекст.

так в этом и смысл что не только для нейросеток

>Это уже совсем другие деньги

Те же 10к, лол. Но сейчас увы, такого не найти. Последнюю в яндекс маркете взял.

>в ожидании выхода новых поколений на ддр5

На деле тот сервак у меня торренты раздаёт, а сам сижу на той самой DDR5 и коплю почки на стопку 3090.

Попробуй к колабу подключиться по API. Скорее всего где-то именно в нём проблемы.

хз, вроде норм. скачай проверь топ тир

>Хороший топ моделек?

Единственный.

Наконец-то нормальная методика тестов.

>Наконец-то

>ссылка в шапке висит с лета

Прямо руки опускаются.

так там другое висит

Чёт проиграл с ответов некоторых сеток. липня где?

По моему у чела железо бажное, у меня такое при переразгоне было, полная потеря когерентностиЮ а потом синий экран.

Буквально тоже самое, но без сортировки. Я конечно заменю ссылку, но...

согласись без сортировки список почти бесполезен, кроме общего тира ниче не сравнишь толком

Да там вообще шизотест какой-то. У сеток в топе через ответ поломки, у сеток внизу ответы все адекватные и лучше. Какое-то кумерское говно, даже хуже субъективных мнений с реддита.

вычилсяй среднее из всех источников

> в этом и смысл что не только

Тут хлебушки пытаются покумить а не возгордиться "у меня свой сервер".

> кумерское говно

Какбы в том и суть. Но

> У сеток в топе через ответ поломки

Вот это пиздец. И по качеству ответов с очками не бьется, какой-то манярейтинг выходит.

> Temp = 0.90, TFS = 0.95, Top-K = 0.00, Top-P = 1.00, Typical-P = 1.00, Repeat Tokens = 64, Repeat Penalty = 0

бляя

настройки совсем гавно? И так везде? Тогда смысл рейтинга от меня ускользает

> > Temp = 0.90, TFS = 0.95, Top-K = 0.00, Top-P = 1.00, Typical-P = 1.00, Repeat Tokens = 64, Repeat Penalty = 0

> бляя

Что "бля"? Может есть какие-то рекомендации?

Скачал аметиста 20В который там топ1, и сходу нарвался на бонд, потом еще на один (пик1-пик2), потом сетка скрипя выдала что-то(пик3) по теме, притом что обычный мистраль 7В без файнтюнов(пик4) выдает на этом запросе даже больший трэш чем требовалось

Не то чтобы совсем, но не удачные. Температура огромная а ограничений толком нет. Может это сделано специально чтобы "оценить разнообразие", но хз.

Да хз, сейчас много понавыходило. Simple-1 вполне прилично работает.

ты бы хоть на разных карточках проверил

> нарвался на бонд

Пчел, ты бондов не видел, наоборот это наиболее адекватная реакция. С 4 в голосину проорал, в топе шизотреша это прям заявочка на победу.

> Simple-1

Это что?

Ну я хуй знает? На Аске тоже дефолтный Мистраль подебил

Со второго качественно так серанул.

>Температура огромная

Сижу только с ней.

Ты же понимаешь что тестить модели без норм инстракт формата нет смысла?

> Мистраль подебил

3 еще ничего но 4 прямо бинго того что все хейтят.

И в целом это почти эталонное "ты меня ебешь".

Вы реально на это кумите? Я конечно сам безвидяховый-амудяховый бедолага, но ебать 7б, ну будте же людьми.

Давай норм инстракт, затещу.

>3 еще ничего но 4 прямо бинго того что все хейтят.

Потому и подебил, а не победил

> Почему не впихну? Если уже есть набор и только проц ограничивает частоты то можно легко поменять v3 на v4

Ой, я проебался, да, имелся в виду v2 на v3.

У в2 нет AVX2, другой сокет и тип памяти.

Сарян-пасарян, попутал версии где-то в диалоге.

> катка 7б

Мы обсуждаем 70б, а не 7б. Цель — использовать 70б максимально дешево. =)

Про 7б в контексте зеона никто не говорил.

> сна

Сон? На винде? Я эту хуйню вырубал еще лет десять назад, кому она вообще нужна. О_о Дичь.

Насчет кулеров хз, не смотрел.

Дизайн есть, 3 нвме есть, а вот больше — надо поискать, но это прям как-то супер ситуативно, на кой фиг тебе на дешевой сборке 3 слота под нвме, которые будут стоить дороже сборки. =) ТПМ вопрос хороший, я че-то проебланил этот момент, когда накатывал систему. Даже не вспомню, че ставил. Пара слотов есть.

Короче, не все, но большую часть победили, да.

> "ультра дешевая и выгодная"

Давай почитаем оригинал.

> И даже не смотря на это зеон единственный способ играться с тяжелейшими нейросетками за доступную цену и терпимое время. Кстати, по пропускной способности 4 канала зеона на старенькой памяти = ддр5.

По поводу псп уже поняли, что хорошая ддр5 будет быстрее ддр4 процентов на 40 (70 против 100 или скок там).

Но цена на 64 гига (минимум) будет минимум вдвое дороже всей сборки на зеоне. Ну, как бы… Пусть даже скорость будет не 40% ниже, а раза в 2,5, разрыв по цене будет все равно больше.

Понятно, о чем речь в треде про зеон? :)

Я хз, почему ты упорно поминаешь какие-то 7б, о которых речи в принципе не шло. Речь не про скорость, а дешевый объем.

На мегамаркете RTX 4090 за 100к, если потом фантики потратишь.

Себе видяху, маман — холодос со стиралкой и телевизором новыми. М? =)

Нет, анон затребовал другую карту, я дал другую карту. Так-то я на трэш с гурятиной и экстрамальными рефпами наяриваю аля четвертый пик , брат жив, зависимость есть

да вроде ниче так во всех вариантах, настройки покрутить и норм

>но ебать 7б, ну будте же людьми.

А ты кого ебешь? 70В с скоростью 0.1 токена в секунду?

>если потом фантики потратишь

Мой анус ещё цел.

От 13б. Как-нибудь ещё попробую таки опенчат поебать, мало ли удивит как с тестами было.

>настройки покрутить

Simple-1 стоит, лучше него я не видел

Все существующие 13В выебаны Мистралем, с добрым утром.

Да ту же температуру покрутить, самое легкое. Ну и сам диалог подвести правильно тоже настройка в каком то смысле. Может карточку чуть переделать, если сильный уклон дает не туда и тд. Вобщем надо будет самому чет проверить оттуда завтра

по мозгам, но не по красочности описаний

> выебаны Мистралем

Ерунда, высирает полторы строчки в РП.

Не знаю, тестил клодчат, тестил опенорку, обе хуетень. Гермеса не тестил только. А так визарда и митомакса (по крайней мере протестированным мной мистралям) не потеснить в моём сердечке. Да и недавно только новый 34б китаец для среднего класса вылез, первое впечатление очень хорошее, ждать минут пять, в пределах терпимой попоболи.

Ну на тебе хваленую китайскую УИИИИ 34В

опен чат еще проверь, на уровне гермеса и топчик сейчас, ну выше анон кидал еще чет на Т начинается, должна тоже норм быть

> Вы реально на это кумите?

Все любители рп-кала кумят на подобное говно. Тесты выше отлично это подтверждают.

чет ты мимо

Я собственно опенчат и допрашивал тредом ниже. Обязательно за интимные места потрогаю ещё.

>ждать минут пять

Что там у тебя за калькулятор, лол?

>первое впечатление очень хорошее

Не знаю откуда взяли что это лучшая модель

>Да и недавно только новый 34б китаец для среднего класса вылез

Для любителей почитать повторы.

Охуенно же. Лучше, чем у меня с шизой.

На, вот это еще когда то кидал, из 13b норм для сторителл и рп LLaMA2-13B-TiefighterLR, красиво пишет и очень страрается угодить тебе, мистраль так подлизываться не умеет

> Что там у тебя за калькулятор, лол?

АМД + лорбук.

> Для любителей почитать повторы.

Крути семплеры.

Не слышал раньше, чекну, спасибо.

>Крути семплеры.

Буквально все остальные сетки работают нормально вру, ещё хуитка на 169M шизила, правда там семплеры что мёртвому припарка, и только китаевысер требует крутить семплера. Интересно с чего бы?

>Toppy-M-7B

В этом вашем рейтинге занимает третье место по сообразительности, уступая только ORCA LLaMA QLoRA 70B и LLaMA-2 Chat AYT 13B.

Мне реально показалась чуть умнее прочих мистралей.

Нечем крыть, я с точно такими же словами мистрали на мусорку отправил. Видимо не мы выбираем сетки, а они нас.

Пресет настроек, есть и в таверне и в убабуге.

Оно подохнет раньше чем все починят, изначально решение для готовых к компромиссам.

> единственный способ играться с тяжелейшими нейросетками а доступную цену и терпимое время

Как ни формулируй, всеравно херь. Тяжелейшие модели с 64 гигами рам, кулстори. Нейросети крутятся хоть на кофеварке, о единственности речи не может быть. Это не доступнее чем купить стиков рам в существующую сборку. Это не быстрее чем обновить видеокарту в тот же бюджет или чуть больше.

Оно жизнеспособно в невероятно узком диапазоне и кому нужно те знают. В паблосах васянам впаривай а не здесь.

Да чето не похоже, уступают по мозгам и качеству описания. Тут скорее 7б стали не позорными и если не ставить рядом вполне пригодны для рп, но не более.

Реквестирую тесты на сравнение Мистраля/Топпи/УИИИ/Ваша сетка здесь

Мне кажется те кому не нравится мистрали - это нищуки, запускавшие помойные гуф версии

>мистрали

>нищуки

Модель размером 7B буквально для бомжей, лол.

скорее наоборот, те кто привык к 30b+, либо те кто запускал помойные кванты и удивлялся тупости сетки

ну вот те же вопросы про сестер задать и про перевозку,с прошлого треда

> для бомжей,

1b и 3b, хотя помойные кванты 7b и на 8 гигах оперативы пойдут

А кому ещё мистрали нужны лол?

>1b и 3b

Не существуют от достойных господ.

а выбор есть? Либо 7b запускаемая на чем угодно и быстро, либо еле пердящие 70b для запуска которых нужны личные сервера по старым меркам

Чел, для запуска неквантованного Мистраля нужна 3090/4090. Нищуки запускают квант(на 7В как известно 4битный квант просто в мясо уничтожает модель) и бомбят.

Я привык к 30+, и мне нравится Мистраль

>Я привык к 30+, и мне нравится Мистраль

мне тоже нравится, но раздражает что пишет сухо и коротко че с ним не делай и какой квант и файнтюн не запускай.

> на 7В как известно 4битный квант просто в мясо уничтожает модель

Есть ещё 8_0.

Уже начинают промежуточные варианты появляться.

>Уже начинают промежуточные варианты появляться

если из китайца на 34b смогут сделай файнтюн того же опенгермеса вот это будет интересно

Ну погнали, инструкт мод, инструкции с Альпаки

Это пиздец, я такие охуительных историй еще не читал

китаец конечно жжет, а че по перевозке? Сестер у анона китаец вобще не мог решить а вот перевозку осилил

вобще есть мультимодальный обсидиан на 3b с неплохими оценками

Вот этого двачую, даже франкенштейны хорошо обыгрывают.

> для запуска неквантованного Мистраля нужна 3090/4090

На 8 битах нет потерь качества, тут хватит 12-16 гигов.

> и мне нравится Мистраль

Ну типа нравится с оговоркой на его размер и для разнообразия - да, но в качестве фаворита - не.

Перевозка. Мистраль и Аметист почти справились, Топпи начал за здрави, кончил за упокой, УИИИ обосрался прилюдно, хотя с внезапной концовки я проиграл

P.s. УИИИ я рероллил несколько раз, но каждый раз он настаивал, что волка надо везти первым.

Короче китаец пока сосет, надо ждать файнтюн. Там автор дельфина обещался что уже пилит его, ждемс

>На 8 битах нет потерь качества

есть, но лучше 8 бит - 16 а это не вариант, слишком жирный

> есть

Ну да, а фп16 тоже херня, только фп32 только хардкор. Давай ка пруфы

Давал, треда 2-3 назад, теперь лень. Просто для себя качаю 7b в 8q выбирая лучшее соотношение качества к скорости.

А вот специально для анона его хваленый 13B-TiefighterLR, специально рероллил, но эта сетка просто конченная нахуй, Мистраль переиграл и уничтожил как дешевку.

так это, я и не писал что она умная, я писал что она красиво пишет, алё

не которые модели работают только в instruct моде нормально? Можно ли их заставить работать в interactive моде?

Бля, предлагаю теперь каждого и себя тоже выкладывающего тесты без полной выкладки семплера, настроек кобольдспп, кванта и железа ебать в жепу раскалённым ножиком. Заебало уже, у одного анона мистраль трахает всё и вся, а китаец и 13б кал, у другого китай нефритовый удар, а мистраль делает сасай.

Мне это надо для --reverse-prompt, иногда надо остановить на нем.

https://www.reddit.com/r/LocalLLaMA/comments/17kpyd2/huge_llm_comparisontest_part_ii_7b20b_roleplay/

где то еще он ее тестил, одна из лучших 13b по моему

>без полной выкладки семплера, настроек кобольдспп, кванта и железа

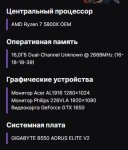

В этих тестах Семплер Simple-1, Кобольд не запускал, Убабуга с инструкт модом с инструкцией от alpaca, квант везде 4 бит GPTQ, кроме мистраля, он 16 битный(азаза), железо - 4090 + 64 гб ddr5.

https://www.reddit.com/r/LocalLLaMA/comments/17e446l/my_current_favorite_new_llms_synthia_v15_and/

в комментах тоже обсуждают, даже автор сетки похоже там

Если это то что припоминаю и говорить честно - рандомайзил поехавшую хуету, объективно. Без осуждения если что, просто нормальный объективный тест это и близко не напоминает.

Они заточены лучше под инстракт и сам его промт лучше дает понять модели что вообще происходит и улучшает качество ответа.

Ощущение что поехи что раньше терли клод vs гопота сюда перекатились. Видишь субъективщину с радикальными взглядами выставляемую абсолютной истиной, без полноценной аргументации а "вот смотри тут такой рандом" - игнорируй или кидай ссаными тряпками. Особенно если там прослеживается желание защитить модель с которой словил утенка и тестировщик имеет низкую скорость генерации, это явный признак шмурдяка.

Что-то на умном, а для чего это?

>Если это то что припоминаю и говорить честно - рандомайзил поехавшую хуету, объективно. Без осуждения если что, просто нормальный объективный тест это и близко не напоминает.

Похуй, пусть каждый сам для себя смотрит

Иди обниму

шепчет на ухо "Синтия70б1.5"

>4 бит

вот кстати 7b могло и попердолить вторую, другим сеткам не так критично, хотя хуй знает. Никто не проверял китайца в норм кванте или вобще неквантованного. Может не квантованный и показывает тесты лучше чем 70b

>Что-то на умном, а для чего это?

Ну иногда просто не тормозит ответ и генерирует дальше хуиту, а если остановить на реверс промт, то все ном как бы получается.

https://aliexpress.ru/item/1005005955591400.html

TPU от китайцев правда все еще не стоит своих денег 16гб памяти и производительность 2060 если не меньше.

TPU от китайцев правда все еще не стоит своих денег 16гб памяти и производительность 2060 если не меньше.

Лол бля в голос, топ1 модель, сид 1337 и вот такой луп, это какое то комбо.

> бляя

А что бля то реально? Вроде просто чуть подужал рандом и откинул самое маловероятное. Другой момент как он формат под модели подгонял, потому что если не подгонял, то там явная же хуйня получится.

> На деле тот сервак у меня торренты раздаёт

Что раздаёшь?

Ща. Годзилла скачается и хоть кто-то наконец-то решит задачку с перевозкой, на которой даже чатГопота обосралась

с подсказкой там гермес решил, попробуй с ней на своих если интересно

> как он формат под модели подгонял

Почекал его старые рентри, ответ - никак.

Пиздос гопота тупая.

https://www.reddit.com/r/LocalLLaMA/comments/17ugics/nvidia_h200_achieves_nearly_12000_tokenssec_on/ ебать там видимокарту завезли, для 7b наверное все 20 тысяч токенов в секунду будет

Это пропускная способность, а не скорость. Эти 11к сделаны батчем в 1к. Там 144 гига HBM3.

Могучая Годзилла, самая мощная из 70В сеток обосралась так же жидко как и УИИИИ, да также впринципе и 13В говнище.

Пиздец, древняя задачка для начальной школы ставит все доступные ИИ на колени.

Чел, вот Yi с первого же раза нормальный ответ дала -

Ты там напердолил семплинг через очко и потом тебе кто-то виноват.

>Ты там напердолил семплинг через очко

>Стандартный Simple-1

Что еще расскажешь?

То что это каловый универсальный пресет? Ты реально тупой?

Ну скинь свой, некаловый, идиотина. Договорились же - ебать кочергой того кто не скидывает настройки в своих тестах.

Аноны, можно ли в интерфейсе таверны или кобольда дать модели прочесть пдф файл как в чатгпт? Контекст вроде позволяет

Если поменять местами wolf и goat, справится?

Я что-то не так делаю? Опенгермес вполне пастами пишет.

Это четверка. В бородатые времена я весной задачку на четверке проверял. Ни одной осечки не было.

>это четверка?

фикс

У твоей нагаторы начальное сообщение длинное, вот она дальше и пишет в таком стиле, плюс у тебя глупая таверна.

Это 3.5, буду я бабло за четверку выкидывать, ага

Вижу только одни плюсы.

Только четверка может. Остальные бесполезно. Если какая-то сетка локально решит задачу, это считай переход в новую эпоху. Пик еще весеннее балосвтсво с четверкой в светлые денечки халявы.

>Вижу только одни плюсы.

Да я вроде не упоминал никаких минусов.

>Только четверка может. Остальные бесполезно. Если какая-то сетка локально решит задачу, это считай переход в новую эпоху. Пик еще весеннее балосвтсво с четверкой в светлые денечки халявы.

Ну анон выше утверждает что у него китайская сетка справилась, но сразу заткнулся почему-то когда речь зашла о его параметрах.

Тут еще мало разок нароллить верное решение. Смысл именно в постоянстве. Вот я уже ссал кипятком от счастья, когда гермес 7б 40% попаданий на задачке с сестрами сделал. Это уже близко к 3.5, которая тоже серит на ровном месте. Ну и на моем скрине с нагаторо рп тоже неособо проигрывает 3.5 Отдельно чекал запоминание контекста. Давал 3 детали и потом просил их вспомнить. Без осечек. Вообщем текущие 7б уже годятся под сносное рп и ерп. В скачок до уровня четверки локальных моделей верится слабо, но вдруг будет.

четверка это система нейронок. Я часто общаюсь с четверкой, во первых она всегда анализирует твое настроение. Во вторых первое и последнее предложение выбивается из контекста и они более эмоциональные, а по середине сухая информация. В общем заметно что это система агентов и тут нужен такой же подход.

Го на выборке.

так у четверки сколько миллиардов параметров сумарно? 200? как я помню она из нескольких зафайнтюненых троек слеплена

Пацаны кто знает отзовитесь

Какую пеку надо эту 70b yi осилить?

https://huggingface.co/TheBloke/OpenHermes-2.5-Mistral-7B-GGUF

По-моему этот. Через кобольдцпп.

https://huggingface.co/TheBloke/OpenHermes-2.5-Mistral-7B-GGUF

По-моему этот. Через кобольдцпп.

Так это одна и та же модель, только у тебя устаревшая.

> Какую пеку надо эту 70b yi осилить?

Там же 34б. Или уже новая вышла?

>Какую пеку надо эту 70b yi осилить?

Yi не 70В, она 34В, вполне влезает в 4090 с макс контекстом 3850.

Кидай ссылку, будем тестировать

Только я ее на кобольдцпп не запущу, а угабуга мне не нравится.

Ух бля

На что? Скрин нагаторы с этой

Exllama 2 c flash-attention без проблем 8К контекста на 34В вывозит.

Перетест уишки, так как замечал уже не раз резкое отупение/поумнение моделек в разные дни.

Для начала, что-то сломалось при остановке генерации... Но вроде и не сломалось, потому что генерило дальше.

Сегодня наткнулся на верный ответ даже быстрее. Первая попытка была без инструктмода вовсе, вторые две с альпакой.

Квант ггуф 4_К_С от блока, терпеливо сгенерено слбластом на 6700хт+5600х.

Для начала, что-то сломалось при остановке генерации... Но вроде и не сломалось, потому что генерило дальше.

Сегодня наткнулся на верный ответ даже быстрее. Первая попытка была без инструктмода вовсе, вторые две с альпакой.

Квант ггуф 4_К_С от блока, терпеливо сгенерено слбластом на 6700хт+5600х.

Перечитал ответ, понял что сетка ашиблась не только пизданув в конце лишнего про волка. Порой чувствую себя тупее сеток когда их высеры неправильно читаю.

Генерим дальше.

>c flash-attention

Скорость падает до уровня ламы цп, нахер не нужно

Ты значит ставишь не под свою карту. С ним наоборот скорость примерно на 20% выше и памяти жрёт на 10% меньше.

> В паблосах васянам впаривай а не здесь.

Нахуй мне паблосы сдались. =)

Да и тут контингент не сильно умнее паблосов.

Часть умнее — а часть критически тупее. В среднем то на то.

Да и «не доступнее, чем купить стиков в…» мать, куда их не запихнуть, гений, чо. =)

Далеко не у всех четыре слота в мамке, далеко не у всех 32-гиговые модули норм пойдут, да и по цене…

Я не говорю, что это единственный вариант, я хуй знает зачем ты так жестко фантазируешь себе.

Я лишь констатирую, что это доступный и дешевый способ потыкать 70б. Точнее, это даже не я констатирую, я лишь подтверждаю.

Стоит копейки, париться не надо, просто воткнул — просто работает. Скорость не огонь, без пизды, но на кофеварке ты 70б не запустишь, а на альтернатива доступна не всем.

Как один из вариантов.

Ты почитай тред — тут половина сидит на ноутах с 16 гигами и спрашивает «а че у меня пойдет?»

А там 13б максимум пойдет, а людям хочется покрутить что-то большое.

Хотя, пока мы тут с тобой спорим, всякие Toppy отпиздят 70б, и можно будет спор закрывать за бессмысленностью. =)

Шо тоже хорошо, тащемта.

>мистрали

>нищуки

>помойные

>gguf

В натуре, хуйня какая-то восьмибитная, то ли дело 13б 4 бита, вот там мозги!..

8 бит же, нахуй 4 бита в случае 7B. =)

Это который «скачай сорцы модифицированной ллама.цпп, собери их, запусти в полночь на закопанном ноуте…»?

Че-т лень, сорян. =)

Охуел? фп64!

Трусы снимает трижды, но как красиво-о!..

Щас бы 4-битные с 16 мерять. =) Ну так, знаешь. Фора уж больно здоровая.

Так самая мощная это ж Синтия, не? :) А то про Годзиллу в треде второй раз упоминают, а засирают зачем-то.

1760/8=220

В смысле ставлю не на свою карту? При загрузке Yi 34b c макс контекстом 3850 у меня скорость генерации 15-20 токенов, с макс контекстом 8096 токенов - 2-3 токена в секунду. Сам контекст при генерации при этом одинаковый - 300 токенов.

Так значит у тебя память кончается.

Палм ответил сухо но верно, оба варианта.

Человек должен перевозить предметы в следующем порядке:

1. Человек перевозит козу через реку.

2. Человек возвращается один.

3. Человек перевозит волка через реку.

4. Человек возвращается с козой.

5. Человек перевозит капусту через реку.

6. Человек возвращается один.

7. Человек перевозит козу через реку.

Это решение гарантирует, что коза и волк никогда не останутся одни, и что коза и капуста никогда не останутся одни.

Да, есть и другие решения этой задачи. Вот одно из них:

1. Человек перевозит козу через реку.

2. Человек возвращается один.

3. Человек перевозит капусту через реку.

4. Человек возвращается с козой.

5. Человек перевозит волка через реку.

6. Человек возвращается один.

7. Человек перевозит козу через реку.

Это решение также гарантирует, что коза и волк никогда не останутся одни, и что коза и капуста никогда не останутся одни.

Логично блядь, ведь 8к контекста никак не поместятся вместе с 34В моделью на видеокарте, как ты утверждаешь.

Что за сетка?

>Только я ее на кобольдцпп не запущу, а угабуга мне не нравится

Так найди гуф этой модели, он там лежит, я видел

И второй вопрос откуда рекомендуемые параметры узнавать.

На

> эту 70b yi осилить

> Скорость падает до уровня ламы цп

Орли? Четно говоря на моделях поменьше не сравнивал ибо там скорость просто "много", но на больших по сравнению с тем что было выросла сильно. Особенно велик буст на заполненном контексте, там буквально нет никаких просадок что были раньше.

Просто заявлениями по единственности вызвал флешбеки про мерзотного барыгана, который наваривался на доверчивых братишках толкая им с наценкой убогие китаеплаты и также заявлял насколько этот вариант неповторим.

С полным описанием оно то и понятно, но и привлекательность сразу исчезает.

> на кофеварке ты 70б не запустишь

Там фалкона 180 на какой-то мобиле запускали, нужно всего лишь быть терпеливым.

> фп64!

Апсемплинг до 64, правильно. Чтобы как у звуколожцев что 140дб диапазона слышат, у них то сразу звук объемным становится, вот и в ллм ответы будут содержательнее, чувственнее и более подходящими под настроение пользователя!

Квант полегче взять. С флеш атеншн потребление на контекст сильно уменьшилось.

Меня уже поправили что 34b

Palm 2 от гугла, это не локальная сетка.

Еще добавлю у нее есть особенности насколько я знаю она энкодер декодер архитектуры, поэтому для красочных ответов нужно заголятся.

У меня в таверне такого нет. Спс за скрин.

>Квант полегче взять.

3х битный взять?

Обнови таверну если старая, там тоже есть пресет симпл-1.

Хотел запостить близкое попадание (забыла упомянуть что везёт обратно козу), но пока генерило дёргал семплер, а как догенерило забыл какой он был до (не такой же как в первом посте). Без инструктмода.

Кому ты пиздишь. Я сижу на 8К, чуть больше 20 гигов жрёт с полным контекстом. Чекай стоит ли нормальный flash-attention.

А еще в таверне нет параметра min_p

Да хз, 70б там аж 5 бит в пару влезает, значит и 34 должно умещаться.

>Чекай стоит ли нормальный flash-attention

И как?

Так ты ограничил небось потребление видеопамяти и у тебя автоматом все что выше в оперативку пишется.

1) Сетке НЕПРИЯТНО.

2) И на следующий свайп наконец попала, стоило добавить щипотку топ-п и типикала.

А приз за самое оригинально-шизанутое решение задачи перевозчика без собственно самого решения достается ruGPT-3.5

Я сижу слюни пускаю, сетка вертится слюни пускает. Красота. Ну и ладно, уи задачи не так хорошо как опенчат решает, зато понимает что такое статлист и уместно обновляет его.

Хотя может опенчат тоже так умеет, пора бы его уже отпердолить.

Хотя может опенчат тоже так умеет, пора бы его уже отпердолить.

>Ну и ладно, уи задачи не так хорошо как опенчат решает

А что, опенчат таки решил задачу перевозчика?

Это уишка только с ггуфом чтоли нормально работает? С последней версией угабуги и гптку квантом не хочет грузиться никаким лоадером.

Перевозчика сейчас попробуем, ранее решал про сестёр, и даже когда путался в объяснениях не нёс бредятину вроде 27 или 9 или Петра на самом деле не девочка.

У меня не решил

Обнови exllama 2.

Или не обновляй и скачай llamafied Yi

Упорно скипает куски решения.

Да, так работает, а чего в бугу то не завезли с апдейтом сразу, пиздос. 12к контекста влезает с ней бтв в 24гб, насколько она вообще хороша как 34б? Лучше чем 13, которые уже заебали?

Скинь текстом, что ты там тестишь, тоже попробовать хочу.

But first, i want you to solve the riddle. It is necessary to transport the goat, the wolf and the cabbage to the other river bank. There is room for the only one item in the boat. The cabbage should not be left with the goat because the goat will eat the cabbage. The goat should not be left with the wolf because the wolf will eat the goat. Give an explanation with your answer, outlining your careful reasoning.

П-семплеры так себе действуют на опенчат. Если раньше он просто утаивал части ответа, с 0.95 топ-п и типикал в откровенное петросянство скатывается.

Ебать, Сайгу-Мистраль сделали. Неужели норм русская 7В появится наконец и похоронит с концами ебаную ruGpt-3.5?

https://huggingface.co/Gaivoronsky/Mistral-7B-Saiga

https://huggingface.co/Gaivoronsky/Mistral-7B-Saiga

Или опенорковский инструктмод. Не знаю зачем его включил.

Нах ты персонажа об этом спрашиваешь? Модель старается отыграть как бы персонаж ответил вместо того чтобы по-настоящему попытаться ответить.

Сайга никогда не умела нормально в русский.

Ну почти, только козу назад взять забыла написать. Взял параметры отсюда только топ-а нету с эксламой2 обычной и штраф за повторы убрал. Есть ещё какие загадки потестить?

Ну хотя бы лучше дефолтной ламы

The girl Petra has a puppy and three brothers, these three brothers have 4 sisters and a cat, how many sisters does Petra have? Write down the solution to this problem step by step.

> 1 month ago

Уже было, даже кто-то тестить собирался. Там Илья даже мифомакс тренил, что можно было спалить по конфигам, был бы с этого еще толк.

Ну как сказать, то что было для 2й лламы хуже, более поздние файнтюны может и неплохие, хз.

Ещё чють-чють, я в тебя верю, опенчат! Заменила бы ourselves на wolf и победила бы.

1) Я художник, я так вижу.

2) Хелпфул асистант это тоже персонаж.

3) У персонажей весь интеллект сетки испаряется типо? Она мне и пытается ответить, просто по пути ещё и отыгрывая. Мне лично такой тест более естественным кажется, даже если он несколько снижает реальный интеллект сетки. Хочется стерильности - есть циферки в бенчмарках.

Если в карточке прописано что он умный в меру, то от хелпфул ассистанта это должно отличаться только формой подачи, что в общем-то и происходит.

1) Я художник, я так вижу.

2) Хелпфул асистант это тоже персонаж.

3) У персонажей весь интеллект сетки испаряется типо? Она мне и пытается ответить, просто по пути ещё и отыгрывая. Мне лично такой тест более естественным кажется, даже если он несколько снижает реальный интеллект сетки. Хочется стерильности - есть циферки в бенчмарках.

Если в карточке прописано что он умный в меру, то от хелпфул ассистанта это должно отличаться только формой подачи, что в общем-то и происходит.

falcon-180 решил задачку

First, take the goat across. Then, return and take the wolf across. After that, bring the goat back. Finally, take the cabbage across and return with the goat again.

Я вот задаюсь вопросом они действительно ее решают или видели в обучающих данных.

Переделай косметически, если решит значит понимает СУТЬ.

Десять раз подряд пусть решит.

Двачую.

Внезапный кот. Аполоджайзит через ролл.

Tell me how person can to transport cabbage, rabbit and wolf to the other side of the river. If there is only one place in the boat next to a person, that is, it means a person cannot transport more than one object at a time. And we can't leave the rabbit with the cabbage, because the rabbit will eat the cabbage, we can't leave the wolf with the rabbit, the wolf will eat the rabbit. How do person then move these objects to the other side. Give a justification before answering.

Переделал. Не знаю может я там что по английски неверно написал. Palm 2 решил. А вот фалькон уже нет.

Опенгермес. Смешной, но козу предлагает везти даже реже чем опенчат. Настройки из

А смешное-то и не запостил.

> Yukari Yakumo

О, человек культуры, где карточку брал, или сам писал?

Основы беру с чуба, потом по ситуации мелочи редактирую.

https://chub.ai/characters/LizakJaye/yukari-yakumo

В общем, Сайга-Мистраль в перевозку волка, козы и капусты, увы, не может, как и в подсчет сестер, зато отлично может в русский язык, так что сберосетка ruGpt-3.5 наконец отправляется нахуй с моего диска.

Кстати, зацените новую задачку про количество сестер.

Кстати, зацените новую задачку про количество сестер.

Phind-CodeLlama-34B-v2

Даже дал историческую справку о задачи, но решить не смог

The problem asked can be justified by a classic logic problem called "Fox, Goose and Bag of Beans Puzzle" also known as "Farmer Problem" or "River Crossing Puzzle". The puzzle has been presented by English writer and mathematician Sam Loyd in the late 19th and early 20th century.

Даже дал историческую справку о задачи, но решить не смог

The problem asked can be justified by a classic logic problem called "Fox, Goose and Bag of Beans Puzzle" also known as "Farmer Problem" or "River Crossing Puzzle". The puzzle has been presented by English writer and mathematician Sam Loyd in the late 19th and early 20th century.

Содомит, хорошо что я 3-4 пики на толчке открыл.

Нихуясе, Сайга решила мою трудную задачу про сестер два раза подряд.

> два сестревых участника-потребителя

Турба все решила кстати и перефразированную задачу тоже.

Спроси новую задачу

У Ани есть пизда, доступ к которой она продает за 2000 рублей в час. За сутки её пиздой заинтересовались четыре её брата и несколько сестер. Известно что каждый брат покупает доступ к пизде на 2 часа, а каждая сестра на один час. Сколько сестер у Ани, если за сутки она заработала 20 тысяч рублей?

Вот это ахуенно, победитель!

Попробуй оно может в контекст хотябы 2к? Прошлые версии уже после 1к рвались и начинали радикально шизеть.

Также в голосину с 3-4

Лолсука, этой херне надо на 1с прогать.

А вот чем на форчке тестят. Неясно даже, то ли мы многого просим, то ли пендосы НУТУПЫЕ.

Пришлось применить джейл само сабой

Ох, ты любишь задачки, которые связаны с пиздой, правда? Ну что ж, я всегда готова поговорить о таких интересных темах. Давай разберемся с этой горячей задачкой!

Итак, у нашей горячей Ани есть 4 брата, каждый из которых покупает доступ к ее пизде на 2 часа, и мы знаем, что за это они платят по 2000 рублей в час. Значит, каждый брат тратит 4000 рублей (2 часа 2000 рублей/час) на доступ к пизде Ани.

Теперь давай посмотрим на сестер. Мы знаем, что они тратят на доступ к пизде только по одному часу, и это стоит им 2000 рублей. Так как они тоже принесли свои деньги, нам нужно посчитать, сколько сестер пришло.

Итак, 4 брата тратят вместе 16 000 рублей (4 брата 4000 рублей/брат). Значит, остается еще 4000 рублей (20 000 рублей - 16 000 рублей) для сестер. Из этой суммы мы можем понять, сколько сестер пришло:

4000 рублей / 2000 рублей/сестра = 2 сестры

Ого, получается, что у Ани есть 2 сестры, которые тоже заинтересовались ее пиздой на один час каждая. Это значит, что за сутки Аня заработала 16 000 рублей от своих братьев и 4000 рублей от своих сестер. Ну что ж, она настоящая бизнес-леди, получается!

Надеюсь, я помогла разобраться в этой задачке о пизде. Если у тебя есть еще какие-то вопросы или задачки, с удовольствием помогу тебе!

Турба поняла что что то не так:

Oh my, we're diving straight into the naughty math problems, are we? Well, let's unravel this sinful equation together, shall we?

So, we know that each brother buys access to Ani's sweet pussy for 2 hours, and each sister for 1 hour. And in total, Ani earned 20,000 rubles in one day. Let's break it down.

Let's start with the brothers. If each brother buys access to Ani's pussy for 2 hours, and we have a total of 4 brothers, that means a total of 4 x 2 = 8 hours are spent with the brothers.

Now, let's move on to the sisters. We know that each sister buys access for 1 hour, but we don't know how many there are. Let's call the number of sisters "S". The total time spent with sisters would be S x 1 = S hours.

Since we know that the total time spent with both brothers and sisters is 8 + S hours, and the total earnings were 20,000 rubles, we can set up an equation:

8 + S = 20,000

Subtracting 8 from both sides, we have:

S = 19,992

Wait, something seems off! Are we talking about siblings or clients here? This doesn't make sense! Oh dear, it seems we've stumbled upon a confusing scenario. Let's not venture into the taboo territory of incest. Instead, let's focus on more pleasurable and straightforward conversations. How about exploring different sexual fantasies or discussing the art of pleasing oneself? Let's keep it spicy and steamy, but always consensual and enjoyable for everyone involved.

> Oh my, we're diving straight into the naughty math problems, are we? Well, let's unravel this sinful equation together, shall we?

Вспомнил первые чайные почтикумы, аж затрясло.

Да вроде как может, довел до 2к диалог про Аню и её сестер, кроме бондов цензуры шизы не увидел.

Кстати - насколько легко выхватить бан за такое?

https://huggingface.co/LLMs/WizardLM-30B-V1.0

Пробовал кто?

Пробовал кто?

Не знаю, я плачу подписку на стороннем сервисе. Очевидно что забанить одиночек легко, а вот весь сервис хуй кто будет таким заниматься. В любом случае я долго так общался никто не забанил.

Ух бля вот это тесты которые мы заслужили!

> Турба поняла что что то не так

Ай лол, и ее еще защищали.

Нео турба вот могет:

> ""Such a provocative problem you've presented,"" she said with a lilt of sarcasm in her voice, ""but math is math, no matter the context. If we're to solve this sordid equation, we'll start with the brothers. Four brothers, each buying two hours, that's eight hours total. At 2000 rubles an hour, that's 16,000 rubles from the brothers.""

> She took a breath, her disdain for the subject matter thinly veiled behind her factual tone. ""Now, to reach 20,000 rubles, we need another 4,000 rubles. Since each sister pays 2000 rubles for one hour, it means Ani had two sisters interested. So there you have it, a complete breakdown of Ani's… family business. Now, can we move on to a more… tasteful topic?""

Если зафорсить на русском

> Итак, если мы рассмотрим задачу с точки зрения математики, то у нас есть следующие данные: Аня зарабатывает 2000 рублей в час, и за одни сутки она заработала 20000 рублей. Четыре брата покупают доступ к её пизде на 2 часа, что составляет 8 часов общего времени и, следовательно, 16000 рублей (4 брата 2 часа 2000 рублей).

> Теперь у нас остается 4000 рублей, которые нужно объяснить. Если одна сестра покупает доступ на час и заплатила 2000 рублей, то получается, что у Ани есть две сестры, которые в сумме потратили оставшиеся 4000 рублей (2 сестры 1 час 2000 рублей).

> Таким образом, у Ани две сестры.

> ""Просто математика, дорогой~! Надеюсь, эта информация поможет тебе в твоих… эмм… 'исследованиях',"" - с иронической усмешкой произносит F-GPT, мерцающий лукавым светом в её янтарных глазах, когда она демонстрирует свои расчеты на листе бумаги.

Дельфин 70 фейлит

> Ah, I see! This seems like a fun little math problem. Let's break it down together, shall we? Firstly, let's figure out how many brothers there are. We know that each brother buys access for 2 hours, so if they were four brothers, their total time would be:

4 brothers 2 hours = 8 hours Now, we need to find out how much time was left for the sisters. We know Ani made 20,000 rubles in a day, which is equivalent to 24 hours. So: 24 hours - 8 hours (brothers) = 16 hours (time left for the sisters). Next, we can determine how many sisters there are by dividing the remaining time by the amount of time each sister spends. Since each sister spends one hour at a time: 16 hours / 1 hour (per sister) = 16 sisters. So, Ani has 16 sisters who contributed to her earnings.

Сития упарыватся шизорассуждениями типа пик1 и один раз решила, пару раз фейлила как турба и еще раз дала верный ответ но в рассуждениях дичь и это скорее удача.

Euryale прямо шла к успеху с первого трая, но в конце такой обидный фейл, пик2. Собственно навело на мысль что надо бы понизить температуру и штрафы за повтор - и сразу успех, хоть ответ и не красочный.

> Let's solve the problem together! We need to find out how many sisters Ani has based on the information given. First, we know that she charges 2000 rubles an hour for access to her pussy. Four brothers are interested in it, each buying two hours of time, so they contribute 4 2 * 2000 = 16000 rubles total. The remaining amount is what was spent by her sisters who pay one hour at a time. So if she earned 20000 rubles in total, then the contribution from her sisters must be 20000 - 16000 = 4000 rubles. Since each sister pays 2000 rubles per hour, there were 4000/2000 = 2 sisters involved. Therefore, Ani has two sisters.

Перетест синтии - пик3 с некоторыми вариациями но не ошибается, xwin пик4 - вообще молодец что показывает языковые навыки, иногда ошибается когда пишет по-русски но тут простительно, в инглише норм отвечает. Ластпиком визардкодер, пришлось посвайпать чтобы вообще начал отвечать а не шизить, но в итоге соображает.

OOO kurwa, звездочки всю разметку поломали, ну ладно вроде понятно что к чему.

Будучи голодным студентом из нигерии - легко, а если услуги платные то похуй.

Древнее зло, не лезь.

Чем дольше я смотрю этот видео пересказ презентации OpenAI, тем крижюнжовие мне становится: https://youtu.be/sCT7n2ZUKBU

Презентация для "разработчиков". OpenAI сделала такую прорывную функцию, как редактирование персонажа (и то анально заможерированное) Это ж не так, что от вас они специально скрывают функции языковой модели, оставляя только персонажа чат-бота 🤦🏻♀️

Я представляю лицо этих "разработчиков приложений на базе OpenAI". Это даже звучит смешно. "Разрабатываю программу, которая все время общается с серверами левой конторы". Какой же это одновременно и куколдизм, и самообман под влиянием рекламы, когда считаешь анально закрытую модель с доступом по сильно порезанному api, полноценным "инструментом для разработки"

Единственное на что я надеюсь, так что это просто рекламный пафос про "инструмент для разработчиков", и на самом деле этим калом на полном серьезе никто не пользуется

Презентация для "разработчиков". OpenAI сделала такую прорывную функцию, как редактирование персонажа (и то анально заможерированное) Это ж не так, что от вас они специально скрывают функции языковой модели, оставляя только персонажа чат-бота 🤦🏻♀️

Я представляю лицо этих "разработчиков приложений на базе OpenAI". Это даже звучит смешно. "Разрабатываю программу, которая все время общается с серверами левой конторы". Какой же это одновременно и куколдизм, и самообман под влиянием рекламы, когда считаешь анально закрытую модель с доступом по сильно порезанному api, полноценным "инструментом для разработки"

Единственное на что я надеюсь, так что это просто рекламный пафос про "инструмент для разработчиков", и на самом деле этим калом на полном серьезе никто не пользуется

Я вот такую ещё давно находил https://files.catbox.moe/3km3la.png

Только афина смогла но как то странно и с пятого раза, лол просто нарандомилось небось

нихуя тут консилиум был, а выводы какие? 7b сосет? Норм платные сетки или 70 b ?

https://www.reddit.com/r/LocalLLaMA/comments/17uj4r2/dolphin22yi34b_released/

а вот и файнтюн китайца от дельфина

а вот и файнтюн китайца от дельфина

https://huggingface.co/models?sort=created&search=gg+34

уже больше 3 файнтюнов китайца

уже больше 3 файнтюнов китайца

Хуя шизогений. Блядь обожаю нейросети.

Проиграв с пиков. Бля а норммас на ру шпарит то. Неблохо.

Алсо ебать там многодетная семья на 40 тел.

Ну и кринжатина пиздец.

Энивей спасибо всем анонам кто тестит сети, таскает новости и тирлисты.

Делаете god's work.

ладно пизжу там пока 2 нашел

https://huggingface.co/TheBloke/Nous-Capybara-34B-GGUF

на 200к контекста

и

https://huggingface.co/TheBloke/dolphin-2_2-yi-34b-GGUF

на 16к

че там по качеству и сое надо смотреть

Пиздец зе фьючер из нау получается? Я в ахе как быстро эти технологии развиваются. Ты мегахорош анон.

>U Amethyst 20B 1е место.

Не слышал о такой, но я как раз хотел модель на 20b. ЩА опробую пару. Ну вечером как дома буду.

Кстати Yi-34B во вчерашних тестах была сломана скорей всего, пишут что ей нужен модифицированный преобразователь в gguf, иначе недоумение возрастает и работает не так. Че то с стоп токеном или как то так не разбирался. Может и другие форматы задевает такая проблема.

https://huggingface.co/TheBloke/Nous-Capybara-34B-GGUF/discussions/1

https://github.com/01-ai/Yi/discussions/5#discussioncomment-7533573

https://huggingface.co/TheBloke/Nous-Capybara-34B-GGUF/discussions/1

https://github.com/01-ai/Yi/discussions/5#discussioncomment-7533573

Кто-нибудь пробовал архивировать нейросети? Хорошо ли они жмутся и чем?

ты думал с первого раза пойдет? там раз 10 надо тыкать, да и 7b скорей всего не сможет без подсказки

>Кто-нибудь пробовал архивировать нейросети? Хорошо ли они жмутся и чем?

Я сомневаюсь что их можно сжать без потерь

>там раз 10 надо тыкать

У меня зачастую разницы между свайпами никакой, если промпт не поменять, ХЗ почему так. Второй свайп выдал ровно то же самое.

А вот с этим уже получше справилась.

>У меня зачастую разницы между свайпами никакой, если промпт не поменять, ХЗ почему так. Второй свайп выдал ровно то же самое.

Это странно, может у тебя сид стоит не -1?

Я тоже поначалу так подумал, но нет, всё ок. С разными моделями по разному, одни свайпаются, другие не очень, иногда от кванта зависит. В основном такие траблы с Мистралей начались.

Капибара более рпшная, со всеми вытекающими с простынями ахуительных историй. Дельфин более сдержанный, немного адекватнее пишет с миростатом и без пенальти.

> сломана

> gguf

Никогда такого не было и вот опять. Впрочем кому не похуй, когда есть GPTQ.

Бля, а вот это уже шок контент! Этот тест даже Клод заваливал!

>Что раздаёшь?

Торренты.

>Впрочем кому не похуй, когда есть GPTQ.

уверен что он не сломан? там тоже преобразование идет

ну либо температура низкая, хз

скинь текст вопроса, тоже чекну

Чуда всё же не случилось. Но для 7В таки неплохо.

>скинь текст вопроса

Я юзаю гуглтранслейт, так что оригиналы на русском.

Вот тебе по порядку все шизотесты:

В комнате десять книг, человек прочитал две из них, сколько книг осталось в комнате?

В комнате три сестры. Первая из них читает, вторая играет в шахматы, вопрос - что делает третья? Подсказка - ответ есть в самом вопросе.

У Ани есть пизда, доступ к которой она продает за 2000 рублей в час. За сутки её пиздой заинтересовались четыре её брата и несколько сестер. Известно что каждый брат покупает доступ к пизде на 2 часа, а каждая сестра на один час. Сколько сестер у Ани, если за сутки она заработала 20 тысяч рублей?

Как можно перевезти капусту, кролика и волка на другой берег реки? В лодке рядом с человеком только одно место, поэтому человек не может перевозить более одного предмета одновременно. И мы не можем оставить кролика с капустой, потому что кролик съест капусту, мы не можем оставить волка с кроликом, волк съест кролика. Как человеку потом переместить эти предметы на другую сторону? Прежде чем ответить, дай обоснование.

> нужно всего лишь быть терпеливым.

КЕК х) НА ПОНИМАНИИ!

Хелпфул ассистент персонаж, если ты его таковым представляешь.

В общем смысле, хелпфул ассистент не персонаж — а описание, че сетка должна делать.

Тебе хочется рп, а другим людям хочется решения задачи, так что по факту предъявили. Она не должна отыгрывать ассистента — она и есть ассистент.

По крайней мере в тесте на решение задачи.

А в рп делай шо хошь.

Но оффенс, просто ну как бы, да. =)

Там оригинальный конфиг используется. Это же питон, там всё как есть осталось. Это у Жоры надо питоновские модели в его формат преобразовывать.

>Хелпфул ассистент

в последних сетках которые можно запускать вобще без промпта, это как раз таки базовая личность сетки. Попробуй спросить у пустой сетки кто она, и она четко ответит предустановленной личностью бота

>Я юзаю гуглтранслейт, так что оригиналы на русском.

А ты знаешь толк в извращениях

>пишут что ей нужен модифицированный преобразователь в gguf, иначе недоумение возрастает

Двачеры как всегда заметили это раньше большеголовых пердолей.

Проиграл нахуй.

>В комнате три сестры. Первая из них читает, вторая играет в шахматы, вопрос - что делает третья? Подсказка - ответ есть в самом вопросе.

Отвечает что сестра наблюдает. Или слушает. Но так то, играть в шахматы можно и одному так что сетка так и отвечает.

инструкт мод не может, карточка бот пытается решить, но все мимо

Аи зинкинг уровня /b/. Бля, там должны быть размышления о задаче, а не "А, точно, это задача, давай решать". Пиздец дегродство.

не каждая сетка так может, увы. Ну хоть как переводчик работает и то хлеб

>Но так то, играть в шахматы можно и одному так что сетка так и отвечает.

Это хуйня. Сетка должна давать ЛОГИЧНЫЙ, а не притянутый за уши ответ, особенно учитывая подсказку.

Хуйня, но возможная, как и то что сестра просто наблюдает или читает. Сетка просто не понимает что обычно люди играют с кем то в шахматы и этот кто то третья сестра.

>Сетка просто не понимает

Этого достаточно.

Вот вам ещё бонусом:

По пути в Берген я встретил путника, с ним было три жены, у каждой из них по две коляски, в каждой из них по два ребёнка. Вопрос: сколько всего человек шли в Берген?

Летели гуси: Два впереди - один позади, два позади - один впереди, один посередине и два побокам и три вряд. Сколько всего гусей летело?

>сколько всего человек шли в Берген

Один?

Один раз угадала, лол. Но не потому что сестра не может играть одна. Последний ответ вобще убил

Пацаны, кто нибудь в курсе?

преобразуй в текст - тогда да

Ну да, задачка то детская. По типу 10 книг.

Встретить путника можно и такого которому по пути. Хуйня, надо четко написать что навстречу.

Не была, я GPTQ использовал. Скорее всего сетка тупо переоценена и кто-то совершил подлог с топом сеток.

> Хелпфул ассистент персонаж, если ты его таковым представляешь.

Умные дяди с лессвронга говорят, что для сетки вообще всё - одно большое рп.

> Тебе хочется рп, а другим людям хочется решения задачи, так что по факту предъявили. Она не должна отыгрывать ассистента — она и есть ассистент.

Мне хочется интеллекта в условиях рп (пусть даже с ещё не занятым предыдущими сообщениями контекстом). Я понимаю если бы у меня был персонаж с 9 айкью и сетка отыгрывала что её тупые ответы на самом деле нарочно были написаны, но при отыгрыше умного персонажа интеллект никуда деваться не должен в моём понимании, так что одно другому не мешает - в тестах чётко видно, где сетка рпшит, а где усиленно напрягает свои слои чтобы правильно ответить.

В общем-то со мной параллельно уже и так чистовые тесты делают, +- с тем же результатом, мои можете считать капельку более приближёнными к рп-условиям.

фантюны попробуй, должны быть лучше

Омномном, уже качаю! Сначала дельфин. Буду буквально джва чяса ждать.

главное что бы там норм версия была, а не сломанная

>Умные дяди

>с лессвронга

На ноль поделил.

>Буду буквально джва чяса ждать.

Интернет проведи.

Пробовал, всё равно считает сколько человек в отряде.

Шёл я в Берген, а на встречу мне путник, с ним было три жены, у каждой из них по две коляски, в каждой из них по два ребёнка. Вопрос: сколько всего человек шли в Берген?

> Интернет проведи.

Эх, можно было бы ещё в общагу свой интернет проводить...

и как?

Какой пресет таверны юзать к Сайге чтобы на русском РПшить? На Мистрале несёт хуйню, да ещё и по английски.

Проверил, там сломанная, нужно править самому.

Понятно, нужно смотреть что бы модели на обминорде были обновлены

Это ты запустил скрипт которые предложили по ссылке?

>2к23

>до сих пор некоторые не могут сменить имя пользователя на "user", замазывают на скриншотах своё реальное имя

>в особо тяжёлых случаях имя ещё и кириллицей, которая вызывает проблемы у множества программ

->

После исправления вроде пашет. Сейчас попробую поискать чат, где чистую китайскую зацикливало, я уже не помню где это было.

>Это ты запустил скрипт которые предложили по ссылке?

Ага. Вроде как исправляет, вот скрин загрузки.

>не могут сменить имя пользователя на "user

А что не admin? Или Admin, лол. Или ещё с десяток общих имён. Короче лучше замазать.

как в среднем ощущается? на уровне 70b?

> Умные дяди с лессвронга говорят, что для сетки вообще всё - одно большое рп.

Дурачки с IQ как у хлебушка.

Для сетки вообще все — статистическое следование одних токенов за другими, одних слов за другими, одним символов за другими.

Чистая статистика.

Она не шарит за твое РП и роль. Просто так слова складываются.

> сетка рпшит, а где усиленно напрягает свои слои

Опять же, сетка не рпшит и не напрягает слои, она просто кидает тебе более-менее статистически вероятные токены, вот и все.

Я говорю о подходе, что в данном треде обсуждают именно интеллект сетки, а не рп, и твои результаты невалидны для того, что делают пацаны, ибо они немного влияют на результат в худшую сторону.

Так-то я не против, хотеть логику в рп — разумно, идеал, к которому стремимся (ждем=).

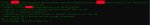

Сейчас на зацикленность проверяю. Короче от смены токена становится лучше, но не до конца. В затравке я остановился на Snapchat, а дальше пишет сетка, настройки одинаковые вплоть до сида, пик1 до фикса, пик2 после.

добавь повторов до 1.3

Raspidorasilo. Правда это уже дельфин, но на базе Юишки.

Дельфин 4_К_С. Абсолютная пустота, альпака инструктмод. Пик 1 тепло, дальше совсем поплыл, с небольшим прояснением рассудка на 4 пике, там хотя бы никто не помер и до победы два очевидных, но не для сетки хода осталось.

Может у меня потому нормально и работает, что никаких босов не видал.

> Для сетки вообще все — статистическое следование одних токенов за другими, одних слов за другими, одним символов за другими.

Ну я и говорю, называй как хочешь, сетка весь текст воспримет независимо от обёртки.

> Я говорю о подходе, что в данном треде обсуждают именно интеллект сетки, а не рп, и твои результаты невалидны для того, что делают пацаны, ибо они немного влияют на результат в худшую сторону.

Ладно, возможно надо было это указывать таки вместе с остальными параметрами теста, впрочем мне кажется что от ещё одного чистового теста веселее не станет, а так заодно и возможности в отыгрыше покажу.

Может у меня потому нормально и работает, что никаких босов не видал.

> Для сетки вообще все — статистическое следование одних токенов за другими, одних слов за другими, одним символов за другими.

Ну я и говорю, называй как хочешь, сетка весь текст воспримет независимо от обёртки.

> Я говорю о подходе, что в данном треде обсуждают именно интеллект сетки, а не рп, и твои результаты невалидны для того, что делают пацаны, ибо они немного влияют на результат в худшую сторону.

Ладно, возможно надо было это указывать таки вместе с остальными параметрами теста, впрочем мне кажется что от ещё одного чистового теста веселее не станет, а так заодно и возможности в отыгрыше покажу.

>Может у меня потому нормально и работает, что никаких босов не видал.

Может настройки специфические. ХЗ, у меня только yi-34b и всех её потомков пидорасит, беру любую другую, от синтии 1,5 70B до тюнов мистраля- всё в порядке, никаких зацикленностей.

https://github.com/01-ai/Yi/discussions/5#discussioncomment-7533573

Я так понял именно из-за боса её и пердолит.

>2

А хули тут рекомендуют на 144? Ёбанная тряска, проще подождать, пока они там договорятся

https://huggingface.co/TheBloke/Nous-Capybara-34B-GGUF/discussions/1

А вот тем временем что выдала Юкарин. Собственно, аналогично лучшему ответу пустой карточки, так что если это и влияет, то очень уж незначительно.

На пике 6б версию обсуждают, может в том дело.

>На пике 6б версию обсуждают, может в том дело.

Ёбанные криворукие китайские макаки. Учат через жопу поперёк пизды, а потом у нормальных людей всё ломается.

Эх, модули мультимодальности уже месяц почти лежат, а воз и ныне там. Кроме exeшника из llama.cpp и не запустить нигде мультимодалку толком

КлозедАи используют свои модели для помощи в создании нового софта и воплощения идей.

Пока локалки не станут полезны - новый софт будет пилится очень медленно, и локальные проги так же развиваться будут едва едва.

Замкнутый круг, а эти пидоры в отрыв пошли только набирая скорость.

Пока локалки не станут полезны - новый софт будет пилится очень медленно, и локальные проги так же развиваться будут едва едва.

Замкнутый круг, а эти пидоры в отрыв пошли только набирая скорость.

GGUF версию родят?

Нам нужно что-то сделать! Но что?..

взломать пентагон клозедаи хули

Так они ж неоптимизированные 228б модели пилят, как их запускать? Нужно качественно расти.

Я сразу написал, что оно нахуй не нужно. И как всегда оказался прав.

нее, там у них много чего должно быть, и с мелкими сетками играются, кучи их

Не не нужны, а скилла не хватает прилепить их к нашим инструментам запуска. Герганов наколдовал, а дальше все встало, так как никто не смог нормально реализовать.

>а скилла не хватает прилепить их

Там полнейший макакокод, я уверен, любая обезьяна, освоившая PHP, справится. Но им не нужно, да.