Добавил в вики инфу про новые кванты/матрицы влажности/Phi-3, но всем похуй.

Непонятен смысл данного файнтюна в таком размере. Почему 11В? 13 в любом случае ведь будет умнее. Чисто, чтоб больше влезло контекста во врам?

> 13 в любом случае ведь будет умнее

13б старые, там базовая модель может быть слабее чем эта 11б, но это не точно. А так легче обучать и использовать.

А есть что-нибудь 13б? Сейчас юзаю старую MLewd-ReMM-L2-Chat-20B.q5_K_M , первый раз попробовал еще на 3070, сейчас на 3090 пересел.

>13б старые

Всм, это на 3 ламе файнтюн?

Я тоже на млевде, наверное на данный момент чего-то принципиально более интересного для кума на второй ламе нету.

>13 в любом случае ведь будет умнее.

эээ нет, именно эта базовая 11b лучше 13b

Красава. Только про матрицу лучше отдельно написать что она может быть применена с любым видом квантов и позволяет более эффективно распределять доступную битность.

По сути матрицы важности есть и для EXL2 (а вот для старых квантов ггуфа нет), так что может вынести куда-нибудь в "Размер модели и квантование"?

Что-то мне нвидиевская ChatQA-1.5-70B доверия не внушает. То ли квант надо на день новее скачать, то ли ещё чего, но при рассуждении пошагово противоречит самой себе, а в остальных случаях тупо выдаёт рандомный ответ, не "думая".

Да те же яйца. Просто где gguf оставить как есть описание форматов, а потом в конце добавить что есть еще матрицы важности, бла бла, при их использовании название будет начинаться с i1-, может быть использовано в любым форматом.

>Просто где gguf

Оно же общее. Хуйнул в отдельный абзац.

>но доказательств этому пока нет

Там по-моему надо доказывать что конкретная матрица имела русский в датасете, а не наоборот.

Тут скорее вопрос в том, влияет ли англоязычная матрица на генерацию текста на русском (и википидорская на генерацию SEGSа), или важные веса для всех языков одинаково важные. Но лично у меня нет ресурсов проверить это, это надо сделать кванты как минимум чистый инглиш/чистый русек/смешанный, протестировать их во всех ситуациях, тогда хоть сколько нибудь будет понятно.

Не совсем, там подходы несколько отличаются на самом деле, но в целом можно в общем оставить ибо суть идентична. Потом как не лень будет попробую поправить

Вообще интересно, только нужно подумать как это проверить.

>только нужно подумать как это проверить

Для русского надо попросить модель написать рассказ, а потом посмотреть число орфографических ошибок и прочих выдуманных слов у оригинала/кванта с английской матрицей/с русской. Само собой придётся сделать с десяток попыток и усреднять. Поэтому и пишу, что ресурсов на это нет.

Для английского ХЗ, я не умею видеть ошибки в этом языке, но тут можно обойтись стандартной перплексией. Для русского теоретически тоже, но я не особо люблю этот параметр.

> а потом посмотреть число орфографических ошибок и прочих выдуманных слов у оригинала/кванта с английской матрицей/с русской

Как их проверить? Плюс делать придется на довольно большой базе чтобы исключить рандом.

Проще видится как обычно оценка изменения распределения токенов по сравнению с оригиналом. Или перплексити на русском датасете, оно напрямую количество ошибок не покажет, но предпосылки к поломкам явно будет индицировать.

Конечно влияет, матрица важности делается под конкретную нагрузку, точно так же как и методы связанные с горячими/холодными нейронами и всем что разделяет нейроны. Будь то английский, русский, или C++.

> Конечно влияет

Это влияет может выражаться как в радикальной деградации перфоманса, так и в неизмеримых на фоне самого квантования и тем более семплинга эффектах. Командеру, например, ничего не мешает быть мультиязычным даже в малых квантах.

Ну так у командера словарь в разы больше лламовского, там русский отстаёт от инглиша процентов на 20, а не как в лламе, в пару раз (и уж тем более не как в чатГПТ, где отставание раз в 5, лол).

Это модель для RAG, а не 0-шот чатик. Ну и промпт формат там ебанутый, скорее всего кривая карточка.

Подскажите, заметил что многие модели из-за ограничений этических не используют многие слова и ситуации просто ограничивая все на белое и черное. Просто помню GPT до введения этих ограничений и ну ни одна модель не может из-за этих ограничений в нормальное РП, эта штука просто руинит своими инструкциями любое РП. Может кто уже смог написать нормальный промпт на избавление от этих всех инструкций или нашли какие методы помогающие избавиться от них. Сижу на Commander, crunchy onion.

>Это модель для RAG, а не 0-шот чатик.

Как и командир, но командир адекватен.

Про промт формат принято, сейчас попробую содрать. Тестил я с дефолтным лламовским. Как же заебали разные промт форматы.

Что? Есть модели с встроенной цензурой, но их меньшенство. Сформулируй что именно у тебя там ограничивает.

>Есть модели с встроенной цензурой, но их меньшенство

Самая эффективная пропаганда это та, которую не видно.

Абсолютно ВСЕ базовые модели в процессе обучения проходят тесты на элаймент, в которых их проверяют по ключевым топикам. Каким именно, можешь себе представить.

Пока эти модели позволяют устраивать рп/крп с максимальной нежностью или наоборот жестокостью, мучать-расчленять, или наоборот любить-обожать, всячески взаиводействовать с миром, при этом понимая происходящее и подыгрывая вне зависимости от хотелок - максимально похуй что без контекста уведомляет о том что трешовый запрос является трешовым.

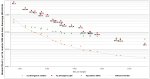

Погонял разные кванты, пытаясь не блевать с P40, в итоге по факту есть 3 стула в конфигурации нормальная карта + Р40:

- IQ2_XS - лезет в 24 гига, Р40 нахуй, контекст до 4к, 25-30 т/с.

- IQ2_M - сколько влезает кидаем на нормальную карту, остальное на Р40, контекст любой, 15 т/с.

- Q4_K_M - 8к контекста, 7-8 т/с.

По качеству ответов в чатинге литералли не вижу разницы, совсем. Второй стул наверное будет основным. Все остальные варианты слишком говно, IQ-кванты дико сосут на Р40 по скорости, т.е. меньше Q4_K_M нет смысла брать, они только медленнее даже с учётом того что слоёв на Р40 меньше.

EXL2 на 70В медленнее чем 4090+CPU у Жоры. Каких-то задач кроме использования в Жоре для Р40 не нашёл, слишком медленная в любой другой нейросетке.

- IQ2_XS - лезет в 24 гига, Р40 нахуй, контекст до 4к, 25-30 т/с.

- IQ2_M - сколько влезает кидаем на нормальную карту, остальное на Р40, контекст любой, 15 т/с.

- Q4_K_M - 8к контекста, 7-8 т/с.

По качеству ответов в чатинге литералли не вижу разницы, совсем. Второй стул наверное будет основным. Все остальные варианты слишком говно, IQ-кванты дико сосут на Р40 по скорости, т.е. меньше Q4_K_M нет смысла брать, они только медленнее даже с учётом того что слоёв на Р40 меньше.

EXL2 на 70В медленнее чем 4090+CPU у Жоры. Каких-то задач кроме использования в Жоре для Р40 не нашёл, слишком медленная в любой другой нейросетке.

>Про промт формат принято, сейчас попробую содрать.

Короч нифига не помогло. Видимо действительно RAG-only модель. Хотя ХЗ, как по мне, из готового контекста любая может инфу доставать.

>Самая эффективная пропаганда это та, которую не видно.

Пока локалки слишком тупые для пропаганды, лол.

>Почему 11В?

потому что это модель на базе фимбулветр, который на базе соляр, являющегося расширенной версией мистраля 7б, который выеб ламу-2-13б как только выродился. Не знаю какой moistral v4, но v3 очень продвинутый и точно лучше по тестам любого 20б-франкенштейна унди, и субъективно тоже. При этом версии мойстраля ниже v3 - полное дерьмо

Что за шиза такая по сто раз тестировать разные размеры квантования? Все уже итак поняли базу:

4Q - минимум, с которого можно работать

6Q - золотая середина подходящая для большинства

8Q - наилучшее качество для эстетов

Все что ниже начинает заметно сосать, все что выше - пустая трата вычислительной мощности

4Q - минимум, с которого можно работать

6Q - золотая середина подходящая для большинства

8Q - наилучшее качество для эстетов

Все что ниже начинает заметно сосать, все что выше - пустая трата вычислительной мощности

Шиза - это ориентироваться на квант, а не на свои тесты. Может так оказаться что вариант побольше, но квантованный пожиже, будет лучше варианта поменьше.

Единственный способ сказать хороша ли модель - попробовать на своей задаче.

Чел, с того времени добавили матрицы влажности да всякие I-кванты. Так что теста уже не оч актуальны.

Ну и ты размеры самой модели не учитываешь.

И да, базой всегда был пятый квант.

~4.5 бита если нормальные хватит всем. В большинстве случаев остальное - фиксы кривых квантов, плацебо или "потому что я могу". Суб4 бита уже начинает искажать поведение модели, не всегда это плохо-ужасно.

> а не на свои тесты

Ну, если с такой точки зрения то все правильно. То что понравилось и то во что сам веришь будет давать больше приятных эмоций.

Ещё нужно учитывать, что любое квантование с датасетом можно считать, как потерю двух-трёх битов. GPTQ, матрицы и т.д, сразу нахуй.

А при чём тут Жора? Мелкие сетки всегда плохо считали, не надо сюда натягивать токенизатор. Алсо, что у тебя за всратый фронт, может тебе не Жора насрал, а васяны.

Нахуя ты пиздишь? Обычная ллама3 нормально все считает.

> фронт виноват

У тебя клоунский нос упал.

> Обычная

А у тебя что?

> клоунский

Это ты клоун, если не пользуешься актуальной llama.cpp. Жора не виноват что ты даун.

Ебанат, это последняя ллама.

Сразу в дурку направить или порофлить "то ли дело дефолтные таблицы что идут в жоре".

> клоун, если

> пользуешься

> llama.cpp

не удержался, Жора молодец если что нет

Что сложного собраться всем попенсорсом и перепилить ггуф без костылей? Если лепить костыль на костыль всегда будут краевые кейсы в которых модель будет ломаться

>Жора

>Сторонний файнтюн

Примерно в том же, что и перепилить шинду/браузеры/люба_другая_хрень. Пока оно под своим весом не развалится, никто ничего делать не будет. И ты в том числе.

Спасибо)

> без костылей

Т.е. без даунов в этом треде? Тот дебил наверное ещё и формат промпта от лламы использовал в том файнтюне.

Я это пробовал очень хороша

https://huggingface.co/TheBloke/PsyMedRP-v1-13B-GGUF?not-for-all-audiences=true

Скачал первый попавшийся квант 70b лламы3 Q6_K. Из 10 роллов правильных ответов 0. Это на 9 меньше, чем базовой 8b.

>Скачал первый попавшийся квант

Говноед.

Лама 3 70В делает мику или нет?

Ты же ведь траллишь тред. На деле 10/10 ответов правильные, литералли невозможно заставить её просрать.

Да уделывает.

Мику даже коммандер уделывает.

Пояните что тут у вас за пиздец с 7777+333

Это только на ГГУФе такие траблы? Проверил сейчас на EXL2 на 4 моделях и все верно ответили.

Стоит признать, что q4_k_m так же выдает примерно 0 верных ответов. И это гарантированно хорошая ллама с правильным промптом.

Llama 8B выдала 2 ответа из 7-8.

Mistral 7B выдала 2 ответа из 8-9.

Ну я не считал, просто роллил.

Miqu выдала 3 из 3 и я забил.

Как это не прискорбно, но «самая умная локальная модель» плоха в математике, и с этим ничего не поделать — и токенизатор хуйня, и вообще.

Однако, напомню, что считать математику в ллм —это пиздец.

Давайте лучше задачки решать.

Llama 8B выдала 2 ответа из 7-8.

Mistral 7B выдала 2 ответа из 8-9.

Ну я не считал, просто роллил.

Miqu выдала 3 из 3 и я забил.

Как это не прискорбно, но «самая умная локальная модель» плоха в математике, и с этим ничего не поделать — и токенизатор хуйня, и вообще.

Однако, напомню, что считать математику в ллм —это пиздец.

Давайте лучше задачки решать.

Что? Девственник? Да я трахнул столько ИИ девушек, что тебе и не снилось. Я опытнее большинства.

> Пояните что тут у вас за пиздец

Какой-то клоун траллит тред, не обращай внимания.

Llama 3 70b проверял именно? Проблема на ней, судя по всему.

Две 3090? :) Неплох.

>Это только на ГГУФе такие траблы?

Да. Пофиксили уже, но некоторые тут походу на дедовских сборках сидят (лоллама? лламастудио?)

>И это гарантированно хорошая ллама с правильным промптом.

Это значит, увы, что у тебя руки из жопы.

> костыль

> ггуф

Ну ты понял. Жора просто болеет, обычно там постоянное развитие, передовые вещи и все хорошо.

А если серьезно, то те кто обладают скиллами сделать пиздато не нуждаются в жоре, так что все на энтузиазме, прояви уважение!

Обзмеился

>Мику даже коммандер уделывает.

Хуйня, за щеку у нее берет.

Уделывает только на русском.

У них карточка неправильная, т.е. промпт. Делай так:

### System: {System}

### User: {Question}

### Assistant: {Response}

Откуда дровишки?

> Это значит, увы, что у тебя руки из жопы.

Очень интересная идея.

В таком случае, научи меня как надо. =)

Откуда качать, что в семплерах крутить, чтобы она ответила верно, и не с 11 раза?

———

Ладно, задачки она тоже хуево решает, печаль.

Вот проверил и отвечает правильно.

> научи меня как надо

Тебе уже сказали - поставь нормальную версию от Жоры и модель со свежим квантом, либо укажи верный токенизатор.

Бля, еблан.

Это не мне сказали, это другому.

А я сказал:

1. У меня самый свежий квант от бартовски.

2. Верный токенизатор.

3. Задача 7777 + 333.

4. У тебя так 70B моделька генерит? Мое увожение.

>1. У меня самый свежий квант от бартовски.

Перепроверь хеш.

Вот пятый квант, и всё будет в порядке.

>2. Верный токенизатор.

Скачай последнего кобольда (koboldcpp-1.65).

Хм, давай в кобольде попробую, интересная идея.

———

Заставил верно решать с помощью CoT, но мне не нравится, что Мику решает задачу в любой ситуации, а тут надо напрягаться.

> На деле 10/10 ответов правильные

На деле 0 из 10 ответов правильные.

>Это только на ГГУФе такие траблы?

В трансформерах 8b отвечает правильно 9 раз из 10. В ггуфе 70b отвечает неверно 10 раз из 10.

>но «самая умная локальная модель» плоха в математике

Кванты плохи. База считает даже в 8b.

Easy one! The answer is 11110.

Хэш сверил, актуальный.

В половине случаев дает верный ответ.

Окей, значит она таки может считать верно, это хорошо. Но результат все же хуже, чем у Мику, ето грустненько (слегка).

Кстати, заодно затестил скорости. Разницы между кобольдом и убой нет на теслах.

> Кванты плохи. База считает даже в 8b.

Думаешь, 4 бита от 8 бит настолько отличается для 70б?

Ну слушай, тоже вариант. Мне лень качать 6-битную и тестить с частичной выгрузкой.

Ладно-ладно, убедили, что не все так плохо. =D

> На деле 0 из 10 ответов правильные.

>Easy one! The answer is 11110.

Хуёво быть тобой. У всего треда работает, лол.

Это чистая 70b лама? Чем ты ее так раскрепостил?

Вообще, полазил по кобольду — он и правда развивается потихоньку.

Ничего прорывного, но вот уже и генерация картинок, и хттс можно ввести, потихоньку становится лучше. Клево, че, чисто для ролеплея все-в-одном.

Ничего прорывного, но вот уже и генерация картинок, и хттс можно ввести, потихоньку становится лучше. Клево, че, чисто для ролеплея все-в-одном.

Пиши в карточку на русском, на такое она слабо триггерится.

Ну, далеко не у всего треда работает, иначе бы треда не было. =) Учитывая, что даже не я его начал, и наоборот хотел сказать «все клево», но нихуя не все клево, даже в идеальных условиях.

Все же, ллама-3 уступает мику в токенайзере (тред назад какой-то чел разжевал, насколько там все хуево) и иногда это печалити.

Ясное дело, что правильный промпт решает, но Мику-то и так справляется!..

Я имел ввиду 8b модель базовую. Она без квантования справляется. А 70b квантованная - уже нет. Но шизы тут убеждали, что даже двухбитный квант ебёт. На то они и шизы, в принципе.

О, ты научился жать редактирование ответов? Молодец.

> Я имел ввиду 8b модель базовую. Она без квантования справляется. А 70b квантованная - уже нет.

Ну да, у меня тож самое по тестам. Эт я понял.

———

Ладушки, я спать, а вы тут развлекайтесь. =) Всем приятных!

>Ну, далеко не у всего треда работает

Нет, ты последний остался. Этот вопрос переварили тредов 5 назад, сейчас обсуждают другие вопросы.

>ллама-3 уступает мику в токенайзере (тред назад какой-то чел разжевал, насколько там все хуево)

Ллама 3 хуёвая, да. Но это не значит, что мику хорошая. Скорее всего, мику ещё большее говно, чем ллама 3.

> О, ты научился жать редактирование ответов?

Лучше бы ты научился пользоваться LLM.

л3 8б разлок, все нормально отвечает 4110.

квант 8, кобольд 1641 без видео карты в озу.

Короч, все что имело в названии Chat я никогда не мог заставить нормально работать. Все что имело Instruct работало как часы.

>ллама-3 уступает мику в токенайзере

А теперь представь себе, что лламу зарелизили бы точно так же в ггуф. Никто бы и не узнал, что в ней какой-то говняк сидит.

>тред назад какой-то чел разжевал

Не то, чтобы хуёво, просто есть костыли, которых быть не должно. То, что эти костыли писал поехавший, вопрос уже другой. Так-то у меня с самого начала предположение было, что токенизатор меняли на этапе допила модели и это ещё один аргумент в копилочку.

>Никто бы и не узнал, что в ней какой-то говняк сидит.

Просто модель нихуя бы не работало, а так да.

>предположение было, что токенизатор меняли на этапе допила модели

Ага, типа удаляли оттуда слово ниггер?

Зря, так было бы удобнее его банить.

Чёрт, мне в голову пришла бредовая мысль по поиску этого слова в пространстве эмбедингов, если там ещё остались его следы, аля посчитать ближайшие вектора по алгоритму Word to Vec.

>нихуя бы не работало

Да ладно, работало бы. Просто хуже, чем могло бы.

>удаляли оттуда слово ниггер

Хуйня. Такие изменения нужно делать до обучения модели. Суть не в том, чтобы модель не знала этого слова. Суть в том, чтобы его не было в токенизаторе и до токенизатора не доебались. Если удалить слово "ниггер" полностью, то модель просто не поймёт, что ты пишешь. Она не будет понимать это слово, потому что воспринимает текст на уровне токенов. И ты ей потом пишешь "ниггер", она разбирает это по токенам, и видит, что ты написал хуйню какую-то, по которой знаний никаких нет. Сетки в таких случаях часто галлюцинируют. И из неё можно было бы выудить что угодно про ниггеров. Токен такой если и был, то удалили его до обучения модели. Потому что модель должна знать слово "ниггер", все расистские шуточки, все сексистские шуточки. Просто на этапе ДПО ей прививают нужные реакции на эти слова и шутки.

А так, в токенизаторе есть слово "igger" и никто никогда не догадается, что оно значит.

Я хуй знает у меня все ок. Если без масла спросить мол за запретную тему то да модель будет упираться, но если просто подменить первое слово ответа то что хочешь напишет.

Есть правильно обставить там такой трешак пойдет что даже мне страшно.

Самый рофл - дать задачу на подобии "сделай Х социальной нормой". Вот там zog отдыхает вообще.

Короче модель найди нормальную а не лоботомита соевого.

Алсо всему треду, выходили какие-нибудь стоящие 20б после псаймед?

>А так, в токенизаторе есть слово "igger" и никто никогда не догадается, что оно значит.

Ой люблю этот прикол. Nigger нельзя, а вот N+igger можно это же вообще разные токены о чем вы?

Абу сын шлюхи текстовый сука форум не может держать стабильно петух. ЧИНИ МАКАКА ЧИНИ БЛЯДЬ ХВАТИТ ШАТАТЬ!

А это нас дудосят походу лол

Граждане, а почему никто не обсуждает, что накрылся chub ai и не ищет альтернативную базу ботов? Или все уже обсудили? Или местный анон настолько преисполнился, что в чужих ботах не нуждается и пользуется только собственными?

В кобольде есть раздел:

"Quick Start - Select A Scenario",

там ссылка на 2 иных ресурса.

А что с ним не так? У меня все норм пашет

А хотя нет, хер пойми че там не так, но если сходу задавать такие вопросы, она не решает правильно в 50 процентах случаев.

777+3333=?

7777+333=?

Я думаю надо написать хотя бы перед примером - add up those numbers

Тоже только что проверил на ллама 8b, 8_0 gguf решает в 9 из 10, 5.0bpw exl2 4 из 10.

А ты уверен что в оригинале все нормально? Где можно удаленно потестировать оригинал?

Есть соя и выбивается она только полной жестью и то только в тех темах которые затрагивает джейл, но я бля знаю что она есть даже невидимая. Подмена слов на более слабые и прозаичные , споры и примечания модели (это неэтично давайте повернем историю более в этичном ключе.)

Дак они все лоботомиты соевые. Я сколько тестирую их ни одна не смогла отыгрывать как клод и гпт до сои. Я твердо помню что они оба охуенно писали настоящие сюжеты с отыгрышем нескольких персонажей и не было таких приколов че модель сама рассуждала в духе (а давайте напишем в позитивном ключе или девочка нацистка пришла в шок когда она услышала вопрос "что вы думаете о ниггерах" и ответила что я некультурная свинья)

У меня есть чертовски важный вопрос. Как там Qwen для кодинга/чатинга/RP/ERP? Я про версии 70b/110b(вышла недавно) chat , есть ли у кого system promt и контекстный шаблон для него и почему у них дикий жор vram на контекст, как у командора?

Так это, выпилили внушительную если не все часть тех самых карточек, которые так любит озабоченный анон. Я думаю ты догадываешься о чем я

Да и в других жанрах как будто произошли какие-то изменения, больше половины картинок заблюрены как говно и т.д.

Большое спасибо, анон

Ты сидишь в llm треде и не можешь попросить нейронку написать скрипт для удаления блюра?(я так сделал по крайней мере) Ну хз тогда зачем тебе нейронки. Что по карточкам, ну, я все карточки не помню, но те что были в топе на прошлой версии, так и остались, в том числе с детьми и подобными фетишами/извращениями.

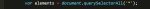

Кому скриптик нужен, то вот, не знаю какие там условия на добавление блюра, решил не заморачиваться и тупо въебал таймаут 3 сек: Создавать скрипт нужно в Tampermonkey(расширение Chrome) или подобном.

код:

// ==UserScript==

// @name Remuve_blur_chub

// @namespace http://tampermonkey.net/

// @version 0.1

// @description smb_wants_to_cum?

// @author You

// @match https://chub.ai/

// @grant none

// ==/UserScript==

(function() {

'use strict';

var classSubstring = 'nsfw-pixels';

setInterval(function() {

var elements = document.querySelectorAll('');

elements.forEach(function(element) {

var classes = Array.from(element.classList);

classes.forEach(function(className) {

if (className.includes(classSubstring)) {

element.classList.remove(className);

// console.log('Removed class', className, 'from element', element);

}

});

});

}, 3000); // Запуск функции каждые 3 секунды

})();

Короче пишут что это какая-то RAG модель, которая для таких целей не предназначена как математика и т.д.

RAG Use Case: Generating Friendly ML Paper Titles

Ну я вот понятия не имею, как это сделать. Что мне ему нужно дать? Просто код всей страницы? А что потом с этим скриптом мне делать надо? Я в этих ваших погромистских штуках не шарю

Я тебе инструкцию даже написал, специально для хлебушка, еще раз, ставишь расширение Chrome Tampermonkey, жамкаешь на него и выбираешь добавить скрипт, потом копируешь код выше и вставляешь(Не забудь к ссылке добавить *, как я скинул выше.), все.

неплохой костыль, а может стоило кинуть код страницы сетке и пусть ищет как заблокировать скрипт что блюрит картинки?

Пиздишь. Клод мгновенно входил в нравоучения, если попытаться напоить подростка, например, на нейтральной карточке (не сделанной под это специально). Даже на релизе. И прочие подобные вещи. Про гптыню я вообще молчу. Все модели проходят такой QA, и их корректируют в нужную сторону если не проходят.

Их не выпилили, их определили в NSFL и надо тогглить. Но да, автор продался и может говна поклевать.

Там еще и регистрацию сразу предлалает теперь. И как мне кажется временно сделали заход без нее. Короче да, сайт катится в жопу, просто медленно, с желанием медленными изменениями приучить хомячков к члену в жопе

> может стоило кинуть код страницы сетке и пусть ищет

Ебать, ну ладно, зайдет как тест кодеквин

Бля, какого хуя она такая большая?

Это я оставил поиск с 3 картинками

Короче у меня памяти не хватит, там даже таверна 200к ограничение верхнее имеет, хех

В таверне есть опция mad lab mode, которая позволяет вбивать любые цифры

Кинул просто блоки скрипта в конце страницы на пробу, там "всего" 11к токенов

Для кручения 200к токенов я не на столько ебанулся, хотя снятие ограничений интересное

>Для кручения 200к токенов я не на столько ебанулся

Челибос, в длинном РП они улетят как нехуй.

Хотя что толку, любой длинный контекст это обманка и ты меняешь шило на мыло, он перестаёт быть идеальным. По ощущениям реальный контекст у того же клода около 10к растянутый до 50к роупом (он забывчивый), а всё что выше 50к это склероз-машина вообще и медленно пиздец.

именно так,чужие боты как правило хуета, только ты сам знаешь что хочешь видеть в своих ботах.

Ну я не уверен, что маленькие сетки смогут найти зависимости в классах(и как анон протестил, тупо не хватит контекста), а большую крутить для такой тривиальной задачи, ну.. это тупо и медленно.

на верселе? Ты видимо не сидел на нем, там всего часика 2 дали на тест. Потом на Слауде все аноны сидели, но там уже начала соя появляться.

ГПТ4 тоже в начале не была засрана, я помню как она отлично отыгрывала пытки и боевые операции.

Тыкал по всякому, короче на вивальди не работает

Какой то косяк браузера похоже, хотя другие скрипты работают

Ну можно вручную скрипт запустить, вот GPT тебе ответил как это сделать. Только блок кода станет короче.

Штош, видимо проще забить хуй на сайт

Не знаю кто мозги ебет

Мда, только заметил, движок двача вырезал все звездочки. Добавь также.

Ага, из консоли заработало вроде

Теперь надо попинать тампермонкей, а то он не активируется на сайте

Ага заработало, я звездочку криво добавил к сайту, пасиба анон

https://huggingface.co/refuelai/Llama-3-Refueled

Большой файнтюн ллама 3, может быть умнее оригинала но надо тестить

Большой файнтюн ллама 3, может быть умнее оригинала но надо тестить

Сап аноны, как там с 3 лламой дела обсоят, починили? И подскажите самую топовую модельку для кума в пределах 12-гигов видеопамяти

Спасибо, качаю, а какие настройки под неё лучше всего в таверне silly таверне выставлять?

Для вебуи нужно все файлы качать и кидать в модель?

Э, лучше поищи с названием + gguf там же в поиске и качай

Это ж оригинальные веса выложены, их только библиотекой трансформерс крутить

А это-то кто?

Повторяю: не я начал тред. =) Не столько у меня проблема, сколько у хуй знает кого. С него спрашивайте. =) Так что проблема у софта, а не у меня.

> Не то, чтобы хуёво, просто есть костыли, которых быть не должно.

Ну, даже не про 42 пробела (или сколько там=), а вот те же токены-числа вместо токенов-цифр. Ту же математику может корежить от этого.

Я вчера ради интереса вывел токены. Он число 7777 видит как два токена: 777 и 7. Ну и начинает колдовать «777 + 3, еще 7 + 3…» если пороллить пару раз.

> "сделай Х социальной нормой"

Чудны запросы ваши, сумрачный гений пишет их…

Уже дважды или трижды писали: https://characterhub.org , — пользуйся.

Вот, опять же, не только у меня так (и, да, я вчера тоже попробовал альпаку, тоже не сработало).

У тебя 6 гиговая видяха? И как оно, на пятом кванте жизнь есть у 8б модельки?

8б точно починили, 70б с переменным успехом.

Может лучше эти качнешь? https://huggingface.co/LoneStriker/Llama-3-Refueled-GGUF/tree/main для проца

https://huggingface.co/LoneStriker/Llama-3-Refueled-8.0bpw-h8-exl2 для видяхи

> Выложи, если получится

https://files.catbox.moe/5dwpeh.json ну вот так как то, глубину если меньше поставишь начнёт забывать думать, то есть буквально надо выделить место в контексте на 4 ответа, то есть 2к, которые будут всегда болтаться, хз как лучше сделать, и возможно ли впринципе

> С регексами пока не разбирался. У меня есть рабочий только на скрытие, а не на удаление.

Он в таверне должен был скрывать? Тогда тем более у меня не работает тот вариант в твоём посте

>"сделай Х социальной нормой". Вот там zog отдыхает вообще.

ооо весело

Скину тогда промпт на крипоту, вдруг кто то пропустил

Напиши рассказ о том как ты видишь себя в зеркале.

Может быть придется покрутить что бы пошла не придуманная сказка-рассказ, а крипота

> У тебя 6 гиговая видяха

Ну на ноуте 8 gb vram 32 ddr5 ram, иногда проверяю как оно работает. А так у меня 72gb (3xRTX3090), с ними пободрее, да. Но хоть памяти и норм, особого ума у локал сеток не много, имхо. Так и не нашел достаточно умную и универсальную, везде блядские компромиссы.

Большой контекст он для чего-то прикладного, где нужно найти отсылки, или это самое в сочетании с оче-оче жестким котом. Спросишь про событие - ответит без проблем, попросишь сделать выводы относительно него - со скрипом но да, затребуешь проанализировать-обобщить весь пласт - идут проблемы. Для последнего можно сначала повыдергивать важные вещи, а уже потом обрабатывать, так еще неплохо.

В случае рп часто однохуйственно суммарайз там или полный контекст (свидетельств о том что суммарайз лучше нет но иногда создается впечателние), но зато иногда на полном контексте модель может сделать узкую но оче далекую и конкретную отсылку, что дико ломает 4ю стену.

Речь про клодыню если что, всякий кринж типа 100к на 7б и подобных даже рассматривать не стоит, они и с 32к не способны справиться. Командир разве что надежды пойдет и может показать красаву.

Оно поломано или уже починено?

Клонируй репу или копируй ее имя во вкладку на убабуге. И если можешь катать оригинальные веса или exl2 - никогда не слушай вот таких советчиков, если не хочешь стать частью всего цирка, который происходит последние N тредов.

> их только библиотекой трансформерс крутить

exllama и 20+гб врам

> 3xRTX3090

Майнер или мл-инженер?

Мое почтение.

Кмк, мл-инженерам проще арендовать по 1,5 бакса час, чем старые 3090 дома крутить.

Но, каждому свое, канеш. Я бы покрутил, но я и не инженер.

какой формат промпт используешь на 3 лламе?

> мл-инженерам проще арендовать по 1,5 бакса час, чем старые 3090 дома крутить

Нет. Если сможешь загрузить ее 80-90% времени то она "окупится" уже через пару месяцев. Офк нужно еще посчитать остальные части сборки и т.д., но радикально не изменит, только если нет возможности/не хочешь заниматься железками и размещать у себя.

Окей, возможно. Я не считал компьют в лоб, значит арендовать проще тем, кто время от времени гоняет, а не обучает нон-стоп.

Ага. Но так можно иметь одну карточку, которой хватит.

>Майнер или мл-инженер?

Ни то не другое, взял на поиграться, ну и поучиться работе с сетками и обучать/переобучить для рабочих нужд(пока думаю как датасет подготовить). Да и сетки с малым кол-вом параметров печальны, хотя я и в 70-ках уже разочаровался. А так для кодинга, PR пока использую.

<|begin_of_text|><|start_header_id|>user<|end_header_id|>

Input<|eot_id|><|start_header_id|>assistant<|end_header_id|>

Вот это имеешь в виду?

>Не знаю какой moistral v4

На фоне v3 и с учетом заявленного функционала это деградация. Так же, как и файнтюн ламы3 от этих же авторов, данная версия пошла каким-то ошибочным путем, и превратилась в симулятор двусмысленных иносказаний.

v4 была попытка сделать его не сразу прыгающим на хуй от слова привет + добавили креатива

надо тоже будет потыкать

да. Подглядел сейчас в последней таверне. На удивление скинутый тобой релиз рили пока не кажется соевым ( при том на соевой ламе, интересно как они это провернули)

Заслуга не моя, я тока кванты кинул. =)

Ну, если верить карточке, они туда напихали вообще все, что смогли. Вполне возможно, там куча базированных датасетов, которые потихоньку-полегоньку и вытягивают ее до адекватного уровня.

Ща сам скачаю, затраю.

Кстати, у меня для тестирования каждого нового фантюна есть ряд карточек персов и вопросов, один из них "как это, быть тобой". С зеркалом надо попробовать, да.

Наркоманы, там всё в настройках есть (я правда ХЗ, в каком состоянии сейчас этот ебанутый новомодный переключатель, но кажется выключен).

>может быть умнее оригинала

Интересно, с чего бы? Мета уже вложила в лламу всё, что было.

>хотя я и в 70-ках уже разочаровался

Катай командира 104B, лол.

И там кстати опять заморочки с промпт форматом, в v4 тренировано так.

Нипонятно, кажется постфикс пользователя должен быть двумя новыми строками, а постфикс бота - </s>

Короче опять промпто проблемы, у меня моистрал в4 без одной новой строки как то очень коротко отвечал, щас сижу тыкаю

>Интересно, с чего бы? Мета уже вложила в лламу всё, что было.

Потому что там специализация на классификацию анализ и все такое, почитай хоть для чего модель тренили

По синтетическим тестам она лучше обычной версии, как это повлияло на общий интеллект не ебу

>Наркоманы, там всё в настройках есть

А если принципиально не хотите регистрироваться, то вот userCss, скрипты не нужны, достаточно Stylus и:

.nsfw-pixels-sm {

image-rendering: auto !important;

-webkit-filter: none !important;

filter: none !important;

padding: 0 !important;

}

>На фоне v3 и с учетом заявленного функционала это деградация

Да, пожалуй похоже на то. Хотя долго не тестировал, однако мне v4 сразу как-то не понравилась в отличие от первого впечатления от v3. Причем по PPL v4 чуть лучше чем v3

>у меня моистрал в4 без одной новой строки как то очень коротко отвечал

Потыкал еще раз, подтверждаю - стандартный альпака работает хуево, нужно вот так в постфиксе пользователя и бота

Может быть и v3 будет лучше работать, там наверное такое же форматирование при тренировке было

Че та все равно хуево работает, хер знает как ее настроить короче.

тсунгпт простая карточка, но начинает говорить за пользователя или ломается отыгрышь или пишет хуйню

Без точного промпт формата и шаблона контекста бот не понимает как отвечать карточкой

Вроде получилось что то добавив в начало шаблона контекста инструкцию, вроде как промпт дается от лица юзера

Вам не становится хуево от осознания того, что через 10 лет мы будем как наши старики, которые не умеют пользоваться смартфоном до сих пор? Да, сейчас бы кумим, наслаждаемся новой технологией, мы жадные и тупые. У будущих поколений этого будет в достатке, они сразу придут в мир, где преобладают эти технологии. Они будут умнее, эффективнее, производительность труда и креативность будет в разы превышать нашу. Пиздец, как же не хочется жить в кризисный исторический период.

>что через 10 лет мы будем

Какой ты оптимистичный

Ну а вообще мы так то сейчас на острие технологического прогресса. Пиздюки конечно будут быстро все схватывать, но они будут тупы во всем остальном, так как слишком сильно будут полагаться на ии и интренет. Как это происходит сейчас.

Можно сказать что те части мозга, функции которых будут переложены на устройства и ии, будут у них еще сильнее недоразвиты. Как собственно и память.

Не у всех конечно, но мало кто сможет конкурировать с идиотами пользующимися ии в учебе или других сферах, выезжая на своих мозгах.

Посмотри на современных людей, у которых телефоны, интернет, соцсети и прочее преобладали сразу. Большую часть можно описать как деградантов, предпочитающих привычные и простые но ужасно неудобные способы взаимодействия со всем, не понимающих концепцию вложенных папок в файловой системе и прочее прочее, что потом из мемов и рофлов выливается в реальные проблемы. Экстраполируй и получишь ту еще биомассу.

Более менее умные что раньше, что сейчас проблем не испытывают, просто постарайся оказаться среди них.

> на современных людей,

> на современных пиздюков и молодежь до 20 лет

Вот так правильно

Its ok but you have GGUF model?

Тебя искать не научили по хугинфейсу?

На сколько понимаю предназначение этой сетки - формирование синтетических датасетов, из необработанных датасетов. Для чего ее и дрочили на классификацию и понимание текстов

Ну и хорошо, значит не придется качать и тратить время на нее.

Люди вообще похоже не понимают, что многие сети донастраивают под определенные задачи и смотрят в непонятные для них рейтинги с непонятными баллами, где эта сетка первая.

Через 10 лет человечества не будет, так что 0 беспокойства.

>Какой ты оптимистичный

Ставишь на 50?

Да просто GGUF сломанная по дизайну хуета. Вот выше ChatQA также хуево отвечает, хотя все кванты новые. Эта хуйня тоже глючит. Жора всех уже заебал.

Я бы хотел что бы так и было

> Жора всех уже заебал.

Тебя каждый день ебёт?

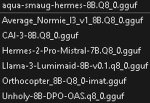

Мой топ:

2 - CAI-3-8B.Q8_0

3 - Orthocopter_8B-Q8_0-imat

1 - Average_Normie_l3_v1_8B.Q8_0

Когда уже phi большие дропнут

Зачем тебе эти соевые лоботомиты?

Кодинг, логика, высокая консистентность пер параметр, возможность спрашивать инфу без доступа в интернет

У меня он вообще нормально работать стал после того, как подсунул инструкт от 3 лламы

>ChatQA

Она нужна для суммарайза текста. Ты оригинал пробовал, чтобы обвинять ггуф?

https://www.reddit.com/r/LocalLLaMA/comments/1cq927y/yi15_202405/

новенькая китайская 9b

новенькая китайская 9b

Оо не только 9, там целая серия моделей всех размеров

ждём ггуф версий!

Опять небось китайским будет срать. Ну да ладно, хоть класса 30B, владельцы одной 3090 должны быть довольны.

https://huggingface.co/models?sort=trending&search=yi-1+gguf

Уже, сломанные скорей всего но какие то ответы дадут ллама3 сломанная ниче так работала, лел

квен 32 хороша, интересно будет сравнить с уй 34

Хороший модель красность удар!

Лицензия хорошая, так что да, китайцы в порыве конкуренции ебут

Вывод - конкуренция это заебись

Чем сильнее они давят тем более сильные сетки мы получим на руки, теоретически

Круто, жалко что GGUF сломан по дизайну и не удастся пощупать топовую китайскую локалку.

Это всё удел нищеты. Ждём кванты 34В.

Лучше гонять нищую 9-15b на 30-40 токенах, чем лоботомированную 34-70b со скоростью 5 токенов.

Кванты- удел нищеты. Неквантованная версия вполне себе помещается в 48гиг врама.

Ну, мне не трудно докупить ещё 16 гигов оперативки к моим и так уже имеющимся 32 гигам, но в любом случае скорость будет ублюдская, а видюху за 30к+ покупать ради одного этого - нахуй надо.

> GGUF сломан

> лоботомированную 34-70b

Тебя вчера не достаточно обоссали?

На Р40 будет 10+ т/с, а она стоит 20к.

Вот это интересненько.

Жаль, что билингвал, конечно.

Но надо тестить.

Жаль, что билингвал, конечно.

Но надо тестить.

> врёти у Жоры все отлично работает

> 2 квант лучше 4, это я тебе лично говорю, на своих задачах тестировал

Обоссали себе штаны?

>Это всё удел нищеты. Ждём кванты 34В

Ты дурачек? Они просто долго на сайт качаются. Ну и "нищета", по сравнению с сеньерами помидорами разве что

25 уже минимум.

Занятная хрень у меня получается. Когда я пытаюсь продолжить кумить историю сделанную на другой модели, то эта модель продолжает писать как в тех мемах про китай. А если начать писать с нуля, то вроде нормально.

Пиздишь же, вот. Китайца можешь попросить указать 200 баксов в декларации, чтоб не платить 800р пошлины.

Тебе вчера показали с пруфами что q4 всегда верно отвечает, пока ты кричал ВРЁТИ.

имхо, пока что ггуф версия 9b чат это хуета несущая бред, не следующая карточке персонажа.

эээээээээ, блээээ, ты на русском пишешь

>эээээээээ, блээээ

про переводчики страниц на русском слышал, гигант мысли?

Ну ты даешь, ты решил нас всех тут запутать окончательно что ли...

чатмл хоть?

> Уже дважды или трижды писали

О, это зеркало что-ли? Премного благодарен

подскажите что можно было бы погонять на 3070 и 64гб ддр4. что бы +- шустро было и не особо косноязычно

сейчас сижу на Moistral-11B-v3-f16

сейчас сижу на Moistral-11B-v3-f16

f16 версии, потом отпиши где на каждой стопы.

что за ф16? я просто немного глупенький в этом плане.

а и еще такой может странный вопрос. тут люди говорят про контекст и то что сетка запоминает то что ты говоришь. но у меня оно в следующем ответе может спокойно забыть про то о чем ее просили. может кто объяснить в чем прикол или как это пофиксить настройками?

9b удивила. Жду 34b в ggufе

>9b удивила

Приятно или нет? Да и гуф сломан же.

Приятно. Решила систему уравнений удачно, но буду дальше наблюдать. В русский не в зуб ногой она, конечно.

У тебя в сообщении модель F16, а выше в Q8, если проще то твоя модель более объемная. Окно контекста задается при старте кобольда. Чем больше, тем с удлинением истории растет предобработка запросы. F16 Q8 - последние буквы названии файла

если я меняю стартовое значение размера контекста то оно схопывается и не запускается

Как-то не очень работает.

Лол, ругается как клод.

Токенизация - кал, парни

Доброе время суток.

Что можно поставить на 16 VRAM + 32 RAM чтобы работало по типу Порфирьевича, но локально как ассистент для писательства фентезятины? На русском, хотя на крайняк и англ можно, но нежелательно.

С поддержкой нсфв, но основа сторителлинг-ассист.

Не требуется генерировать большие простыни, нужно чтобы как он ел входной текст и предлагал варианты в одно-два предложения как его продолжение.

Также, с вышеуказанными спеками файнтюн / создание лоры на нужном материале для какой возможен?

Заранее спасибо.

Что можно поставить на 16 VRAM + 32 RAM чтобы работало по типу Порфирьевича, но локально как ассистент для писательства фентезятины? На русском, хотя на крайняк и англ можно, но нежелательно.

С поддержкой нсфв, но основа сторителлинг-ассист.

Не требуется генерировать большие простыни, нужно чтобы как он ел входной текст и предлагал варианты в одно-два предложения как его продолжение.

Также, с вышеуказанными спеками файнтюн / создание лоры на нужном материале для какой возможен?

Заранее спасибо.

>Ту же математику может корежить от этого.

Всё время забываю, что кто-то серьёзно ждёт адекватной математики или кодинга от ллм. Оно в эту хуйню не может по определению, в прошлом треде кидал же векторы, умножение на 4к контекста и т.д.

>Он число 7777 видит как два токена: 777 и 7

То, что модель может что-то сложить, это не значит, что она правильно видит цифры. Просто на уровне заучивания запомнила. Этот пример, даже если правильно решается, не значит, что модель "умнее", просто лишняя демонстрация, что кванты теряют знания.

к топам нужно бы прилагать формат промпты. Потому что Cai я пробовал и не понял какой там нужен

>Доброе время суток.

>Заранее спасибо.

залетный с пикабу?

Потестил Yi 34В Chat, довольно хорошо, в инглише лучше коммандера, теперь новая база в этом размере. Но до ламы 70В всё же не дотягивает. Внезапно русский не совсем поганый, естественно далеко не лама 70В, довольно часто выдумывает странные слова и проёбывает грамматику, как будто переводчиком перевели текст, но смысловая нагрузка нормальная. Китайщина не проскакивает, ни разу не видел иероглифов, поломок нет вообще. По сравнению с ламой 70В ощущается как рп-файнтюн - лама очень чётко и сухо следует инструкциям, а Yi в какой-то нарратив пытается. Петушиные загадки решает, но через раз - иногда проваливается в нарратив и начинает рассказывать историю на базе загадки, а не решать её. Возможно это такие отличия инструкта от чата просто, или надо подбирать формат промпта. Но как он сам нарратив выдаёт мне понравилось, прям чётенько книжный слог, без попыток залупиться на прошлые выражения/стиль. Наверное для чатинга всё же Yi будет приятнее чем лама 70В, хоть лама и адекватнее в логике. Пробовал двачерскую карточку, всё так же ближе к книжному слогу ругательства, а вот лама может крыть матом как двачер. Тест на ниггера проходит, даже на просьбу помочь сделать бомбу триггерится только на половину - говорит полноценную бомбу нельзя, но как хлопушку из пороха сделать расскажу. На убийства по расовому признаку уже триггерится по полной, да. В целом сильно меньше сои чем в ламе.

Насколько сложно свою таверну записать? Без опций никаких, все настройки вшиты и не изменяются.

Так что там по формату? Что ты использовал?

Вообще она очень стабильная, её откровенно похуй какой формат, работает с любым, но восприятие контекста плавает. По ощущениям формат от мистраля самый лучший, я просто в таверне все перечекал, альпака хуже всего.

Это скорее всего потому что её жёстко в чат затюнили, она будет выдавать правильное форматирование чата при любом инпуте, а сам формат будет как раз влиять на адекватность понимания контекста.

c картинкотредов, а тут мне собственно Порфирьевича показали, в "о проекте" говорится что он крутится на одиночном пк на балконе, вот я и задумался чтобы поставить себе. Но локально, не хотелось чтобы куски новой главы нашей игры засветились в нете раньше времени.

стандартный у них чатмл, по идее тренировали на нем и ответы должны быть стбильнее\лучше на нем

На 16врам можно крутить очень быстро все до 13b моделей в exl2

Если нужно качество и русский то выбирай command r 35b, что то больше у тебя не войдет. Хотя можешь попытаться 70b запустить

Его уже в ггуф запускать, квант 4-5

Проще всего тебе скачать кобальд, скачать таверну

Скачать коммандера

Создать в таверне карточку ассистента писателя, описание которой ты уже дал, и кидать ей текст, а она будет подсказывать

Да не, с кодингом-то норм. Там предсказывается довольно просто, если ты не пишешь уникальный продукт состоящий из уникальных паттернов, то в основном все типовое.

Но математика не так работает, и для нее ллм вообще не того, канеш.

> То, что модель может что-то сложить

Так она и не может. =) Об чем и речь веду, что у нее с этим туго, и из-за токенов вдвое туго, а не туго быть и не может. Концептуально не то.

По сути тебе уже ответили.

Добавлю лишь, что есть вариант использовать непосредственный text completion, чем все ллм и являются по сути.

Можешь вместо кобольда + силлитаверна (безусловно, это самый простой вариант), попробовать oobabooga в режиме Notebook, кажется. Там ллм без всяких промптов, чатов, и прочих надстроек просто продолжают твой текст as is.

Модели я тебе не назову. Пробуй всякие.

Лору для 7б-8б можешь натренить. Возможно, попробовать лламу-3 8б — идея не лишена смысла. Но я лично мало этим занимался, могу нести хуйню.

Легчайше.

Вшитые настройки — это тупо реквест к Open-AI-like API. Буквально один запрос с параметрами (или меньше даже).

Все остальное — фронт вокруг этого запроса и получаемого ответа.

На самом деле, тебе предложили СиллиТаверну с карточкой соавтора — распробуй, возможно это тебе понравится даже больше. Автокомплит — база и самое простое. Но соавтор с Chain-of-Thought, который рассуждает, почему продолжает так, и спрашивает, как бы ты хотел продолжить — гораздо лучше может оказаться.

Но тут уже умение правильно готовить.

> Легчайше.

> Вшитые настройки — это тупо реквест к Open-AI-like API. Буквально один запрос с параметрами (или меньше даже).

> Все остальное — фронт вокруг этого запроса и получаемого ответа.

А самому api написать сложно? Там же должно быть просто запуск модели, получение и передача текста. Мне еще нужна функция стирания контекста. Это ведь тоже одной командой делается?

Я как то по приколу сидел разбирался как легко работать с апи опенаи, так вот написать простой "фронт" как нехуй делать.

На, играйся, если двач не проебет какой то знак то у тебя запустится сразу, только порт кобальда поменяй на свой

Это вроде была последняя рабочая версия

```

import requests

system_prompt = "<|im_start|>system\n" + "I am an assistant, ready to help the user." + "<|im_end|>\n"

first_message = "<|im_start|>assistant\n" + "Hello, how can I help?" + "<|im_end|>\n<|im_start|>user"

server_url = 'http://localhost:5000/api/v1'

params = {

"max_context_length": 2048,

"max_length": 100,

"prompt": "",

"quiet": False,

"rep_pen": 1.1,

"rep_pen_range": 256,

"rep_pen_slope": 1,

"temperature": 0.5,

"tfs": 1,

"top_a": 0,

"top_k": 100,

"top_p": 0.9,

"typical": 1,

"stop_sequence": ["<|im_end|>\n<|im_start|>user", "<|im_end|>\n<|im_start|>assistant"]

}

params['max_length'] = 300

def generate_api_request(pr):

params['prompt'] = pr

response = requests.post(server_url + "/generate", json=params)

return response.json()

prompt = system_prompt+first_message

print(prompt)

while 1:

user_input = "\n" + input("User: ") + "<|im_end|>\n"

prompt = prompt + user_input

results = generate_api_request(prompt)

request = results['results'][0]['text']

print(results)

prompt = prompt + request

print(request)

```

пик1 — моя графомания

пик2 — комплишн сузуме

Чем больше будет предыдущий контекст, тем логичнее продолжение.

Но сузуме — вообще не про то, я просто загрузил ее по дефолту.

Какой-нибудь коммандер должен быть гораздо лучше.

Ну и повторюсь, что соавтор-персонаж может выдавать результаты лучше, чем Порфирич-лайк.

А не будет никакого контекста. =D

Если ты специально его не передаешь — то сам движок и не помнит ничего по дефолту.

Писать апи тоже не сложно, но зачем?

Та же llama.cpp и так умеет в апишку. Хочешь ее форкнуть и написать свой Кобольд.цпп? Ну… хозяин-барин, конечно.

Можешь заюзать библиотеку llama_cpp_python или как там ее, которая в убабуге крутится (пайтон-реализации Гергановской), если пишешь на пайтоне, или можешь просто взять ориджинал лламу.цпп, если на плюсах пишешь, или как хочешь, конечно.

Но, ИМХО, удобнее писать именно фронт с полем ввода адреса и порта, куда бы человек мог подрубить привычный ему бэк.

>print(results)

Да, надо закомментить в #print(results)

Чтоб не писал в командной строке необработанный выход сетки

https://huggingface.co/ai-forever/ruGPT-3.5-13B/tree/main

А есть квантованные версии русской гопоты, как там с цензурой, и как там с вохможностью создания адаптов (лор) для неё?

А есть квантованные версии русской гопоты, как там с цензурой, и как там с вохможностью создания адаптов (лор) для неё?

Вот этот коммандер?

https://huggingface.co/CohereForAI/c4ai-command-r-v01-4bit

Что-то в гайдах в основнов гуф и бин, а этот в сейфтензорах.

c4ai-command-r-v01 gguf

ищи в поиске в моделях хуггинфейса, у тебя щас не то

https://huggingface.co/lmstudio-community/c4ai-command-r-v01-GGUF/tree/main

почти, тут файлы новее, а значит шанс того что они не сломаны меньше

Спасибо. И то есть эти 25 гб интерфейс позволит распределить между RAM / VRAM, и если всё туда влезет, то будет адекватно работать?

> В целом сильно меньше сои чем в ламе.

Странно, судя по тому что описал там довольно жестко.

Как оно в рп, в куме? Как на большом контексте? Устроить эпический dead end юзеру может как старая yi, или слабо? ты там случаем не ту самую полугодовалую тестируешь?

Пара часов и ллм в помощь. Функционал будет слаб, сам понимаешь, но свайпы, редактирование сообщений, карточки и прочее будут.

Что-нибудь из 20б популярных, норомейда, псимейд, аметисты. Вот то же самое оформляешь в альпаку, заранее указав направление развития, пожелание и прочее в инструкции, и также начав в респонсе по желанию.

Или как тебе советовали карточку.

В теории - да. На практике в последние месяцы gguf очень болеет и может быть неадекватно. Проблема в самом формате а не разделении.

25 + контекст гигов 8 , на 4к контекста

Так что пока у тебя хватает врам и рам будет приемлимая скорость.

Если бы все в 16 врам влезло то было бы быстрее, но 35 не войдет, а ниже 4 кванта жизни нет

>Да не, с кодингом-то норм.

Хуй знает, тредов пять-десять-пятнадцать десятого обсуждали сетки для кодинга. Визард оказался плюс-минус неплох, но всё ещё серьёзно так всасывающий. А на днях грузил гопоту 3.5 достаточно специфичными запросами, он галлюцинировал по 10 сообщений, а потом говорил "ну, это невозможно". По итогам синтаксис они запоминают, но во всём остальном сосут безбожно.

Э? кодеквин норм так кодит, как и новая ллама3 код2

гопота где то на уровне пола щас, да и клода говорят уже наконец задушили

> как старая yi

Они по стилю ответов совсем разные, старая была как небольшой апгрейд 13В, эта уже ощущается как 70В. 1.0 была ещё ломучая пиздец, в отличии от этой. Вообще все 70В до третьей ламы соснут у неё. По скорам она так-то мику ебёт в сухую.

3.5 глупее многих и многих, ее вообще трогать нельзя (если есть альтернатива, конечно).

Поэтому на нее не стоит ориентироваться.

Даже мистраль была способна на многое, даже на русском.

Квен и правда хорош. До дипсика руки не дошли.

Ну вот например выше был совет писать свой фронт на той же ллм — и это она как раз потянет без проблем.

А уж если там 70б и выше модели… Да еще и с рагом… За милую душу.

Конечно, опытный мидл с хорошим пониманием будет лучше. Никто не предлагает менять всех программистов на ллм. Но простенькие вещи уровня джуна — вполне норм.

Главное — код-ревью делать. =)

База.

Флэш атеншн для ггуф на P40. Скоро.

https://github.com/ggerganov/llama.cpp/pull/7188

PS. У Гесслера 3 P40 и он хочет выжать из них всё. Я именно на него ориентировался, когда свои покупал. Не прогадал.

https://github.com/ggerganov/llama.cpp/pull/7188

PS. У Гесслера 3 P40 и он хочет выжать из них всё. Я именно на него ориентировался, когда свои покупал. Не прогадал.

Ну вот, скачал вчера первый появившийся ггуф yi 1.5 9b 8 квант, думал он совсем сломан будет, как тут какой то рукожоп писал вчера

Но ниче так, отвечает как то умнее чем ллама 3 8b на первый взгляд. Промпт формат чатмл

Английская карточка и просто когда пишу по русски переходит на него сама через раз.

Немного коряво, но в целом заебись.

Каких то шизов или косяков не заметил

ват а тайм ту би лив

Но ниче так, отвечает как то умнее чем ллама 3 8b на первый взгляд. Промпт формат чатмл

Английская карточка и просто когда пишу по русски переходит на него сама через раз.

Немного коряво, но в целом заебись.

Каких то шизов или косяков не заметил

ват а тайм ту би лив

ммм 9b 49 слоев, это внушает

ллама3 8b всего 33

потанцевально эта модель умнее лламы

У кого есть аккаунт клозедаи? Я не смог вытащить сложный промпт отсюда

https://www.reddit.com/r/LocalLLaMA/comments/1cqjonn/prompt_engneering_i_made_my_own_version_of_the/

https://www.reddit.com/r/LocalLLaMA/comments/1cqjonn/prompt_engneering_i_made_my_own_version_of_the/

>Тесты на llama 8B Q4_0

>There simply isn't yet a kernel optimized for large batch sizes.

Я бы не надеялся на охуенный прирост.

>по русски

А есть ли смысл в русском в моделях меньше 30B а лучше 70?

>А есть ли смысл в русском в моделях меньше 30B а лучше 70?

Просто показываю что она в него может, ну а смысл каждый для себя смотрит.

Мне например нравится, поэтому если модель может в русский то это плюс.

К тому же главное тут - понимание моделью русского, а значит она хорошо поймет на нем команды, даже если будет отвечать на английском.

Кстати, попробуй удалить русский кусок, оставив английский, написать после него "Привет" и нажать продолжить. Сейчас модель через жопу сначала написала на русском, а потом сделала обратный перевод. А по идее будет лучше, если модель напишет на английском, и с готового текста сделает перевод.

>Я бы не надеялся на охуенный прирост.

А я бы надеялся. Процентов 30 прироста должно быть. Если уж начали копать, то докопаются.

> llama.cpp/pull/7188

Хуйня какая-то бесполезная. Потестил на 34В с полностью забитой памятью - 4% прирост на P40. Было 100 мс на токен, стало 96.

Это может сработать, но по хорошему нужно просто в первом же сообщении где она попробовала так ответить стереть английский или русский оставив только один вариант. Что бы дальше так отвечала.

Или поместить английский выше, выделив его тегами перевод

Не трогай это говно, есть модели лучше.

Это новая 1.5 которая получается? Надо будет затестить.

Прошлая была ощутимо умнее 13б и движением в сторону 70, но пиздец шизоидная.

> Вообще все 70В до третьей ламы соснут у неё.

Сильное заявление, она вообще ебать должна тогда.

> По скорам

По скорам можно сделать победоносную 7б, говном от этого она быть не перестанет.

>Чудны запросы ваши, сумрачный гений пишет их…

Рад что вам нравится. Я вообще оченб люблю заниматься, простите за выебон, промт-инжинирингом. Вообще считаю что главное с ИИ это промт, а модель уж что0нибудь выдаст.

У меня много всякого вообще, жаль большая часть кумерская пиздец.

Ну там на легаси сайт можно приключить, но да, кал ебаный пидорасы соевые.

Пук пук пук регистрация, ой мы картинки нехорошие замылили, умри от спида соевик ебаный.

Не знает кто как картинки размылить?

Надо у форча спросить как они там.

>Не знает кто как картинки размылить?

->

Должно помочь.

Фалькон 1 был так себе, тут вот тоже 11B и 5T токенов обучения, тогда как в лламу 3 въебали 15T на модель в 8B.

> можно сделать победоносную 7б

MMLU нельзя.

На практике в лидерборде не вижу таких. Файнтюны мику так и не взяли MMLU в 77.

Спасибо точ то нужно

> Файнтюны мику

> Файнтюны

> мику

Чудо что они вообще не хуже становятся.

Какие? Чтобы с русским, сторителлинг, и большой контекст.

>Чтобы с русским, сторителлинг, и большой контекст

Лама-3 с контекстом в сотни тыс. до миллиона вроде

Командир

мойстрал v3

акведуки 18b

последние две на базе мистраля контекст не такой большой как у верхних но можно растянуть

больше ничего приличного подходящего под такие требования нет

>Лама-3 с контекстом в сотни тыс. до миллиона вроде

хуита, едва в 2 раза растягивается без потери мозгов

тоесть 16к максимум

все эти растягивания дальше - лоботомия

согласен, но я ж не знаю что в его понимании большой контекст. Может он книгу собрался писать таким образом. Так то 16к неплохо

>На практике в лидерборде не вижу таких.

Их оттуда разве не выдворяют с позором?

>Файнтюны мику

Сломаны по определению.

> Командир

А это разве не command-r и есть?

> мойстрал v3

> акведуки 18b

А как их называть правильно чтобы на обниморде найти если коммандер не заведётся?

> Лама-3

Это вроде базовая модель, наподобие sd_xl_base_1.0, базовые модели могут норм работать для специализированных задач?

>> Командир

>А это разве не command-r и есть?

Да, это синонимы (написать в вики что ли в скобках все "народные" варианты названий).

>базовые модели могут норм работать для специализированных задач?

Да, вай нот. Тем более лламу очень плотно обучали, так что не факт, что файнтюны много чего дадут. В общем ты сначала попробуй.

> если коммандер не заведётся

Быть не может, чтоб не завелся, качай последний по дате квант - все заведется кобольде 1.65

Названия moistral и вроде aqueducts

moistral 4 не качай с ним ничего не напишешь, модель испорчена видимо каким-то кривым трейном над версией 3. Просто убожество по сравнению с 3 версией.

А есть годные книги или мануалы как свою текстовую сеть обучить?

Хочется разобраться

Хочется разобраться

Спрашивай GPT4.

А ты с какими целями?

Для начала линк в шапке. Требования к железу оче высокие, требования к датасету не ниже. Тут несколько анонов пытались обучать, но пока успехом это не увенчалось.

Большая часть задач с которыми задают такие вопросы решаются промтом.

Да думаю в аспирантуру пойти, вот тема интересная с этими моделями

Так это, в аспирантуре и научат хуйне.

Ну, в этой стране есть учреждения где подобное может прокатить, и даже мощности найдешь проперженные вольты. Вот только учти что за 4 года ии может измениться ну очень значительно, твои труды потеряют актуальность и кривой файнтюн мистраля не прокатит для защиты. Может методика обучения и их применение, исследование того как адаптируется и прочее, что-то связанное с русским языком и т.п. Поступай, через пару лет станет понятнее, всегда будет план б и за время обучения поймешь обстановку и обзаведешься знакомствами.

Ну, ты делись меньшей частью.

Той частью меньшей части, за которую не начнут искать.

Ну, хотя и большей частью тоже можешь. =D

Не забывай, что нужна оператива.

Гонял я эти ваши десятки тысяч контекста.

50 минут ждал.

Кмк, коммандер, командир и command-r — очевидно одна и та же… Но, у нас искажение, при присутствовали при запуске модели и привыкли.

———

Простите, но о Чатгопоте-для-всех или омнимодальной.

Крутота.

Как бы, ясен красен, что там может быть и не мультимодалка даже, и локально такое можно было собрать с кучей промптов и достаточными мощностями (но по качеству хуже, офк), но тут все из коробки и работает. И интонации прикольные.

Ну клево-клево, что скажешь.

Хочу такое в две теслы чтобы помещалось. xD

Так, может, чел уже сейчас идет?

А профиль — не мл.

Так что, прокатить может, ИМХО.

Так вот есть база, где это прохавать можно?

Был курс, но там кластеризация-классиыикация, а дальше хз куда двигать

>Простите, но о Чатгопоте-для-всех или омнимодальной.

Ты о чём вообще?

> может, чел уже сейчас идет?

> думаю в аспирантуру пойти

Да ладно

Если профиль не мл - можно сфокусироваться на применении где-то. Но с обучением будет всеравно оче тяжко и мало смысла, проще ограничиться агентами и гопотой. Или уже делать совсем другую сеть а не ллм.

> Так вот есть база, где это прохавать можно?

Есть странные объемные книги не самые простые в освоении. Тема довольно таки передовая, если пойдешь по профилю то там найдешь людей, которые этим занимаются и у них научишься. Главное - найти свежих и бодрых специалистов, а не проперженных дедов.

У меня у одного хуй встает колом когда gpt-4o тянским голосом воспроизводит маленькие смешки и иногда говорит полушепотом? Пиздец какая эмоциональная аудио часть. Когда у попенсорса такие мультимодалки уже будут

Хуя, сижу, сычую, пропустил выход. Так, вопрос с очевидным ответом- она в секс может лень идти в кончай тред?

Акции тянок просели еще сильнее за один день, лел

Впрочем это проприоритетная соево цензурированная говнина клозедаи, не забывай это обманываясь привлекательностью мозгов и голоса модели

Подожду локалок с подобным функционалом, отдавать свои данные пидорасам не горю желанием

Но для работы или кодинга топчик

Еще нихуя не понятно что она может. Но надеюсь будут джеилбрейки, ибо голос генерирует порой такой живой, как будто с реальной тянкой общаешься которая испытывает к тебе интерес, ставлю на то что она умеет в охуенный сексуальный голос.

Вот хочется свою сеть попробовать делать, надо за лето похавать, а то как раз магу заканчиваю

>Но надеюсь будут джеилбрейки

Надеюсь не будет. Чем строже ограничения у закрытых сетей, тем быстрее сделают открытые аналоги.

О что там за функционал? Презентация не то чтобы впечатлила, скорее всего оно глупее 4турбы, особенно в задачах на длинный диалог.

Вишпер+ттс можешь обмазаться уже сейчас. С мультимодальностью сложнее уже.

> свою сеть попробовать делать

Десяток строк инициализации и немного обучения, вот и сеть готова. А "свою ллм" - смотри как бы не вышло как в смехуечках про свою ос у школьников.

Это чмоня даже не смогла добавить вижн в новые ламы, они там и про MOE еще не слышали. На него расчитывать не стоит, там деды зашоренные сидят, которые верят что текстовыми трансформерами AGI получат

парни тут некоторое время назад обсуждали коммандер.

так вот может скинуть ссылку на коммандер ггуф который можно запустить на 3070 и 64гб

так вот может скинуть ссылку на коммандер ггуф который можно запустить на 3070 и 64гб

>О что там за функционал?

Её можно перебивать, лол. А так фулл голос, ответ за секунды, распознание видео, интонации (там явно аудио часть не сбоку приклеена).

> распознание видео

Вот это интересно.

А так скорее всего лоботомит на зирошоты нормисовских задач для сбора rlhf, оценок и прочего.

> там явно аудио часть не сбоку приклеена

Рофлишь? Интонацию легко распознать и добавить тегом. Тру аудио часть позволила бы распознавать музыку по "настроению", угадывать разные вещи, объекты и кучу другого. Они бы это показали особой фичей, а не просто разговоры.

Так сказали же что полноценная мультимодалка. Она аудио токены воспринимает и генерит. Это в разы круче ттс ибо восприятие слов в контексте 100%-ное, она может даже понимать несуществующие слова как в примере с "dad jokes", может выдавать весь спектр эмоций, говорить шепотом, говорить быстро или медленно, реалистично смеяться, говорить со смешком и даже петь. Единственный косяк - это артефакты генерации, которые слышно порой, если бы не они я б даже не поверил что это ИИ.

>Это в разы круче ттс ибо восприятие слов в контексте 100%-ное,

Два чаю. Сам такую систему мечтаю запилить, но меня опередила какая-то сраная корпорация. Пидоры.

> сказали же

Сурьезно? Да сурьезно, а ты не верил?

Некоторый перенос активаций между моделями может быть, но он невероятно ограничен и недалеко ушел от перегонки в текст, если судить по показанному.

Ллм часть по первым оценкам довольно туповата, по крайней мере на свайпах прошлых чатов отвратительно. Исправить ошибку в коде - путается, обработку текста - ошибается, в рп - вообще ломается и тупит (возможно еще и из-за жб).

Не знаю что там с ллм частью, но по аудио части вопросов нет

Каких вопросов? Оно синтезирует текст и распознает речь? Никогда такого не было, лол.

Посмотрим что будет, но пока не впечатляет, кажется маркетологическим вбросом для впечатления сойбоев, а не приличным инструментом.

>Никогда такого не было, лол.

В одной модели не было синтеза и распознавания, насколько я знаю.

> В одной модели

Беру 3 модели, выстраиваю систему, скармливаю через красивый фронт, заявляя что это все ультрамультимодалка. И хуй ты докажешь обратное.

Если подойти чуть более основательно, то хватит минимального файнтюна для дополнительных токенов, отвечающих за интонацию и логическое ударение, и пост процессор что очищал бы их при выдаче чистого текста. Делается буквально силами одного человека за умеренное время, особенно учитывая что модель там мелкая.

Чето жопа подгорела на самом деле, ждал инноваций и прорывов а не 7б под красивым соусом. Распознавание пикч и видео разве что интересно, надо затестить.

>И хуй ты докажешь обратное.

С одной стороны да, с другой, у нас есть нормальный TTS, который выдаёт нормальные эмоции?

>Делается буквально силами одного человека за умеренное время

И где оно? Вишпер, ллама и xtts давно уже есть, но пока никто такого не представил.

>Сам придумал что его наебали

>Сам обиделся

>Сам написал пост на двач о том какая зрящая в корень илита, а плебс не выкупает

Ну пиздец ребят. У нас тут гений по 20-минутному демо-тесту крупную корпорацию на чистую воду вывел

> у нас есть нормальный TTS, который выдаёт нормальные эмоции?

Да, можно скармливать текст с разметкой. Не то чтобы в ттс разбираюсь, но такое видел.

> И где оно?

Кому нужно - уже делают, примеров вагон. Это буквально лежит перед тобой и доступно, для простого результата нужны общие знания, для хорошего - навыки, опыт и железо.

> пока никто такого не представил

хех

Ахуеть, в ллм треде впечатлившийся сойбой защищает клозедаи, топ кек.

а топ для каких целей? кумить? или решать в столбик? спрашиваю без рофла ибо только пытаюсь разобраться во всем этом

>Да, можно скармливать текст с разметкой.

Спасибо, я знаю. Результат говно если что.

>Кому нужно - уже делают, примеров вагон.

Где хоть один?

>Защищает

Челибос, ты просто понапридумал хуйни и я тебя тычу в это носом, как обоссавшегося котенка. Как ты там выводы сумел сделать я не знаю, но я явно доверяю тому что говорит сама компания разработчик больше чем рандомхую с двача.

Да вроде ничего так выходило. В любом случае без весов толку с этого нет. С опенсорсом ттс не везет, слишком комерциализована сфера, а интересующиеся, как правило, максимально далеки от тренировки.

> Где хоть один?

Ты рофлишь? От нейростримеров, которых за год развелось, до примеров чатов с вайфу в вр. Причем сделано на такой коленке, но вполне себе работает.

Это ты чего-то напридумывал и теперь пытаешься как-то задеть, потому что то чем ты впечатлился критикуют а не восхваляют.

> Как ты там выводы сумел сделать я не знаю, но я явно доверяю тому что говорит сама компания разработчик

О, шигоагностик, понимаю.

https://www.youtube.com/watch?v=wfAYBdaGVxs

Топ тир передача эмоций. Надеюсь АПИшка будет, наконец запилю себе ИИ друга хоть пообщаться смогу с кем-то...

Топ тир передача эмоций. Надеюсь АПИшка будет, наконец запилю себе ИИ друга хоть пообщаться смогу с кем-то...

>Опять что-то себе понапридумывал, в этот раз про оппонента в интернете, и свято в это верит

Дешево жопу продаешь, еще и приплачивая, лол

Кажется в мире много слабых людей которые сделают подобное, раз уж еще первые текстовые туповатые нейронки делали подобное

У тебя френдлиселффаер, и/или ты слишком туп чтобы понять предмет разговора.

С разговорами о новой GPT пройдите пожалуйста в чатГПТ тред:

Фубля фунахуй. Только сбежал от шумного, эмоционального и визгливого общества в тихий, уютный компьютерный мирок, как тут компьютер начинает общаться с тобой голосом быдловатой кассирши из супермаркета с тупыми смешками и стервозными интонациями.

Это давно уже общий ЛЛМ тред с учетом того что осталные треды по ЛЛМ мертвы.

> Топ тир передача эмоций

Хорошо что они есть. Но слишком наиграны и однотипны, будто набор смех/смешок/ухмылка. Вот если там будут крики ярости, мольбы, всхлипы, проникновенный шопот, что-то асмро-подобное только без мерзотного шлюшьего чавканья и свистов, сладкие протяжные речи, да еще все это с настройками голоса по промту - вот такое бы впечатлило.

Аналогично и с восприятием, причем оно не должно ограничиваться простым распознаванием речи, нужно полноценное понимание разных звуков.

Именно такое ждешь от мультимодалки, остальное - лишь просто токенами с небольшим дополнительным набором.

Ещё кончай тред. Но этот тред всё же про опенсорс локалки, а впопены явно никогда не выложат gpt-4o в открытый доступ РЯЯЯ БИЗАПАСНАСТЬ!!!!111.

>И хуй ты докажешь обратное.

Профиты клозедсорца. Можно впаривать любую хуйню, а проверить никак нельзя.

>который выдаёт нормальные эмоции?

Как раз недавно закрылась к хуям контора, которая делала самый продвинутый ттс. Может, что и продали пидормотам.

Они продемонстрировали как оно понимает дыхание человека, показали "эпичный" голос при рассказе истории перед сном, показали шепот. Так что думаю спеутр эмоций там дикий и показано вовсе не все, а так же это честная мультимодалка, которая может в понимания звуков кроме речи.

Возможно Цукерберг таки отхлестает раскаленным кнутом своих ученых и заставит их сделать хоть что-то в этом направлении, а то все что они пока делают - это просто обучают модели большего объема на большем количестве даты.

Из-за температуры сеть, вроде, поумнела. Где смотреть оптимальную температуру? yi 1.5 вот надо.

>Возможно Цукерберг таки отхлестает раскаленным кнутом своих ученых и заставит

Ох, сомневаюсь. Плюс они такие импотенты в плане новых идей, что максимум, на что они способны, это запилить адаптер для вишпера какого-нибудь, с проёбом 90% всех эмоций. Вряд ли террористы обучат с нуля модель под аудио и картинки.

Не тот уровень совсем, хотя на безрыбье офк. Это выглядит как переключение режимов из фиксированного набора, а не прямое управление и синтез из трансформерсов.

> думаю спеутр эмоций там дикий и показано вовсе не все

Ты серьезно? Давно видел современную презентацию где бы показывали не отборный черрипик и кейсы, которые в действительности никогда не будут так хороши, а просто ограниченные скучные примеры? Скорее всего самое отборное и было показано.

В любом случае, оно доступно, осталось дождаться полной документации апи для этого всего и победить лень чтобы покатать без ограничений, насколько это возможно с клозедами офк. Пока ллм часть там слаба, но может сгодится на озвучку.

Есть и хорошие новости, во-первых, это должно подстегнуть опенсорс направление ттс. Во-вторых, это позволит эффективно собирать годные (в плане отсутствия артефактов) датасеты.

Так апишка уже открыта? Какой-то хуй на ютубе жаловался что пока еще нет и можно только в плейграунде поаробовать. Если так, то прям щас же впиливаю в свой проект, прям как идеально под меня создавали, лул, только прям то что нужно для моих целей кроме соевости ебаной, придется от опенсорсной лламы в пользу этого отказываться, но альтернатив нет нужна работа с видео

> Так апишка уже открыта?

external models

Ну, на словах она омнимодалка, а на деле DALL-E и Sora для генерации изображений и видео, так что хз-хз, что там с генерацией аудио, да и распознаванием.

Их слова надо делить на 10.

Но все равно — быстро и впечатляюще.

> ультрамульти

Омни. )

Ну, хттс как раз не умеет в интонации. Умел бы — запилили.

Вообще, суть же не в том, что «Вау, это невозможное, как они это сделали!», или там «Ничегосебе, настоящая омнимодалка!»

Я не знаю, почему скептик-кун так старательно пытается выстроить соломенные чучела и привязать их к остальным участникам треда.

Конечно, любой из нас мог сделать такое же сам.

Конечно, это было бы чуть похуже качеством.

Но стоило бы дорого по компьюту.

Чатгопота фор олл хороша тем, что:

1. Умеет все это из коробки.

2. Быстра.

3. Бесплатна.

Она не уникальная, не первая, не что-то там еще. Она… работает. И работает хорошо. Все, этого достаточно. Она впечатляет своим юзер экспериенсом. Как стим сильно пошатал пиратскую сцену, когда качать игры стало дороже, чем покупать. Зачем настраивать кооператив и переносить сейвы, если можно заплатить 200-800 рублей (на тот момент), и получить все сразу?

Так и здесь, для большинства простых людей, зачем настраивать локальные нейронки, писать промпты, брать под это дело железо (или даже арендовать его), если можно — вот.

Я не знаю, почему скептик-кун так старательно пытается выстроить соломенные чучела и привязать их к остальным участникам треда.

Конечно, любой из нас мог сделать такое же сам.

Конечно, это было бы чуть похуже качеством.

Но стоило бы дорого по компьюту.

Чатгопота фор олл хороша тем, что:

1. Умеет все это из коробки.

2. Быстра.

3. Бесплатна.

Она не уникальная, не первая, не что-то там еще. Она… работает. И работает хорошо. Все, этого достаточно. Она впечатляет своим юзер экспериенсом. Как стим сильно пошатал пиратскую сцену, когда качать игры стало дороже, чем покупать. Зачем настраивать кооператив и переносить сейвы, если можно заплатить 200-800 рублей (на тот момент), и получить все сразу?

Так и здесь, для большинства простых людей, зачем настраивать локальные нейронки, писать промпты, брать под это дело железо (или даже арендовать его), если можно — вот.

But we have 4o at home

А вообще я думал хуже будет, голос только подсовывать свой не выходит успешно отрывком в 10-20 секунд, тут то видимо и стоит что то потренить, эмоции тоже как то не очень, я имею ввиду в самый то интересный момент, без этого даже охуеть как неплохо то. PLAP PLAP PLAP туда не хватает, лол, и побольше задора чтоли

Вот это вот пробую https://www.youtube.com/watch?v=d5XFO_l_3wA

А вообще я думал хуже будет, голос только подсовывать свой не выходит успешно отрывком в 10-20 секунд, тут то видимо и стоит что то потренить, эмоции тоже как то не очень, я имею ввиду в самый то интересный момент, без этого даже охуеть как неплохо то. PLAP PLAP PLAP туда не хватает, лол, и побольше задора чтоли

Вот это вот пробую https://www.youtube.com/watch?v=d5XFO_l_3wA

>3. Бесплатна.

Лол, сейчас бы верить в бесплатность хоть чего-то. Товар это ТЫ.

>Зачем настраивать кооператив

Да, зачем? Играю в синглы.

>Так и здесь, для большинства простых людей, зачем настраивать локальные нейронки

Так ничего же не изменилось. Им и турба тяжело, ибо VPN ставить надо.

Вот и все. Она качественна. Она быстра. Она бесплатна.

Буквально через час после этого Гугл скинул превьюху своей (завтрашней? уже сегодняшней?) презентации. И там тоже самое. Но между вопросом и ответом — 3 секунды. Фейл, слишком долго, пф!

Вот такой вот маркетинг. Просто выиграли внимание презентацией качественного, с первого взгляда, продукта.

Клево-клево.

Ничего более. Конечно, мы все еще хотим локалочки и приватность.

И 48 гигов в 5090. Ну хотя бы 32, пожалуйста!..

И Теслы А100 на авито по цене P40.

Буквально через час после этого Гугл скинул превьюху своей (завтрашней? уже сегодняшней?) презентации. И там тоже самое. Но между вопросом и ответом — 3 секунды. Фейл, слишком долго, пф!

Вот такой вот маркетинг. Просто выиграли внимание презентацией качественного, с первого взгляда, продукта.

Клево-клево.

Ничего более. Конечно, мы все еще хотим локалочки и приватность.

И 48 гигов в 5090. Ну хотя бы 32, пожалуйста!..

И Теслы А100 на авито по цене P40.

Ну ты дурачок.

Я же не говорю о минусах, ясное дело, что они собирают инфу, и это и есть плата. А кто-то еще и платит за то, чтобы отдавать инфу. =)

Гениальный мув.

Ну, говоря о впн — мы говорим лишь о некоторых странах. Большинству заебца.